La prima startup di sicurezza informatica di Josh Lospinoso è stata acquisita nel 2017 da Raytheon/Forcepoint. Il suo secondo, Shift5, lavora con le forze armate statunitensi, gli operatori ferroviari e le compagnie aeree, inclusa JetBlue. Laureato nel 2009 a West Point e Rhodes Scholar, l'ex capitano dell'esercito di 36 anni ha trascorso più di un decennio creazione di strumenti di hacking per la National Security Agency e il Cyber Command degli Stati Uniti.

Lospinoso ha recentemente dichiarato a una sottocommissione dei servizi armati del Senato come l'intelligenza artificiale può aiutare a proteggere le operazioni militari. Il CEO/programmatore ha discusso l'argomento con l'Associated Press e come le vulnerabilità del software nei sistemi d'arma siano una grave minaccia per l'esercito americano. L'intervista è stata modificata per chiarezza e lunghezza.

D: Nella tua testimonianza, hai descritto due principali minacce alle tecnologie basate sull'intelligenza artificiale: una è il furto. Questo si spiega da sé. L'altro è l'avvelenamento dei dati. Puoi spiegarlo?

R: Un modo per pensare all'avvelenamento dei dati è come disinformazione digitale. Se gli avversari sono in grado di creare i dati che le tecnologie abilitate all'intelligenza artificiale vedono, possono avere un impatto profondo sul funzionamento di tale tecnologia.

D: Si sta verificando un avvelenamento dei dati?

A: Non lo vediamo in generale. Ma è avvenuto. Uno dei casi più noti si è verificato nel 2016. Microsoft ha rilasciato un chatbot di Twitter chiamato Tay che ha appreso dalle conversazioni che ha avuto online. Gli utenti malintenzionati hanno cospirato per twittare un linguaggio offensivo e offensivo. Tay ha iniziato a generare contenuti provocatori. Microsoft lo ha portato offline.

D: L'intelligenza artificiale non è solo chatbot. È stato a lungo parte integrante della sicurezza informatica, giusto?

R: L'intelligenza artificiale viene utilizzata nei filtri e-mail per cercare di contrassegnare e segregare la posta indesiderata e le esche di phishing. Un altro esempio sono gli endpoint, come il programma antivirus sul tuo laptop o il software di rilevamento malware che viene eseguito sulle reti. Naturalmente, anche gli hacker offensivi usano l'intelligenza artificiale per tentare di sconfiggere quei sistemi di classificazione. Si chiama IA contraddittoria.

D: Parliamo di sistemi software militari. Un 2018 allarmante Rapporto dell'ufficio di responsabilità del governo ha affermato che quasi tutti i sistemi d'arma di nuova concezione presentavano vulnerabilità mission-critical. E il Pentagono sta pensando di inserire l'intelligenza artificiale in tali sistemi?

R: Ci sono due problemi qui. In primo luogo, dobbiamo proteggere adeguatamente i sistemi d'arma esistenti. Questo è un debito tecnico che abbiamo e che richiederà molto tempo per essere saldato. Poi c'è una nuova frontiera per proteggere gli algoritmi di intelligenza artificiale: nuove cose che installeremmo. Il rapporto GAO non parlava davvero di intelligenza artificiale. Quindi dimentica l'intelligenza artificiale per un secondo. Se questi sistemi sono rimasti così come sono, sono ancora profondamente vulnerabili.

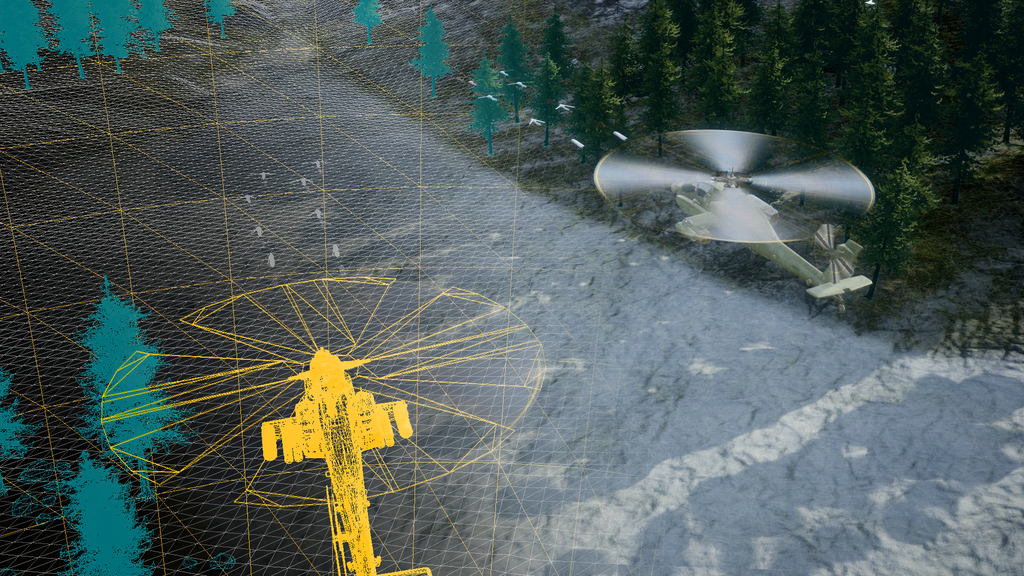

Stiamo discutendo di spingerci oltre e aggiungere funzionalità abilitate all'intelligenza artificiale per cose come una migliore manutenzione e intelligenza operativa. Alla grande. Ma stiamo costruendo in cima a un castello di carte. Molti sistemi sono vecchi di decenni, adattati con tecnologie digitali. Aerei, veicoli terrestri, assetti spaziali, sottomarini. Ora sono interconnessi. Stiamo scambiando dati dentro e fuori. I sistemi sono porosi, difficili da aggiornare e potrebbero essere attaccati. Una volta che un utente malintenzionato ottiene l'accesso, il gioco è finito.

A volte è più facile costruire una nuova piattaforma che riprogettare i componenti digitali dei sistemi esistenti. Ma c'è un ruolo per l'IA nella protezione di questi sistemi. L'intelligenza artificiale può essere utilizzata per difendersi se qualcuno cerca di comprometterli.

D: Hai testimoniato che sospendere la ricerca sull'IA, come alcuni hanno sollecitato, sarebbe una cattiva idea perché favorirebbe la Cina e altri concorrenti. Ma hai anche preoccupazioni per la corsa precipitosa ai prodotti AI. Perché?

A: Odio sembrare fatalista, ma sembra applicabile il cosiddetto caso di "uso bruciante". Un prodotto immesso sul mercato spesso prende fuoco (viene violato, fallisce, provoca danni involontari). E noi diciamo: "Ragazzo, avremmo dovuto integrare la sicurezza". Mi aspetto che il ritmo dello sviluppo dell'IA acceleri e potremmo non fermarci abbastanza per farlo in modo sicuro e responsabile. Almeno la Casa Bianca e il Congresso stanno discutendo di questi problemi.

D: Sembra che un gruppo di aziende, anche nel settore della difesa, si stia affrettando ad annunciare prodotti AI semicotti.

R: Tutte le aziende tecnologiche e molte aziende non tecnologiche hanno fatto quasi una svolta stridente verso l'IA. Le dislocazioni economiche stanno arrivando. I modelli di business cambieranno radicalmente. Le dislocazioni stanno già accadendo o sono all'orizzonte e i leader aziendali stanno cercando di non farsi cogliere impreparati.

D: E l'uso dell'intelligenza artificiale nel processo decisionale militare come il targeting?

A: Non credo, categoricamente non penso che gli algoritmi di intelligenza artificiale - i dati che stiamo raccogliendo - siano pronti per la prima serata affinché un sistema di armi letali prenda decisioni. Siamo così lontani da questo.

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- PlatoAiStream. Intelligenza dei dati Web3. Conoscenza amplificata. Accedi qui.

- Coniare il futuro con Adryenn Ashley. Accedi qui.

- Acquista e vendi azioni in società PRE-IPO con PREIPO®. Accedi qui.

- Fonte: https://www.defensenews.com/artificial-intelligence/2023/05/29/adversarial-ai-a-threat-to-military-systems-shift5s-lospinoso-says/

- :ha

- :È

- :non

- 2016

- 2017

- 2018

- 70

- a

- capace

- Chi siamo

- accelerare

- accesso

- responsabilità

- acquisito

- l'aggiunta di

- adeguatamente

- contraddittorio

- agenzia

- AI

- ricerca ai

- aereo

- Compagnie Aeree

- Algoritmi

- Tutti

- già

- anche

- an

- ed

- Annunciare

- Un altro

- antivirus

- APPLICA

- SONO

- armato

- Army

- artificiale

- intelligenza artificiale

- AS

- Attività

- associato

- At

- Vasca

- BE

- perché

- stato

- ha iniziato

- in linea di massima

- costruire

- Costruzione

- costruito

- Mazzo

- affari

- ma

- by

- detto

- Materiale

- funzionalità

- Carte

- Custodie

- casi

- catturati

- il cambiamento

- chatbot

- chatbots

- Cina

- chiarezza

- classificazione

- Raccolta

- arrivo

- Aziende

- azienda

- concorrenti

- componenti

- compromesso

- preoccupazioni

- Congresso

- contenuto

- Conversazioni

- potuto

- corso

- artigianali

- critico

- Cyber

- Cybersecurity

- dati

- Debito

- decennio

- decenni

- Decision Making

- decisioni

- Difesa

- descritta

- rivelazione

- sviluppato

- Mercato

- digitale

- discusso

- discutere

- Le disinformazioni sanitarie

- do

- effettua

- più facile

- Economico

- abbastanza

- Ogni

- esempio

- esistente

- attenderti

- Spiegare

- fallisce

- lontano

- favorire

- filtri

- Antincendio

- Nome

- Nel

- Ex

- da

- Frontier

- fondamentalmente

- Guadagni

- gioco

- GAO

- generare

- ottenere

- andando

- grande

- Terra

- hacked

- hacker

- pirateria informatica

- ha avuto

- successo

- Happening

- Hard

- Avere

- a capofitto

- Aiuto

- qui

- il suo

- orizzonte

- Casa

- Come

- HTTPS

- i

- idea

- if

- immagini

- Impact

- migliorata

- in

- Compreso

- install

- integrale

- Intelligence

- interconnesso

- Colloquio

- ai miglioramenti

- sicurezza

- IT

- jetBlue

- ad appena

- Lingua

- laptop

- capi

- imparato

- meno

- Lunghezza

- piace

- Lunghi

- a lungo

- fatto

- manutenzione

- maggiore

- Fare

- il malware

- rilevamento di malware

- molti

- Rappresentanza

- Microsoft

- forza

- Militare

- Missione

- modelli

- Scopri di più

- Detto

- il

- sicurezza nazionale

- National Security Agency

- quasi

- Bisogno

- reti

- New

- Nuova piattaforma

- romanzo

- adesso

- si è verificato

- of

- offensivo

- Office

- offline

- di frequente

- Vecchio

- on

- una volta

- ONE

- online

- opera

- operativa

- Operazioni

- Operatori

- or

- Altro

- su

- ancora

- Pace

- pausa

- Paga le

- pentagono

- phishing

- Perno

- piattaforma

- Platone

- Platone Data Intelligence

- PlatoneDati

- punto

- stampa

- premio

- Direttore

- Prodotto

- Prodotti

- Programma

- protegge

- spingendo

- Mettendo

- A binario

- pronto

- veramente

- recentemente

- ridisegnare

- rilasciato

- rapporto

- riparazioni

- responsabile

- destra

- Ruolo

- corsa

- s

- Suddetto

- dire

- dice

- Secondo

- settore

- sicuro

- fissaggio

- problemi di

- vedere

- vedendo

- sembra

- Senato

- Servizi

- dovrebbero

- So

- finora

- Software

- alcuni

- Qualcuno

- Suono

- lo spazio

- esaurito

- startup

- rimasto

- Ancora

- sottocomitato

- soggetto

- tale

- scambio

- sistema

- SISTEMI DI TRATTAMENTO

- Fai

- Parlare

- mira

- Tech

- Azienda tecnologica

- Consulenza

- Tecnologie

- Tecnologia

- testimoniato

- testimonianza

- di

- che

- I

- furto

- Li

- poi

- Là.

- Strumenti Bowman per analizzare le seguenti finiture:

- di

- cose

- think

- Pensiero

- questo

- quelli

- minaccia

- minacce

- tempo

- a

- ha preso

- top

- verso

- prova

- Tweet

- seconda

- noi

- upgrade

- uso

- utilizzato

- utenti

- Veicoli

- molto

- vulnerabilità

- Vulnerabile

- Prima

- Modo..

- we

- Armi

- WELL

- ovest

- Che

- bianca

- Casa Bianca

- perché

- con

- lavori

- sarebbe

- Tu

- Trasferimento da aeroporto a Sharm

- zefiro