La velocità di throughput della memoria e la bassa latenza sono fondamentali poiché l'inferenza si sposta dal data center al perimetro della rete.

L'intelligenza artificiale/ML si sta evolvendo a un ritmo rapidissimo. Non passa settimana in questo momento senza alcuni nuovi ed entusiasmanti sviluppi nel campo e applicazioni come ChatGPT hanno portato le capacità di intelligenza artificiale generativa saldamente in prima linea all'attenzione del pubblico.

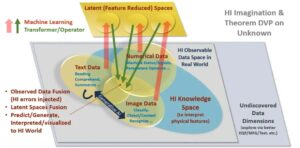

L'AI/ML è in realtà composta da due applicazioni: training e inferenza. Ognuno di essi fa affidamento sulle prestazioni della memoria e ciascuno presenta una serie di requisiti univoci che guidano la scelta della migliore soluzione di memoria.

Con la formazione, la larghezza di banda e la capacità della memoria sono requisiti critici. Ciò è particolarmente vero se si considerano le dimensioni e la complessità dei modelli di dati delle reti neurali che crescono a un ritmo di 10 volte all’anno. L'accuratezza della rete neurale dipende dalla qualità e dalla quantità di esempi nel set di dati di addestramento, il che si traduce nella necessità di enormi quantità di dati e quindi di larghezza di banda e capacità di memoria.

Dato il valore creato attraverso la formazione, esiste un forte incentivo a completare i percorsi formativi il più rapidamente possibile. Poiché le applicazioni di formazione vengono eseguite in data center sempre più limitati in termini di energia e spazio, vengono favorite le soluzioni che offrono efficienza energetica e dimensioni ridotte. Considerati tutti questi requisiti, HBM3 è una soluzione di memoria ideale per l'hardware di addestramento AI. Fornisce eccellenti capacità di larghezza di banda e capacità.

L'output dell'addestramento della rete neurale è un modello di inferenza che può essere utilizzato su vasta scala. Con questo modello, un dispositivo di inferenza può elaborare e interpretare input al di fuori dei limiti dei dati di addestramento. Per l'inferenza, la velocità di throughput della memoria e la bassa latenza sono fondamentali, soprattutto quando è necessaria un'azione in tempo reale. Con il crescente spostamento dell’inferenza dell’intelligenza artificiale dal cuore del data center ai confini della rete, queste funzionalità di memoria stanno diventando ancora più critiche.

I progettisti hanno una serie di scelte di memoria per l'inferenza AI/ML, ma per quanto riguarda il parametro critico della larghezza di banda, la memoria GDDR6 brilla davvero. Con una velocità dati di 24 Gigabit al secondo (Gb/s) e un'interfaccia a 32 bit, un dispositivo GDDR6 può fornire 96 Gigabyte al secondo (GB/s) di larghezza di banda della memoria, più del doppio di quella di qualsiasi DDR o memoria alternativa. Soluzioni LPDDR. La memoria GDDR6 offre un'ottima combinazione di velocità, larghezza di banda e prestazioni di latenza per l'inferenza AI/ML, in particolare per l'inferenza all'edge.

Il sottosistema di interfaccia di memoria Rambus GDDR6 offre prestazioni di 24 Gb/s e si basa su oltre 30 anni di esperienza nell'integrità del segnale ad alta velocità e nell'integrità dell'alimentazione (SI/PI), fondamentali per il funzionamento di GDDR6 ad alte velocità. È costituito da un PHY e un controller digitale, che fornisce un sottosistema di interfaccia di memoria GDDR6 completo.

Unisciti a me al webinar Rambus questo mese su "Inferenza AI/ML ad alte prestazioni con memoria GDDR24 da 6 GB" per scoprire in che modo GDDR6 supporta i requisiti di memoria e prestazioni dei carichi di lavoro di inferenza AI/ML e conoscere alcune delle considerazioni chiave sulla progettazione e l'implementazione dei sottosistemi di interfaccia di memoria GDDR6.

Risorse:

Franco Ferro

(tutti i post)

Frank Ferro è direttore senior del marketing di prodotto per i core IP di Rambus.

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- PlatoAiStream. Intelligenza dei dati Web3. Conoscenza amplificata. Accedi qui.

- Coniare il futuro con Adryenn Ashley. Accedi qui.

- Acquista e vendi azioni in società PRE-IPO con PREIPO®. Accedi qui.

- Fonte: https://semiengineering.com/gddr6-delivers-the-performance-for-ai-ml-inference/

- :ha

- :È

- :non

- 24

- 26

- 27

- 30

- 8

- a

- WRI

- precisione

- Action

- AI

- Addestramento AI

- AI / ML

- Tutti

- Tutti i messaggi

- alternativa

- importi

- an

- ed

- in qualsiasi

- applicazioni

- SONO

- AS

- At

- attenzione

- Larghezza di banda

- BE

- diventando

- stato

- MIGLIORE

- in linea di massima

- portato

- costruito

- ma

- by

- Materiale

- funzionalità

- Ultra-Grande

- centro

- centri

- ChatGPT

- scegliere

- scelte

- combinazione

- completamento di una

- complessità

- Considerazioni

- controllore

- creato

- critico

- dati

- Banca dati

- data center

- set di dati

- consegnare

- fornisce un monitoraggio

- dipende

- schierato

- Design

- sviluppi

- dispositivo

- digitale

- Direttore

- scopri

- doppio

- guidare

- ogni

- bordo

- efficienza

- enorme

- particolarmente

- Anche

- evoluzione

- Esempi

- eccellente

- coinvolgenti

- competenza

- Caratteristiche

- campo

- fermamente

- Nel

- prima linea

- Fondazione

- da

- generativo

- AI generativa

- dato

- va

- grande

- Crescita

- Hardware

- Avere

- Cuore

- quindi

- Alta

- Come

- HTTPS

- ideale

- implementazione

- in

- Incentivo

- sempre più

- Ingressi

- interezza

- Interfaccia

- ai miglioramenti

- IP

- IT

- jpg

- Le

- Latenza

- IMPARARE

- fulmine

- piace

- Basso

- Marketing

- Memorie

- modello

- modelli

- Mese

- Scopri di più

- di applicazione

- che necessitano di

- Rete

- Dati di rete

- Neurale

- rete neurale

- New

- adesso

- numero

- of

- offrire

- Offerte

- on

- operativo

- or

- produzione

- al di fuori

- ancora

- Pace

- parametro

- particolare

- particolarmente

- performance

- Platone

- Platone Data Intelligence

- PlatoneDati

- popolarità

- possibile

- Post

- energia

- potente

- processi

- Prodotto

- fornisce

- fornitura

- la percezione

- qualità

- quantità

- rapidamente

- tasso

- tempo reale

- veramente

- Requisiti

- destra

- RIGA

- Correre

- Secondo

- anziano

- set

- MUTEVOLE

- Turni

- Signal

- Taglia

- inferiore

- So

- soluzione

- Soluzioni

- alcuni

- lo spazio

- velocità

- velocità

- supporti

- di

- che

- Il

- Là.

- Strumenti Bowman per analizzare le seguenti finiture:

- questo

- Attraverso

- portata

- miniature

- a

- Training

- seconda

- unico

- APPREZZIAMO

- webinar

- settimana

- quando

- quale

- largo

- con

- senza

- anno

- anni

- zefiro