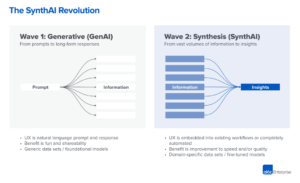

Kami mulai melihat tahap paling awal dari tumpukan teknologi muncul dalam kecerdasan buatan (AI) generatif. Ratusan startup baru bergegas ke pasar untuk mengembangkan model dasar, membangun aplikasi asli AI, dan membangun infrastruktur/peralatan.

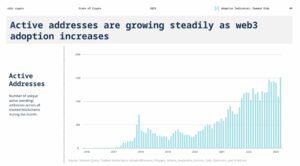

Banyak tren teknologi panas yang terlalu digembar-gemborkan jauh sebelum pasar menyusul. Tetapi ledakan AI yang generatif telah disertai dengan keuntungan nyata di pasar nyata, dan daya tarik nyata dari perusahaan nyata. Model seperti Stable Diffusion dan ChatGPT mencetak rekor historis untuk pertumbuhan pengguna, dan beberapa aplikasi telah mencapai $100 juta dari pendapatan tahunan kurang dari setahun setelah diluncurkan. Perbandingan berdampingan menunjukkan model AI mengungguli manusia dalam beberapa tugas dengan beberapa urutan besarnya.

Jadi, ada cukup data awal yang menunjukkan transformasi besar-besaran sedang terjadi. Apa yang tidak kita ketahui, dan yang sekarang menjadi pertanyaan kritis, adalah: Di mana di pasar ini nilai akan bertambah?

Selama setahun terakhir, kami telah bertemu dengan puluhan pendiri dan operator startup di perusahaan besar yang berhubungan langsung dengan AI generatif. Kami telah mengamati itu vendor infrastruktur kemungkinan besar adalah pemenang terbesar di pasar ini sejauh ini, menangkap sebagian besar dolar yang mengalir melalui tumpukan. Perusahaan aplikasi meningkatkan pendapatan topline dengan sangat cepat tetapi sering kesulitan dengan retensi, diferensiasi produk, dan margin kotor. Dan kebanyakan penyedia model, meskipun bertanggung jawab atas keberadaan pasar ini, belum mencapai skala komersial yang besar.

Dengan kata lain, perusahaan yang menciptakan nilai terbesar — yaitu melatih model AI generatif dan menerapkannya di aplikasi baru — belum menangkap sebagian besar darinya. Memprediksi apa yang akan terjadi selanjutnya jauh lebih sulit. Tapi menurut kami hal utama yang harus dipahami adalah bagian tumpukan mana yang benar-benar dibedakan dan dipertahankan. Ini akan berdampak besar pada struktur pasar (yaitu pengembangan perusahaan horizontal vs. vertikal) dan pendorong nilai jangka panjang (misalnya margin dan retensi). Sejauh ini, kami kesulitan menemukan pertahanan struktural di manapun di tumpukan, di luar parit tradisional untuk petahana.

Kami sangat optimis pada AI generatif dan percaya itu akan berdampak besar pada industri perangkat lunak dan seterusnya. Tujuan dari postingan ini adalah untuk memetakan dinamika pasar dan mulai menjawab pertanyaan yang lebih luas tentang model bisnis AI generatif.

Tumpukan teknologi tingkat tinggi: Infrastruktur, model, dan aplikasi

Untuk memahami bagaimana pasar AI generatif terbentuk, pertama-tama kita perlu menentukan bagaimana tampilan tumpukan hari ini. Inilah pandangan awal kami.

Tumpukan dapat dibagi menjadi tiga lapisan:

- Aplikasi yang mengintegrasikan model AI generatif ke dalam produk yang menghadap pengguna, baik menjalankan saluran model mereka sendiri ("aplikasi end-to-end") atau mengandalkan API pihak ketiga

- Model yang memperkuat produk AI, tersedia baik sebagai API hak milik atau sebagai pos pemeriksaan sumber terbuka (yang, pada gilirannya, memerlukan solusi hosting)

- Infrastruktur vendor (yaitu platform cloud dan produsen perangkat keras) yang menjalankan beban kerja pelatihan dan inferensi untuk model AI generatif

Penting untuk diperhatikan: Ini bukan peta pasar, tetapi kerangka kerja untuk menganalisis pasar. Di setiap kategori, kami mencantumkan beberapa contoh vendor terkenal. Kami belum berusaha untuk menjadi komprehensif atau mencantumkan semua aplikasi AI generatif luar biasa yang telah dirilis. Kami juga tidak membahas lebih jauh di sini tentang perkakas MLops atau LLMops, yang belum terstandarisasi tinggi dan akan dibahas di pos mendatang.

Gelombang pertama aplikasi AI generatif mulai mencapai skala, tetapi berjuang dengan retensi dan diferensiasi

Dalam siklus teknologi sebelumnya, kebijaksanaan konvensional adalah untuk membangun perusahaan besar dan mandiri, Anda harus memiliki pelanggan akhir — apakah itu berarti konsumen individu atau pembeli B2B. Sangat menggoda untuk percaya bahwa perusahaan terbesar dalam AI generatif juga akan menjadi aplikasi pengguna akhir. Sejauh ini, tidak jelas itu masalahnya.

Yang pasti, pertumbuhan aplikasi AI generatif telah mencengangkan, didorong oleh kebaruan belaka dan banyaknya kasus penggunaan. Faktanya, kami mengetahui setidaknya tiga kategori produk yang telah melampaui pendapatan tahunan $100 juta: pembuatan gambar, penulisan naskah, dan penulisan kode.

Namun, pertumbuhan saja tidak cukup untuk membangun perusahaan perangkat lunak yang tahan lama. Secara kritis, pertumbuhan harus menguntungkan — dalam artian bahwa pengguna dan pelanggan, begitu mereka mendaftar, menghasilkan keuntungan (margin kotor tinggi) dan bertahan lama (retensi tinggi). Dengan tidak adanya diferensiasi teknis yang kuat, aplikasi B2B dan B2C mendorong nilai pelanggan jangka panjang melalui efek jaringan, menyimpan data, atau membangun alur kerja yang semakin kompleks.

Dalam AI generatif, asumsi tersebut tidak selalu benar. Di seluruh perusahaan aplikasi yang telah kami ajak bicara, ada berbagai margin kotor — setinggi 90% dalam beberapa kasus, tetapi lebih sering serendah 50-60%, sebagian besar didorong oleh biaya inferensi model. Pertumbuhan top-of-funnel sangat luar biasa, tetapi tidak jelas apakah strategi akuisisi pelanggan saat ini dapat diskalakan — kami telah melihat keberhasilan akuisisi berbayar dan retensi mulai menurun. Banyak aplikasi juga relatif tidak terdiferensiasi, karena mereka mengandalkan model AI dasar yang serupa dan belum menemukan efek jaringan yang jelas, atau data/alur kerja, yang sulit diduplikasi oleh pesaing.

Jadi, belum jelas bahwa menjual aplikasi pengguna akhir adalah satu-satunya, atau bahkan jalan terbaik, untuk membangun bisnis AI generatif yang berkelanjutan. Margin harus meningkat karena persaingan dan efisiensi dalam model bahasa meningkat (lebih lanjut tentang ini di bawah). Retensi harus meningkat karena wisatawan AI meninggalkan pasar. Dan ada argumen kuat bahwa aplikasi yang terintegrasi secara vertikal memiliki keunggulan dalam mendorong diferensiasi. Tapi masih banyak yang harus dibuktikan.

Ke depan, beberapa pertanyaan besar yang dihadapi perusahaan aplikasi AI generatif antara lain:

- Integrasi vertikal (“model + aplikasi”). Mengkonsumsi model AI sebagai layanan memungkinkan pengembang aplikasi melakukan iterasi dengan cepat dengan tim kecil dan bertukar penyedia model seiring kemajuan teknologi. Di sisi lain, beberapa pengembang berpendapat bahwa produk tersebut is model, dan bahwa pelatihan dari awal adalah satu-satunya cara untuk menciptakan pertahanan — yaitu dengan terus melatih kembali data produk hak milik. Tapi itu datang dengan biaya persyaratan modal yang jauh lebih tinggi dan tim produk yang kurang gesit.

- Membangun fitur vs. aplikasi. Produk AI generatif mengambil beberapa bentuk berbeda: aplikasi desktop, aplikasi seluler, plugin Figma/Photoshop, ekstensi Chrome, bahkan bot Discord. Sangat mudah untuk mengintegrasikan produk AI di mana pengguna sudah bekerja, karena UI umumnya hanya berupa kotak teks. Manakah dari perusahaan ini yang akan menjadi perusahaan mandiri — dan mana yang akan diserap oleh pemain lama, seperti Microsoft atau Google, yang telah memasukkan AI ke dalam lini produk mereka?

- Mengelola melalui siklus hype. Belum jelas apakah churn melekat pada kumpulan produk AI generatif saat ini, atau apakah itu merupakan artefak dari pasar awal. Atau jika lonjakan minat pada AI generatif akan turun saat hype mereda. Pertanyaan-pertanyaan ini memiliki implikasi penting bagi perusahaan aplikasi, termasuk kapan harus menginjak pedal gas dalam penggalangan dana; seberapa agresif berinvestasi dalam akuisisi pelanggan; segmen pengguna mana yang akan diprioritaskan; dan kapan harus menyatakan kecocokan pasar-produk.

Penyedia model menemukan AI generatif, tetapi belum mencapai skala komersial besar

Apa yang sekarang kita sebut AI generatif tidak akan ada tanpa penelitian dan rekayasa brilian yang dilakukan di tempat-tempat seperti Google, OpenAI, dan Stabilitas. Melalui arsitektur model baru dan upaya heroik untuk menskalakan pipa pelatihan, kita semua mendapat manfaat dari kemampuan luar biasa dari model bahasa besar (LLM) saat ini dan model pembuatan gambar.

Namun pendapatan yang terkait dengan perusahaan ini masih relatif kecil dibandingkan penggunaan dan buzz. Dalam pembuatan gambar, Difusi Stabil telah melihat pertumbuhan komunitas yang eksplosif, didukung oleh ekosistem antarmuka pengguna, penawaran yang dihosting, dan metode penyempurnaan. Tetapi Stabilitas memberikan pos pemeriksaan utama mereka secara gratis sebagai prinsip inti bisnis mereka. Dalam model bahasa natural, OpenAI mendominasi dengan GPT-3/3.5 dan ChatGPT. Tetapi relatif beberapa aplikasi pembunuh yang dibangun di atas OpenAI ada sejauh ini, dan harganya sudah dijatuhkan sekali.

Ini mungkin hanya fenomena sementara. Stabilitas adalah perusahaan baru yang belum fokus pada monetisasi. OpenAI memiliki potensi untuk menjadi bisnis besar-besaran, menghasilkan porsi yang signifikan dari semua pendapatan kategori NLP karena semakin banyak aplikasi mematikan yang dibangun — terutama jika mereka integrasi ke dalam portofolio produk Microsoft berjalan lancar. Mengingat penggunaan model ini yang sangat besar, pendapatan skala besar mungkin tidak jauh di belakang.

Tapi ada juga kekuatan penyeimbang. Model yang dirilis sebagai open source dapat dihosting oleh siapa saja, termasuk perusahaan luar yang tidak menanggung biaya yang terkait dengan pelatihan model skala besar (hingga puluhan atau ratusan juta dolar). Dan tidak jelas apakah ada model sumber tertutup yang dapat mempertahankan keunggulannya tanpa batas. Misalnya, kami mulai melihat LLM yang dibangun oleh perusahaan seperti Anthropic, Cohere, dan Character.ai mendekati tingkat kinerja OpenAI, dilatih pada kumpulan data serupa (yaitu internet) dan dengan arsitektur model serupa. Contoh Difusi Stabil menunjukkan hal itu if model open source mencapai tingkat kinerja dan dukungan komunitas yang memadai, maka alternatif berpemilik mungkin akan sulit bersaing.

Mungkin kesimpulan paling jelas bagi penyedia model, sejauh ini, adalah bahwa komersialisasi kemungkinan besar terkait dengan hosting. Permintaan untuk API berpemilik (misalnya dari OpenAI) berkembang pesat. Layanan hosting untuk model open-source (misalnya Hugging Face dan Replicate) muncul sebagai hub yang berguna untuk berbagi dan mengintegrasikan model dengan mudah — dan bahkan memiliki beberapa efek jaringan tidak langsung antara produsen model dan konsumen. Ada juga hipotesis kuat bahwa uang dapat dimonetisasi melalui perjanjian penyesuaian dan hosting dengan pelanggan perusahaan.

Di luar itu, ada sejumlah pertanyaan besar yang dihadapi penyedia model:

- Komoditisasi. Ada kepercayaan umum bahwa model AI akan menyatu dalam performa dari waktu ke waktu. Berbicara dengan pengembang aplikasi, jelas itu belum terjadi, dengan pemimpin yang kuat baik dalam model teks maupun gambar. Keunggulan mereka tidak didasarkan pada arsitektur model yang unik, tetapi pada persyaratan modal yang tinggi, data interaksi produk eksklusif, dan bakat AI yang langka. Apakah ini akan berfungsi sebagai keuntungan yang tahan lama?

- Risiko kelulusan. Mengandalkan penyedia model adalah cara yang bagus bagi perusahaan aplikasi untuk memulai, dan bahkan mengembangkan bisnis mereka. Namun ada insentif bagi mereka untuk membuat dan/atau menghosting model mereka sendiri setelah mencapai skala. Dan banyak penyedia model memiliki distribusi pelanggan yang sangat miring, dengan beberapa aplikasi mewakili sebagian besar pendapatan. Apa yang terjadi jika/ketika pelanggan ini beralih ke pengembangan AI internal?

- Apakah uang itu penting? Janji AI generatif begitu besar — dan juga berpotensi sangat berbahaya — sehingga banyak penyedia model telah mengaturnya sebagai korporasi kepentingan publik (korps B), mengeluarkan bagian keuntungan yang dibatasi, atau dengan cara lain memasukkan barang publik secara eksplisit ke dalam misi mereka. Ini sama sekali tidak menghalangi upaya penggalangan dana mereka. Tapi ada diskusi yang masuk akal untuk membahas apakah sebagian besar penyedia model benar-benar ingin untuk menangkap nilai, dan jika mereka harus.

Vendor infrastruktur menyentuh segalanya, dan menuai hasilnya

Hampir semua yang ada di AI generatif melewati GPU (atau TPU) yang dihosting cloud di beberapa titik. Baik untuk penyedia model/laboratorium penelitian yang menjalankan beban kerja pelatihan, perusahaan hosting yang menjalankan inferensi/penyesuaian halus, atau perusahaan aplikasi yang melakukan kombinasi keduanya — TERJADI adalah sumber kehidupan AI generatif. Untuk pertama kalinya dalam waktu yang sangat lama, kemajuan pada teknologi komputasi yang paling mengganggu secara besar-besaran terikat dengan komputasi.

Akibatnya, banyak uang di pasar AI generatif akhirnya mengalir ke perusahaan infrastruktur. Untuk menaruh beberapa sangat angka kasar di sekitarnya: Kami memperkirakan bahwa, rata-rata, perusahaan aplikasi menghabiskan sekitar 20-40% dari pendapatan untuk inferensi dan penyempurnaan per pelanggan. Ini biasanya dibayarkan langsung ke penyedia cloud untuk instance komputasi atau ke penyedia model pihak ketiga — yang, pada gilirannya, membelanjakan sekitar setengah dari pendapatan mereka untuk infrastruktur cloud. Jadi, masuk akal untuk menebak bahwa 10-20% dari total pendapatan dalam AI generatif saat ini beralih ke penyedia cloud.

Selain itu, startup yang melatih model mereka sendiri telah mengumpulkan miliaran dolar dalam modal ventura — yang sebagian besar (hingga 80-90% di putaran awal) biasanya juga dihabiskan dengan penyedia cloud. Banyak perusahaan teknologi publik menghabiskan ratusan juta per tahun untuk pelatihan model, baik dengan penyedia cloud eksternal atau langsung dengan produsen perangkat keras.

Inilah yang kami sebut, dalam istilah teknis, "banyak uang" - terutama untuk pasar yang baru lahir. Sebagian besar dihabiskan di Big 3 cloud: Amazon Web Services (AWS), Google Cloud Platform (GCP), dan Microsoft Azure. Penyedia cloud ini secara kolektif menghabiskan lebih dari $ 100 miliar per tahun dalam belanja modal untuk memastikan mereka memiliki platform yang paling komprehensif, andal, dan kompetitif. Dalam AI generatif, khususnya, mereka juga mendapat manfaat dari kendala pasokan karena mereka memiliki akses istimewa ke perangkat keras yang langka (misalnya GPU Nvidia A100 dan H100).

Menariknya, kami mulai melihat persaingan yang kredibel muncul. Penantang seperti Oracle telah membuat terobosan dengan pengeluaran capex yang besar dan insentif penjualan. Dan beberapa startup, seperti Coreweave dan Lambda Labs, telah berkembang pesat dengan solusi yang ditargetkan khusus untuk pengembang model besar. Mereka bersaing dalam hal biaya, ketersediaan, dan dukungan yang dipersonalisasi. Mereka juga memaparkan abstraksi sumber daya yang lebih terperinci (yaitu wadah), sedangkan awan besar hanya menawarkan instans VM karena batas virtualisasi GPU.

Di belakang layar, menjalankan sebagian besar beban kerja AI, sejauh ini mungkin pemenang terbesar dalam AI generatif: Nvidia. Perusahaan dilaporkan $3.8 milyar pendapatan GPU pusat data pada kuartal ketiga tahun fiskal 2023, termasuk porsi yang berarti untuk kasus penggunaan AI generatif. Dan mereka telah membangun parit yang kuat di sekitar bisnis ini melalui investasi puluhan tahun dalam arsitektur GPU, ekosistem perangkat lunak yang kuat, dan penggunaan mendalam di komunitas akademik. Satu analisis terbaru menemukan bahwa GPU Nvidia dikutip dalam makalah penelitian 90 kali lebih banyak daripada gabungan chip AI teratas.

Opsi perangkat keras lainnya memang ada, termasuk Unit Pemrosesan Tensor Google (TPU); GPU AMD Instinct; chip AWS Inferentia dan Trainium; dan akselerator AI dari startup seperti Cerebras, Sambanova, dan Graphcore. Intel, yang terlambat memasuki permainan, juga memasuki pasar dengan chip Habana kelas atas dan GPU Ponte Vecchio. Namun sejauh ini, beberapa dari chip baru ini telah mengambil pangsa pasar yang signifikan. Dua pengecualian yang harus diperhatikan adalah Google, yang TPU-nya telah mendapatkan daya tarik di komunitas Stable Diffusion dan di beberapa kesepakatan GCP besar, dan TSMC, yang dipercaya memproduksi semua dari chip yang tercantum di sini, termasuk GPU Nvidia (Intel menggunakan campuran fabrikasinya sendiri dan TSMC untuk membuat chipnya).

Dengan kata lain, infrastruktur adalah lapisan tumpukan yang menguntungkan, tahan lama, dan tampaknya dapat dipertahankan. Pertanyaan besar yang harus dijawab untuk perusahaan infra meliputi:

- Memegang beban kerja tanpa kewarganegaraan. GPU Nvidia sama di mana pun Anda menyewanya. Sebagian besar beban kerja AI tidak memiliki kewarganegaraan, dalam arti bahwa inferensi model tidak memerlukan database atau penyimpanan terlampir (selain untuk bobot model itu sendiri). Ini berarti beban kerja AI mungkin lebih portabel di cloud daripada beban kerja aplikasi tradisional. Bagaimana, dalam konteks ini, penyedia cloud dapat membuat keterikatan dan mencegah pelanggan beralih ke opsi termurah?

- Bertahan dari akhir kelangkaan chip. Penetapan harga untuk penyedia cloud, dan untuk Nvidia sendiri, telah didukung oleh pasokan langka dari GPU yang paling diinginkan. Salah satu penyedia memberi tahu kami bahwa daftar harga untuk A100 sebenarnya Pada meningkat sejak diluncurkan, yang sangat tidak biasa untuk perangkat keras komputasi. Ketika batasan pasokan ini akhirnya dihilangkan, melalui peningkatan produksi dan/atau adopsi platform perangkat keras baru, bagaimana pengaruhnya terhadap penyedia cloud?

- Bisakah awan penantang menerobos? Kami sangat percaya itu awan vertikal akan mengambil pangsa pasar dari 3 Besar dengan penawaran yang lebih terspesialisasi. Di AI sejauh ini, para penantang telah mengukir daya tarik yang berarti melalui diferensiasi teknis yang moderat dan dukungan dari Nvidia — di mana penyedia cloud lama adalah pelanggan terbesar dan pesaing baru. Pertanyaan jangka panjangnya adalah, apakah ini cukup untuk mengatasi keuntungan skala dari 3 Besar?

Jadi… di mana nilai akan bertambah?

Tentu saja, kita belum tahu. Tetapi berdasarkan data awal yang kami miliki untuk AI generatif, digabungkan dengan pengalaman kami dengan perusahaan AI/ML sebelumnya, intuisi kita adalah sebagai berikut.

Tampaknya, hari ini, tidak ada parit sistemik dalam AI generatif. Sebagai pendekatan orde pertama, aplikasi tidak memiliki diferensiasi produk yang kuat karena mereka menggunakan model serupa; model menghadapi diferensiasi jangka panjang yang tidak jelas karena dilatih pada kumpulan data serupa dengan arsitektur serupa; penyedia cloud tidak memiliki diferensiasi teknis yang mendalam karena mereka menjalankan GPU yang sama; dan bahkan perusahaan perangkat keras memproduksi chip mereka dengan pabrik yang sama.

Ada, tentu saja, parit standar: parit berskala (“Saya memiliki atau dapat mengumpulkan lebih banyak uang daripada Anda!”), parit rantai pasokan (“Saya memiliki GPU, Anda tidak!”), parit ekosistem (“ Semua orang sudah menggunakan perangkat lunak saya!”), parit algoritmik (“Kami lebih pintar dari Anda!”), parit distribusi (“Saya sudah memiliki tim penjualan dan lebih banyak pelanggan daripada Anda!”), dan parit pipa data (“Saya' telah menjelajahi lebih banyak internet daripada Anda!”). Tapi tak satu pun dari parit ini cenderung tahan lama dalam jangka panjang. Dan masih terlalu dini untuk mengetahui apakah efek jaringan langsung yang kuat terjadi di setiap lapisan tumpukan.

Berdasarkan data yang tersedia, tidak jelas apakah akan ada dinamika jangka panjang pemenang-ambil-semua dalam AI generatif.

Ini aneh. Tapi bagi kami, itu kabar baik. Ukuran potensial pasar ini sulit untuk dipahami — di antara keduanya semua perangkat lunak dan segala usaha manusia — jadi kami mengharapkan banyak, banyak pemain dan kompetisi yang sehat di semua level tumpukan. Kami juga mengharapkan perusahaan horizontal dan vertikal untuk berhasil, dengan pendekatan terbaik ditentukan oleh pasar akhir dan pengguna akhir. Misalnya, jika diferensiasi utama dalam produk akhir adalah AI itu sendiri, kemungkinan vertikalisasi (yaitu menggabungkan aplikasi yang menghadap pengguna ke model buatan sendiri) akan menang. Sedangkan jika AI adalah bagian dari kumpulan fitur berekor panjang yang lebih besar, maka kemungkinan besar horizontalisasi akan terjadi. Tentu saja, kita juga harus melihat pembangunan parit yang lebih tradisional dari waktu ke waktu - dan kita bahkan mungkin melihat jenis parit baru.

Apa pun masalahnya, satu hal yang kami yakini adalah AI generatif mengubah permainan. Kita semua mempelajari aturan secara real time, ada banyak sekali nilai yang akan dibuka, dan lanskap teknologi akan terlihat sangat berbeda sebagai hasilnya. Dan kami di sini untuk itu!

Semua gambar di postingan ini dibuat menggunakan Midjourney.

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- Platoblockchain. Intelijen Metaverse Web3. Pengetahuan Diperkuat. Akses Di Sini.

- Sumber: https://a16z.com/2023/01/19/who-owns-the-generative-ai-platform/

- $ 100 juta

- $3

- 1

- a

- A100

- Tentang Kami

- akademik

- akselerator

- mengakses

- dicapai

- perolehan

- di seluruh

- sebenarnya

- Adopsi

- uang muka

- Keuntungan

- keuntungan

- Setelah

- perjanjian

- di depan

- AI

- Platform AI

- saya menggunakan kasus

- AI / ML

- algoritmik

- Semua

- memungkinkan

- sendirian

- sudah

- alternatif

- menakjubkan

- Amazon

- Amazon Web Services

- Layanan Web Amazon (AWS)

- AMD

- jumlah

- menganalisa

- dan

- disetahunkan

- menjawab

- siapapun

- Lebah

- aplikasi

- muncul

- Aplikasi

- aplikasi

- Menerapkan

- pendekatan

- aplikasi

- arsitektur

- membantah

- argumen

- sekitar

- buatan

- kecerdasan buatan

- Kecerdasan buatan (AI)

- terkait

- tersedianya

- tersedia

- rata-rata

- AWS

- Inferensi AWS

- Biru langit

- B2B

- B2C

- berdasarkan

- Beruang

- karena

- menjadi

- sebelum

- di belakang

- keyakinan

- Percaya

- diyakini

- orang percaya

- di bawah

- manfaat

- TERBAIK

- antara

- Luar

- Besar

- Terbesar

- Milyar

- miliaran

- ledakan

- bot

- terikat

- Kotak

- Istirahat

- cemerlang

- lebih luas

- membangun

- Bangunan

- dibangun di

- Bullish

- bisnis

- bisnis

- pembeli

- panggilan

- kemampuan

- modal

- menangkap

- Menangkap

- kasus

- kasus

- kategori

- Kategori

- pusat

- tertentu

- penantang

- Perubahan

- karakter

- ChatGPT

- termurah

- keping

- Keripik

- Chrome

- dikutip

- jelas

- lebih dekat

- awan

- infrastruktur cloud

- Platform Cloud

- kode

- kolektif

- kombinasi

- bergabung

- bagaimana

- komersial

- komersialisasi

- Umum

- masyarakat

- Perusahaan

- perusahaan

- dibandingkan

- bersaing

- kompetisi

- pesaing

- kompleks

- luas

- menghitung

- komputasi

- kendala

- Konsumen

- Wadah

- konteks

- terus-menerus

- konvensional

- bertemu

- copywriting

- Core

- Perusahaan

- Biaya

- Biaya

- Tentu saja

- membuat

- dibuat

- membuat

- kredibel

- kritis

- terbaru

- pelanggan

- pelanggan

- siklus

- data

- Data Center

- database

- kumpulan data

- transaksi

- Penawaran

- dekade

- mendalam

- Permintaan

- Desktop

- mengembangkan

- pengembang

- Pengembangan

- Devs

- berbeda

- bentuk yang berbeda

- dibedakan

- Difusi

- langsung

- langsung

- perselisihan

- ditemukan

- diskusi

- mengganggu

- distribusi

- distribusi

- Terbagi

- melakukan

- dolar

- mendominasi

- Dont

- puluhan

- mendorong

- didorong

- driver

- penggerak

- dinamis

- dinamika

- setiap

- Terdahulu

- Awal

- Produktif

- mudah

- ekosistem

- Tepi

- efek

- efisiensi

- upaya

- antara

- muncul

- Teknik

- cukup

- memastikan

- Enterprise

- pelanggan perusahaan

- terutama

- memperkirakan

- Bahkan

- akhirnya

- segala sesuatu

- contoh

- contoh

- mengharapkan

- pengalaman

- ekstensi

- luar

- Menghadapi

- menghadapi

- Jatuh

- Fitur

- Fitur

- beberapa

- Menemukan

- temuan

- Pertama

- pertama kali

- Fiskal

- cocok

- Penerjunan

- Mengalir

- Mengalir

- terfokus

- berikut

- pasukan

- bentuk

- ditemukan

- Prinsip Dasar

- pendiri

- Kerangka

- Gratis

- dari

- Penggalangan Dana

- masa depan

- Keuntungan

- permainan

- GAS

- umumnya

- menghasilkan

- generasi

- generatif

- AI generatif

- mendapatkan

- diberikan

- memberikan

- tujuan

- Pergi

- akan

- baik

- Google Cloud

- Google Cloud Platform

- GPU

- GPU

- memahami

- besar

- bruto

- Tumbuh

- Pertumbuhan

- dewasa

- Pertumbuhan

- Setengah

- terjadi

- terjadi

- Terjadi

- Sulit

- Perangkat keras

- berbahaya

- sehat

- di sini

- High

- lebih tinggi

- sangat

- historis

- Memukul

- memegang

- memegang

- Horisontal

- tuan rumah

- host

- tuan

- PANAS

- Seterpercayaapakah Olymp Trade? Kesimpulan

- HTTPS

- besar

- manusia

- Ratusan

- ratusan juta

- Hype

- gambar

- generasi gambar

- gambar

- Dampak

- implikasi

- penting

- memperbaiki

- in

- Di lain

- Insentif

- Insentif

- memasukkan

- Termasuk

- Tergabung

- menggabungkan

- Meningkatkan

- Pada meningkat

- Meningkatkan

- makin

- luar biasa

- Incumbent

- independen

- sendiri-sendiri

- industri

- Infrastruktur

- inheren

- mengintegrasikan

- terpadu

- integrasi

- Intel

- Intelijen

- interaksi

- bunga

- interface

- Internet

- intuisi

- Jadian

- Menginvestasikan

- investasi

- Ditempatkan

- IT

- Diri

- kunci

- Tahu

- Labs

- Kekurangan

- pemandangan

- bahasa

- besar

- besar-besaran

- sebagian besar

- lebih besar

- Terakhir

- Tahun lalu

- Terlambat

- jalankan

- lapisan

- lapisan

- pemimpin

- pengetahuan

- Meninggalkan

- Tingkat

- adalah ide yang bagus

- Mungkin

- batas

- baris

- Daftar

- Daftar

- Panjang

- lama

- jangka panjang

- melihat

- TERLIHAT

- Lot

- Rendah

- menguntungkan

- terbuat

- memelihara

- utama

- Mayoritas

- membuat

- Produsen

- banyak

- peta

- margin

- Pasar

- peta pasar

- Struktur pasar

- pasar

- besar-besaran

- secara besar-besaran

- max-width

- berarti

- cara

- metode

- Microsoft

- Microsoft Azure

- Pertengahan Perjalanan

- juta

- jutaan

- Misi

- MLOps

- mobil

- ponsel-apps

- model

- model

- monetisasi

- uangkan

- uang

- lebih

- paling

- beberapa

- baru lahir

- Alam

- Bahasa Alami

- perlu

- Perlu

- jaringan

- New

- perangkat keras baru

- berita

- berikutnya

- gesit

- nLP

- novel

- kebaruan

- jumlah

- nomor

- Nvidia

- Jelas

- menawarkan

- Penawaran

- ONE

- Buka

- open source

- OpenAI

- operator

- pilihan

- Opsi

- peramal

- perintah

- terorganisir

- Lainnya

- jika tidak

- di luar

- Mengatasi

- sendiri

- memiliki

- dibayar

- dokumen

- bagian

- tertentu

- bagian

- melewati

- path

- prestasi

- mungkin

- Personalized

- gejala

- pipa saluran

- Tempat

- Tempat

- Platform

- Platform

- plato

- Kecerdasan Data Plato

- Data Plato

- pemain

- kebanyakan

- plugin

- Titik

- mungkin

- Pos

- potensi

- berpotensi

- kekuasaan

- memprediksi

- mencegah

- harga pompa cor beton mini

- harga

- primer

- Sebelumnya

- Prioritaskan

- pengolahan

- Produsen

- Produk

- Produksi

- Produk

- Keuntungan

- menguntungkan

- keuntungan

- Kemajuan

- janji

- hak milik

- Rasakan itu

- pemberi

- penyedia

- publik

- menempatkan

- Perempat

- pertanyaan

- Pertanyaan

- segera

- menaikkan

- menonjol

- jarak

- cepat

- mencapai

- tercapai

- nyata

- real-time

- masuk akal

- baru

- arsip

- relatif

- dirilis

- dapat diandalkan

- Dihapus

- Menyewa

- mewakili

- membutuhkan

- Persyaratan

- penelitian

- sumber

- tanggung jawab

- mengakibatkan

- penyimpanan

- pendapatan

- pendapatan

- Risiko

- kuat

- putaran

- aturan

- Run

- berjalan

- penjualan

- Insentif Penjualan

- sama

- terukur

- Skala

- Langka

- Kelangkaan

- adegan

- melihat

- segmen

- Penjualan

- rasa

- melayani

- layanan

- Layanan

- set

- pengaturan

- beberapa

- Bentuknya

- Share

- saham

- harus

- Menunjukkan

- menandatangani

- penting

- mirip

- sejak

- Ukuran

- kecil

- lancar

- So

- sejauh ini

- Perangkat lunak

- larutan

- Solusi

- beberapa

- di suatu tempat

- sumber

- khusus

- Secara khusus

- menghabiskan

- menghabiskan

- Stabilitas

- stabil

- tumpukan

- magang

- berdiri

- standalone

- standar

- awal

- mulai

- Mulai

- startup

- Startups

- Tongkat

- Masih

- penyimpanan

- strategi

- kuat

- struktural

- struktur

- Perjuangan

- berhasil

- cukup

- Menyarankan

- menyediakan

- mendukung

- Didukung

- gelora

- berkelanjutan

- Beralih

- sistemik

- Mengambil

- pengambilan

- Bakat

- pembicaraan

- ditargetkan

- tugas

- tim

- tech

- perusahaan teknologi

- Teknis

- Teknologi

- sementara

- istilah

- Grafik

- mereka

- diri

- hal

- Ketiga

- pihak ketiga

- tiga

- Melalui

- Terjalin

- rapat

- waktu

- kali

- untuk

- hari ini

- terlalu

- puncak

- menyentuh

- daya tarik

- tradisional

- terlatih

- Pelatihan

- Transformasi

- dahsyat

- Tren

- benar

- tsmc

- MENGHIDUPKAN

- jenis

- khas

- ui

- Akhirnya

- pokok

- memahami

- unik

- unit

- luar biasa

- us

- penggunaan

- menggunakan

- Pengguna

- Pengguna

- nilai

- Luas

- vendor

- usaha

- modal ventura

- melalui

- View

- Menonton

- Gelombang

- jaringan

- layanan web

- terkenal

- Apa

- apakah

- yang

- sementara

- SIAPA

- lebar

- Rentang luas

- Wikipedia

- akan

- menang

- pemenang

- kebijaksanaan

- tanpa

- kata

- Kerja

- Alur kerja

- penulisan

- tahun

- zephyrnet.dll