Gambar oleh Penulis

Ada banyak kursus dan sumber daya yang tersedia mengenai pembelajaran mesin dan ilmu data, tetapi sangat sedikit yang membahas rekayasa data. Hal ini menimbulkan beberapa pertanyaan. Apakah ini bidang yang sulit? Apakah ia menawarkan bayaran rendah? Bukankah peran ini dianggap semenarik peran teknologi lainnya? Namun, kenyataannya banyak perusahaan yang secara aktif mencari talenta teknik data dan menawarkan gaji yang besar, terkadang melebihi $200,000 USD. Insinyur data memainkan peran penting sebagai arsitek platform data, merancang dan membangun sistem dasar yang memungkinkan ilmuwan data dan pakar pembelajaran mesin berfungsi secara efektif.

Untuk mengatasi kesenjangan industri ini, DataTalkClub telah memperkenalkan bootcamp yang transformatif dan gratis, “Zoomcamp Rekayasa Data“. Kursus ini dirancang untuk memberdayakan pemula atau profesional yang ingin beralih karier, dengan keterampilan penting dan pengalaman praktis dalam rekayasa data.

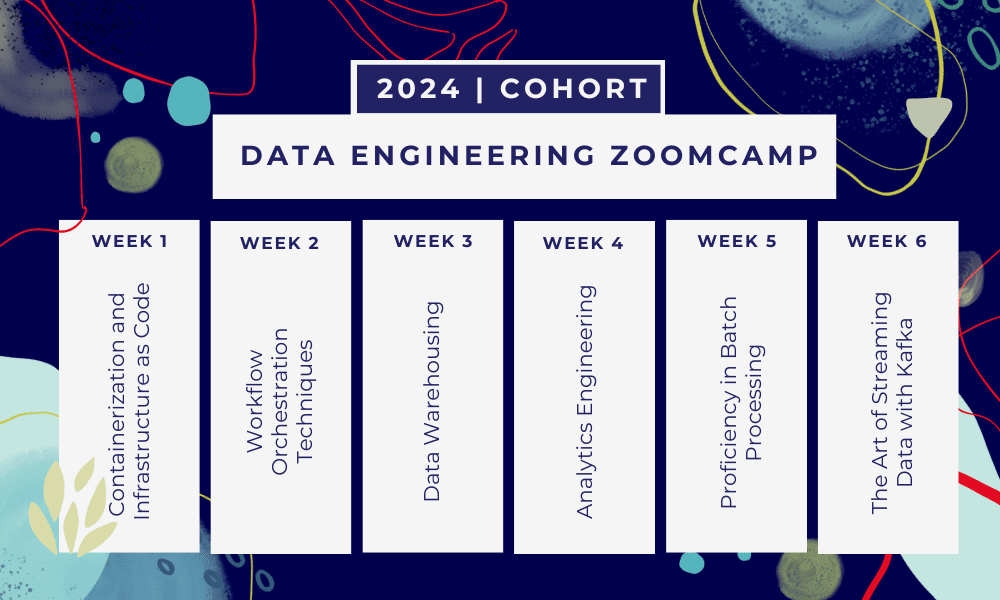

Ini adalah sebuah kamp pelatihan 6 minggu di mana Anda akan belajar melalui berbagai kursus, bahan bacaan, lokakarya, dan proyek. Di akhir setiap modul, Anda akan diberikan pekerjaan rumah untuk mempraktikkan apa yang telah Anda pelajari.

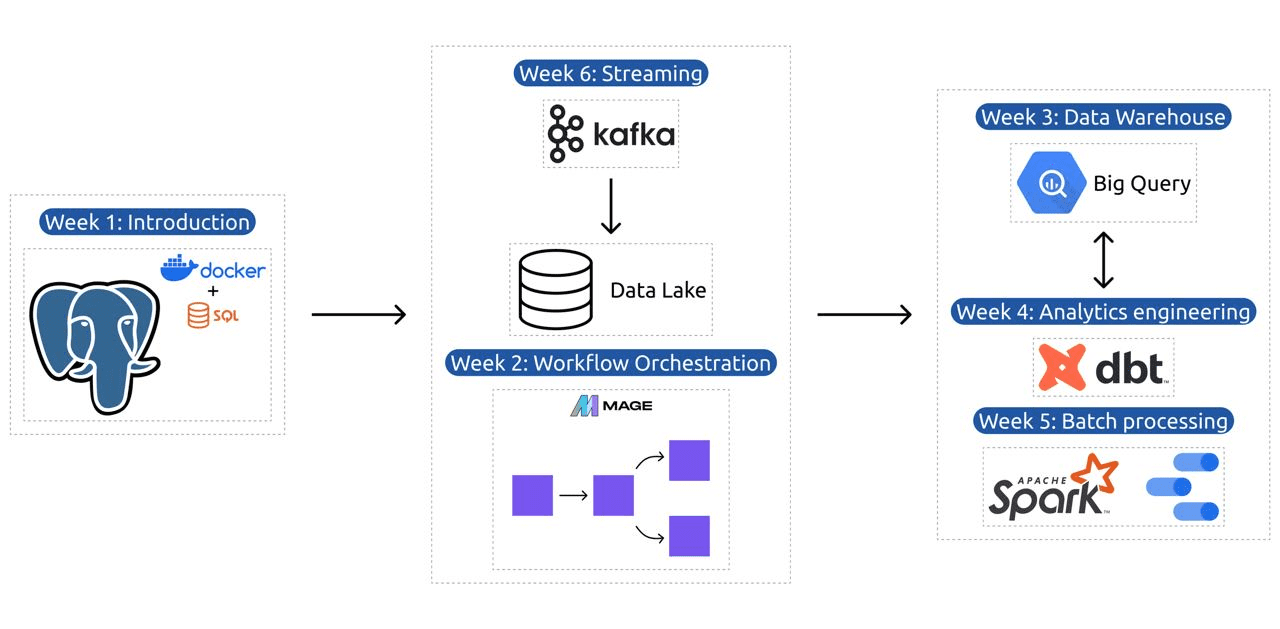

- Minggu 1: Pengantar GCP, Docker, Postgres, Terraform, dan penyiapan lingkungan.

- Minggu 2: Orkestrasi alur kerja dengan Mage.

- Minggu 3: Gudang data dengan BigQuery dan pembelajaran mesin dengan BigQuery.

- Minggu 4: Insinyur analitik dengan dbt, Google Data Studio, dan Metabase.

- Minggu 5: Pemrosesan batch dengan Spark.

- Minggu 6: Streaming dengan Kafka.

Gambar dari DataTalksClub/data-engineering-zoomcamp

Silabus berisi 6 modul, 2 lokakarya, dan sebuah proyek yang mencakup semua yang diperlukan untuk menjadi insinyur data profesional.

Modul 1: Menguasai Kontainerisasi dan Infrastruktur sebagai Kode

Dalam modul ini, Anda akan mempelajari tentang Docker dan Postgres, dimulai dari dasar-dasarnya hingga tutorial mendetail tentang cara membuat pipeline data, menjalankan Postgres dengan Docker, dan banyak lagi.

Modul ini juga mencakup alat-alat penting seperti pgAdmin, Docker-compose, dan topik penyegaran SQL, dengan konten opsional tentang jaringan Docker dan panduan khusus untuk pengguna Linux subsistem Windows. Pada akhirnya, kursus ini memperkenalkan Anda pada GCP dan Terraform, yang memberikan pemahaman menyeluruh tentang containerisasi dan infrastruktur sebagai kode, yang penting untuk lingkungan berbasis cloud modern.

Modul 2: Teknik Orkestrasi Alur Kerja

Modul ini menawarkan eksplorasi mendalam tentang Mage, kerangka kerja hybrid sumber terbuka yang inovatif untuk transformasi dan integrasi data. Modul ini dimulai dengan dasar-dasar orkestrasi alur kerja, berlanjut ke latihan praktis dengan Mage, termasuk menyiapkannya melalui Docker dan membuat pipeline ETL dari API ke Postgres dan Google Cloud Storage (GCS), lalu ke BigQuery.

Perpaduan modul antara video, sumber daya, dan tugas praktis memastikan pengalaman belajar yang komprehensif, membekali pelajar dengan keterampilan untuk mengelola alur kerja data yang canggih menggunakan Mage.

Lokakarya 1: Strategi Penyerapan Data

Pada lokakarya pertama, Anda akan menguasai pembuatan saluran penyerapan data yang efisien. Lokakarya ini berfokus pada keterampilan penting seperti mengekstraksi data dari API dan file, normalisasi dan memuat data, serta teknik pemuatan tambahan. Setelah menyelesaikan lokakarya ini, Anda akan dapat membuat saluran data yang efisien seperti seorang data engineer senior.

Modul 3: Pergudangan Data

Modul ini merupakan eksplorasi mendalam tentang penyimpanan dan analisis data, dengan fokus pada Data Warehousing menggunakan BigQuery. Panduan ini mencakup konsep-konsep utama seperti pemartisian dan pengelompokan, serta mendalami praktik terbaik BigQuery. Modul ini berkembang ke topik tingkat lanjut, khususnya integrasi Machine Learning (ML) dengan BigQuery, menyoroti penggunaan SQL untuk ML, dan menyediakan sumber daya tentang penyetelan hyperparameter, prapemrosesan fitur, dan penerapan model.

Modul 4: Rekayasa Analisis

Modul rekayasa analitik berfokus pada pembuatan proyek menggunakan dbt (Data Build Tool) dengan gudang data yang sudah ada, baik BigQuery atau PostgreSQL.

Modul ini mencakup pengaturan dbt di lingkungan cloud dan lokal, memperkenalkan konsep teknik analitik, ETL vs ELT, dan pemodelan data. Ini juga mencakup fitur dbt tingkat lanjut seperti model tambahan, tag, kait, dan snapshot.

Pada akhirnya, modul ini memperkenalkan teknik untuk memvisualisasikan data yang diubah menggunakan alat seperti Google Data Studio dan Metabase, dan menyediakan sumber daya untuk pemecahan masalah dan pemuatan data yang efisien.

Modul 5: Kemahiran dalam Pemrosesan Batch

Modul ini mencakup pemrosesan batch menggunakan Apache Spark, dimulai dengan pengenalan pemrosesan batch dan Spark, serta petunjuk instalasi untuk Windows, Linux, dan MacOS.

Ini mencakup menjelajahi Spark SQL dan DataFrames, menyiapkan data, melakukan operasi SQL, dan memahami internal Spark. Terakhir, diakhiri dengan menjalankan Spark di cloud dan mengintegrasikan Spark dengan BigQuery.

Modul 6: Seni Streaming Data dengan Kafka

Modul dimulai dengan pengenalan konsep pemrosesan aliran, diikuti dengan eksplorasi mendalam tentang Kafka, termasuk dasar-dasarnya, integrasi dengan Confluent Cloud, dan aplikasi praktis yang melibatkan produsen dan konsumen.

Modul ini juga mencakup konfigurasi dan aliran Kafka, membahas topik-topik seperti penggabungan aliran, pengujian, windowing, dan penggunaan ksqldb & Connect Kafka. Selain itu, ia memperluas fokusnya ke lingkungan Python dan JVM, menampilkan Faust untuk pemrosesan aliran Python, Pyspark – Streaming Terstruktur, dan contoh Scala untuk Kafka Streams.

Lokakarya 2: Pemrosesan Aliran dengan SQL

Anda akan belajar memproses dan mengelola data streaming dengan RisingWave, yang memberikan solusi hemat biaya dengan pengalaman gaya PostgreSQL untuk memberdayakan aplikasi pemrosesan streaming Anda.

Proyek: Aplikasi Rekayasa Data Dunia Nyata

Tujuan dari proyek ini adalah untuk mengimplementasikan semua konsep yang telah kita pelajari dalam kursus ini untuk membangun pipeline data end-to-end. Anda akan membuat dasbor yang terdiri dari dua ubin dengan memilih kumpulan data, membangun jalur pipa untuk memproses data dan menyimpannya di danau data, membangun jalur pipa untuk mentransfer data yang diproses dari danau data ke gudang data, mentransformasikannya data di gudang data dan mempersiapkannya untuk dashboard, dan terakhir membangun dashboard untuk menyajikan data secara visual.

Detail Kelompok 2024

- Pendaftaran: Daftar sekarang

- Tanggal mulai: 15 Januari 2024, pukul 17:00 CET

- Pembelajaran mandiri dengan dukungan terpandu

- Folder kelompok dengan pekerjaan rumah dan tenggat waktu

- Interaktif Komunitas Slack untuk pembelajaran rekan

Prasyarat

- Keterampilan coding dasar dan baris perintah

- Fondasi dalam SQL

- Python: bermanfaat tetapi tidak wajib

Instruktur Ahli Memimpin Perjalanan Anda

- Ankush Khanna

- Victoria Perez Mola

- Alexei Grigorev

- Matt Palmer

- Luis Oliveira

- Michael Pembuat Sepatu

Bergabunglah dengan kelompok 2024 kami dan mulailah belajar dengan komunitas teknik data yang luar biasa. Dengan pelatihan yang dipimpin oleh para ahli, pengalaman langsung, dan kurikulum yang disesuaikan dengan kebutuhan industri, bootcamp ini tidak hanya membekali Anda dengan keterampilan yang diperlukan tetapi juga menempatkan Anda di garis depan jalur karier yang menguntungkan dan banyak diminati. Daftar hari ini dan ubah aspirasi Anda menjadi kenyataan!

Abi Ali Awan (@1abidaliawan) adalah ilmuwan data profesional bersertifikat yang suka membuat model pembelajaran mesin. Saat ini, ia berfokus pada pembuatan konten dan penulisan blog teknis tentang pembelajaran mesin dan teknologi ilmu data. Abid memiliki gelar Magister Manajemen Teknologi dan gelar Sarjana Teknik Telekomunikasi. Visinya adalah untuk membangun produk AI menggunakan jaringan saraf grafik untuk siswa yang berjuang dengan penyakit mental.

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- PlatoData.Jaringan Vertikal Generatif Ai. Berdayakan Diri Anda. Akses Di Sini.

- PlatoAiStream. Intelijen Web3. Pengetahuan Diperkuat. Akses Di Sini.

- PlatoESG. Karbon, teknologi bersih, energi, Lingkungan Hidup, Tenaga surya, Penanganan limbah. Akses Di Sini.

- PlatoHealth. Kecerdasan Uji Coba Biotek dan Klinis. Akses Di Sini.

- Sumber: https://www.kdnuggets.com/the-only-free-course-you-need-to-become-a-professional-data-engineer?utm_source=rss&utm_medium=rss&utm_campaign=the-only-free-course-you-need-to-become-a-professional-data-engineer

- :memiliki

- :adalah

- :bukan

- :Di mana

- $NAIK

- 000

- 1

- 15%

- 17

- 2024

- a

- Sanggup

- Tentang Kami

- aktif

- Selain itu

- menangani

- maju

- maju

- Setelah

- AI

- Semua

- sepanjang

- juga

- menakjubkan

- an

- analisis

- Analytical

- analisis

- dan

- dan infrastruktur

- Apache

- Apache Spark

- api

- Lebah

- aplikasi

- arsitek

- ADALAH

- Seni

- AS

- At

- tersedia

- Dasar-dasar

- BE

- menjadi

- menjadi

- Pemula

- bermanfaat

- TERBAIK

- Praktik Terbaik

- permintaan besar

- Campuran

- blog

- kedua

- membangun

- Bangunan

- tapi

- by

- Lowongan Kerja

- karir

- Tersertifikasi

- awan

- Cloud Storage

- kekelompokan

- kode

- Pengkodean

- Kelompok

- masyarakat

- Perusahaan

- menyelesaikan

- luas

- konsep

- menyimpulkan

- konfigurasi

- Anak sungai

- Terhubung

- dianggap

- Terdiri dari

- membangun

- Konsumen

- mengandung

- Konten

- pembuatan konten

- Tentu saja

- Pelatihan

- meliputi

- membuat

- membuat

- penciptaan

- sangat penting

- Sekarang

- Kurikulum

- dasbor

- data

- insinyur data

- Danau Data

- ilmu data

- ilmuwan data

- penyimpanan data

- data warehouse

- Tanggal

- Derajat

- penyebaran

- dirancang

- merancang

- terperinci

- sulit

- Buruh pelabuhan

- setiap

- efektif

- efisien

- antara

- memberdayakan

- aktif

- akhir

- ujung ke ujung

- insinyur

- Teknik

- Insinyur

- mendaftarkan

- Memastikan

- Lingkungan Hidup

- lingkungan

- penting

- Eter (ETH)

- segala sesuatu

- contoh

- menarik

- ada

- pengalaman

- ahli

- eksplorasi

- Menjelajahi

- Meluas

- Fitur

- Fitur

- Menampilkan

- beberapa

- bidang

- File

- Akhirnya

- Pertama

- Fokus

- berfokus

- berfokus

- diikuti

- Untuk

- garis terdepan

- Dasar

- Kerangka

- Gratis

- dari

- fungsi

- Fundamental

- celah

- GCP

- diberikan

- Google Cloud

- grafik

- Jaringan Saraf Grafik

- kendali

- hands-on

- Memiliki

- he

- menyoroti

- -nya

- memegang

- holistik

- pekerjaan rumah

- kait

- Namun

- HTTPS

- Hibrida

- Penyesuaian Hyperparameter

- penyakit

- melaksanakan

- in

- secara mendalam

- termasuk

- Termasuk

- inkremental

- industri

- Infrastruktur

- inovatif

- instalasi

- instruksi

- Mengintegrasikan

- integrasi

- ke

- diperkenalkan

- Memperkenalkan

- memperkenalkan

- Pengantar

- perkenalan

- melibatkan

- IT

- NYA

- Januari

- Bergabung

- kafka

- KDnugget

- kunci

- danau

- terkemuka

- BELAJAR

- belajar

- pelajar

- pengetahuan

- 'like'

- baris

- linux

- pemuatan

- lokal

- mencari

- mencintai

- Rendah

- menguntungkan

- mesin

- Mesin belajar

- macos

- mengelola

- pengelolaan

- wajib

- banyak

- menguasai

- Menguasai

- bahan

- mental yang

- Penyakit kejiwaan

- ML

- model

- pemodelan

- model

- modern

- modul

- Modul

- lebih

- beberapa

- perlu

- Perlu

- dibutuhkan

- kebutuhan

- jaringan

- jaringan

- saraf

- saraf jaringan

- tujuan

- of

- menawarkan

- Penawaran

- on

- hanya

- open source

- Operasi

- or

- teknik mengatur musik

- Lainnya

- kami

- Naik haji

- khususnya

- path

- Membayar

- buah pir

- melakukan

- pipa saluran

- Platform

- plato

- Kecerdasan Data Plato

- Data Plato

- Bermain

- posisi

- Postgresql

- Praktis

- Aplikasi Praktis

- praktek

- praktek

- mempersiapkan

- menyajikan

- proses

- diproses

- pengolahan

- Produsen

- Produk

- profesional

- profesional

- maju

- proyek

- memprojeksikan

- menyediakan

- menyediakan

- Ular sanca

- Pertanyaan

- meningkatkan

- Bacaan

- dunia nyata

- Kenyataan

- Sumber

- Peran

- peran

- berjalan

- s

- gaji

- Scala

- Ilmu

- ilmuwan

- ilmuwan

- pencarian

- memilih

- senior

- pengaturan

- penyiapan

- keterampilan

- kendur

- larutan

- beberapa

- kadang-kadang

- mutakhir

- percikan

- khusus

- SQL

- awal

- Mulai

- penyimpanan

- aliran

- Streaming

- stream

- tersusun

- Berjuang

- Siswa

- studio

- besar

- seperti itu

- mendukung

- Beralih

- sistem

- disesuaikan

- Bakat

- tugas

- tech

- Teknis

- teknik

- Teknologi

- Teknologi

- telekomunikasi

- Terraform

- pengujian

- bahwa

- Grafik

- Dasar-dasar

- kemudian

- ini

- Melalui

- untuk

- hari ini

- alat

- alat

- Topik

- Pelatihan

- Mentransfer

- Mengubah

- Transformasi

- transformatif

- berubah

- mengubah

- tutorial

- dua

- pemahaman

- USD

- menggunakan

- Pengguna

- menggunakan

- Ve

- sangat

- melalui

- Video

- penglihatan

- visual

- vs

- Gudang

- Pergudangan

- we

- Apa

- yang

- SIAPA

- akan

- Windows

- dengan

- alur kerja

- Alur kerja

- bengkel

- Lokakarya

- penulisan

- kamu

- Anda

- zephyrnet.dll