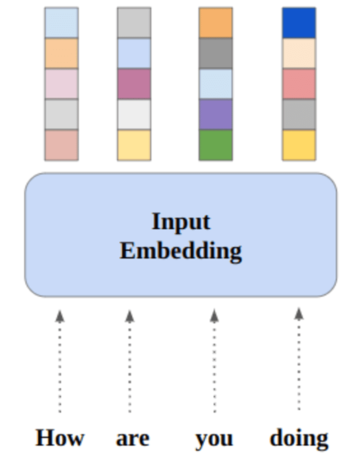

Gambar oleh Penulis

Dalam postingan ini, kita akan menjelajahi model sumber terbuka canggih baru yang disebut Mixtral 8x7b. Kita juga akan mempelajari cara mengaksesnya menggunakan pustaka LLaMA C++ dan cara menjalankan model bahasa besar dengan komputasi dan memori yang lebih sedikit.

Campuran 8x7b adalah model campuran ahli (SMoE) berkualitas tinggi dengan bobot terbuka, yang dibuat oleh Mistral AI. Ini dilisensikan di bawah Apache 2.0 dan mengungguli Llama 2 70B di sebagian besar benchmark sekaligus memiliki inferensi 6x lebih cepat. Mixtral cocok atau mengalahkan GPT3.5 pada sebagian besar tolok ukur standar dan merupakan model bobot terbuka terbaik dalam hal biaya/kinerja.

Gambar dari Campuran para ahli

Mixtral 8x7B menggunakan jaringan campuran ahli yang jarang hanya untuk dekoder. Ini melibatkan pemilihan blok feedforward dari 8 grup parameter, dengan jaringan router memilih dua grup ini untuk setiap token, menggabungkan outputnya secara aditif. Metode ini meningkatkan jumlah parameter model sekaligus mengelola biaya dan latensi, menjadikannya seefisien model 12.9 miliar, meskipun memiliki total parameter 46.7 miliar.

Model Mixtral 8x7B unggul dalam menangani konteks luas 32 ribu token dan mendukung berbagai bahasa, termasuk Inggris, Prancis, Italia, Jerman, dan Spanyol. Ini menunjukkan kinerja yang kuat dalam pembuatan kode dan dapat disesuaikan menjadi model mengikuti instruksi, mencapai skor tinggi pada benchmark seperti MT-Bench.

LLaMA.cpp adalah pustaka C/C++ yang menyediakan antarmuka berkinerja tinggi untuk model bahasa besar (LLM) berdasarkan arsitektur LLM Facebook. Ini adalah perpustakaan ringan dan efisien yang dapat digunakan untuk berbagai tugas, termasuk pembuatan teks, terjemahan, dan menjawab pertanyaan. LLaMA.cpp mendukung berbagai LLM, termasuk LLaMA, LLaMA 2, Falcon, Alpaca, Mistral 7B, Mixtral 8x7B, dan GPT4ALL. Ini kompatibel dengan semua sistem operasi dan dapat berfungsi pada CPU dan GPU.

Di bagian ini, kita akan menjalankan aplikasi web llama.cpp di Colab. Dengan menulis beberapa baris kode, Anda akan dapat merasakan performa model canggih baru di PC atau di Google Colab.

Mulai

Pertama, kita akan mengunduh repositori GitHub llama.cpp menggunakan baris perintah di bawah ini:

!git clone --depth 1 https://github.com/ggerganov/llama.cpp.gitSetelah itu, kita akan mengubah direktori ke dalam repositori dan menginstal llama.cpp menggunakan perintah `make`. Kami memasang llama.cpp untuk GPU NVidia dengan CUDA terpasang.

%cd llama.cpp

!make LLAMA_CUBLAS=1Unduh Modelnya

Kita dapat mendownload model dari Hugging Face Hub dengan memilih versi file model `.gguf` yang sesuai. Informasi lebih lanjut tentang berbagai versi dapat ditemukan di TheBloke/Mixtral-8x7B-Instruksikan-v0.1-GGUF.

Gambar dari TheBloke/Mixtral-8x7B-Instruksikan-v0.1-GGUF

Anda dapat menggunakan perintah `wget` untuk mengunduh model di direktori saat ini.

!wget https://huggingface.co/TheBloke/Mixtral-8x7B-Instruct-v0.1-GGUF/resolve/main/mixtral-8x7b-instruct-v0.1.Q2_K.ggufAlamat Eksternal untuk Server LLaMA

Saat kita menjalankan server LLaMA, ini akan memberi kita IP localhost yang tidak berguna bagi kita di Colab. Kita memerlukan koneksi ke proxy localhost dengan menggunakan port proxy kernel Colab.

Setelah menjalankan kode di bawah ini, Anda akan mendapatkan hyperlink global. Kami akan menggunakan tautan ini untuk mengakses aplikasi web kami nanti.

from google.colab.output import eval_js

print(eval_js("google.colab.kernel.proxyPort(6589)"))

https://8fx1nbkv1c8-496ff2e9c6d22116-6589-colab.googleusercontent.com/Menjalankan Server

Untuk menjalankan server LLaMA C++, Anda perlu memberikan perintah server dengan lokasi file model dan nomor port yang benar. Penting untuk memastikan bahwa nomor port cocok dengan yang kita mulai pada langkah sebelumnya untuk port proxy.

%cd /content/llama.cpp

!./server -m mixtral-8x7b-instruct-v0.1.Q2_K.gguf -ngl 27 -c 2048 --port 6589

Aplikasi web obrolan dapat diakses dengan mengklik hyperlink port proxy pada langkah sebelumnya karena server tidak berjalan secara lokal.

Aplikasi Web LLaMA C++

Sebelum kita mulai menggunakan chatbot, kita perlu menyesuaikannya. Ganti “LLaMA” dengan nama model Anda di bagian prompt. Selain itu, ubah nama pengguna dan nama bot untuk membedakan respons yang dihasilkan.

Mulailah mengobrol dengan menggulir ke bawah dan mengetik di bagian obrolan. Jangan ragu untuk mengajukan pertanyaan teknis yang gagal dijawab dengan benar oleh model sumber terbuka lainnya.

Jika Anda mengalami masalah dengan aplikasi, Anda dapat mencoba menjalankannya sendiri menggunakan Google Colab saya: https://colab.research.google.com/drive/1gQ1lpSH-BhbKN-DdBmq5r8-8Rw8q1p9r?usp=sharing

Tutorial ini memberikan panduan komprehensif tentang cara menjalankan model sumber terbuka tingkat lanjut, Mixtral 8x7b, di Google Colab menggunakan pustaka LLaMA C++. Dibandingkan dengan model lainnya, Mixtral 8x7b memberikan kinerja dan efisiensi yang unggul, menjadikannya solusi terbaik bagi mereka yang ingin bereksperimen dengan model bahasa besar namun tidak memiliki sumber daya komputasi yang luas. Anda dapat dengan mudah menjalankannya di laptop atau di komputasi awan gratis. Ini mudah digunakan, dan Anda bahkan dapat menyebarkan aplikasi obrolan Anda agar orang lain dapat menggunakan dan bereksperimen.

Saya harap solusi sederhana untuk menjalankan model besar ini bermanfaat bagi Anda. Saya selalu mencari opsi yang sederhana dan lebih baik. Jika Anda memiliki solusi yang lebih baik lagi, beri tahu saya, dan saya akan membahasnya lain kali.

Abi Ali Awan (@1abidaliawan) adalah ilmuwan data profesional bersertifikat yang suka membuat model pembelajaran mesin. Saat ini, ia berfokus pada pembuatan konten dan penulisan blog teknis tentang pembelajaran mesin dan teknologi ilmu data. Abid memiliki gelar Magister Manajemen Teknologi dan gelar Sarjana Teknik Telekomunikasi. Visinya adalah untuk membangun produk AI menggunakan jaringan saraf grafik untuk siswa yang berjuang dengan penyakit mental.

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- PlatoData.Jaringan Vertikal Generatif Ai. Berdayakan Diri Anda. Akses Di Sini.

- PlatoAiStream. Intelijen Web3. Pengetahuan Diperkuat. Akses Di Sini.

- PlatoESG. Karbon, teknologi bersih, energi, Lingkungan Hidup, Tenaga surya, Penanganan limbah. Akses Di Sini.

- PlatoHealth. Kecerdasan Uji Coba Biotek dan Klinis. Akses Di Sini.

- Sumber: https://www.kdnuggets.com/running-mixtral-8x7b-on-google-colab-for-free?utm_source=rss&utm_medium=rss&utm_campaign=running-mixtral-8x7b-on-google-colab-for-free

- :adalah

- :bukan

- 1

- 12

- 27

- 46

- 7

- 8

- a

- Sanggup

- mengakses

- diakses

- mencapai

- Selain itu

- alamat

- maju

- AI

- Semua

- juga

- selalu

- am

- an

- dan

- menjawab

- Apache

- aplikasi

- Aplikasi

- sesuai

- arsitektur

- ADALAH

- AS

- meminta

- berdasarkan

- BE

- mulai

- di bawah

- Benchmark

- TERBAIK

- Lebih baik

- antara

- Memblokir

- blog

- Bot

- kedua

- membangun

- Bangunan

- tapi

- by

- C + +

- bernama

- CAN

- Tersertifikasi

- perubahan

- mengobrol

- ChatBot

- mengobrol

- memilih

- awan

- kode

- menggabungkan

- dibandingkan

- cocok

- luas

- komputasi

- menghitung

- komputasi

- koneksi

- Konten

- pembuatan konten

- konteks

- benar

- Biaya

- menutupi

- dibuat

- penciptaan

- terbaru

- Sekarang

- menyesuaikan

- data

- ilmu data

- ilmuwan data

- Derajat

- memberikan

- menunjukkan

- menyebarkan

- Meskipun

- membedakan

- do

- turun

- Download

- setiap

- mudah

- efisiensi

- efisien

- pertemuan

- Teknik

- Inggris

- Meningkatkan

- Bahkan

- unggul

- pengalaman

- eksperimen

- ahli

- menyelidiki

- luas

- Menghadapi

- Gagal

- elang

- lebih cepat

- merasa

- beberapa

- File

- berfokus

- Untuk

- ditemukan

- Gratis

- Perancis

- dari

- fungsi

- dihasilkan

- generasi

- Jerman

- mendapatkan

- GitHub

- Memberikan

- Aksi

- GPU

- GPU

- grafik

- Jaringan Saraf Grafik

- Grup

- membimbing

- Penanganan

- Memiliki

- memiliki

- he

- bermanfaat

- High

- kinerja tinggi

- berkualitas tinggi

- -nya

- memegang

- berharap

- Seterpercayaapakah Olymp Trade? Kesimpulan

- How To

- HTTPS

- Pusat

- i

- if

- penyakit

- mengimpor

- penting

- in

- Termasuk

- informasi

- dimulai

- install

- Instalasi

- Antarmuka

- ke

- melibatkan

- IP

- masalah

- IT

- Italia

- KDnugget

- Tahu

- bahasa

- Bahasa

- laptop

- besar

- Latensi

- kemudian

- BELAJAR

- pengetahuan

- membiarkan

- Perpustakaan

- Izin

- ringan

- 'like'

- baris

- baris

- LINK

- Llama

- lokal

- tempat

- mencari

- mencintai

- mesin

- Mesin belajar

- membuat

- Membuat

- pengelolaan

- pelaksana

- menguasai

- korek api

- me

- Memori

- mental yang

- Penyakit kejiwaan

- metode

- campuran

- model

- model

- memodifikasi

- lebih

- paling

- beberapa

- my

- nama

- Perlu

- jaringan

- saraf

- saraf jaringan

- New

- berikutnya

- jumlah

- Nvidia

- of

- on

- ONE

- Buka

- open source

- operasi

- sistem operasi

- Opsi

- or

- Lainnya

- Lainnya

- kami

- Mengungguli

- keluaran

- output

- sendiri

- parameter

- parameter

- PC

- prestasi

- plato

- Kecerdasan Data Plato

- Data Plato

- silahkan

- Pos

- sebelumnya

- Produk

- profesional

- tepat

- memberikan

- menyediakan

- wakil

- pertanyaan

- Pertanyaan

- jarak

- mengurangi

- mengenai

- menggantikan

- gudang

- penelitian

- Sumber

- tanggapan

- router

- Run

- berjalan

- s

- Ilmu

- ilmuwan

- skor

- bergulir

- Bagian

- memilih

- Server

- Sederhana

- sejak

- larutan

- sumber

- Spanyol

- standar

- state-of-the-art

- Langkah

- kuat

- Berjuang

- Siswa

- unggul

- Mendukung

- yakin

- sistem

- tugas

- Teknis

- Teknologi

- Teknologi

- telekomunikasi

- teks

- pembuatan teks

- bahwa

- Grafik

- mereka

- Ini

- ini

- itu

- waktu

- untuk

- token

- Token

- Total

- Terjemahan

- mencoba

- tutorial

- dua

- bawah

- us

- menggunakan

- bekas

- Pengguna

- user-friendly

- kegunaan

- menggunakan

- variasi

- berbagai

- versi

- penglihatan

- ingin

- we

- jaringan

- aplikasi web

- yang

- sementara

- SIAPA

- lebar

- Rentang luas

- akan

- dengan

- penulisan

- kamu

- Anda

- zephyrnet.dll