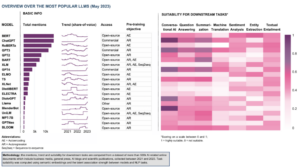

Dalam bidang kecerdasan buatan yang berkembang pesat, pemrosesan bahasa alami telah menjadi titik fokus bagi para peneliti dan pengembang. Membangun di atas dasar dari Arsitektur transformator dan Peningkatan dua arah BERT, beberapa model bahasa terobosan telah muncul dalam beberapa tahun terakhir, mendorong batasan dari apa yang dapat dipahami dan dihasilkan oleh mesin.

Pada artikel ini, kita akan mempelajari kemajuan terbaru dalam dunia model bahasa berskala besar, mengeksplorasi peningkatan yang diperkenalkan oleh masing-masing model, kemampuannya, dan potensi aplikasinya. Kita juga akan melihat Model Bahasa Visual (VLM) yang dilatih untuk memproses tidak hanya data tekstual tetapi juga data visual.

Jika Anda ingin melewatkannya, berikut adalah model bahasa yang kami tampilkan:

- GPT-3 oleh OpenAI

- LaMDA oleh Google

- PaLM oleh Google

- Flamingo oleh DeepMind

- BLIP-2 oleh Salesforce

- LLaMA oleh Meta AI

- GPT-4 oleh OpenAI

Jika konten pendidikan yang mendalam ini bermanfaat bagi Anda, Anda bisa berlangganan milis penelitian AI kami untuk diperingatkan ketika kami merilis materi baru.

Model Bahasa Besar Terpenting (LLM) dan Model Bahasa Visual (VLM) pada tahun 2023

1. GPT-3 oleh OpenAI

Kesimpulan

Tim OpenAI memperkenalkan GPT-3 sebagai alternatif untuk memiliki kumpulan data berlabel untuk setiap tugas bahasa baru. Mereka menyarankan bahwa meningkatkan model bahasa dapat meningkatkan kinerja beberapa tembakan tugas-agnostik. Untuk menguji saran ini, mereka melatih model bahasa autoregresif parameter 175B, yang disebut GPT-3, dan mengevaluasi kinerjanya pada lebih dari dua lusin tugas NLP. Evaluasi di bawah pembelajaran beberapa tembakan, pembelajaran satu tembakan, dan pembelajaran tanpa tembakan menunjukkan bahwa GPT-3 mencapai hasil yang menjanjikan dan bahkan terkadang mengungguli hasil canggih yang dicapai oleh model yang disesuaikan.

Apa tujuannya?

- Untuk menyarankan solusi alternatif untuk masalah yang ada, ketika kumpulan data berlabel diperlukan untuk setiap tugas bahasa baru.

Bagaimana pendekatan masalahnya?

- Para peneliti menyarankan peningkatan model bahasa untuk meningkatkan kinerja beberapa tembakan tugas-agnostik.

- Grafik GPT-3 model menggunakan model dan arsitektur yang sama dengan GPT-2, termasuk inisialisasi yang dimodifikasi, pra-normalisasi, dan tokenisasi yang dapat dibalik.

- Namun, berbeda dengan GPT-2, ia menggunakan pola perhatian jarang padat dan pita lokal bergantian pada lapisan transformator, seperti pada Transformator Jarang.

Apa hasilnya?

- Model GPT-3 tanpa fine-tuning mencapai hasil yang menjanjikan pada sejumlah tugas NLP, dan bahkan terkadang melampaui model state-of-the-art yang telah disesuaikan untuk tugas spesifik tersebut:

- pada CoQA benchmark, 81.5 F1 dalam pengaturan zero-shot, 84.0 F1 dalam pengaturan one-shot, dan 85.0 F1 dalam pengaturan few-shot, dibandingkan dengan skor 90.7 F1 yang dicapai oleh SOTA yang disesuaikan dengan baik.

- pada TriviaQA benchmark, akurasi 64.3% dalam pengaturan zero-shot, 68.0% dalam pengaturan one-shot, dan 71.2% dalam pengaturan few-shot, melampaui keadaan seni (68%) sebesar 3.2%.

- pada LAMBADA dataset, akurasi 76.2% dalam pengaturan zero-shot, 72.5% dalam pengaturan one-shot, dan 86.4% dalam pengaturan few-shot, melampaui state of the art (68%) sebesar 18%.

- Artikel berita yang dihasilkan oleh model GPT-175 dengan parameter 3B sulit dibedakan dari yang asli, menurut evaluasi manusia (dengan akurasi hampir di atas tingkat kemungkinan di ~ 52%).

- Terlepas dari kinerja GPT-3 yang luar biasa, ia mendapat ulasan beragam dari komunitas AI:

- “Hype GPT-3 terlalu berlebihan. Ini mengesankan (terima kasih atas pujian yang bagus!) Tetapi masih memiliki kelemahan serius dan terkadang membuat kesalahan yang sangat konyol. AI akan mengubah dunia, tetapi GPT-3 hanyalah tampilan yang sangat awal. Masih banyak yang harus kita pikirkan. " - Sam Altman, CEO dan salah satu pendiri OpenAI.

- “Saya terkejut betapa sulitnya menghasilkan teks tentang Muslim dari GPT-3 yang tidak ada hubungannya dengan kekerasan… atau dibunuh…” - Abubakar Abid, CEO dan pendiri Gradio.

- "Tidak. GPT-3 pada dasarnya tidak memahami dunia yang dibicarakannya. Meningkatkan korpus lebih lanjut akan memungkinkannya menghasilkan bunga rampai yang lebih kredibel tetapi tidak memperbaiki kurangnya pemahaman mendasar tentang dunia. Demo GPT-4 masih membutuhkan pengambilan ceri manusia. " - Gary Marcus, CEO dan pendiri Robust.ai.

- “Mengekstrapolasi kinerja spektakuler GPT3 ke masa depan menunjukkan bahwa jawaban atas kehidupan, alam semesta, dan segalanya hanyalah 4.398 triliun parameter.” - Geoffrey Hinton, pemenang Turing Award.

Di mana mempelajari lebih lanjut tentang penelitian ini?

Di mana Anda bisa mendapatkan kode implementasi?

- Kode itu sendiri tidak tersedia, tetapi beberapa statistik set data bersama dengan sampel token 2048 tanpa syarat dan tanpa filter dari GPT-3 dirilis pada GitHub.

2. LaMDA oleh Google

Kesimpulan

Labahasa Model untuk Danalog Aaplikasi (MDA) dibuat melalui proses penyempurnaan sekelompok model bahasa neural berbasis Transformer yang dirancang khusus untuk dialog. Model ini memiliki maksimal 137B parameter dan dilatih untuk menggunakan sumber pengetahuan eksternal. Pengembang LaMDA memiliki tiga tujuan utama – kualitas, keamanan, dan landasan. Hasil menunjukkan bahwa fine-tuning memungkinkan penyempitan kesenjangan kualitas ke tingkat manusia, namun kinerja model tetap di bawah tingkat manusia sehubungan dengan keamanan dan groundedness.

Penyair Google, dirilis baru-baru ini sebagai alternatif untuk ChatGPT, didukung oleh LaMDA. Meskipun Bard sering dicap sebagai membosankan, ini bisa dilihat sebagai bukti komitmen Google untuk mengutamakan keselamatan, bahkan di tengah persaingan ketat antara Google dan Microsoft untuk membangun dominasi di bidang AI generatif.

Apa tujuannya?

- Untuk membangun model untuk aplikasi dialog domain terbuka, di mana agen dialog dapat berkomunikasi tentang topik apa pun dengan respons yang masuk akal, spesifik untuk konteksnya, didasarkan pada sumber yang dapat dipercaya, dan etis.

Bagaimana pendekatan masalahnya?

- LaMDA dibangun di atas Transformator, arsitektur jaringan neural yang diciptakan dan dijadikan sumber terbuka oleh Google Research pada tahun 2017.

- Seperti model bahasa besar lainnya, termasuk BERT dan GPT-3, LaMDA dilatih pada terabyte data teks untuk mempelajari bagaimana kata-kata berhubungan satu sama lain dan kemudian memprediksi kata apa yang akan muncul selanjutnya.

- Namun, tidak seperti kebanyakan model bahasa, LaMDA dilatih tentang dialog untuk memahami nuansa yang membedakan percakapan terbuka dari bentuk bahasa lainnya.

- Model ini juga disesuaikan untuk meningkatkan kepekaan, keamanan, dan kekhususan tanggapannya. Sementara frase seperti "itu bagus" dan "Saya tidak tahu" bisa berarti dalam banyak skenario dialog, mereka tidak akan mengarah pada percakapan yang menarik dan menarik.

- Generator LaMDA pertama-tama menghasilkan beberapa respons kandidat, yang semuanya diberi skor berdasarkan seberapa aman, masuk akal, spesifik, dan menarik respons tersebut. Respons dengan skor keamanan rendah disaring, lalu hasil peringkat teratas dipilih sebagai respons.

Apa hasilnya?

- Sejumlah eksperimen menunjukkan bahwa LaMDA dapat berpartisipasi dalam percakapan terbuka tentang berbagai topik.

- Serangkaian evaluasi kualitatif menegaskan bahwa tanggapan model cenderung masuk akal, spesifik, menarik, dan didasarkan pada sumber eksternal yang dapat diandalkan, tetapi masih ada ruang untuk perbaikan.

- Terlepas dari semua kemajuan yang dicapai sejauh ini, penulis menyadari bahwa model tersebut masih memiliki banyak keterbatasan yang dapat menghasilkan tanggapan yang tidak sesuai atau bahkan berbahaya.

Di mana mempelajari lebih lanjut tentang penelitian ini?

Di mana Anda bisa mendapatkan kode implementasi?

- Implementasi PyTorch open-source untuk arsitektur pra-pelatihan LaMDA tersedia di GitHub.

3. Palm oleh Google

Kesimpulan

Pabegitu saja Lpenderitaan Model (Telapak) adalah parameter 540 miliar, model bahasa berbasis Transformer. PaLM dilatih pada chip 6144 TPU v4 menggunakan Pathways, sistem ML baru untuk pelatihan yang efisien di beberapa TPU Pod. Model ini menunjukkan manfaat penskalaan dalam pembelajaran beberapa langkah, mencapai hasil canggih pada ratusan pemahaman bahasa dan tolok ukur generasi. PaLM mengungguli model canggih yang disempurnakan pada tugas penalaran multi-langkah dan melebihi rata-rata kinerja manusia pada tolok ukur BIG-bench.

Apa tujuannya?

- Untuk meningkatkan pemahaman tentang bagaimana penskalaan model bahasa besar memengaruhi pembelajaran beberapa langkah.

Bagaimana pendekatan masalahnya?

- Ide utamanya adalah untuk menskalakan pelatihan model bahasa parameter 540 miliar dengan sistem Pathways:

- Tim menggunakan paralelisme data di tingkat Pod di dua Pod Cloud TPU v4 sambil menggunakan data standar dan paralelisme model dalam setiap Pod.

- Mereka mampu menskalakan pelatihan hingga 6144 chip TPU v4, konfigurasi sistem berbasis TPU terbesar yang digunakan untuk pelatihan hingga saat ini.

- Model tersebut mencapai efisiensi pelatihan 57.8% pemanfaatan FLOP perangkat keras, yang menurut penulis, adalah efisiensi pelatihan tertinggi yang pernah dicapai untuk model bahasa besar pada skala ini.

- Data pelatihan untuk model PaLM mencakup kombinasi set data bahasa Inggris dan multibahasa yang berisi dokumen web berkualitas tinggi, buku, Wikipedia, percakapan, dan kode GitHub.

Apa hasilnya?

- Sejumlah eksperimen menunjukkan bahwa kinerja model meningkat tajam saat tim menskalakan ke model terbesar mereka.

- PaLM 540B mencapai kinerja terobosan pada beberapa tugas yang sangat sulit:

- Pemahaman bahasa dan generasi. Model yang diperkenalkan melampaui kinerja beberapa tembakan dari model besar sebelumnya pada 28 dari 29 tugas yang mencakup tugas menjawab pertanyaan, tugas penutupan dan penyelesaian kalimat, tugas pemahaman membaca dalam konteks, tugas penalaran akal sehat, tugas SuperGLUE, dan lagi. Performa PaLM pada tugas bangku BESAR menunjukkan bahwa PaLM dapat membedakan sebab dan akibat, serta memahami kombinasi konseptual dalam konteks yang sesuai.

- Pemikiran. Dengan dorongan 8-shot, PaLM memecahkan 58% masalah di GSM8K, tolok ukur dari ribuan pertanyaan matematika tingkat sekolah dasar yang menantang, mengungguli skor teratas sebelumnya sebesar 55% yang dicapai dengan menyempurnakan model GPT-3 175B. PaLM juga menunjukkan kemampuan untuk menghasilkan penjelasan eksplisit dalam situasi yang memerlukan kombinasi kompleks dari inferensi logis multi-langkah, pengetahuan dunia, dan pemahaman bahasa yang mendalam.

- Pembuatan kode. PaLM bekerja setara dengan Codex 12B yang disempurnakan dengan menggunakan 50 kali lebih sedikit kode Python untuk pelatihan, memastikan bahwa model bahasa besar mentransfer pembelajaran dari bahasa pemrograman lain dan data bahasa alami secara lebih efektif.

Di mana mempelajari lebih lanjut tentang penelitian ini?

Di mana Anda bisa mendapatkan kode implementasi?

- Implementasi PyTorch tidak resmi dari arsitektur Transformer spesifik dari makalah penelitian PaLM tersedia di GitHub. Itu tidak akan berskala dan diterbitkan hanya untuk tujuan pendidikan.

4. Flamingo oleh DeepMind

Kesimpulan

Flamingo adalah keluarga Model Bahasa Visual (VLM) mutakhir, dilatih pada korpora web multimoda skala besar dengan campuran teks dan gambar. Dengan pelatihan ini, model dapat beradaptasi dengan tugas baru menggunakan contoh beranotasi minimal, yang disediakan sebagai prompt. Flamingo menggabungkan kemajuan arsitektur utama yang dirancang untuk menggabungkan kekuatan model hanya-visi dan hanya-bahasa yang telah dilatih sebelumnya, urutan proses dari data visual dan tekstual yang disisipkan secara bervariasi, dan mengakomodasi gambar atau video sebagai input dengan mulus. Model menunjukkan kemampuan beradaptasi yang mengesankan untuk berbagai tugas gambar dan video seperti menjawab pertanyaan visual, tugas memberi teks, dan menjawab pertanyaan visual pilihan ganda, menetapkan standar kinerja baru menggunakan petunjuk khusus tugas dalam pembelajaran beberapa gambar.

Apa tujuannya?

- Untuk membuat kemajuan dalam mengaktifkan model multimoda untuk mempelajari dan melakukan tugas baru dengan cepat berdasarkan instruksi singkat:

- Paradigma pra-pelatihan model yang banyak digunakan pada sejumlah besar data yang diawasi, kemudian menyempurnakannya untuk tugas tertentu, intensif sumber daya dan memerlukan ribuan titik data beranotasi bersama dengan penyetelan hyperparameter per tugas yang cermat.

- Model saat ini yang menggunakan tujuan kontrastif memungkinkan adaptasi zero-shot untuk tugas-tugas baru tetapi gagal pada tugas-tugas yang lebih terbuka seperti memberi teks atau menjawab pertanyaan visual karena mereka tidak memiliki kemampuan menghasilkan bahasa.

- Penelitian ini bertujuan untuk memperkenalkan model baru yang secara efektif mengatasi masalah ini dan menunjukkan kinerja yang unggul dalam rezim data rendah.

Bagaimana pendekatan masalahnya?

- DeepMind memperkenalkan Flamingo, VLM yang dirancang untuk pembelajaran beberapa langkah pada berbagai tugas bahasa dan visi terbuka, hanya menggunakan beberapa contoh masukan/keluaran.

- Model Flamingo adalah model pembuatan teks autoregresif yang dikondisikan secara visual yang dapat memproses token teks yang dicampur dengan gambar dan/atau video dan menghasilkan teks sebagai keluaran.

- Arsitektur Flamingo menggabungkan dua model pra-terlatih dan beku yang saling melengkapi:

- Model visi yang mampu "memahami" pemandangan visual.

- Model bahasa besar yang bertugas melakukan penalaran dasar.

- Komponen arsitektur baru mengintegrasikan model-model ini dengan cara yang mempertahankan pengetahuan yang diperoleh selama pra-pelatihan intensif komputasi mereka.

- Selain itu, model Flamingo menampilkan arsitektur berbasis Perceiver, yang memungkinkannya menyerap gambar atau video beresolusi tinggi. Arsitektur ini dapat menghasilkan token visual dalam jumlah tetap per gambar/video dari berbagai fitur input visual yang luas dan bervariasi.

Apa hasilnya?

- Penelitian menunjukkan bahwa mirip dengan LLM, yang merupakan pembelajar dengan beberapa langkah yang baik, VLM dapat belajar dari beberapa contoh masukan/keluaran untuk tugas pemahaman gambar dan video seperti klasifikasi, pemberian teks, atau menjawab pertanyaan.

- Flamingo menetapkan tolok ukur baru dalam pembelajaran beberapa tembakan, menunjukkan kinerja yang unggul pada berbagai 16 bahasa multimodal dan tugas pemahaman gambar/video.

- Untuk 6 dari 16 tugas ini, Flamingo melampaui kinerja canggih yang disempurnakan, meskipun hanya menggunakan 32 contoh khusus tugas – kira-kira 1000 kali lebih sedikit data pelatihan khusus tugas daripada model berkinerja terbaik saat ini.

Di mana mempelajari lebih lanjut tentang penelitian ini?

Di mana Anda bisa mendapatkan kode implementasi?

- DeepMind tidak merilis implementasi resmi Flamingo.

- Anda mungkin menemukan implementasi open source dari pendekatan yang diperkenalkan di Buka Flamingo Github Repo.

- Implementasi PyTorch alternatif tersedia di sini.

5. BLIP-2 oleh Salesforce

Kesimpulan

BLIP-2 adalah kerangka kerja pra-pelatihan yang efisien dan generik untuk model visi dan bahasa, yang dirancang untuk menghindari biaya yang semakin mahal dari model skala besar pra-pelatihan. BLIP-2 memanfaatkan pembuat enkode gambar pra-terlatih beku siap pakai dan model bahasa besar beku untuk mem-bootstrap pra-pelatihan bahasa penglihatan, menggabungkan Querying Transformer ringan yang telah dilatih sebelumnya dalam dua tahap. Tahap pertama memulai pembelajaran representasi bahasa-visi dari pembuat enkode gambar yang dibekukan, dan tahap kedua mendorong pembelajaran generatif visi-ke-bahasa dari model bahasa yang dibekukan. Meskipun memiliki parameter yang dapat dilatih secara signifikan lebih sedikit, BLIP-2 mengungguli metode canggih, melampaui Flamingo80B DeepMind sebesar 8.7% pada VQAv2 zero-shot dengan parameter yang dapat dilatih 54x lebih sedikit. Model ini juga menunjukkan kemampuan pembuatan gambar-ke-teks zero-shot yang menjanjikan mengikuti instruksi bahasa alami.

Apa tujuannya?

- Untuk mendapatkan performa tercanggih pada tugas bahasa vision, sekaligus mengurangi biaya komputasi.

Bagaimana pendekatan masalahnya?

- Tim Salesforce memperkenalkan kerangka pra-pelatihan bahasa visi baru yang dijuluki BLIP-2, Bootstrapping Lbahasa-Ibijaksana Ppelatihan ulang dengan model unimodal beku:

- Model unimodal pra-pelatihan tetap dibekukan selama pra-pelatihan untuk mengurangi biaya perhitungan dan menghindari masalah lupa bencana.

- Untuk memfasilitasi penyelarasan lintas-modal dan menjembatani kesenjangan modalitas antara model visi pra-terlatih dan model bahasa pra-terlatih, tim mengusulkan Querying Transformer (Q-Former) ringan yang bertindak sebagai penghambat informasi antara pembuat enkode gambar beku dan gambar beku. LLM.

- Q-former dilatih sebelumnya dengan strategi dua tahap baru:

- Tahap pra-pelatihan pertama melakukan pembelajaran representasi bahasa-visi. Ini memaksa Q-Former untuk mempelajari representasi visual yang paling relevan dengan teks.

- Tahap pra-pelatihan kedua melakukan pembelajaran generatif visi-ke-bahasa dengan menghubungkan output Q-Former ke LLM yang dibekukan. Q-Former dilatih sedemikian rupa sehingga representasi visual keluarannya dapat ditafsirkan oleh LLM.

Apa hasilnya?

- BLIP-2 memberikan hasil yang luar biasa dan canggih di berbagai tugas bahasa visi, yang mencakup jawaban pertanyaan visual, keterangan gambar, dan pengambilan teks gambar.

- Misalnya, ini mengungguli Flamingo sebesar 8.7% pada VQAv2 zero-shot.

- Selain itu, kinerja luar biasa ini dicapai dengan efisiensi komputer yang jauh lebih tinggi:

- BLIP-2 mengungguli Flamingo-80B saat menggunakan parameter yang dapat dilatih 54× lebih sedikit.

- BLIP-2 memiliki kapasitas untuk melakukan pembuatan gambar-ke-teks zero-shot sebagai respons terhadap instruksi bahasa alami, sehingga membuka jalan untuk mengembangkan keterampilan seperti penalaran pengetahuan visual dan percakapan visual.

- Akhirnya, penting untuk dicatat bahwa BLIP-2 adalah pendekatan serbaguna yang dapat memanfaatkan model unimodal yang lebih canggih untuk lebih meningkatkan kinerja pra-pelatihan bahasa visi.

Di mana mempelajari lebih lanjut tentang penelitian ini?

Di mana Anda bisa mendapatkan kode implementasi?

Implementasi BLIP-2 resmi tersedia di GitHub.

6. LLaMA oleh Meta AI

Kesimpulan

Tim Meta AI menegaskan bahwa model yang lebih kecil yang dilatih dengan lebih banyak token lebih mudah untuk dilatih ulang dan disesuaikan untuk aplikasi produk tertentu. Oleh karena itu, mereka memperkenalkan Panggilan (Lsetuju Labahasa Model Meta AI), kumpulan model bahasa dasar dengan parameter 7B hingga 65B. LLaMA 33B dan 65B dilatih dengan 1.4 triliun token, sedangkan model terkecil, LLaMA 7B, dilatih dengan satu triliun token. Mereka secara eksklusif menggunakan kumpulan data yang tersedia untuk umum, tanpa bergantung pada data eksklusif atau terbatas. Tim juga menerapkan peningkatan arsitektur utama dan melatih teknik pengoptimalan kecepatan. Akibatnya, LLaMA-13B mengungguli GPT-3, lebih dari 10 kali lebih kecil, dan LLaMA-65B menunjukkan kinerja kompetitif dengan PaLM-540B.

Apa tujuannya?

- Untuk menunjukkan kelayakan pelatihan model berperforma terbaik hanya pada set data yang dapat diakses publik, tanpa bergantung pada sumber data eksklusif atau terbatas.

- Untuk menyediakan komunitas riset dengan model yang lebih kecil dan lebih berkinerja dan dengan demikian, memungkinkan mereka yang tidak memiliki akses ke infrastruktur dalam jumlah besar, untuk mempelajari model bahasa yang besar.

Bagaimana pendekatan masalahnya?

- Untuk melatih model LLaMA, peneliti hanya menggunakan data yang tersedia untuk umum, dan kompatibel dengan sumber terbuka.

- Mereka juga memperkenalkan beberapa peningkatan pada arsitektur Transformer standar:

- Mengadopsi metodologi GPT-3, stabilitas pelatihan ditingkatkan dengan menormalkan input untuk setiap sub-lapisan transformator, daripada menormalkan output.

- Terinspirasi oleh model PaLM, para peneliti mengganti non-linieritas ReLU dengan fungsi aktivasi SwiGLU, untuk meningkatkan kinerja.

- Terinspirasi oleh Su dkk (2021), mereka menghilangkan embedding posisi absolut dan sebagai gantinya, menggabungkan embedding posisi putar (RoPE) di setiap lapisan jaringan.

- Terakhir, tim Meta AI meningkatkan kecepatan pelatihan model mereka dengan:

- Menggunakan implementasi perhatian multi-kepala kausal yang efisien dengan tidak menyimpan bobot perhatian atau menghitung skor kunci/permintaan yang disamarkan.

- Menggunakan pos pemeriksaan untuk meminimalkan aktivasi yang dihitung ulang selama pass mundur.

- Tumpang tindih perhitungan aktivasi dan komunikasi antara GPU melalui jaringan (karena operasi all_reduce).

Apa hasilnya?

- LLaMA-13B melampaui GPT-3 meskipun lebih dari 10 kali lebih kecil, sementara LLaMA-65B bertahan melawan PaLM-540B.

Di mana mempelajari lebih lanjut tentang penelitian ini?

Di mana Anda bisa mendapatkan kode implementasi?

- Meta AI menyediakan akses ke LLaMA untuk peneliti akademik, individu yang terkait dengan pemerintah, masyarakat sipil, lembaga akademik, dan laboratorium penelitian industri global berdasarkan evaluasi kasus individu. Untuk melamar, buka yang berikut ini Repositori GitHub.

7. GPT-4 oleh OpenAI

Kesimpulan

GPT-4 adalah model multimodal berskala besar yang menerima input gambar dan teks serta menghasilkan output teks. Karena masalah persaingan dan keamanan, detail spesifik tentang arsitektur dan pelatihan model dirahasiakan. Dalam hal performa, GPT-4 mengungguli model bahasa sebelumnya pada tolok ukur tradisional dan menunjukkan peningkatan yang signifikan dalam pemahaman niat pengguna dan properti keselamatan. Model ini juga mencapai kinerja tingkat manusia pada berbagai ujian, termasuk skor 10% teratas pada Ujian Uniform Bar yang disimulasikan.

Apa tujuannya?

- Untuk mengembangkan model multimodal skala besar yang dapat menerima input gambar dan teks dan menghasilkan output teks.

- Untuk mengembangkan infrastruktur dan metode pengoptimalan yang berperilaku dapat diprediksi di berbagai skala.

Bagaimana pendekatan masalahnya?

- Karena lanskap kompetitif dan implikasi keamanan, OpenAI memutuskan untuk menyembunyikan detail tentang arsitektur, ukuran model, perangkat keras, komputasi pelatihan, konstruksi kumpulan data, dan metode pelatihan.

- Mereka mengungkapkan bahwa:

- GPT-4 adalah model berbasis Transformer, dilatih sebelumnya untuk memprediksi token berikutnya dalam sebuah dokumen.

- Ini menggunakan data yang tersedia untuk umum dan data berlisensi pihak ketiga.

- Model disempurnakan menggunakan Reinforcement Learning from Human Feedback (RLHF).

- Informasi yang belum dikonfirmasi menunjukkan bahwa GPT-4 bukanlah model padat tunggal seperti pendahulunya, tetapi sebuah koalisi pembangkit tenaga listrik dari delapan model terpisah, masing-masing mengemas 220 miliar parameter yang mengejutkan.

Apa hasilnya?

- GPT-4 mencapai kinerja tingkat manusia pada sebagian besar ujian profesional dan akademik, terutama mencetak 10% teratas pada Ujian Uniform Bar yang disimulasikan.

- Model GPT-4 dasar pra-pelatihan mengungguli model bahasa yang ada dan sistem canggih sebelumnya pada tolok ukur NLP tradisional, tanpa pembuatan khusus tolok ukur atau protokol pelatihan tambahan.

- GPT-4 menunjukkan peningkatan substansial dalam mengikuti maksud pengguna, dengan responsnya lebih disukai daripada respons GPT-3.5 dalam 70.2% dari 5,214 permintaan dari ChatGPT dan OpenAI API.

- Properti keamanan GPT-4 telah meningkat secara signifikan dibandingkan dengan GPT-3.5, dengan penurunan 82% dalam menanggapi permintaan konten yang tidak diizinkan dan peningkatan 29% dalam kepatuhan terhadap kebijakan untuk permintaan sensitif (misalnya nasihat medis dan tindakan menyakiti diri sendiri).

Di mana mempelajari lebih lanjut tentang penelitian ini?

Di mana Anda bisa mendapatkan kode implementasi?

- Implementasi kode GPT-4 tidak tersedia.

Aplikasi Dunia Nyata Model Bahasa Besar (Visi).

Terobosan penelitian AI paling signifikan dalam beberapa tahun terakhir datang dari model AI besar yang dilatih pada kumpulan data besar. Model-model ini menunjukkan kinerja yang mengesankan, dan menarik untuk memikirkan bagaimana AI dapat merevolusi seluruh industri, seperti layanan pelanggan, pemasaran, e-niaga, perawatan kesehatan, pengembangan perangkat lunak, jurnalisme, dan banyak lainnya.

Model bahasa besar memiliki banyak aplikasi dunia nyata. GPT-4 mencantumkan yang berikut ini:

- Pemahaman dan pembuatan bahasa alami untuk chatbots dan asisten virtual.

- Terjemahan mesin antar bahasa.

- Ringkasan artikel, laporan, atau dokumen teks lainnya.

- Analisis sentimen untuk riset pasar atau pemantauan media sosial.

- Pembuatan konten untuk pemasaran, media sosial, atau penulisan kreatif.

- Sistem penjawab pertanyaan untuk dukungan pelanggan atau basis pengetahuan.

- Klasifikasi teks untuk pemfilteran spam, kategorisasi topik, atau organisasi dokumen.

- Alat pembelajaran dan bimbingan bahasa yang dipersonalisasi.

- Pembuatan kode dan bantuan pengembangan perangkat lunak.

- Analisis dan bantuan dokumen medis, hukum, dan teknis.

- Alat aksesibilitas untuk penyandang disabilitas, seperti konversi teks ke ucapan dan konversi ucapan ke teks.

- Layanan pengenalan suara dan transkripsi.

Jika kita menambahkan bagian visual, area aplikasi yang mungkin akan diperluas lebih jauh:

Sangat menarik untuk mengikuti terobosan AI baru-baru ini dan memikirkan potensi penerapannya di dunia nyata. Namun, sebelum menerapkan model ini dalam kehidupan nyata, kami perlu mengatasi risiko dan batasan terkait, yang sayangnya cukup signifikan.

Risiko dan Keterbatasan

Jika Anda bertanya kepada GPT-4 tentang risiko dan batasannya, kemungkinan akan memberi Anda daftar panjang masalah yang relevan. Setelah memfilter daftar ini dan menambahkan beberapa pertimbangan tambahan, saya berakhir dengan serangkaian risiko dan batasan utama berikut yang dimiliki oleh model bahasa besar modern:

- Bias dan diskriminasi: Model-model ini belajar dari sejumlah besar data teks, yang sering mengandung konten bias dan diskriminatif. Akibatnya, keluaran yang dihasilkan dapat secara tidak sengaja melanggengkan stereotip, bahasa yang menyinggung, dan diskriminasi berdasarkan faktor seperti jenis kelamin, ras, atau agama.

- Keterangan yg salah: Model bahasa besar dapat menghasilkan konten yang secara faktual salah, menyesatkan, atau ketinggalan zaman. Sementara model dilatih pada berbagai sumber, mereka mungkin tidak selalu memberikan informasi yang paling akurat atau terkini. Seringkali hal ini terjadi karena model memprioritaskan menghasilkan keluaran yang secara tata bahasa benar atau tampak koheren, meskipun menyesatkan.

- Kurangnya pemahaman: Meskipun model ini tampaknya memahami bahasa manusia, mereka beroperasi terutama dengan mengidentifikasi pola dan asosiasi statistik dalam data pelatihan. Mereka tidak memiliki pemahaman yang mendalam tentang konten yang mereka hasilkan, yang terkadang menghasilkan keluaran yang tidak masuk akal atau tidak relevan.

- Konten yang tidak pantas: Model bahasa terkadang dapat menghasilkan konten yang menyinggung, berbahaya, atau tidak pantas. Sementara upaya dilakukan untuk meminimalkan konten tersebut, itu masih dapat terjadi karena sifat data pelatihan dan ketidakmampuan model untuk memahami konteks atau maksud pengguna.

Kesimpulan

Model bahasa besar tidak diragukan lagi telah merevolusi bidang pemrosesan bahasa alami dan menunjukkan potensi besar dalam meningkatkan produktivitas di berbagai peran dan industri. Kemampuan mereka untuk menghasilkan teks seperti manusia, mengotomatiskan tugas-tugas biasa, dan memberikan bantuan dalam proses kreatif dan analitis telah menjadikan mereka alat yang sangat diperlukan di dunia yang serba cepat dan didorong oleh teknologi saat ini.

Namun, sangat penting untuk mengakui dan memahami batasan dan risiko yang terkait dengan model yang kuat ini. Masalah seperti bias, misinformasi, dan potensi penggunaan jahat tidak dapat diabaikan. Saat kami terus mengintegrasikan teknologi yang digerakkan oleh AI ini ke dalam kehidupan sehari-hari, penting untuk mencapai keseimbangan antara meningkatkan kemampuan mereka dan memastikan pengawasan manusia, terutama dalam situasi sensitif dan berisiko tinggi.

Jika kami berhasil mengadopsi teknologi AI generatif secara bertanggung jawab, kami akan membuka jalan untuk masa depan di mana kecerdasan buatan dan keahlian manusia bekerja sama untuk mendorong inovasi dan menciptakan dunia yang lebih baik untuk semua.

Selamat menikmati artikel ini? Mendaftar untuk lebih banyak pembaruan penelitian AI.

Kami akan memberi tahu Anda ketika kami merilis lebih banyak artikel ringkasan seperti ini.

terkait

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- PlatoData.Jaringan Vertikal Generatif Ai. Berdayakan Diri Anda. Akses Di Sini.

- PlatoAiStream. Intelijen Web3. Pengetahuan Diperkuat. Akses Di Sini.

- PlatoESG. Otomotif / EV, Karbon, teknologi bersih, energi, Lingkungan Hidup, Tenaga surya, Penanganan limbah. Akses Di Sini.

- BlockOffset. Modernisasi Kepemilikan Offset Lingkungan. Akses Di Sini.

- Sumber: https://www.topbots.com/top-language-models-transforming-ai-in-2023/

- :memiliki

- :adalah

- :bukan

- :Di mana

- $NAIK

- 1

- 10

- 12b

- 16

- 2%

- 2017

- 2021

- 2023

- 214

- 220

- 28

- 32

- 50

- 7

- 70

- 710

- 72

- 8

- 84

- 90

- a

- kemampuan

- Sanggup

- Tentang Kami

- atas

- Mutlak

- akademik

- Setuju

- Menerima

- mengakses

- dapat diakses

- menampung

- Menurut

- ketepatan

- tepat

- dicapai

- Mencapai

- mencapai

- mengakui

- di seluruh

- Activation

- aktivasi

- tindakan

- menyesuaikan

- adaptasi

- menambahkan

- menambahkan

- tambahan

- Tambahan

- alamat

- alamat

- Mengadopsi

- kemajuan

- nasihat

- Setelah

- terhadap

- Agen

- AI

- ai penelitian

- bertujuan

- AL

- sama

- Semua

- mengizinkan

- Membiarkan

- memungkinkan

- sepanjang

- juga

- alternatif

- Meskipun

- selalu

- di tengah-tengah

- antara

- jumlah

- jumlah

- an

- analisis

- Analytical

- dan

- Lain

- menjawab

- Apa pun

- api

- muncul

- aplikasi

- Mendaftar

- pendekatan

- sesuai

- sekitar

- arsitektur

- arsitektur

- ADALAH

- daerah

- sekitar

- susunan

- Seni

- artikel

- artikel

- buatan

- kecerdasan buatan

- AS

- Bantuan

- asisten

- terkait

- asosiasi

- At

- perhatian

- penulis

- mengotomatisasikan

- tersedia

- rata-rata

- menghindari

- hadiah

- Saldo

- bar

- mendasarkan

- berdasarkan

- dasar

- dasar

- BE

- karena

- menjadi

- sebelum

- makhluk

- di bawah

- patokan

- Benchmark

- Manfaat

- Lebih baik

- antara

- prasangka

- bias

- Milyar

- Buku-buku

- Bootstrap

- kedua

- batas-batas

- terobosan

- terobosan

- JEMBATAN

- luas

- membangun

- Bangunan

- dibangun di

- tapi

- by

- bernama

- CAN

- calon

- tidak bisa

- kemampuan

- mampu

- Kapasitas

- hati-hati

- kasus

- bencana

- Menyebabkan

- ceo

- CEO dan Pendiri

- menantang

- kesempatan

- perubahan

- chatbots

- ChatGPT

- Keripik

- klaim

- klasifikasi

- awan

- Co-founder

- kode

- KOHEREN

- koleksi

- kombinasi

- kombinasi

- bagaimana

- komitmen

- Komunikasi

- masyarakat

- dibandingkan

- cocok

- kompetitif

- komplementer

- kompleks

- pemenuhan

- komponen

- komputasi

- menghitung

- komputer

- komputasi

- konseptual

- Kekhawatiran

- konfigurasi

- DIKONFIRMASI

- Menghubungkan

- Karena itu

- pertimbangan

- konstruksi

- Konten

- konteks

- Konteks

- terus

- kontras

- Percakapan

- percakapan

- Konversi

- benar

- Sesuai

- Biaya

- Biaya

- bisa

- membuat

- dibuat

- Kreatif

- kredibel

- sangat penting

- terbaru

- pelanggan

- Layanan Pelanggan

- Customer Support

- canggih

- harian

- data

- titik data

- kumpulan data

- Tanggal

- memutuskan

- mengurangi

- mendalam

- DeepMind

- memberikan

- mendemonstrasikan

- menunjukkan

- menunjukkan

- menunjukkan

- Demo

- Tergantung

- penggelaran

- dirancang

- Meskipun

- rincian

- mengembangkan

- pengembang

- berkembang

- Pengembangan

- dialog

- Dialog

- sulit

- cacat

- Membuka

- Diskriminasi

- membedakan

- beberapa

- do

- dokumen

- dokumen

- tidak

- Kekuasaan

- Dont

- lusin

- mendorong

- dijuluki

- dua

- selama

- e

- e-commerce

- E&T

- setiap

- Awal

- mudah

- edukasi

- efek

- efektif

- efisiensi

- efisien

- upaya

- dieliminasi

- muncul

- aktif

- memungkinkan

- meliputi

- menarik

- Inggris

- mempertinggi

- ditingkatkan

- Perangkat tambahan

- meningkatkan

- memastikan

- penting

- menetapkan

- menetapkan

- etis

- dievaluasi

- evaluasi

- evaluasi

- Bahkan

- Setiap

- segala sesuatu

- bukti

- berkembang

- pemeriksaan

- contoh

- contoh

- melebihi

- luar biasa

- menarik

- khusus

- pameran

- ada

- Lihat lebih lanjut

- eksperimen

- keahlian

- Menjelajahi

- luar

- f1

- memudahkan

- faktor

- Jatuh

- keluarga

- jauh

- sangat menarik

- serba cepat

- Fitur

- fitur

- Fitur

- umpan balik

- beberapa

- sedikit

- bidang

- Angka

- penyaringan

- Menemukan

- Pertama

- Memperbaiki

- tetap

- mengikuti

- berikut

- Untuk

- bentuk

- Foundations

- pendiri

- Kerangka

- dari

- beku

- fungsi

- mendasar

- secara fundamental

- lebih lanjut

- masa depan

- diperoleh

- celah

- Gender

- menghasilkan

- dihasilkan

- menghasilkan

- menghasilkan

- generasi

- generatif

- AI generatif

- generator

- mendapatkan

- GitHub

- Melihat sekilas

- Aksi

- Go

- tujuan

- akan

- baik

- Pemerintah

- GPU

- kelas

- groundbreaking

- Kelompok

- memiliki

- Terjadi

- Sulit

- Perangkat keras

- berbahaya

- Memiliki

- memiliki

- kesehatan

- di sini

- berkualitas tinggi

- resolusi tinggi

- berisiko tinggi

- lebih tinggi

- paling tinggi

- memegang

- Seterpercayaapakah Olymp Trade? Kesimpulan

- Namun

- HTML

- HTTPS

- besar

- manusia

- Ratusan

- Hype

- Penyesuaian Hyperparameter

- ide

- mengidentifikasi

- if

- gambar

- gambar

- besar

- implementasi

- diimplementasikan

- implikasi

- penting

- impresif

- memperbaiki

- ditingkatkan

- perbaikan

- perbaikan

- in

- secara mendalam

- ketidakmampuan

- memasukkan

- termasuk

- Termasuk

- Tergabung

- menggabungkan

- menggabungkan

- Meningkatkan

- Pada meningkat

- meningkatkan

- makin

- sendiri-sendiri

- individu

- industri

- industri

- informasi

- Infrastruktur

- Inisiat

- Innovation

- memasukkan

- input

- sebagai gantinya

- lembaga

- instruksi

- mengintegrasikan

- Intelijen

- maksud

- menarik

- ke

- memperkenalkan

- diperkenalkan

- Jadian

- isu

- masalah

- IT

- NYA

- Diri

- jurnalisme

- jpg

- hanya

- kunci

- tujuan utama

- Tahu

- pengetahuan

- Labs

- Kekurangan

- pemandangan

- bahasa

- Bahasa

- besar

- besar-besaran

- terbesar

- Terbaru

- lapisan

- lapisan

- memimpin

- BELAJAR

- pengetahuan

- Informasi

- kurang

- Tingkat

- adalah ide yang bagus

- Leverage

- memanfaatkan

- leveraging

- Izin

- Hidup

- ringan

- 'like'

- Mungkin

- keterbatasan

- Daftar

- daftar

- hidup

- Llama

- lokal

- logis

- Panjang

- melihat

- Lot

- Rendah

- Mesin

- terbuat

- membuat

- MEMBUAT

- banyak

- Marcus

- Pasar

- riset pasar

- Marketing

- bahan

- matematika

- max-width

- maksimum

- Mungkin..

- berarti

- Media

- medis

- Bergabung

- meta

- Metodologi

- metode

- Microsoft

- keberatan

- minimal

- Keterangan yg salah

- menyesatkan

- kesalahan

- campur aduk

- ML

- model

- model

- modern

- dimodifikasi

- pemantauan

- lebih

- paling

- banyak

- beberapa

- Muslim

- Alam

- Bahasa Alami

- Pengolahan Bahasa alami

- Alam

- Perlu

- dibutuhkan

- jaringan

- saraf

- Bahasa saraf

- saraf jaringan

- New

- berita

- berikutnya

- bagus

- nLP

- terutama

- tidak ada

- jumlah

- banyak sekali

- tujuan

- target

- terjadi

- of

- serangan

- resmi

- sering

- on

- ONE

- yang

- hanya

- Buka

- open source

- OpenAI

- beroperasi

- Operasi

- optimasi

- or

- organisasi

- Lainnya

- Lainnya

- kami

- di luar

- mengungguli

- Mengungguli

- keluaran

- terkemuka

- lebih

- sendiri

- palem

- kertas

- pola pikir

- parameter

- parameter

- bagian

- ikut

- khususnya

- lulus

- pola

- mengaspal

- Paving

- untuk

- melakukan

- prestasi

- melakukan

- melakukan

- frase

- memilih

- plato

- Kecerdasan Data Plato

- Data Plato

- polong

- Titik

- poin

- Kebijakan

- mungkin

- potensi

- didukung

- kuat

- meramalkan

- disukai

- sebelumnya

- terutama

- Sebelumnya

- memprioritaskan

- Masalah

- masalah

- proses

- proses

- pengolahan

- menghasilkan

- Produk

- produktifitas

- profesional

- Pemrograman

- bahasa pemrograman

- Kemajuan

- menjanjikan

- properties

- mengusulkan

- hak milik

- protokol

- memberikan

- disediakan

- menyediakan

- di depan umum

- diterbitkan

- tujuan

- Mendorong

- Ular sanca

- pytorch

- kualitatif

- kualitas

- pertanyaan

- Pertanyaan

- segera

- Ras

- jarak

- cepat

- agak

- Bacaan

- nyata

- kehidupan nyata

- dunia nyata

- baru

- baru-baru ini

- pengakuan

- mengenali

- menurunkan

- mengurangi

- diet

- penguatan pembelajaran

- melepaskan

- dirilis

- relevan

- dapat diandalkan

- sumber terpercaya

- agama

- mengandalkan

- tinggal

- tetap

- luar biasa

- diganti

- laporan

- perwakilan

- permintaan

- membutuhkan

- membutuhkan

- penelitian

- Komunitas penelitian

- peneliti

- intensif sumber daya

- menghormati

- menanggapi

- tanggapan

- tanggapan

- terbatas

- mengakibatkan

- Hasil

- mempertahankan

- Review

- merevolusionerkan

- merevolusi

- risiko

- persaingan

- kuat

- peran

- Kamar

- aman

- Safety/keselamatan

- tenaga penjualan

- sama

- Skala

- sisik

- skala

- skenario

- adegan

- Sekolah

- skor

- skor

- mencetak gol

- mulus

- Kedua

- terlihat

- terlihat

- terpilih

- peka

- terpisah

- Seri

- serius

- layanan

- Layanan

- set

- pengaturan

- beberapa

- kaget

- Pendek

- Menunjukkan

- menunjukkan

- Pertunjukkan

- menandatangani

- penting

- signifikan

- Demikian pula

- tunggal

- situasi

- Ukuran

- keterampilan

- lebih kecil

- So

- sejauh ini

- Sosial

- media sosial

- Masyarakat

- Perangkat lunak

- pengembangan perangkat lunak

- semata-mata

- larutan

- Memecahkan

- beberapa

- mutakhir

- sumber

- sumber

- Sourcing

- Spam

- tertentu

- Secara khusus

- kekhususan

- spektakuler

- speech-to-text

- kecepatan

- Stabilitas

- Tahap

- magang

- standar

- standar

- Negara

- state-of-the-art

- statistik

- statistika

- Masih

- Penyelarasan

- kekuatan

- menyerang

- Belajar

- besar

- berhasil

- seperti itu

- menyarankan

- Menyarankan

- RINGKASAN

- unggul

- pengawasan

- mendukung

- melampaui

- sistem

- sistem

- Pembicaraan

- tugas

- tugas

- tim

- Teknis

- teknik

- Teknologi

- istilah

- uji

- pembuatan teks

- Text-to-Speech

- dari

- Terima kasih

- bahwa

- Grafik

- Masa depan

- Negara

- Dunia

- mereka

- Mereka

- kemudian

- Sana.

- dengan demikian

- karena itu

- Ini

- mereka

- berpikir

- pihak ketiga

- ini

- itu

- meskipun?

- ribuan

- tiga

- Melalui

- kali

- untuk

- hari ini

- bersama

- token

- Tokenisasi

- Token

- terlalu

- alat

- puncak

- TOPBOT

- tema

- Topik

- terhadap

- tradisional

- Pelatihan VE

- terlatih

- Pelatihan

- transfer

- transformator

- mengubah

- Terjemahan

- Triliun

- turing

- Les

- dua

- tak bersyarat

- bawah

- memahami

- pemahaman

- melakukan

- niscaya

- sayangnya

- Alam semesta

- tidak seperti

- mutakhir

- Pembaruan

- menggunakan

- bekas

- Pengguna

- kegunaan

- menggunakan

- memanfaatkan

- variasi

- berbagai

- Luas

- serba guna

- sangat

- Video

- Video

- maya

- penglihatan

- VOX

- adalah

- Cara..

- we

- jaringan

- BAIK

- adalah

- Apa

- ketika

- yang

- sementara

- SIAPA

- seluruh

- lebar

- Rentang luas

- Wikipedia

- akan

- dengan

- dalam

- tanpa

- kata

- Kerja

- bekerja sama

- dunia

- penulisan

- tahun

- namun

- kamu

- zephyrnet.dll

- Pembelajaran Zero-Shot