Setelah bertahun-tahun melakukan pengembangan, Meta akhirnya dapat meluncurkan akselerator AI buatannya dengan cara yang berarti pada tahun ini.

Kerajaan Facebook mengonfirmasi keinginannya untuk melengkapi penerapan GPU Nvidia H100 dan AMD MI300X dengan keluarga chip Meta Training Inference Accelerator (MTIA) minggu ini. Secara khusus, Meta akan menerapkan prosesor yang dioptimalkan untuk inferensi, dilaporkan diberi nama sandi Artemis, berdasarkan suku cadang generasi pertama raksasa Lembah Silikon itu menggoda tahun lalu.

“Kami gembira dengan kemajuan yang telah kami capai dalam upaya silikon internal kami dengan MTIA dan berada di jalur yang tepat untuk mulai menerapkan varian inferensi kami dalam produksi pada tahun 2024,” kata juru bicara Meta. Pendaftaran pada hari Kamis.

“Kami melihat akselerator yang kami kembangkan secara internal akan sangat melengkapi GPU yang tersedia secara komersial dalam memberikan perpaduan optimal antara kinerja dan efisiensi pada beban kerja khusus Meta,” lanjut perwakilan tersebut. Detailnya? Tidak. Juru bicaranya mengatakan kepada kami: “Kami berharap dapat menyampaikan lebih banyak pembaruan mengenai rencana MTIA masa depan kami pada akhir tahun ini.”

Kami mengartikan bahwa chip yang berfokus pada inferensi generasi kedua diluncurkan secara luas, mengikuti versi khusus lab generasi pertama untuk inferensi, dan nanti kami akan mengetahui bagian-bagian yang ditujukan terutama untuk pelatihan atau pelatihan dan inferensi.

Meta telah menjadi salah satu pelanggan terbaik Nvidia dan AMD seiring dengan berkembangnya penerapan beban kerja AI, sehingga meningkatkan kebutuhan dan penggunaan silikon khusus untuk membuat perangkat lunak pembelajaran mesinnya berjalan secepat mungkin. Oleh karena itu, keputusan raksasa Instagram untuk mengembangkan prosesor kustomnya sendiri tidaklah terlalu mengejutkan.

Faktanya, perusahaan besar tersebut, secara sepintas, relatif terlambat memasuki kelompok silikon AI khusus dalam hal penerapan di dunia nyata. Amazon dan Google telah menggunakan komponen buatan sendiri untuk mempercepat sistem pembelajaran mesin internal, seperti model pemberi rekomendasi, dan kode ML pelanggan selama beberapa tahun. Sementara itu, Microsoft mengungkapkan akselerator buatannya tahun lalu.

Namun selain fakta bahwa Meta meluncurkan chip inferensi MTIA dalam skala besar, jejaring sosial tersebut belum mengungkapkan arsitektur tepatnya atau beban kerja apa yang dicadangkannya untuk silikon internal dan yang diturunkan ke GPU AMD dan Nvidia.

Kemungkinan besar Meta akan menjalankan model yang sudah ada pada ASIC kustomnya untuk membebaskan sumber daya GPU untuk aplikasi yang lebih dinamis atau berkembang. Kami telah melihat Meta melakukan hal ini sebelumnya dengan akselerator khusus yang dirancang untuk memindahkan data dan menghitung beban kerja video yang intensif.

Mengenai desain yang mendasarinya, pengamat industri di SemiAnalysis memberi tahu kami bahwa chip baru ini sangat didasarkan pada arsitektur bagian generasi pertama Meta.

Batu pijakan

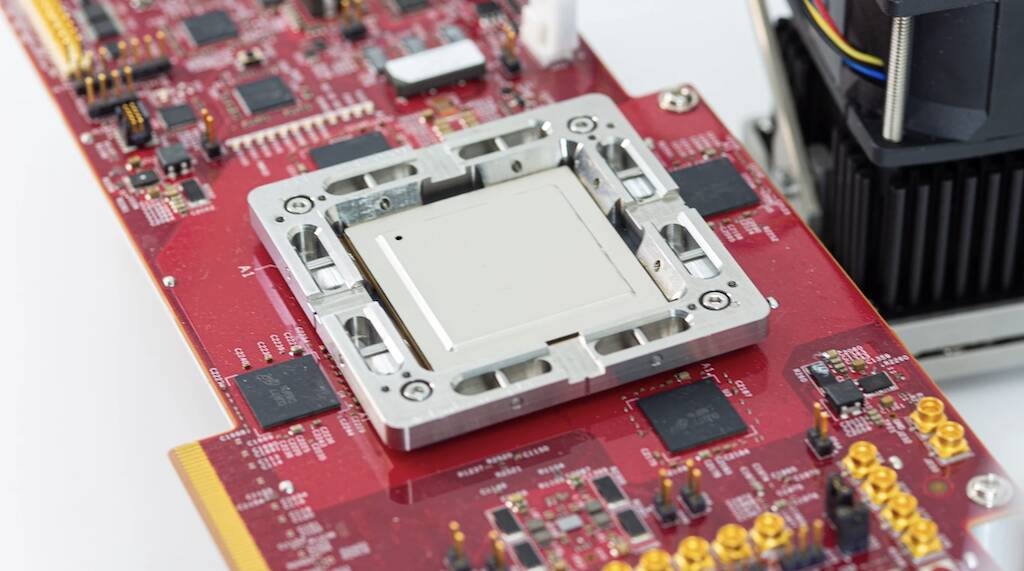

Diumumkan pada awal tahun 2023 setelah tiga tahun pengembangan, bagian MTIA v1 Meta, yang teman-teman kita di Platform Selanjutnya memandang musim semi lalu, dirancang khusus dengan mempertimbangkan model rekomendasi pembelajaran mendalam.

Chip generasi pertama dibuat dengan cluster CPU RISC-V dan dibuat menggunakan proses 7nm TSMC. Di bagian dalamnya, komponen ini menggunakan matriks elemen pemrosesan berukuran delapan kali delapan yang masing-masing dilengkapi dengan dua inti CPU RV, salah satunya dilengkapi dengan ekstensi matematika vektor. Inti-inti ini ditenagai oleh SRAM on-chip sebesar 128 MB dan memori LPDDR128 hingga 5 GB.

Seperti yang diklaim Meta tahun lalu, chip tersebut berjalan pada 800 MHz dan mencapai 102.4 triliun operasi per detik kinerja INT8 atau 51.2 teraFLOPS dengan presisi setengah (FP16). Sebagai perbandingan, Nvidia H100 mampu menghasilkan hampir empat petaFLOPS kinerja FP8 yang jarang. Meskipun tidak sekuat GPU Nvidia atau AMD, chip ini memiliki satu keunggulan utama: Konsumsi daya. Chip itu sendiri memiliki daya desain termal hanya 25 watt.

Menurut SemiAnalisis, Chip terbaru Meta menawarkan inti yang ditingkatkan dan menukar LPDDR5 dengan memori bandwidth tinggi yang dikemas menggunakan teknologi chip-on-wafer-on-substrate (CoWoS) TSMC.

Perbedaan penting lainnya adalah chip Meta generasi kedua akan diterapkan secara luas di seluruh infrastruktur pusat datanya. Menurut raksasa Facebook tersebut, meskipun bagian generasi pertama digunakan untuk menjalankan model iklan produksi, ia tidak pernah meninggalkan lab.

Mengejar kecerdasan umum buatan

Selain bagian khusus, induk Facebook dan Instagram telah membuangnya miliaran dolar untuk GPU dalam beberapa tahun terakhir untuk mempercepat segala jenis tugas yang tidak sesuai dengan platform CPU konvensional. Namun, munculnya model bahasa besar, seperti GPT-4 dan Llama 2 milik Meta, telah mengubah lanskap dan mendorong penerapan cluster GPU secara besar-besaran.

Pada skala Meta beroperasi, tren ini memerlukan perubahan drastis pada infrastrukturnya, termasuk mendesain ulang dari beberapa pusat data untuk mendukung kebutuhan daya dan pendinginan yang sangat besar terkait dengan penerapan AI dalam jumlah besar.

Dan penerapan Meta akan semakin besar dalam beberapa bulan ke depan karena perusahaan mengalihkan fokus dari metaverse ke pengembangan dari kecerdasan umum buatan. Seharusnya, pekerjaan yang dilakukan pada AI akan membantu membentuk metaverse atau semacamnya.

Menurut CEO Mark Zuckerberg, Meta berencana menyebarkan sebanyak 350,000 Nvidia H100 pada tahun ini saja.

Pihak biz juga mengumumkan rencana untuk menyebarkan AMD yang baru diluncurkan GPU MI300X di pusat datanya. Zuckerberg mengklaim perusahaannya akan mengakhiri tahun ini dengan kekuatan komputasi yang setara dengan 600,000 H100. Jadi jelas chip MTIA Meta tidak akan menggantikan GPU dalam waktu dekat. ®

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- PlatoData.Jaringan Vertikal Generatif Ai. Berdayakan Diri Anda. Akses Di Sini.

- PlatoAiStream. Intelijen Web3. Pengetahuan Diperkuat. Akses Di Sini.

- PlatoESG. Karbon, teknologi bersih, energi, Lingkungan Hidup, Tenaga surya, Penanganan limbah. Akses Di Sini.

- PlatoHealth. Kecerdasan Uji Coba Biotek dan Klinis. Akses Di Sini.

- Sumber: https://go.theregister.com/feed/www.theregister.com/2024/02/02/meta_ai_chips/

- :memiliki

- :adalah

- $NAIK

- 000

- 102

- 2%

- 2023

- 2024

- 25

- 350

- 4

- 51

- 600

- 800

- a

- Tentang Kami

- mempercepat

- akselerator

- akselerator

- Menurut

- di seluruh

- sebenarnya

- Keuntungan

- pengiklanan

- Setelah

- AI

- Semua

- sendirian

- di samping

- juga

- Amazon

- AMD

- an

- dan

- mengumumkan

- aplikasi

- arsitektur

- ADALAH

- sekitar

- buatan

- kecerdasan umum buatan

- AS

- Asics

- asam

- terkait

- At

- tersedia

- berdasarkan

- BE

- menjadi

- menjadi

- sebelum

- TERBAIK

- Luar

- biz

- membanggakan

- dibangun di

- by

- mampu

- ceo

- berubah

- Perubahan

- keping

- Keripik

- diklaim

- Jelas

- rapat

- Kelompok

- CO

- kode

- secara komersial

- perusahaan

- perbandingan

- komplementer

- komponen

- komponen

- menghitung

- komputasi

- daya komputasi

- DIKONFIRMASI

- konsumsi

- terus

- konvensional

- PERUSAHAAN

- CPU

- adat

- pelanggan

- pelanggan

- data

- Datacenter

- keputusan

- mengantarkan

- menyebarkan

- penggelaran

- penyebaran

- penyebaran

- Mendesain

- dirancang

- keinginan

- rincian

- mengembangkan

- dikembangkan

- Pengembangan

- MELAKUKAN

- perbedaan

- dolar

- dilakukan

- turun

- didorong

- dinamis

- setiap

- Awal

- efisiensi

- upaya

- antara

- elemen

- Kekaisaran

- dipekerjakan

- akhir

- lengkap

- Setara

- mapan

- Eter (ETH)

- berkembang

- gembira

- ekstensi

- Menghadapi

- fakta

- keluarga

- FAST

- Fed

- beberapa

- Akhirnya

- Menemukan

- Fokus

- berikut

- Untuk

- bentuk

- Depan

- empat

- Gratis

- teman

- dari

- masa depan

- Umum

- kecerdasan umum

- murah hati

- mendapatkan

- raksasa

- Go

- akan

- GPU

- GPU

- dewasa

- memiliki

- Setengah

- Memiliki

- membantu

- sangat

- -nya

- buatan sendiri

- kap

- Namun

- HTTPS

- besar

- ditingkatkan

- in

- Termasuk

- meningkatkan

- industri

- Infrastruktur

- Intelijen

- dimaksudkan

- intensif

- intern

- internal

- adalah n

- IT

- NYA

- Diri

- jpg

- hanya

- laboratorium

- pemandangan

- bahasa

- besar

- lebih besar

- Terakhir

- Tahun lalu

- Terlambat

- kemudian

- Terbaru

- meninggalkan

- 'like'

- Mungkin

- Llama

- melihat

- terbuat

- utama

- membuat

- cara

- banyak

- tanda

- Mark Zuckerberg

- besar-besaran

- matematika

- Matriks

- Mungkin..

- berarti

- berarti

- Sementara itu

- Memori

- meta

- Metaverse

- Microsoft

- keberatan

- mencampur

- ML

- model

- bulan

- lebih

- Dekat

- hampir

- Perlu

- jaringan

- tak pernah

- New

- chip baru

- baru saja

- berikutnya

- maupun

- penting

- Nvidia

- of

- on

- ONE

- hanya

- beroperasi

- Operasi

- optimal

- or

- kami

- di luar

- lebih

- sendiri

- dikemas

- bagian

- bagian

- pihak

- untuk

- prestasi

- rencana

- Platform

- plato

- Kecerdasan Data Plato

- Data Plato

- mungkin

- kekuasaan

- kuat

- perlu

- Ketelitian

- terutama

- proses

- pengolahan

- Prosesor

- prosesor

- Produksi

- Kemajuan

- RE

- dunia nyata

- baru

- relatif

- Persyaratan

- Sumber

- Reuters

- Terungkap

- Naik

- Menggulung

- bergulir

- Rute

- Run

- s

- Skala

- Kedua

- melihat

- terlihat

- beberapa

- berbagi

- Pergeseran

- Silikon

- Silicon Valley

- So

- Sosial

- jaringan sosial

- Perangkat lunak

- beberapa

- sesuatu

- Segera

- jarang

- khusus

- Secara khusus

- juru bicara

- musim semi

- awal

- seperti itu

- suplemen

- mendukung

- mengherankan

- sistem

- T

- pengambilan

- tugas

- tech

- mengatakan

- istilah

- bahwa

- Grafik

- Pemandangan

- Metaverse

- panas

- Ini

- ini

- minggu ini

- tahun ini

- tiga

- Kamis

- Demikian

- titan

- untuk

- mengatakan

- atasnya

- jalur

- perdagangan

- Pelatihan

- Tren

- Triliun

- tsmc

- dua

- bawah

- pokok

- Pembaruan

- us

- menggunakan

- bekas

- menggunakan

- v1

- Lembah

- Varian

- Ve

- vektor

- versi

- Video

- adalah

- Cara..

- we

- minggu

- adalah

- yang

- sementara

- sangat

- tersebar luas

- akan

- dengan

- Won

- Kerja

- akan

- tahun

- tahun

- zephyrnet.dll

- Zuckerberg