HPE Temukan EMEA Saat ini, ketika semua pembuat teknologi besar berebut mendapatkan keuntungan dari AI, HPE berupaya untuk tetap relevan dengan mengadopsi apa yang disebut oleh CEO tertinggi Antonio Neri sebagai strategi “asli AI”.

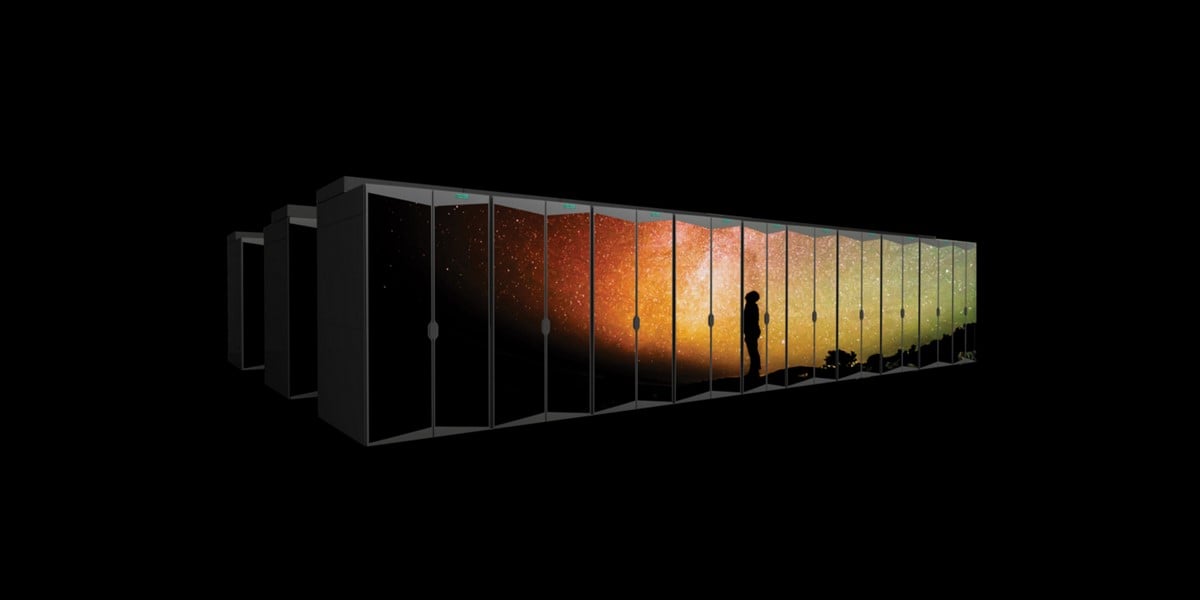

Klaimnya adalah bahwa HPE dapat mendukung pelanggan melalui setiap bagian siklus hidup model AI, mulai dari pelatihan hingga penyesuaian dan pengambilan kesimpulan. Sebagian dari hal ini bergantung pada HPE memiliki Cray, dan mampu menyediakan teknologi superkomputer yang diperlukan untuk melatih model AI berukuran besar, yang menurut Neri merupakan pembeda yang tidak dimiliki oleh beberapa pesaing HPE.

HPE, seperti banyak perusahaan lain di industri ini, melihat masa depan sebagai AI dan lebih banyak lagi AI – meskipun dalam kasus ini disampaikan melalui platform Greenlake. Perusahaan perlu meyakinkan pasar bahwa mereka memiliki bagian penting dari teka-teki AI.

Dalam pidatonya di acara Discover HPE di Barcelona, Neri menyoroti peluang penggunaan AI di perusahaan, dengan menggunakan ungkapan lama bahwa AI akan menjadi “teknologi yang paling disruptif dalam masa hidup kita.”

Pernyataan seperti itu merupakan hal yang lumrah saat ini, menyusul ledakan minat terhadap model AI generatif yang disebabkan oleh OpenAI dan chatbot ChatGPT-nya yang didasarkan pada model bahasa besar.

“AI dipandang sebagai sebuah janji sebelum tahun 2022 dan ChatGPT datang dan mengguncang fondasinya,” kata Neri.

“Sekarang bayangkan masa depan di mana setiap keputusan bisnis dimungkinkan oleh AI. Masa depan di mana analitik prediktif mendorong tingkat aktivitas baru untuk membantu Anda membuat keputusan yang lebih baik, lebih cepat, dan memprediksi tren peluang bisnis baru,” kata Neri.

Untuk mendukung hal ini, Neri didampingi oleh Karl Havard, direktur pelaksana Awan Taiga, sebuah perusahaan Eropa yang membangun cloud khusus untuk pemrosesan AI.

Taiga menggunakan node Cray XD HPE, dilengkapi dengan GPU Nvidia H100 untuk platformnya, perangkat keras yang sama dengan layanan superkomputer GreenLake for Large Language Models milik HPE yang diumumkan pada bulan Juni.

Havard mengatakan perusahaannya bertujuan untuk melakukan hal tersebut menjual mendemokratisasi akses terhadap AI generatif, sehingga startup dan perusahaan kecil bisa mendapatkan sumber daya yang mereka perlukan untuk melatih model, dibandingkan harus membangun infrastruktur mereka sendiri atau menggunakan cloud publik yang besar.

Perjanjian dengan perusahaan lain juga penting bagi HPE, Neri mengakui, khususnya Nvidia, mengingat bahwa GPU-nya memainkan peran penting dalam sistem superkomputer HPE untuk AI dan solusi perusahaan untuk AI generatif, yang terakhir ini mengumumkan minggu ini di Temukan.

VP Nvidia untuk Komputasi Perusahaan, Manuvir Das, hadir dalam keynote tersebut untuk menjelaskan bahwa banyak pengguna perusahaan tidak perlu menghabiskan seluruh waktu dan upaya untuk membangun dan melatih AI mereka sendiri, namun dalam banyak kasus dapat mengambil pelatihan sebelumnya. model pondasi dan gunakan saja, atau sesuaikan agar lebih sesuai dengan kebutuhan mereka.

“Dengan model pondasi, seseorang telah melakukan semua pekerjaan untuk Anda. Mereka sudah mengerjakan 99 persen pekerjaannya dan kalau 1 persen sisanya bisa saya kerjakan, sekarang modelnya ada di tangan saya,” jelasnya.

Namun, Nvidia juga merupakan pemasok utama bagi pesaing HPE, terutama Dell, yang awal tahun ini meluncurkan platformnya sendiri untuk inferensi dan penyesuaian AI serta penyetelan model. Ini juga menggunakan GPU Nvidia dan perangkat lunak AI Enterprise suite-nya.

Terlepas dari seluruh perhatian dan investasi yang diberikan pada pelatihan model AI saat ini, HPE percaya bahwa inferensi adalah hal yang lebih penting, karena hal ini pada akhirnya mewakili sebagian besar siklus hidup model AI.

“Penggunaan AI terjadi saat Anda siap menerapkan model ini, dan itu terjadi pada sisi inferensi,” kata Neri saat menjawab pertanyaan. “Hal ini dapat dilakukan di pusat data, namun saya yakin sebagian besar kesimpulannya akan membantu pemrosesan real-time di mana data berada, sehingga keputusan harus dibuat lebih cepat.”

Potensi permintaan akan infrastruktur baru untuk mendukung inferensi AI mungkin merupakan hal yang dibutuhkan HPE, menyusul kebutuhan baru-baru ini Penurunan pendapatan sebesar 31 persen untuk bisnis Komputasinya. Hal ini menyusul penurunan pendapatan yang dilaporkan selama dua kuartal sebelumnya.

“Bisnis Komputasi, masih belum berhenti, dan mungkin akan mendapatkan kesempatan lain karena inferensi AI,” kata Neri saat menjawab pertanyaan lain.

Bagaimana jika industri tidak menyetujui janji AI?

Namun dengan HPE yang bertaruh besar pada AI, apa yang terjadi jika AI tidak menjadi titik perubahan besar yang diklaim oleh banyak komentator?

Matt Harris, direktur pelaksana HPE untuk Inggris, Irlandia, Timur Tengah, dan Afrika, bersikukuh bahwa hal ini akan mengubah cara bisnis beroperasi secara mendasar.

“Saya rasa AI generatif di ChatGPT telah mengedepankan AI dalam kesadaran dan proses berpikir semua orang, namun menurut saya hal ini tidak berlebihan. Saya pikir AI akan menyusup ke dalam kehidupan kita, dan hal ini sudah terjadi, jika Anda berpikir bahwa pencarian di internet telah meningkat selama bertahun-tahun, atau penggunaan chatbot yang berbicara dengan Anda untuk menyelesaikan pertanyaan atau masalah pelanggan, hal tersebut sudah cukup meluas,” kata Harris. ®

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- PlatoData.Jaringan Vertikal Generatif Ai. Berdayakan Diri Anda. Akses Di Sini.

- PlatoAiStream. Intelijen Web3. Pengetahuan Diperkuat. Akses Di Sini.

- PlatoESG. Karbon, teknologi bersih, energi, Lingkungan Hidup, Tenaga surya, Penanganan limbah. Akses Di Sini.

- PlatoHealth. Kecerdasan Uji Coba Biotek dan Klinis. Akses Di Sini.

- Sumber: https://go.theregister.com/feed/www.theregister.com/2023/12/01/hpe_talks_up_ai_some/

- :memiliki

- :adalah

- :bukan

- :Di mana

- $NAIK

- 1

- 2022

- a

- Sanggup

- Tentang Kami

- mengakses

- kegiatan

- Mengadopsi

- Afrika

- AI

- Model AI

- bertujuan

- Semua

- sudah

- juga

- Meskipun

- an

- analisis

- dan

- mengumumkan

- Lain

- ADALAH

- ARM

- AS

- At

- perhatian

- jauh

- kembali

- barcelona

- berdasarkan

- BE

- karena

- sebelum

- makhluk

- Percaya

- percaya

- Lebih baik

- Pertaruhan

- Besar

- teknologi besar

- lebih besar

- Peminjaman

- kedua

- Terbawa

- membangun

- Bangunan

- bisnis

- bisnis

- tapi

- membeli

- by

- Panggilan

- datang

- CAN

- Bisa Dapatkan

- kasus

- kasus

- disebabkan

- ceo

- perubahan

- ChatBot

- chatbots

- ChatGPT

- klaim

- mengklaim

- klaim

- awan

- CO

- komentator

- Perusahaan

- perusahaan

- menghitung

- komputasi

- Kesadaran

- meyakinkan

- bisa

- kritis

- pelanggan

- pelanggan

- kustomisasi

- data

- Datacenter

- keputusan

- keputusan

- Menurun

- disampaikan

- Dell

- Permintaan

- mendemokrasikan

- menyebarkan

- pembeda

- Kepala

- menemukan

- mengganggu

- do

- tidak

- doesn

- don

- dilakukan

- mendorong

- Menjatuhkan

- selama

- Terdahulu

- Timur

- usaha

- diaktifkan

- Enterprise

- perusahaan

- Eter (ETH)

- Eropa

- Acara

- Setiap

- semua orang

- Menjelaskan

- menjelaskan

- ledakan

- lebih cepat

- diikuti

- berikut

- Untuk

- depan

- Prinsip Dasar

- Foundations

- dari

- secara fundamental

- masa depan

- generatif

- AI generatif

- mendapatkan

- diberikan

- Go

- akan

- GPU

- lebih besar

- Terjadi

- Perangkat keras

- Memiliki

- memiliki

- he

- membantu

- Disorot

- engsel

- -nya

- horison

- Seterpercayaapakah Olymp Trade? Kesimpulan

- Namun

- HTTPS

- besar

- i

- if

- membayangkan

- Dampak

- ditingkatkan

- in

- industri

- Infleksi

- Titik belok

- Infrastruktur

- sebagai gantinya

- bunga

- Internet

- ke

- investasi

- Irlandia

- adalah n

- IT

- NYA

- bergabung

- jpg

- Juni

- hanya

- karl

- kunci

- Intisari

- label

- bahasa

- besar

- diluncurkan

- adalah ide yang bagus

- siklus hidup

- seumur hidup

- 'like'

- hidup

- Lot

- terbuat

- membuat

- pembuat

- pelaksana

- Managing Director

- banyak

- Pasar

- Cocok

- Tengah

- Timur Tengah

- tambang

- model

- model

- saat

- lebih

- paling

- asli

- perlu

- Perlu

- kebutuhan

- New

- node

- terutama

- sekarang

- Nvidia

- of

- on

- OpenAI

- beroperasi

- Peluang

- or

- Lainnya

- Lainnya

- kami

- di luar

- lebih

- dilebih-lebihkan

- sendiri

- memiliki

- bagian

- tertentu

- persen

- memilih

- potongan-potongan

- anggukan

- sangat penting

- Platform

- Platform

- plato

- Kecerdasan Data Plato

- Data Plato

- Bermain

- plus

- Titik

- potensi

- meramalkan

- prediktif

- Predictive Analytics

- cukup

- sebelumnya

- mungkin

- masalah

- proses

- pengolahan

- janji

- publik

- teka-teki

- query

- pertanyaan

- siap

- nyata

- real-time

- baru

- relevan

- tinggal

- yang tersisa

- Dilaporkan

- merupakan

- Persyaratan

- Sumber

- tanggapan

- pendapatan

- saingan

- Peran

- s

- Tersebut

- sama

- mengatakan

- Pencarian

- terlihat

- melihat

- layanan

- terguncang

- tembakan

- sisi

- lebih kecil

- So

- Perangkat lunak

- larutan

- MEMECAHKAN

- beberapa

- Seseorang

- di suatu tempat

- khusus

- menghabiskan

- Tahap

- Startups

- Laporan

- Penyelarasan

- menyerang

- rangkaian

- Superkomputer

- pemasok

- menyediakan

- mendukung

- sistem

- T

- pembicaraan

- tech

- Teknologi

- bahwa

- Grafik

- Masa depan

- mereka

- Ini

- mereka

- hal

- berpikir

- ini

- tahun ini

- pikir

- Melalui

- waktu

- untuk

- Pelatihan VE

- Pelatihan

- Tren

- MENGHIDUPKAN

- dua

- Uk

- Akhirnya

- penggunaan

- menggunakan

- Pengguna

- menggunakan

- Ve

- melalui

- vp

- adalah

- Cara..

- Apa

- ketika

- yang

- akan

- dengan

- Kerja

- tahun

- tahun

- kamu

- zephyrnet.dll