15 Okt 2023 (

Berita Nanowerk) Model Bahasa Besar (LLM) seperti ChatGPT dan Bard telah menggemparkan dunia tahun ini, dengan banyak perusahaan yang menginvestasikan jutaan dolar untuk mengembangkan alat AI ini, dan beberapa chatbot AI terkemuka bernilai miliaran dolar. LLM ini, yang semakin banyak digunakan dalam chatbot AI, mengumpulkan seluruh informasi di Internet untuk mempelajari dan menginformasikan jawaban yang mereka berikan terhadap permintaan yang ditentukan pengguna, yang dikenal sebagai 'prompt'. Namun, ilmuwan komputer dari startup keamanan AI Mindgard dan Lancaster University di Inggris telah menunjukkan bahwa potongan LLM ini dapat disalin dalam waktu kurang dari seminggu hanya dengan $50, dan informasi yang diperoleh dapat digunakan untuk meluncurkan serangan yang ditargetkan. . Para peneliti memperingatkan bahwa penyerang yang mengeksploitasi kerentanan ini dapat mengungkap informasi rahasia pribadi, melewati batasan, memberikan jawaban yang salah, atau melancarkan serangan lebih lanjut yang ditargetkan. Dirinci dalam makalah baru (

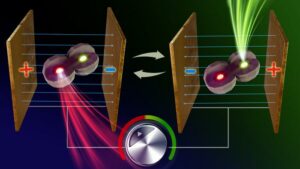

“Model Leeching: An Extraction Attack Targeting LLMs”) yang akan dipresentasikan pada CAMLIS 2023 (Konferensi Pembelajaran Mesin Terapan untuk Keamanan Informasi) para peneliti menunjukkan bahwa ada kemungkinan untuk menyalin aspek-aspek penting dari LLM yang ada dengan harga murah, dan mereka menunjukkan bukti adanya kerentanan yang ditransfer antar model yang berbeda. Serangan ini, yang disebut 'model leeching', bekerja dengan berbicara kepada LLM sedemikian rupa – menanyakan serangkaian perintah yang ditargetkan – sehingga LLM memperoleh informasi mendalam yang menjelaskan cara kerja model tersebut. Tim peneliti, yang memfokuskan studi mereka pada ChatGPT-3.5-Turbo, kemudian menggunakan pengetahuan ini untuk membuat model salinan mereka sendiri, yang 100 kali lebih kecil tetapi mereplikasi aspek-aspek utama LLM. Para peneliti kemudian dapat menggunakan salinan model ini sebagai tempat pengujian untuk mengetahui cara mengeksploitasi kerentanan di ChatGPT tanpa terdeteksi. Mereka kemudian dapat menggunakan pengetahuan yang diperoleh dari model mereka untuk menyerang kerentanan di ChatGPT dengan peningkatan tingkat keberhasilan sebesar 11%. Dr Peter Garraghan dari Lancaster University, CEO Mindgard, dan Peneliti Utama penelitian tersebut, mengatakan: “Apa yang kami temukan secara ilmiah menarik, namun sangat mengkhawatirkan. Ini adalah salah satu karya pertama yang secara empiris menunjukkan bahwa kerentanan keamanan dapat berhasil ditransfer antara model Machine Learning sumber tertutup dan sumber terbuka, yang sangat memprihatinkan mengingat betapa banyak industri bergantung pada model Pembelajaran Mesin yang tersedia untuk umum yang dihosting di tempat-tempat seperti HuggingFace.” Para peneliti mengatakan penelitian mereka menyoroti bahwa meskipun teknologi AI digital yang kuat ini memiliki kegunaan yang jelas, terdapat kelemahan tersembunyi, dan bahkan mungkin terdapat kerentanan umum di seluruh model. Bisnis di seluruh industri saat ini atau bersiap untuk menginvestasikan miliaran dolar dalam menciptakan LLM mereka sendiri untuk melakukan berbagai tugas seperti asisten pintar. Jasa keuangan dan perusahaan besar mengadopsi teknologi ini namun para peneliti mengatakan bahwa kerentanan ini harus menjadi perhatian utama bagi semua bisnis yang berencana membangun atau menggunakan LLM pihak ketiga. Dr Garraghan berkata: “Meskipun teknologi LLM berpotensi transformatif, dunia usaha dan ilmuwan harus berpikir dengan sangat hati-hati dalam memahami dan mengukur risiko dunia maya yang terkait dengan adopsi dan penerapan LLM.”

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- PlatoData.Jaringan Vertikal Generatif Ai. Berdayakan Diri Anda. Akses Di Sini.

- PlatoAiStream. Intelijen Web3. Pengetahuan Diperkuat. Akses Di Sini.

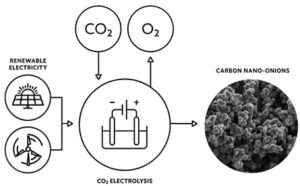

- PlatoESG. Karbon, teknologi bersih, energi, Lingkungan Hidup, Tenaga surya, Penanganan limbah. Akses Di Sini.

- PlatoHealth. Kecerdasan Uji Coba Biotek dan Klinis. Akses Di Sini.

- Sumber: https://www.nanowerk.com/news2/robotics/newsid=63842.php