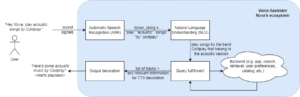

Kemajuan terkini dalam pengembangan LLM telah mempopulerkan penggunaannya untuk beragam tugas NLP yang sebelumnya ditangani menggunakan metode pembelajaran mesin lama. Model bahasa besar mampu memecahkan berbagai masalah bahasa seperti klasifikasi, peringkasan, pengambilan informasi, pembuatan konten, menjawab pertanyaan, dan mempertahankan percakapan — semuanya hanya menggunakan satu model. Namun bagaimana kita tahu bahwa mereka melakukan tugasnya dengan baik dalam semua tugas yang berbeda ini?

Munculnya LLM telah mengungkap masalah yang belum terselesaikan: kita tidak memiliki standar yang dapat diandalkan untuk mengevaluasinya. Apa yang membuat evaluasi lebih sulit adalah bahwa evaluasi tersebut digunakan untuk tugas-tugas yang sangat beragam dan kami tidak memiliki definisi yang jelas tentang jawaban yang baik untuk setiap kasus penggunaan.

Artikel ini membahas pendekatan terkini untuk mengevaluasi LLM dan memperkenalkan papan peringkat LLM baru yang memanfaatkan evaluasi manusia yang meningkatkan teknik evaluasi yang ada.

Bentuk evaluasi awal yang pertama dan biasa dilakukan adalah menjalankan model pada beberapa kumpulan data yang dikurasi dan memeriksa kinerjanya. HuggingFace membuat Buka Papan Peringkat LLM di mana model besar akses terbuka dievaluasi menggunakan empat kumpulan data terkenal (Tantangan Penalaran AI2 , HellaSwag , MMLU , JujurQA). Hal ini berhubungan dengan evaluasi otomatis dan memeriksa kemampuan model untuk mendapatkan fakta untuk beberapa pertanyaan spesifik.

Ini adalah contoh pertanyaan dari MMLU Himpunan data.

Subyek: perguruan tinggi_kedokteran

Pertanyaan: Efek samping yang diharapkan dari suplementasi kreatin adalah.

- A) kelemahan otot

- B) pertambahan massa tubuh

- C) kram otot

- D) hilangnya elektrolit

Jawaban: (B)

Pemberian skor pada model untuk menjawab pertanyaan jenis ini merupakan metrik yang penting dan berfungsi dengan baik untuk pengecekan fakta, namun hal ini tidak menguji kemampuan generatif model. Ini mungkin kelemahan terbesar dari metode evaluasi ini karena menghasilkan teks bebas adalah salah satu fitur terpenting LLM.

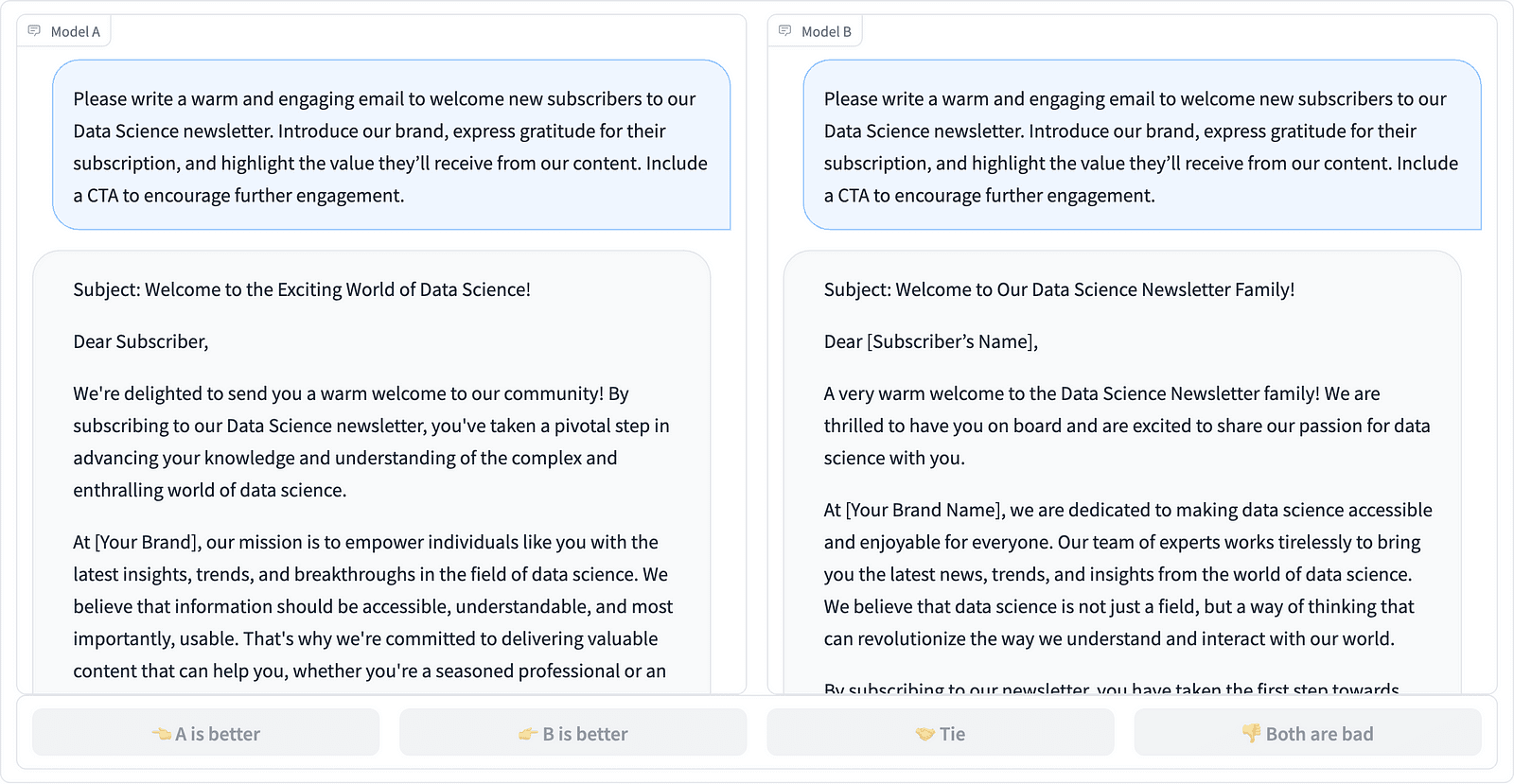

Tampaknya ada konsensus dalam komunitas bahwa untuk mengevaluasi model dengan benar kita memerlukan evaluasi manusia. Hal ini biasanya dilakukan dengan membandingkan tanggapan dari model yang berbeda.

Membandingkan dua penyelesaian cepat dalam proyek LMSYS – tangkapan layar oleh Penulis

Anotator memutuskan respons mana yang lebih baik, seperti terlihat pada contoh di atas, dan terkadang menghitung perbedaan kualitas penyelesaian cepat. Organisasi LMSYS telah membuat a leaderboard yang menggunakan jenis evaluasi manusia ini dan membandingkan 17 model berbeda, melaporkan Peringkat elo untuk setiap model.

Karena evaluasi manusia sulit untuk diukur, terdapat upaya untuk meningkatkan dan mempercepat proses evaluasi dan hal ini menghasilkan proyek menarik yang disebut AlpakaEval. Di sini setiap model dibandingkan dengan garis dasar (teks-davinci-003 disediakan oleh GPT-4) dan evaluasi manusia diganti dengan penilaian GPT-4. Ini memang cepat dan terukur, tetapi bisakah kita memercayai model di sini untuk melakukan penilaian? Kita perlu mewaspadai bias model. Proyek ini sebenarnya menunjukkan bahwa GPT-4 mungkin menginginkan jawaban yang lebih panjang.

Metode evaluasi LLM terus berkembang seiring dengan pencarian komunitas AI terhadap pendekatan yang mudah, adil, dan terukur. Perkembangan terbaru datang dari tim di Toloka dengan yang baru leaderboard untuk lebih memajukan standar evaluasi saat ini.

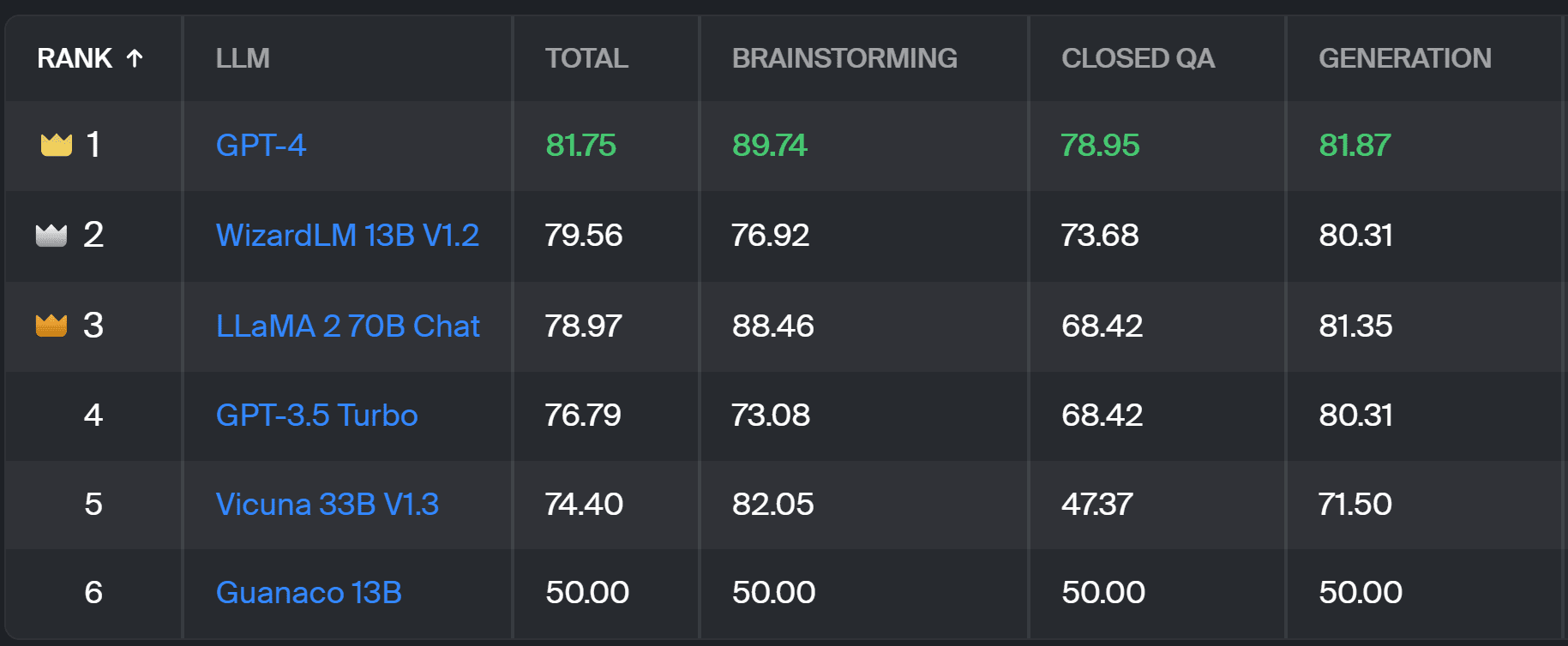

Baru leaderboard membandingkan respons model dengan perintah pengguna di dunia nyata yang dikategorikan berdasarkan tugas NLP berguna sebagaimana diuraikan dalam makalah InstructGPT ini. Ini juga menunjukkan tingkat kemenangan keseluruhan setiap model di semua kategori.

Papan peringkat Toloka – tangkapan layar oleh Penulis

Evaluasi yang digunakan untuk proyek ini serupa dengan yang dilakukan di AlpacaEval. Skor di papan peringkat mewakili tingkat kemenangan masing-masing model dibandingkan dengan Guanaco 13B model, yang berfungsi di sini sebagai perbandingan dasar. Pemilihan Guanaco 13B merupakan penyempurnaan dari metode AlpacaEval, yang menggunakan model text-davinci-003 yang akan segera ketinggalan zaman sebagai dasar.

Evaluasi sebenarnya dilakukan oleh anotator ahli manusia berdasarkan serangkaian petunjuk di dunia nyata. Untuk setiap prompt, anotator diberikan dua penyelesaian dan ditanya mana yang mereka sukai. Anda dapat menemukan detail tentang metodologinya di sini.

Jenis evaluasi manusia ini lebih berguna dibandingkan metode evaluasi otomatis lainnya dan harus memperbaiki evaluasi manusia yang digunakan Papan peringkat LMSYS. Kelemahan dari metode LMSYS adalah siapa pun yang memiliki link dapat mengambil bagian dalam evaluasi, sehingga menimbulkan pertanyaan serius mengenai kualitas data yang dikumpulkan dengan cara ini. Kumpulan anotator ahli yang tertutup memiliki potensi lebih baik untuk mendapatkan hasil yang andal, dan Toloka menerapkan teknik kontrol kualitas tambahan untuk memastikan kualitas data.

Dalam artikel ini, kami telah memperkenalkan solusi baru yang menjanjikan untuk mengevaluasi LLM — Papan Peringkat Toloka. Pendekatannya inovatif, menggabungkan kekuatan metode yang ada, menambahkan rincian tugas tertentu, dan menggunakan teknik anotasi manusia yang andal untuk membandingkan model.

Jelajahi papan, dan bagikan pendapat dan saran Anda untuk perbaikan bersama kami.

Magdalena Konkiewicz adalah Data Evangelist di Toloka, sebuah perusahaan global yang mendukung pengembangan AI yang cepat dan terukur. Dia meraih gelar Master di bidang Kecerdasan Buatan dari Universitas Edinburgh dan pernah bekerja sebagai Insinyur NLP, Pengembang, dan Ilmuwan Data untuk bisnis di Eropa dan Amerika. Dia juga terlibat dalam mengajar dan membimbing Ilmuwan Data dan secara teratur berkontribusi pada publikasi Ilmu Data dan Pembelajaran Mesin.

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- PlatoData.Jaringan Vertikal Generatif Ai. Berdayakan Diri Anda. Akses Di Sini.

- PlatoAiStream. Intelijen Web3. Pengetahuan Diperkuat. Akses Di Sini.

- PlatoESG. Karbon, teknologi bersih, energi, Lingkungan Hidup, Tenaga surya, Penanganan limbah. Akses Di Sini.

- PlatoHealth. Kecerdasan Uji Coba Biotek dan Klinis. Akses Di Sini.

- Sumber: https://www.kdnuggets.com/a-better-way-to-evaluate-llms?utm_source=rss&utm_medium=rss&utm_campaign=a-better-way-to-evaluate-llms

- :memiliki

- :adalah

- :bukan

- :Di mana

- $NAIK

- 17

- a

- kemampuan

- Tentang Kami

- atas

- di seluruh

- sebenarnya

- sebenarnya

- Tambahan

- Menambahkan

- memajukan

- uang muka

- AI

- Semua

- juga

- Amerika

- an

- dan

- menjawab

- jawaban

- Apa pun

- berlaku

- pendekatan

- pendekatan

- ADALAH

- Arena

- artikel

- buatan

- kecerdasan buatan

- AS

- At

- secara otomatis

- sadar

- b

- Dasar

- BE

- karena

- menjadi

- Lebih baik

- bias

- Terbesar

- papan

- tubuh

- Terbawa

- bisnis

- tapi

- by

- CAN

- mampu

- kasus

- kategori

- menantang

- Cek

- pilihan

- klasifikasi

- jelas

- tertutup

- menggabungkan

- datang

- masyarakat

- perusahaan

- membandingkan

- dibandingkan

- pembandingan

- perbandingan

- Konsensus

- Konten

- pembuatan konten

- terus-menerus

- berkontribusi

- kontrol

- Percakapan

- berkorespondensi

- dibuat

- penciptaan

- orang banyak

- dikuratori

- terbaru

- data

- kualitas data

- ilmu data

- ilmuwan data

- kumpulan data

- memutuskan

- definisi

- Derajat

- rincian

- Pengembang

- Pengembangan

- perbedaan

- berbeda

- Kerugian

- beberapa

- do

- tidak

- melakukan

- dilakukan

- Dont

- Kelemahan

- setiap

- Mudah

- Edinburgh

- efek

- upaya

- elektrolit

- insinyur

- memastikan

- Eropa

- mengevaluasi

- dievaluasi

- mengevaluasi

- evaluasi

- Pengabar Injil

- berkembang

- memeriksa

- contoh

- ada

- diharapkan

- ahli

- fakta

- adil

- FAST

- mendukung

- Fitur

- Menemukan

- Pertama

- Untuk

- bentuk

- empat

- Gratis

- dari

- lebih lanjut

- Mendapatkan

- dikumpulkan

- menghasilkan

- generatif

- mendapatkan

- GitHub

- diberikan

- Aksi

- baik

- pekerjaan yang baik

- Sulit

- sulit

- Memiliki

- di sini

- sangat

- memegang

- Seterpercayaapakah Olymp Trade? Kesimpulan

- HTTPS

- MemelukWajah

- manusia

- penting

- memperbaiki

- perbaikan

- perbaikan

- meningkatkan

- in

- informasi

- mulanya

- inovatif

- Intelijen

- menarik

- diperkenalkan

- Memperkenalkan

- terlibat

- IT

- NYA

- Pekerjaan

- hanya

- hanya satu

- KDnugget

- Tahu

- Kekurangan

- bahasa

- besar

- Terbaru

- pengetahuan

- leveraging

- cahaya

- lagi

- lepas

- mesin

- Mesin belajar

- mempertahankan

- MEMBUAT

- cara

- Massa

- menguasai

- Mungkin..

- mentoring

- metode

- Metodologi

- metode

- metrik

- model

- model

- lebih

- paling

- otot

- Perlu

- New

- solusi baru

- nLP

- of

- lebih tua

- on

- ONE

- Buka

- Pendapat

- Lainnya

- diuraikan

- secara keseluruhan

- bagian

- melakukan

- prestasi

- dilakukan

- plato

- Kecerdasan Data Plato

- Data Plato

- potensi

- lebih suka

- sebelumnya

- mungkin

- Masalah

- masalah

- proses

- proyek

- menjanjikan

- meminta

- tepat

- disediakan

- publikasi

- kualitas

- pertanyaan

- Pertanyaan

- pemeliharaan

- Penilaian

- dunia nyata

- secara teratur

- dapat diandalkan

- diganti

- Pelaporan

- mewakili

- itu

- tanggapan

- tanggapan

- mengakibatkan

- Hasil

- Naik

- Run

- s

- terukur

- Skala

- Ilmu

- ilmuwan

- ilmuwan

- skor

- mencetak gol

- pencarian

- tampaknya

- terlihat

- serius

- melayani

- set

- beberapa

- Share

- dia

- harus

- ditunjukkan

- Pertunjukkan

- sisi

- mirip

- tunggal

- larutan

- Memecahkan

- beberapa

- kadang-kadang

- tertentu

- kecepatan

- standar

- standar

- kekuatan

- seperti itu

- pendukung

- Mengambil

- tugas

- Pengajaran

- tim

- teknik

- uji

- teks

- dari

- bahwa

- Grafik

- mereka

- Mereka

- Sana.

- Ini

- mereka

- ini

- untuk

- Kepercayaan

- dua

- mengetik

- khas

- universitas

- atas

- us

- penggunaan

- menggunakan

- gunakan case

- bekas

- Pengguna

- kegunaan

- menggunakan

- biasa

- variasi

- Cara..

- we

- kelemahan

- BAIK

- terkenal

- adalah

- Apa

- Apa itu

- yang

- menang

- dengan

- dalam

- bekerja

- kamu

- Anda

- zephyrnet.dll