07 फरवरी, 2023 (

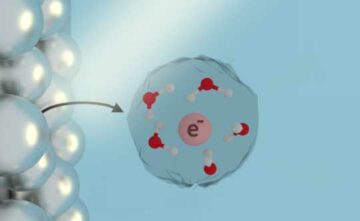

नानावरक न्यूज़) OpenAI के GPT-3 जैसे बड़े भाषा मॉडल बड़े पैमाने पर तंत्रिका नेटवर्क हैं जो कविता से लेकर प्रोग्रामिंग कोड तक मानव-जैसे पाठ उत्पन्न कर सकते हैं। इंटरनेट डेटा के भंडार का उपयोग करके प्रशिक्षित, ये मशीन-लर्निंग मॉडल इनपुट टेक्स्ट का एक छोटा सा हिस्सा लेते हैं और फिर उस टेक्स्ट की भविष्यवाणी करते हैं जो अगले आने की संभावना है। लेकिन ये सभी मॉडल इतना ही नहीं कर सकते। शोधकर्ता एक विचित्र घटना की खोज कर रहे हैं जिसे संदर्भ-आधारित शिक्षण के रूप में जाना जाता है, जिसमें एक बड़ा भाषा मॉडल केवल कुछ उदाहरण देखने के बाद किसी कार्य को पूरा करना सीखता है - इस तथ्य के बावजूद कि उसे उस कार्य के लिए प्रशिक्षित नहीं किया गया था। उदाहरण के लिए, कोई मॉडल को कई उदाहरण वाक्य और उनकी भावनाएं (सकारात्मक या नकारात्मक) खिला सकता है, फिर उसे एक नया वाक्य बता सकता है और मॉडल सही भावना दे सकता है। आमतौर पर, GPT-3 जैसे मशीन-लर्निंग मॉडल को इस नए कार्य के लिए नए डेटा के साथ फिर से प्रशिक्षित करने की आवश्यकता होगी। इस प्रशिक्षण प्रक्रिया के दौरान, मॉडल अपने मापदंडों को अपडेट करता है क्योंकि यह कार्य सीखने के लिए नई जानकारी संसाधित करता है। लेकिन संदर्भ में सीखने के साथ, मॉडल के पैरामीटर अपडेट नहीं किए जाते हैं, इसलिए ऐसा लगता है जैसे मॉडल कुछ भी सीखे बिना एक नया कार्य सीखता है। एमआईटी, गूगल रिसर्च और स्टैनफोर्ड यूनिवर्सिटी के वैज्ञानिक इस रहस्य को जानने का प्रयास कर रहे हैं। उन्होंने ऐसे मॉडलों का अध्ययन किया जो बड़े भाषा मॉडलों के समान हैं, यह देखने के लिए कि वे मापदंडों को अपडेट किए बिना कैसे सीख सकते हैं। शोधकर्ताओं के सैद्धांतिक परिणाम बताते हैं कि ये विशाल तंत्रिका नेटवर्क मॉडल अपने अंदर छिपे छोटे, सरल रैखिक मॉडल को समाहित करने में सक्षम हैं। बड़ा मॉडल तब इस छोटे, रैखिक मॉडल को एक नए कार्य को पूरा करने के लिए प्रशिक्षित करने के लिए एक सरल शिक्षण एल्गोरिदम लागू कर सकता है, केवल बड़े मॉडल के भीतर पहले से मौजूद जानकारी का उपयोग करके। इसके पैरामीटर फिक्स रहते हैं. एक कंप्यूटर विज्ञान स्नातक छात्र और एक पेपर के मुख्य लेखक एकिन अक्युरेक कहते हैं, इन-संदर्भ सीखने के पीछे के तंत्र को समझने की दिशा में एक महत्वपूर्ण कदम, यह शोध सीखने के एल्गोरिदम के आसपास और अधिक अन्वेषण का द्वार खोलता है जिसे ये बड़े मॉडल लागू कर सकते हैं।

“What learning algorithm is in-context learning? Investigations with linear models”) इस घटना की खोज। संदर्भ में सीखने की बेहतर समझ के साथ, शोधकर्ता महंगे पुनर्प्रशिक्षण की आवश्यकता के बिना मॉडलों को नए कार्यों को पूरा करने में सक्षम बना सकते हैं। “आमतौर पर, यदि आप इन मॉडलों को ठीक करना चाहते हैं, तो आपको डोमेन-विशिष्ट डेटा एकत्र करने और कुछ जटिल इंजीनियरिंग करने की आवश्यकता है। लेकिन अब हम इसे केवल एक इनपुट, पांच उदाहरण दे सकते हैं, और यह वही पूरा करता है जो हम चाहते हैं। इसलिए संदर्भ में सीखना एक बहुत ही रोमांचक घटना है," अक्युरेक कहते हैं। पेपर में अक्युरेक के साथ शामिल होने वाले हैं गूगल ब्रेन के एक शोध वैज्ञानिक और अल्बर्टा विश्वविद्यालय में कंप्यूटिंग विज्ञान के प्रोफेसर डेल शूरमैन्स; साथ ही वरिष्ठ लेखक जैकब एंड्रियास, एमआईटी इलेक्ट्रिकल इंजीनियरिंग और कंप्यूटर विज्ञान विभाग में एक्स कंसोर्टियम सहायक प्रोफेसर और एमआईटी कंप्यूटर विज्ञान और कृत्रिम बुद्धिमत्ता प्रयोगशाला (सीएसएआईएल) के सदस्य; तेंगयु मा, स्टैनफोर्ड में कंप्यूटर विज्ञान और सांख्यिकी के सहायक प्रोफेसर; और डैनी झोउ, Google Brain के प्रमुख वैज्ञानिक और अनुसंधान निदेशक। यह शोध लर्निंग रिप्रेजेंटेशन पर अंतर्राष्ट्रीय सम्मेलन में प्रस्तुत किया जाएगा।

एक मॉडल के भीतर एक मॉडल

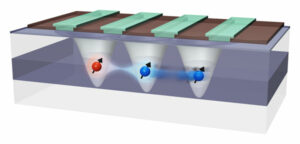

अक्युरेक का कहना है कि मशीन-लर्निंग अनुसंधान समुदाय में, कई वैज्ञानिक यह मानने लगे हैं कि बड़े भाषा मॉडल संदर्भ-आधारित शिक्षण कर सकते हैं क्योंकि उन्हें प्रशिक्षित किया जाता है। उदाहरण के लिए, GPT-3 में सैकड़ों अरब पैरामीटर हैं और इसे विकिपीडिया लेखों से लेकर रेडिट पोस्ट तक इंटरनेट पर बड़ी संख्या में पाठ पढ़कर प्रशिक्षित किया गया था। इसलिए, जब कोई किसी नए कार्य के मॉडल उदाहरण दिखाता है, तो संभवतः उसने पहले से ही कुछ समान देखा है क्योंकि इसके प्रशिक्षण डेटासेट में अरबों वेबसाइटों से पाठ शामिल है। यह नए कार्य करना सीखने के बजाय प्रशिक्षण के दौरान देखे गए पैटर्न को दोहराता है। अक्यूरेक ने परिकल्पना की कि संदर्भ में सीखने वाले न केवल पहले देखे गए पैटर्न से मेल खा रहे हैं, बल्कि वास्तव में नए कार्य करना सीख रहे हैं। उन्होंने और अन्य लोगों ने सिंथेटिक डेटा का उपयोग करके इन मॉडलों को संकेत देकर प्रयोग किया था, जिसे वे पहले कहीं नहीं देख सकते थे, और पाया कि मॉडल अभी भी केवल कुछ उदाहरणों से सीख सकते हैं। अक्यूरेक और उनके सहयोगियों ने सोचा कि शायद इन तंत्रिका नेटवर्क मॉडल के अंदर छोटे मशीन-लर्निंग मॉडल हैं जिन्हें मॉडल एक नया कार्य पूरा करने के लिए प्रशिक्षित कर सकते हैं। वह कहते हैं, "यह सीखने की लगभग सभी घटनाओं को समझा सकता है जो हमने इन बड़े मॉडलों के साथ देखी हैं।" इस परिकल्पना का परीक्षण करने के लिए, शोधकर्ताओं ने ट्रांसफार्मर नामक एक तंत्रिका नेटवर्क मॉडल का उपयोग किया, जिसमें जीपीटी -3 के समान वास्तुकला है, लेकिन विशेष रूप से संदर्भ में सीखने के लिए प्रशिक्षित किया गया था। इस ट्रांसफार्मर की वास्तुकला की खोज करके, उन्होंने सैद्धांतिक रूप से साबित कर दिया कि यह अपने छिपे हुए राज्यों के भीतर एक रैखिक मॉडल लिख सकता है। एक तंत्रिका नेटवर्क परस्पर जुड़े नोड्स की कई परतों से बना होता है जो डेटा को संसाधित करते हैं। छिपी हुई अवस्थाएँ इनपुट और आउटपुट परतों के बीच की परतें हैं। उनके गणितीय मूल्यांकन से पता चलता है कि यह रैखिक मॉडल ट्रांसफार्मर की शुरुआती परतों में कहीं लिखा हुआ है। फिर ट्रांसफार्मर सरल शिक्षण एल्गोरिदम को लागू करके रैखिक मॉडल को अपडेट कर सकता है। संक्षेप में, मॉडल स्वयं के एक छोटे संस्करण का अनुकरण और प्रशिक्षण करता है।

छुपी परतों को टटोलना

शोधकर्ताओं ने जांच प्रयोगों का उपयोग करके इस परिकल्पना का पता लगाया, जहां उन्होंने एक निश्चित मात्रा को पुनर्प्राप्त करने की कोशिश करने के लिए ट्रांसफार्मर की छिपी हुई परतों को देखा। “इस मामले में, हमने रैखिक मॉडल के वास्तविक समाधान को पुनर्प्राप्त करने का प्रयास किया, और हम दिखा सकते हैं कि पैरामीटर छिपे हुए राज्यों में लिखा गया है। इसका मतलब है कि रैखिक मॉडल कहीं न कहीं मौजूद है," वे कहते हैं। इस सैद्धांतिक कार्य का निर्माण करते हुए, शोधकर्ता तंत्रिका नेटवर्क में केवल दो परतें जोड़कर एक ट्रांसफार्मर को संदर्भ में सीखने में सक्षम बनाने में सक्षम हो सकते हैं। अक्युरेक चेतावनी देते हैं कि ऐसा संभव होने से पहले अभी भी कई तकनीकी विवरणों पर काम करना बाकी है, लेकिन यह इंजीनियरों को ऐसे मॉडल बनाने में मदद कर सकता है जो नए डेटा के साथ पुनः प्रशिक्षण की आवश्यकता के बिना नए कार्यों को पूरा कर सकते हैं। आगे बढ़ते हुए, अक्युरेक ने उन कार्यों के साथ संदर्भ-आधारित शिक्षण की खोज जारी रखने की योजना बनाई है जो इस काम में अध्ययन किए गए रैखिक मॉडल की तुलना में अधिक जटिल हैं। वे इन प्रयोगों को बड़े भाषा मॉडलों पर भी लागू कर सकते हैं यह देखने के लिए कि क्या उनके व्यवहार को सरल शिक्षण एल्गोरिदम द्वारा भी वर्णित किया गया है। इसके अलावा, वह प्रीट्रेनिंग डेटा के प्रकारों की गहराई से खोज करना चाहता है जो संदर्भ में सीखने को सक्षम कर सकता है। “इस काम से, लोग अब कल्पना कर सकते हैं कि ये मॉडल उदाहरणों से कैसे सीख सकते हैं। इसलिए, मेरी आशा है कि यह संदर्भ-आधारित शिक्षा के बारे में कुछ लोगों के विचारों को बदल देगा," अक्युरेक कहते हैं। “ये मॉडल उतने मूर्ख नहीं हैं जितना लोग सोचते हैं। वे इन कार्यों को यूं ही याद नहीं रखते। वे नए कार्य सीख सकते हैं, और हमने दिखाया है कि यह कैसे किया जा सकता है।

- एसईओ संचालित सामग्री और पीआर वितरण। आज ही प्रवर्धित हो जाओ।

- प्लेटोब्लॉकचैन। Web3 मेटावर्स इंटेलिजेंस। ज्ञान प्रवर्धित। यहां पहुंचें।

- स्रोत: https://www.nanowerk.com/news2/robotics/newsid=62325.php