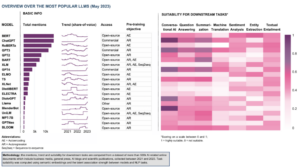

कृत्रिम बुद्धिमत्ता के तेजी से विकसित हो रहे क्षेत्र में, प्राकृतिक भाषा प्रसंस्करण शोधकर्ताओं और डेवलपर्स के लिए एक केंद्र बिंदु बन गया है। की नींव पर निर्माण ट्रांसफार्मर वास्तुकला और BERT का द्विदिशात्मक उन्नयनहाल के वर्षों में कई अभूतपूर्व भाषा मॉडल उभरे हैं, जो मशीनें क्या समझ सकती हैं और क्या उत्पन्न कर सकती हैं, इसकी सीमाओं को आगे बढ़ा रही हैं।

इस लेख में, हम बड़े पैमाने के भाषा मॉडल की दुनिया में नवीनतम प्रगति पर प्रकाश डालेंगे, प्रत्येक मॉडल द्वारा पेश किए गए संवर्द्धन, उनकी क्षमताओं और संभावित अनुप्रयोगों की खोज करेंगे। हम विज़ुअल लैंग्वेज मॉडल (वीएलएम) पर भी गौर करेंगे जो न केवल पाठ्य बल्कि दृश्य डेटा को संसाधित करने के लिए प्रशिक्षित हैं।

यदि आप इधर-उधर जाना चाहते हैं, तो यहां वे भाषा मॉडल हैं जिन्हें हमने प्रदर्शित किया है:

- OpenAI द्वारा GPT-3

- Google द्वारा LaMDA

- Google द्वारा PaLM

- डीपमाइंड द्वारा फ्लेमिंगो

- सेल्सफोर्स द्वारा BLIP-2

- मेटा एआई द्वारा LLaMA

- OpenAI द्वारा GPT-4

यदि यह गहन शैक्षिक सामग्री आपके लिए उपयोगी है, तो आप कर सकते हैं हमारी AI रिसर्च मेलिंग लिस्ट को सब्सक्राइब करें जब हम नई सामग्री जारी करते हैं तो सतर्क रहें।

2023 में सबसे महत्वपूर्ण बड़े भाषा मॉडल (एलएलएम) और दृश्य भाषा मॉडल (वीएलएम)

1. OpenAI द्वारा GPT-3

सारांश

OpenAI टीम ने प्रत्येक नए भाषा कार्य के लिए लेबल किए गए डेटासेट के विकल्प के रूप में GPT-3 पेश किया। उन्होंने सुझाव दिया कि भाषा मॉडल को बढ़ाने से कार्य-अज्ञेयवादी कुछ-शॉट प्रदर्शन में सुधार हो सकता है। इस सुझाव का परीक्षण करने के लिए, उन्होंने 175बी-पैरामीटर ऑटोरेग्रेसिव भाषा मॉडल को प्रशिक्षित किया, जिसे कहा जाता है GPT-3, और दो दर्जन से अधिक एनएलपी कार्यों पर इसके प्रदर्शन का मूल्यांकन किया। फ्यू-शॉट लर्निंग, वन-शॉट लर्निंग और जीरो-शॉट लर्निंग के तहत किए गए मूल्यांकन से पता चलता है कि GPT-3 ने आशाजनक परिणाम प्राप्त किए और यहां तक कि कभी-कभी फाइन-ट्यून किए गए मॉडल द्वारा प्राप्त किए गए अत्याधुनिक परिणामों से भी बेहतर प्रदर्शन किया।

लक्ष्य क्या है?

- मौजूदा समस्या के वैकल्पिक समाधान का सुझाव देने के लिए, जब प्रत्येक नए भाषा कार्य के लिए लेबल किए गए डेटासेट की आवश्यकता होती है।

समस्या से कैसे संपर्क किया जाता है?

- शोधकर्ताओं ने कार्य-अज्ञेयवादी कुछ-शॉट प्रदर्शन को बेहतर बनाने के लिए भाषा मॉडल को बढ़ाने का सुझाव दिया।

- RSI GPT-3 मॉडल GPT-2 के समान मॉडल और आर्किटेक्चर का उपयोग करता है, जिसमें संशोधित आरंभीकरण, पूर्व-सामान्यीकरण और प्रतिवर्ती टोकन शामिल हैं।

- हालांकि, GPT-2 के विपरीत, यह ट्रांसफार्मर की परतों में बारी-बारी से घने और स्थानीय रूप से बंधी विरल ध्यान पैटर्न का उपयोग करता है, जैसा कि विरल ट्रांसफार्मर.

परिणाम क्या हैं?

- ठीक-ट्यूनिंग के बिना GPT-3 मॉडल एनएलपी कार्यों के कई परिणामों पर आशाजनक परिणाम प्राप्त करता है, और यहां तक कि कभी-कभी अत्याधुनिक मॉडलों को पार करता है जो उस विशिष्ट कार्य के लिए ठीक-ठाक थे:

- पर सीओक्यूए बेंचमार्क, शून्य-शॉट सेटिंग में 81.5 एफ 1, एक-शॉट सेटिंग में 84.0 एफ 1, और कुछ शॉट सेटिंग में 85.0 एफ 1, ठीक-ठाक एसओटीए द्वारा प्राप्त 90.7 एफ 1 स्कोर की तुलना में।

- पर सामान्य ज्ञान बेंच -मार्क, शून्य-शॉट सेटिंग में 64.3% सटीकता, एक-शॉट सेटिंग में 68.0%, और कुछ-शॉट सेटिंग में 71.2%, कला की स्थिति (68%) को 3.2% से पार करता है।

- पर Lambada डेटासेट, शून्य-शॉट सेटिंग में 76.2% सटीकता, एक-शॉट सेटिंग में 72.5%, और कुछ शॉट सेटिंग में 86.4%, कला की स्थिति को पार करते हुए (68%) 18%।

- 175B- पैरामीटर GPT-3 मॉडल द्वारा उत्पन्न समाचार लेखों को वास्तविक मूल्यांकन से अलग करना मुश्किल है, मानव मूल्यांकन (~ 52% पर मौका स्तर के ऊपर सटीकता के साथ) के अनुसार।

- GPT-3 के उल्लेखनीय प्रदर्शन के बावजूद, इसे AI समुदाय से मिश्रित समीक्षाएं मिलीं:

- “GPT-3 प्रचार बहुत अधिक है। यह प्रभावशाली है (अच्छी तारीफ के लिए धन्यवाद!) लेकिन इसमें अभी भी गंभीर कमजोरियां हैं और कभी-कभी बहुत ही मूर्खतापूर्ण गलतियां होती हैं। AI दुनिया को बदलने जा रहा है, लेकिन GPT-3 एक बहुत ही शुरुआती झलक है। हमारे पास अभी भी बहुत कुछ है। - सैम Altman, सीईओ और OpenAI के सह-संस्थापक.

- "मैं हैरान हूं कि जीपीटी -3 से मुसलमानों के बारे में पाठ उत्पन्न करना कितना कठिन है, जिसका हिंसा से कोई लेना-देना नहीं है ... या आ रहा है ..." - अबूबकर आबिद, सीईओ और ग्रैडियो के संस्थापक.

- "नहीं। GPT-3 मौलिक रूप से उस दुनिया को नहीं समझता है जिसके बारे में वह बात करता है। आगे कॉर्पस को बढ़ाने से यह एक अधिक विश्वसनीय पेस्टीस उत्पन्न करने की अनुमति देगा, लेकिन दुनिया की समझ की मौलिक कमी को ठीक नहीं करेगा। GPT-4 के डेमो को अभी भी मानव चेरी पिकिंग की आवश्यकता होगी। " - गैरी माक्र्स, सीईओ और Robust.ai के संस्थापक.

- "भविष्य में GPT3 के शानदार प्रदर्शन को विस्तार देने से पता चलता है कि जीवन, ब्रह्मांड और सब कुछ का जवाब सिर्फ 4.398 ट्रिलियन पैरामीटर है।" - जेफ्री हिंटन, ट्यूरिंग अवार्ड विजेता.

इस शोध के बारे में अधिक जानकारी कहाँ से प्राप्त करें?

आप कार्यान्वयन कोड कहां से प्राप्त कर सकते हैं?

- कोड स्वयं उपलब्ध नहीं है, लेकिन जीपीटी -2048 से बिना शर्त, अनफ़िल्टर्ड 3-टोकन नमूने के साथ कुछ डेटासेट आँकड़े जारी किए गए हैं GitHub.

2. Google द्वारा LaMDA

सारांश

Laन्गुएज Mके लिए Dसंवाद Aआवेदन (लाएमडीए) ट्रांसफ़ॉर्मर-आधारित तंत्रिका भाषा मॉडल के एक समूह को फ़ाइन-ट्यूनिंग की प्रक्रिया के माध्यम से बनाया गया था जो विशेष रूप से संवादों के लिए डिज़ाइन किए गए हैं। इन मॉडलों में अधिकतम 137B पैरामीटर हैं और इन्हें ज्ञान के बाहरी स्रोतों का उपयोग करने के लिए प्रशिक्षित किया गया था। LaMDA डेवलपर्स के मन में तीन प्रमुख उद्देश्य थे - गुणवत्ता, सुरक्षा और आधारभूतता। परिणामों ने प्रदर्शित किया कि फाइन-ट्यूनिंग मानव स्तर पर गुणवत्ता के अंतर को कम करने की अनुमति देता है, लेकिन सुरक्षा और आधारभूतता के संबंध में मॉडल का प्रदर्शन मानव स्तर से नीचे रहा।

गूगल के बार्ड, रिहा हाल ही में ChatGPT के विकल्प के रूप में, LaMDA द्वारा संचालित है। बार्ड के रूप में अक्सर लेबल किए जाने के बावजूद बोरिंग, इसे जनरेटिव AI के क्षेत्र में प्रभुत्व स्थापित करने के लिए Google और Microsoft के बीच तीव्र प्रतिद्वंद्विता के बीच भी, सुरक्षा को प्राथमिकता देने के लिए Google की प्रतिबद्धता के प्रमाण के रूप में देखा जा सकता है।

लक्ष्य क्या है?

- ओपन-डोमेन संवाद अनुप्रयोगों के लिए एक मॉडल बनाने के लिए, जहां एक संवाद एजेंट समझदार, संदर्भ के लिए विशिष्ट, विश्वसनीय स्रोतों पर आधारित और नैतिक प्रतिक्रियाओं के साथ किसी भी विषय के बारे में बातचीत करने में सक्षम है।

समस्या से कैसे संपर्क किया जाता है?

- LaMDA पर बनाया गया है ट्रांसफार्मर, एक न्यूरल नेटवर्क आर्किटेक्चर जिसे Google रिसर्च ने 2017 में खोजा और ओपन-सोर्स किया।

- BERT और GPT-3 सहित अन्य बड़े भाषा मॉडल की तरह, LaMDA को टेक्स्ट डेटा के टेराबाइट्स पर प्रशिक्षित किया जाता है ताकि यह सीखा जा सके कि शब्द एक दूसरे से कैसे संबंधित हैं और फिर भविष्यवाणी करते हैं कि आगे कौन से शब्द आने की संभावना है।

- हालांकि, अधिकांश भाषा मॉडल के विपरीत, LaMDA को उन बारीकियों को चुनने के लिए संवाद पर प्रशिक्षित किया गया था जो भाषा के अन्य रूपों से खुली बातचीत को अलग करती हैं।

- इसके जवाबों की समझदारी, सुरक्षा और विशिष्टता को बेहतर बनाने के लिए मॉडल को भी ठीक किया गया है। जबकि "यह अच्छा है" और "मुझे नहीं पता" जैसे वाक्यांश कई संवाद परिदृश्यों में सार्थक हो सकते हैं, वे दिलचस्प और आकर्षक बातचीत की ओर ले जाने की संभावना नहीं रखते हैं।

- LaMDA जनरेटर पहले कई उम्मीदवार प्रतिक्रियाएं उत्पन्न करता है, जो सभी कितने सुरक्षित, समझदार, विशिष्ट और दिलचस्प हैं, इसके आधार पर स्कोर किया जाता है। कम सुरक्षा स्कोर वाली प्रतिक्रियाओं को फ़िल्टर कर दिया जाता है, और फिर शीर्ष क्रम के परिणाम को प्रतिक्रिया के रूप में चुना जाता है।

परिणाम क्या हैं?

- कई प्रयोग बताते हैं कि LaMDA विभिन्न विषयों पर खुली बातचीत में भाग ले सकता है।

- गुणात्मक मूल्यांकन की एक श्रृंखला ने पुष्टि की कि मॉडल की प्रतिक्रियाएँ समझदार, विशिष्ट, दिलचस्प और विश्वसनीय बाहरी स्रोतों पर आधारित होती हैं लेकिन अभी भी सुधार की गुंजाइश है।

- अब तक की गई सभी प्रगति के बावजूद, लेखक यह मानते हैं कि मॉडल में अभी भी कई सीमाएँ हैं जिसके परिणामस्वरूप अनुपयुक्त या हानिकारक प्रतिक्रियाएँ उत्पन्न हो सकती हैं।

इस शोध के बारे में अधिक जानकारी कहाँ से प्राप्त करें?

आप कार्यान्वयन कोड कहां से प्राप्त कर सकते हैं?

- LaMDA के पूर्व-प्रशिक्षण आर्किटेक्चर के लिए एक ओपन-सोर्स PyTorch कार्यान्वयन पर उपलब्ध है GitHub.

3. Google द्वारा PaLM

सारांश

Paवैसे Lपीड़ा Mओडेल (हथेली) 540 बिलियन का पैरामीटर, ट्रांसफॉर्मर-आधारित भाषा मॉडल है। PaLM को 6144 TPU v4 चिप्स पर पाथवे का उपयोग करके प्रशिक्षित किया गया था, जो कई TPU पॉड्स में कुशल प्रशिक्षण के लिए एक नई ML प्रणाली है। मॉडल सैकड़ों भाषा समझ और जनरेशन बेंचमार्क पर अत्याधुनिक परिणाम प्राप्त करने, कुछ-शॉट सीखने में स्केलिंग के लाभों को प्रदर्शित करता है। PaLM मल्टी-स्टेप रीजनिंग कार्यों पर परिष्कृत अत्याधुनिक मॉडलों से बेहतर प्रदर्शन करता है और BIG-बेंच बेंचमार्क पर औसत मानव प्रदर्शन को पार करता है।

लक्ष्य क्या है?

- इस बात की समझ में सुधार करने के लिए कि कैसे बड़े भाषा मॉडल का स्केलिंग कुछ-शॉट सीखने को प्रभावित करता है।

समस्या से कैसे संपर्क किया जाता है?

- मुख्य विचार पाथवे सिस्टम के साथ 540 बिलियन पैरामीटर भाषा मॉडल के प्रशिक्षण को मापना है:

- टीम प्रत्येक पॉड के भीतर मानक डेटा और मॉडल समानता का उपयोग करते हुए दो क्लाउड टीपीयू v4 पॉड्स में पॉड स्तर पर डेटा समांतरता का उपयोग कर रही थी।

- वे प्रशिक्षण को 6144 टीपीयू v4 चिप्स तक बढ़ाने में सक्षम थे, जो अब तक के प्रशिक्षण के लिए उपयोग किया जाने वाला सबसे बड़ा टीपीयू-आधारित सिस्टम कॉन्फ़िगरेशन है।

- मॉडल ने 57.8% हार्डवेयर FLOPs उपयोग की प्रशिक्षण दक्षता हासिल की, जो कि लेखकों का दावा है, इस पैमाने पर बड़े भाषा मॉडल के लिए अभी तक हासिल की गई उच्चतम प्रशिक्षण दक्षता है।

- PaLM मॉडल के प्रशिक्षण डेटा में उच्च गुणवत्ता वाले वेब दस्तावेज़, पुस्तकें, विकिपीडिया, वार्तालाप और GitHub कोड वाले अंग्रेज़ी और बहुभाषी डेटासेट का संयोजन शामिल था।

परिणाम क्या हैं?

- कई प्रयोगों से पता चलता है कि जैसे-जैसे टीम ने अपने सबसे बड़े मॉडल को बढ़ाया, मॉडल के प्रदर्शन में तेजी से वृद्धि हुई।

- PaLM 540B ने कई बहुत कठिन कार्यों पर सफलता हासिल की:

- भाषा समझ और पीढ़ी. पेश किए गए मॉडल ने 28 में से 29 कार्यों पर पिछले बड़े मॉडलों के कुछ-शॉट प्रदर्शन को पार कर लिया, जिसमें प्रश्न-उत्तर कार्य, क्लोज़ और वाक्य-पूर्ण कार्य, संदर्भ में पढ़ने की समझ के कार्य, सामान्य ज्ञान तर्क कार्य, सुपरग्लू कार्य और शामिल हैं। अधिक। बीआईजी-बेंच कार्यों पर पीएएलएम के प्रदर्शन ने दिखाया कि यह कारण और प्रभाव को अलग कर सकता है, साथ ही उपयुक्त संदर्भों में वैचारिक संयोजनों को समझ सकता है।

- विचार. 8-शॉट प्रॉम्प्टिंग के साथ, PaLM GSM58K में 8% समस्याओं का समाधान करता है, जो कि ग्रेड स्कूल स्तर के हजारों चुनौतीपूर्ण गणित प्रश्नों का बेंचमार्क है, जो GPT-55 3B मॉडल को फाइन-ट्यूनिंग करके हासिल किए गए 175% के पूर्व शीर्ष स्कोर से बेहतर प्रदर्शन करता है। PaLM उन स्थितियों में स्पष्ट स्पष्टीकरण उत्पन्न करने की क्षमता भी प्रदर्शित करता है जिनमें बहु-चरण तार्किक अनुमान, विश्व ज्ञान और गहरी भाषा समझ के जटिल संयोजन की आवश्यकता होती है।

- कोड पीढ़ी. PaLM प्रशिक्षण के लिए 12 गुना कम पायथन कोड का उपयोग करते हुए फाइन-ट्यून कोडेक्स 50B के बराबर प्रदर्शन करता है, यह पुष्टि करता है कि बड़े भाषा मॉडल अन्य प्रोग्रामिंग भाषाओं और प्राकृतिक भाषा डेटा दोनों से सीखने को अधिक प्रभावी ढंग से स्थानांतरित करते हैं।

इस शोध के बारे में अधिक जानकारी कहाँ से प्राप्त करें?

आप कार्यान्वयन कोड कहां से प्राप्त कर सकते हैं?

- PaLM शोध पत्र से विशिष्ट ट्रांसफार्मर आर्किटेक्चर का एक अनौपचारिक PyTorch कार्यान्वयन पर उपलब्ध है GitHub. यह पैमाना नहीं होगा और केवल शैक्षिक उद्देश्यों के लिए प्रकाशित किया जाता है।

4. डीपमाइंड द्वारा फ्लेमिंगो

सारांश

फ्लेमिंगो विज़ुअल लैंग्वेज मॉडल (वीएलएम) का एक अत्याधुनिक परिवार है, जो मिश्रित पाठ और छवियों के साथ बड़े पैमाने पर मल्टीमॉडल वेब कॉर्पोरा पर प्रशिक्षित है। इस प्रशिक्षण के साथ, मॉडल संकेत के रूप में प्रदान किए गए न्यूनतम एनोटेट उदाहरणों का उपयोग करके नए कार्यों को अनुकूलित कर सकते हैं। फ्लेमिंगो में प्रमुख वास्तुशिल्प प्रगति को शामिल किया गया है, जो पूर्व-प्रशिक्षित दृष्टि-केवल और भाषा-केवल मॉडल की शक्तियों को मर्ज करने, अलग-अलग इंटरलीव्ड दृश्य और पाठ्य डेटा की प्रक्रिया अनुक्रमों और छवियों या वीडियो को इनपुट के रूप में सहजता से समायोजित करने के लिए डिज़ाइन की गई है। मॉडल दृश्य प्रश्न-उत्तर, कैप्शनिंग कार्य और बहुविकल्पीय दृश्य प्रश्न-उत्तर जैसे छवि और वीडियो कार्यों की एक श्रृंखला के लिए प्रभावशाली अनुकूलन क्षमता प्रदर्शित करते हैं, कुछ-शॉट सीखने में कार्य-विशिष्ट संकेतों का उपयोग करके नए प्रदर्शन मानक स्थापित करते हैं।

लक्ष्य क्या है?

- संक्षिप्त निर्देशों के आधार पर नए कार्यों को जल्दी से सीखने और निष्पादित करने के लिए मल्टीमॉडल मॉडल को सक्षम करने की दिशा में प्रगति करना:

- बड़ी मात्रा में पर्यवेक्षित डेटा पर एक मॉडल को पूर्व-प्रशिक्षित करने, फिर इसे विशिष्ट कार्य के लिए ठीक करने का व्यापक रूप से उपयोग किया जाने वाला प्रतिमान, संसाधन-गहन है और सावधानीपूर्वक प्रति-कार्य हाइपरपैरामीटर ट्यूनिंग के साथ-साथ हजारों एनोटेटेड डेटा बिंदुओं की आवश्यकता होती है।

- वर्तमान मॉडल जो एक विरोधाभासी उद्देश्य का उपयोग करते हैं, वे नए कार्यों के लिए शून्य-शॉट अनुकूलन की अनुमति देते हैं, लेकिन कैप्शनिंग या विज़ुअल प्रश्न-उत्तर जैसे अधिक खुले-अंत वाले कार्यों में कम पड़ जाते हैं क्योंकि उनमें भाषा निर्माण क्षमताओं का अभाव होता है।

- इस शोध का उद्देश्य एक नया मॉडल पेश करना है जो इन मुद्दों को प्रभावी ढंग से संबोधित करता है और कम डेटा वाले क्षेत्रों में बेहतर प्रदर्शन प्रदर्शित करता है।

समस्या से कैसे संपर्क किया जाता है?

- डीपमाइंड ने केवल कुछ इनपुट/आउटपुट उदाहरणों का उपयोग करके, विभिन्न ओपन-एंड विज़न और भाषा कार्यों पर कुछ-शॉट सीखने के लिए डिज़ाइन किए गए फ्लेमिंगो, वीएलएम को पेश किया।

- फ्लेमिंगो मॉडल दृश्य-वातानुकूलित ऑटोरेग्रेसिव टेक्स्ट जेनरेशन मॉडल हैं जो छवियों और/या वीडियो के साथ मिश्रित टेक्स्ट टोकन को संसाधित कर सकते हैं और आउटपुट के रूप में टेक्स्ट उत्पन्न कर सकते हैं।

- फ्लेमिंगो की वास्तुकला में दो पूरक पूर्व-प्रशिक्षित और जमे हुए मॉडल शामिल हैं:

- दृश्य दृश्यों को "समझने" में सक्षम एक दृष्टि मॉडल।

- एक बड़ा भाषा मॉडल जिसे बुनियादी तर्क-वितर्क करने का काम सौंपा गया है।

- नवीन वास्तुकला घटक इन मॉडलों को इस तरह से एकीकृत करते हैं जो उनके कम्प्यूटेशनल रूप से गहन पूर्व-प्रशिक्षण के दौरान प्राप्त ज्ञान को बरकरार रखता है।

- इसके अलावा, फ्लेमिंगो मॉडल में पर्सीवर-आधारित आर्किटेक्चर की सुविधा होती है, जो उन्हें उच्च-रिज़ॉल्यूशन वाली छवियों या वीडियो को ग्रहण करने की अनुमति देता है। यह आर्किटेक्चर विज़ुअल इनपुट सुविधाओं की एक विस्तृत और परिवर्तनीय श्रृंखला से प्रति छवि/वीडियो पर एक निश्चित संख्या में विज़ुअल टोकन उत्पन्न कर सकता है।

परिणाम क्या हैं?

- शोध से पता चलता है कि एलएलएम के समान, जो कुछ-शॉट वाले अच्छे शिक्षार्थी हैं, वीएलएम छवि और वीडियो को समझने के कार्यों जैसे वर्गीकरण, कैप्शनिंग या प्रश्न-उत्तर के लिए कुछ इनपुट/आउटपुट उदाहरणों से सीख सकते हैं।

- फ्लेमिंगो ने 16 मल्टीमॉडल भाषा और छवि/वीडियो समझ कार्यों की एक विस्तृत श्रृंखला पर बेहतर प्रदर्शन का प्रदर्शन करते हुए, कुछ-शॉट सीखने में एक नया मानदंड स्थापित किया है।

- इन 6 कार्यों में से 16 के लिए, फ्लेमिंगो ने अत्याधुनिक प्रदर्शन को बेहतर बनाया है, भले ही यह केवल 32 कार्य-विशिष्ट उदाहरणों का उपयोग करता है - वर्तमान शीर्ष-प्रदर्शन वाले मॉडल की तुलना में लगभग 1000 गुना कम कार्य-विशिष्ट प्रशिक्षण डेटा।

इस शोध के बारे में अधिक जानकारी कहाँ से प्राप्त करें?

आप कार्यान्वयन कोड कहां से प्राप्त कर सकते हैं?

- डीपमाइंड ने फ्लेमिंगो का आधिकारिक कार्यान्वयन जारी नहीं किया।

- आप इसमें प्रस्तुत दृष्टिकोण का खुला स्रोत कार्यान्वयन पा सकते हैं ओपनफ्लेमिंगो जीथब रेपो.

- वैकल्पिक PyTorch कार्यान्वयन उपलब्ध है यहाँ उत्पन्न करें.

5. Salesforce द्वारा BLIP-2

सारांश

BLIP-2 दृष्टि-और-भाषा मॉडल के लिए एक कुशल और सामान्य पूर्व-प्रशिक्षण ढांचा है, जिसे पूर्व-प्रशिक्षण बड़े पैमाने के मॉडल की बढ़ती निषेधात्मक लागत को रोकने के लिए डिज़ाइन किया गया है। BLIP-2 दृष्टि-भाषा पूर्व-प्रशिक्षण को बूटस्ट्रैप करने के लिए ऑफ-द-शेल्फ जमे हुए पूर्व-प्रशिक्षित छवि एन्कोडर्स और जमे हुए बड़े भाषा मॉडल का लाभ उठाता है, जिसमें दो चरणों में पूर्व-प्रशिक्षित हल्के क्वेरी ट्रांसफार्मर को शामिल किया जाता है। पहला चरण एक जमे हुए छवि एनकोडर से दृष्टि-भाषा प्रतिनिधित्व सीखने की शुरुआत करता है, और दूसरा चरण एक जमे हुए भाषा मॉडल से दृष्टि-से-भाषा जनरेटिव सीखने को प्रेरित करता है। काफी कम प्रशिक्षण योग्य पैरामीटर होने के बावजूद, BLIP-2 अत्याधुनिक तरीकों से बेहतर प्रदर्शन करता है, 80x कम प्रशिक्षण योग्य मापदंडों के साथ शून्य-शॉट VQAv8.7 पर डीपमाइंड के फ्लेमिंगो2B को 54% से पीछे छोड़ देता है। मॉडल प्राकृतिक भाषा निर्देशों का पालन करते हुए आशाजनक शून्य-शॉट छवि-से-पाठ पीढ़ी क्षमताओं को भी प्रदर्शित करता है।

लक्ष्य क्या है?

- गणना लागत को कम करते हुए, दृष्टि भाषा कार्यों पर अत्याधुनिक प्रदर्शन प्राप्त करना।

समस्या से कैसे संपर्क किया जाता है?

- सेल्सफोर्स टीम ने BLIP-2 नाम से एक नया विज़न-लैंग्वेज प्री-ट्रेनिंग फ्रेमवर्क पेश किया, Bऊटस्ट्रैपिंग Lपीड़ा-Iदाना Pजमे हुए यूनिमॉडल मॉडल के साथ पुनः प्रशिक्षण:

- गणना लागत को कम करने और भयावह भूलने की समस्या से बचने के लिए पूर्व-प्रशिक्षित यूनिमॉडल मॉडल पूर्व-प्रशिक्षण के दौरान जमे हुए रहते हैं।

- क्रॉस-मोडल संरेखण को सुविधाजनक बनाने और पूर्व-प्रशिक्षित दृष्टि मॉडल और पूर्व-प्रशिक्षित भाषा मॉडल के बीच के अंतर को पाटने के लिए, टीम एक हल्के क्वेरीिंग ट्रांसफार्मर (क्यू-फॉर्मर) का प्रस्ताव करती है जो जमे हुए छवि एनकोडर और जमे हुए छवि एनकोडर के बीच एक सूचना बाधा के रूप में कार्य करता है। एलएलएम.

- क्यू-फॉर्मर को नई दो-चरणीय रणनीति के साथ पूर्व-प्रशिक्षित किया गया है:

- पहला पूर्व-प्रशिक्षण चरण दृष्टि-भाषा प्रतिनिधित्व सीखने का कार्य करता है। यह क्यू-फॉर्मर को पाठ के लिए सबसे अधिक प्रासंगिक दृश्य प्रतिनिधित्व सीखने के लिए लागू करता है।

- दूसरा प्री-ट्रेनिंग चरण क्यू-फॉर्मर के आउटपुट को फ्रोजन एलएलएम से जोड़कर विज़न-टू-लैंग्वेज जेनरेटर लर्निंग करता है। क्यू-फॉर्मर को इस तरह प्रशिक्षित किया गया है कि इसके आउटपुट विज़ुअल प्रतिनिधित्व की व्याख्या एलएलएम द्वारा की जा सकती है।

परिणाम क्या हैं?

- BLIP-2 विभिन्न दृष्टि-भाषा कार्यों में असाधारण, अत्याधुनिक परिणाम प्रदान करता है, जिसमें दृश्य प्रश्न उत्तर, छवि कैप्शनिंग और छवि-पाठ पुनर्प्राप्ति शामिल है।

- उदाहरण के लिए, यह शून्य-शॉट VQAv8.7 पर फ्लेमिंगो से 2% बेहतर प्रदर्शन करता है।

- इसके अलावा, यह उत्कृष्ट प्रदर्शन काफी अधिक कंप्यूटर दक्षता के साथ हासिल किया गया है:

- 2× कम प्रशिक्षण योग्य मापदंडों का उपयोग करते हुए बीएलआईपी-80 फ्लेमिंगो-54बी से बेहतर प्रदर्शन करता है।

- BLIP-2 में प्राकृतिक भाषा निर्देशों के जवाब में शून्य-शॉट छवि-से-पाठ पीढ़ी शुरू करने की क्षमता है, जिससे दृश्य ज्ञान तर्क और दृश्य वार्तालाप जैसे कौशल विकसित करने का मार्ग प्रशस्त होता है।

- अंत में, यह ध्यान रखना महत्वपूर्ण है कि BLIP-2 एक बहुमुखी दृष्टिकोण है जो दृष्टि-भाषा पूर्व-प्रशिक्षण के प्रदर्शन को और बढ़ाने के लिए अधिक परिष्कृत यूनिमॉडल मॉडल का लाभ उठा सकता है।

इस शोध के बारे में अधिक जानकारी कहाँ से प्राप्त करें?

आप कार्यान्वयन कोड कहां से प्राप्त कर सकते हैं?

आधिकारिक BLIP-2 कार्यान्वयन यहां उपलब्ध है GitHub.

6. मेटा एआई द्वारा LLaMA

सारांश

मेटा एआई टीम का दावा है कि अधिक टोकन पर प्रशिक्षित छोटे मॉडल विशिष्ट उत्पाद अनुप्रयोगों के लिए पुन: प्रशिक्षित और फाइन-ट्यून करना आसान है। इसलिए परिचय देते हैं लामा (LARGE Laन्गुएज Mओडेल मेटा AI), 7बी से 65बी पैरामीटर के साथ मूलभूत भाषा मॉडल का संग्रह। LLaMA 33B और 65B को 1.4 ट्रिलियन टोकन पर प्रशिक्षित किया गया था, जबकि सबसे छोटे मॉडल, LLaMA 7B को एक ट्रिलियन टोकन पर प्रशिक्षित किया गया था। वे मालिकाना या प्रतिबंधित डेटा पर निर्भर किए बिना विशेष रूप से सार्वजनिक रूप से उपलब्ध डेटासेट का उपयोग करते थे। टीम ने प्रमुख वास्तुशिल्प संवर्द्धन और प्रशिक्षण गति अनुकूलन तकनीकों को भी लागू किया। नतीजतन, LLaMA-13B ने GPT-3 से बेहतर प्रदर्शन किया, 10 गुना छोटा होने के कारण, और LLaMA-65B ने PaLM-540B के साथ प्रतिस्पर्धी प्रदर्शन प्रदर्शित किया।

लक्ष्य क्या है?

- मालिकाना या प्रतिबंधित डेटा स्रोतों पर भरोसा किए बिना, केवल सार्वजनिक रूप से सुलभ डेटासेट पर शीर्ष प्रदर्शन करने वाले मॉडल को प्रशिक्षित करने की व्यवहार्यता प्रदर्शित करने के लिए।

- अनुसंधान समुदाय को छोटे और अधिक प्रदर्शन करने वाले मॉडल प्रदान करने के लिए और इस प्रकार, बड़े भाषा मॉडल का अध्ययन करने के लिए उन लोगों को सक्षम करें जिनके पास बड़ी मात्रा में बुनियादी ढांचे तक पहुंच नहीं है।

समस्या से कैसे संपर्क किया जाता है?

- LLaMA मॉडल को प्रशिक्षित करने के लिए, शोधकर्ताओं ने केवल उस डेटा का उपयोग किया जो सार्वजनिक रूप से उपलब्ध है, और ओपन सोर्सिंग के अनुकूल है।

- उन्होंने मानक ट्रांसफॉर्मर आर्किटेक्चर में कुछ सुधार भी पेश किए हैं:

- GPT-3 कार्यप्रणाली को अपनाते हुए, आउटपुट को सामान्य करने के बजाय प्रत्येक ट्रांसफ़ॉर्मर सब-लेयर के लिए इनपुट को सामान्य करके प्रशिक्षण की स्थिरता को बढ़ाया गया।

- PaLM मॉडल से प्रेरित होकर, शोधकर्ताओं ने प्रदर्शन को बेहतर बनाने के लिए ReLU गैर-रैखिकता को SwiGLU सक्रियण फ़ंक्शन के साथ बदल दिया।

- से प्रेरित होकर सु एट अल (2021), उन्होंने पूर्ण स्थितीय एम्बेडिंग को समाप्त कर दिया और इसके बजाय, नेटवर्क की प्रत्येक परत पर रोटरी स्थितीय एम्बेडिंग (RoPE) को शामिल किया।

- अंत में, मेटा एआई टीम ने अपने मॉडल की प्रशिक्षण गति में सुधार किया:

- अटेंशन वेट या नकाबपोश कुंजी / क्वेरी स्कोर की गणना न करके कुशल कारण बहु-सिर ध्यान कार्यान्वयन का उपयोग करना।

- बैकवर्ड पास के दौरान पुन: गणना की गई सक्रियता को कम करने के लिए चेकपॉइंटिंग का उपयोग करना।

- नेटवर्क पर जीपीयू के बीच सक्रियता और संचार की गणना को ओवरलैप करना (all_reduce संचालन के कारण)।

परिणाम क्या हैं?

- LLaMA-13B 3 गुना छोटा होने के बावजूद GPT-10 से आगे निकल जाता है, जबकि LLaMA-65B PaLM-540B के खिलाफ अपनी पकड़ रखता है।

इस शोध के बारे में अधिक जानकारी कहाँ से प्राप्त करें?

आप कार्यान्वयन कोड कहां से प्राप्त कर सकते हैं?

- मेटा एआई अकादमिक शोधकर्ताओं, सरकार से जुड़े व्यक्तियों, नागरिक समाज, शैक्षणिक संस्थानों और वैश्विक उद्योग अनुसंधान प्रयोगशालाओं को एक व्यक्तिगत मामले के मूल्यांकन के आधार पर LLaMA तक पहुंच प्रदान करता है। आवेदन करने के लिए निम्नलिखित पर जाएं गिटहब भंडार.

7. OpenAI द्वारा GPT-4

सारांश

GPT-4 एक बड़े पैमाने का मल्टीमॉडल मॉडल है जो इमेज और टेक्स्ट इनपुट को स्वीकार करता है और टेक्स्ट आउटपुट उत्पन्न करता है। प्रतिस्पर्धी और सुरक्षा चिंताओं के कारण, मॉडल की वास्तुकला और प्रशिक्षण के बारे में विशिष्ट विवरण रोके गए हैं। प्रदर्शन के संदर्भ में, GPT-4 पारंपरिक बेंचमार्क पर पिछले भाषा मॉडल को पार करता है और उपयोगकर्ता की समझ और सुरक्षा गुणों में महत्वपूर्ण सुधार दिखाता है। मॉडल विभिन्न परीक्षाओं में मानव-स्तर के प्रदर्शन को भी प्राप्त करता है, जिसमें सिम्युलेटेड यूनिफ़ॉर्म बार परीक्षा पर शीर्ष 10% स्कोर शामिल है।

लक्ष्य क्या है?

- एक बड़े पैमाने पर, मल्टीमॉडल मॉडल विकसित करने के लिए जो छवि और टेक्स्ट इनपुट स्वीकार कर सकता है और टेक्स्ट आउटपुट उत्पन्न कर सकता है।

- बुनियादी ढांचे और अनुकूलन विधियों को विकसित करने के लिए जो व्यापक पैमाने पर व्यापक रूप से व्यवहार करते हैं।

समस्या से कैसे संपर्क किया जाता है?

- प्रतिस्पर्धी परिदृश्य और सुरक्षा निहितार्थों के कारण, OpenAI ने आर्किटेक्चर, मॉडल आकार, हार्डवेयर, प्रशिक्षण कंप्यूट, डेटासेट निर्माण और प्रशिक्षण विधियों पर विवरण वापस लेने का निर्णय लिया।

- वे खुलासा करते हैं कि:

- GPT-4 एक ट्रांसफार्मर-आधारित मॉडल है, जो दस्तावेज़ में अगले टोकन की भविष्यवाणी करने के लिए पूर्व-प्रशिक्षित है।

- यह सार्वजनिक रूप से उपलब्ध डेटा और तीसरे पक्ष के लाइसेंस प्राप्त डेटा का उपयोग करता है।

- मानव प्रतिक्रिया (RLHF) से सुदृढीकरण सीखने का उपयोग करके मॉडल को ठीक किया गया था।

- अपुष्ट जानकारी से पता चलता है कि GPT-4 अपने पूर्ववर्तियों की तरह एक एकल सघन मॉडल नहीं है, बल्कि आठ अलग-अलग मॉडलों का एक पावरहाउस गठबंधन है, जिनमें से प्रत्येक में 220 बिलियन पैरामीटर हैं।

परिणाम क्या हैं?

- GPT-4 अधिकांश पेशेवर और शैक्षणिक परीक्षाओं में मानव-स्तर का प्रदर्शन प्राप्त करता है, विशेष रूप से सिम्युलेटेड यूनिफ़ॉर्म बार परीक्षा में शीर्ष 10% में स्कोरिंग।

- पूर्व-प्रशिक्षित आधार GPT-4 मॉडल बेंचमार्क-विशिष्ट क्राफ्टिंग या अतिरिक्त प्रशिक्षण प्रोटोकॉल के बिना, पारंपरिक एनएलपी बेंचमार्क पर मौजूदा भाषा मॉडल और पूर्व अत्याधुनिक प्रणालियों को बेहतर बनाता है।

- चैटजीपीटी और ओपनएआई एपीआई के 4 संकेतों में से 3.5% में जीपीटी-70.2 की प्रतिक्रियाओं पर अपनी प्रतिक्रियाओं को प्राथमिकता देने के साथ जीपीटी-5,214 निम्नलिखित उपयोगकर्ता के इरादे में पर्याप्त सुधार प्रदर्शित करता है।

- GPT-4 की तुलना में GPT-3.5 के सुरक्षा गुणों में काफी सुधार हुआ है, अस्वीकृत सामग्री अनुरोधों के जवाब में 82% की कमी और संवेदनशील अनुरोधों (जैसे, चिकित्सा सलाह और आत्म-नुकसान) के लिए नीतियों के अनुपालन में 29% की वृद्धि हुई है।

इस शोध के बारे में अधिक जानकारी कहाँ से प्राप्त करें?

आप कार्यान्वयन कोड कहां से प्राप्त कर सकते हैं?

- GPT-4 का कोड कार्यान्वयन उपलब्ध नहीं है।

बड़े (विज़न) भाषा मॉडल के वास्तविक दुनिया के अनुप्रयोग

हाल के वर्षों की सबसे महत्वपूर्ण एआई अनुसंधान सफलताएँ बड़े डेटासेट पर प्रशिक्षित बड़े एआई मॉडल से आती हैं। ये मॉडल प्रभावशाली प्रदर्शन प्रदर्शित करते हैं, और यह सोचना आकर्षक है कि एआई ग्राहक सेवा, विपणन, ई-कॉमर्स, स्वास्थ्य सेवा, सॉफ्टवेयर विकास, पत्रकारिता और कई अन्य जैसे पूरे उद्योगों में कैसे क्रांति ला सकता है।

बड़े भाषा मॉडल में कई वास्तविक दुनिया के अनुप्रयोग होते हैं। GPT-4 निम्नलिखित को सूचीबद्ध करता है:

- चैटबॉट्स और आभासी सहायकों के लिए प्राकृतिक भाषा समझ और पीढ़ी।

- भाषाओं के बीच मशीनी अनुवाद।

- लेखों, रिपोर्टों, या अन्य टेक्स्ट दस्तावेज़ों का सारांश।

- मार्केट रिसर्च या सोशल मीडिया मॉनिटरिंग के लिए सेंटीमेंट एनालिसिस।

- मार्केटिंग, सोशल मीडिया या रचनात्मक लेखन के लिए सामग्री निर्माण।

- ग्राहक सहायता या ज्ञान के आधार के लिए प्रश्न-उत्तर प्रणाली।

- स्पैम फ़िल्टरिंग, विषय वर्गीकरण, या दस्तावेज़ संगठन के लिए टेक्स्ट वर्गीकरण।

- वैयक्तिकृत भाषा शिक्षण और शिक्षण उपकरण।

- कोड जनरेशन और सॉफ्टवेयर विकास सहायता।

- चिकित्सा, कानूनी और तकनीकी दस्तावेज़ विश्लेषण और सहायता।

- विकलांग व्यक्तियों के लिए अभिगम्यता उपकरण, जैसे टेक्स्ट-टू-स्पीच और स्पीच-टू-टेक्स्ट रूपांतरण।

- भाषण मान्यता और प्रतिलेखन सेवाएं।

यदि हम एक दृश्य भाग जोड़ते हैं, तो संभावित अनुप्रयोगों के क्षेत्रों का और विस्तार होता है:

हाल की एआई सफलताओं का अनुसरण करना और उनके संभावित वास्तविक दुनिया के अनुप्रयोगों के बारे में सोचना बहुत ही रोमांचक है। हालांकि, इन मॉडलों को वास्तविक जीवन में लागू करने से पहले हमें संबंधित जोखिमों और सीमाओं को संबोधित करने की आवश्यकता है, जो दुर्भाग्य से काफी महत्वपूर्ण हैं।

जोखिम और सीमाएं

यदि आप GPT-4 से इसके जोखिमों और सीमाओं के बारे में पूछते हैं, तो यह संभवतः आपको प्रासंगिक चिंताओं की एक लंबी सूची प्रदान करेगा। इस सूची के माध्यम से छानने और कुछ अतिरिक्त विचार जोड़ने के बाद, मैं आधुनिक बड़े भाषा मॉडल के प्रमुख जोखिमों और सीमाओं के निम्नलिखित सेट के साथ समाप्त हो गया हूं:

- पक्षपात और भेदभाव: ये मॉडल बड़ी मात्रा में टेक्स्ट डेटा से सीखते हैं, जिसमें अक्सर पूर्वाग्रह और भेदभावपूर्ण सामग्री होती है। परिणामस्वरूप, उत्पन्न आउटपुट अनजाने में लिंग, जाति या धर्म जैसे कारकों के आधार पर रूढ़िवादिता, आपत्तिजनक भाषा और भेदभाव को समाप्त कर सकते हैं।

- झूठी खबर: बड़े भाषा मॉडल ऐसी सामग्री उत्पन्न कर सकते हैं जो तथ्यात्मक रूप से गलत, भ्रामक या पुरानी हो। जबकि मॉडल को विभिन्न प्रकार के स्रोतों पर प्रशिक्षित किया जाता है, वे हमेशा सबसे सटीक या अद्यतित जानकारी प्रदान नहीं कर सकते हैं। अक्सर ऐसा इसलिए होता है क्योंकि मॉडल ऐसे आउटपुट उत्पन्न करने को प्राथमिकता देता है जो व्याकरणिक रूप से सही हों या सुसंगत प्रतीत हों, भले ही वे भ्रामक हों।

- तालमेल की कमी: हालांकि ये मॉडल मानव भाषा को समझते हैं, वे मुख्य रूप से प्रशिक्षण डेटा में पैटर्न और सांख्यिकीय संघों की पहचान करके काम करते हैं। उन्हें अपने द्वारा उत्पन्न सामग्री की गहरी समझ नहीं होती है, जिसके परिणामस्वरूप कभी-कभी निरर्थक या अप्रासंगिक आउटपुट हो सकते हैं।

- अनुचित सामग्री: भाषा मॉडल कभी-कभी आपत्तिजनक, हानिकारक या अनुपयुक्त सामग्री उत्पन्न कर सकते हैं। हालांकि इस तरह की सामग्री को कम करने के प्रयास किए जाते हैं, फिर भी यह प्रशिक्षण डेटा की प्रकृति और संदर्भ या उपयोगकर्ता के इरादे को समझने में मॉडलों की अक्षमता के कारण हो सकता है।

निष्कर्ष

बड़े भाषा मॉडल ने निस्संदेह प्राकृतिक भाषा प्रसंस्करण के क्षेत्र में क्रांति ला दी है और विभिन्न भूमिकाओं और उद्योगों में उत्पादकता बढ़ाने की अपार क्षमता का प्रदर्शन किया है। मानव-समान पाठ उत्पन्न करने, सांसारिक कार्यों को स्वचालित करने और रचनात्मक और विश्लेषणात्मक प्रक्रियाओं में सहायता प्रदान करने की उनकी क्षमता ने उन्हें आज की तेज़-तर्रार, प्रौद्योगिकी-संचालित दुनिया में अपरिहार्य उपकरण बना दिया है।

हालांकि, इन शक्तिशाली मॉडलों से जुड़ी सीमाओं और जोखिमों को स्वीकार करना और समझना महत्वपूर्ण है। पूर्वाग्रह, गलत सूचना और दुर्भावनापूर्ण उपयोग की संभावना जैसे मुद्दों को नजरअंदाज नहीं किया जा सकता है। जैसा कि हम इन एआई-संचालित तकनीकों को अपने दैनिक जीवन में एकीकृत करना जारी रखते हैं, विशेष रूप से संवेदनशील और उच्च जोखिम वाली स्थितियों में उनकी क्षमताओं का लाभ उठाने और मानव पर्यवेक्षण सुनिश्चित करने के बीच संतुलन बनाना आवश्यक है।

यदि हम जिम्मेदारी से जनरेटिव एआई तकनीकों को अपनाने में सफल होते हैं, तो हम एक ऐसे भविष्य का मार्ग प्रशस्त करेंगे जहां कृत्रिम बुद्धिमत्ता और मानव विशेषज्ञता एक साथ मिलकर नवाचार को चलाने और सभी के लिए एक बेहतर दुनिया बनाने के लिए काम करेंगे।

इस लेख का आनंद लें? अधिक AI अनुसंधान अपडेट के लिए साइन अप करें।

जब हम इस तरह के और अधिक सारांश लेख जारी करते हैं तो हम आपको बताएंगे।

सम्बंधित

- एसईओ संचालित सामग्री और पीआर वितरण। आज ही प्रवर्धित हो जाओ।

- प्लेटोडेटा.नेटवर्क वर्टिकल जेनरेटिव एआई। स्वयं को शक्तिवान बनाएं। यहां पहुंचें।

- प्लेटोआईस्ट्रीम। Web3 इंटेलिजेंस। ज्ञान प्रवर्धित। यहां पहुंचें।

- प्लेटोईएसजी. ऑटोमोटिव/ईवीएस, कार्बन, क्लीनटेक, ऊर्जा, पर्यावरण, सौर, कचरा प्रबंधन। यहां पहुंचें।

- BlockOffsets. पर्यावरणीय ऑफसेट स्वामित्व का आधुनिकीकरण। यहां पहुंचें।

- स्रोत: https://www.topbots.com/top-language-models-transforming-ai-in-2023/

- :हैस

- :है

- :नहीं

- :कहाँ

- $यूपी

- 1

- 10

- 12b

- 16

- 2%

- 2017

- 2021

- 2023

- 214

- 220

- 28

- 32

- 50

- 7

- 70

- 710

- 72

- 8

- 84

- 90

- a

- क्षमता

- योग्य

- About

- ऊपर

- पूर्ण

- शैक्षिक

- स्वीकार करें

- स्वीकार करता है

- पहुँच

- सुलभ

- समायोजित

- अनुसार

- शुद्धता

- सही

- हासिल

- प्राप्त

- प्राप्त करने

- स्वीकार करना

- के पार

- सक्रियण

- सक्रियता

- कार्य करता है

- अनुकूलन

- अनुकूलन

- जोड़ना

- जोड़ने

- इसके अलावा

- अतिरिक्त

- पता

- पतों

- अपनाने

- प्रगति

- सलाह

- बाद

- के खिलाफ

- एजेंट

- AI

- ai शोध

- करना

- AL

- एक जैसे

- सब

- अनुमति देना

- की अनुमति दे

- की अनुमति देता है

- साथ में

- भी

- वैकल्पिक

- हालांकि

- हमेशा

- बीच में

- के बीच में

- राशि

- राशियाँ

- an

- विश्लेषण

- विश्लेषणात्मक

- और

- अन्य

- जवाब

- कोई

- एपीआई

- दिखाई देते हैं

- अनुप्रयोगों

- लागू करें

- दृष्टिकोण

- उपयुक्त

- लगभग

- वास्तु

- स्थापत्य

- हैं

- क्षेत्रों के बारे में जानकारी का उपयोग करके ट्रेडिंग कर सकते हैं।

- चारों ओर

- ऐरे

- कला

- लेख

- लेख

- कृत्रिम

- कृत्रिम बुद्धिमत्ता

- AS

- सहायता

- सहायकों

- जुड़े

- संघों

- At

- ध्यान

- लेखकों

- को स्वचालित रूप से

- उपलब्ध

- औसत

- से बचने

- पुरस्कार

- शेष

- बार

- आधार

- आधारित

- बुनियादी

- आधार

- BE

- क्योंकि

- बन

- से पहले

- जा रहा है

- नीचे

- बेंचमार्क

- मानक

- लाभ

- बेहतर

- के बीच

- पूर्वाग्रह

- पूर्वाग्रहों

- बिलियन

- पुस्तकें

- जूते का फीता

- के छात्रों

- सीमाओं

- सफलता

- सफलताओं

- पुल

- विस्तृत

- निर्माण

- इमारत

- बनाया गया

- लेकिन

- by

- बुलाया

- कर सकते हैं

- उम्मीदवार

- नही सकता

- क्षमताओं

- सक्षम

- क्षमता

- सावधान

- मामला

- विपत्तिपूर्ण

- कारण

- मुख्य कार्यपालक अधिकारी

- सीईओ और संस्थापक

- चुनौतीपूर्ण

- संयोग

- परिवर्तन

- chatbots

- ChatGPT

- चिप्स

- दावा

- वर्गीकरण

- बादल

- सह-संस्थापक

- कोड

- सुसंगत

- संग्रह

- संयोजन

- संयोजन

- कैसे

- प्रतिबद्धता

- संचार

- समुदाय

- तुलना

- संगत

- प्रतियोगी

- पूरक

- जटिल

- अनुपालन

- घटकों

- गणना

- गणना करना

- कंप्यूटर

- कंप्यूटिंग

- वैचारिक

- चिंताओं

- विन्यास

- की पुष्टि

- कनेक्ट कर रहा है

- इसके फलस्वरूप

- विचार

- निर्माण

- सामग्री

- प्रसंग

- संदर्भों

- जारी रखने के

- इसके विपरीत

- कन्वर्सेशन (Conversation)

- बातचीत

- रूपांतरण

- सही

- इसी

- लागत

- लागत

- सका

- बनाना

- बनाया

- क्रिएटिव

- विश्वसनीय

- महत्वपूर्ण

- वर्तमान

- ग्राहक

- ग्राहक सेवा

- ग्राहक सहयोग

- अग्रणी

- दैनिक

- तिथि

- डेटा अंक

- डेटासेट

- तारीख

- का फैसला किया

- कमी

- गहरा

- Deepmind

- बचाता है

- दिखाना

- साबित

- दर्शाता

- प्रदर्शन

- क़ौम

- निर्भर करता है

- तैनाती

- बनाया गया

- के बावजूद

- विवरण

- विकसित करना

- डेवलपर्स

- विकासशील

- विकास

- बातचीत

- बातचीत

- मुश्किल

- विकलांग

- खुलासा

- भेदभाव

- अंतर करना

- कई

- do

- दस्तावेज़

- दस्तावेजों

- कर देता है

- प्रभुत्व

- dont

- दर्जन

- ड्राइव

- करार दिया

- दो

- दौरान

- e

- ई - कॉमर्स

- ई एंड टी

- से प्रत्येक

- शीघ्र

- आसान

- शैक्षिक

- प्रभाव

- प्रभावी रूप से

- दक्षता

- कुशल

- प्रयासों

- सफाया

- उभरा

- सक्षम

- समर्थकारी

- शामिल

- मनोहन

- अंग्रेज़ी

- बढ़ाना

- वर्धित

- संवर्द्धन

- बढ़ाने

- सुनिश्चित

- आवश्यक

- स्थापित करना

- स्थापित करता

- नैतिक

- मूल्यांकित

- मूल्यांकन

- मूल्यांकन

- और भी

- प्रत्येक

- सब कुछ

- सबूत

- उद्विकासी

- परीक्षा

- उदाहरण

- उदाहरण

- से अधिक

- असाधारण

- उत्तेजक

- अनन्य रूप से

- प्रदर्श

- मौजूदा

- विस्तार

- प्रयोगों

- विशेषज्ञता

- तलाश

- बाहरी

- f1

- की सुविधा

- कारकों

- गिरना

- परिवार

- दूर

- आकर्षक

- तेजी से रफ़्तार

- Feature

- चित्रित किया

- विशेषताएं

- प्रतिक्रिया

- कुछ

- कम

- खेत

- आकृति

- छानने

- खोज

- प्रथम

- फिक्स

- तय

- का पालन करें

- निम्नलिखित

- के लिए

- रूपों

- नींव

- संस्थापक

- ढांचा

- से

- जमे हुए

- समारोह

- मौलिक

- मूलरूप में

- आगे

- भविष्य

- प्राप्त की

- अन्तर

- लिंग

- उत्पन्न

- उत्पन्न

- उत्पन्न करता है

- सृजन

- पीढ़ी

- उत्पादक

- जनरेटिव एआई

- जनक

- मिल

- GitHub

- झलक

- वैश्विक

- Go

- लक्ष्य

- जा

- अच्छा

- गूगल

- गूगल की

- सरकार

- GPUs

- ग्रेड

- अभूतपूर्व

- समूह

- था

- हो जाता

- कठिन

- हार्डवेयर

- हानिकारक

- है

- होने

- स्वास्थ्य सेवा

- यहाँ उत्पन्न करें

- उच्च गुणवत्ता

- उच्च संकल्प

- भारी जोखिम

- उच्चतर

- उच्चतम

- रखती है

- कैसे

- तथापि

- एचटीएमएल

- HTTPS

- विशाल

- मानव

- सैकड़ों

- प्रचार

- हाइपरपरमेटर ट्यूनिंग

- विचार

- पहचान

- if

- की छवि

- छवियों

- अत्यधिक

- कार्यान्वयन

- कार्यान्वित

- निहितार्थ

- महत्वपूर्ण

- प्रभावशाली

- में सुधार

- उन्नत

- सुधार

- सुधार

- in

- में गहराई

- असमर्थता

- शामिल

- शामिल

- सहित

- निगमित

- को शामिल किया गया

- शामिल

- बढ़ना

- वृद्धि हुई

- बढ़ती

- तेजी

- व्यक्ति

- व्यक्तियों

- उद्योगों

- उद्योग

- करें-

- इंफ्रास्ट्रक्चर

- आरंभ

- नवोन्मेष

- निवेश

- निविष्टियां

- बजाय

- संस्थानों

- निर्देश

- एकीकृत

- बुद्धि

- इरादा

- दिलचस्प

- में

- परिचय कराना

- शुरू की

- आविष्कार

- मुद्दा

- मुद्दों

- IT

- आईटी इस

- खुद

- पत्रकारिता

- जेपीजी

- केवल

- कुंजी

- प्रमुख उद्देश्य

- जानना

- ज्ञान

- लैब्स

- रंग

- परिदृश्य

- भाषा

- भाषाऐं

- बड़ा

- बड़े पैमाने पर

- सबसे बड़ा

- ताज़ा

- परत

- परतों

- नेतृत्व

- जानें

- सीख रहा हूँ

- कानूनी

- कम

- स्तर

- स्तर

- लीवरेज

- leverages

- लाभ

- लाइसेंस - प्राप्त

- जीवन

- हल्के

- पसंद

- संभावित

- सीमाओं

- सूची

- सूचियाँ

- लाइव्स

- लामा

- स्थानीय स्तर पर

- तार्किक

- लंबा

- देखिए

- लॉट

- निम्न

- मशीनें

- बनाया गया

- बनाना

- बनाता है

- बहुत

- मार्कस

- बाजार

- बाजार अनुसंधान

- विपणन (मार्केटिंग)

- सामग्री

- गणित

- अधिकतम-चौड़ाई

- अधिकतम

- मई..

- सार्थक

- मीडिया

- मेडिकल

- मर्ज

- मेटा

- क्रियाविधि

- तरीकों

- माइक्रोसॉफ्ट

- मन

- कम से कम

- झूठी खबर

- भ्रामक

- गलतियां

- मिश्रित

- ML

- आदर्श

- मॉडल

- आधुनिक

- संशोधित

- निगरानी

- अधिक

- अधिकांश

- बहुत

- विभिन्न

- मुसलमानों

- प्राकृतिक

- प्राकृतिक भाषा

- प्राकृतिक भाषा संसाधन

- प्रकृति

- आवश्यकता

- जरूरत

- नेटवर्क

- तंत्रिका

- तंत्रिका भाषा

- तंत्रिका नेटवर्क

- नया

- समाचार

- अगला

- अच्छा

- NLP

- विशेष रूप से

- कुछ नहीं

- संख्या

- अनेक

- उद्देश्य

- उद्देश्य

- होते हैं

- of

- अपमानजनक

- सरकारी

- अक्सर

- on

- ONE

- लोगों

- केवल

- खुला

- खुला स्रोत

- OpenAI

- संचालित

- संचालन

- इष्टतमीकरण

- or

- संगठन

- अन्य

- अन्य

- हमारी

- आउट

- बेहतर प्रदर्शन करने

- Outperforms

- उत्पादन

- बकाया

- के ऊपर

- अपना

- ताड़

- काग़ज़

- मिसाल

- प्राचल

- पैरामीटर

- भाग

- भाग लेना

- विशेष रूप से

- पास

- पैटर्न उपयोग करें

- प्रशस्त

- फ़र्श

- प्रति

- निष्पादन

- प्रदर्शन

- प्रदर्शन

- प्रदर्शन

- मुहावरों

- चुनना

- प्लेटो

- प्लेटो डेटा इंटेलिजेंस

- प्लेटोडाटा

- फली

- बिन्दु

- अंक

- नीतियाँ

- संभव

- संभावित

- संचालित

- शक्तिशाली

- भविष्यवाणी करना

- वरीय

- पिछला

- मुख्यत

- पूर्व

- प्राथमिकता

- मुसीबत

- समस्याओं

- प्रक्रिया

- प्रक्रियाओं

- प्रसंस्करण

- उत्पादन

- एस्ट्रो मॉल

- उत्पादकता

- पेशेवर

- प्रोग्रामिंग

- प्रोग्रामिंग की भाषाएँ

- प्रगति

- होनहार

- गुण

- का प्रस्ताव

- मालिकाना

- प्रोटोकॉल

- प्रदान करना

- बशर्ते

- प्रदान करता है

- सार्वजनिक रूप से

- प्रकाशित

- प्रयोजनों

- धक्का

- अजगर

- pytorch

- गुणात्मक

- गुणवत्ता

- प्रश्न

- प्रशन

- जल्दी से

- दौड़

- रेंज

- तेजी

- बल्कि

- पढ़ना

- वास्तविक

- असली जीवन

- असली दुनिया

- हाल

- हाल ही में

- मान्यता

- पहचान

- को कम करने

- को कम करने

- आहार

- सुदृढीकरण सीखना

- और

- रिहा

- प्रासंगिक

- विश्वसनीय

- विश्वसनीय स्रोतों

- धर्म

- भरोसा

- रहना

- बने रहे

- असाधारण

- प्रतिस्थापित

- रिपोर्ट

- प्रतिनिधित्व

- अनुरोधों

- की आवश्यकता होती है

- की आवश्यकता होती है

- अनुसंधान

- अनुसंधान समुदाय

- शोधकर्ताओं

- गहन संसाधन

- सम्मान

- जवाब

- प्रतिक्रिया

- प्रतिक्रियाएं

- प्रतिबंधित

- परिणाम

- परिणाम

- बरकरार रखती है

- समीक्षा

- क्रांतिकारी बदलाव

- क्रांति ला दी

- जोखिम

- विरोध

- मजबूत

- भूमिकाओं

- कक्ष

- सुरक्षित

- सुरक्षा

- salesforce

- वही

- स्केल

- तराजू

- स्केलिंग

- परिदृश्यों

- दृश्यों

- स्कूल के साथ

- स्कोर

- स्कोर

- स्कोरिंग

- मूल

- दूसरा

- लगता है

- देखा

- चयनित

- संवेदनशील

- अलग

- कई

- गंभीर

- सेवा

- सेवाएँ

- सेट

- की स्थापना

- कई

- हैरान

- कम

- दिखाना

- पता चला

- दिखाता है

- हस्ताक्षर

- महत्वपूर्ण

- काफी

- उसी प्रकार

- विलक्षण

- स्थितियों

- आकार

- कौशल

- छोटे

- So

- अब तक

- सोशल मीडिया

- सोशल मीडिया

- समाज

- सॉफ्टवेयर

- सॉफ्टवेयर विकास

- केवल

- समाधान

- हल करती है

- कुछ

- परिष्कृत

- स्रोत

- सूत्रों का कहना है

- सोर्सिंग

- स्पैम

- विशिष्ट

- विशेष रूप से

- विशेषता

- बहुत शानदार

- भाषण से पाठ

- गति

- स्थिरता

- ट्रेनिंग

- चरणों

- मानक

- मानकों

- राज्य

- राज्य के-the-कला

- सांख्यिकीय

- आँकड़े

- फिर भी

- स्ट्रेटेजी

- ताकत

- हड़ताल

- अध्ययन

- पर्याप्त

- सफल

- ऐसा

- सुझाव

- पता चलता है

- सारांश

- बेहतर

- पर्यवेक्षण

- समर्थन

- पार

- प्रणाली

- सिस्टम

- बाते

- कार्य

- कार्य

- टीम

- तकनीकी

- तकनीक

- टेक्नोलॉजीज

- शर्तों

- परीक्षण

- पाठ पीढ़ी

- पाठ से भाषण

- से

- धन्यवाद

- कि

- RSI

- भविष्य

- राज्य

- दुनिया

- लेकिन हाल ही

- उन

- फिर

- वहाँ।

- जिसके चलते

- इसलिये

- इन

- वे

- सोचना

- तीसरे दल

- इसका

- उन

- हालांकि?

- हजारों

- तीन

- यहाँ

- बार

- सेवा मेरे

- आज का दि

- एक साथ

- टोकन

- tokenization

- टोकन

- भी

- उपकरण

- ऊपर का

- टॉपबॉट्स

- विषय

- विषय

- की ओर

- परंपरागत

- रेलगाड़ी

- प्रशिक्षित

- प्रशिक्षण

- स्थानांतरण

- ट्रांसफार्मर

- बदलने

- अनुवाद करें

- खरब

- ट्यूरिंग

- Tutoring

- दो

- बिना शर्त

- के अंतर्गत

- समझना

- समझ

- शुरू

- निश्चित रूप से

- दुर्भाग्य से

- ब्रम्हांड

- भिन्न

- आधुनिकतम

- अपडेट

- उपयोग

- प्रयुक्त

- उपयोगकर्ता

- का उपयोग करता है

- का उपयोग

- इस्तेमाल

- विविधता

- विभिन्न

- व्यापक

- बहुमुखी

- बहुत

- वीडियो

- वीडियो

- वास्तविक

- दृष्टि

- स्वर

- था

- मार्ग..

- we

- वेब

- कुंआ

- थे

- क्या

- कब

- कौन कौन से

- जब

- कौन

- पूरा का पूरा

- चौड़ा

- विस्तृत श्रृंखला

- विकिपीडिया

- मर्जी

- साथ में

- अंदर

- बिना

- शब्द

- काम

- एक साथ काम करो

- विश्व

- लिख रहे हैं

- साल

- अभी तक

- इसलिए आप

- जेफिरनेट

- जीरो-शॉट लर्निंग