Nous commençons à voir les tout premiers stades d'une pile technologique émerger dans l'intelligence artificielle générative (IA). Des centaines de nouvelles startups se précipitent sur le marché pour développer des modèles de base, créer des applications natives d'IA et mettre en place une infrastructure/des outils.

De nombreuses tendances technologiques en vogue sont exagérées bien avant que le marché ne rattrape son retard. Mais le boom de l'IA générative s'est accompagné de gains réels sur de vrais marchés et d'une réelle traction de la part de vraies entreprises. Des modèles comme Stable Diffusion et ChatGPT établissent des records historiques de croissance des utilisateurs, et plusieurs applications ont atteint 100 millions de dollars de revenus annualisés moins d'un an après leur lancement. Des comparaisons côte à côte montrent des modèles d'IA surpasser les humains dans certaines tâches par plusieurs ordres de grandeur.

Il existe donc suffisamment de données préliminaires pour suggérer qu'une transformation massive est en cours. Ce que nous ne savons pas, et ce qui est maintenant devenu la question critique, c'est : Où sur ce marché la valeur s'accumulera-t-elle ?

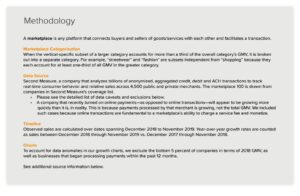

Au cours de la dernière année, nous avons rencontré des dizaines de fondateurs de startups et d'opérateurs dans de grandes entreprises qui traitent directement de l'IA générative. Nous avons observé que fournisseurs d'infrastructures sont probablement les plus grands gagnants de ce marché jusqu'à présent, capturant la majorité des dollars circulant dans la pile. Sociétés d'applications augmentent très rapidement leurs revenus, mais ont souvent du mal à fidéliser, à différencier leurs produits et à générer des marges brutes. Et plus fournisseurs de modèles, bien que responsables de l'existence même de ce marché, n'ont pas encore atteint une grande échelle commerciale.

En d'autres termes, les entreprises qui créent le plus de valeur, c'est-à-dire former des modèles d'IA génératifs et les appliquer dans de nouvelles applications, n'en ont pas capturé la majeure partie. Prédire ce qui va se passer ensuite est beaucoup plus difficile. Mais nous pensons que l'élément clé à comprendre est quelles parties de la pile sont vraiment différenciées et défendables. Cela aura un impact majeur sur la structure du marché (c'est-à-dire le développement horizontal ou vertical de l'entreprise) et les moteurs de la valeur à long terme (par exemple les marges et la rétention). Jusqu'à présent, nous avons eu du mal à trouver une défense structurelle de n'importe où dans la pile, en dehors des fossés traditionnels pour les titulaires.

Nous sommes incroyablement optimistes quant à l'IA générative et pensons qu'elle aura un impact massif sur l'industrie du logiciel et au-delà. L'objectif de cet article est de cartographier la dynamique du marché et de commencer à répondre aux questions plus larges sur les modèles commerciaux d'IA générative.

Pile technologique de haut niveau : infrastructure, modèles et applications

Pour comprendre comment le marché de l'IA générative prend forme, nous devons d'abord définir à quoi ressemble la pile aujourd'hui. Voici notre avis préliminaire.

La pile peut être divisée en trois couches :

- Applications qui intègrent des modèles d'IA génératifs dans un produit destiné à l'utilisateur, soit en exécutant leurs propres pipelines de modèles ("applications de bout en bout"), soit en s'appuyant sur une API tierce

- Des modèles photo qui alimentent les produits d'IA, mis à disposition soit sous forme d'API propriétaires, soit sous forme de points de contrôle open source (qui, à leur tour, nécessitent une solution d'hébergement)

- Infrastructure les fournisseurs (c'est-à-dire les plates-formes cloud et les fabricants de matériel) qui exécutent des charges de travail de formation et d'inférence pour les modèles d'IA génératifs

Il est important de noter : Il ne s'agit pas d'une carte du marché, mais d'un cadre pour analyser le marché. Dans chaque catégorie, nous avons répertorié quelques exemples de fournisseurs bien connus. Nous n'avons pas tenté d'être exhaustifs ou de répertorier toutes les incroyables applications d'IA génératives qui ont été publiées. Nous n'allons pas non plus approfondir ici les outils MLops ou LLMops, qui ne sont pas encore hautement standardisés et seront abordés dans un prochain article.

La première vague d'applications d'IA générative commence à atteindre l'échelle, mais a du mal à se retenir et à se différencier

Dans les cycles technologiques précédents, la sagesse conventionnelle était que pour construire une grande entreprise indépendante, vous devez posséder le client final, qu'il s'agisse de consommateurs individuels ou d'acheteurs B2B. Il est tentant de croire que les plus grandes entreprises de l'IA générative seront également des applications pour les utilisateurs finaux. Jusqu'à présent, il n'est pas clair que ce soit le cas.

Certes, la croissance des applications d'IA générative a été stupéfiante, propulsée par la pure nouveauté et une pléthore de cas d'utilisation. En fait, nous connaissons au moins trois catégories de produits qui ont déjà dépassé les 100 millions de dollars de revenus annualisés : la génération d'images, la rédaction et l'écriture de code.

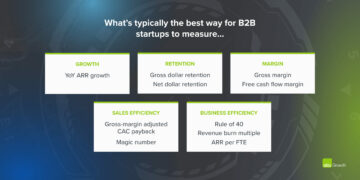

Cependant, la croissance seule ne suffit pas à bâtir des entreprises de logiciels durables. Surtout, la croissance doit être rentable - dans le sens où les utilisateurs et les clients, une fois qu'ils se sont inscrits, génèrent des bénéfices (marges brutes élevées) et restent longtemps (rétention élevée). En l'absence d'une forte différenciation technique, les applications B2B et B2C génèrent de la valeur client à long terme grâce aux effets de réseau, à la conservation des données ou à la création de flux de travail de plus en plus complexes.

Dans l'IA générative, ces hypothèses ne sont pas nécessairement vraies. Dans toutes les sociétés d'applications avec lesquelles nous avons parlé, il existe un large éventail de marges brutes, allant jusqu'à 90 % dans quelques cas, mais le plus souvent aussi bas que 50 à 60 %, principalement en raison du coût de l'inférence de modèle. La croissance du haut de l'entonnoir a été incroyable, mais il n'est pas clair si les stratégies actuelles d'acquisition de clients seront évolutives - nous constatons déjà que l'efficacité et la rétention de l'acquisition payante commencent à diminuer. De nombreuses applications sont également relativement indifférenciées, car elles s'appuient sur des modèles d'IA sous-jacents similaires et n'ont pas découvert d'effets de réseau évidents, ou de données/flux de travail, difficiles à dupliquer pour les concurrents.

Il n'est donc pas encore évident que la vente d'applications pour les utilisateurs finaux soit la seule, voire la meilleure, voie pour créer une entreprise d'IA générative durable. Les marges devraient s'améliorer à mesure que la concurrence et l'efficacité des modèles linguistiques augmentent (plus d'informations à ce sujet ci-dessous). La rétention devrait augmenter à mesure que les touristes IA quittent le marché. Et il y a un argument solide à faire valoir que les applications intégrées verticalement ont un avantage dans la différenciation. Mais il reste encore beaucoup à prouver.

Pour l'avenir, certaines des grandes questions auxquelles sont confrontées les entreprises d'applications d'IA génératives incluent :

- Intégration verticale ("modèle + application"). La consommation de modèles d'IA en tant que service permet aux développeurs d'applications d'itérer rapidement avec une petite équipe et d'échanger des fournisseurs de modèles à mesure que la technologie progresse. D'un autre côté, certains développeurs affirment que le produit is le modèle, et que la formation à partir de zéro est le seul moyen de créer de la justesse - c'est-à-dire en se re-formant continuellement sur des données de produit exclusives. Mais cela se fait au prix d'exigences en capital beaucoup plus élevées et d'une équipe produit moins agile.

- Construire des fonctionnalités par rapport à des applications. Les produits d'IA générative prennent différentes formes : applications de bureau, applications mobiles, plugins Figma/Photoshop, extensions Chrome, voire des bots Discord. Il est facile d'intégrer des produits d'IA là où les utilisateurs travaillent déjà, car l'interface utilisateur n'est généralement qu'une zone de texte. Lesquelles de ces entreprises deviendront des entreprises autonomes - et lesquelles seront absorbées par des opérateurs historiques, comme Microsoft ou Google, qui intègrent déjà l'IA dans leurs gammes de produits ?

- Gérer à travers le cycle de battage médiatique. Il n'est pas encore clair si le taux de désabonnement est inhérent au lot actuel de produits d'IA générative, ou s'il s'agit d'un artefact d'un marché précoce. Ou si le regain d'intérêt pour l'IA générative s'estompera à mesure que le battage médiatique s'estompera. Ces questions ont des implications importantes pour les entreprises d'applications, y compris quand appuyer sur la pédale d'accélérateur lors de la collecte de fonds ; avec quel dynamisme investir dans l'acquisition de clients ; quels segments d'utilisateurs prioriser ; et quand déclarer l'adéquation produit-marché.

Les fournisseurs de modèles ont inventé l'IA générative, mais n'ont pas atteint une grande échelle commerciale

Ce que nous appelons maintenant l'IA générative n'existerait pas sans le brillant travail de recherche et d'ingénierie effectué dans des endroits comme Google, OpenAI et Stability. Grâce à de nouvelles architectures de modèles et à des efforts héroïques pour faire évoluer les pipelines de formation, nous bénéficions tous des capacités époustouflantes des grands modèles de langage (LLM) et des modèles de génération d'images actuels.

Pourtant, les revenus associés à ces entreprises sont encore relativement faibles par rapport à l'utilisation et au buzz. Dans la génération d'images, Stable Diffusion a connu une croissance communautaire explosive, soutenue par un écosystème d'interfaces utilisateur, d'offres hébergées et de méthodes de réglage fin. Mais Stability donne gratuitement leurs principaux points de contrôle en tant que principe fondamental de leur entreprise. Dans les modèles de langage naturel, OpenAI domine avec GPT-3/3.5 et ChatGPT. Mais relativement peu d'applications tueuses construites sur OpenAI existent jusqu'à présent, et les prix ont déjà tombé une fois.

Ce n'est peut-être qu'un phénomène temporaire. Stability est une nouvelle entreprise qui ne s'est pas encore concentrée sur la monétisation. OpenAI a le potentiel de devenir une entreprise massive, gagnant une part importante de tous les revenus de la catégorie NLP à mesure que de plus en plus d'applications tueuses sont créées - surtout si leur intégration dans le portefeuille de produits de Microsoft se passe en douceur. Compte tenu de l'utilisation massive de ces modèles, les revenus à grande échelle ne sont peut-être pas loin derrière.

Mais il y a aussi des contre-pouvoirs. Les modèles publiés en open source peuvent être hébergés par n'importe qui, y compris des entreprises extérieures qui ne supportent pas les coûts associés à la formation de modèles à grande échelle (jusqu'à des dizaines ou des centaines de millions de dollars). Et il n'est pas clair si des modèles à source fermée peuvent conserver leur avantage indéfiniment. Par exemple, nous commençons à voir des LLM construits par des entreprises comme Anthropic, Cohere et Character.ai se rapprocher des niveaux de performance OpenAI, formés sur des ensembles de données similaires (c'est-à-dire Internet) et avec des architectures de modèles similaires. L'exemple de la diffusion stable suggère que if les modèles open source atteignent un niveau suffisant de performances et de support communautaire, alors les alternatives propriétaires peuvent avoir du mal à rivaliser.

Jusqu'à présent, la conclusion la plus claire pour les fournisseurs de modèles est peut-être que la commercialisation est probablement liée à l'hébergement. La demande d'API propriétaires (par exemple d'OpenAI) augmente rapidement. Les services d'hébergement pour les modèles open source (par exemple, Hugging Face et Replicate) apparaissent comme des hubs utiles pour partager et intégrer facilement des modèles - et ont même des effets de réseau indirects entre les producteurs de modèles et les consommateurs. Il existe également une hypothèse forte selon laquelle il est possible de monétiser grâce à des accords de réglage fin et d'hébergement avec des entreprises clientes.

Au-delà de cela, cependant, il y a un certain nombre de grandes questions auxquelles sont confrontés les fournisseurs de modèles :

- Marchandisation. Il existe une croyance commune selon laquelle les modèles d'IA convergeront en termes de performances au fil du temps. En parlant aux développeurs d'applications, il est clair que cela ne s'est pas encore produit, avec de solides leaders dans les modèles de texte et d'image. Leurs avantages ne reposent pas sur des architectures de modèles uniques, mais sur des exigences de capital élevées, des données d'interaction de produits exclusives et des talents rares en IA. Cela constituera-t-il un avantage durable ?

- Risque de diplôme. S'appuyer sur des fournisseurs de modèles est un excellent moyen pour les entreprises d'applications de démarrer et même de développer leurs activités. Mais ils sont incités à créer et/ou à héberger leurs propres modèles une fois qu'ils ont atteint l'échelle. Et de nombreux fournisseurs de modèles ont des distributions de clients très asymétriques, quelques applications représentant la majorité des revenus. Que se passe-t-il si/quand ces clients passent au développement d'IA en interne ?

- L'argent est-il important ? La promesse de l'IA générative est si grande - et aussi potentiellement si nuisible - que de nombreux fournisseurs de modèles se sont organisés en sociétés d'utilité publique (corps B), ont émis des parts de bénéfices plafonnées ou ont autrement incorporé explicitement le bien public dans leur mission. Cela n'a pas du tout entravé leurs efforts de collecte de fonds. Mais il y a une discussion raisonnable à avoir pour savoir si la plupart des fournisseurs de modèles souhaitez pour capturer de la valeur, et s'ils le devraient.

Les fournisseurs d'infrastructure touchent à tout et récoltent les fruits

Presque tout dans l'IA générative passe par un GPU (ou TPU) hébergé dans le cloud à un moment donné. Que ce soit pour les fournisseurs de modèles/laboratoires de recherche exécutant des charges de travail de formation, les sociétés d'hébergement exécutant l'inférence/le réglage fin, ou les sociétés d'applications combinant les deux – FLOPS sont la pierre angulaire de l'IA générative. Pour la première fois depuis très longtemps, les progrès de la technologie informatique la plus perturbatrice sont massivement liés au calcul.

En conséquence, une grande partie de l'argent du marché de l'IA générative est finalement acheminée vers les sociétés d'infrastructure. pour mettre quelques très chiffres approximatifs : nous estimons qu'en moyenne, les entreprises d'applications dépensent environ 20 à 40 % de leurs revenus en inférence et en ajustement par client. Cette somme est généralement versée soit directement aux fournisseurs de cloud pour les instances de calcul, soit à des fournisseurs de modèles tiers, qui, à leur tour, dépensent environ la moitié de leurs revenus dans l'infrastructure cloud. Il est donc raisonnable de supposer que 10 à 20 % des revenu total dans l'IA générative va aujourd'hui aux fournisseurs de cloud.

En plus de cela, les startups formant leurs propres modèles ont levé des milliards de dollars en capital-risque - dont la majorité (jusqu'à 80 à 90 % dans les premiers tours) est généralement également dépensée avec les fournisseurs de cloud. De nombreuses entreprises technologiques publiques dépensent des centaines de millions par an en formation de modèles, soit avec des fournisseurs de cloud externes, soit directement avec des fabricants de matériel.

C'est ce que nous appellerions, en termes techniques, «beaucoup d'argent» - en particulier pour un marché naissant. La majeure partie est dépensée au Big 3 Clouds : Amazon Web Services (AWS), Google Cloud Platform (GCP) et Microsoft Azure. Ces fournisseurs de cloud collectivement dépenser plus que $ 100 milliards par an en capex pour s'assurer qu'ils disposent des plates-formes les plus complètes, les plus fiables et les plus compétitives. Dans l'IA générative, en particulier, ils bénéficient également de contraintes d'approvisionnement car ils ont un accès préférentiel à du matériel rare (par exemple, les GPU Nvidia A100 et H100).

Fait intéressant, cependant, nous commençons à voir émerger une concurrence crédible. Des challengers comme Oracle ont fait des percées avec de grosses dépenses d'investissement et des incitations à la vente. Et quelques startups, comme Coreweave et Lambda Labs, ont connu une croissance rapide avec des solutions destinées spécifiquement aux grands développeurs de modèles. Ils se font concurrence sur le coût, la disponibilité et l'assistance personnalisée. Ils exposent également des abstractions de ressources plus granulaires (c'est-à-dire des conteneurs), tandis que les grands clouds n'offrent que des instances de VM en raison des limites de virtualisation GPU.

Dans les coulisses, exécutant la grande majorité des charges de travail d'IA, est peut-être le plus grand gagnant de l'IA générative à ce jour : Nvidia. L'entreprise rapporté 3.8 XNUMX $ milliard du chiffre d'affaires GPU du centre de données au troisième trimestre de son exercice 2023, y compris une partie significative pour les cas d'utilisation de l'IA générative. Et ils ont construit de solides douves autour de cette activité grâce à des décennies d'investissement dans l'architecture GPU, un écosystème logiciel robuste et une utilisation approfondie dans la communauté universitaire. Une analyse récente ont constaté que les GPU Nvidia sont cités dans les articles de recherche 90 fois plus que les meilleures startups de puces AI combinées.

D'autres options matérielles existent, y compris Google Tensor Processing Units (TPU); GPU AMD Instinct ; Puces AWS Inferentia et Trainium ; et des accélérateurs d'IA de startups comme Cerebras, Sambanova et Graphcore. Intel, en retard dans le jeu, entre également sur le marché avec ses puces haut de gamme Habana et ses GPU Ponte Vecchio. Mais jusqu'à présent, peu de ces nouvelles puces ont pris des parts de marché significatives. Les deux exceptions à surveiller sont Google, dont les TPU ont gagné du terrain dans la communauté Stable Diffusion et dans certaines grandes transactions GCP, et TSMC, qui est censé fabriquer TOUTE des puces répertoriées ici, y compris les GPU Nvidia (Intel utilise un mélange de ses propres fabs et TSMC pour fabriquer ses puces).

L'infrastructure est, en d'autres termes, une couche lucrative, durable et apparemment défendable dans la pile. Les grandes questions auxquelles doivent répondre les entreprises infra comprennent :

- Conserver les charges de travail sans état. Les GPU Nvidia sont les mêmes partout où vous les louez. La plupart des charges de travail d'IA sont sans état, en ce sens que l'inférence de modèle ne nécessite pas de bases de données ou de stockage attachés (autre que pour les pondérations de modèle elles-mêmes). Cela signifie que les charges de travail d'IA peuvent être plus portables sur les clouds que les charges de travail d'application traditionnelles. Comment, dans ce contexte, les fournisseurs de cloud peuvent-ils créer de la rigidité et empêcher les clients de se tourner vers l'option la moins chère ?

- Survivre à la fin de la pénurie de puces. Les prix pour les fournisseurs de cloud, et pour Nvidia lui-même, ont été soutenus par la rareté des GPU les plus recherchés. Un fournisseur nous a dit que le prix catalogue des A100 avait en fait increased depuis son lancement, ce qui est très inhabituel pour le matériel de calcul. Lorsque cette contrainte d'approvisionnement sera finalement supprimée, grâce à une production accrue et/ou à l'adoption de nouvelles plates-formes matérielles, quel impact cela aura-t-il sur les fournisseurs de cloud ?

- Un cloud challenger peut-il percer ? Nous croyons fermement que nuages verticaux prendra des parts de marché aux Big 3 avec des offres plus spécialisées. Jusqu'à présent, dans le domaine de l'IA, les challengers se sont taillé une place de choix grâce à une différenciation technique modérée et au soutien de Nvidia, pour qui les fournisseurs de cloud en place sont à la fois les plus gros clients et les concurrents émergents. La question à long terme est-elle suffisante pour surmonter les avantages d'échelle des Big 3 ?

Alors… où la valeur s'accumulera-t-elle ?

Bien sûr, nous ne savons pas encore. Mais sur la base des premières données dont nous disposons pour l'IA générative, combinées avec notre expérience avec les premières entreprises d'IA/ML, notre intuition est la suivante.

Il ne semble pas, aujourd'hui, y avoir de douves systémiques dans l'IA générative. En tant qu'approximation de premier ordre, les applications manquent d'une forte différenciation des produits car elles utilisent des modèles similaires ; les modèles sont confrontés à une différenciation à long terme peu claire car ils sont formés sur des ensembles de données similaires avec des architectures similaires ; les fournisseurs de cloud manquent de différenciation technique profonde car ils exécutent les mêmes GPU ; et même les fabricants de matériel fabriquent leurs puces dans les mêmes usines.

Il y a, bien sûr, les douves standard : les douves d'échelle ("J'ai ou je peux lever plus d'argent que vous !"), Les douves de la chaîne d'approvisionnement ("J'ai les GPU, pas vous !"), Les douves de l'écosystème (" Tout le monde utilise déjà mon logiciel !"), les douves algorithmiques ("Nous sommes plus malins que vous !"), les douves de distribution ("J'ai déjà une équipe commerciale et plus de clients que vous !") et les douves de pipeline de données ("Je J'ai exploré plus d'Internet que vous !"). Mais aucune de ces douves n'a tendance à être durable à long terme. Et il est trop tôt pour dire si des effets de réseau puissants et directs s'installent dans n'importe quelle couche de la pile.

Sur la base des données disponibles, il n'est tout simplement pas clair s'il y aura une dynamique à long terme, gagnant-gagnant, dans l'IA générative.

C'est bizarre. Mais pour nous, c'est une bonne nouvelle. La taille potentielle de ce marché est difficile à appréhender — quelque part entre tous les logiciels ainsi que toutes les entreprises humaines – nous nous attendons donc à beaucoup, beaucoup de joueurs et à une saine concurrence à tous les niveaux de la pile. Nous nous attendons également à ce que les entreprises horizontales et verticales réussissent, la meilleure approche étant dictée par les marchés finaux et les utilisateurs finaux. Par exemple, si la principale différenciation du produit final est l'IA elle-même, il est probable que la verticalisation (c'est-à-dire le couplage étroit de l'application destinée à l'utilisateur au modèle développé en interne) l'emportera. Alors que si l'IA fait partie d'un ensemble de fonctionnalités plus large et à longue traîne, il est plus probable qu'une horizontalisation se produise. Bien sûr, nous devrions également voir la construction de douves plus traditionnelles au fil du temps - et nous pourrions même voir de nouveaux types de douves s'installer.

Quoi qu'il en soit, une chose dont nous sommes certains, c'est que l'IA générative change la donne. Nous apprenons tous les règles en temps réel, il y a énormément de valeur qui sera débloquée, et le paysage technologique va donc être très, très différent. Et nous sommes là pour ça !

Toutes les images de cet article ont été créées avec Midjourney.

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- Platoblockchain. Intelligence métaverse Web3. Connaissance Amplifiée. Accéder ici.

- La source: https://a16z.com/2023/01/19/who-owns-the-generative-ai-platform/

- 100 millions de dollars

- $3

- 1

- a

- A100

- Qui sommes-nous

- académique

- accélérateurs

- accès

- atteint

- acquisition

- à travers

- actually

- Adoption

- avances

- Avantage

- avantages

- Après

- accords

- devant

- AI

- Plateforme IA

- cas d'utilisation de l'IA

- AI / ML

- algorithmique

- Tous

- permet

- seul

- déjà

- des alternatives

- incroyable

- Amazon

- Amazon Web Services

- Amazon Web Services (AWS)

- AMD

- montant

- il analyse

- ainsi que

- annualisé

- répondre

- chacun.e

- Apis

- appli

- apparaître

- Application

- applications

- Application

- une approche

- applications

- architecture

- argumenter

- argument

- autour

- artificiel

- intelligence artificielle

- Intelligence artificielle (AI)

- associé

- disponibilité

- disponibles

- moyen

- AWS

- Inférence AWS

- Azure

- B2B

- B2C

- basé

- Gardez

- car

- devenez

- before

- derrière

- philosophie

- CROYONS

- cru

- les croyants

- ci-dessous

- profiter

- LES MEILLEURS

- jusqu'à XNUMX fois

- Au-delà

- Big

- Le plus grand

- Milliards

- milliards

- boom

- les robots

- lié

- Box

- Pause

- brillant

- plus large

- construire

- Développement

- construit

- Haussier

- la performance des entreprises

- entreprises

- acheteurs

- Appelez-nous

- capacités

- capital

- capturer

- Capturer

- maisons

- cas

- catégories

- Catégories

- Canaux centraux

- certaines

- provocateur

- Modifications

- caractère

- ChatGPT

- moins cher

- puce

- chips

- Chrome

- cité

- clair

- plus

- le cloud

- infrastructure de cloud

- cloud Platform

- code

- collectivement

- combinaison

- combiné

- comment

- commercial

- commercialisation

- Commun

- Communautés

- Sociétés

- Société

- par rapport

- rivaliser

- concurrence

- concurrents

- complexe

- complet

- calcul

- informatique

- contraintes

- Les consommateurs

- Conteneurs

- contexte

- continuellement

- conventionnel

- converger

- écriture de copie

- Core

- Corporations

- Prix

- Costs

- cours

- engendrent

- créée

- La création

- crédible

- critique

- Courant

- des clients

- Clients

- cycles

- données

- Centre de données

- bases de données

- ensembles de données

- affaire

- Offres

- décennies

- profond

- Demande

- à poser

- développer

- mobiles

- Développement

- Devs

- différent

- différentes formes

- différencié

- La diffusion

- directement

- discorde

- découvert

- spirituelle

- perturbateur

- distribution

- distributions

- divisé

- faire

- dollars

- domine

- Ne pas

- des dizaines

- motivation

- entraîné

- conducteurs

- conduite

- Dynamic

- dynamique

- chacun

- Plus tôt

- "Early Bird"

- Revenus

- même

- risque numérique

- Edge

- les effets

- efficace

- efforts

- non plus

- économies émergentes.

- ENGINEERING

- assez

- assurer

- Entreprise

- clients entreprise

- notamment

- estimation

- Pourtant, la

- faire une éventuelle

- peut

- exemple

- exemples

- attendre

- Découvrez

- extensions

- externe

- Visage

- Automne

- Fonctionnalité

- Fonctionnalités:

- few

- Trouvez

- trouver

- Prénom

- première fois

- Fiscal

- s'adapter

- Retournement

- Écoulement

- Flux

- concentré

- Abonnement

- Forces

- document

- trouvé

- Fondation

- fondateurs

- Framework

- Test d'anglais

- de

- Collecte de fonds

- avenir

- Gains

- jeu

- GAS

- généralement

- générer

- génération

- génératif

- IA générative

- obtenez

- donné

- donne

- objectif

- Goes

- aller

- Bien

- Google Cloud

- Google Cloud Platform

- GPU

- GPU

- saisir

- l'

- brut

- Croître

- Croissance

- cultivé

- Croissance

- Half

- arriver

- arrivé

- arrive

- Dur

- Matériel

- nuisible

- la santé

- ici

- Haute

- augmentation

- très

- historique

- Frappé

- appuyez en continu

- tenue

- Horizontal

- hôte

- organisé

- hébergement

- HOT

- Comment

- HTTPS

- majeur

- humain

- Des centaines

- des centaines de millions

- Hype

- image

- génération d'image

- satellite

- Impact

- implications

- important

- améliorer

- in

- Dans d'autres

- Motivation

- Incitations

- comprendre

- Y compris

- Incorporée

- incorporation

- Améliore

- increased

- Augmente

- de plus en plus

- incroyablement

- Titulaire

- indépendant

- individuel

- industrie

- Infrastructure

- inhérent

- intégrer

- des services

- l'intégration

- Intel

- Intelligence

- l'interaction

- intérêt

- interfaces

- Internet

- intuition

- A inventé

- Investir

- un investissement

- Publié

- IT

- lui-même

- ACTIVITES

- Savoir

- Labs

- Peindre

- paysage d'été

- langue

- gros

- grande échelle

- principalement

- plus importantes

- Nom de famille

- L'année dernière

- En retard

- lancer

- couche

- poules pondeuses

- dirigeants

- apprentissage

- Laisser

- Niveau

- niveaux

- Probable

- limites

- lignes

- Liste

- Listé

- Location

- Longtemps

- long-term

- Style

- LOOKS

- Lot

- Faible

- lucratif

- LES PLANTES

- maintenir

- majeur

- Majorité

- faire

- Fabricants

- de nombreuses

- Localisation

- marges

- Marché

- carte du marché

- Structure du marché

- Marchés

- massif

- massivement

- largeur maximale

- significative

- veux dire

- méthodes

- Microsoft

- Microsoft Azure

- À mi-parcours

- million

- des millions

- Mission

- MLOps

- Breeze Mobile

- application mobile

- modèle

- numériques jumeaux (digital twin models)

- monétisation

- monétiser

- de l'argent

- PLUS

- (en fait, presque toutes)

- plusieurs

- naissant

- Nature

- Langage naturel

- nécessairement

- Besoin

- réseau et

- Nouveauté

- nouveau matériel

- nouvelles

- next

- agile

- nlp

- roman

- nouveauté

- nombre

- numéros

- Nvidia

- évident

- code

- Offrandes

- ONE

- ouvert

- open source

- OpenAI

- opérateurs

- Option

- Options

- oracle

- passer commande

- Organisé

- Autre

- autrement

- au contrôle

- Overcome

- propre

- Possède

- payé

- papiers

- partie

- particulier

- les pièces

- passes

- chemin

- performant

- être

- Personnalisé

- phénomène

- pipeline

- Place

- Des endroits

- plateforme

- Plateformes

- Platon

- Intelligence des données Platon

- PlatonDonnées

- joueurs

- pléthore

- plugins

- Point

- possible

- Post

- défaillances

- l'éventualité

- power

- prévoir

- empêcher

- prix

- Tarifs

- primaire

- Avant

- Prioriser

- traitement

- Nos producteurs

- Produit

- Vidéo

- Produits

- Profit

- rentable

- bénéfices

- Progrès

- PROMETTONS

- propriétaire

- Prouver

- de voiture.

- fournisseurs

- public

- mettre

- Trimestre

- question

- fréquemment posées

- vite.

- augmenter

- collectés

- gamme

- rapidement

- nous joindre

- atteint

- réal

- en temps réel

- raisonnable

- récent

- Articles

- relativement

- libéré

- fiable

- Supprimé

- Location

- représentation

- exigent

- Exigences

- un article

- ressource

- responsables

- résultat

- rétention

- de revenus

- recettes

- Analyse

- robuste

- tours

- Courir

- pour le running

- vente

- Incitations à la vente

- même

- évolutive

- Escaliers intérieurs

- Rare

- Rareté

- Scènes

- voir

- segments

- Disponible

- sens

- besoin

- service

- Services

- set

- mise

- plusieurs

- Forme

- Partager

- Partages

- devrait

- montrer

- signer

- significative

- similaires

- depuis

- Taille

- petit

- sans demander

- So

- jusqu'à présent

- Logiciels

- sur mesure

- Solutions

- quelques

- quelque part

- Identifier

- spécialisé

- spécifiquement

- passer

- dépensé

- Stabilité

- stable

- empiler

- étapes

- Utilisation d'un

- autonome

- Standard

- Commencer

- j'ai commencé

- Commencez

- Commencez

- Startups

- bâton

- Encore

- storage

- les stratégies

- STRONG

- de construction

- structure

- Lutter

- réussir

- suffisant

- Suggère

- la quantité

- Support

- Appareils

- se pose

- durable

- Interrupteur

- systémique

- Prenez

- prise

- Talent

- parlant

- des campagnes marketing ciblées,

- tâches

- équipe

- technologie

- entreprises technologiques

- Technique

- Technologie

- temporaire

- conditions

- La

- leur

- se

- chose

- Troisièmement

- des tiers.

- trois

- Avec

- Attaché

- fermement

- fiable

- fois

- à

- aujourd'hui

- trop

- top

- -nous

- traction

- traditionnel

- qualifié

- Formation

- De La Carrosserie

- énorme

- Trends

- oui

- TSMC

- TOUR

- types

- typiquement

- ui

- En fin de compte

- sous-jacent

- comprendre

- unique

- unités

- inhabituel

- us

- Utilisation

- utilisé

- Utilisateur

- utilisateurs

- Plus-value

- Vaste

- fournisseurs

- entreprise

- capital-risque

- via

- Voir

- Montres

- Vague

- web

- services Web

- bien connu

- Quoi

- que

- qui

- tout en

- WHO

- large

- Large gamme

- Wikipédia

- sera

- gagner

- gagnants

- sagesse

- sans

- des mots

- Activités principales

- workflows

- écriture

- an

- zéphyrnet