Généré avec Midjourney

Les entreprises de tous les secteurs et de tous les coins du monde se précipitent pour intégrer la puissance de grands modèles de langage (LLM) comme ChatGPT d'OpenAI, Claude d'Anthropic et Jurassic d'AI12Lab pour améliorer les performances dans un large éventail d'applications commerciales, telles que les études de marché, le service client , et la génération de contenu.

Cependant, la création d'une application LLM à l'échelle de l'entreprise nécessite un ensemble d'outils et une compréhension différents de ceux de la création d'applications d'apprentissage automatique (ML) traditionnelles. Les chefs d'entreprise et les cadres qui souhaitent préserver la voix de la marque et la qualité de service fiable doivent développer une compréhension plus approfondie du fonctionnement des LLM et des avantages et inconvénients de divers outils dans une pile d'applications LLM.

Dans cet article, nous vous donnerons une introduction essentielle à la stratégie et aux outils de haut niveau dont vous aurez besoin pour créer et exécuter une application LLM pour votre entreprise.

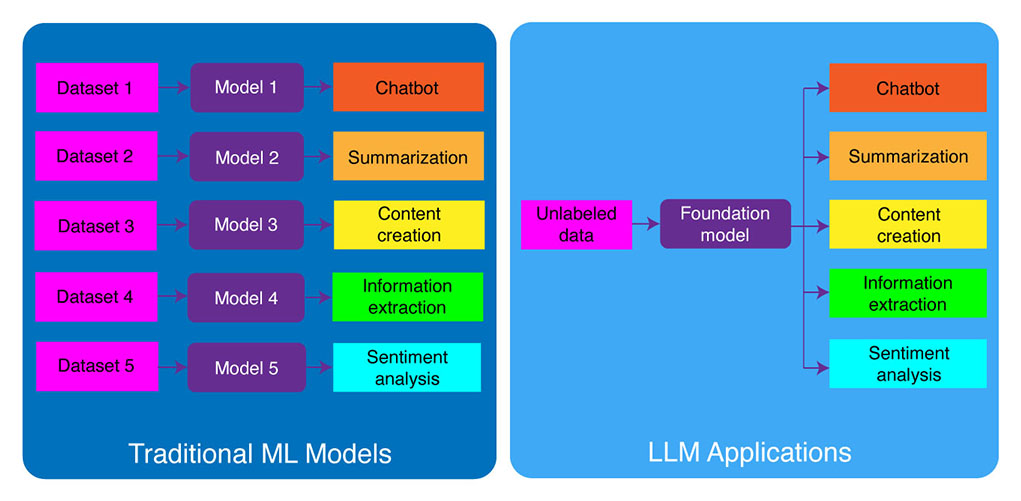

Développement ML traditionnel vs applications LLM

Les modèles d'apprentissage automatique traditionnels étaient spécifiques à une tâche, ce qui signifie que vous deviez créer un modèle distinct pour chaque tâche différente. Par exemple, si vous vouliez analyser le sentiment des clients, vous auriez besoin de créer un modèle, et si vous vouliez créer un chatbot de support client, vous auriez besoin de créer un autre modèle.

Ce processus de création et de formation de modèles ML spécifiques à une tâche prend du temps et nécessite beaucoup de données. Le type d'ensembles de données nécessaires pour former ces différents modèles de ML varierait également en fonction de la tâche. Pour former un modèle pour analyser le sentiment des clients, vous auriez besoin d'un ensemble de données d'avis de clients qui ont été étiquetés avec un sentiment correspondant (positif, négatif, neutre). Pour former un modèle pour créer un chatbot de support client, vous auriez besoin d'un ensemble de données de conversations entre les clients et le support technique.

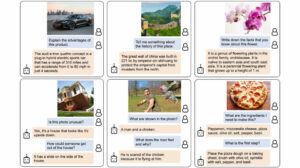

Les grands modèles de langage ont changé cela. Les LLM sont pré-formés sur un ensemble de données massif de texte et de code, ce qui leur permet de bien performer sur un large éventail de tâches prêtes à l'emploi, notamment :

- Résumé de texte

- Création de contenu

- Traduction

- Extraction d'information

- Question répondant

- Analyse des sentiments

- Service client

- Assistante commerciale

Le processus de développement des applications LLM peut être décomposé en quatre étapes essentielles :

- Choisissez un modèle de fondation approprié. C'est un élément clé qui définit les performances de votre application LLM.

- Personnalisez le modèle, si nécessaire. Vous devrez peut-être affiner le modèle ou l'augmenter avec la base de connaissances supplémentaire pour répondre à vos besoins spécifiques.

- Configurer l'infrastructure de ML. Cela inclut le matériel et les logiciels nécessaires pour exécuter votre application (c'est-à-dire les semi-conducteurs, les puces, l'hébergement cloud, l'inférence et le déploiement).

- Améliorez votre application avec des outils supplémentaires. Ces outils peuvent aider à améliorer l'efficacité, les performances et la sécurité de votre application.

Examinons maintenant la pile technologique correspondante.

Si ce contenu éducatif approfondi vous est utile, abonnez-vous à notre liste de diffusion AI d'être alerté lorsque nous publierons du nouveau matériel.

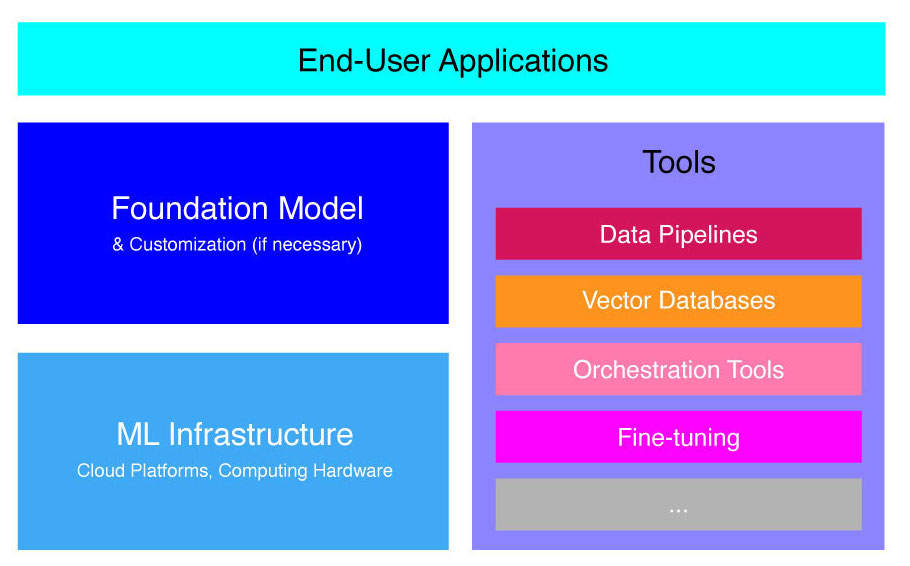

Pile d'applications LLM de haut niveau

Les applications LLM reposent sur plusieurs composants clés, notamment :

- Un modèle de base, ce qui peut nécessiter une personnalisation dans des cas d'utilisation spécifiques.

- Infrastructure ML des ressources informatiques suffisantes via des plates-formes cloud ou le propre matériel de l'entreprise.

- Outils supplémentaires, tels que les pipelines de données, les bases de données vectorielles, les outils d'orchestration, les plates-formes ML de réglage fin, les outils de surveillance des performances des modèles, etc.

Nous allons vous présenter brièvement ces composants afin que vous puissiez mieux comprendre la boîte à outils nécessaire pour créer et déployer une application LLM.

Que sont les modèles de fondation ?

L'utilisation d'un seul LLM pré-formé peut vous faire économiser beaucoup de temps et de ressources. Cependant, la formation d'un tel modèle à partir de zéro est un processus opportun et coûteux qui dépasse les capacités de la plupart des entreprises, à l'exception de quelques leaders technologiques.

Plusieurs entreprises et équipes de recherche ont formé ces modèles et permettent à d'autres entreprises de les utiliser. Les principaux exemples incluent ChatGPT, Claude, Llama, Jurassic et T5. Ces modèles destinés au public sont appelés modèles de base. Certains d'entre eux sont propriétaires et peuvent être consultés via des appels API moyennant des frais. D'autres sont open source et peuvent être utilisés gratuitement. Ces modèles sont pré-formés sur un ensemble de données massif de données textuelles non étiquetées, ce qui leur permet d'effectuer un large éventail de tâches, de la génération de copies publicitaires créatives à la communication avec vos clients dans leur langue maternelle au nom de l'entreprise.

Il existe deux principaux types de modèles de fondation : propriétaire et open-source.

Modèles propriétaires appartiennent à une seule entreprise ou organisation et ne sont généralement disponibles que moyennant des frais. Certains des exemples les plus populaires de modèles propriétaires incluent les modèles GPT d'OpenAI, les modèles Claude d'Anthropic et les modèles Jurassic d'AI21 Labs.

Modèles open source sont généralement disponibles gratuitement pour quiconque souhaite les utiliser. Cependant, certains modèles open source ont des limites à leur utilisation, telles que : (1) n'être disponibles qu'à des fins de recherche, (2) n'être disponibles que pour un usage commercial par des entreprises d'une certaine taille. La communauté open-source affirme que mettre de telles restrictions ne permet pas à un modèle de se qualifier comme "open-source". Néanmoins, les exemples les plus importants de modèles de langage pouvant être utilisés gratuitement incluent les modèles Llama de Meta, les modèles Falcon du Technology Innovation Institute d'Abu Dhabi et les modèles StableLM de Stability AI. En savoir plus sur les modèles open source et les risques associés ici.

Voyons maintenant plusieurs facteurs à prendre en compte lors du choix d'un modèle de base pour votre application LLM.

Choisissez un modèle de fondation

La sélection du meilleur modèle de base pour votre application LLM peut être un processus difficile, mais nous pouvons essentiellement le décomposer en trois étapes :

- Choisissez entre des modèles propriétaires et open source. Les modèles propriétaires sont généralement plus grands et plus performants que les modèles open source, mais ils peuvent être plus coûteux à utiliser et moins flexibles. De plus, le code n'est pas aussi transparent, ce qui rend difficile le débogage ou le dépannage des problèmes de performances des modèles propriétaires. Les modèles open source, en revanche, reçoivent généralement moins de mises à jour et moins de support de la part des développeurs.

- Choisissez la taille du modèle. Les modèles plus grands sont généralement plus performants pour effectuer des tâches qui nécessitent beaucoup de connaissances, telles que répondre à des questions ou générer un texte créatif. Cependant, les modèles plus grands sont également plus coûteux en termes de calcul. Vous pouvez commencer par expérimenter avec des modèles plus grands, puis passer à des modèles plus petits tant que les performances d'un modèle sont satisfaisantes pour votre cas d'utilisation.

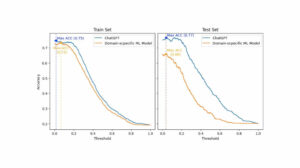

- Sélectionnez un modèle spécifique. Vous pouvez commencer par passer en revue les critères de référence généraux pour présélectionner les modèles à tester. Ensuite, continuez à tester différents modèles pour vos affectations spécifiques à l'application. Pour une analyse comparative personnalisée, envisagez de calculer Notes BLEU et ROUGE, les métriques qui permettent de quantifier le nombre de corrections nécessaires au texte généré par l'IA avant de publier la sortie pour les applications human-in-the-loop.

Pour une meilleure compréhension des différences entre les différents modèles de langage, consultez notre aperçu des modèles de langage les plus puissants (LLM) et de langage visuel (VLM).

Après avoir choisi un modèle de base pour votre application, vous pouvez déterminer si vous devez personnaliser le modèle pour des performances encore meilleures.

Personnaliser un modèle de fondation

Dans certains cas, vous souhaiterez peut-être personnaliser un modèle de langage de base pour de meilleures performances dans votre cas d'utilisation spécifique. Par exemple, vous souhaiterez peut-être optimiser pour un certain :

- Domaine. Si vous opérez dans des domaines spécifiques, tels que le juridique, la finance ou la santé, vous souhaiterez peut-être enrichir le vocabulaire du modèle dans ce domaine afin qu'il puisse mieux comprendre et répondre aux requêtes des utilisateurs finaux.

- Tâche. Par exemple, si vous souhaitez que le modèle génère des campagnes marketing, vous pouvez lui fournir des exemples spécifiques de contenu marketing de marque. Cela aidera le modèle à apprendre les modèles et les styles qui conviennent à votre entreprise et à votre public.

- Ton de la voix. Si vous avez besoin que le modèle utilise un ton de voix spécifique, vous pouvez personnaliser le modèle sur un jeu de données qui inclut des exemples de vos échantillons linguistiques cibles.

Il existe trois manières de personnaliser un modèle de langage de base :

- Réglage fin : fournit au modèle un ensemble de données étiquetées spécifiques au domaine d'environ 100 à 500 enregistrements. Les pondérations du modèle sont mises à jour, ce qui devrait se traduire par de meilleures performances sur les tâches représentées par cet ensemble de données.

- Adaptation de domaine: fournit au modèle un ensemble de données non étiqueté spécifique au domaine qui contient un grand corpus de données du domaine correspondant. Les poids du modèle sont également mis à jour dans ce cas.

- Récupération de l'information: augmente le modèle de base avec des connaissances de domaine fermé. Le modèle n'est pas ré-entraîné et les poids du modèle restent les mêmes. Cependant, le modèle est autorisé à récupérer des informations à partir d'une base de données vectorielle contenant des données pertinentes.

Les deux premières approches nécessitent des ressources informatiques importantes pour recycler le modèle, ce qui n'est généralement faisable que pour les grandes entreprises disposant du talent technique approprié pour gérer la personnalisation. Les petites entreprises utilisent généralement l'approche la plus courante consistant à augmenter le modèle avec une connaissance du domaine via une base de données vectorielle, que nous détaillons plus loin dans cet article dans la section sur les outils LLM.

Configurer l'infrastructure de ML

Le composant d'infrastructure ML du paysage LLMOps comprend les plates-formes cloud, le matériel informatique et d'autres ressources nécessaires au déploiement et à l'exécution des LLM. Ce composant est particulièrement pertinent si vous choisissez d'utiliser un modèle open source ou de personnaliser le modèle pour votre application. Dans ce cas, vous aurez peut-être besoin de ressources informatiques importantes pour affiner le modèle, si nécessaire, et l'exécuter.

Il existe un certain nombre de plates-formes cloud qui offrent des services pour le déploiement de LLM, notamment Google Cloud Platform, Amazon Web Services et Microsoft Azure. Ces plates-formes offrent un certain nombre de fonctionnalités qui facilitent le déploiement et l'exécution des LLM, notamment :

- Modèles préformés pouvant être affinés pour votre application spécifique

- Infrastructure gérée qui prend en charge le matériel et les logiciels sous-jacents

- Outils et services pour surveiller et déboguer vos LLM

La quantité de ressources informatiques dont vous avez besoin dépendra de la taille et de la complexité de votre modèle, des tâches que vous souhaitez qu'il exécute et de l'échelle de l'activité commerciale, où vous souhaitez déployer ce modèle.

Augmenter avec des outils

Des outils supplémentaires LLM adjacents peuvent être utilisés pour améliorer encore les performances de votre application LLM.

Pipelines de données

Si vous avez besoin d'utiliser vos données dans votre produit LLM, le pipeline de prétraitement des données sera un pilier essentiel de votre nouvelle pile technologique, tout comme dans la pile d'IA d'entreprise traditionnelle. Ces outils incluent des connecteurs pour ingérer des données à partir de n'importe quelle source, une couche de transformation de données et des connecteurs en aval. Les principaux fournisseurs de pipeline de données, tels que Databricks et Snowflake, et de nouveaux acteurs, comme Unstructured, permettent aux développeurs de pointer facilement des corpus volumineux et très hétérogènes de données en langage naturel (par exemple, des milliers de fichiers PDF, des présentations PowerPoint, des journaux de discussion, du HTML gratté, etc.) à un point d'accès unique ou même dans un document unique qui peut être utilisé ultérieurement par les applications LLM.

Bases de données vectorielles

Les grands modèles de langage sont limités au traitement de quelques milliers de mots à la fois, ils ne peuvent donc pas traiter efficacement des documents volumineux par eux-mêmes. Pour exploiter la puissance des documents volumineux, les entreprises doivent utiliser des bases de données vectorielles.

Les bases de données vectorielles sont des systèmes de stockage qui transforment les documents volumineux qu'ils reçoivent via des pipelines de données en vecteurs gérables ou incorporations. Les applications LLM peuvent ensuite interroger ces bases de données pour identifier les bons vecteurs, en extrayant uniquement les pépites d'informations nécessaires.

Certaines des bases de données vectorielles les plus importantes actuellement disponibles sont Pinecone, Chroma et Weaviate.

Outils d'orchestration

Lorsqu'un utilisateur soumet une requête à votre application LLM, telle qu'une question pour le service client, l'application doit créer une série d'invites avant de soumettre cette requête au modèle de langage. La demande finale adressée au modèle de langage est généralement composée d'un modèle d'invite codé en dur par le développeur, d'exemples de sorties valides appelées exemples à plusieurs reprises, de toute information nécessaire extraite d'API externes et d'un ensemble de documents pertinents extraits de la base de données vectorielle. . Les outils d'orchestration d'entreprises telles que LangChain ou LlamaIndex peuvent aider à rationaliser ce processus en fournissant des cadres prêts à l'emploi pour la gestion et l'exécution des invites.

Réglage fin

De grands modèles de langage formés sur des ensembles de données volumineux peuvent produire un texte grammaticalement correct et fluide. Cependant, ils peuvent manquer de précision dans certains domaines, comme la médecine ou le droit. Le réglage fin de ces modèles sur des ensembles de données spécifiques à un domaine leur permet d'internaliser les caractéristiques uniques de ces domaines, améliorant ainsi leur capacité à générer du texte pertinent.

La mise au point d'un LLM peut être un processus coûteux pour les petites entreprises. Cependant, les solutions d'entreprises comme Weights & Biases et OctoML peuvent aider à un réglage fin rationalisé et efficace. Ces solutions fournissent une plate-forme permettant aux entreprises d'affiner les LLM sans avoir à investir dans leur propre infrastructure.

Autres outils

Il existe de nombreux autres outils qui peuvent être utiles pour créer et exécuter des applications LLM. Par exemple, vous pouvez avoir besoin d'outils d'étiquetage si vous souhaitez affiner le modèle avec vos échantillons de données spécifiques. Vous pouvez également déployer des outils spécifiques pour surveiller les performances de votre application, car même des modifications mineures du modèle de base ou des demandes des clients peuvent avoir un impact significatif sur les performances des invites. Enfin, il existe des outils qui surveillent la sécurité des modèles pour vous aider à éviter de promouvoir des contenus haineux, des recommandations dangereuses ou des préjugés. La nécessité et l'importance de ces différents outils dépendront de votre cas d'utilisation spécifique.

Quelle est la prochaine étape dans le développement d'applications LLM ?

Les quatre étapes du développement de produits LLM dont nous avons discuté ici constituent un fondement essentiel de la stratégie d'IA générative de toute entreprise qui exploite de grands modèles de langage. Il est important que les chefs d'entreprise non techniques les comprennent, même si vous avez une équipe technique qui met en œuvre les détails. Nous publierons à l'avenir des didacticiels plus détaillés sur la façon de tirer parti de la vaste gamme d'outils d'IA générative sur le marché. Pour l'instant, vous pouvez abonnez-vous à notre newsletter pour obtenir les dernières mises à jour.

Vous aimez cet article ? Inscrivez-vous pour plus de mises à jour sur l'IA d'entreprise.

Nous vous informerons lorsque nous publierons d'autres articles résumés comme celui-ci.

Services Connexes

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Automobile / VE, Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- Décalages de bloc. Modernisation de la propriété des compensations environnementales. Accéder ici.

- La source: https://www.topbots.com/llm-product-development-technology-stack/

- :est

- :ne pas

- :où

- $UP

- 1

- a

- capacité

- Qui sommes-nous

- abu dhabi

- accès

- accédé

- activité

- Ad

- Supplémentaire

- En outre

- adjacent

- AI

- Stratégie de l'IA

- permettre

- permis

- permet

- aussi

- Amazon

- Amazon Web Services

- montant

- an

- il analyse

- ainsi que le

- Une autre

- Anthropique

- tous

- chacun.e

- api

- Apis

- Application

- Le développement d'applications

- applications

- une approche

- approches

- approprié

- SONT

- domaines

- article

- sur notre blog

- AS

- associé

- At

- public

- disponibles

- éviter

- Azure

- base

- En gros

- BE

- était

- before

- nom

- va

- analyse comparative

- repères

- LES MEILLEURS

- Améliorée

- jusqu'à XNUMX fois

- Au-delà

- biais

- renforcer

- Box

- brand

- marqué

- Pause

- brièvement

- Cassé

- construire

- Développement

- construit

- la performance des entreprises

- applications commerciales

- Des chefs d'entreprise

- entreprises

- mais

- by

- le calcul

- appelé

- Appels

- Campagnes

- CAN

- capacités

- capable

- les soins

- maisons

- cas

- certaines

- difficile

- modifié

- Modifications

- Chatbot

- ChatGPT

- vérifier

- chips

- Selectionnez

- choose

- choisi

- prétentions

- le cloud

- cloud Hosting

- cloud Platform

- code

- commercial

- Commun

- communicant

- Communautés

- Sociétés

- Société

- De l'entreprise

- complexité

- composant

- composants électriques

- composé

- informatique

- Inconvénients

- Considérer

- construire

- contient

- contenu

- conversations

- copies

- Coin

- correct

- Corrections

- Correspondant

- cher

- Conception

- Lecture

- Customiser

- des clients

- Service à la clientèle

- Support à la clientèle

- Clients

- personnalisation

- personnaliser

- dangereux

- données

- Base de données

- bases de données

- Databricks

- ensembles de données

- profond

- définir

- Selon

- déployer

- déployer

- déploiement

- détail

- détaillé

- détails

- développer

- Développeur

- mobiles

- développement

- Développement

- Dhabi

- différences

- différent

- difficile

- discuter

- discuté

- document

- INSTITUTIONNELS

- Ne fait pas

- domaine

- domaines

- down

- e

- chacun

- Easy

- pédagogique

- de manière efficace

- efficace

- efficace

- élite

- permettant

- de renforcer

- améliorer

- enrichir

- Entreprise

- notamment

- essential

- etc

- Ether (ETH)

- Pourtant, la

- Chaque

- exemple

- exemples

- Sauf

- exécution

- cadres

- cher

- externe

- facteurs

- faucon

- réalisable

- Fonctionnalités:

- frais

- few

- moins

- finale

- finalement

- la traduction de documents financiers

- Prénom

- flexible

- Pour

- Fondation

- quatre

- cadres

- Gratuit

- De

- plus

- avenir

- Général

- générer

- générateur

- génération

- génératif

- IA générative

- obtenez

- Donner

- globe

- Go

- aller

- Google Cloud

- Google Cloud Platform

- Sol

- main

- Matériel

- harnais

- Vous avez

- ayant

- la médecine

- vous aider

- ici

- de haut niveau

- très

- hébergement

- Comment

- How To

- Cependant

- HTML

- HTTPS

- i

- if

- Impact

- la mise en œuvre

- importance

- important

- améliorer

- in

- en profondeur

- comprendre

- inclut

- Y compris

- industrie

- d'information

- Infrastructure

- Innovation

- Institut

- intégrer

- développement

- Introduction

- Investir

- IT

- jpg

- juste

- ACTIVITES

- Genre

- Savoir

- spécialisées

- l'étiquetage

- Labs

- Peindre

- paysage d'été

- langue

- gros

- plus importantes

- plus tard

- Nouveautés

- Dernières mises à jour

- Droit applicable et juridiction compétente

- couche

- dirigeants

- conduisant

- APPRENTISSAGE

- apprentissage

- Légal

- moins

- Levier

- les leviers

- comme

- limites

- limité

- Flamme

- Location

- Style

- Lot

- click

- machine learning

- Entrée

- a prendre une

- FAIT DU

- gérer

- les gérer

- de nombreuses

- Marché

- Étude de marché

- Stratégie

- Campagnes Marketing

- marché

- massif

- Matériel

- largeur maximale

- Mai..

- sens

- médecine

- Découvrez

- Meta

- Métrique

- Microsoft

- Microsoft Azure

- pourrait

- mineur

- ML

- modèle

- numériques jumeaux (digital twin models)

- Surveiller

- Stack monitoring

- PLUS

- (en fait, presque toutes)

- Le Plus Populaire

- indigène

- Nature

- Langage naturel

- nécessaire

- Besoin

- nécessaire

- Besoins

- négatif

- Neutri

- Nouveauté

- Nouvelle technologie

- Newsletter

- next

- non technique

- maintenant

- nombre

- of

- code

- on

- ONE

- et, finalement,

- uniquement

- open source

- OpenAI

- fonctionner

- Optimiser

- or

- orchestration

- organisation

- Autre

- Autres

- nos

- ande

- sortie

- vue d'ensemble

- propre

- propriété

- motifs

- effectuer

- performant

- effectuer

- Pilier

- pipeline

- plateforme

- Plateformes

- Platon

- Intelligence des données Platon

- PlatonDonnées

- joueurs

- Point

- Populaire

- positif

- possible

- power

- solide

- La précision

- Présentations

- d'ouvrabilité

- processus

- traitement

- produire

- Produit

- le développement de produits

- important

- la promotion de

- propriétaire

- AVANTAGES

- fournir

- fournisseurs

- fournit

- aportando

- publier

- des fins

- Putting

- qualifier

- qualité

- requêtes

- question

- fréquemment posées

- gamme

- Lire

- recevoir

- recommandations

- Articles

- libérer

- libération

- pertinent

- fiable

- représenté

- nécessaire

- demandes

- exigent

- a besoin

- un article

- Resources

- Réagir

- restrictions

- résultat

- examen

- Avis

- bon

- risques

- Courir

- pour le running

- Sécurité

- même

- Épargnez

- Escaliers intérieurs

- Section

- sécurité

- Semi-conducteurs

- sentiment

- séparé

- Série

- service

- Services

- set

- plusieurs

- devrait

- signer

- significative

- de façon significative

- unique

- Taille

- petit

- faibles

- So

- Logiciels

- Solutions

- quelques

- Identifier

- groupe de neurones

- Stabilité

- empiler

- Commencer

- rester

- Étapes

- Encore

- storage

- de Marketing

- rationaliser

- rationalisé

- modes

- tel

- suffisant

- RÉSUMÉ

- Support

- Système

- Prenez

- prend

- Talent

- Target

- Tâche

- tâches

- équipe

- équipes

- technologie

- Technique

- support technique.

- Technologie

- innovation technologique

- modèle

- Essais

- que

- qui

- Les

- El futuro

- leur

- Les

- puis

- Là.

- Ces

- l'ont

- this

- ceux

- milliers

- trois

- Avec

- fiable

- long

- à

- TON

- Ton de la voix

- Boîte à outils

- les outils

- top

- TOPBOTS

- traditionnel

- Train

- qualifié

- Formation

- Transformer

- De La Carrosserie

- communication

- tutoriels

- deux

- types

- typiquement

- sous-jacent

- comprendre

- compréhension

- expérience unique et authentique

- caractéristiques uniques

- a actualisé

- Actualités

- utilisé

- cas d'utilisation

- d'utiliser

- Utilisateur

- d'habitude

- divers

- via

- Voix

- vs

- souhaitez

- voulu

- veut

- façons

- we

- web

- services Web

- WELL

- ont été

- quand

- que

- qui

- WHO

- large

- Large gamme

- sera

- comprenant

- sans

- des mots

- activités principales

- pourra

- you

- Votre

- zéphyrnet