Un nouveau document technique intitulé "Recherche d'architecture neuronale optimisée pour le matériel à grande échelle" a été publié par des chercheurs de Google, Apple et Waymo.

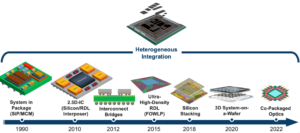

"Cet article présente la première recherche d'architecture neurale optimisée pour le matériel à grande échelle (H2O-NAS) pour concevoir automatiquement des modèles d'apprentissage automatique précis et performants adaptés à l'architecture matérielle sous-jacente. H2O-NAS se compose de trois composants clés : un nouvel algorithme de recherche massivement parallèle "one-shot" avec partage de poids intelligent, qui peut s'adapter aux espaces de recherche de O(10280) et gérer de gros volumes de trafic de production ; des espaces de recherche optimisés pour le matériel pour divers modèles ML sur du matériel hétérogène ; et un nouveau modèle de performance hybride à deux phases et une fonction de récompense multi-objectifs optimisée pour les déploiements à grande échelle », indique le document.

Trouvez le article technique ici. Publié en mars 2023.

Sheng Li, Garrett Andersen, Tao Chen, Liqun Cheng, Julian Grady, Da Huang, Quoc V. Le, Andrew Li, Xin Li, Yang Li, Chen Liang, Yifeng Lu, Yun Ni, Ruoming Pang, Mingxing Tan, Martin Wicke, Gang Wu, Shengqi Zhu, Parthasarathy Ranganathan et Norman P. Jouppi. 2023. Recherche d'architecture neurale optimisée par matériel hyperscale. Dans Actes de la 28e Conférence internationale ACM sur le support architectural pour les langages de programmation et les systèmes d'exploitation, Volume 3 (ASPLOS 2023). Association pour les machines informatiques, New York, NY, États-Unis, 343–358. https://doi.org/10.1145/3582016.3582049

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- Platoblockchain. Intelligence métaverse Web3. Connaissance Amplifiée. Accéder ici.

- Frapper l'avenir avec Adryenn Ashley. Accéder ici.

- La source: https://semiengineering.com/hyperscale-hw-optimized-neural-architecture-search-google/

- ][p

- 2023

- a

- Avec cette connaissance vient le pouvoir de prendre

- ACM

- algorithme

- ainsi que

- Andersen

- Andrew

- Apple

- architectural

- architecture

- Association

- At

- automatiquement

- by

- CAN

- chen

- Cheng

- composants électriques

- informatique

- Congrès

- DA

- déploiements

- Conception

- plusieurs

- Prénom

- Pour

- fonction

- Gang

- manipuler

- Matériel

- HTTPS

- Hybride

- in

- Intelligent

- International

- Introduit

- clés / KEY :

- Langues

- gros

- apprentissage

- click

- machine learning

- machinerie

- Mars

- Martin

- massivement

- ML

- modèle

- numériques jumeaux (digital twin models)

- Neural

- Nouveauté

- New York

- roman

- NY

- of

- on

- d'exploitation

- systèmes d'exploitation

- optimisé

- Papier

- Parallèle

- performant

- Platon

- Intelligence des données Platon

- PlatonDonnées

- Procédures

- Vidéo

- Programmation

- langages de programmation

- publié

- chercheurs

- Récompenser

- Escaliers intérieurs

- Rechercher

- partage

- espaces

- États

- Support

- Système

- Technique

- La

- trois

- titré

- à

- circulation

- sous-jacent

- États-Unis

- le volume

- volumes

- était

- waymo

- poids

- qui

- avec

- wu

- zéphyrnet