HPE Découvrez la région EMEA Maintenant que tous les grands fabricants de technologie se disputent une part du gâteau des revenus de l’IA, HPE entend rester pertinent en adoptant ce que le PDG Antonio Neri appelle une stratégie « native de l’IA ».

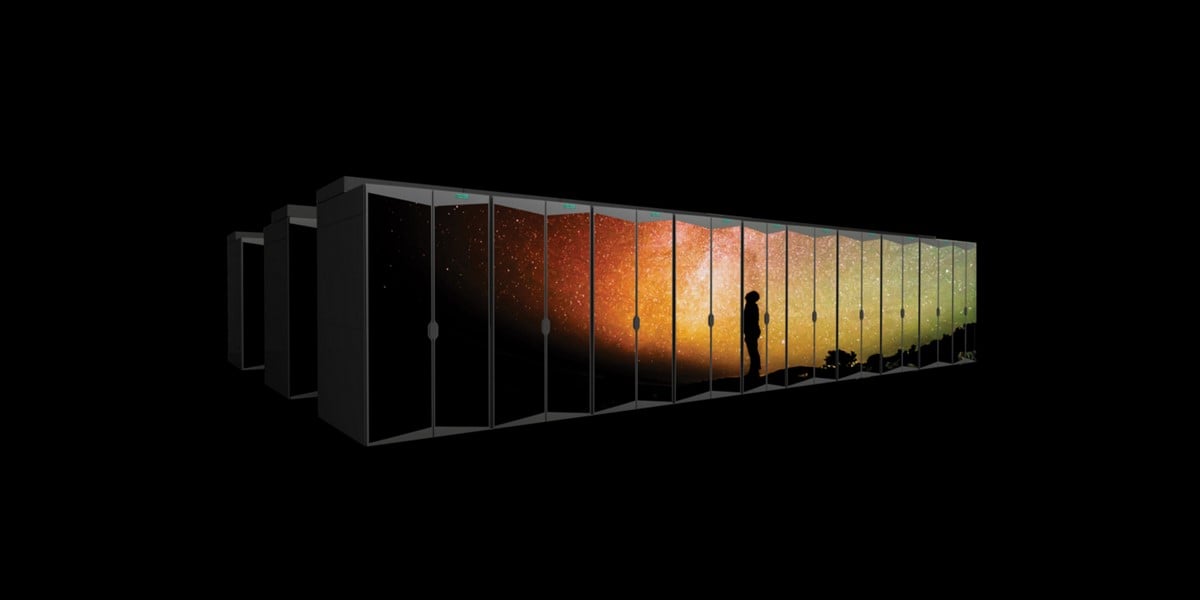

L’affirmation est que HPE peut accompagner les clients tout au long du cycle de vie du modèle d’IA, de la formation au réglage et à l’inférence. Cela dépend en partie de HPE possède Cray, et être capable de fournir la technologie de calcul intensif nécessaire à la formation de grands modèles d'IA, ce qui, selon Neri, constitue un différenciateur que certains concurrents de HPE n'ont pas.

HPE, comme beaucoup d’autres acteurs du secteur, voit l’avenir sous la forme de l’IA et encore plus d’IA – bien que dans son cas, ce soit via la plateforme Greenlake. L’entreprise devra convaincre le marché qu’elle possède les pièces clés du puzzle de l’IA.

Lors de son discours lors de l'événement Discover de HPE à Barcelone, Neri a souligné les opportunités d'utilisation de l'IA dans les entreprises, empruntant l'expression éculée selon laquelle l'IA sera « la technologie la plus disruptive de notre vie ».

De telles déclarations sont monnaie courante à l’heure actuelle, suite à l’explosion d’intérêt pour les modèles d’IA génératifs provoquée par OpenAI et son chatbot ChatGPT basé sur un grand modèle de langage.

"L'IA était considérée comme une promesse quelque part à l'horizon avant 2022 et ChatGPT est venu et a ébranlé les fondations", a déclaré Neri.

« Imaginez maintenant un avenir où chaque décision commerciale sera rendue possible par l’IA. Un avenir où l'analyse prédictive génère de nouveaux niveaux d'activités pour vous aider à prendre des décisions meilleures et plus rapides et à prédire les tendances concernant les nouvelles opportunités commerciales », a déclaré Neri.

Pour étayer son propos, Neri a été rejoint sur scène par Karl Havard, directeur général de Nuage de taïga, une entreprise européenne qui construit un cloud spécialisé pour le traitement de l'IA.

Taiga utilise les nœuds Cray XD de HPE, équipés de GPU Nvidia H100 pour sa plate-forme, le même matériel que le service de supercalcul GreenLake for Large Language Models de HPE annoncé en juin.

Havard a déclaré que son entreprise avait pour objectif de vendre démocratiser l'accès à l'IA générative, afin que les startups et les petites entreprises puissent obtenir les ressources dont elles ont besoin pour former leurs modèles, au lieu d'avoir à construire leur propre infrastructure ou à recourir aux grands cloud publics.

Les accords avec d'autres sociétés sont également essentiels pour HPE, a concédé Neri, en particulier avec Nvidia, étant donné que ses GPU jouent un rôle central à la fois dans les systèmes de calcul intensif de HPE pour l'IA et dans la solution d'entreprise pour l'IA générative, cette dernière A annoncé cette semaine à Découvrir.

Le vice-président de Nvidia pour l'informatique d'entreprise, Manuvir Das, a fait une apparition lors du discours d'ouverture pour expliquer que de nombreux utilisateurs d'entreprise n'ont pas besoin de consacrer tout le temps et les efforts nécessaires pour créer et former leur propre IA, mais peuvent dans de nombreux cas se procurer un outil pré-entraîné. modèle de base et utilisez-le simplement, ou ajustez-le pour mieux répondre à ses besoins.

« Avec les modèles de fondation, quelqu'un a fait tout le travail à votre place. Ils ont fait 99 pour cent du travail et si je peux faire le 1 pour cent restant, maintenant le modèle est le mien », a-t-il expliqué.

Nvidia, cependant, est également un fournisseur clé des concurrents de HPE, notamment Dell, qui a lancé plus tôt cette année ses propres plates-formes d'inférence et de personnalisation de l'IA ainsi que le réglage des modèles. Ceux-ci utilisent également les GPU Nvidia et sa suite logicielle AI Enterprise.

Malgré toute l'attention et les investissements consacrés actuellement à la formation des modèles d'IA, HPE estime que l'inférence est la chose la plus importante, car elle représente en fin de compte la plus grande partie du cycle de vie d'un modèle d'IA.

"L'utilisation de l'IA se produit lorsque vous êtes prêt à déployer ces modèles, et cela se produit du côté de l'inférence", a déclaré Neri en réponse à une question. "Cela peut se faire dans le centre de données, mais je pense qu'une grande partie de l'inférence servira à faciliter le traitement en temps réel là où se trouvent les données, là où les décisions doivent être prises plus rapidement."

Cette demande potentielle de nouvelle infrastructure pour prendre en charge l’inférence de l’IA pourrait être exactement ce dont HPE a besoin, suite au récent Baisse de 31 % des revenus de son activité Compute. Cela fait suite à une baisse des revenus déclarés au cours des deux trimestres précédents.

"Le secteur du calcul ne va pas disparaître et recevra probablement un autre coup de pouce grâce à l'inférence de l'IA", a déclaré Neri en réponse à une autre question.

Et si l’industrie n’adhère pas aux promesses de l’IA ?

Mais alors que HPE mise gros sur l’IA, que se passera-t-il si cela ne s’avère pas être l’énorme point d’inflexion que prétendent de nombreux commentateurs ?

Matt Harris, directeur général de HPE pour le Royaume-Uni, l'Irlande, le Moyen-Orient et l'Afrique, est catégorique sur le fait que cela va changer fondamentalement la façon dont les entreprises fonctionnent.

« Je pense que l'IA générative dans ChatGPT a placé l'IA au premier plan de la conscience et du processus de pensée de chacun, mais je ne pense pas que ce soit exagéré. Je pense que l'IA va infiltrer nos vies, et c'est déjà fait, si vous pensez à la façon dont la recherche sur Internet s'est améliorée au fil des ans, ou à l'utilisation de chatbots qui vous parlent pour résoudre les requêtes ou les problèmes des clients, c'est déjà assez répandu », a déclaré Harris. ®

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- PlatoHealth. Veille biotechnologique et essais cliniques. Accéder ici.

- La source: https://go.theregister.com/feed/www.theregister.com/2023/12/01/hpe_talks_up_ai_some/

- :possède

- :est

- :ne pas

- :où

- $UP

- 1

- 2022

- a

- Capable

- Qui sommes-nous

- accès

- d'activités

- L'adoption d'

- Afrique

- AI

- Modèles AI

- vise

- Tous

- déjà

- aussi

- Bien que

- an

- analytique

- ainsi que le

- annoncé

- Une autre

- SONT

- BRAS

- AS

- At

- précaution

- et

- RETOUR

- Barcelona

- basé

- BE

- car

- before

- va

- CROYONS

- croit

- Améliorée

- Pari

- Big

- grande technologie

- plus gros

- Emprunt

- tous les deux

- Apporté

- construire

- Développement

- la performance des entreprises

- entreprises

- mais

- acheter

- by

- Appels

- venu

- CAN

- Peut obtenir

- maisons

- cas

- causé

- CEO

- Change

- Chatbot

- Chatbots

- ChatGPT

- réclamer

- réclame

- prétentions

- le cloud

- CO

- commentateurs

- Sociétés

- Société

- calcul

- informatique

- Conscience

- convaincre

- pourriez

- critique

- des clients

- Clients

- personnalisation

- données

- Datacenter

- décision

- décisions

- Les baisses

- livré

- Dell

- Demande

- démocratiser

- déployer

- différenciateur

- Directeur

- découvrez

- perturbateur

- do

- doesn

- Don

- fait

- motivation

- Goutte

- pendant

- Plus tôt

- Est

- effort

- activé

- Entreprise

- entreprises

- Ether (ETH)

- du

- événement

- Chaque

- tout le monde

- Expliquer

- expliqué

- explosion

- plus rapide

- suivi

- Abonnement

- Pour

- devant

- Fondation

- Fondations

- De

- fondamentalement

- avenir

- génératif

- IA générative

- obtenez

- donné

- Go

- aller

- GPU

- plus grand

- arrive

- Matériel

- Vous avez

- ayant

- he

- vous aider

- Surbrillance

- charnières

- sa

- horizon

- Comment

- Cependant

- HTTPS

- majeur

- i

- if

- image

- Impact

- amélioré

- in

- industrie

- inflexion

- Point d'inflexion

- Infrastructure

- plutôt ;

- intérêt

- Internet

- développement

- un investissement

- Irlande

- ISN

- IT

- SES

- rejoint

- jpg

- juin

- juste

- karl

- ACTIVITES

- Tonique

- Libellé

- langue

- gros

- lancé

- niveaux

- vos produits

- durée de vie

- comme

- Vit

- Lot

- LES PLANTES

- a prendre une

- fabricant

- les gérer

- Directeur Général

- de nombreuses

- Marché

- Match

- Milieu

- Moyen-Orient

- mine

- modèle

- numériques jumeaux (digital twin models)

- moment

- PLUS

- (en fait, presque toutes)

- indigène

- nécessaire

- Besoin

- Besoins

- Nouveauté

- nœuds

- notamment

- maintenant

- Nvidia

- of

- on

- OpenAI

- fonctionner

- Opportunités

- or

- Autre

- Autres

- nos

- ande

- plus de

- exagéré

- propre

- posséder

- partie

- particulier

- pour cent

- en particulier pendant la préparation

- pièces

- tangage

- pivot

- plateforme

- Plateformes

- Platon

- Intelligence des données Platon

- PlatonDonnées

- Jouez

- plus

- Point

- défaillances

- prévoir

- prédictive

- Analyses prédictives

- assez

- précédent

- Probablement

- d'ouvrabilité

- processus

- traitement

- PROMETTONS

- public

- puzzle

- requêtes

- question

- solutions

- réal

- en temps réel

- récent

- pertinent

- rester

- restant

- Signalé

- représente

- Exigences

- Resources

- réponse

- de revenus

- rivaux

- Rôle

- s

- Saïd

- même

- dit

- Rechercher

- vu

- voit

- service

- secoué

- coup

- côté

- faibles

- So

- Logiciels

- sur mesure

- RÉSOUDRE

- quelques

- Quelqu'un

- quelque part

- spécialisé

- passer

- Étape

- Startups

- déclarations

- de Marketing

- grève

- suite

- Superinformatique

- fournisseur

- la quantité

- Support

- Système

- T

- parlant

- technologie

- Technologie

- qui

- Les

- El futuro

- leur

- Ces

- l'ont

- chose

- penser

- this

- cette année

- pensée

- Avec

- fiable

- à

- Train

- Formation

- Trends

- TOUR

- deux

- Uk

- En fin de compte

- Utilisation

- utilisé

- utilisateurs

- en utilisant

- Ve

- via

- vp

- était

- Façon..

- Quoi

- quand

- qui

- sera

- comprenant

- activités principales

- an

- années

- you

- zéphyrnet