Un article technique intitulé « WWW : What, When, Where to Compute-in-Memory » a été publié par des chercheurs de l'Université Purdue.

Résumé:

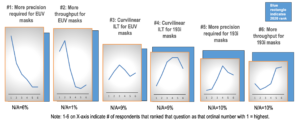

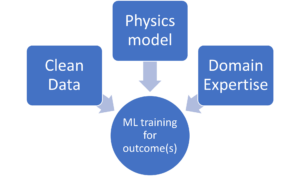

« Le calcul en mémoire (CiM) s'est imposé comme une solution intéressante pour réduire les coûts élevés de déplacement de données dans les machines von Neumann. CiM peut effectuer des opérations de multiplication matricielle générale (GEMM) massivement parallèles en mémoire, le calcul dominant dans l'inférence d'apprentissage automatique (ML). Cependant, la réaffectation de la mémoire pour le calcul pose des questions clés sur 1) Quel type de CiM utiliser : étant donné la multitude de CiM analogiques et numériques, il est nécessaire de déterminer leur adéquation du point de vue des systèmes. 2) Quand utiliser CiM : l'inférence ML inclut des charges de travail avec une variété d'exigences de mémoire et de calcul, ce qui rend difficile l'identification du moment où CiM est plus bénéfique que les cœurs de traitement standard. 3) Où intégrer CiM : chaque niveau de mémoire a une bande passante et une capacité différentes, ce qui affecte le mouvement des données et les avantages de localisation de l'intégration CiM.

Dans cet article, nous explorons les réponses à ces questions concernant l'intégration CiM pour l'accélération de l'inférence ML. Nous utilisons Timeloop-Accelergy pour une évaluation précoce au niveau système des prototypes CiM, y compris les primitives analogiques et numériques. Nous intégrons CiM dans différents niveaux de mémoire cache dans une architecture de base de type Nvidia A100 et adaptons le flux de données à diverses charges de travail ML. Nos expériences montrent que les architectures CiM améliorent l'efficacité énergétique, atteignant une énergie jusqu'à 0.12 fois inférieure à la ligne de base établie avec la précision INT-8, et jusqu'à 4 fois des gains de performances avec l'entrelacement et la duplication de poids. Le travail proposé donne un aperçu du type de CiM à utiliser, ainsi que du moment et de l'endroit où l'intégrer de manière optimale dans la hiérarchie du cache pour l'accélération GEMM.

Trouvez le article technique ici. Publié en décembre 2023 (préimpression).

Sharma, Tanvi, Mustafa Ali, Indranil Chakraborty et Kaushik Roy. « WWW : quoi, quand et où calculer en mémoire. » Préimpression arXiv arXiv :2312.15896 (2023).

Lecture connexe

Augmenter l'efficacité énergétique de l'IA grâce au calcul en mémoire

Comment traiter des charges de travail zettascale et respecter un budget énergétique fixe.

Modélisation du calcul en mémoire avec efficacité biologique

L’IA générative oblige les fabricants de puces à utiliser les ressources de calcul de manière plus intelligente.

SRAM dans l'IA : l'avenir de la mémoire

Pourquoi la SRAM est considérée comme un élément essentiel dans les architectures informatiques nouvelles et traditionnelles.

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- PlatoHealth. Veille biotechnologique et essais cliniques. Accéder ici.

- La source: https://semiengineering.com/cim-integration-for-ml-inference-acceleration/

- :possède

- :est

- :où

- $UP

- 1

- 2023

- a

- accélération

- la réalisation de

- AI

- alléger

- an

- et les

- réponses

- architecture

- AS

- At

- Bande passante

- Baseline

- avantageux

- avantages.

- tous les deux

- budget

- by

- cachette

- CAN

- Compétences

- irrésistible

- calcul

- calcul

- Costs

- critique

- données

- Décembre

- détermination

- différent

- difficile

- numérique

- dominant

- chacun

- "Early Bird"

- efficace

- élément

- émergé

- énergie

- l'efficacité énergétique

- établies

- évaluation

- expériences

- explorez

- fixé

- Pour

- Forces

- De

- avenir

- Gains

- Général

- donné

- ici

- hiérarchie

- Haute

- Cependant

- HTTPS

- identifier

- améliorer

- in

- inclut

- Y compris

- idées.

- intégrer

- l'intégration

- développement

- IT

- jpg

- ACTIVITES

- apprentissage

- Niveau

- niveaux

- baisser

- click

- machine learning

- Les machines

- Fabrication

- massivement

- Matrice

- Mémoire

- ML

- PLUS

- mouvement

- multitude

- nécessaire

- Nouveauté

- Nvidia

- of

- on

- ouvert

- Opérations

- nos

- Papier

- Parallèle

- effectuer

- performant

- objectifs

- Platon

- Intelligence des données Platon

- PlatonDonnées

- pose

- power

- La précision

- processus

- traitement

- proposé

- prototypes

- fournit

- publié

- fréquemment posées

- en ce qui concerne

- Exigences

- chercheurs

- Resources

- roy

- montrer

- sur mesure

- Standard

- rester

- pertinence

- Système

- Technique

- que

- qui

- La

- El futuro

- leur

- Ces

- this

- titré

- à

- traditionnel

- type

- université

- utilisé

- variété

- divers

- vu

- ab

- était

- we

- poids

- Quoi

- quand

- comprenant

- dans les

- activités principales

- zéphyrnet