Jay Dawani est le co-fondateur et PDG de Laboratoires lémuriens, une startup développant une plate-forme de calcul accélérée spécialement conçue pour les applications d'IA. La plateforme brise les barrières matérielles pour rendre le développement de l’IA plus rapide, moins cher, plus durable et accessible à un plus grand nombre d’entreprises.

Avant de fonder Lemurian, Jay a fondé deux autres sociétés dans le domaine de l'IA. Il est également l’auteur du célèbre ouvrage «Mathématiques pour l'apprentissage profond. »

Expert en intelligence artificielle, robotique et mathématiques, Jay a été CTO de BlocPlay, une société publique qui construit une plateforme de jeu basée sur la blockchain, et a été directeur de l'IA chez GEC, où il a dirigé le développement de plusieurs projets clients couvrant des domaines. de la vente au détail, du commerce algorithmique, du repliement des protéines, des robots pour l'exploration spatiale, des systèmes de recommandation, etc. Dans ses temps libres, il a également été conseiller au NASA Frontier Development Lab, Spacebit et SiaClassic.

La dernière fois que nous avons présenté Lemurian Labs, vous vous êtes concentré sur la robotique et l'IA de pointe. Vous vous concentrez désormais sur le centre de données et l'infrastructure cloud. Que s’est-il passé qui vous a donné envie de changer de direction ?

En effet, nous sommes passés de la création d'un système sur puce hautes performances et à faible latence pour les applications robotiques autonomes qui pourraient accélérer l'ensemble de la boucle détection-planification-action à la création d'un accélérateur spécifique à un domaine pour l'IA axé sur les applications à l'échelle du centre de données. . Mais ce n’était pas simplement un pivot ordinaire ; c’était un appel de clairon auquel nous pensions avoir la responsabilité de répondre.

En 2018, nous travaillions à la formation d'un modèle paramétrique de 2.1 milliards de dollars, mais nous avons abandonné cet effort car le coût était si extraordinairement élevé que nous ne pouvions pas le justifier. Imaginez donc ma surprise que GPT3, qu'OpenAI a publié sous le nom de ChatGPT en novembre 2022, soit un modèle de paramètres de 175 milliards de dollars. Ce modèle est plus de 80 fois plus grand que celui sur lequel nous travaillions à peine 4 ans plus tôt, ce qui est à la fois excitant et effrayant.

Le coût de la formation d’un tel modèle est pour le moins stupéfiant. Sur la base des tendances actuelles en matière d’évolution, nous pouvons nous attendre à ce que le coût de formation d’un modèle d’IA d’avant-garde dépasse le milliard de dollars dans un avenir pas trop lointain. Même si les capacités de ces modèles sont étonnantes, leur coût est ridiculement élevé. Sur la base de cette trajectoire, seule une poignée d’entreprises très bien dotées en ressources et disposant de leurs propres centres de données seront en mesure de se permettre de former, de déployer et d’affiner ces modèles. Ce n’est pas uniquement parce que le calcul est coûteux et gourmand en énergie, mais aussi parce que les piles logicielles sur lesquelles nous comptons n’ont pas été conçues pour ce monde.

En raison de contraintes géographiques et énergétiques, il n’existe qu’un nombre limité d’endroits où construire des centres de données. Pour répondre aux exigences de calcul de l’IA, nous devons être capables de construire des machines à l’échelle zetta sans avoir besoin de 20 réacteurs nucléaires pour les alimenter. Nous avons besoin d’une solution plus pratique, évolutive et économique. Nous avons regardé autour de nous et n’avons vu personne sur le point de résoudre ce problème. Nous sommes donc allés à la planche à dessin pour examiner le problème de manière globale en tant que système de systèmes et raisonner sur une solution à partir des premiers principes. Nous nous sommes demandé comment concevoir la pile complète, du logiciel au matériel, si nous devions répondre de manière économique à 10 milliards de requêtes LLM par jour. Nous avons jeté notre dévolu sur une machine zettascale de moins de 200 MW, d’ici 2028.

L’astuce consiste à l’envisager du point de vue d’une mise à l’échelle incommensurable : différentes parties d’un système suivent des règles de mise à l’échelle différentes, de sorte qu’à un moment donné, les choses cessent de fonctionner, commencent à se briser ou le compromis coût-bénéfice n’a plus de sens. Lorsque cela se produit, la seule option est de repenser le système. Notre évaluation et notre solution englobent la charge de travail, le système numérique, le modèle de programmation, le compilateur, le runtime et le matériel de manière globale.

Heureusement, nos investisseurs existants et le reste du marché voient la vision, et nous avons levé un tour de table de 9 millions de dollars pour développer notre format numérique – PAL, explorer l'espace de conception et converger vers une architecture pour notre accélérateur spécifique à un domaine, et concevoir notre compilateur et runtime. Dans les simulations, nous avons pu obtenir un gain de débit 20 fois supérieur à celui des GPU modernes avec une empreinte énergétique inférieure, et nous prévoyons d'être en mesure de fournir un avantage 8 fois supérieur en termes de performances système pour un coût total de possession sur la même technologie de transistor.

Inutile de dire que nous avons beaucoup de travail devant nous, mais nous sommes très enthousiasmés par la perspective de pouvoir redéfinir l'économie des centres de données pour garantir un avenir où l'IA sera largement accessible à tous.

Cela semble certainement excitant et ces chiffres semblent impressionnants. Mais vous avez mentionné les systèmes numériques, le matériel, les compilateurs et les environnements d'exécution comme toutes les choses sur lesquelles vous vous concentrez – cela semble être beaucoup de choses à entreprendre en même temps pour n'importe quelle entreprise. Cela semble être une proposition très risquée. Les startups ne sont-elles pas censées être plus ciblées ?

Cela ressemble à de nombreux efforts différents, mais il s’agit en fait d’un seul effort avec de nombreuses parties interconnectées. Résoudre un seul de ces éléments indépendamment des autres ne fera qu’entraver le potentiel d’innovation, car cela aboutira à négliger les inefficacités et les goulots d’étranglement systémiques. Jensen Huang l'a très bien dit : « Pour être une entreprise d'informatique accélérée, vous devez être une entreprise complète », et je suis entièrement d'accord. Ce n’est pas pour rien qu’ils sont actuellement leaders sur le marché. Mais je contesterais l’idée selon laquelle nous ne sommes pas concentrés. C'est sur la manière dont nous envisageons le problème de manière globale et sur la meilleure façon de le résoudre pour nos clients que nous nous concentrons.

Cela nécessite une approche multidisciplinaire comme la nôtre. Chaque partie de notre travail informe et soutient les autres, nous permettant de créer une solution qui est bien plus que la somme de ses parties. Imaginez si vous deviez construire une voiture de course. Vous ne choisiriez pas arbitrairement un châssis, ajouteriez des pneus de course et installeriez le moteur le plus puissant que vous puissiez trouver pour le piloter, n'est-ce pas ? Vous penseriez à l'aérodynamique de la carrosserie de la voiture pour réduire la traînée et améliorer la force d'appui, optimiser la répartition du poids pour une bonne maniabilité, concevoir le moteur sur mesure pour des performances maximales, obtenir un système de refroidissement pour éviter la surchauffe, spécifier un arceau de sécurité pour assurer la sécurité du conducteur. , etc. Chacun de ces éléments s’appuie et informe l’autre.

Cela dit, il est risqué d’essayer de tout faire en même temps pour n’importe quelle entreprise, quel que soit son secteur. Pour gérer les risques, nous adoptons une approche progressive, nous permettant de valider notre technologie auprès des clients et d'ajuster notre stratégie si nécessaire. Nous avons prouvé que notre format numérique fonctionne et qu'il offre une meilleure zone de performances en termes de puissance que les types à virgule flottante équivalents, tout en ayant également de meilleures propriétés numériques qui facilitent la quantification des réseaux neuronaux avec des largeurs de bits plus petites. Nous avons conçu une architecture dans laquelle nous avons confiance et qui convient à la fois à la formation et à l'inférence. Mais le plus important est de trouver le bon logiciel, et c’est l’essentiel de notre objectif immédiat. Nous devons nous assurer que nous prenons les bonnes décisions dans notre pile logicielle en fonction de la situation dans laquelle nous envisageons le monde dans un an ou deux ou plus.

Créer une entreprise de quincaillerie est difficile, coûteux et prend beaucoup de temps. L’accent mis sur les logiciels semble à première vue être une activité très viable en soi, et potentiellement plus attrayante pour les investisseurs dans le climat actuel. Pourquoi faites-vous également du matériel informatique alors que de nombreuses entreprises bien financées dans le domaine ferment leurs portes, ont du mal à être adoptées par les clients et que les grands acteurs construisent leur propre matériel ?

Vous avez tout à fait raison : les entreprises de logiciels ont généralement pu lever des capitaux beaucoup plus facilement que les entreprises de matériel informatique, et ce matériel est très résistant. Nous nous concentrons actuellement beaucoup sur les logiciels, car c'est là que nous voyons le plus gros problème. Soyons clairs, le problème n'est pas de savoir si je peux faire fonctionner des noyaux sur un CPU ou un GPU avec des performances élevées ; c'est un problème résolu depuis longtemps. Le problème d'aujourd'hui est de savoir comment permettre aux développeurs d'obtenir plus facilement plus de performances, de manière productive, à partir de plusieurs milliers de clusters de nœuds constitués de calculs hétérogènes, sans leur demander de remanier leur flux de travail.

C'est le problème que nous nous efforçons actuellement de résoudre avec une pile logicielle qui donne aux développeurs des super pouvoirs et libère toutes les capacités des ordinateurs à l'échelle des entrepôts, afin que nous puissions former et déployer des modèles d'IA de manière plus économique.

En ce qui concerne l’investissement, oui, les sociétés de capital-risque sont plus sélectives quant au type d’entreprises qu’elles soutiennent, mais cela signifie également qu’elles recherchent des sociétés ayant le potentiel d’offrir des produits véritablement révolutionnaires qui ont une voie claire vers la commercialisation tout en ayant un impact significatif. Nous avons appris des défis et des erreurs des autres et avons activement conçu notre modèle commercial et notre feuille de route pour faire face aux risques. Il est également important de noter que ce qui fait le succès des startups est rarement la facilité avec laquelle elles peuvent lever des fonds de capital-risque, mais plutôt leur ingéniosité, leur entêtement et leur orientation client.

Et avant que vous ne le demandiez, nous travaillons toujours sur le matériel, mais principalement sur la simulation pour le moment. Nous n'avons pas l'intention de nous arrêter avant un moment. Mais nous pouvons garder cette conversation pour une autre fois.

C’est certainement convaincant et votre approche progressive est très différente de ce que nous avons vu faire par d’autres fabricants de matériel. Je comprends le problème que vous dites que votre pile logicielle résoudra, mais comment votre logiciel se différencie-t-il des différents efforts du marché ?

La plupart des entreprises auxquelles vous faites référence s'efforcent de faciliter la programmation des GPU en introduisant des modèles de programmation basés sur des tuiles ou des mappages de tâches pour obtenir plus de performances des GPU, ou en créant de nouveaux langages de programmation pour obtenir des noyaux hautes performances planifiés sur différents plates-formes avec support pour l'assemblage en ligne. Ce sont des problèmes importants auxquels ils s’attaquent, mais nous considérons que le problème que nous résolvons est presque orthogonal.

Pensons un instant à la cadence des transitions matérielles et logicielles. Les architectures monocœur ont amélioré leurs performances grâce à la vitesse d'horloge et à la densité des transistors, mais les vitesses d'horloge ont finalement atteint un plateau. Le parallélisme utilisant de nombreux cœurs a contourné ce problème et fourni des accélérations considérables. Il a fallu environ une décennie aux logiciels pour rattraper leur retard, car les modèles de programmation, les compilateurs et les environnements d'exécution ont dû être repensés pour aider les développeurs à extraire la valeur de ce paradigme. Ensuite, les GPU ont commencé à devenir des accélérateurs à usage général, toujours avec un modèle de programmation différent. Encore une fois, il a fallu près d’une décennie aux développeurs pour extraire de la valeur ici.

Encore une fois, le matériel atteint un plateau : la loi de Moore, les contraintes énergétiques et thermiques, les goulots d'étranglement de la mémoire et la diversité des charges de travail ainsi que le besoin de calcul exponentiellement plus important nous poussent à construire des architectures informatiques de plus en plus hétérogènes pour de meilleures performances, efficacité et coût total. Ce changement de matériel créera bien sûr des défis pour les logiciels, car nous ne disposons pas des compilateurs et des environnements d'exécution appropriés pour prendre en charge la prochaine évolution de l'informatique. Cette fois cependant, nous ne devrions pas avoir à attendre encore 10 ans pour que les logiciels extraient la valeur des architectures hétérogènes ou des grands clusters, surtout lorsqu'ils sont inutilisés à plus de 80 %.

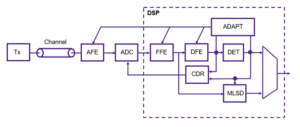

Nous nous concentrons sur la création d'un modèle de programmation prenant en compte l'hétérogénéité avec un parallélisme basé sur les tâches, abordant les performances portables avec des optimisations multi-processeurs, une compilation contextuelle et une allocation dynamique des ressources. Et pour nous, peu importe qu'il s'agisse d'un CPU, d'un GPU, d'un TPU, d'un SPU (architecture Lémurienne) ou d'un maillage de tous. Je sais que cela ressemble à beaucoup de mots fantaisistes, mais ce que cela signifie réellement, c'est que nous avons rendu possible la programmation de n'importe quel type de processeur avec une seule approche, et que nous pouvons porter le code d'un type de processeur à un autre avec un minimum de ressources. sans avoir à sacrifier les performances, et planifiez le travail de manière adaptative et dynamique sur tous les nœuds.

Si ce que vous dites est vrai, vous pourriez redéfinir complètement l’informatique. Parlons de financement. Vous avez levé 9 millions de dollars en financement de démarrage l'année dernière, ce qui signifie un fort soutien des investisseurs et une confiance en votre vision. Qu'as-tu fait depuis ?

Au cours de la dernière année, grâce au financement de démarrage, nous avons fait des progrès significatifs. Avec notre équipe désormais composée de 20 membres, nous avons méticuleusement relevé les défis, dialogué avec les clients et affiné notre approche.

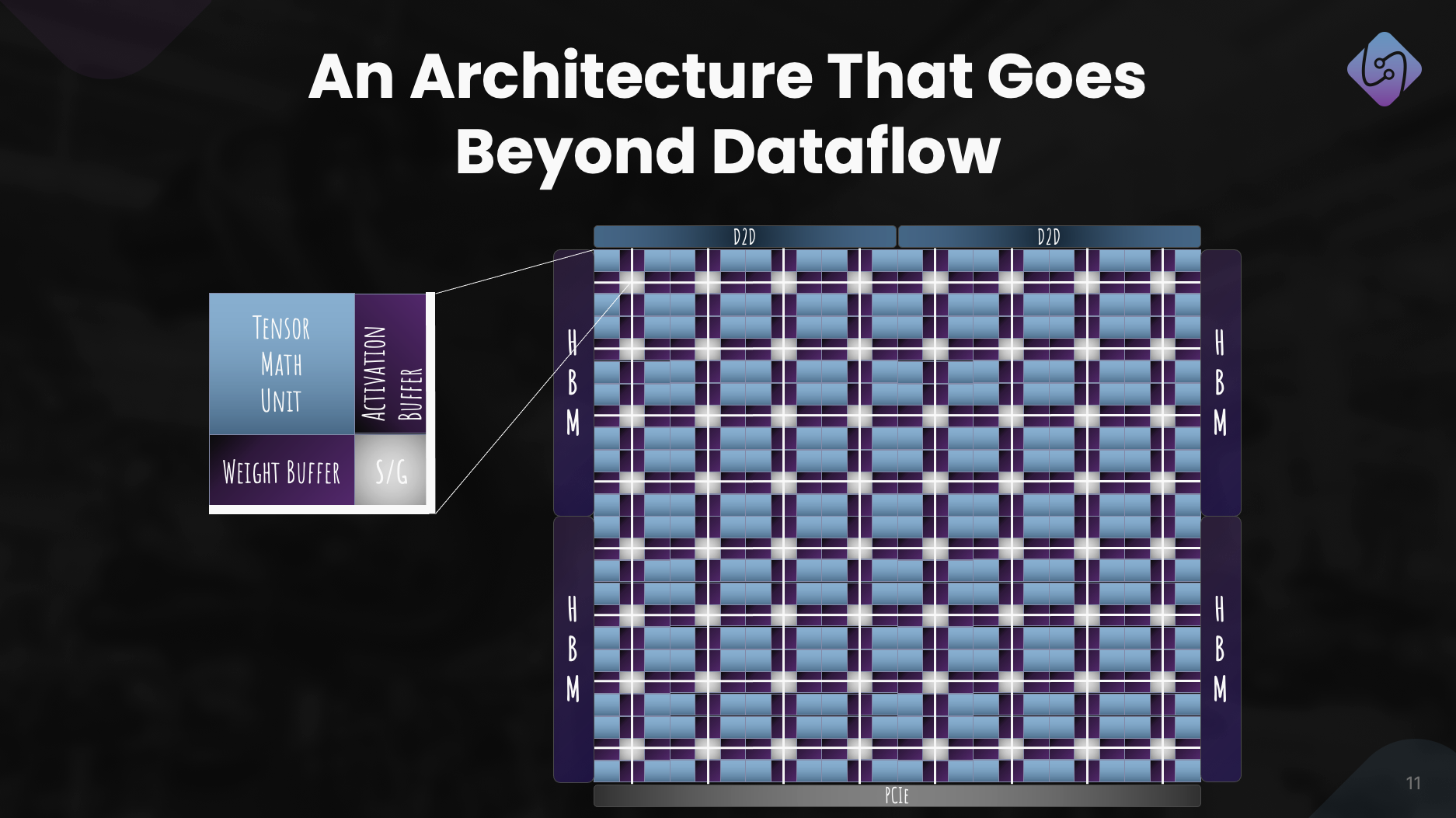

Nous nous sommes concentrés sur l'amélioration de PAL pour la formation et l'inférence, avons exploré l'architecture informatique de notre accélérateur et développé un simulateur pour les mesures de performance. Simultanément, nous avons repensé notre pile logicielle pour les applications de centres de données, en mettant l'accent sur l'informatique hétérogène.

Cet effort a abouti à une architecture bien définie, démontrant l'efficacité de PAL pour l'IA à grande échelle. Au-delà des progrès technologiques, nous avons poursuivi les collaborations et la sensibilisation pour démocratiser l’accès. Ces efforts permettent à Lemurian Labs de relever les défis immédiats des clients, en se préparant à la sortie de notre silicium de production.

Quels sont les projets à moyen terme de Lemurian Labs concernant le développement de la pile logicielle, les collaborations et l'amélioration de l'architecture de l'accélérateur ?

Notre objectif immédiat est de créer une pile logicielle ciblant les CPU, les GPU et nos accélérateurs d'IA avec des performances portables, qui sera mise à la disposition des premiers partenaires à la fin de l'année. Nous sommes actuellement en conversation avec la plupart des principales sociétés de semi-conducteurs, fournisseurs de services cloud, hyperscalers et sociétés d'IA pour leur donner accès à notre compilateur et à notre environnement d'exécution. En parallèle, nous continuons à travailler et à améliorer l'architecture de notre accélérateur pour un système matériel et logiciel véritablement co-conçu. Et bien sûr, nous venons de commencer à augmenter notre série A avec un très fort intérêt de la part de la communauté des investisseurs, ce qui nous permettra d'agrandir notre équipe et d'atteindre notre objectif de livraison de produits logiciels en fin d'année.

En conclusion, comment voyez-vous Lemurian Labs contribuer à changer le paysage du développement, de l’accessibilité et de l’équité de l’IA dans les années à venir ?

Nous n’avons pas eu l’intention de redéfinir l’informatique uniquement dans un but commercial ou pour le plaisir. En tant que Lémuriens, notre force motrice est que nous croyons au potentiel de transformation de l’IA et que plus que quelques entreprises devraient avoir les ressources nécessaires pour définir l’avenir de cette technologie et la manière dont nous l’utilisons. Nous ne trouvons pas non plus acceptable que l'infrastructure des centres de données pour l'IA soit en passe de consommer jusqu'à 20 % de l'énergie mondiale d'ici 2030. Nous nous sommes tous réunis parce que nous pensons qu'il existe une meilleure voie à suivre pour la société si nous pouvons faire L'IA plus accessible en réduisant considérablement les coûts associés, en accélérant le rythme de l'innovation en matière d'IA et en élargissant son impact. En relevant les défis de l’infrastructure matérielle actuelle, nous cherchons à ouvrir la voie à l’autonomisation d’un milliard de personnes avec les capacités de l’IA, garantissant ainsi une distribution équitable de cette technologie avancée. Nous espérons que notre engagement en faveur de solutions axées sur les produits, de collaboration et d’innovation continue nous positionnera comme une force motrice pour façonner l’avenir du développement de l’IA afin qu’il soit positif.

Lisez aussi:

Partagez cet article via:

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- PlatoHealth. Veille biotechnologique et essais cliniques. Accéder ici.

- La source: https://semiwiki.com/ceo-interviews/341485-ceo-interview-jay-dawani-of-lemurian-labs-2/

- :possède

- :est

- :ne pas

- :où

- 9 millions de dollars

- $UP

- 1

- 10

- 20

- 2018

- 2022

- 2028

- 2030

- 20x

- 300

- 4

- a

- Capable

- Qui sommes-nous

- absolument

- accélérer

- accéléré

- accélérateur

- accélérateurs

- acceptable

- accès

- accessibilité

- accessible

- atteindre

- à travers

- activement

- ajouter

- propos

- adressé

- adresser

- régler

- Adoption

- Avancée

- Technologie avancée

- progrès

- conseiller

- encore

- devant

- AI

- Modèles AI

- algorithmique

- trading algorithmique

- Tous

- allocation

- Permettre

- presque

- aussi

- Amazon

- an

- ainsi que les

- Une autre

- répondre

- tous

- chacun.e

- attirant

- applications

- une approche

- arbitrairement

- architecture

- architectures

- SONT

- domaines

- autour

- artificiel

- intelligence artificielle

- AS

- demander

- demandant

- Assemblée

- Évaluation de risque climatique

- associé

- étonnant

- At

- auteur

- autonome

- disponibles

- RETOUR

- obstacles

- basé

- BE

- car

- devenir

- était

- before

- va

- philosophie

- CROYONS

- profiter

- LES MEILLEURS

- Améliorée

- Au-delà

- plus gros

- Milliards

- basé sur blockchain

- planche

- corps

- tous les deux

- goulets d'étranglement

- Rupture

- pauses

- élargir

- construire

- Développement

- construit

- construit

- masse

- la performance des entreprises

- modèle d'affaires

- entreprises

- mais

- by

- Cadence

- Appelez-nous

- venu

- CAN

- Peut obtenir

- capacités

- aptitude

- capital

- Attraper

- Canaux centraux

- CEO

- Entretien avec le PDG

- Assurément

- challenge

- globaux

- en changeant

- châssis

- ChatGPT

- moins chère

- clair

- client

- Climat

- horloge

- fermeture

- le cloud

- infrastructure de cloud

- Co-fondateur

- code

- collaboration

- collaborations

- Venir

- commercial

- commercialisation

- engagement

- Communautés

- Sociétés

- Société

- par rapport

- irrésistible

- compilateur

- complètement

- composants électriques

- calcul

- ordinateur

- ordinateurs

- informatique

- confiance

- contraintes

- consommer

- continuer

- continu

- contribuant

- converger

- Conversation

- conversations

- Système de refroidissement

- correct

- Prix

- pourriez

- cours

- couvrant

- Processeur

- engendrent

- Cross

- CTO

- Courant

- Lecture

- Customiser

- conception personnalisée

- des clients

- Clients

- données

- Centre de données

- Datacenter

- journée

- décennie

- décisions

- profond

- Vous permet de définir

- livrer

- page de livraison.

- demandes

- démocratiser

- densité

- déployer

- Conception

- un

- développer

- développé

- mobiles

- développement

- Développement

- DID

- différent

- différencier

- Directeur

- Loin

- distribution

- Diversité

- do

- Ne fait pas

- faire

- dollars

- domaine

- fait

- Ne pas

- portes

- Dramatiquement

- dessin

- driver

- conduite

- Goutte

- Dynamic

- dynamiquement

- chacun

- Plus tôt

- "Early Bird"

- plus facilement

- même

- économiquement

- Économie

- Edge

- efficacité

- efficace

- effort

- efforts

- éléments

- mettant l'accent

- l'autonomisation des

- permettre

- permettant

- englobe

- fin

- énergie

- engagé

- Moteur

- de renforcer

- améliorer

- assurer

- assurer

- Tout

- équitable

- équité

- Équivalent

- notamment

- etc

- faire une éventuelle

- tout le monde

- évolution

- dépassent

- excité

- passionnant

- existant

- attendre

- cher

- expert

- exploration

- explorez

- Exploré

- exponentielle

- extrait

- extraordinairement

- fait

- fantaisie

- loin

- plus rapide

- en vedette

- ressentir

- se sentait

- few

- Trouvez

- Prénom

- flottant

- Focus

- concentré

- mettant l'accent

- suivre

- numérique

- Pour

- Force

- le format

- Avant

- Fondée

- fonder

- de

- frontière

- alimenté

- plein

- Un paquet entier

- d’étiquettes électroniques entièrement

- amusement

- financement

- avenir

- L'avenir de l'IA

- Gain

- gagné

- jeux

- Plateforme de jeu

- engrenage

- Général

- généralement

- géographique

- obtenez

- obtention

- Donner

- donné

- donne

- objectif

- aller

- Bien

- eu

- GPU

- GPU

- révolutionnaire

- Croître

- ait eu

- poignée

- Maniabilité

- arrivé

- arrive

- Matériel

- Vous avez

- ayant

- he

- vous aider

- ici

- Haute

- empêcher

- sa

- Frappé

- frappe

- d'espérance

- Comment

- How To

- HTTPS

- huang

- Avide

- i

- if

- image

- Immédiat

- Impact

- important

- impressionnant

- améliorer

- amélioration

- in

- de plus en plus

- industrie

- inefficacités

- informe

- Infrastructure

- Innovation

- Intelligence

- l'intention

- interconnecté

- intérêt

- Interview

- Découvrez le tout nouveau

- un investissement

- investor

- Investisseurs

- seul

- IT

- SES

- Jensen Huang

- jpg

- juste

- XNUMX éléments à

- Genre

- Savoir

- laboratoire

- Labs

- paysage d'été

- Langues

- gros

- plus importantes

- Nom de famille

- L'année dernière

- Latence

- Droit applicable et juridiction compétente

- leader

- conduisant

- savant

- au

- LED

- laisser

- comme

- ll

- llm

- Location

- Longtemps

- plus long

- Style

- regardé

- recherchez-

- Lot

- Faible

- abaissement

- click

- Les machines

- LES PLANTES

- a prendre une

- FAIT DU

- Fabrication

- gérer

- de nombreuses

- Marché

- Leader du marché

- mathématiques

- Matière

- largeur maximale

- maximales

- Mai..

- me

- veux dire

- Découvrez

- Membres

- Mémoire

- mentionné

- seulement

- engrener

- méticuleusement

- Métrique

- million

- minimal

- erreurs

- modèle

- numériques jumeaux (digital twin models)

- Villas Modernes

- moment

- PLUS

- (en fait, presque toutes)

- beaucoup

- multidisciplinaire

- my

- NASA

- Besoin

- nécessaire

- besoin

- réseaux

- Neural

- les réseaux de neurones

- Nouveauté

- next

- aucune

- nœud

- nœuds

- noter

- Notion

- Novembre

- maintenant

- nucléaire

- nombre

- numéros

- of

- code

- on

- une fois

- ONE

- uniquement

- OpenAI

- optimisations

- Optimiser

- Option

- or

- de commander

- ordinaire

- Autre

- Autres

- nos

- nous-mêmes

- ande

- sensibilisation

- plus de

- Réviser

- propre

- possession

- Rythme

- paradigme

- Parallèle

- paramètre

- partie

- partenaires,

- les pièces

- passé

- chemin

- paver

- Personnes

- performant

- phasé

- en particulier pendant la préparation

- Pivoter

- Des endroits

- plans

- plateforme

- Plateformes

- Platon

- Intelligence des données Platon

- PlatonDonnées

- plus

- Point

- Point de vue

- portable

- position

- positions

- positif

- possible

- Post

- défaillances

- l'éventualité

- power

- solide

- Méthode

- assez

- empêcher

- qui se déroulent

- principes

- Problème

- d'ouvrabilité

- traitement

- Processeur

- Produit

- Vidéo

- Produits

- Programme

- Programmation

- langages de programmation

- projets

- propriétés

- proposition

- perspective

- Protéines

- proven

- à condition de

- fournisseurs

- public

- purement

- but

- Poussant

- requêtes

- Race

- course

- augmenter

- collectés

- élevage

- rarement

- Lire

- vraiment

- raison

- Recommandation

- redéfinir

- reconcevoir

- réduire

- référant

- raffiné

- en ce qui concerne

- réinventée

- libérer

- libéré

- compter

- a besoin

- ressource

- Resources

- responsabilité

- REST

- résulté

- Résultats

- détail

- bon

- risques

- Risqué

- feuille de route

- robotique

- Collaboratif

- Roulent

- grossièrement

- Round

- pour le running

- sacrifier

- des

- Saïd

- même

- Épargnez

- dire

- dire

- évolutive

- Escaliers intérieurs

- mise à l'échelle

- calendrier

- prévu

- sur le lien

- seed

- Financement de démarrage

- Tour de semences

- Chercher

- semble

- vu

- sélectif

- semi-conducteur

- sens

- Série

- de série A

- besoin

- servi

- service

- les fournisseurs de services

- set

- plusieurs

- mise en forme

- décalage

- devrait

- mettre en valeur

- Sites

- significative

- signifie

- Silicium

- simulation

- simulations

- simulateur

- simultanément

- depuis

- unique

- considérable

- Glissement

- faibles

- So

- Société

- Logiciels

- sur mesure

- Solutions

- RÉSOUDRE

- résolu

- Résoudre

- quelques

- Son

- sons

- Space

- exploration de l'espace

- Spatial

- groupe de neurones

- spécifiquement

- vitesse

- vitesses

- empiler

- Combos

- échelonnement

- Commencer

- j'ai commencé

- Commencez

- Startups

- Encore

- Arrêter

- de Marketing

- progrès

- STRONG

- Luttant

- réussi

- tel

- convient

- somme

- Support

- Les soutiens

- supposé

- surprise

- durable

- combustion propre

- systémique

- Système

- Prenez

- prend

- prise

- discutons-en

- le ruban

- Target

- objectifs

- équipe

- technologie

- Technologie

- que

- qui

- Les

- El futuro

- Le paysage

- le monde

- leur

- Les

- puis

- Là.

- thermique

- Ces

- l'ont

- des choses

- penser

- this

- ceux

- bien que?

- mille

- Avec

- débit

- fiable

- pneus

- à

- aujourd'hui

- ensemble

- trop

- a

- Total

- difficile

- vers

- suivre

- Commerce

- Train

- Formation

- trajectoire

- transformation

- transition

- transitions

- Trends

- astuce

- oui

- vraiment

- Essai

- deux

- types

- sous

- comprendre

- unité

- déverrouille

- sur

- us

- utilisé

- en utilisant

- VALIDER

- Plus-value

- divers

- VC

- Financement VC

- VCs

- très

- via

- viable

- Voir

- vision

- attendez

- souhaitez

- Entrepots

- était

- we

- poids

- WELL

- bien défini

- est allé

- ont été

- Quoi

- quand

- que

- qui

- tout en

- why

- sera

- comprenant

- sans

- des mots

- activités principales

- workflow

- de travail

- vos contrats

- world

- monde

- pourra

- an

- années

- Oui

- you

- Votre

- zéphyrnet