محتوای حمایت شده

ChatGPT و ابزارهای مشابه مبتنی بر مدل های زبان بزرگ (LLM) شگفت انگیز هستند. اما آنها ابزار همه منظوره نیستند.

درست مانند انتخاب ابزارهای دیگر برای ساختن و ایجاد. شما باید مورد مناسب را برای کار انتخاب کنید. سعی نمی کنید پیچ را با چکش سفت کنید یا با لیسک همبرگر را برگردانید. این روند ممکن است ناخوشایند باشد و منجر به یک شکست کثیف شود.

مدلهای زبانی مانند LLM تنها بخشی از مجموعه ابزار یادگیری ماشینی گستردهتر را تشکیل میدهند که هم هوش مصنوعی مولد و هم هوش مصنوعی پیشبینیکننده را در بر میگیرد. انتخاب نوع صحیح مدل یادگیری ماشین برای همسویی با الزامات وظیفه شما بسیار مهم است.

بیایید عمیق تر به این موضوع بپردازیم که چرا LLM ها برای کمک به شما در پیش نویس متن یا ایده های هدیه ایده پردازی مناسب تر هستند تا برای مقابله با مهم ترین وظایف مدل سازی پیش بینی کننده کسب و کار شما. هنوز یک نقش حیاتی برای مدلهای یادگیری ماشینی "سنتی" که قبل از LLM بودند و بارها ارزش خود را در مشاغل ثابت کردهاند، وجود دارد. ما همچنین یک رویکرد پیشگام برای استفاده از این ابزارها با هم بررسی خواهیم کرد - یک پیشرفت هیجان انگیز که ما در Pecan آن را می نامیم. GenAI پیش بینی کننده.

LLM ها برای کلمات طراحی شده اند نه اعداد

در یادگیری ماشینی، روشهای مختلف ریاضی برای تجزیه و تحلیل آنچه به عنوان «دادههای آموزشی» شناخته میشود، استفاده میشود - مجموعه دادههای اولیه نشاندهنده مشکلی که یک تحلیلگر داده یا دانشمند داده امیدوار است حل کند.

اهمیت داده های آموزشی را نمی توان اغراق کرد. این الگوها و روابطی را که یک مدل یادگیری ماشینی میآموزد تا زمانی که بعداً دادههای جدید و نادیدهای به آن داده میشود، پیشبینی کند، در خود جای میدهد.

بنابراین، به طور خاص LLM چیست؟ مدلهای زبان بزرگ یا LLM زیر چتر یادگیری ماشینی قرار میگیرند. آنها از یادگیری عمیق سرچشمه می گیرند و ساختار آنها به طور خاص برای پردازش زبان طبیعی توسعه یافته است.

ممکن است بگویید آنها بر پایه کلمات ساخته شده اند. هدف آنها صرفاً پیش بینی کلمه بعدی در یک دنباله از کلمات است. برای مثال، ویژگی تصحیح خودکار آیفونها در iOS 17 اکنون از یک LLM برای پیشبینی بهتر کلمه بعدی که به احتمال زیاد قصد تایپ کردن آن را دارید، استفاده میکند.

حالا تصور کنید که یک مدل یادگیری ماشینی هستید. (با ما همراه باشید، ما می دانیم که این یک کشش است.) شما برای پیش بینی کلمات آموزش دیده اید. شما میلیون ها کلمه را از طیف گسترده ای از منابع در مورد انواع موضوعات خوانده و مطالعه کرده اید. مربیان شما (معروف به توسعه دهندگان) به شما کمک کرده اند تا بهترین راه ها را برای پیش بینی کلمات و ایجاد متن جدید متناسب با درخواست کاربر بیاموزید.

اما اینجا یک پیچ و تاب است. یک کاربر اکنون یک صفحه گسترده گسترده از داده های مشتری و تراکنش، با میلیون ها ردیف اعداد، به شما می دهد و از شما می خواهد اعداد مربوط به این داده های موجود را پیش بینی کنید.

فکر میکنید پیشبینیهای شما چگونه خواهد بود؟ اول، احتمالاً از این که این کار با چیزی که برای یادگیری آن سخت کار کرده اید مطابقت ندارد، آزرده خاطر خواهید شد. (خوشبختانه، تا آنجایی که ما می دانیم، LLM ها هنوز احساساتی ندارند.) مهمتر از آن، از شما خواسته می شود تا کاری را انجام دهید که با آنچه آموخته اید مطابقت ندارد. و احتمالاً عملکرد خوبی نخواهید داشت.

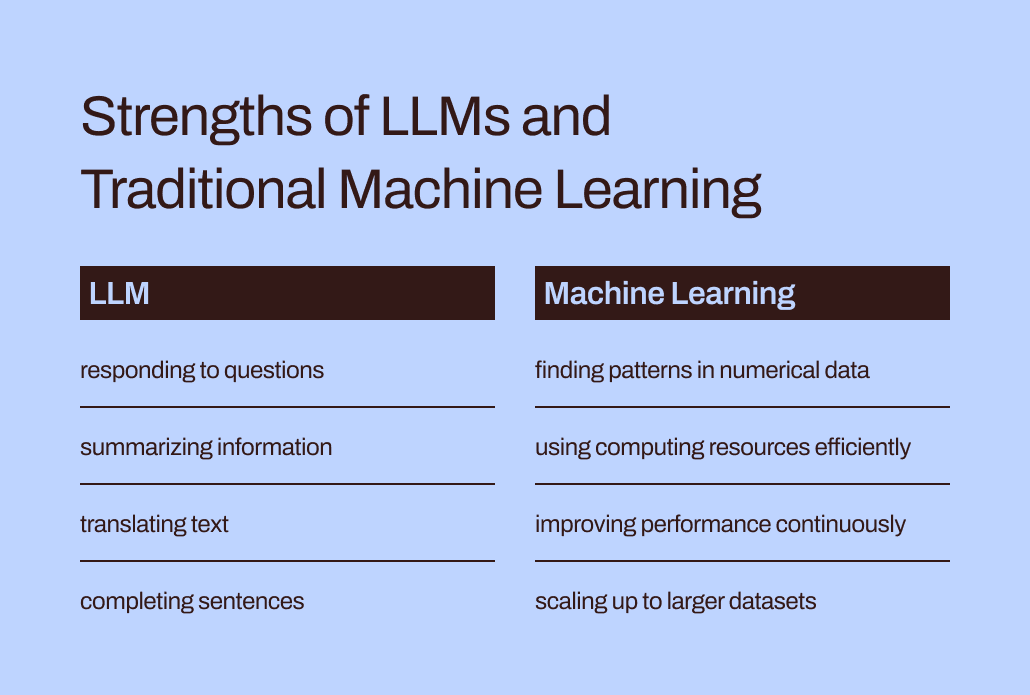

شکاف بین آموزش و تکلیف به توضیح اینکه چرا LLM ها برای کارهای پیش بینی شامل داده های عددی و جدولی مناسب نیستند کمک می کند - قالب داده اولیه که اکثر مشاغل جمع آوری می کنند. در عوض، یک مدل یادگیری ماشینی که بهطور خاص برای مدیریت این نوع دادهها ساخته و تنظیم شده است، مؤثرتر است. این به معنای واقعی کلمه برای این آموزش دیده است.

چالش های کارایی و بهینه سازی LLMs

روشهای یادگیری ماشین سنتی علاوه بر تطبیق بهتری برای دادههای عددی، بسیار کارآمدتر و آسانتر برای بهینهسازی عملکرد بهتر از LLM هستند.

بیایید به تجربه شما در جعل هویت یک LLM برگردیم. خواندن همه آن کلمات و مطالعه سبک و توالی آنها به نظر می رسد یک تن کار است، درست است؟ برای درونی کردن همه این اطلاعات تلاش زیادی میشود.

به طور مشابه، آموزش پیچیده LLM ها می تواند منجر به مدل هایی با میلیاردها پارامتر شود. این پیچیدگی به این مدل ها اجازه می دهد تا تفاوت های ظریف زبان انسانی را درک کنند و به آن پاسخ دهند. با این حال، زمانی که LLM ها پاسخ هایی را ایجاد می کنند، آموزش های سنگین با نیازهای محاسباتی سنگین همراه است. الگوریتمهای یادگیری ماشین «سنتی» با جهتگیری عددی، مانند درختهای تصمیمگیری یا شبکههای عصبی، احتمالاً به منابع محاسباتی بسیار کمتری نیاز دارند. و این مورد «بزرگتر بهتر است» نیست. حتی اگر LLMها بتوانند دادههای عددی را مدیریت کنند، این تفاوت به این معنی است که روشهای یادگیری ماشین سنتی هنوز سریعتر، کارآمدتر، از نظر زیستمحیطی پایدارتر و مقرونبهصرفهتر خواهند بود.

علاوه بر این، آیا تا به حال از ChatGPT پرسیده اید که چگونه می تواند پاسخ خاصی را ارائه دهد؟ پاسخ آن احتمالاً کمی مبهم خواهد بود:

من پاسخهایی را بر اساس ترکیبی از دادههای دارای مجوز، دادههای ایجاد شده توسط مربیان انسانی و دادههای در دسترس عموم تولید میکنم. آموزش من همچنین شامل مجموعه دادههای مقیاس بزرگی بود که از منابع مختلف، از جمله کتابها، وبسایتها و سایر متون به دست آمده بودند تا درک گستردهای از زبان انسان ایجاد کنند. فرآیند آموزش شامل انجام محاسبات بر روی هزاران GPU در طول هفته ها یا ماه ها است، اما جزئیات دقیق و مقیاس های زمانی اختصاصی OpenAI است.

How much of the “knowledge” reflected in that response came from the human trainers vs. the public data vs. books? Even ChatGPT itself isn’t sure: “The relative proportions of these sources are unknown, and I don’t have detailed visibility into which specific documents were part of my training set.”

It’s a bit unnerving to have ChatGPT provide such confident answers to your questions but not be able to trace its responses to specific sources. LLMs’ limited interpretability and explainability also pose challenges in optimizing them for particular business needs. It can be hard to understand the rationale behind their information or predictions. To further complicate things, certain businesses contend with regulatory demands that mean they must be able to explain the factors influencing a model’s predictions. All in all, these challenges show that traditional machine learning models — generally more interpretable and explainable — are likely better suited for business use cases.

مکان مناسب برای LLM در جعبه ابزار پیش بینی کسب و کار

بنابراین، آیا ما باید LLM ها را به وظایف مرتبط با کلمه خود رها کنیم و آنها را برای موارد استفاده پیش بینی کننده فراموش کنیم؟ در حال حاضر ممکن است به نظر برسد که آنها نمی توانند در پیش بینی ریزش مشتری یا ارزش طول عمر مشتری کمک کنند.

نکته اینجاست: در حالی که گفتن «مدلهای یادگیری ماشینی سنتی» باعث میشود این تکنیکها به طور گسترده قابل درک و استفاده آسان به نظر برسند، ما از تجربه خود در Pecan میدانیم که کسبوکارها هنوز تا حد زیادی در تلاش هستند تا حتی این اشکال آشناتر از هوش مصنوعی را بپذیرند.

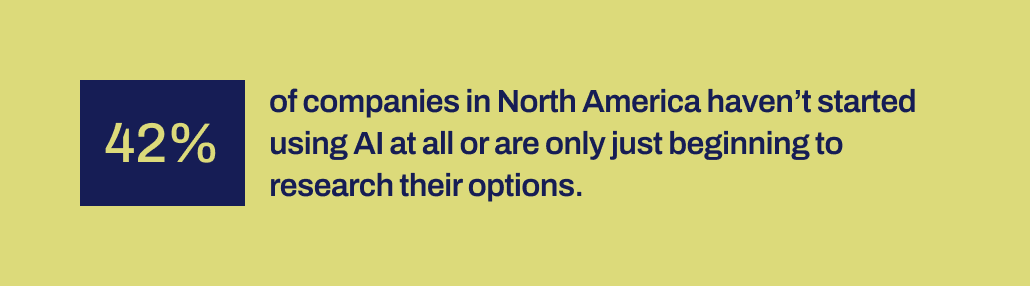

Recent research by Workday reveals that 42% of companies in North America either haven’t initiated the use of AI or are just in the early stages of exploring their options. And it’s been over a decade since machine learning tools became more accessible to companies. They’ve had the time, and various tools are available.

بنا به دلایلی، علیرغم سر و صدای زیاد در مورد علم داده و هوش مصنوعی – و پتانسیل تایید شده آنها برای تأثیر تجاری قابل توجه، اجرای موفقیت آمیز هوش مصنوعی به طور شگفت انگیزی نادر بوده است. برخی مکانیسم های مهم برای کمک به پل زدن بین وعده های داده شده توسط هوش مصنوعی و توانایی اجرای مولد آن وجود ندارد.

و این دقیقاً همان جایی است که ما معتقدیم LLM اکنون می تواند نقش مهمی را ایفا کند. LLM می تواند به کاربران تجاری کمک کند تا از شکاف بین شناسایی یک مشکل تجاری برای حل و توسعه یک مدل پیش بینی عبور کنند.

با LLMهایی که اکنون در تصویر هستند، تیمهای تجاری و دادهای که توانایی یا ظرفیت کدگذاری دستی مدلهای یادگیری ماشین را ندارند، اکنون میتوانند بهتر نیازهای خود را به مدلها ترجمه کنند. آنطور که والدین دوست دارند بگویند، میتوانند از کلمات خود برای شروع فرآیند مدلسازی استفاده کنند.

ادغام LLM ها با تکنیک های یادگیری ماشین که برای برتری در داده های تجاری ساخته شده اند

این قابلیت اکنون در Predictive GenAI Pecan آمده است، که در حال ادغام نقاط قوت LLM با پلتفرم یادگیری ماشینی بسیار پیشرفته و خودکار ما است. چت پیشگویانه مبتنی بر LLM، ورودیهای یک کاربر تجاری را جمعآوری میکند تا تعریف و توسعه یک سؤال پیشبینیکننده را راهنمایی کند - مشکل خاصی که کاربر میخواهد با یک مدل حل کند.

سپس، با استفاده از GenAI، پلتفرم ما یک دفترچه یادداشت پیشبینی تولید میکند تا گام بعدی به سمت مدلسازی را آسانتر کند. باز هم، با تکیه بر قابلیت های LLM، نوت بوک حاوی پرس و جوهای SQL از پیش پر شده برای انتخاب داده های آموزشی برای مدل پیش بینی است. قابلیتهای آمادهسازی خودکار دادهها، مهندسی ویژگیها، ساخت مدل و قابلیتهای استقرار اسپند میتواند بقیه فرآیند را در زمان رکورد، سریعتر از هر راهحل مدلسازی پیشبینیکننده دیگری انجام دهد.

به طور خلاصه، Pecan's Predictive GenAI از مهارتهای زبانی بینظیر LLM استفاده میکند تا بهترین پلتفرم مدلسازی پیشبینیکننده در کلاس ما را برای کاربران تجاری در دسترستر و دوستانهتر کند. ما خوشحالیم که ببینیم این رویکرد چگونه به بسیاری از شرکتها کمک میکند تا با هوش مصنوعی موفق شوند.

بنابراین، در حالی که LLMs تنها برای رسیدگی به تمام نیازهای پیش بینی شما مناسب نیستند، آنها می توانند نقش قدرتمندی در پیشبرد پروژه های هوش مصنوعی شما داشته باشند. با تفسیر مورد استفاده شما و ارائه یک شروع اولیه با کد SQL تولید شده به طور خودکار، Predictive GenAI Pecan راه را در اتحاد این فناوری ها پیشروی می کند. تو می توانی اکنون با یک آزمایش رایگان آن را بررسی کنید.

- محتوای مبتنی بر SEO و توزیع روابط عمومی. امروز تقویت شوید.

- PlatoData.Network Vertical Generative Ai. به خودت قدرت بده دسترسی به اینجا.

- PlatoAiStream. هوش وب 3 دانش تقویت شده دسترسی به اینجا.

- PlatoESG. کربن ، CleanTech، انرژی، محیط، خورشیدی، مدیریت پسماند دسترسی به اینجا.

- PlatoHealth. هوش بیوتکنولوژی و آزمایشات بالینی. دسترسی به اینجا.

- منبع: https://www.kdnuggets.com/2024/01/pecan-llms-used-alone-cant-address-companys-predictive-needs?utm_source=rss&utm_medium=rss&utm_campaign=why-llms-used-alone-cant-address-your-companys-predictive-needs

- : دارد

- :است

- :نه

- :جایی که

- ٪۱۰۰

- 17

- a

- توانایی

- قادر

- درباره ما

- در دسترس

- تصدیق شده

- اضافه

- نشانی

- اتخاذ

- پس از

- از نو

- AI

- نام

- الگوریتم

- تراز

- معرفی

- اجازه می دهد تا

- تنها

- قبلا

- همچنین

- شگفت انگیز

- امریکا

- an

- روانکاو

- تحلیل

- و

- پاسخ

- پاسخ

- هر

- روش

- هستند

- دور و بر

- وارد

- AS

- همکاری

- At

- خودکار

- خودکار یادگیری ماشین

- بطور خودکار

- در دسترس

- به عقب

- مستقر

- BE

- خرس

- شد

- بوده

- شروع

- پشت سر

- بودن

- باور

- بهترین

- بهتر

- میان

- میلیاردها

- بیت

- پیچ

- کتاب

- هر دو

- فکر بکر وناگهانی

- بریج

- پل زدن

- گسترده تر

- بنا

- ساخته

- کسب و کار

- تاثیر کسب و کار

- کسب و کار

- اما

- by

- صدا

- آمد

- CAN

- قابلیت های

- قابلیت

- ظرفیت

- حمل

- مورد

- موارد

- معین

- چالش ها

- شکاف عظیم

- گپ

- GPT چت

- انتخاب

- رمز

- جمع آوری

- می آید

- شرکت

- شرکت

- پیچیده

- پیچیدگی

- محاسباتی

- محاسبات

- محاسبه

- مطمئن

- را تشکیل می دهند

- شامل

- اصلاح

- مقرون به صرفه

- میتوانست

- طراحی شده

- ایجاد

- ایجاد شده

- ایجاد

- بحرانی

- صلیب

- بسیار سخت

- مشتری

- داده ها

- تحلیلگر داده

- آماده سازی داده ها

- علم اطلاعات

- دانشمند داده

- مجموعه داده ها

- دهه

- تصمیم

- عمیق

- یادگیری عمیق

- عمیق تر

- تعریف

- خواسته

- گسترش

- طراحی

- با وجود

- دقیق

- جزئیات

- توسعه

- توسعه

- توسعه دهندگان

- در حال توسعه

- پروژه

- تفاوت

- مختلف

- DIG

- do

- اسناد و مدارک

- نمی کند

- دان

- آیا

- پیش نویس

- رسم

- در اوایل

- آسان تر

- ساده

- موثر

- بهره وری

- موثر

- تلاش

- هر دو

- شامل

- مهندسی

- از نظر محیطی

- اتر (ETH)

- حتی

- تا کنون

- مثال

- اکسل

- برانگیخته

- مهیج

- موجود

- تجربه

- توضیح دهید

- قابل توضیح

- اکتشاف

- بررسی

- عوامل

- شکست

- سقوط

- آشنا

- بسیار

- سریعتر

- ویژگی

- احساسات

- کمتر

- نام خانوادگی

- مناسب

- متناسب است

- فلیپ

- برای

- قالب

- اشکال

- خوشبختانه

- به جلو

- پایه

- رایگان

- دوستانه

- از جانب

- بیشتر

- فیوز کردن

- شکاف

- جنایی

- عموما

- تولید می کنند

- تولید

- تولید می کند

- مولد

- هوش مصنوعی مولد

- هدیه

- داده

- می دهد

- دادن

- Go

- هدف

- GPU ها

- راهنمایی

- بود

- چکش

- دسته

- اداره

- سخت

- آیا

- پناهگاه

- سر

- سنگین

- کمک

- کمک کرد

- کمک

- کمک می کند

- خیلی

- دارای

- امیدوار

- چگونه

- اما

- HTTPS

- انسان

- i

- ایده ها

- شناسایی

- if

- تصور کنید

- تأثیر

- انجام

- پیاده سازی ها

- مهم

- مهمتر

- in

- از جمله

- تأثیرگذار

- اطلاعات

- اول

- آغاز

- ورودی

- در عوض

- قصد

- به

- گرفتار

- شامل

- شامل

- IOS

- IT

- ITS

- خود

- کار

- تنها

- kdnuggets

- دانستن

- شناخته شده

- زبان

- بزرگ

- در مقیاس بزرگ

- تا حد زیادی

- بعد

- برجسته

- یاد گرفتن

- آموخته

- یادگیری

- ترک کردن

- مجاز

- عمر

- پسندیدن

- احتمالا

- محدود شده

- خیلی

- دستگاه

- فراگیری ماشین

- تکنیک های یادگیری ماشین

- ساخته

- ساخت

- باعث می شود

- بسیاری

- عظیم

- مسابقه

- ریاضی

- متوسط

- مکانیزم

- مربیان

- روش

- قدرت

- میلیون ها نفر

- گم

- مخلوط

- مدل

- مدل سازی

- مدل

- ماه

- بیش

- کارآمدتر

- اکثر

- متحرک

- بسیار

- باید

- my

- طبیعی

- زبان طبیعی

- پردازش زبان طبیعی

- نیاز

- نیازهای

- شبکه

- عصبی

- شبکه های عصبی

- جدید

- بعد

- شمال

- شمال امریکا

- دفتر یادداشت

- اکنون

- تفاوت های ظریف

- تعداد

- به دست آمده

- of

- on

- ONE

- فقط

- OpenAI

- بهینه سازی

- بهینه سازی

- بهینه سازی

- گزینه

- or

- دیگر

- ما

- خارج

- نتایج

- روی

- بیش از حد

- پارامترهای

- پدر و مادر

- بخش

- ویژه

- الگوهای

- انجام دادن

- کارایی

- انتخاب کنید

- تصویر

- پیشگام

- محل

- سکو

- افلاطون

- هوش داده افلاطون

- PlatoData

- بازی

- پتانسیل

- قوی

- دقیقا

- پیش بینی

- پیش بینی

- پیش بینی

- پیش بینی

- تهیه

- اصلی

- شاید

- مشکل

- روند

- در حال پردازش

- پروژه ها

- وعده

- اختصاصی

- اثبات شده

- ارائه

- عمومی

- عمومی

- نمایش ها

- سوال

- سوالات

- محدوده

- نادر

- منطق

- خواندن

- مطالعه

- دلیل

- رکورد

- پالوده

- منعکس شده

- تنظیم کننده

- مربوط

- روابط

- نسبی

- به طور مکرر

- نمایندگی

- درخواست

- مورد نیاز

- تحقیق

- منابع

- پاسخ

- پاسخ

- پاسخ

- REST

- نتیجه

- نتیجه

- فاش می کند

- راست

- نقش

- در حال اجرا

- s

- گفتن

- گفته

- علم

- دانشمند

- دیدن

- به نظر می رسد

- را انتخاب کنید

- انتخاب

- دنباله

- تنظیم

- کوتاه

- باید

- نشان

- اهمیت

- قابل توجه

- مشابه

- به سادگی

- پس از

- مهارت ها

- So

- راه حل

- حل

- برخی از

- صدا

- برای تلفن های موبایل

- منابع

- خاص

- به طور خاص

- صفحه گسترده

- SQL

- مراحل

- شروع

- آغاز شده

- گام

- هنوز

- نقاط قوت

- ساختار

- تلاش

- مورد مطالعه قرار

- در حال مطالعه

- سبک

- موفق شدن

- موفق

- چنین

- مطمئن

- قابل تحمل

- T

- مقابله با

- گرفتن

- کار

- وظایف

- تیم ها

- تکنیک

- فن آوری

- متن

- نسبت به

- که

- La

- شان

- آنها

- اینها

- آنها

- چیز

- اشیاء

- فکر می کنم

- این

- کسانی که

- هزاران نفر

- سفت کردن

- زمان

- به

- با هم

- تن

- ابزار

- ابزار

- تاپیک

- نسبت به

- رد

- سنتی

- آموزش دیده

- آموزش

- معامله

- ترجمه کردن

- درختان

- امتحان

- دور زدن

- پیچ

- نوع

- چتر

- زیر

- فهمیدن

- درک

- فهمید

- متحد شدن

- ناشناخته

- بی نظیر

- us

- استفاده کنید

- مورد استفاده

- استفاده

- کاربر

- کاربران

- استفاده

- با استفاده از

- ارزش

- تنوع

- مختلف

- وسیع

- دید

- حیاتی

- vs

- می خواهد

- مسیر..

- راه

- we

- وب سایت

- هفته

- خوب

- بود

- چی

- چه شده است

- چه زمانی

- که

- در حین

- چرا

- به طور گسترده ای

- اراده

- با

- در داخل

- کلمه

- کلمات

- مهاجرت کاری

- مشغول به کار

- با ارزش

- خواهد بود

- هنوز

- شما

- شما

- زفیرنت