بازی دیگری که مدتها تصور میشد فتح برای هوش مصنوعی (AI) بسیار چالش برانگیز است، به دست رباتها افتاد: Stratego.

DeepNash، یک هوش مصنوعی ساخته شده توسط شرکت مستقر در لندن Deepmind، اکنون با انسان های متخصص در Stratego مطابقت دارد، یک بازی رومیزی که به تفکر استراتژیک بلندمدت در برابر اطلاعات ناقص نیاز دارد.

این آخرین شاهکار در پی یک پیروزی بزرگ دیگر برای هوش مصنوعی در بازی هایی که قبلاً تصور می شد نقطه قوت انسان است، به دست می آید.

همین هفته گذشته، سیسرو متا، هوش مصنوعی که می تواند از بازیکنان انسانی پیشی بگیرد در بازی دیپلماسی، برای پیشی گرفتن از حریفان آنلاین تاریخ ساز شد.

مایکل ولمن از دانشگاه میشیگان در آن آربور، دانشمند کامپیوتری که استدلال استراتژیک و بازی را مطالعه میکند، میگوید: «میزانی که در سالهای اخیر ویژگیهای کیفی متفاوت بازی توسط هوش مصنوعی تسخیر شده یا به سطوح جدیدی تسلط پیدا کرده است، بسیار قابل توجه است. تئوری.

ولمن میگوید: «استراتگو و دیپلماسی کاملاً با یکدیگر متفاوت هستند و همچنین دارای ویژگیهای چالشبرانگیزی هستند که بهویژه با بازیهایی که به نقاط عطف مشابهی رسیدهاند متفاوت هستند».

اطلاعات ناقص

این بازی دارای ویژگی هایی است که به طور کلی بسیار پیچیده تر از شطرنج، Go یا پوکر است. شطرنج، برو و پوکر همه توسط هوش مصنوعی تسلط یافته اند.

در بازی Stratego، دو بازیکن هر کدام 40 مهره را روی یک تخته قرار می دهند، اما نباید مهره های حریف خود را ببینند.

هدف از این بازی این است که مهره ها را به نوبت حرکت دهید تا حریف را از بین ببرید و پرچمی را بگیرید.

درخت بازی Stratego - نموداری از تمام راههای ممکن بازی - دارای 10535 حالت در برابر Go's 10360 است.

وقتی صحبت از اطلاعات ناقص در ابتدای بازی می شود، Stratego دارای 1066 موقعیت خصوصی احتمالی است، رقمی که تنها 106 موقعیت شروع را در پوکر دو نفره تگزاس هولدم کاهش می دهد.

جولین پرولات، محقق DeepMind مستقر در پاریس میگوید: «پیچیدگی محض تعداد نتایج ممکن در Stratego به این معنی است که الگوریتمهایی که در بازیهای با اطلاعات کامل عملکرد خوبی دارند، و حتی آنهایی که برای پوکر کار میکنند، کار نمیکنند».

DeepNash توسط Perolat و همکارانش توسعه داده شد.

ربات الهام گرفته از نش

نام این ربات ادای احترامی است به جان نش، ریاضیدان مشهور آمریکایی، که نظریه تعادل نش را ارائه کرد که فرض میکند «مجموعهای از استراتژیهای پایدار» وجود دارد که میتوانند توسط بازیکنان بهگونهای دنبال شوند که هیچ بازیکنی با تغییر استراتژی سودی نبرد. به تنهایی به این ترتیب، بازیها معمولاً تعادلهای نش صفر، یک یا چند دارند.

دیپ نش الگوریتم یادگیری تقویتی و شبکه عصبی عمیق را برای یافتن تعادل نش ترکیب می کند.

به طور کلی، یادگیری تقویتی جایی است که یک عامل هوشمند (برنامه رایانه ای) با محیط تعامل می کند و بهترین خط مشی را برای دیکته کردن عمل برای هر حالت بازی می آموزد.

برای داشتن یک سیاست بهینه، دیپنش در مجموع 5.5 میلیارد بازی علیه خودش انجام داد.

در اصل، اگر یک طرف جریمه شود، طرف دیگر پاداش می گیرد و متغیرهای شبکه عصبی - که نشان دهنده خط مشی هستند - بر این اساس اصلاح می شوند.

در برخی از مراحل، DeepNash بر روی یک تعادل تقریبی نش همگرا می شود. برخلاف سایر رباتها، DeepNash خود را بدون s بهینه میکندجستجو از طریق درخت بازی.

به مدت دو هفته، دیپنش در پلتفرم بازیهای آنلاین، Gravon، در برابر بازیکنان انسان Stratego بازی کرد.

پس از رقابت در 50 مسابقه، Ai از سال 2002 در بین تمام بازیکنان Gravon Stratego در رتبه سوم قرار گرفت.

کارل تویلز، یکی از محققان DeepMind مستقر در پاریس، میگوید: «کار ما نشان میدهد که چنین بازی پیچیدهای مانند Stratego، که شامل اطلاعات ناقص است، برای حل آن نیازی به تکنیکهای جستجو ندارد. "این یک گام واقعاً بزرگ به جلو در هوش مصنوعی است."

سایر محققان نیز تحت تأثیر این شاهکار قرار گرفته اند.

نتایج چشمگیر

نوام براون، محقق Meta AI که مقر آن در شهر نیویورک است و یکی از اعضای تیمی که در سال 2019 AI Pluribus4 بازی پوکر را گزارش کرد، موافق است: «نتایج چشمگیر هستند.

در Meta، شرکت مادر فیس بوک، براون و همکارانش هوش مصنوعی ساختند که می تواند دیپلماسی را بازی کند، بازی ای که در آن هفت بازیکن برای کنترل جغرافیایی اروپا با جابجایی قطعات روی نقشه به رقابت می پردازند.

در دیپلماسی هدف کنترل مراکز تدارکاتی توسط واحدهای متحرک (ناوگان و ارتش) است.

متا می گوید سیسرو بسیار مهم است زیرا هوش مصنوعی به محیط های غیر خصمانه متکی است.

برخلاف گذشته که موفقیتهای عمده قبلی برای هوش مصنوعی چند عامله در محیطهای کاملاً متخاصم مانند شطرنج، برو و پوکر بوده است، جایی که ارتباطات هیچ ارزشی ندارد، سیسرو از یک موتور استدلال استراتژیک و ماژول گفتگوی قابل کنترل استفاده میکند.

براون میگوید: «وقتی از بازیهای دو نفره مجموع صفر فراتر میروید، ایده تعادل نش دیگر برای بازی خوب با انسانها مفید نیست.

براون و تیمش سیسرو را با استفاده از دادههای 125,261 بازی نسخه آنلاین دیپلماسی که شامل بازیکنان انسانی بود، آموزش دادند.

سیسرو با استفاده از داده های خودبازی و یک ماژول استدلال استراتژیک (SRM) یاد گرفت که قضاوت را بر اساس وضعیت بازی و پیام های انباشته شده، حرکات احتمالی و سیاست های بازیکنان دیگر پیش بینی کند.

متا می گوید که داده های 125,261 بازی دیپلماسی را که به صورت آنلاین در webDiplomacy.net انجام شده است جمع آوری کرده است. از این بازی ها، در مجموع 40,408 بازی حاوی دیالوگ بوده و در مجموع 12,901,662 پیام بین بازیکنان رد و بدل شده است.

رفتار در دنیای واقعی

براون معتقد است رباتهایی مانند سیسرو که بازی میکنند میتوانند با انسانها تعامل داشته باشند و «عملکردهای غیربهینه یا حتی غیرمنطقی انسان میتواند راه را برای برنامههای کاربردی در دنیای واقعی هموار کند».

او میگوید: «اگر یک خودروی خودران میسازید، نمیخواهید تصور کنید که همه رانندگان دیگر در جاده کاملاً منطقی هستند و رفتار مطلوبی دارند.

سیسرو، او می افزاید، گام بزرگی در این مسیر است. ما هنوز یک پا در دنیای بازی داریم، اما اکنون یک پا در دنیای واقعی نیز داریم.

دیگرانی مانند ولمن موافق هستند، اما اصرار دارند که هنوز کارهای بیشتری باید انجام شود. او میگوید: «بسیاری از این تکنیکها در واقع فراتر از بازیهای تفریحی به کاربردهای دنیای واقعی مرتبط هستند. با این وجود، در برخی مواقع، آزمایشگاههای تحقیقاتی پیشرو هوش مصنوعی باید از تنظیمات تفریحی فراتر بروند و چگونگی اندازهگیری پیشرفت علمی را در «بازیهای» دنیای واقعی که واقعاً به آنها اهمیت میدهیم، اندازهگیری کنند.»

/متانیوز.

- AI

- بیت کوین

- بلاکچین

- انطباق با بلاک چین

- chatbot

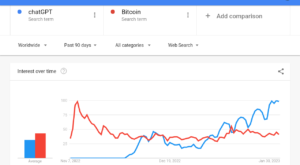

- GPT چت

- coinbase

- coingenius

- یادگیری کامپیوتر

- اجماع

- کنفرانس رمزنگاری

- معدنکاری رمز گشایی

- کریپتو کارنسی (رمز ارزها )

- غیر متمرکز

- DEFI

- دارایی های دیجیتال

- ethereum

- فراگیری ماشین

- متانیوز

- رمز غیر قابل شستشو

- افلاطون

- افلاطون آی

- هوش داده افلاطون

- PlatoData

- بازی پلاتو

- چند ضلعی

- اثبات سهام

- W3

- زفیرنت