یکی از چالشهای پیش روی کسبوکارها در دنیای پس از کووید-19 این واقعیت است که رفتار مصرفکننده به هنجارهای قبل از همهگیری باز نمیگردد. مصرف کنندگان کالاها و خدمات بیشتری را به صورت آنلاین خریداری می کنند و تعداد فزاینده ای از مردم از راه دور کار می کنند و فقط به چند تغییر عمده اشاره می کنند. همانطور که شرکت ها شروع به حرکت در جهان پس از COVID-19 می کنند و اقتصادها به آرامی شروع به بازگشایی می کنند، استفاده از ابزارهای تجزیه و تحلیل داده برای کمک به آنها برای سازگاری با این روندهای جدید بسیار ارزشمند خواهد بود. ابزارهای تجزیه و تحلیل داده ها به ویژه برای شناسایی الگوهای خرید جدید و ارائه یک تجربه شخصی سازی شده بیشتر به مشتریان، علاوه بر درک بهتر رفتار جدید مصرف کنندگان مفید خواهد بود.

با این حال، بسیاری از شرکتها هنوز با موانعی برای پروژههای کلان داده موفق دست و پنجه نرم میکنند. در سراسر صنایع، پذیرش ابتکارات کلان داده رو به افزایش است. هزینه ها افزایش یافته است و اکثریت قریب به اتفاق شرکت هایی که از داده های بزرگ استفاده می کنند انتظار بازگشت سرمایه را دارند. با این وجود، شرکتها هنوز از فقدان دید در فرآیندها و اطلاعات بهعنوان نقطه درد اولیه دادههای بزرگ یاد میکنند. مدلسازی دقیق بخشهای مشتریان میتواند برای کسبوکارهایی که نمیدانند چرا، چگونه و چه زمانی مشتریانشان تصمیم به خرید میگیرند، غیرممکن است.

برای مقابله با این مشکل، شرکتها ممکن است نیاز داشته باشند جایگزینی برای کلان داده، یعنی دادههای ضخیم در نظر بگیرند، تعریف هر دو اصطلاح مفید است. کلان داده در مقابل داده های ضخیم.

بزرگ داده داده های بزرگ و پیچیده بدون ساختار است که با 3 V تعریف می شود. حجم، با داده های بزرگ، باید حجم بالایی از داده های کم تراکم و بدون ساختار را پردازش کنید. این میتواند دادههایی با ارزش ناشناخته باشد، مانند اقدامات فیسبوک، فیدهای داده توییتر، جریانهای کلیک در یک صفحه وب یا یک برنامه تلفن همراه، یا تجهیزات دارای حسگر. برای برخی از سازمان ها، این ممکن است ده ها ترابایت داده باشد. برای دیگران، ممکن است صدها پتابایت باشد. سرعت: سرعت سریعی است که داده ها با آن دریافت و بر اساس آن عمل می شود. تنوع به انواع زیادی از داده های موجود اشاره دارد. انواع داده های غیرساختار یافته و نیمه ساختاریافته، مانند متن، صدا و ویدئو، نیاز به پیش پردازش اضافی برای استخراج معنی و پشتیبانی از ابرداده دارند.

داده های ضخیم در مورد طیف پیچیده ای از رویکردهای تحقیقاتی اولیه و ثانویه، از جمله نظرسنجی، پرسشنامه، گروه های متمرکز، مصاحبه، مجلات، فیلم ها و غیره است. این نتیجه همکاری بین دانشمندان داده و انسان شناسان است که با هم کار می کنند تا حجم زیادی از داده ها را درک کنند. آنها با هم، داده ها را تجزیه و تحلیل می کنند و به دنبال اطلاعات کیفی مانند بینش ها، ترجیحات، انگیزه ها و دلایل رفتار می گردند. در هسته خود، داده های غلیظ، داده های کیفی (مانند مشاهدات، احساسات، واکنش ها) هستند که بینش هایی را در مورد زندگی عاطفی روزمره مصرف کنندگان ارائه می دهند. از آنجایی که هدف دادههای غلیظ آشکار کردن احساسات، داستانها و مدلهای مردم از دنیایی است که در آن زندگی میکنند، تعیین کمیت آن دشوار است.

مقایسه کلان داده و داده های ضخیم

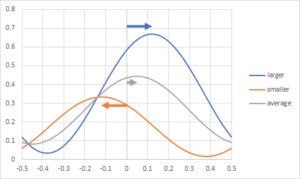

- Big Data کمی است، در حالی که Thick Data کیفی است.

- Big Data اطلاعات زیادی تولید می کند که برای پر کردن و/یا آشکار کردن شکاف های دانش به چیزی بیشتر نیاز دارد. Thick Data معنای پشت تجسم و تجزیه و تحلیل Big Data را آشکار می کند.

- Big Data بینش هایی را با طیف خاصی از نقاط داده نشان می دهد، در حالی که Thick Data زمینه اجتماعی و ارتباطات بین نقاط داده را نشان می دهد.

- کلان داده اعداد را ارائه می دهد. Thick Data داستان ها را ارائه می دهد.

- کلان داده به هوش مصنوعی/آموزش ماشینی متکی است. داده های ضخیم به یادگیری انسان متکی است.

Thick Data می تواند یک تمایز درجه یک باشد، و به کسب و کارها کمک می کند تا انواع بینش هایی را که گاهی امیدوارند تنها از کلان داده به دست آورند، کشف کنند. میتواند به کسبوکارها کمک کند تا به تصویر بزرگ نگاه کنند و تمام داستانهای مختلف را کنار هم بگذارند، در حالی که تفاوتهای بین هر رسانه را در بر میگیرد و از آنها برای بیرون کشیدن مضامین و تضادهای جالب استفاده میکند. بدون تعادل، خطر در دنیای کلان داده این است که سازمانها و افراد شروع به تصمیمگیری و بهینهسازی عملکرد برای معیارها میکنند – معیارهایی که از الگوریتمها مشتق شدهاند و در کل این فرآیند بهینهسازی، افراد، داستانها، تجربیات واقعی فراموش میشوند.

اگر شرکتهای بزرگ فناوری سیلیکون ولی واقعاً میخواهند جهان را درک کنند، باید هم مقادیر (دادههای بزرگ) و هم کیفیت (دادههای غلیظ) آن را به تصویر بکشند. متأسفانه، جمعآوری دومی مستلزم آن است که به جای «دیدن دنیا از طریق عینک گوگل» (یا در مورد فیسبوک، واقعیت مجازی)، رایانهها را پشت سر بگذارند و جهان را دست اول تجربه کنند. دو دلیل اصلی وجود دارد:

- برای درک افراد، باید زمینه آنها را درک کنید

- بیشتر "جهان" دانش پس زمینه است

به جای اینکه به دنبال درک ما صرفاً بر اساس آنچه که در مورد کلان داده ها انجام می دهیم، باشد، داده های غلیظ به دنبال درک ما از نظر نحوه ارتباط ما با جهان های مختلفی است که در آن زندگی می کنیم.

تنها با درک دنیای ما، هر کسی میتواند واقعاً «جهان» را به عنوان یک کل درک کند، این دقیقاً همان چیزی است که شرکتهایی مانند گوگل و فیسبوک میگویند که میخواهند انجام دهند. برای «درک جهان» باید هم کمیتهای (دادههای بزرگ) و هم کیفیت (دادههای غلیظ) آن را در نظر بگیرید.

در واقع، شرکتهایی که بیش از حد به اعداد، نمودارها و دادههای بزرگ تکیه میکنند، در معرض خطر مصون ماندن خود از واقعیت غنی و کیفی زندگی روزمره مشتریان خود هستند. آنها میتوانند توانایی تصور و درک اینکه چگونه جهان – و کسبوکار خودشان – ممکن است در حال تکامل باشد را از دست بدهند. با برون سپاری تفکر خود به Big Data، توانایی ما برای درک جهان با مشاهده دقیق شروع به پژمرده شدن می کند، همانطور که شما حس و بافت یک شهر جدید را تنها با پیمایش در آن با کمک GPS از دست می دهید.

شرکت ها و مدیران موفق برای درک زمینه احساسی و حتی احشایی که در آن افراد با محصول یا خدمات خود مواجه می شوند، کار می کنند و می توانند با تغییر شرایط سازگار شوند. آنها میتوانند از چیزی که ما دوست داریم آن را Thick Data بنامیم استفاده کنند که عنصر انسانی Big Data را تشکیل میدهد.

یکی از فناوریهای امیدوارکننده که میتواند بهترینهای هر دو جهان (دادههای بزرگ و دادههای ضخیم) را به ما بدهد، این است محاسبات عاطفی

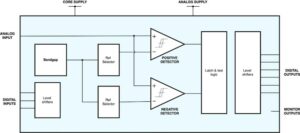

محاسبات موثر مطالعه و توسعه سیستم ها و دستگاه هایی است که می توانند تأثیرات انسانی را تشخیص، تفسیر، پردازش و شبیه سازی کنند. این یک رشته بین رشته ای است که شامل علوم کامپیوتر، روانشناسی و علوم شناختی می شود. در حالی که ریشههای این رشته را میتوان تا تحقیقات اولیه فلسفی در مورد احساسات جستجو کرد («تأثیر» اساساً مترادف «احساس» است)، شاخه مدرنتر علوم رایانه با مقاله روزالیند پیکارد در سال 1995 در مورد احساسات سرچشمه گرفت. محاسبات عاطفی انگیزه تحقیق توانایی شبیه سازی است یکدلی. ماشین باید حالت عاطفی انسان ها را تفسیر کند و رفتار خود را با آنها تطبیق دهد و به آن احساسات پاسخ مناسب بدهد.

استفاده از الگوریتمهای محاسباتی مؤثر در جمعآوری و پردازش دادهها، دادهها را انسانیتر میکند و هر دو طرف داده را نشان میدهد: کمی و کیفی.

احمد بنافا، نویسنده کتاب ها:

اینترنت امن و هوشمند اشیا (IoT) با استفاده از بلاک چین و هوش مصنوعی

مقالات بیشتر را در: سایت پروفسور بنافا

منابع

https://www.linkedin.com/pulse/8-key-tech-trends-post-covid-19-world-ahmed-banafa/

https://www.bdex.com/thick-data-why-marketers-must-understand-why-people-behave-the-way-they-do/

https://www.usertesting.com/blog/thick-data-vs-big-data

https://www.oracle.com/in/big-data/what-is-big-data/

https://www.cognizant.com/us/en/glossary/thick-data

http://www.brandwatch.com/2014/04/what-is-thick-data-and-why-should-you-use-it/

http://ethnographymatters.net/2013/05/13/big-data-needs-thick-data/

http://www.wired.com/2014/04/your-big-data-is-worthless-if-you-dont-bring-it-into-the-real-world/

http://www.big-dataforum.com/238/big-data-how-about-%E2%80%9Cthick-data%E2%80%9D-%E2%80%94-or-did-we-just-create-another-haystack

http://blog.marketresearch.com/thick-data-and-market-research-understanding-your-customers

http://www.wired.com/2013/03/clive-thompson-2104/

اشتراک گذاری این پست از طریق: منبع: https://semiwiki.com/general/304678-thick-data-vs-big-data/

- اضافی

- اتخاذ

- الگوریتم

- معرفی

- آمازون

- تحلیل

- علم تجزیه و تحلیل

- نرم افزار

- مقالات

- سمعی

- بهترین

- بزرگ داده

- تصویر بزرگ

- فناوری بزرگ

- شرکت های بزرگ فناوری

- بلاکچین

- کتاب

- بریج

- کسب و کار

- صدا

- تغییر دادن

- شهر:

- شناختی

- دانا

- همکاری

- شرکت

- علم کامپیوتر

- کامپیوتر

- محاسبه

- اتصالات

- مصرف کننده

- رفتار مصرف کننده

- مصرف کنندگان

- مشتریان

- داده ها

- تجزیه و تحلیل داده ها

- تجسم داده ها

- معامله

- تحویل

- پروژه

- دستگاه ها

- در اوایل

- احساسات

- تجهیزات

- مدیران

- تجربه

- تجارب

- فیس بوک

- نما

- FAST

- نام خانوادگی

- تمرکز

- فراموش

- دادن

- مغازه

- گوگل

- GPS

- زیاد

- چگونه

- HTTPS

- انسان

- صدها نفر

- تصویر

- از جمله

- لوازم

- اطلاعات

- بینش

- اینترنت

- اینترنت از چیزهایی که

- مصاحبه

- تعلیم دادن

- سرمایه گذاری

- اینترنت اشیا

- IT

- کلید

- دانش

- بزرگ

- یادگیری

- لینک

- عمده

- اکثریت

- ساخت

- متوسط

- موبایل

- برنامه موبایل

- مدل سازی

- از جمله

- تعداد

- آنلاین

- وحی

- سازمان های

- دیگران

- برون سپاری

- درد

- مقاله

- مردم

- کارایی

- تصویر

- محصول

- پروژه ها

- روانشناسی

- خرید

- خرید

- کمی

- محدوده

- واکنش

- واقعیت

- دلایل

- باز کردن

- تحقیق

- پاسخ

- خطر

- علم

- دانشمندان

- ثانوی

- به دنبال

- حس

- خدمات

- سیلیکون ولی (Silicon Valley)

- هوشمند

- So

- آگاهی

- هزینه

- شروع

- دولت

- داستان

- مهاجرت تحصیلی

- موفق

- پشتیبانی

- سیستم های

- فن آوری

- پیشرفته

- جهان

- تفکر

- روند

- توییتر

- برملا کردن

- us

- ارزش

- تصویری

- فیلم های

- مجازی

- واقعیت مجازی

- دید

- تجسم

- وب

- WHO

- مهاجرت کاری

- جهان