پس از سالها توسعه، متا در نهایت ممکن است امسال شتابدهندههای هوش مصنوعی بومی خود را به روشی معنادار عرضه کند.

امپراتوری فیس بوک تمایل خود را برای تکمیل استقرار پردازنده های گرافیکی Nvidia H100 و AMD MI300X با خانواده تراشه های Meta Training Inference Accelerator (MTIA) در این هفته تایید کرد. به طور خاص، متا یک پردازنده استنتاج بهینه شده را مستقر خواهد کرد، بنا بر گزارش ها با اسم رمز آرتمیس، بر اساس قطعات نسل اول غول سیلیکون ولی تند و زننده سال گذشته است.

یکی از سخنگویان متا گفت: «ما از پیشرفتی که در تلاشهای سیلیکونی داخلی خود با MTIA داشتهایم هیجانزده هستیم و در مسیر شروع به کارگیری نوع استنتاج خود در تولید در سال 2024 هستیم. ثبت نام در روز پنج شنبه.

این نماینده ادامه داد: «ما شتابدهندههای توسعهیافته داخلی خود را میبینیم که در ارائه ترکیبی بهینه از عملکرد و کارایی در بارهای کاری متا خاص، بسیار مکمل GPUهای تجاری موجود هستند. جزئیات؟ جواب منفی. سخنگوی به ما گفت: "ما مشتاقانه منتظر به اشتراک گذاشتن به روز رسانی های بیشتر در مورد برنامه های آینده MTIA خود در اواخر امسال هستیم."

ما آن را به این معنا در نظر می گیریم که تراشه متمرکز بر استنتاج نسل دوم به طور گسترده ای در حال گسترش است، به دنبال نسخه ای که فقط آزمایشگاهی نسل اول برای استنتاج است، و ممکن است بعداً در مورد قطعاتی که عمدتاً برای آموزش یا آموزش و استنباط در نظر گرفته شده اند، مطلع شویم.

متا به یکی از بهترین مشتریان انویدیا و AMD تبدیل شده است زیرا استقرار بارهای کاری هوش مصنوعی افزایش یافته است و نیاز و استفاده آن از سیلیکون تخصصی را افزایش می دهد تا نرم افزار یادگیری ماشینی خود را با بیشترین سرعت ممکن اجرا کند. بنابراین، تصمیم غول اینستاگرام برای توسعه پردازنده های سفارشی خود چندان هم تعجب آور نیست.

در واقع، شرکت بزرگ، از نظر استقرار در دنیای واقعی، نسبتاً دیر به مهمانی سیلیکونی AI سفارشی رسیده است. آمازون و گوگل چندین سال است که از اجزای داخلی برای تسریع سیستمهای یادگیری ماشین داخلی، مانند مدلهای توصیهگر و کد ML مشتری استفاده میکنند. در همین حال، مایکروسافت سال گذشته شتاب دهنده های داخلی خود را معرفی کرد.

اما فراتر از این واقعیت که متا یک تراشه استنتاج MTIA را در مقیاس بزرگ عرضه می کند، این شبکه اجتماعی معماری دقیق آن را فاش نکرده است و نه اینکه چه بار کاری برای سیلیکون داخلی ذخیره می کند و چه مواردی را در پردازنده های گرافیکی AMD و Nvidia بارگذاری می کند.

به احتمال زیاد متا مدل های شناخته شده ای را روی ASIC های سفارشی خود اجرا خواهد کرد تا منابع GPU را برای برنامه های پویاتر یا در حال تکامل آزاد کند. قبلاً متا را دیدهایم که این مسیر را با شتابدهندههای سفارشی که برای تخلیه دادهها و محاسبه بارهای فشرده ویدیویی طراحی شدهاند، طی کرده است.

در مورد طراحی زیربنایی، ناظران صنعت در SemiAnalysis به ما می گویند که تراشه جدید کاملاً مبتنی بر معماری قطعات نسل اول متا است.

سنگ پله

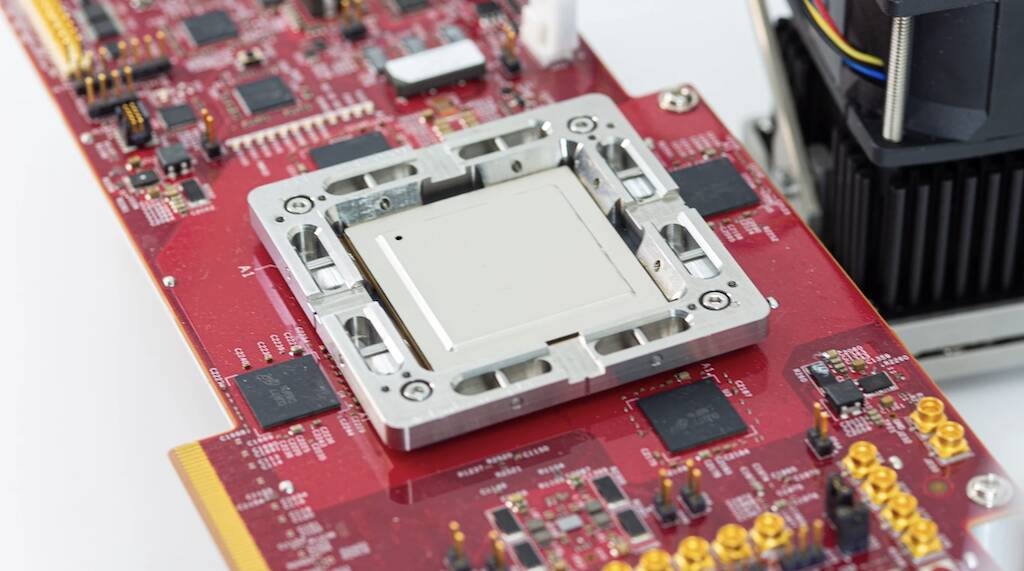

در اوایل سال 2023 پس از سه سال توسعه، قطعات MTIA v1 متا معرفی شد که دوستان ما در پلت فرم بعدی نگاه بهار گذشته، به طور خاص با مدلهای توصیهگر یادگیری عمیق در ذهن طراحی شدند.

تراشه نسل اول حول یک کلاستر CPU RISC-V ساخته شد و با استفاده از فرآیند 7 نانومتری TSMC ساخته شد. در زیر هود، این قطعه از یک ماتریس هشت در هشت از عناصر پردازشی استفاده میکند که هر کدام به دو هسته CPU RV مجهز شدهاند، که یکی از آنها با پسوندهای ریاضی برداری مجهز شده است. این هستهها از 128 مگابایت حافظه SRAM روی تراشه و حداکثر 128 گیگابایت حافظه LPDDR5 تغذیه میشوند.

همانطور که متا در سال گذشته ادعا کرد، این تراشه با فرکانس 800 مگاهرتز کار میکرد و به 102.4 تریلیون عملیات در ثانیه عملکرد INT8 یا 51.2 ترافلاپس با نیم دقت (FP16) رسید. در مقایسه، H100 انویدیا قادر است نزدیک به چهار پتافلاپ با عملکرد پراکنده FP8 داشته باشد. در حالی که به اندازه پردازنده های گرافیکی انویدیا یا AMD قدرتمند نیست، این تراشه یک مزیت عمده داشت: مصرف انرژی. خود تراشه دارای قدرت طراحی حرارتی فقط 25 وات بود.

مطابق با نیمه تجزیه و تحلیلجدیدترین تراشه متا دارای هسته های بهبود یافته است و LPDDR5 را با حافظه با پهنای باند بالا بسته بندی شده با استفاده از فناوری تراشه روی ویفر روی بستر (CoWoS) TSMC معامله می کند.

تفاوت قابل توجه دیگر این است که تراشه نسل دوم متا در واقع شاهد استقرار گسترده در زیرساخت مرکز داده خود خواهد بود. به گفته فیسبوک تایتان، در حالی که بخش نسل اول برای اجرای مدلهای تبلیغاتی تولیدی استفاده میشد، هرگز از آزمایشگاه خارج نشد.

تعقیب هوش مصنوعی عمومی

بخشهای سفارشی را کنار بگذاریم، فیسبوک و اینستاگرام مادر را کنار گذاشته است میلیاردها دلار در GPU ها در سال های اخیر برای سرعت بخشیدن به همه نوع وظایف نامناسب برای سیستم عامل های CPU معمولی. با این حال، ظهور مدلهای زبانی بزرگ، مانند GPT-4 و Llama 2 خود متا، چشمانداز را تغییر داده و باعث گسترش خوشههای GPU عظیم شده است.

در مقیاسی که متا فعالیت می کند، این روندها تغییرات شدیدی را در زیرساخت های آن، از جمله طراحی مجدد کردن چندین دیتاسنتر برای پشتیبانی از نیازهای انرژی و سرمایش عظیم مرتبط با استقرارهای بزرگ هوش مصنوعی.

و استقرار متا تنها در چند ماه آینده بزرگتر می شود زیرا شرکت تمرکز خود را از متاورس به سمت تغییر می دهد. توسعه هوش عمومی مصنوعی ظاهراً، کار انجام شده روی هوش مصنوعی به شکل گیری متاورز یا چیزی شبیه به آن کمک می کند.

به گفته مارک زاکربرگ، مدیرعامل، متا تنها در سال جاری قصد دارد تا 350,000 دستگاه Nvidia H100 را به کار گیرد.

بیز همچنین اعلام کرد که قصد دارد AMD را به تازگی راه اندازی کند راه اندازی پردازندههای گرافیکی MI300X در دیتاسنترهای آن. زاکربرگ ادعا کرد که شرکت او سال را با قدرت محاسباتی معادل 600,000 H100 به پایان خواهد رساند. بنابراین واضح است که تراشههای MTIA متا به این زودیها جایگزین پردازندههای گرافیکی نخواهند شد. ®

- محتوای مبتنی بر SEO و توزیع روابط عمومی. امروز تقویت شوید.

- PlatoData.Network Vertical Generative Ai. به خودت قدرت بده دسترسی به اینجا.

- PlatoAiStream. هوش وب 3 دانش تقویت شده دسترسی به اینجا.

- PlatoESG. کربن ، CleanTech، انرژی، محیط، خورشیدی، مدیریت پسماند دسترسی به اینجا.

- PlatoHealth. هوش بیوتکنولوژی و آزمایشات بالینی. دسترسی به اینجا.

- منبع: https://go.theregister.com/feed/www.theregister.com/2024/02/02/meta_ai_chips/

- : دارد

- :است

- $UP

- 000

- 102

- 2%

- 2023

- 2024

- 25

- 350

- 4

- 51

- 600

- 800

- a

- درباره ما

- شتاب دادن

- شتاب دهنده

- شتاب دهنده ها

- مطابق

- در میان

- واقعا

- مزیت - فایده - سود - منفعت

- تبلیغات

- پس از

- AI

- معرفی

- تنها

- در کنار

- همچنین

- آمازون

- AMD

- an

- و

- اعلام کرد

- برنامه های کاربردی

- معماری

- هستند

- دور و بر

- مصنوعی

- هوش عمومی مصنوعی

- AS

- ASIC ها

- کنار

- مرتبط است

- At

- در دسترس

- مستقر

- BE

- شدن

- بوده

- قبل از

- بهترین

- خارج از

- BIZ

- می افتد

- ساخته

- by

- توانا

- مدیر عامل شرکت

- تغییر

- تبادل

- تراشه

- چیپس

- ادعا کرد که

- به وضوح

- نزدیک

- خوشه

- CO

- رمز

- تجاری

- شرکت

- مقایسه

- مکمل

- جزء

- اجزاء

- محاسبه

- محاسبه

- قدرت پردازش

- تایید شده

- مصرف

- ادامه داد:

- معمولی

- شرکت

- پردازنده

- سفارشی

- مشتری

- مشتریان

- داده ها

- مرکز داده

- تصمیم

- تحویل

- گسترش

- استقرار

- گسترش

- اعزام ها

- طرح

- طراحی

- میل

- جزئیات

- توسعه

- توسعه

- پروژه

- DID

- تفاوت

- دلار

- انجام شده

- پایین

- رانده

- پویا

- هر

- در اوایل

- بهره وری

- تلاش

- هر دو

- عناصر

- امپراطوری

- به کار گرفته شده

- پایان

- مجهز بودن

- معادل

- تاسیس

- اتر (ETH)

- در حال تحول

- برانگیخته

- ضمیمهها

- چهره

- فیس بوک

- واقعیت

- خانواده

- FAST

- تغذیه

- کمی از

- سرانجام

- پیدا کردن

- تمرکز

- پیروی

- برای

- فرم

- به جلو

- چهار

- رایگان

- دوستان

- از جانب

- آینده

- سوالات عمومی

- هوش عمومی

- سخاوتمندانه

- دریافت کنید

- غول

- Go

- رفتن

- گوگل

- GPU

- GPU ها

- رشد کرد

- بود

- نیم

- آیا

- کمک

- خیلی

- خود را

- خانه دار

- کاپوت

- اما

- HTTPS

- عظیم

- بهبود یافته

- in

- از جمله

- افزایش

- صنعت

- شالوده

- اینستگرام

- اطلاعات

- مورد نظر

- شدید

- داخلی

- داخلی

- نیست

- IT

- ITS

- خود

- JPG

- تنها

- آزمایشگاه

- چشم انداز

- زبان

- بزرگ

- بزرگتر

- نام

- پارسال

- دیر

- بعد

- آخرین

- ترک کرد

- پسندیدن

- احتمالا

- پشم لاما

- نگاه کنيد

- ساخته

- عمده

- ساخت

- روش

- بسیاری

- علامت

- علامت زوکربرگ

- عظیم

- ریاضی

- ماتریس

- ممکن است..

- متوسط

- معنی دار

- در ضمن

- حافظه

- متا

- متاوررس

- مایکروسافت

- ذهن

- مخلوط

- ML

- مدل

- ماه

- بیش

- نزدیک

- تقریبا

- نیاز

- شبکه

- هرگز

- جدید

- تراشه جدید

- به تازگی

- بعد

- نه

- قابل توجه

- کارت گرافیک Nvidia

- of

- on

- ONE

- فقط

- عمل می کند

- عملیات

- بهینه

- or

- ما

- خارج

- روی

- خود

- بسته بندی

- بخش

- بخش

- حزب

- برای

- کارایی

- برنامه

- سیستم عامل

- افلاطون

- هوش داده افلاطون

- PlatoData

- ممکن

- قدرت

- قوی

- دقیق

- دقت

- در درجه اول

- روند

- در حال پردازش

- پردازنده

- پردازنده ها

- تولید

- پیشرفت

- RE

- دنیای واقعی

- اخیر

- نسبتا

- مورد نیاز

- منابع

- رویترز

- نشان داد

- طلوع

- نورد

- نورد

- مسیر

- دویدن

- s

- مقیاس

- دوم

- دیدن

- مشاهده گردید

- چند

- اشتراک

- شیفت

- سیلیکون

- سیلیکون ولی (Silicon Valley)

- So

- آگاهی

- شبکه های اجتماعی

- نرم افزار

- برخی از

- چیزی

- بزودی

- پراکنده

- تخصصی

- به طور خاص

- سخنگوی

- بهار

- شروع

- چنین

- مکمل

- پشتیبانی

- تعجب آور

- سیستم های

- T

- مصرف

- وظایف

- فن آوری

- گفتن

- قوانین و مقررات

- که

- La

- منظره

- متاورس

- حرارتی

- اینها

- این

- این هفته

- در این سال

- سه

- پنج شنبه

- بدین ترتیب

- تیتان

- به

- گفته شده

- در صدر

- مسیر

- معاملات

- آموزش

- روند

- تریلیون

- tsmc

- دو

- زیر

- اساسی

- به روز رسانی

- us

- استفاده کنید

- استفاده

- با استفاده از

- v1

- دره

- نوع دیگر

- Ve

- بردار

- نسخه

- تصویری

- بود

- مسیر..

- we

- هفته

- بود

- که

- در حین

- به طور گسترده ای

- بطور گسترده

- اراده

- با

- برنده شد

- مهاجرت کاری

- خواهد بود

- سال

- سال

- زفیرنت

- زوکربرگ