تصویر از Adobe Firefly

«ما خیلی زیاد بودیم. ما به پول زیاد، تجهیزات زیاد دسترسی داشتیم و کم کم دیوانه شدیم.»

فرانسیس فورد کاپولا استعاره ای برای شرکت های هوش مصنوعی نمی ساخت که زیاد هزینه می کنند و راه خود را گم می کنند، اما او می توانست چنین باشد. آخرالزمان در حال حاضر بسیار حماسی بود، اما همچنین پروژه ای طولانی، دشوار و گران برای ساخت، بسیار شبیه به GPT-4. من پیشنهاد می کنم که توسعه LLM ها به پول زیاد و تجهیزات بیش از حد منجر شده است. و برخی از تبلیغات "ما فقط هوش عمومی را اختراع کردیم" کمی دیوانه کننده است. اما اکنون نوبت جوامع منبع باز است که بهترین کار را انجام دهند: ارائه نرم افزار رقیب رایگان با استفاده از پول و تجهیزات بسیار کمتر.

OpenAI بیش از 11 میلیارد دلار بودجه دریافت کرده است و تخمین زده می شود که GPT-3.5 برای هر دوره آموزشی 5 تا 6 میلیون دلار هزینه دارد. ما در مورد GPT-4 اطلاعات کمی داریم، زیرا OpenAI نمی گوید، اما فکر می کنم می توان فرض کرد که کوچکتر از GPT-3.5 نیست. در حال حاضر کمبود GPU در سراسر جهان وجود دارد و - برای تغییر - به دلیل آخرین کریپتوکوین نیست. استارتآپهای مولد هوش مصنوعی زمانی که مالک هیچ یک از IP برای LLM نیستند، سری A+ 100 میلیون دلاری را با ارزشگذاریهای هنگفت به دست میآورند. واگن LLM در دنده بالاست و پول در جریان است.

به نظر می رسید که قالب ریخته شده بود: فقط شرکت های با جیب عمیق مانند مایکروسافت/OpenAI، آمازون و گوگل می توانستند هزینه آموزش مدل های پارامتری صد میلیاردی را بپردازند. مدل های بزرگتر مدل های بهتری در نظر گرفته شد. GPT-3 مشکلی پیش آمده است؟ فقط صبر کنید تا یک نسخه بزرگتر وجود داشته باشد و همه چیز درست می شود! شرکتهای کوچکتری که بهدنبال رقابت بودند، باید سرمایهی بسیار بیشتری جمعآوری میکردند یا در بازار ChatGPT رها میشدند که کالاهای خود را ادغام کنند. دانشگاه، با بودجه تحقیقاتی محدودتر، به حاشیه کشیده شد.

خوشبختانه، گروهی از افراد باهوش و پروژههای منبع باز این موضوع را بهجای محدودیت به عنوان یک چالش در نظر گرفتند. محققان در استنفورد آلپاکا را منتشر کردند، مدلی با 7 میلیارد پارامتر که عملکرد آن به مدل پارامتر 3.5 میلیاردی GPT-175 نزدیک است. به دلیل نداشتن منابع لازم برای ساخت مجموعه آموزشی به اندازه استفاده شده توسط OpenAI، آنها هوشمندانه تصمیم گرفتند یک LLM، LLaMA منبع باز آموزش دیده را انتخاب کنند و به جای آن، آن را روی یک سری از دستورات و خروجی های GPT-3.5 تنظیم کنند. اساساً مدل یاد گرفت که GPT-3.5 چه کاری انجام می دهد، که به نظر می رسد یک استراتژی بسیار مؤثر برای تکرار رفتار آن است.

Alpaca فقط برای استفاده غیرتجاری در کد و داده مجوز دارد زیرا از مدل منبع باز غیر تجاری LLaMA استفاده می کند و OpenAI صراحتاً هرگونه استفاده از API های خود را برای ایجاد محصولات رقیب ممنوع می کند. این امر چشمانداز وسوسهانگیز تنظیم دقیق یک LLM منبع باز متفاوت را بر اساس دستورات و خروجی Alpaca ایجاد میکند... ایجاد یک مدل سوم GPT-3.5 با امکانات مختلف مجوز.

در اینجا لایه دیگری از طنز وجود دارد، زیرا همه LLM های اصلی بر روی متن ها و تصاویر دارای حق چاپ موجود در اینترنت آموزش دیده اند و یک پنی به صاحبان حقوق پرداخت نکرده اند. این شرکتها با این استدلال که استفاده «تحولکننده» است، معافیت «استفاده منصفانه» را تحت قانون حق چاپ ایالات متحده ادعا میکنند. با این حال، وقتی نوبت به خروجی مدلهایی میشود که با دادههای رایگان میسازند، واقعاً نمیخواهند کسی همین کار را با آنها انجام دهد. من انتظار دارم که این موضوع با اندیشیدن صاحبان حقوق تغییر کند و ممکن است در نقطهای به دادگاه ختم شود.

این یک نکته مجزا و متمایز است که توسط نویسندگان منبع باز با مجوز محدود مطرح شده است که برای هوش مصنوعی مولد برای محصولات Code مانند CoPilot، مخالف استفاده از کد آنها برای آموزش به این دلیل است که مجوز دنبال نمی شود. مشکل تک تک نویسندگان منبع باز این است که آنها باید موضع خود را نشان دهند - کپی اساسی - و متحمل خسارت شده اند. و از آنجایی که مدلها پیوند کد خروجی را به ورودی (خطوط کد منبع توسط نویسنده) سخت میکنند و ضرر اقتصادی ندارند (قرار میرود رایگان باشد)، درست کردن موضوع بسیار سختتر است. این برخلاف سازندگان انتفاعی (مانند عکاسان) است که کل مدل کسبوکارشان در صدور مجوز/فروش آثارشان است و توسط جمعآوریکنندههایی مانند Getty Images که میتوانند کپیبرداری اساسی را نشان دهند، نشان داده میشوند.

نکته جالب دیگر در مورد LLaMA این است که از متا بیرون آمده است. در ابتدا فقط برای محققان منتشر شد و سپس از طریق BitTorrent به جهان منتشر شد. متا در کسبوکاری اساساً متفاوت از OpenAI، مایکروسافت، گوگل و آمازون است، زیرا سعی در فروش سرویسها یا نرمافزارهای ابری به شما ندارد، و بنابراین انگیزههای بسیار متفاوتی دارد. این طرحهای محاسباتی خود را در گذشته منبع باز کرده است (OpenCompute) و شاهد بهبود جامعه در آنها بوده است - ارزش منبع باز را درک میکند.

متا می تواند یکی از مهم ترین مشارکت کنندگان AI منبع باز باشد. نه تنها منابع عظیمی دارد، بلکه در صورت تکثیر فناوری هوش مصنوعی مولد بسیار سودمند است: محتوای بیشتری برای کسب درآمد در رسانه های اجتماعی برای آن وجود خواهد داشت. متا سه مدل منبع باز دیگر AI منتشر کرده است: ImageBind (نمایه سازی داده های چند بعدی)، DINOv2 (بینایی کامپیوتری) و Segment Anything. دومی اشیاء منحصر به فرد را در تصاویر شناسایی می کند و تحت مجوز بسیار مجاز آپاچی منتشر می شود.

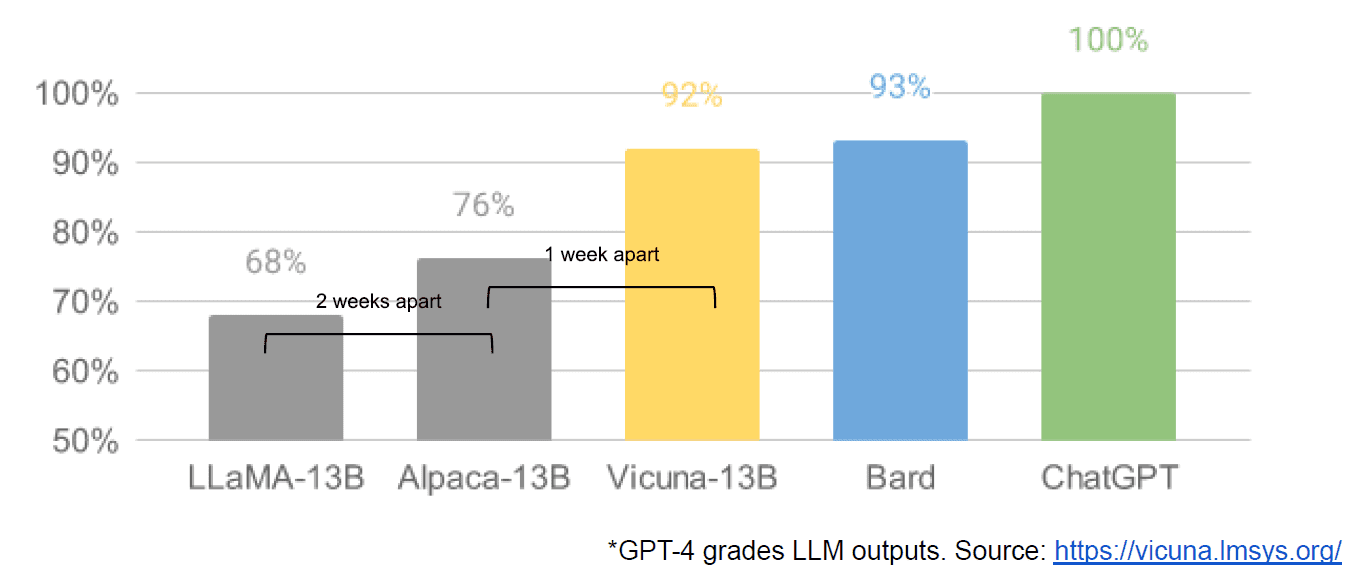

در نهایت، ما همچنین ادعای افشای یک سند داخلی Google را داشتیم «ما هیچ خندقی نداریم، و نه OpenAI» که دیدگاهی مبهم از مدلهای بسته در مقابل نوآوری جوامعی دارد که مدلهای بسیار کوچکتر و ارزانتری تولید میکنند که عملکردی نزدیک یا بهتر از آن دارند. همتایان منبع بسته آنها. ظاهراً می گویم زیرا هیچ راهی برای تأیید منبع مقاله به عنوان داخلی بودن Google وجود ندارد. با این حال، حاوی این نمودار قانع کننده است:

محور عمودی درجه بندی خروجی های LLM توسط GPT-4 است که واضح باشد.

Stable Diffusion، که تصاویر را از متن ترکیب میکند، نمونه دیگری از مواردی است که هوش مصنوعی منبع باز مولد سریعتر از مدلهای اختصاصی پیشرفت کرده است. تکرار اخیر آن پروژه (ControlNet) آن را به گونه ای بهبود داده است که از قابلیت های Dall-E2 پیشی گرفته است. این امر ناشی از سرهم بندی های زیادی در سرتاسر جهان بود که منجر به سرعت پیشرفتی شد که برای هر مؤسسه ای دشوار است. برخی از آن سرهمآوران متوجه شدند که چگونه میتوانند Stable Diffusion را سریعتر برای آموزش و اجرای سختافزار ارزانتر بسازند و چرخههای تکرار کوتاهتری را برای افراد بیشتری امکانپذیر کنند.

و بنابراین ما به دایره کامل رسیده ایم. نداشتن پول زیاد و تجهیزات زیاد باعث الهام بخشیدن سطح زیرکانه ای از نوآوری توسط کل جامعه مردم عادی شده است. چه زمانی برای یک توسعه دهنده هوش مصنوعی.

متیو لاج مدیر عامل شرکت Diffblue، یک استارت آپ AI For Code است. او بیش از 25 سال تجربه متنوع در رهبری محصول در شرکت هایی مانند Anaconda و VMware دارد. لاج در حال حاضر در هیئت مدیره پروژه Good Law فعالیت می کند و معاون رئیس هیئت امنای انجمن عکاسی سلطنتی است.

- محتوای مبتنی بر SEO و توزیع روابط عمومی. امروز تقویت شوید.

- PlatoAiStream. Web3 Data Intelligence دانش تقویت شده دسترسی به اینجا.

- ضرب کردن آینده با آدرین اشلی. دسترسی به اینجا.

- خرید و فروش سهام در شرکت های PRE-IPO با PREIPO®. دسترسی به اینجا.

- منبع: https://www.kdnuggets.com/2023/05/llm-apocalypse-revenge-open-source-clones.html?utm_source=rss&utm_medium=rss&utm_campaign=llm-apocalypse-now-revenge-of-the-open-source-clones

- : دارد

- :است

- :نه

- :جایی که

- $UP

- 9

- a

- قادر

- درباره ما

- آکادمی

- دسترسی

- خشت

- پیشرفت

- جمع کننده ها

- AI

- معرفی

- ادعا شده است

- ادعا شده

- همچنین

- آمازون

- an

- و

- دیگر

- هر

- هر کس

- هر چیزی

- آپاچی

- رابط های برنامه کاربردی

- هستند

- استدلال

- مقاله

- AS

- فرض

- At

- نویسنده

- نویسندگان

- در دسترس

- محور

- BE

- زیرا

- بوده

- بودن

- مزایای

- بهترین

- بهتر

- بزرگتر

- بیت تورنت

- تخته

- هر دو

- بودجه

- ساختن

- بنا

- دسته

- کسب و کار

- مدل کسب و کار

- اما

- by

- آمد

- CAN

- قابلیت های

- سرمایه

- مورد

- مدیر عامل شرکت

- صندلی

- به چالش

- تغییر دادن

- GPT چت

- ارزان تر

- را انتخاب

- دایره

- ادعا

- واضح

- نزدیک

- بسته

- ابر

- خدمات ابر

- رمز

- بیا

- می آید

- کالا

- جوامع

- انجمن

- شرکت

- متقاعد کننده

- رقابت

- رقابت

- محاسبه

- کامپیوتر

- چشم انداز کامپیوتر

- محتوا

- همکاران

- کپی برداری

- حق چاپ

- هزینه

- میتوانست

- دادگاه

- ایجاد

- ایجاد

- سازندگان

- رمزنگاری

- در حال حاضر

- چرخه

- داده ها

- تحویل

- قائم مقام

- طرح

- توسعه دهنده

- پروژه

- مردن

- مختلف

- مشکل

- انتشار

- متمایز

- مختلف

- do

- سند

- میکند

- آیا

- e

- اقتصادی

- موثر

- را قادر می سازد

- پایان

- تمام

- EPIC

- تجهیزات

- اساسا

- برآورد

- حتی

- مثال

- انتظار

- گران

- تجربه

- بسیار

- سریعتر

- شکل گرفت

- در حال جریان

- به دنبال

- برای

- گدار

- رایگان

- از جانب

- کامل

- اساساً

- بودجه

- چرخ دنده

- سوالات عمومی

- مولد

- هوش مصنوعی مولد

- خوب

- گوگل

- GPU

- گراف

- بزرگ

- بود

- سخت

- سخت افزار

- آیا

- داشتن

- he

- اینجا کلیک نمایید

- زیاد

- خیلی

- دارندگان

- چگونه

- چگونه

- اما

- HTTPS

- بزرگ

- هیپ

- i

- شناسایی می کند

- if

- تصاویر

- مهم

- بهبود

- بهبود یافته

- in

- انگیزه

- فرد

- ابداع

- ورودی

- اینسان

- الهام بخش

- در عوض

- موسسه

- یکپارچگی

- جالب

- داخلی

- اینترنت

- اختراع

- IP

- طنز

- IT

- تکرار

- ITS

- تنها

- kdnuggets

- دانستن

- فرود

- آخرین

- قانون

- لایه

- رهبری

- آموخته

- ترک کرد

- کمتر

- سطح

- مجوز

- مجاز

- صدور مجوز

- پسندیدن

- خطوط

- ارتباط دادن

- لینک

- کوچک

- پشم لاما

- طولانی

- نگاه

- به دنبال

- از دست دادن

- خاموش

- خیلی

- عمده

- ساخت

- ساخت

- بسیاری

- بازار

- عظیم

- مسابقه

- ممکن است..

- رسانه ها

- متا

- مایکروسافت

- مدل

- مدل

- کسب درآمد

- پول

- بیش

- اکثر

- بسیار

- نیاز

- نه

- نه

- غیرتجاری

- اکنون

- هدف

- اشیاء

- of

- on

- ONE

- فقط

- باز کن

- منبع باز

- پروژه های متن باز

- OpenAI

- or

- عادی

- در اصل

- دیگر

- خارج

- تولید

- روی

- خود

- سرعت

- پارامتر

- گذشته

- پرداخت

- مردم

- انجام دادن

- کارایی

- افلاطون

- هوش داده افلاطون

- PlatoData

- نقطه

- فرصت

- قدرت

- مشکل

- محصول

- محصولات

- پروژه

- پروژه ها

- اختصاصی

- چشم انداز

- بالا بردن

- مطرح شده

- نسبتا

- واقعا

- اخیر

- منتشر شد

- نمایندگی

- تحقیق

- محققان

- منابع

- محدودیت

- نتیجه

- حقوق

- دور

- سلطنتی

- دویدن

- s

- امن

- همان

- گفتن

- مشاهده گردید

- بخش

- فروش

- جداگانه

- سلسله

- سری A

- خدمت

- خدمات

- تنظیم

- کمبود

- نشان

- پس از

- تنها

- اندازه

- کوچکتر

- هوشمند

- So

- آگاهی

- رسانه های اجتماعی

- جامعه

- نرم افزار

- برخی از

- چیزی

- منبع

- کد منبع

- خرج کردن

- پایدار

- استنفورد

- شروع یو پی اس

- شروع

- استراتژی

- چنین

- نشان می دهد

- مفروض

- پیشی گرفت

- گرفتن

- صورت گرفته

- طول می کشد

- پیشرفته

- نسبت به

- که

- La

- منبع

- جهان

- شان

- آنها

- سپس

- آنجا.

- آنها

- چیز

- فکر می کنم

- سوم

- این

- کسانی که

- سه

- زمان

- به

- هم

- در زمان

- قطار

- آموزش دیده

- آموزش

- دور زدن

- تبدیل

- زیر

- درک می کند

- منحصر به فرد

- بر خلاف

- تا

- us

- استفاده کنید

- استفاده

- استفاده

- با استفاده از

- ارزیابی ها

- ارزش

- بررسی

- نسخه

- عمودی

- بسیار

- از طريق

- چشم انداز

- دید

- آموزش VMware

- vs

- صبر کنيد

- می خواهم

- بود

- مسیر..

- we

- رفت

- بود

- چی

- چه زمانی

- که

- WHO

- تمام

- که

- اراده

- WISE

- با

- مهاجرت کاری

- جهان

- اشتباه

- شما

- زفیرنت