توسط: دکتر چارلز واردمن، دکتر کریستوفر سویت و دکتر پل برنر

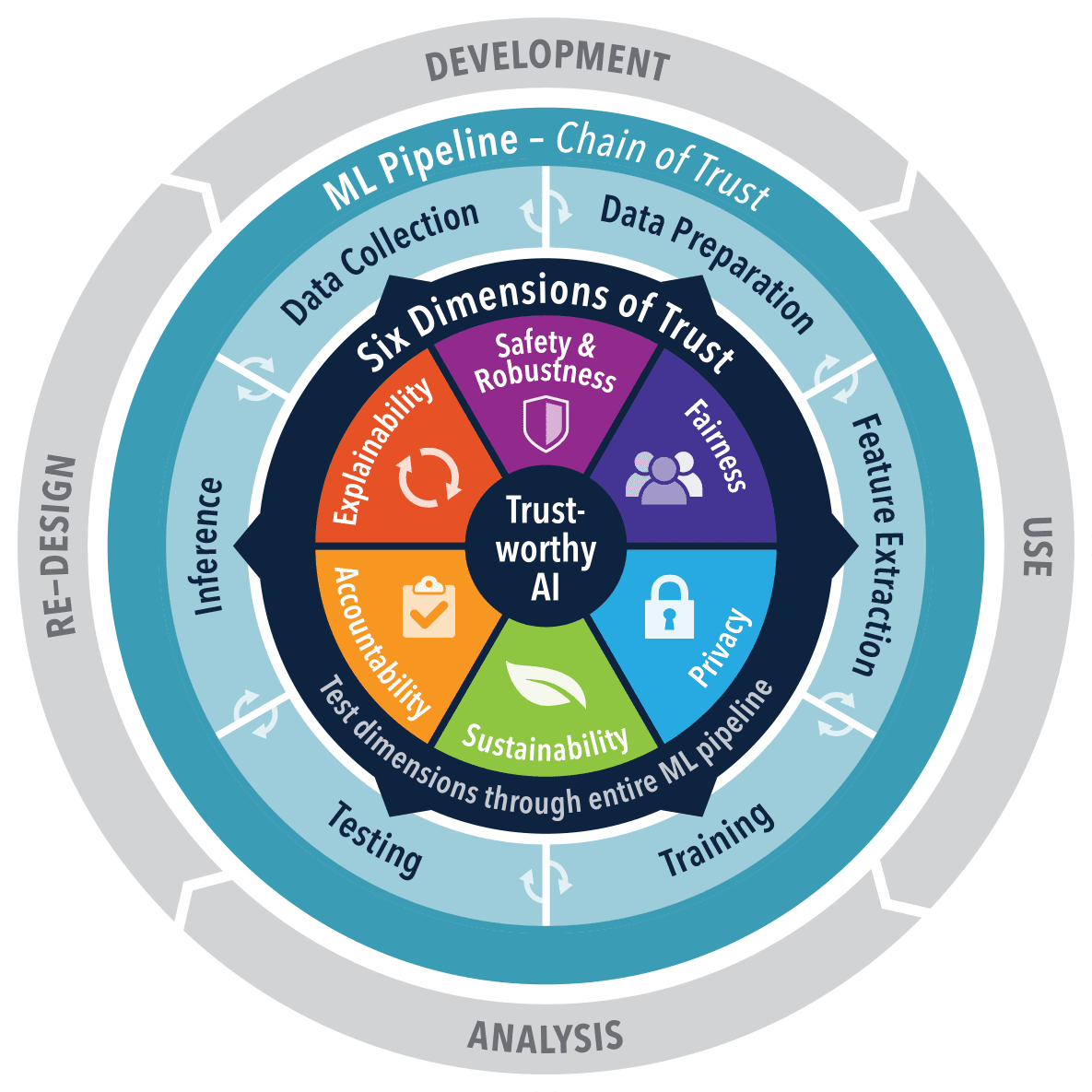

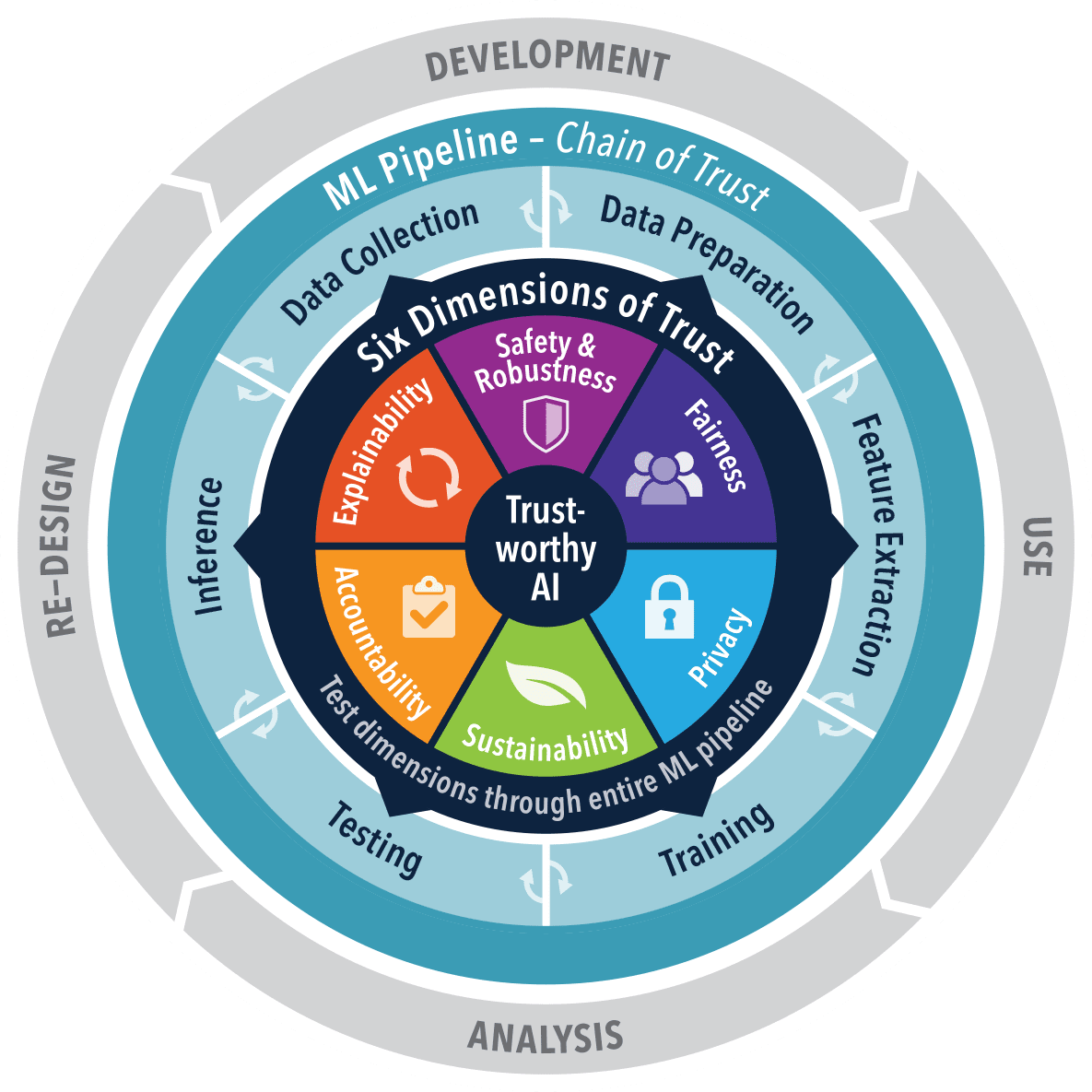

In alignment with President Biden’s recent فرمان اجرایی با تاکید بر هوش مصنوعی ایمن، مطمئن و قابل اعتماد، ما خود را به اشتراک می گذاریم هوش مصنوعی قابل اعتماد (TAI) دروس آموخته شده دو سال پس از دوره پروژه های تحقیقاتی ما. این ابتکار تحقیقاتی که در شکل زیر به تصویر کشیده شده است، بر عملیاتی کردن هوش مصنوعی متمرکز است که استانداردهای اخلاقی و عملکرد دقیق را برآورده می کند. با روند رو به رشد صنعت به سمت شفافیت و مسئولیت پذیری در سیستم های هوش مصنوعی، به ویژه در زمینه های حساس مانند امنیت ملی، همسو است. این مقاله تغییر از مهندسی نرمافزار سنتی به رویکردهای هوش مصنوعی را که در آن اعتماد مهم است، منعکس میکند.

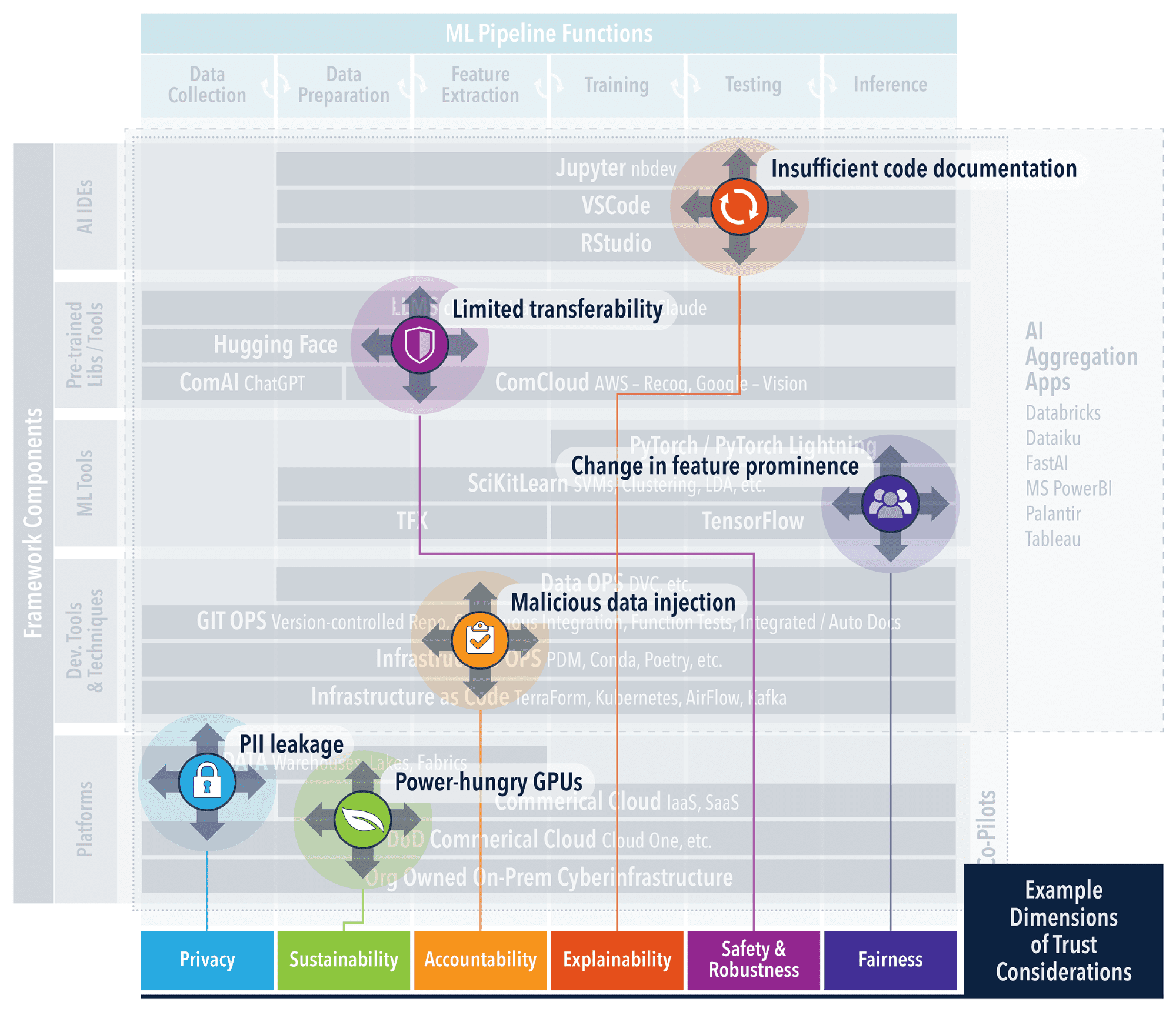

Transitioning from “Software 1.0 to 2.0 and notions of 3.0″ necessitates a reliable infrastructure that not only conceptualizes but also practically enforces trust in AI. Even a simple set of example ML components such as that shown in the figure below, demonstrates the significant complexity that must be understood to address trust concerns at each level. Our TAI Frameworks sub-Project addresses this need by offering an integration point for software and best practices from TAI research products. Frameworks like these lower the barriers to TAI implementation. By automating the setup, developers and decision-makers can channel their efforts toward innovation and strategy, rather than grappling with initial complexities. This ensures that trust is not an afterthought but a prerequisite, with each phase from data management to model deployment being inherently aligned with ethical and operational standards. The result is a streamlined path to deploying AI systems that are not only technologically advanced but also ethically sound and strategically reliable for high-stakes environments. The TAI Frameworks project surveys and leverages existing software tools and best practices that have their own open source, sustainable communities and can be directly leveraged within the existing operational environments.

GitOps has become integral to AI engineering, especially within the framework of TAI. It represents an evolution in how software development and operational workflows are managed, offering a declarative approach to infrastructure and application lifecycle management. This methodology is pivotal in ensuring continuous quality and incorporating ethical responsibility in AI systems. The TAI Frameworks Project leverages GitOps as a foundational component to automate and streamline the development pipeline, from code to deployment. This approach ensures that best practices in software engineering are adhered to automatically, allowing for an immutable audit trail, version-controlled environment, and seamless rollback capabilities. It simplifies complex deployment processes. Moreover, GitOps facilitates the integration of ethical considerations by providing a structure where ethical checks can be automated as part of the CI/CD pipeline. The adoption of CI/CD in AI development is not just about maintaining code quality; it’s about ensuring that AI systems are reliable, safe, and perform as expected. TAI promotes automated testing protocols that address the unique challenges of AI, particularly as we enter the era of generative AI and prompt-based systems. Testing is no longer confined to static code analysis and unit tests. It extends to dynamic validation of AI behaviors, encompassing the outputs of generative models and the efficacy of prompts. Automated test suites must now be capable of assessing not just the accuracy of responses, but also their relevance and safety.

در پیگیری TAI، یک رویکرد دادهمحور اساسی است، زیرا کیفیت و وضوح دادهها را بر پیچیدگیهای الگوریتمها اولویت میدهد و در نتیجه اعتماد و قابلیت تفسیر را از پایه ایجاد میکند. در این چارچوب، طیف وسیعی از ابزارها برای حفظ یکپارچگی داده ها و قابلیت ردیابی در دسترس است. دی وی سی (کنترل نسخه داده) به ویژه به دلیل تطابق آن با چارچوب GitOps، بهبود Git برای دربرگرفتن داده ها و مدیریت آزمایش مورد علاقه است (به گزینه های جایگزین مراجعه کنید. اینجا کلیک نمایید). این کنترل دقیق نسخه را برای مجموعه داده ها و مدل ها تسهیل می کند، درست همانطور که Git برای کد انجام می دهد، که برای اقدامات موثر CI/CD ضروری است. این تضمین میکند که موتورهای دادهای که سیستمهای هوش مصنوعی را تامین میکنند، به طور مداوم با دادههای دقیق و قابل ممیزی تغذیه میشوند، که پیش نیازی برای هوش مصنوعی قابل اعتماد است. ما اهرم می کنیم nbdev که با تبدیل کردن نوت بوک های Jupyter به رسانه ای برای برنامه نویسی باسواد و برنامه نویسی اکتشافی، dvc را تحسین می کند، و انتقال از تحلیل اکتشافی به کدهای مستند را ساده می کند. ماهیت توسعه نرمافزار به این سبک از «برنامهنویسی» تغییر میکند و تنها با تکامل هوش مصنوعی «Co-Pilots» که به مستندسازی و ساخت برنامههای هوش مصنوعی کمک میکند، تسریع مییابد. لایحه مواد نرم افزاری (SBoMs) و AI BoMs، که توسط استانداردهای باز مانند SPDX, are integral to this ecosystem. They serve as detailed records that complement dvc and nbdev, encapsulating the provenance, composition, and compliance of AI models. SBoMs provide a comprehensive list of components, ensuring that each element of the AI system is accounted for and verified. AI BoMs extend this concept to include data sources and transformation processes, offering a level of transparency to models and data in an AI application. Together, they form a complete picture of an AI system’s lineage, promoting trust and facilitating understanding among stakeholders.

Ethical and data-centric approaches are fundamental to TAI, ensuring AI systems are both effective and reliable. Our TAI frameworks project leverages tools like dvc for data versioning and nbdev for literate programming, reflecting a shift in software engineering that accommodates the nuances of AI. These tools are emblematic of a greater trend towards integrating data quality, transparency, and ethical considerations from the start of the AI development process. In the civilian and defense sectors alike, the principles of TAI remain constant: a system is only as reliable as the data it’s built on and the ethical framework it adheres to. As the complexity of AI increases, so does the need for robust frameworks that can handle this complexity transparently and ethically. The future of AI, particularly in mission critical applications, will hinge on the adoption of these data-centric and ethical approaches, solidifying trust in AI systems across all domains.

درباره نویسندگان

چارلز واردمن، کریستوفر سویت و پل برنر از دانشمندان پژوهشگر این دانشگاه هستند مرکز محاسبات تحقیقاتی دانشگاه نوتردام. آنها چندین دهه تجربه در توسعه نرم افزارهای علمی و الگوریتم با تمرکز بر تحقیقات کاربردی برای انتقال فناوری به عملیات محصول دارند. آنها دارای مقالات فنی متعدد، پتنت ها و فعالیت های تحقیقاتی با بودجه در حوزه علم داده و زیرساخت سایبری هستند. تکههای هفتگی TAI که با پروژههای تحقیقاتی دانشآموزی هماهنگ شدهاند را میتوان یافت اینجا کلیک نمایید.

دکتر چارلز واردمن یک دانشمند محقق در مرکز محاسبات تحقیقاتی دانشگاه نوتردام است.

- محتوای مبتنی بر SEO و توزیع روابط عمومی. امروز تقویت شوید.

- PlatoData.Network Vertical Generative Ai. به خودت قدرت بده دسترسی به اینجا.

- PlatoAiStream. هوش وب 3 دانش تقویت شده دسترسی به اینجا.

- PlatoESG. کربن ، CleanTech، انرژی، محیط، خورشیدی، مدیریت پسماند دسترسی به اینجا.

- PlatoHealth. هوش بیوتکنولوژی و آزمایشات بالینی. دسترسی به اینجا.

- منبع: https://www.kdnuggets.com/expert-insights-on-developing-safe-secure-and-trustworthy-ai-frameworks?utm_source=rss&utm_medium=rss&utm_campaign=expert-insights-on-developing-safe-secure-and-trustworthy-ai-frameworks

- : دارد

- :است

- :نه

- :جایی که

- $UP

- 1

- a

- درباره ما

- تسریع شد

- مسئوليت

- اختصاص

- دقت

- دقیق

- در میان

- فعالیت ها

- نشانی

- آدرس

- پایبند شد

- اتخاذ

- پیشرفته

- AI

- مهندسی هوش مصنوعی

- مدل های هوش مصنوعی

- سیستم های هوش مصنوعی

- کمک

- الگوریتم

- الگوریتم

- هم راستا

- هم ترازی

- تراز می کند

- به طور یکسان

- معرفی

- اجازه دادن

- همچنین

- جایگزین

- در میان

- an

- تحلیل

- و

- کاربرد

- برنامه های کاربردی

- اعمال می شود

- روش

- رویکردها

- هستند

- مناطق

- مقاله

- AS

- ارزیابی

- At

- حسابرسی

- خودکار بودن

- خودکار

- بطور خودکار

- اتوماسیون

- در دسترس

- موانع

- BE

- شدن

- بودن

- در زیر

- بهترین

- بهترین شیوه

- بایدن

- لایحه

- هر دو

- ساخته

- اما

- by

- CAN

- قابلیت های

- توانا

- مرکز

- چالش ها

- کانال

- چارلز

- چک

- کریستوفر

- CISA

- وضوح

- رمز

- جوامع

- متمم

- کامل

- پیچیده

- پیچیدگی ها

- پیچیدگی

- انطباق

- تعریف

- جزء

- اجزاء

- ترکیب

- جامع

- محاسبه

- مفهوم

- نگرانی ها

- ملاحظات

- همواره

- ثابت

- ساخت و ساز

- مداوم

- کنترل

- دوره

- بحرانی

- داده ها

- مدیریت اطلاعات

- کیفیت داده

- علم اطلاعات

- کنترل نسخه داده

- مجموعه داده ها

- دهه

- تصمیم گیرندگان

- دفاع

- نشان می دهد

- استقرار

- گسترش

- دقیق

- توسعه دهندگان

- در حال توسعه

- پروژه

- مستقیما

- مستندات

- میکند

- حوزه

- dr

- دی وی سی

- پویا

- هر

- اکوسیستم

- موثر

- اثر

- تلاش

- عنصر

- با تاکید بر

- شامل

- شامل

- مهندسی

- موتورهای حرفه ای

- افزایش

- تضمین می کند

- حصول اطمینان از

- وارد

- محیط

- محیط

- عصر

- به خصوص

- ضروری است

- ایجاد

- اخلاقی

- حتی

- تکامل

- در حال تحول

- مثال

- موجود

- انتظار می رود

- تجربه

- تجربه

- کارشناس

- بینش تخصصی

- گسترش

- گسترش می یابد

- تسهیل می کند

- تسهیل کننده

- FAST

- تغذیه

- شکل

- تمرکز

- تمرکز

- برای

- فرم

- یافت

- بنیادین

- چارچوب

- چارچوب

- از جانب

- اساسی

- بودجه

- آینده

- آینده هوش مصنوعی

- مولد

- هوش مصنوعی مولد

- رفتن

- GitHub

- چنگ زدن

- بیشتر

- زمین

- در حال رشد

- دسته

- آیا

- لولا

- چگونه

- HTML

- HTTPS

- تغییر ناپذیر

- پیاده سازی

- in

- شامل

- گنجاندن

- افزایش

- صنعت

- شالوده

- ذاتا

- اول

- ابتکار عمل

- ابداع

- بینش

- انتگرال

- ادغام

- ادغام

- تمامیت

- به

- پیچیدگی ها

- IT

- ITS

- تنها

- kdnuggets

- آموخته

- درس

- درس های آموخته شده

- سطح

- قدرت نفوذ

- اهرم

- اهرم ها

- wifecycwe

- پسندیدن

- لینک

- فهرست

- سواد آموزی

- دیگر

- کاهش

- نگهداری

- اداره می شود

- مدیریت

- متوسط

- ملاقات

- روش شناسی

- ماموریت

- ML

- مدل

- مدل

- علاوه بر این

- باید

- ملی

- امنیت ملی

- طبیعت

- نیاز

- نه

- نوت بوک

- اکنون

- تفاوت های ظریف

- متعدد

- of

- ارائه

- on

- فقط

- باز کن

- منبع باز

- قابل استفاده

- عملیات

- ما

- خروجی

- روی

- خود

- اوراق

- برترین

- بخش

- ویژه

- اختراعات

- مسیر

- پل

- انجام دادن

- کارایی

- فاز

- تصویر

- خط لوله

- محوری

- افلاطون

- هوش داده افلاطون

- PlatoData

- نقطه

- برق

- عملا

- شیوه های

- دقیق

- رئيس جمهور

- رئیس جمهور پیشنهاد

- از اصول

- اولویت بندی می کند

- روند

- فرآیندهای

- محصول

- محصولات

- برنامه نويسي

- پروژه

- پروژه ها

- ترویج می کند

- ترویج

- پرسیدن

- پروتکل

- منشاء

- ارائه

- ارائه

- دستیابی

- کیفیت

- محدوده

- نسبتا

- قلمروها

- اخیر

- سوابق

- بازتاب

- بازتاب می دهد

- ربط

- قابل اعتماد

- ماندن

- نشان دهنده

- تحقیق

- پاسخ

- مسئوليت

- نتیجه

- دقیق

- تنومند

- s

- امن

- ایمنی

- علم

- علمی

- دانشمندان

- بدون درز

- بخش ها

- امن

- تیم امنیت لاتاری

- دیدن

- حساس

- خدمت

- تنظیم

- برپایی

- اشتراک گذاری

- تغییر

- نشان داده شده

- قابل توجه

- ساده

- ساده می کند

- So

- نرم افزار

- قبض نرم افزار

- توسعه نرم افزار

- مهندسی نرم افزار

- محکم شدن

- صدا

- منبع

- منابع

- سهامداران

- استانداردهای

- شروع

- استراتژیک

- استراتژی

- ساده کردن

- ساده

- ساده

- ساختار

- دانشجو

- سبک

- چنین

- قابل تحمل

- شیرین

- سیستم

- سیستم های

- فنی

- پیشرفته

- آزمون

- تست

- تست

- نسبت به

- که

- La

- آینده

- شان

- در نتیجه

- اینها

- آنها

- این

- به

- با هم

- ابزار

- نسبت به

- طرف

- قابلیت ردیابی

- سنتی

- دنباله

- انتقال

- دگرگونی

- انتقال

- شفافیت

- شفاف

- روند

- اعتماد

- قابل اعتماد

- عطف

- دو

- درک

- فهمید

- منحصر به فرد

- واحد

- دانشگاه

- حمایت

- اعتبار سنجی

- تایید

- نسخه

- کنترل نسخه

- we

- هفتگی

- که

- اراده

- با

- در داخل

- گردش کار

- سال

- زفیرنت