در سرتاسر جهان شوک به سرعت پیشرفت با GPT چت و دیگر هوش مصنوعی ایجاد شده با آنچه به عنوان مدل های زبان بزرگ (LLM) شناخته می شود. این سیستم ها می توانند متنی تولید کنند که به نظر می رسد تفکر، درک و حتی خلاقیت را نشان می دهد.

اما آیا این سیستم ها واقعاً می توانند فکر کنند و بفهمند؟ این سوالی نیست که بتوان از طریق پیشرفت تکنولوژی به آن پاسخ داد، اما تحلیل و استدلال دقیق فلسفی به ما می گوید که پاسخ منفی است. و بدون بررسی این مسائل فلسفی، ما هرگز به طور کامل خطرات و مزایای انقلاب هوش مصنوعی را درک نخواهیم کرد.

در سال 1950، پدر محاسبات مدرن، آلن تورینگ، چاپ مقاله که راهی برای تعیین اینکه آیا یک کامپیوتر فکر می کند یا نه، ارائه می کند. اکنون به این "آزمون تورینگ" می گویند. تورینگ انسانی را در حال مکالمه با دو همکار پنهان از دید تصور کرد: یکی انسان دیگری و دیگری یک کامپیوتر. این بازی برای کار کردن است که کدام است.

اگر یک کامپیوتر بتواند 70 درصد از قضات را در یک مکالمه 5 دقیقه ای فریب دهد و فکر کند که یک شخص است، کامپیوتر امتحان را با موفقیت پشت سر می گذارد. آیا قبولی در آزمون تورینگ - چیزی که اکنون قریب الوقوع به نظر می رسد - نشان می دهد که یک هوش مصنوعی به فکر و درک دست یافته است؟

چالش شطرنج

تورینگ این سؤال را بهعنوان ناامیدکنندهای مبهم رد کرد و آن را با تعریفی عملگرایانه از «اندیشه» جایگزین کرد، که به موجب آن فکر کردن به معنای قبولی در آزمون است.

با این حال، تورینگ در اشتباه بود، زیرا گفت تنها مفهوم روشن "درک"، مفهوم صرفا رفتاری گذراندن آزمون او است. اگرچه این طرز تفکر اکنون بر علم شناختی غالب است، اما یک مفهوم واضح و روزمره از "درک" نیز وجود دارد که به هوشیاری. درک به این معنا به معنای درک آگاهانه حقیقت در مورد واقعیت است.

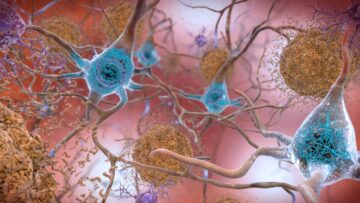

در 1997، هوش مصنوعی دیپ بلو استاد بزرگ شطرنج گری کاسپاروف را شکست داد. در یک مفهوم صرفا رفتاری از درک، دیپ بلو دانشی از استراتژی شطرنج داشت که از هر انسانی پیشی گرفت. اما آگاهانه نبود: هیچ احساس یا تجربه ای نداشت.

انسان ها آگاهانه قوانین شطرنج و منطق یک استراتژی را درک می کنند. در مقابل، Deep Blue مکانیزمی بی احساس بود که برای عملکرد خوب در بازی آموزش دیده بود. به همین ترتیب، ChatGPT یک مکانیسم بی احساس است که بر روی مقادیر عظیمی از داده های ساخت بشر آموزش داده شده است تا محتوایی تولید کند که به نظر می رسد توسط یک شخص نوشته شده است.

آگاهانه معنی کلماتی را که به بیرون تف می کند نمی فهمد. اگر "فکر" به معنای عمل بازتاب آگاهانه باشد، ChatGPT هیچ فکری در مورد چیزی ندارد.

زمان پرداخت

چگونه می توانم مطمئن باشم که ChatGPT هوشیار نیست؟ در دهه 1990، عصب شناس کریستف کخ دیوید چالمرز، فیلسوف، یک مورد شراب خوب را شرط بندی کرده است که دانشمندان در 25 سال به طور کامل "همبستگی های عصبی آگاهی" را مشخص می کردند.

منظور او از این بود که آنها اشکال فعالیت مغزی لازم و کافی برای تجربه آگاهانه را شناسایی می کردند. زمان آن فرا رسیده است که کوچ پرداخت کند، زیرا اتفاق نظر وجود ندارد که این اتفاق افتاده است.

این بخاطر این است که هوشیاری با نگاه کردن به درون سر شما قابل مشاهده نیست. دانشمندان علوم اعصاب در تلاش خود برای یافتن ارتباط بین فعالیت مغز و تجربه باید بر شهادت آزمودنی های خود یا بر نشانگرهای بیرونی آگاهی تکیه کنند. اما روش های مختلفی برای تفسیر داده ها وجود دارد.

برخی از دانشمندان بر این باورند که ارتباط نزدیکی بین آگاهی و شناخت بازتابی وجود دارد - توانایی مغز برای دسترسی و استفاده از اطلاعات برای تصمیمگیری. این باعث میشود آنها فکر کنند که قشر جلوی مغز - جایی که فرآیندهای سطح بالای کسب دانش در آن اتفاق میافتد - اساساً در تمام تجربیات آگاهانه دخالت دارد. دیگران این را انکار می کنند، به جای آن بحث می کنند پردازش حسی مربوطه در هر ناحیه محلی از مغز اتفاق می افتد.

دانشمندان درک خوبی از شیمی پایه مغز دارند. ما همچنین در درک عملکردهای سطح بالای بخشهای مختلف مغز پیشرفت کردهایم. اما ما تقریباً در مورد چیزی که در این بین وجود دارد بی اطلاع هستیم: اینکه چگونه عملکرد سطح بالای مغز در سطح سلولی تحقق می یابد.

مردم در مورد پتانسیل اسکن برای آشکار کردن عملکرد مغز بسیار هیجان زده می شوند. اما fMRI (تصویربرداری رزونانس مغناطیسی کاربردی) وضوح بسیار پایینی دارد: هر پیکسل در اسکن مغز، 5.5 میلیون نورون مطابقت دارد، که به این معنی است که محدودیتی برای جزئیات این اسکن ها وجود دارد.

من معتقدم پیشرفت در هشیاری زمانی حاصل خواهد شد که نحوه عملکرد مغز را بهتر درک کنیم.

مکث در توسعه

همانطور که در کتاب آینده ام بحث می کنم چرا؟ هدف کیهان, آگاهی باید تکامل یافته باشد زیرا تفاوت رفتاری ایجاد کرده است. سیستمهای دارای آگاهی باید متفاوت رفتار کنند و بنابراین بهتر از سیستمهای بدون آگاهی زنده بمانند.

اگر همه رفتارها توسط شیمی و فیزیک اساسی تعیین می شد، انتخاب طبیعی هیچ انگیزه ای برای آگاه کردن موجودات نداشت. ما می توانستیم به عنوان مکانیسم های بقای بی احساس تکامل یافته باشیم.

بنابراین، شرط من این است که با یادگیری بیشتر در مورد جزئیات عملکرد مغز، دقیقاً تشخیص خواهیم داد که کدام بخش از مغز تجسم آگاهی است. این به این دلیل است که آن مناطق رفتاری از خود نشان خواهند داد که با شیمی و فیزیک شناخته شده کنونی قابل توضیح نیست. قبلا، پیش از این، برخی از دانشمندان علوم اعصاب به دنبال توضیحات جدید بالقوه برای آگاهی برای تکمیل معادلات اساسی فیزیک هستند.

در حالی که پردازش LLM اکنون برای ما پیچیده تر از آن است که بتوانیم آن را به طور کامل درک کنیم، می دانیم که در اصل می توان آن را از فیزیک شناخته شده پیش بینی کرد. بر این اساس، می توانیم با اطمینان ادعا کنیم که ChatGPT آگاه نیست.

خطرات زیادی توسط هوش مصنوعی وجود دارد، و من کاملاً از تماس اخیر ده ها هزار نفر از جمله رهبران فناوری استیو وزنیاک و ایلان ماسک حمایت می کنم. مکث کردن توسعه برای رفع نگرانی های ایمنی برای مثال، پتانسیل تقلب بسیار زیاد است. با این حال، این استدلال که فرزندان سیستمهای هوش مصنوعی فعلی فوقالعاده هوشمند خواهند بود و از این رو تهدیدی بزرگ برای بشریت خواهند بود، نابهنگام است.

این بدان معنا نیست که سیستمهای هوش مصنوعی فعلی خطرناک نیستند. اما ما نمیتوانیم یک تهدید را به درستی ارزیابی کنیم، مگر اینکه آن را به طور دقیق دستهبندی کنیم. LLM ها باهوش نیستند. آنها سیستمهایی هستند که برای نشان دادن ظاهر ظاهری هوش انسانی آموزش دیدهاند. ترسناک است، اما نه آنقدرها.![]()

این مقاله از مجله منتشر شده است گفتگو تحت مجوز Creative Commons دفعات بازدید: مقاله.

تصویر های اعتباری: گرت آلتمن از جانب Pixabay

- محتوای مبتنی بر SEO و توزیع روابط عمومی. امروز تقویت شوید.

- PlatoAiStream. Web3 Data Intelligence دانش تقویت شده دسترسی به اینجا.

- ضرب کردن آینده با آدرین اشلی. دسترسی به اینجا.

- خرید و فروش سهام در شرکت های PRE-IPO با PREIPO®. دسترسی به اینجا.

- منبع: https://singularityhub.com/2023/05/23/chatgpt-cant-think-consciousness-is-something-entirely-different-to-todays-ai/

- : دارد

- :است

- :نه

- $UP

- 1

- 2019

- 70

- a

- توانایی

- قادر

- درباره ما

- بالاتر

- AC

- دسترسی

- به درستی

- دست

- کسب

- عمل

- فعالیت

- نشانی

- پیشرفت

- پیشرفته

- پس از

- AI

- سیستم های هوش مصنوعی

- آلن

- آلن تورینگ

- معرفی

- قبلا

- همچنین

- هر چند

- مقدار

- an

- تحلیل

- و

- دیگر

- پاسخ

- هر

- هر چیزی

- هستند

- مناطق

- استدلال

- استدلال

- دور و بر

- مقاله

- مصنوعی

- هوش مصنوعی

- AS

- At

- تلاشها

- اساسی

- اساس

- BE

- زیرا

- بوده

- بودن

- باور

- در زیر

- مزایای

- شرط

- بهتر

- میان

- بیت

- آبی

- کتاب

- مغز

- فعالیت مغز

- اما

- دکمه

- by

- صدا

- نام

- CAN

- دقیق

- مورد

- GPT چت

- شیمی

- شطرنج

- واضح

- کلیک

- نزدیک

- رمز

- شناختی

- جمع آوری

- COM

- بیا

- مردم عادی

- پیچیده

- درک

- کامپیوتر

- محاسبه

- طرح

- نگرانی ها

- با اطمینان

- ارتباط

- هوشیار

- آگاهی

- اجماع

- محتوا

- کنتراست

- گفتگو

- مطابقت دارد

- میتوانست

- مقابله با

- ایجاد شده

- خالق

- خلاقیت

- اعتبار

- cs

- جاری

- در حال حاضر

- خطرناک

- خطرات

- داده ها

- داود

- تصمیم گیری

- عمیق

- جزئیات

- دقیق

- مشخص

- تعیین

- پروژه

- تفاوت

- مختلف

- نمایش دادن

- do

- میکند

- نمی کند

- غالب است

- دان

- پایین

- الون

- Elon مشک

- پایان

- مشغول

- به طور کامل

- معادلات

- اساسا

- حتی

- هر روز

- تکامل

- مثال

- برانگیخته

- نمایش دادن

- تجربه

- تجارب

- توضیح داده شده

- خارجی

- احساسات

- پیدا کردن

- پایان

- برای

- اشکال

- آینده

- تقلب

- از جانب

- کاملا

- تابعی

- عملکرد

- توابع

- بازی

- تولید می کنند

- دریافت کنید

- GIF

- دادن

- خوب

- فهم

- بود

- اتفاق افتاده است

- اتفاق می افتد

- آیا

- he

- سر

- از این رو

- پنهان

- در سطح بالا

- خود را

- چگونه

- اما

- HTML

- HTTP

- HTTPS

- بزرگ

- انسان

- هوش انسانی

- بشریت

- i

- شناسایی

- شناسایی

- if

- تصور

- تصویربرداری

- عظیم

- in

- از جمله

- اطلاعات

- اطلاعات

- در عوض

- اطلاعات

- هوشمند

- به

- گرفتار

- مسائل

- IT

- تنها

- دانستن

- دانش

- شناخته شده

- کخ

- زبان

- بزرگ

- رهبران

- منجر می شود

- یاد گرفتن

- سطح

- مجوز

- پسندیدن

- محدود

- محلی

- به دنبال

- کم

- ساخته

- عمده

- ساخت

- ساخت

- بسیاری

- متوسط

- معنی

- به معنی

- به معنای

- مکانیزم

- مکانیسم

- میلیون

- مدل

- مدرن

- بیش

- انگیزه

- بسیار

- چندگانه

- مشک

- باید

- my

- طبیعی

- طبیعت

- لازم

- نورون ها

- هرگز

- جدید

- نه

- ایده

- اکنون

- of

- on

- ONE

- فقط

- or

- دیگر

- دیگران

- خارج

- با ما

- پرداخت

- عبور می کند

- عبور

- پرداخت

- مردم

- در صد

- انجام دادن

- شخص

- شخصی

- اطلاعات شخصی

- فیزیک

- محل

- افلاطون

- هوش داده افلاطون

- PlatoData

- لطفا

- پتانسیل

- عملگرا

- دقیقا

- پیش بینی

- زودرس

- اصل

- فرآیندهای

- در حال پردازش

- تولید کردن

- پیشرفت

- صرفا

- هدف

- سوال

- سریع

- نرخ

- خواندن

- واقعیت

- متوجه

- واقعا

- اخیر

- انعکاس

- منطقه

- مناطق

- مربوط

- تکیه

- برداشتن

- جایگزین

- وضوح

- تشدید

- فاش کردن

- انقلاب

- قوانین

- s

- ایمنی

- سعید

- اسکن

- علم

- دانشمندان

- دیدن

- به دنبال

- به نظر می رسد

- انتخاب

- حس

- نشان

- So

- برخی از

- چیزی

- استیو

- استیو ووزنیاک (Steve Wozniak)

- استراتژی

- کافی

- مکمل

- پشتیبانی

- بقاء

- زنده ماندن

- سیستم های

- TAG

- گرفتن

- طول می کشد

- فن آوری

- فنی

- گفتن

- ده ها

- آزمون

- شهادت

- نسبت به

- که

- La

- جهان

- شان

- آنها

- سپس

- آنجا.

- اینها

- آنها

- فکر می کنم

- تفکر

- فکر می کند

- این

- کسانی که

- فکر

- هزاران نفر

- تهدید

- از طریق

- گره خورده است

- زمان

- به

- امروز

- هم

- آموزش دیده

- حقیقت

- تورینگ

- آزمون تورینگ

- دو

- زیر

- اساسی

- فهمیدن

- درک

- us

- استفاده کنید

- مختلف

- بسیار

- چشم انداز

- بود

- مسیر..

- راه

- we

- خوب

- چه زمانی

- چه

- که

- ویکیپدیا

- اراده

- با

- بدون

- کلمات

- مهاجرت کاری

- کار کردن

- کارگر

- کارها

- با این نسخهها کار

- جهان

- خواهد بود

- کتبی

- اشتباه

- سال

- شما

- شما

- زفیرنت

- صفر