معرفی

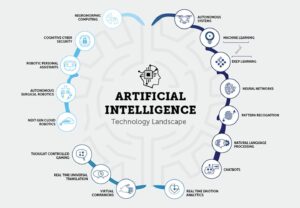

از آنجایی که حوزه هوش مصنوعی (AI) به رشد و تکامل خود ادامه می دهد، برای توسعه دهندگان مشتاق هوش مصنوعی به روز شدن با آخرین تحقیقات و پیشرفت ها اهمیت فزاینده ای پیدا می کند. یکی از بهترین راهها برای انجام این کار، خواندن مقالههای هوش مصنوعی برای توسعهدهندگان GenAI است که بینشهای ارزشمندی را در مورد تکنیکها و الگوریتمهای پیشرفته ارائه میدهد. این مقاله به بررسی 15 مقاله ضروری هوش مصنوعی برای توسعه دهندگان GenAI می پردازد. این مقالات موضوعات مختلفی از پردازش زبان طبیعی گرفته تا بینایی کامپیوتری را پوشش می دهند. آنها درک شما را از هوش مصنوعی افزایش می دهند و شانس شما را برای اولین شغل خود در این زمینه هیجان انگیز افزایش می دهند.

اهمیت مقالات AI برای توسعه دهندگان GenAI

مقالات AI Papers برای توسعه دهندگان GenAI به محققان و کارشناسان اجازه می دهد تا یافته ها، روش ها و پیشرفت های خود را با جامعه گسترده تر به اشتراک بگذارند. با خواندن این مقالات، به آخرین پیشرفتهای هوش مصنوعی دسترسی پیدا میکنید و به شما این امکان را میدهد که جلوتر از منحنی باشید و تصمیمات آگاهانه در کار خود بگیرید. علاوه بر این، مقالات AI Papers برای توسعه دهندگان GenAI اغلب توضیحات مفصلی از الگوریتم ها و تکنیک ها ارائه می دهند و به شما درک عمیق تری از نحوه کار آنها و نحوه اعمال آنها در مسائل دنیای واقعی می دهند.

خواندن مقالات AI برای توسعه دهندگان GenAI مزایای متعددی را برای توسعه دهندگان مشتاق هوش مصنوعی ارائه می دهد. در مرحله اول، به شما کمک می کند تا از آخرین تحقیقات و روندها در این زمینه مطلع شوید. این دانش هنگام درخواست مشاغل مرتبط با هوش مصنوعی بسیار مهم است، زیرا کارفرمایان اغلب به دنبال نامزدهایی می گردند که با جدیدترین پیشرفت ها آشنا هستند. علاوه بر این، خواندن مقالات هوش مصنوعی به شما امکان می دهد دانش خود را گسترش دهید و درک عمیق تری از مفاهیم و روش های هوش مصنوعی به دست آورید. این دانش را می توان در پروژه ها و تحقیقات شما به کار برد و شما را به یک توسعه دهنده هوش مصنوعی ماهرتر و ماهرتر تبدیل کرد.

جدول محتوا

یک مرور کلی: مقالات ضروری AI برای توسعه دهندگان GenAI با پیوند

مقاله 1: ترانسفورماتورها: توجه تنها چیزی است که نیاز دارید

ارتباط دادن: اینجا را بخوانید

خلاصه مقاله

این مقاله ترانسفورماتور را معرفی میکند، یک معماری شبکه عصبی جدید برای وظایف انتقال توالی، مانند ترجمه ماشینی. برخلاف مدلهای سنتی مبتنی بر شبکههای عصبی مکرر یا کانولوشن، ترانسفورماتور تنها به مکانیسمهای توجه متکی است و نیاز به تکرار و پیچیدگی را از بین میبرد. نویسندگان استدلال می کنند که این معماری از نظر کیفیت ترجمه، افزایش موازی پذیری و کاهش زمان آموزش، عملکرد برتری را ارائه می دهد.

بینش های کلیدی مقالات هوش مصنوعی برای توسعه دهندگان GenAI

- مکانیسم توجه

ترانسفورماتور کاملاً بر اساس مکانیسم های توجه ساخته شده است و به آن امکان می دهد وابستگی های جهانی بین توالی های ورودی و خروجی را ثبت کند. این رویکرد مدل را قادر می سازد تا روابط را بدون محدود شدن با فاصله بین عناصر در دنباله ها در نظر بگیرد.

- موازی سازی

یکی از مزیت های اصلی معماری ترانسفورماتور موازی پذیری افزایش یافته آن است. مدلهای تکرارشونده سنتی از محاسبات متوالی رنج میبرند و موازیسازی را به چالش میکشند. طراحی ترانسفورماتور امکان پردازش موازی کارآمدتر را در حین تمرین فراهم می کند و زمان تمرین را کاهش می دهد.

- کیفیت و کارایی برتر

این مقاله نتایج تجربی را بر روی وظایف ترجمه ماشینی ارائه میکند و نشان میدهد که ترانسفورماتور به کیفیت ترجمه برتر در مقایسه با مدلهای موجود دست مییابد. با اختلاف قابل توجهی از نتایج پیشرفته قبلی، از جمله مدل های مجموعه، بهتر عمل می کند. علاوه بر این، ترانسفورماتور این نتایج را با زمان تمرین بسیار کمتری به دست می آورد.

- عملکرد ترجمه

در کار ترجمه انگلیسی به آلمانی WMT 2014، مدل پیشنهادی به امتیاز BLEU 28.4 دست می یابد که از بهترین نتایج موجود با بیش از 2 BLEU پیشی می گیرد. در تکلیف انگلیسی به فرانسوی، این مدل پس از آموزش تنها به مدت 41.8 روز روی هشت پردازنده گرافیکی، امتیاز BLEU پیشرفته 3.5 را برای تک مدل ایجاد می کند.

- تعمیم به وظایف دیگرنویسندگان نشان می دهند که معماری Transformer به خوبی به وظایفی فراتر از ترجمه ماشینی تعمیم می یابد. آنها با موفقیت این مدل را برای تجزیه حوزه انگلیسی به کار میبرند و سازگاری آن را با مسائل مختلف انتقال توالی نشان میدهند.

مقاله 2: BERT: پیش آموزش ترانسفورماتورهای عمیق دو جهته برای درک زبان

ارتباط دادن: اینجا را بخوانید

خلاصه مقاله

پیشآموزش مدل زبان برای بهبود وظایف مختلف پردازش زبان طبیعی مؤثر بوده است. این مقاله بین رویکردهای مبتنی بر ویژگی و تنظیم دقیق برای استفاده از بازنمایی های زبانی از پیش آموزش دیده تمایز قائل می شود. BERT برای رسیدگی به محدودیتها در رویکردهای تنظیم دقیق، بهویژه محدودیت تک جهتی مدلهای زبان استاندارد معرفی شده است. این مقاله یک هدف پیشآموزشی «مدل زبان نقابدار» (MLM) را پیشنهاد میکند که از کار Cloze الهام گرفته شده است تا نمایشهای دوطرفه را فعال کند. وظیفه «پیشبینی جمله بعدی» برای پیشآموزش مشترک بازنماییهای جفت متن نیز استفاده میشود.

بینش های کلیدی مقالات هوش مصنوعی برای توسعه دهندگان GenAI

- اهمیت پیش تمرینی دوطرفه

این مقاله بر اهمیت پیشآموزش دوطرفه برای بازنمایی زبان تأکید میکند. بر خلاف مدلهای قبلی، BERT از مدلهای زبان ماسکدار برای فعال کردن نمایشهای دوسویه عمیق استفاده میکند، که از مدلهای زبان یکجهت استفاده شده توسط کارهای قبلی پیشی میگیرد.

- کاهش در معماری های خاص وظیفه

BERT نشان میدهد که نمایشهای از قبل آموزشدیده شده نیاز به معماریهای ویژه کار با مهندسی شده را کاهش میدهند. این اولین مدل نمایش مبتنی بر تنظیم دقیق است که به عملکرد پیشرفتهای در طیف متنوعی از وظایف سطح جمله و سطح نشانه دست مییابد و از معماریهای خاص کار بهتر عمل میکند.

- پیشرفت های پیشرفته

BERT در یازده وظیفه پردازش زبان طبیعی به نتایج پیشرفته جدیدی دست می یابد و تطبیق پذیری خود را به نمایش می گذارد. پیشرفت های قابل توجه شامل افزایش قابل توجه امتیاز GLUE، دقت MultiNLI و پیشرفت در وظایف پاسخگویی به پرسش SQuAD v1.1 و v2.0 است.

شما همچنین می توانید بخوانید: تنظیم دقیق BERT با مدل سازی زبان نقاب دار

مقاله 3: GPT: مدل های زبان یادگیرندگان کمی هستند

ارتباط دادن: اینجا را بخوانید

خلاصه مقاله

این مقاله پیشرفتهایی را که در وظایف پردازش زبان طبیعی (NLP) با مقیاسگذاری مدلهای زبان، با تمرکز بر GPT-3 (Generative Pre-trained Transformer 3)، یک مدل زبان اتورگرسیو با 175 میلیارد پارامتر. نویسندگان تاکید می کنند که در حالی که اخیرا است مدل های NLP دستاوردهای قابل توجهی را از طریق پیشآموزش و تنظیم دقیق نشان میدهند، آنها اغلب به مجموعه دادههای ویژه وظایف با هزاران مثال برای تنظیم دقیق نیاز دارند. در مقابل، انسان ها می توانند وظایف زبانی جدیدی را با چند مثال یا دستورالعمل های ساده انجام دهند.

بینش های کلیدی مقالات هوش مصنوعی برای توسعه دهندگان GenAI

- افزایش مقیاس عملکرد چند شات را بهبود می بخشد

نویسندگان نشان میدهند که بزرگکردن مدلهای زبان بهطور قابلتوجهی عملکرد ناشناخته تکلیفی را افزایش میدهد. GPT-3، با اندازه پارامتر بزرگ خود، گاهی اوقات با رویکردهای پیشرفته تنظیم دقیق بدون تنظیم دقیق یا به روز رسانی گرادیان، به رقابت می رسد.

- کاربرد گسترده

GPT-3 عملکرد قوی را در وظایف مختلف NLP از جمله ترجمه، پاسخگویی به سؤال، کارهای بسته، و کارهایی که نیاز به استدلال در جریان یا تطبیق دامنه دارند، نشان می دهد. - چالش ها و محدودیت ها

در حالی که GPT-3 قابلیتهای یادگیری چند شات قابلتوجهی را نشان میدهد، نویسندگان مجموعههای داده را در جایی که مشکل دارد شناسایی میکنند و مسائل روششناختی مربوط به آموزش در مجموعههای وب بزرگ را برجسته میکنند. - نسل مقاله شبیه انسان

GPT-3 میتواند مقالات خبری تولید کند که ارزیابیکنندگان انسانی تشخیص آنها را از مقالات نوشته شده توسط انسان دشوار میدانند. - تأثیرات اجتماعی و ملاحظات گسترده تر

این مقاله تأثیرات اجتماعی گستردهتر قابلیتهای GPT-3، بهویژه در تولید متن شبیه انسان را مورد بحث قرار میدهد. پیامدهای عملکرد آن در وظایف مختلف از نظر کاربردهای عملی و چالش های بالقوه در نظر گرفته می شود. - محدودیت های رویکردهای فعلی NLP

نویسندگان محدودیتهای رویکردهای NLP کنونی، بهویژه تکیه آنها به مجموعه دادههای تنظیم دقیق کار خاص را برجسته میکنند، که چالشهایی مانند نیاز به مجموعه دادههای برچسبگذاری شده بزرگ و خطر تطبیق بیش از حد برای توزیعهای کار باریک را ایجاد میکند. علاوه بر این، نگرانیهایی در مورد توانایی تعمیم این مدلها در خارج از محدوده توزیع آموزشی آنها ایجاد میشود.

مقاله 4: CNN: طبقه بندی ImageNet با شبکه های عصبی کانولوشن عمیق

ارتباط دادن: اینجا را بخوانید

خلاصه مقاله

این مقاله توسعه و آموزش یک شبکه عصبی پیچیده و عمیق (CNN) را برای طبقهبندی تصویر در مجموعه دادههای چالش تشخیص تصویری مقیاس بزرگ ImageNet (ILSVRC) توصیف میکند. این مدل در مقایسه با روشهای پیشرفته قبلی پیشرفتهای قابلتوجهی در دقت طبقهبندی دارد.

بینش های کلیدی مقالات هوش مصنوعی برای توسعه دهندگان GenAI

- معماری مدل

شبکه عصبی مورد استفاده در این مطالعه یک CNN عمیق با 60 میلیون پارامتر و 650,000 نورون است. این شامل پنج لایه کانولوشن، برخی به دنبال لایههای max-pooling، و سه لایه کاملاً متصل با یک نرمافزار 1000 جهته نهایی برای طبقهبندی است.

- داده های آموزش

این مدل بر روی مجموعه داده قابل توجهی از 1.2 میلیون تصویر با وضوح بالا از مسابقه ImageNet ILSVRC-2010 آموزش داده شده است. فرآیند آموزش شامل طبقه بندی تصاویر به 1000 کلاس مختلف است.

- عملکرد

این مدل در دادههای آزمایشی به ترتیب به نرخهای خطای 1 و 5 برتر 37.5% و 17.0% دست مییابد. این نرخ های خطا به طور قابل توجهی بهتر از آخرین حالت قبلی است، که نشان دهنده اثربخشی رویکرد پیشنهادی است.

- بهبود در Overfitting

این مقاله چندین تکنیک را برای رسیدگی به مسائل بیش از حد برازش معرفی میکند، از جمله نورونهای غیراشباع، پیادهسازی GPU کارآمد برای آموزش سریعتر، و یک روش منظمسازی به نام «افتاده» در لایههای کاملاً متصل. - کارایی محاسباتی

علیرغم نیازهای محاسباتی آموزش CNNهای بزرگ، این مقاله خاطرنشان میکند که GPUهای فعلی و پیادهسازیهای بهینهشده، آموزش چنین مدلهایی را بر روی تصاویر با وضوح بالا امکانپذیر میسازد.

- مشارکتها

این مقاله مشارکت های این مطالعه را برجسته می کند، از جمله آموزش یکی از بزرگترین شبکه های عصبی کانولوشنال بر روی مجموعه داده های ImageNet و دستیابی به نتایج پیشرفته در مسابقات ILSVRC.

شما همچنین می توانید بخوانید: یک آموزش جامع برای یادگیری شبکه های عصبی کانولوشن

مقاله 5: GATs: Graph Attention Networks

ارتباط دادن: اینجا را بخوانید

خلاصه مقاله

این مقاله یک معماری مبتنی بر توجه را برای طبقهبندی گره در دادههای ساختاریافته معرفی میکند و کارایی، تطبیق پذیری و عملکرد رقابتی آن را در معیارهای مختلف نشان میدهد. ادغام مکانیسم های توجه ابزار قدرتمندی برای مدیریت نمودارهای ساختار یافته دلخواه است.

بینش های کلیدی مقالات هوش مصنوعی برای توسعه دهندگان GenAI

- شبکه های توجه نمودار (GAT)GATها از لایههای خودتوجهی پوشانده استفاده میکنند تا محدودیتهای روشهای قبلی بر اساس پیچیدگی نمودارها را برطرف کنند. این معماری به گرهها اجازه میدهد تا بر روی ویژگیهای همسایگی خود حضور داشته باشند، به طور ضمنی وزنهای مختلف را برای گرههای مختلف بدون تکیه بر عملیات ماتریس پرهزینه یا دانش پیشینی از ساختار نمودار مشخص میکنند.

- پرداختن به چالش های مبتنی بر طیف

GAT ها به طور همزمان چندین چالش را در شبکه های عصبی گراف طیفی حل می کنند. چالشهای شبکه توجه نمودار (GAT) شامل فیلترهای محلی، محاسبات شدید و فیلترهای غیرمکانی شده است. علاوه بر این، GATها به پایه ویژه لاپلاسی بستگی دارند، که به کاربرد آنها در مسائل القایی و انتقالی کمک می کند.

- عملکرد در بین معیارها

مدلهای GAT به نتایج پیشرفتهای در چهار معیار گراف ثابت میرسند یا مطابقت دارند: مجموعه دادههای شبکه استنادی Cora، Citeseer، و Pubmed، و همچنین مجموعه دادههای تعامل پروتئین-پروتئین. این معیارها سناریوهای یادگیری انتقالی و استقرایی را پوشش می دهند و تطبیق پذیری GAT ها را نشان می دهند.

- مقایسه با رویکردهای قبلی

این مقاله مروری جامع از رویکردهای قبلی، از جمله شبکههای عصبی بازگشتی، ارائه میکند. شبکه های عصبی نموداری (GNN)، روش های طیفی و غیر طیفی و مکانیسم های توجه. GATها مکانیسمهای توجهی را در خود جای دادهاند که امکان موازیسازی کارآمد را در جفتهای گره-همسایه و کاربرد در گرههایی با درجات مختلف فراهم میکنند.

- کارایی و کاربردGAT ها یک عملیات موازی پذیر و کارآمد را ارائه می دهند که می تواند برای گره های گراف با درجات مختلف با تعیین وزن های دلخواه برای همسایگان اعمال شود. این مدل مستقیماً برای مسائل یادگیری استقرایی اعمال میشود، و آن را برای کارهایی مناسب میکند که نیاز به تعمیم به نمودارهای کاملاً نامعلوم دارد.

- ارتباط با مدل های قبلی

نویسندگان خاطرنشان میکنند که GATها را میتوان بهعنوان یک نمونه خاص از MoNet دوباره فرمولبندی کرد، شباهتهایی را با شبکههای رابطهای به اشتراک گذاشت و به کارهایی متصل شد که از عملیات توجه همسایگی استفاده میکنند. مدل توجه پیشنهادی با رویکردهای مرتبط مانند Duan و همکاران مقایسه شده است. (2017) و دنیل و همکاران. (2017).

مقاله 6: ViT: یک تصویر ارزش 16×16 کلمه دارد: ترانسفورماتور برای تشخیص تصویر در مقیاس

ارتباط دادن: اینجا را بخوانید

خلاصه مقاله

این مقاله تسلط معماریهای کانولوشن را در بینایی کامپیوتر علیرغم موفقیت معماریهای ترانسفورماتور در پردازش زبان طبیعی تأیید میکند. با الهام از کارایی و مقیاس پذیری ترانسفورماتورها در NLP، نویسندگان یک ترانسفورماتور استاندارد را مستقیماً با حداقل تغییرات روی تصاویر اعمال کردند.

را معرفی می کنند Vision Transformer (ViT)، که در آن تصاویر به تکههایی تقسیم میشوند و دنباله جاسازیهای خطی این وصلهها به عنوان ورودی ترانسفورماتور عمل میکند. این مدل بر روی وظایف طبقه بندی تصویر به شیوه ای نظارت شده آموزش دیده است. در ابتدا، هنگامی که بر روی مجموعه دادههای با اندازه متوسط مانند ImageNet بدون منظمسازی قوی آموزش داده میشود، ViT به دقت کمی کمتر از ResNetهای قابل مقایسه دست مییابد.

با این حال، نویسندگان نشان میدهند که آموزش در مقیاس بزرگ برای موفقیت ViT بسیار مهم است و از محدودیتهای تحمیلشده به دلیل عدم وجود تعصبات استقرایی خاص فراتر میرود. هنگامی که ViT روی مجموعه داده های عظیم از قبل آموزش داده می شود، از شبکه های کانولوشنال پیشرفته در معیارهای متعدد، از جمله ImageNet، CIFAR-100 و VTAB، بهتر عمل می کند. این مقاله بر تاثیر مقیاس گذاری در دستیابی به نتایج قابل توجه با معماری ترانسفورماتور در بینایی کامپیوتر تاکید می کند.

بینش های کلیدی مقالات هوش مصنوعی برای توسعه دهندگان GenAI

- ترانسفورماتور در بینایی کامپیوتر

این مقاله اتکای غالب به شبکههای عصبی کانولوشنال (CNN) برای وظایف بینایی رایانه را به چالش میکشد. این نشان میدهد که یک ترانسفورماتور خالص، زمانی که مستقیماً به دنبالهای از وصلههای تصویر اعمال شود، میتواند به عملکرد عالی در وظایف طبقهبندی تصویر دست یابد.

- Vision Transformer (ViT)

نویسندگان Vision Transformer (ViT) را معرفی می کنند، مدلی که از مکانیسم های خودتوجهی مشابه ترانسفورماتورها در NLP استفاده می کند. ViT می تواند به نتایج رقابتی در معیارهای مختلف تشخیص تصویر، از جمله ImageNet، CIFAR-100، و VTAB دست یابد.

- پیش آموزش و آموزش انتقالی

این مقاله بر اهمیت پیشآموزش بر روی مقادیر زیاد داده، مشابه رویکرد NLP، و سپس انتقال بازنماییهای آموختهشده به وظایف خاص تشخیص تصویر تأکید میکند. وقتی ViT روی مجموعه داده های عظیمی مانند ImageNet-21k یا JFT-300M از قبل آموزش داده شود، از شبکه های پیچیده پیشرفته در معیارهای مختلف بهتر عمل می کند.

- کارایی محاسباتیViT با منابع محاسباتی بسیار کمتری در طول آموزش به نتایج قابل توجهی دست می یابد شبکه های کانولوشن پیشرفته این کارایی به ویژه زمانی قابل توجه است که مدل در مقیاس بزرگ از قبل آموزش داده شده باشد.

- تاثیر پوسته پوسته شدن

این مقاله اهمیت مقیاسپذیری را در دستیابی به عملکرد برتر با معماریهای ترانسفورماتور در بینایی کامپیوتر برجسته میکند. آموزش در مقیاس بزرگ در مجموعه دادههای حاوی میلیونها تا صدها میلیون تصویر به ViT کمک میکند بر فقدان برخی سوگیریهای القایی موجود در CNN غلبه کند.

مقاله 7: AlphaFold2: ساختار پروتئین بسیار دقیق با AlphaFold

ارتباط دادن: اینجا را بخوانید

خلاصه مقاله

مقاله "AlphaFold2: ساختار پروتئین بسیار دقیق با AlphaFold" AlphaFold2 را معرفی می کند، یک مدل یادگیری عمیق که به طور دقیق ساختارهای پروتئین را پیش بینی می کند. AlphaFold2 از معماری جدید مبتنی بر توجه بهره می برد و به پیشرفتی در تاکردن پروتئین دست می یابد.

بینش های کلیدی مقالات هوش مصنوعی برای توسعه دهندگان GenAI

- AlphaFold2 از یک شبکه عصبی عمیق با مکانیسم های توجه برای پیش بینی ساختار سه بعدی پروتئین ها از توالی های اسید آمینه آنها استفاده می کند.

- این مدل بر روی مجموعه داده بزرگی از ساختارهای پروتئینی شناخته شده آموزش داده شد و به دقت بیسابقهای در چهاردهمین مسابقه تاخوردگی پروتئین پیشبینی ساختار پروتئین (CASP14) دست یافت.

- پیشبینیهای دقیق AlphaFold2 میتواند به طور بالقوه انقلابی در کشف دارو، مهندسی پروتئین و سایر زمینههای بیوشیمی ایجاد کند.

مقاله 8: GANs: Generative Adversarial Networks

ارتباط دادن: اینجا را بخوانید

خلاصه مقاله

این مقاله به چالشهای موجود در آموزش مدلهای مولد عمیق میپردازد و رویکردی نوآورانه به نام شبکههای متخاصم را معرفی میکند. در این چارچوب، مدلهای مولد و افتراقی در یک بازی شرکت میکنند که در آن مدل مولد با هدف تولید نمونههایی غیرقابل تشخیص از دادههای واقعی است. در مقابل، مدل تمایز بین نمونه های واقعی و تولید شده تمایز قائل می شود. فرآیند آموزش خصمانه منجر به یک راه حل منحصر به فرد می شود، با مدل تولیدی که توزیع داده ها را بازیابی می کند.

بینش های کلیدی مقالات هوش مصنوعی برای توسعه دهندگان GenAI

- چارچوب خصمانه

نویسندگان یک چارچوب متخاصم را معرفی میکنند که در آن دو مدل به طور همزمان آموزش داده میشوند - یک مدل تولیدی (G) که توزیع دادهها را در بر میگیرد و یک مدل افتراقی (D) که احتمال اینکه یک نمونه از دادههای آموزشی بهجای مدل تولیدی آمده را تخمین بزند.

- بازی Minimaxروش آموزش شامل به حداکثر رساندن احتمال اشتباه مدل افتراقی است. این چارچوب بهعنوان یک بازی دو نفره مینیمکس فرمولبندی میشود، که در آن مدل تولیدی با هدف تولید نمونههایی غیرقابل تشخیص از دادههای واقعی، و مدل متمایز با هدف طبقهبندی اینکه آیا یک نمونه واقعی است یا درست تولید شده است.

- راه حل منحصر به فرد

یک راه حل منحصر به فرد در توابع دلخواه برای G و D وجود دارد که G توزیع داده های آموزشی را بازیابی می کند و D در همه جا برابر با 1/2 است. این تعادل از طریق فرآیند آموزش خصمانه حاصل می شود.

- پرسپترون های چند لایه (MLP)نویسندگان نشان میدهند که کل سیستم را میتوان با استفاده از انتشار پسزمینه زمانی که پرسپترونهای چندلایه نشاندهنده G و D هستند آموزش داد.

- بدون استنباط تقریبی

چارچوب پیشنهادی از مشکلات تقریب محاسبات احتمالی غیرقابل حل در برآورد حداکثر احتمال اجتناب می کند. همچنین بر چالشها در استفاده از مزایای واحدهای خطی تکهای در زمینه تولیدی غلبه میکند.

مقاله 9: RoBERTa: یک رویکرد پیشآموزشی BERT بهینه شده قوی

ارتباط دادن: اینجا را بخوانید

خلاصه مقاله

این مقاله به مشکل کمآموزی BERT میپردازد و RoBERTa را معرفی میکند، نسخه بهینهشدهای که از عملکرد BERT پیشی میگیرد. تغییرات در روش آموزشی RoBERTa و استفاده از یک مجموعه داده جدید (CC-NEWS) به نتایج پیشرفته در چندین وظایف پردازش زبان طبیعی کمک می کند. یافتهها بر اهمیت انتخابهای طراحی و استراتژیهای آموزشی در اثربخشی پیشآموزش مدل زبان تأکید میکنند. منابع منتشر شده، از جمله مدل و کد RoBERTa، به جامعه تحقیقاتی کمک می کند.

بینش های کلیدی مقالات هوش مصنوعی برای توسعه دهندگان GenAI

- پیش تمرینی BERT

نویسندگان آن را می یابند برت، یک مدل زبانی که به طور گسترده مورد استفاده قرار می گیرد، به طور قابل توجهی آموزش دیده بود. با ارزیابی دقیق تأثیر تنظیم هایپرپارامتر و اندازه مجموعه آموزشی، آنها نشان می دهند که BERT را می توان بهبود بخشید تا با عملکرد همه مدل های منتشر شده پس از آن مطابقت داشته باشد یا از آن فراتر رود.

- دستور العمل آموزشی بهبود یافته (RoBERTa)

نویسندگان تغییراتی را در روش آموزشی BERT ارائه میکنند و RoBERTa را به دست میآورند. این تغییرات شامل دورههای تمرینی طولانیتر با دستههای بزرگتر، حذف هدف پیشبینی جمله بعدی، آموزش در توالیهای طولانیتر و تنظیمات الگوی پوشش پویا برای دادههای آموزشی است.

- کمک مجموعه دادهاین مقاله مجموعه داده جدیدی به نام CC-NEWS را معرفی می کند که از نظر اندازه با سایر مجموعه داده های مورد استفاده خصوصی قابل مقایسه است. گنجاندن این مجموعه داده به کنترل بهتر اثرات اندازه مجموعه آموزشی کمک می کند و به بهبود عملکرد در کارهای پایین دستی کمک می کند.

- دستاوردهای عملکرد

RoBERTa، با تغییرات پیشنهادی، به نتایج پیشرفتهای در کارهای معیارهای مختلف، از جمله GLUE، RACE، و SQuAD دست مییابد. این با عملکرد تمام روشهای پس از BERT در کارهایی مانند MNLI، QNLI، RTE، STS-B، SQuAD و RACE مطابقت دارد یا از آن فراتر میرود.

- رقابتپذیری پیشآموزش مدل زبان نقابدار

این مقاله مجدداً تأیید میکند که هدف پیشآموزشی مدل زبان نقابدار، با انتخابهای طراحی درست، با سایر اهداف آموزشی اخیراً پیشنهاد شده رقابتی است.

- منابع منتشر شده

نویسندگان مدل RoBERTa خود را به همراه کدهای پیشآموزشی و تنظیم دقیق پیادهسازی شده در PyTorch منتشر کردند که به تکرارپذیری و کاوش بیشتر یافتههای خود کمک میکند.

همچنین خواندن: مقدمه ای ملایم برای RoBERTa

مقاله 10: NeRF: نمایش صحنهها بهعنوان میدانهای تابشی عصبی برای سنتز نمایش

ارتباط دادن: اینجا را بخوانید

خلاصه مقاله

بهینه سازی شامل به حداقل رساندن خطا بین تصاویر مشاهده شده با موقعیت های شناخته شده دوربین و نماهای ارائه شده از نمایش صحنه پیوسته است. این مقاله چالشهای مربوط به همگرایی و کارایی را با معرفی رمزگذاری موقعیتی برای رسیدگی به توابع فرکانس بالاتر و پیشنهاد یک روش نمونهگیری سلسله مراتبی برای کاهش تعداد پرسوجوهای مورد نیاز برای نمونهگیری کافی، بررسی میکند.

بینش های کلیدی مقالات هوش مصنوعی برای توسعه دهندگان GenAI

- بازنمایی صحنه پیوسته

این مقاله روشی را برای نمایش صحنههای پیچیده به عنوان میدانهای تابشی عصبی ۵ بعدی با استفاده از شبکههای پرسپترون چندلایه (MLP) ارائه میکند.

- رندر متفاوت

روش رندر پیشنهادی مبتنی بر تکنیکهای رندر حجمی کلاسیک است که امکان بهینهسازی مبتنی بر گرادیان را با استفاده از تصاویر استاندارد RGB فراهم میکند.

- استراتژی نمونه گیری سلسله مراتبی

یک استراتژی نمونهگیری سلسله مراتبی برای بهینهسازی ظرفیت MLP به سمت مناطقی با محتوای صحنه قابل مشاهده، با پرداختن به مسائل همگرایی معرفی شده است.

- رمزگذاری موقعیتیاستفاده از رمزگذاری موقعیتی برای نگاشت مختصات ورودی 5 بعدی در فضایی با ابعاد بالاتر، بهینه سازی موفقیت آمیز میدان های تابشی عصبی را برای محتوای صحنه با فرکانس بالا امکان پذیر می کند.

روش پیشنهادی از روشهای سنتز نمای پیشرفته، از جمله برازش نمایشهای سه بعدی عصبی و آموزش شبکههای کانولوشنی عمیق، پیشی میگیرد. این مقاله یک نمایش صحنه عصبی پیوسته را برای ارائه نماهای جدید فوتورئالیستی با وضوح بالا از تصاویر RGB در تنظیمات طبیعی معرفی میکند، با مقایسههای اضافی که در ویدیوی تکمیلی به نمایش گذاشته میشود تا اثربخشی آن در رسیدگی به هندسه و ظاهر صحنه پیچیده را برجسته کند.

مقاله 11: FunSearch: اکتشافات ریاضی از جستجوی برنامه با مدل های زبان بزرگ

ارتباط دادن: اینجا را بخوانید

خلاصه مقاله

این مقاله FunSearch را معرفی میکند، یک رویکرد جدید برای استفاده از مدلهای زبان بزرگ (LLM) برای حل مشکلات پیچیده، بهویژه در اکتشافات علمی. چالش اولیه ای که به آن پرداخته شده، وقوع توهمات (توهمات) در LLM ها است که منجر به اظهارات قابل قبول اما نادرست می شود. FunSearch یک LLM از پیش آموزش دیده را با یک ارزیاب سیستماتیک در یک روش تکاملی ترکیب می کند تا بر این محدودیت غلبه کند.

بینش های کلیدی مقالات هوش مصنوعی برای توسعه دهندگان GenAI

- حل مسئله با LLM

این مقاله به این موضوع میپردازد که LLMها در ایجاد ایدههای جدید و راهحلهای صحیح برای مسائل پیچیده ناکام هستند. این بر اهمیت یافتن ایده های جدید و قابل تأیید صحیح، به ویژه برای چالش های ریاضی و علمی تأکید می کند.

- رویه تکاملی - FunSearch

FunSearch یک LLM از پیش آموزش دیده را با یک ارزیاب در یک فرآیند تکاملی ترکیب می کند. این برنامه به طور مکرر برنامه های کم امتیاز را به برنامه هایی با امتیاز بالا تبدیل می کند و کشف دانش جدید را تضمین می کند. این فرآیند شامل اعلان بهترین عکس، اسکلت های برنامه در حال تکامل، حفظ تنوع برنامه و مقیاس بندی ناهمزمان است.

- کاربرد در ترکیبات اکستریمال

این مقاله اثربخشی FunSearch را بر روی مشکل مجموعه کلاهی در ترکیبهای اکسترمال نشان میدهد. FunSearch ساختارهای جدیدی از مجموعههای کلاهک بزرگ را کشف میکند، که از بهترین نتایج شناختهشده پیشی میگیرد و بیشترین پیشرفت را در 20 سال اخیر در کران پایین مجانبی ایجاد میکند.

- مسئله الگوریتمی – بسته بندی سطل آنلاین

FunSearch برای مشکل بسته بندی سطل آنلاین اعمال می شود و منجر به کشف الگوریتم های جدیدی می شود که در توزیع های مورد علاقه به خوبی مطالعه شده از الگوریتم های سنتی بهتر عمل می کنند. کاربردهای بالقوه شامل بهبود الگوریتم های زمان بندی کار است.

- برنامه ها در مقابل راه حل هاFunSearch بر تولید برنامههایی تمرکز میکند که نحوه حل یک مشکل را بهجای خروج مستقیم راهحلها توصیف میکنند. این برنامهها بیشتر قابل تفسیر هستند، تعامل با متخصصان حوزه را تسهیل میکنند و نسبت به سایر انواع توصیفها، مانند شبکههای عصبی، آسانتر به کار میروند.

- تاثیر میان رشته ای

روش FunSearch امکان کاوش در طیف گسترده ای از مشکلات را فراهم می کند و آن را به یک رویکرد همه کاره با کاربردهای بین رشته ای تبدیل می کند. این مقاله پتانسیل خود را برای ایجاد اکتشافات علمی قابل تأیید با استفاده از LLM ها نشان می دهد.

مقاله 12: VAEs: Auto-Encoding Variational Bayes

ارتباط دادن: اینجا را بخوانید

خلاصه مقاله

مقاله "Auto-Encoding Variational Bayes" به چالش استنتاج و یادگیری کارآمد در مدل های احتمالی جهت دار با متغیرهای پنهان پیوسته می پردازد، به ویژه زمانی که توزیع های خلفی غیرقابل حل هستند و با مجموعه داده های بزرگ سروکار دارند. نویسندگان یک الگوریتم استنتاج تغییرات تصادفی و یادگیری را پیشنهاد میکنند که به خوبی برای مجموعههای داده بزرگ مقیاس میشود و حتی در توزیعهای غیرقابل تحمل پسین نیز قابل استفاده است.

بینش های کلیدی مقالات هوش مصنوعی برای توسعه دهندگان GenAI

- پارامترسازی مجدد کران پایینی متغیر

این مقاله یک پارامتر مجدد از کران پایینی متغیر را نشان میدهد که منجر به تخمینگر کران پایینتر میشود. این برآوردگر با استفاده از روشهای گرادیان تصادفی استاندارد قابل بهینهسازی است و از نظر محاسباتی کارآمد است.

- استنتاج خلفی کارآمد برای متغیرهای پنهان پیوستهنویسندگان الگوریتم رمزگذاری خودکار VB (AEVB) را برای مجموعههای داده با متغیرهای پنهان پیوسته در هر نقطه داده پیشنهاد میکنند. این الگوریتم از تخمینگر خلیجهای متغیر گرادیان تصادفی (SGVB) برای بهینهسازی یک مدل شناسایی استفاده میکند و استنتاج پسینی کارآمد را از طریق نمونهگیری اجدادی امکانپذیر میسازد. این رویکرد از طرحهای استنتاج تکراری گران قیمت مانند مونت کارلو زنجیره مارکوف (MCMC) برای هر نقطه داده اجتناب میکند.

- مزایای نظری و نتایج تجربی

مزایای نظری روش پیشنهادی در نتایج تجربی منعکس شده است. این مقاله پیشنهاد میکند که مدل پارامترسازی و شناسایی مجدد منجر به کارایی محاسباتی و مقیاسپذیری میشود، و این رویکرد را برای مجموعههای داده بزرگ و در موقعیتهایی که پسین غیرقابل تحمل است، قابل اجرا میکند.

همچنین بخوانید: رونمایی از ماهیت Stochastic در یادگیری ماشین

مقاله 13: حافظه کوتاه مدت بلند مدت

ارتباط دادن: اینجا را بخوانید

خلاصه مقاله

این مقاله به چالش یادگیری ذخیره اطلاعات در بازه های زمانی طولانی در شبکه های عصبی مکرر می پردازد. این یک روش جدید و کارآمد مبتنی بر گرادیان به نام "حافظه کوتاه مدت بلند مدت" (LSTM) را معرفی می کند که بر مشکلات جریان برگشت خطای ناکافی و رو به زوال غلبه می کند. LSTM جریان خطای ثابت را از طریق "چرخ و فلک های خطای ثابت" اعمال می کند و از واحدهای دروازه ضربی برای کنترل دسترسی استفاده می کند. با پیچیدگی مکان-زمان محلی (O(1) در هر گام زمانی و وزن)، نتایج تجربی نشان میدهد که LSTM از الگوریتمهای موجود در مورد سرعت یادگیری و میزان موفقیت، بهویژه برای کارهایی با تاخیر زمانی طولانی، بهتر عمل میکند.

بینش های کلیدی مقالات هوش مصنوعی برای توسعه دهندگان GenAI

- تحلیل مسئله

این مقاله تجزیه و تحلیل دقیقی از چالشهای مرتبط با جریان برگشتی خطا در شبکههای عصبی مکرر ارائه میکند و مسائل مربوط به انفجار یا ناپدید شدن سیگنالهای خطا در طول زمان را برجسته میکند.

- معرفی LSTM

نویسندگان LSTM را به عنوان یک معماری جدید معرفی می کنند که برای رسیدگی به مشکلات ناپدید شدن و انفجار سیگنال های خطا طراحی شده است. LSTM جریان خطای ثابت را از طریق واحدهای تخصصی ترکیب می کند و از واحدهای دروازه ضربی برای تنظیم دسترسی به این جریان خطا استفاده می کند.

- نتایج تجربی

از طریق آزمایشهایی با دادههای مصنوعی، این مقاله نشان میدهد که LSTM از سایر الگوریتمهای شبکه تکرارشونده، از جمله BPTT، RTRL، همبستگی آبشاری تکراری، شبکههای المان، و قطعهسازی توالی عصبی بهتر عمل میکند. LSTM یادگیری سریعتر و نرخ موفقیت بالاتر را نشان می دهد، به ویژه در حل وظایف پیچیده با تاخیرهای طولانی.

- محلی در فضا و زمان

LSTM به عنوان یک معماری محلی در فضا و زمان، با پیچیدگی محاسباتی در هر مرحله زمانی و وزن O(1) توصیف میشود.

- قابل اجرا بودن

معماری LSTM پیشنهادی به طور موثر وظایف پیچیده و مصنوعی تاخیر طولانی مدت را حل می کند که با موفقیت توسط الگوریتم های شبکه تکراری قبلی برطرف نشده است.

- محدودیت ها و مزایا

این مقاله محدودیتها و مزایای LSTM را مورد بحث قرار میدهد و بینشهایی در مورد کاربرد عملی معماری پیشنهادی ارائه میدهد.

همچنین بخوانید: LSTM چیست؟ مقدمه ای بر حافظه کوتاه مدت

مقاله 14: یادگیری مدل های بصری قابل انتقال از طریق نظارت زبان طبیعی

ارتباط دادن: اینجا را بخوانید

خلاصه مقاله

این مقاله آموزش سیستمهای بینایی کامپیوتری پیشرفته را با یادگیری مستقیم از متن خام در مورد تصاویر به جای تکیه بر مجموعههای ثابت از دستههای اشیاء از پیش تعیینشده بررسی میکند. نویسندگان با استفاده از مجموعه دادهای متشکل از 400 میلیون جفت (تصویر، متن) جمعآوریشده از اینترنت، یک کار پیشآموزشی برای پیشبینی اینکه کدام عنوان با یک تصویر مشخص مطابقت دارد، پیشنهاد میکنند. مدل حاصل، CLIP (Contrastive Language-Image Pre-training)، یادگیری کارآمد و مقیاس پذیر بازنمایی تصویر را نشان می دهد. پس از پیش آموزش، زبان طبیعی به مفاهیم بصری ارجاع می دهد و امکان انتقال شات صفر به وظایف مختلف پایین دست را فراهم می کند. CLIP بر روی بیش از 30 مجموعه داده بینایی کامپیوتری محک زده شده است، که عملکرد رقابتی را بدون آموزش کار خاص به نمایش می گذارد.

بینش های کلیدی مقالات هوش مصنوعی برای توسعه دهندگان GenAI

- آموزش زبان طبیعی برای بینایی کامپیوتر

این مقاله به بررسی استفاده از نظارت زبان طبیعی برای آموزش مدلهای بینایی رایانهای به جای رویکرد آموزشی سنتی بر روی مجموعه دادههای برچسبگذاری شده جمعی مانند ImageNet میپردازد.

- وظیفه قبل از آموزشنویسندگان یک کار ساده پیش از آموزش را پیشنهاد می کنند: پیش بینی اینکه کدام عنوان با یک تصویر مشخص مطابقت دارد. این کار برای یادگیری نمایش های تصویری پیشرفته از ابتدا در مجموعه داده عظیمی از 400 میلیون جفت (تصویر، متن) جمع آوری شده به صورت آنلاین استفاده می شود.

- انتقال صفر شات

پس از پیش آموزش، مدل از زبان طبیعی برای ارجاع به مفاهیم بصری آموخته شده یا توصیف مفاهیم جدید استفاده می کند. این امکان انتقال صفر مدل را به وظایف پایین دستی بدون نیاز به آموزش داده خاص را فراهم می کند.

- محک زدن بر روی وظایف مختلف

این مقاله عملکرد رویکرد پیشنهادی را بر روی بیش از 30 مجموعه داده بینایی کامپیوتری مختلف ارزیابی میکند که وظایفی مانند OCR، تشخیص عمل در ویدئوها، مکانیابی جغرافیایی و طبقهبندی اشیاء ریز دانه را پوشش میدهد.

- عملکرد رقابتی

این مدل عملکرد رقابتی را با خطوط پایه کاملاً نظارت شده در وظایف مختلف نشان میدهد، که اغلب با دقت مدلهای آموزشدیده شده بر روی مجموعه دادههای خاص کار بدون آموزش خاص مجموعه داده اضافی مطابقت دارد یا از آن فراتر میرود.

- مطالعه مقیاس پذیری

نویسندگان مقیاس پذیری رویکرد خود را با آموزش مجموعه ای از هشت مدل با سطوح مختلف منابع محاسباتی مطالعه می کنند. عملکرد انتقال یک تابع کاملاً قابل پیشبینی از محاسبات است.

- استحکام مدل

این مقاله تاکید میکند که مدلهای CLIP شات صفر قویتر از مدلهای ImageNet نظارتشده با دقت معادل هستند، و نشان میدهد که ارزیابی صفر شات مدلهای تکلیف-آگنوستیک معیاری نمایندهتر از قابلیت یک مدل را ارائه میدهد.

مقاله 15: LORA: سازگاری با رتبه پایین مدل های زبان بزرگ

ارتباط دادن: اینجا را بخوانید

خلاصه مقاله

این مقاله LoRA را بهعنوان روشی کارآمد برای تطبیق مدلهای بزرگ زبان از پیش آموزشدیده با وظایف خاص، پرداختن به چالشهای استقرار مرتبط با افزایش اندازه آنها پیشنهاد میکند. این روش به طور قابل ملاحظه ای پارامترهای قابل آموزش و نیازهای حافظه GPU را کاهش می دهد و در عین حال کیفیت مدل را در معیارهای مختلف حفظ یا بهبود می بخشد. پیادهسازی منبع باز پذیرش LoRA را در کاربردهای عملی تسهیل میکند.

بینش های کلیدی مقالات هوش مصنوعی برای توسعه دهندگان GenAI

1. بیان مسأله

- پیشآموزش در مقیاس بزرگ و به دنبال آن تنظیم دقیق یک رویکرد رایج در پردازش زبان طبیعی است.

- با بزرگتر شدن مدلها، تنظیم دقیق کمتر امکانپذیر میشود، بهویژه هنگام استقرار مدلهایی با پارامترهای عظیم، مانند GPT-3 (175 میلیارد پارامتر).

2. راه حل پیشنهادی: سازگاری با رتبه پایین (LoRA)

- این مقاله LoRA را معرفی میکند، روشی که وزنهای مدل از پیش آموزش دیده را منجمد میکند و ماتریسهای تجزیه رتبه قابل آموزش را در هر لایه از معماری ترانسفورماتور معرفی میکند.

- LoRA به طور قابل توجهی تعداد پارامترهای قابل آموزش را برای کارهای پایین دستی در مقایسه با تنظیم دقیق کامل کاهش می دهد.

3. مزایای LoRA

- کاهش پارامتر: در مقایسه با تنظیم دقیق، LoRA می تواند تعداد پارامترهای قابل آموزش را تا 10,000 بار کاهش دهد و از نظر محاسباتی کارآمدتر شود.

- کارایی حافظه: LoRA نیاز به حافظه GPU را تا 3 برابر در مقایسه با تنظیم دقیق کاهش می دهد.

- کیفیت مدل: با وجود داشتن پارامترهای آموزش پذیر کمتر، LoRA از نظر کیفیت مدل در مدل های مختلف از جمله RoBERTa، DeBERTa، GPT-2 و GPT-3 برابر یا بهتر از تنظیم دقیق عمل می کند.

4. غلبه بر چالش های استقرار

- این مقاله با معرفی LoRA به چالش استقرار مدلهایی با پارامترهای زیادی میپردازد که امکان تعویض کارآمد بدون آموزش مجدد کل مدل را فراهم میکند.

5. کارایی و تأخیر استنتاج کم

- LoRA به اشتراک گذاری یک مدل از پیش آموزش دیده را برای ساخت چندین ماژول LoRA برای کارهای مختلف، کاهش نیازهای ذخیره سازی و سربار تعویض وظیفه تسهیل می کند.

- هنگام استفاده از بهینه سازهای تطبیقی، آموزش کارآمدتر می شود و مانع ورود سخت افزاری را تا 3 برابر کاهش می دهد.

6. سازگاری و یکپارچگی

- LoRA با روش های مختلف قبلی سازگار است و می تواند با آنها ترکیب شود، مانند پیشوند تنظیم.

- طراحی خطی پیشنهادی امکان ادغام ماتریسهای قابل آموزش با وزنهای منجمد را در حین استقرار فراهم میکند و در مقایسه با مدلهای کاملاً دقیق، تاخیر استنتاج اضافی ایجاد نمیکند.

7. تحقیق تجربی

- این مقاله شامل یک بررسی تجربی در مورد کمبود رتبه در انطباق مدل زبان، ارائه بینش در مورد اثربخشی رویکرد LoRA است.

8. پیاده سازی منبع باز

- نویسندگان بستهای را ارائه میکنند که ادغام LoRA با مدلهای PyTorch و پیادهسازیها و نقاط بازرسی مدل را برای RoBERTa، DeBERTa و GPT-2 تسهیل میکند.

همچنین می توانید بخوانید: تنظیم دقیق پارامترهای کارآمد مدل های زبان بزرگ با LoRA و QLoRA

نتیجه

در پایان، بررسی 15 مقاله ضروری AI برای توسعه دهندگان GenAI که در این مقاله برجسته شده اند، صرفاً یک توصیه نیست، بلکه یک الزام استراتژیک برای هر توسعه دهنده مشتاق است. این مقالات هوش مصنوعی سفری جامع را از طریق چشم انداز متنوع هوش مصنوعی ارائه می دهند که دامنه های حیاتی مانند پردازش زبان طبیعی، بینایی کامپیوتر و فراتر از آن را در بر می گیرد. توسعه دهندگان با غوطه ور شدن در بینش ها و نوآوری های ارائه شده در این مقالات، به درک عمیقی از تکنیک ها و الگوریتم های پیشرفته این حوزه دست می یابند.

مربوط

- محتوای مبتنی بر SEO و توزیع روابط عمومی. امروز تقویت شوید.

- PlatoData.Network Vertical Generative Ai. به خودت قدرت بده دسترسی به اینجا.

- PlatoAiStream. هوش وب 3 دانش تقویت شده دسترسی به اینجا.

- PlatoESG. کربن ، CleanTech، انرژی، محیط، خورشیدی، مدیریت پسماند دسترسی به اینجا.

- PlatoHealth. هوش بیوتکنولوژی و آزمایشات بالینی. دسترسی به اینجا.

- منبع: https://www.analyticsvidhya.com/blog/2024/01/essential-ai-papers-every-gen-ai-developer-must-read/

- : دارد

- :است

- :نه

- :جایی که

- $UP

- 000

- 1

- 10

- 11

- 12

- 13

- 14

- ٪۱۰۰

- 17

- 20

- سال 20

- 2014

- 2017

- 28

- 30

- 3d

- 400

- 41

- 60

- 7

- 8

- 9

- 913

- a

- توانایی

- درباره ما

- AC

- دسترسی

- دقت

- دقیق

- به درستی

- رسیدن

- دست

- دستیابی به

- دستیابی به

- در میان

- عمل

- انطباق

- انطباقی

- اضافی

- علاوه بر این

- نشانی

- خطاب

- آدرس

- خطاب به

- تنظیمات

- اتخاذ

- پیشرفت

- مزیت - فایده - سود - منفعت

- مزایای

- دشمن

- پس از

- پیش

- AI

- اهداف

- AL

- الگوریتم

- الگوریتم

- معرفی

- اجازه دادن

- اجازه دادن

- اجازه می دهد تا

- در امتداد

- همچنین

- مقدار

- an

- تحلیل

- و

- هر

- مربوط

- کاربرد

- برنامه های کاربردی

- اعمال می شود

- اعمال میشود

- درخواست

- با استفاده از

- روش

- رویکردها

- تقریبی

- معماری

- هستند

- مناطق

- استدلال

- بوجود می آیند

- مقاله

- مقالات

- مصنوعی

- هوش مصنوعی

- هوش مصنوعی (AI)

- AS

- مشتاق

- ارزیابی

- مرتبط است

- At

- مراجعه كردن

- توجه

- نویسندگان

- سد

- مستقر

- اساسی

- BE

- شود

- بودن

- در زیر

- محک

- معیار

- معیار

- مزایای

- بهترین

- بهتر

- میان

- خارج از

- تعصبات

- بیلیون

- BIN

- بالا بردن

- هر دو

- بسته

- دستیابی به موفقیت

- پیشرفت ها

- گسترده تر

- بنا

- ساخته

- اما

- by

- نام

- آمد

- دوربین

- CAN

- نامزد

- کلاه لبه دار

- قابلیت های

- قابلیت

- ظرفیت

- گرفتن

- جلب

- Осторожно

- ابشاری

- دسته

- معین

- زنجیر

- زنجیر

- به چالش

- چالش ها

- به چالش کشیدن

- شانس

- تبادل

- انتخاب

- کلاس ها

- طبقه بندی

- طبقه بندی کنید

- CNN

- رمز

- ترکیب شده

- ترکیب

- مشترک

- انجمن

- قابل مقایسه

- مقایسه

- مقایسه

- سازگار

- شایسته

- رقابت

- مسابقات

- رقابتی

- رقابت

- به طور کامل

- پیچیده

- پیچیدگی

- جامع

- محاسبه

- محاسباتی

- محاسبات

- کامپیوتر

- چشم انداز کامپیوتر

- محاسبه

- مفاهیم

- نگرانی ها

- نتیجه

- اتصال

- متصل

- در نظر بگیرید

- در نظر گرفته

- تشکیل شده است

- ثابت

- محتوا

- مسابقه

- زمینه

- ادامه

- مداوم

- کنتراست

- کمک

- کمک می کند

- کمک

- مشارکت

- کنترل

- همگرایی

- شبکه عصبی حلقوی

- اصلاح

- به درستی

- ارتباط

- مطابقت دارد

- گران

- پوشش

- پوشش

- بحرانی

- بسیار سخت

- جاری

- منحنی

- لبه برش

- داده ها

- مجموعه داده ها

- روز

- معامله

- تصمیم گیری

- کاهش می دهد

- عمیق

- یادگیری عمیق

- شبکه عصبی عمیق

- عمیق تر

- خواسته

- نشان دادن

- نشان می دهد

- نشان دادن

- بستگی دارد

- وابستگی

- گسترش

- استقرار

- گسترش

- توصیف

- شرح داده شده

- توصیف

- طرح

- طراحی

- با وجود

- دقیق

- توسعه دهنده

- توسعه دهندگان

- در حال توسعه

- مختلف

- مشکل

- مشکلات

- جهت دار

- مستقیما

- کشف می کند

- کشف

- فاصله

- تمیز دادن

- متمایز می کند

- توزیع

- توزیع

- مختلف

- تنوع

- do

- دامنه

- حوزه

- تسلط

- دارو

- کشف مواد مخدر

- در طی

- پویا

- E&T

- هر

- آسان تر

- موثر

- به طور موثر

- اثر

- اثرات

- اثر

- بهره وری

- موثر

- هشت

- هر دو

- عناصر

- یازده

- حذف می شود

- از بین بردن

- اهمیت دادن

- تأکید می کند

- کارفرمایان

- کار می کند

- قادر ساختن

- را قادر می سازد

- را قادر می سازد

- پشتیبانی می کند

- تعامل

- مهندسی

- انگلیسی

- بالا بردن

- پیشرفت ها

- افزایش می یابد

- حصول اطمینان از

- تمام

- به طور کامل

- ورود

- برابر

- تعادل

- معادل

- خطا

- به خصوص

- ماهیت

- ضروری است

- تاسیس

- ایجاد می کند

- تخمین می زند

- اتر (ETH)

- ارزیابی

- ارزیابی

- حتی

- در همه جا

- تکامل یابد

- تکامل می یابد

- در حال تحول

- مثال ها

- تجاوز

- بیش از

- عالی

- مهیج

- نمایشگاه ها

- موجود

- وجود دارد

- گسترش

- گران

- تجربی

- آزمایش

- کارشناسان

- اکتشاف

- اکتشاف

- کاوش می کند

- بررسی

- تمدید شده

- تسهیل می کند

- تسهیل کننده

- عدم

- آشنا

- سریعتر

- امکان پذیر است

- امکانات

- کمی از

- کمتر

- رشته

- زمینه

- فیلترها برای تصفیه آب

- نهایی

- پیدا کردن

- پیدا کردن

- یافته ها

- نام خانوادگی

- مناسب

- پنج

- ثابت

- جریان

- تمرکز

- تمرکز

- به دنبال

- برای

- یافت

- چهار

- چارچوب

- فرکانس

- از جانب

- منجمد

- کامل

- کاملا

- تابع

- توابع

- بیشتر

- افزایش

- عایدات

- بازی

- GAN ها

- دروازه

- جنایی

- تولید می کنند

- تولید

- مولد

- مولد

- مدل مولد

- مهربان

- هندسه

- داده

- دادن

- جهانی

- GPU

- GPU ها

- گراف

- نمودارهای عصبی نمودار

- نمودار ها

- شدن

- دسته

- اداره

- سخت افزار

- داشتن

- کمک می کند

- سلسله مراتبی

- زیاد

- فرکانس بالا

- کیفیت بالا

- بالاتر

- نماد

- برجسته

- مشخص کردن

- های لایت

- خیلی

- چگونه

- چگونه

- HTTPS

- انسان

- انسان

- صدها نفر

- صدها میلیون

- تنظیم فراپارامتر

- ایده ها

- شناسایی

- تصویر

- طبقه بندی تصویر

- شناسایی تصویر

- IMAGEnet

- تصاویر

- تأثیر

- اثرات

- امری ضروری

- پیاده سازی

- پیاده سازی ها

- اجرا

- پیامدهای

- اهمیت

- مهم

- تحمیل

- بهبود یافته

- بهبود

- ارتقاء

- را بهبود می بخشد

- بهبود

- in

- شامل

- شامل

- از جمله

- ترکیب کردن

- شامل

- افزایش

- افزایش

- افزایش

- به طور فزاینده

- نشان دادن

- اطلاعات

- اطلاع

- در ابتدا

- نوآوری

- ابتکاری

- ورودی

- بینش

- الهام بخش

- نمونه

- در عوض

- دستورالعمل

- ادغام

- اطلاعات

- شدید

- اثر متقابل

- فعل و انفعالات

- علاقه

- اینترنت

- به

- معرفی

- معرفی

- معرفی می کند

- معرفی

- معرفی

- تحقیق

- شامل

- شامل

- موضوع

- مسائل

- IT

- ITS

- کار

- شغل ها

- سفر

- JPG

- دانش

- شناخته شده

- عدم

- فرود

- چشم انداز

- زبان

- بزرگ

- در مقیاس بزرگ

- بزرگتر

- بزرگترین

- تاخیر

- آخرین

- لایه

- لایه

- برجسته

- منجر می شود

- یاد گرفتن

- آموخته

- یادگیری

- کمتر

- سطح

- قدرت نفوذ

- اهرم ها

- بهره برداری

- پسندیدن

- احتمال

- محدودیت

- محدودیت

- محدود شده

- محلی

- طولانی

- مدت زمان طولانی

- نگاه کنيد

- کم

- کاهش

- پایین آوردن

- دستگاه

- ترجمه ماشین

- ساخته

- نگهداری

- عمده

- ساخت

- ساخت

- روش

- بسیاری

- نقشه

- حاشیه

- عظیم

- مسابقه

- کبریت

- مطابق

- ریاضی

- ماتریس

- حداکثر عرض

- به حداکثر رساندن

- بیشترین

- اندازه

- مکانیسم

- حافظه

- صرفا - فقط

- ادغام

- روش

- متدولوژی ها

- روش شناسی

- روش

- میلیون

- میلیون ها نفر

- حداقل

- به حداقل رساندن

- اشتباه

- مدل

- مدل

- تغییرات

- ماژول ها

- بیش

- کارآمدتر

- علاوه بر این

- اکثر

- چندگانه

- باید

- باید بخواند

- طبیعی

- زبان طبیعی

- پردازش زبان طبیعی

- طبیعت

- نیاز

- ضروری

- نیازهای

- نرگس

- توری

- شبکه

- شبکه

- عصبی

- شبکه های عصبی

- شبکه های عصبی

- NeurIPS

- نورون ها

- جدید

- اخبار

- بعد

- nlp

- نه

- گره

- گره

- قابل توجه

- توجه داشته باشید

- یادداشت

- رمان

- عدد

- هدف

- هدف

- اهداف

- مشاهده

- وقوع

- OCR

- of

- ارائه

- پیشنهادات

- غالبا

- on

- ONE

- آنهایی که

- آنلاین

- فقط

- منبع باز

- عمل

- عملیات

- بهینه سازی

- بهینه سازی

- بهینه

- or

- دیگر

- بهتر از

- بهتر از

- عملکرد بهتر

- تولید

- خارج از

- روی

- غلبه بر

- فائق آمدن

- مروری

- بسته

- جفت

- ها Pankaj

- مقاله

- اوراق

- موازی

- پارامتر

- پارامترهای

- ویژه

- ویژه

- پچ های

- الگو

- برای

- انجام دادن

- کارایی

- انجام می دهد

- دوره ها

- عکاسی

- افلاطون

- هوش داده افلاطون

- PlatoData

- محتمل

- نقطه

- به شمار

- پتانسیل

- بالقوه

- قوی

- عملی

- برنامه های کاربردی عملی

- پیش بینی

- قابل پیش بینی

- پیش بینی

- پیش گویی

- پیش بینی

- پیش بینی می کند

- در حال حاضر

- ارائه شده

- هدیه

- قبلی

- اصلی

- قبلا

- احتمال

- مشکل

- مشکلات

- روش

- روند

- در حال پردازش

- تولید کردن

- عمیق

- برنامه

- برنامه ها

- پروژه ها

- پیشنهادات

- پیشنهاد شده

- پیشنهاد می کند

- خواستگاری کردن

- پروتئين

- پروتئین ها

- اثبات شده

- اثبات می کند

- ارائه

- فراهم می کند

- ارائه

- منتشر شده

- مارماهی

- کیفیت

- نمایش ها

- نژاد

- محدوده

- رتبه بندی

- نرخ

- نسبتا

- خام

- رسیده

- خواندن

- مطالعه

- دوباره تأیید می کند

- واقعی

- دنیای واقعی

- اخیر

- تازه

- دستور العمل

- به رسمیت شناختن

- توصیه

- بازیابی

- عود

- راجعه

- بازگشتی

- كاهش دادن

- کاهش

- را کاهش می دهد

- کاهش

- کاهش

- مرجع

- منابع

- منعکس شده

- با توجه

- تنظیم کردن

- مربوط

- روابط

- آزاد

- منتشر شد

- اعتماد

- تکیه بر

- بقایای

- قابل توجه

- ارائه شده

- تفسیر

- نشان دادن

- نمایندگی

- نماینده

- نمایندگی

- نیاز

- نیاز

- مورد نیاز

- تحقیق

- جامعه پژوهشی

- محققان

- منابع

- به ترتیب

- نتیجه

- نتایج

- بازآموزی

- فاش کردن

- انقلابی کردن

- RGB

- راست

- خطر

- تنومند

- مقیاس پذیری

- مقیاس پذیر

- مقیاس

- مقیاس ها

- مقیاس گذاری

- سناریوها

- صحنه

- صحنه های

- زمان بندی

- طرح ها

- علمی

- نمره

- خراش

- جستجو

- جمله

- دنباله

- سلسله

- خدمت

- تنظیم

- مجموعه

- تنظیمات

- چند

- اشتراک گذاری

- اشتراک

- کوتاه مدت

- نشان

- نمایش داده شده

- نمایشگاه

- نمایش

- نشان می دهد

- سیگنال

- اهمیت

- قابل توجه

- به طور قابل توجهی

- مشابه

- شباهت ها

- ساده

- به طور همزمان

- شرایط

- اندازه

- ماهر

- به نرمی

- اجتماعی

- فقط

- راه حل

- مزایا

- حل

- حل می کند

- حل کردن

- برخی از

- گاهی

- فضا

- فضا و زمان

- تنش

- تخصصی

- خاص

- طیفی

- سرعت

- انشعاب

- استاندارد

- وضعیت هنر

- اظهارات

- ماندن

- گام

- ذخیره سازی

- opbevare

- استراتژیک

- استراتژی ها

- استراتژی

- قوی

- ساختار

- ساخت یافته

- ساختار

- مبارزات

- مهاجرت تحصیلی

- قابل توجه

- قابل ملاحظه ای

- موفقیت

- موفق

- موفقیت

- چنین

- حاکی از

- مناسب

- برتر

- نظارت

- فراتر می رود

- فراتر

- SVG

- سنتز

- سیستم

- سیستم های

- کار

- وظایف

- تکنیک

- تمایل

- قوانین و مقررات

- آزمون

- متن

- نسبت به

- که

- La

- نمودار

- شان

- آنها

- سپس

- نظری

- اینها

- آنها

- این

- هزاران نفر

- سه

- از طریق

- زمان

- بار

- به

- ابزار

- تاپیک

- طرف

- سنتی

- قطار

- آموزش دیده

- آموزش

- انتقال

- انتقال

- ترانسفورماتور

- ترانسفورماتور

- ترجمه

- کیفیت ترجمه

- روند

- آموزش

- دو

- انواع

- تأکید

- درک

- منحصر به فرد

- واحد

- بر خلاف

- بی سابقه

- به روز شده

- به روز رسانی

- استفاده کنید

- استفاده

- استفاده

- با استفاده از

- استفاده می کند

- v1

- ارزشمند

- مختلف

- قابل تصدیق و تایید

- همه کاره

- تطبیق پذیری

- نسخه

- تصویری

- فیلم های

- چشم انداز

- نمایش ها

- قابل رویت

- دید

- سیستم های بینایی

- بصری

- تشخیص بصری

- حجم

- vs

- بود

- راه

- وب

- وزن

- خوب

- چه زمانی

- چه

- که

- در حین

- وسیع

- دامنه گسترده

- به طور گسترده ای

- گسترده تر

- جامعه گسترده تر

- ویکیپدیا

- اراده

- با

- در داخل

- بدون

- کلمات

- مهاجرت کاری

- با این نسخهها کار

- با ارزش

- کتبی

- سال

- متورق

- شما

- شما

- زفیرنت