سرعت توان حافظه و تأخیر کم هنگام تغییر استنتاج از مرکز داده به لبه شبکه بسیار مهم است.

هوش مصنوعی/ML با سرعتی برق آسا در حال تکامل است. در حال حاضر هفته ای بدون پیشرفت های جدید و هیجان انگیز در این زمینه نمی گذرد و برنامه هایی مانند ChatGPT قابلیت های مولد هوش مصنوعی را به طور جدی در خط مقدم توجه عموم قرار داده اند.

AI/ML واقعاً دو کاربرد است: آموزش و استنتاج. هر کدام به عملکرد حافظه متکی هستند و هر کدام مجموعه منحصر به فردی از الزامات دارند که انتخاب بهترین راه حل حافظه را هدایت می کند.

با آموزش، پهنای باند حافظه و ظرفیت نیازهای حیاتی هستند. این امر به ویژه با توجه به اندازه و پیچیدگی مدلهای داده شبکه عصبی که با نرخ 10 برابر در سال در حال رشد بوده است، بیشتر است. دقت شبکه عصبی به کیفیت و کمیت مثالها در مجموعه دادههای آموزشی بستگی دارد که به نیاز به حجم عظیمی از دادهها و در نتیجه پهنای باند و ظرفیت حافظه تبدیل میشود.

با توجه به ارزش ایجاد شده از طریق آموزش، انگیزه قدرتمندی برای تکمیل هرچه سریعتر دوره های آموزشی وجود دارد. از آنجایی که برنامه های آموزشی در مراکز داده اجرا می شوند که به طور فزاینده ای برای نیرو و فضا محدود می شوند، راه حل هایی که کارایی انرژی و اندازه کوچکتر را ارائه می دهند ترجیح داده می شوند. با توجه به تمام این الزامات، HBM3 یک راه حل حافظه ایده آل برای سخت افزار آموزش هوش مصنوعی است. پهنای باند و ظرفیت عالی را فراهم می کند.

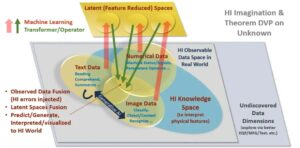

خروجی آموزش شبکه عصبی یک مدل استنتاجی است که می تواند به طور گسترده اجرا شود. با این مدل، یک دستگاه استنتاج می تواند ورودی های خارج از محدوده داده های آموزشی را پردازش و تفسیر کند. برای استنباط، سرعت توان عملیاتی حافظه و تأخیر کم بسیار مهم هستند، به ویژه زمانی که به اقدام در زمان واقعی نیاز است. با تغییر بیشتر و بیشتر استنتاج هوش مصنوعی از قلب مرکز داده به لبه شبکه، این ویژگی های حافظه بسیار مهم تر می شوند.

طراحان تعدادی انتخاب حافظه برای استنتاج AI/ML دارند، اما در پارامتر حیاتی پهنای باند، حافظه GDDR6 واقعا می درخشد. با سرعت داده 24 گیگابیت در ثانیه (Gb/s) و یک رابط گسترده 32 بیتی، یک دستگاه GDDR6 می تواند 96 گیگابایت در ثانیه (GB/s) پهنای باند حافظه ارائه دهد که بیش از دو برابر هر DDR یا جایگزین دیگری است. راه حل های LPDDR حافظه GDDR6 ترکیبی عالی از سرعت، پهنای باند و عملکرد تأخیر را برای استنتاج AI/ML، به ویژه برای استنتاج در لبه ارائه میکند.

زیرسیستم رابط حافظه Rambus GDDR6 عملکرد 24 گیگابیت بر ثانیه را ارائه می دهد و بر اساس بیش از 30 سال تخصص یکپارچگی سیگنال پرسرعت و یکپارچگی توان (SI/PI) ساخته شده است که برای عملکرد GDDR6 در سرعت های بالا ضروری است. این شامل یک کنترلر PHY و دیجیتال است که یک زیرسیستم رابط حافظه کامل GDDR6 را ارائه می دهد.

به من در وبینار رامبوس در این ماه بپیوندید.استنتاج AI/ML با عملکرد بالا با حافظه 24G GDDR6برای کشف اینکه چگونه GDDR6 از حافظه و الزامات عملکرد بارهای کاری استنتاج AI/ML پشتیبانی می کند و در مورد برخی از ملاحظات کلیدی طراحی و پیاده سازی زیرسیستم های رابط حافظه GDDR6 اطلاعاتی کسب کنید.

منابع:

فرانک فرو

(همه پست ها)

فرانک فرو مدیر ارشد بازاریابی محصول برای هسته های IP در Rambus است.

- محتوای مبتنی بر SEO و توزیع روابط عمومی. امروز تقویت شوید.

- PlatoAiStream. Web3 Data Intelligence دانش تقویت شده دسترسی به اینجا.

- ضرب کردن آینده با آدرین اشلی. دسترسی به اینجا.

- خرید و فروش سهام در شرکت های PRE-IPO با PREIPO®. دسترسی به اینجا.

- منبع: https://semiengineering.com/gddr6-delivers-the-performance-for-ai-ml-inference/

- : دارد

- :است

- :نه

- 24

- 26

- 27

- 30

- 8

- a

- درباره ما

- دقت

- عمل

- AI

- آموزش هوش مصنوعی

- AI / ML

- معرفی

- همه پست ها

- جایگزین

- مقدار

- an

- و

- هر

- برنامه های کاربردی

- هستند

- AS

- At

- توجه

- پهنای باند

- BE

- تبدیل شدن به

- بوده

- بهترین

- گسترده

- آورده

- ساخته

- اما

- by

- CAN

- قابلیت های

- ظرفیت

- مرکز

- مراکز

- GPT چت

- انتخاب

- انتخاب

- ترکیب

- کامل

- پیچیدگی

- ملاحظات

- کنترل کننده

- ایجاد شده

- بحرانی

- داده ها

- مرکز داده

- مرکز دادهها

- مجموعه داده ها

- ارائه

- ارائه

- بستگی دارد

- مستقر

- طرح

- تحولات

- دستگاه

- دیجیتال

- مدیر

- كشف كردن

- دو برابر

- راندن

- هر

- لبه

- بهره وری

- عظیم

- به خصوص

- حتی

- در حال تحول

- مثال ها

- عالی

- مهیج

- تخصص

- امکانات

- رشته

- محکم

- برای

- خط مقدم

- پایه

- از جانب

- مولد

- هوش مصنوعی مولد

- داده

- می رود

- بزرگ

- در حال رشد

- سخت افزار

- آیا

- قلب

- از این رو

- زیاد

- چگونه

- HTTPS

- دلخواه

- پیاده سازی

- in

- انگیزه

- به طور فزاینده

- ورودی

- تمامیت

- رابط

- به

- IP

- IT

- JPG

- کلید

- تاخیر

- یاد گرفتن

- رعد و برق

- پسندیدن

- کم

- بازار یابی (Marketing)

- حافظه

- مدل

- مدل

- ماه

- بیش

- ضروری

- نیازمند

- شبکه

- داده های شبکه

- عصبی

- شبکه های عصبی

- جدید

- اکنون

- عدد

- of

- ارائه

- پیشنهادات

- on

- عملیاتی

- or

- تولید

- خارج از

- روی

- سرعت

- پارامتر

- ویژه

- ویژه

- کارایی

- افلاطون

- هوش داده افلاطون

- PlatoData

- محبوبیت

- ممکن

- پست ها

- قدرت

- قوی

- روند

- محصول

- فراهم می کند

- ارائه

- عمومی

- کیفیت

- مقدار

- به سرعت

- نرخ

- زمان واقعی

- واقعا

- مورد نیاز

- راست

- ROW

- دویدن

- دوم

- ارشد

- تنظیم

- انتقال

- شیفت

- سیگنال

- اندازه

- کوچکتر

- So

- راه حل

- مزایا

- برخی از

- فضا

- سرعت

- سرعت

- پشتیبانی از

- نسبت به

- که

- La

- آنجا.

- اینها

- این

- از طریق

- توان

- کوچک

- به

- آموزش

- دو

- منحصر به فرد

- ارزش

- وبینار

- هفته

- چه زمانی

- که

- وسیع

- با

- بدون

- سال

- سال

- زفیرنت