07. veebruar 2023 (

Nanowerki uudised) Suured keelemudelid, nagu OpenAI GPT-3, on tohutud närvivõrgud, mis võivad genereerida inimesesarnast teksti alates luulest kuni programmeerimiskoodini. Need masinõppemudelid, mis on koolitatud Interneti-andmetega, võtavad väikese osa sisendtekstist ja ennustavad seejärel tõenäoliselt järgmisena ilmuvat teksti. Kuid see pole kõik, mida need mudelid teha suudavad. Teadlased uurivad uudishimulikku nähtust, mida nimetatakse kontekstis õppimiseks, mille puhul suur keelemudel õpib ülesande täitma pärast seda, kui on näinud vaid mõnda näidet – hoolimata asjaolust, et seda ei koolitatud selleks ülesandeks. Näiteks võib keegi anda mudelile mitu näitelauset ja nende tundeid (positiivseid või negatiivseid), seejärel paluda seda uue lausega ja mudel saab anda õige suhtumise. Tavaliselt tuleb masinõppe mudelit, nagu GPT-3, selle uue ülesande jaoks uute andmetega ümber õpetada. Selle koolitusprotsessi ajal värskendab mudel oma parameetreid, kuna see töötleb ülesande õppimiseks uut teavet. Kuid kontekstis õppimise korral mudeli parameetreid ei värskendata, seega tundub, et mudel õpib uue ülesande selgeks ilma midagi õppimata. MIT, Google Researchi ja Stanfordi ülikooli teadlased püüavad seda mõistatust lahti harutada. Nad uurisid mudeleid, mis on väga sarnased suurte keelemudelitega, et näha, kuidas nad saavad õppida ilma parameetreid värskendamata. Teadlaste teoreetilised tulemused näitavad, et need massiivsed närvivõrgu mudelid on võimelised sisaldama väiksemaid, lihtsamaid lineaarseid mudeleid, mis on nende sisse maetud. Suur mudel võiks seejärel rakendada lihtsat õppealgoritmi, et koolitada seda väiksemat lineaarset mudelit uue ülesande täitmiseks, kasutades ainult suuremas mudelis juba sisalduvat teavet. Selle parameetrid jäävad fikseerituks. Oluliseks sammuks kontekstis õppimise taga olevate mehhanismide mõistmisel avab see uurimus ukse õppimisalgoritmide põhjalikumaks uurimiseks, mida need suured mudelid saavad rakendada, ütleb arvutiteaduse magistrant ja artikli juhtiv autor Ekin Akyürek (

“What learning algorithm is in-context learning? Investigations with linear models”) seda nähtust uurides. Kontekstisisese õppimise paremaks mõistmisel võivad teadlased võimaldada mudelitel täita uusi ülesandeid, ilma et oleks vaja kulukat ümberõpet. "Tavaliselt, kui soovite neid mudeleid täpsustada, peate koguma domeenispetsiifilisi andmeid ja tegema keerukaid projekte. Kuid nüüd saame sellele lihtsalt anda sisendi, viis näidet ja see saavutab selle, mida me tahame. Nii et kontekstis õppimine on päris põnev nähtus, ”ütleb Akyürek. Akyürekiga ühinevad paberil Dale Schuurmans, Google Braini teadur ja Alberta ülikooli arvutiteaduse professor; samuti vanemautorid Jacob Andreas, X konsortsiumi abiprofessor MIT elektrotehnika ja arvutiteaduse osakonnas ning MIT arvutiteaduse ja tehisintellekti labori (CSAIL) liige; Tengyu Ma, Stanfordi arvutiteaduse ja statistika dotsent; ja Danny Zhou, Google Braini juhtivteadlane ja uurimisdirektor. Uurimust esitletakse rahvusvahelisel õpperepresentatsioonide konverentsil.

Mudel mudelis

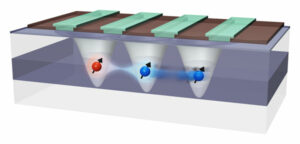

Akyürek ütleb, et masinõppe uurimisringkondades on paljud teadlased hakanud uskuma, et suured keelemudelid võivad nende koolitamise tõttu kontekstis õppimist teostada. Näiteks GPT-3-l on sadu miljardeid parameetreid ja seda koolitati, lugedes Internetis tohutul hulgal teksti, alates Wikipedia artiklitest kuni Redditi postitusteni. Seega, kui keegi näitab uue ülesande mudelinäiteid, on ta tõenäoliselt juba näinud midagi väga sarnast, kuna selle koolitusandmekogum sisaldas teksti miljarditelt veebisaitidelt. See kordab treeningu ajal nähtud mustreid, mitte ei õpi uusi ülesandeid täitma. Akyürek oletas, et kontekstis õppijad ei sobita lihtsalt varem nähtud mustreid, vaid õpivad tegelikult uusi ülesandeid täitma. Tema ja teised olid katsetanud, andes neile mudelitele viipasid, kasutades sünteetilisi andmeid, mida nad poleks varem kusagil näinud, ja avastasid, et mudelid võivad siiski õppida vaid mõnest näitest. Akyürek ja tema kolleegid arvasid, et võib-olla on nendes närvivõrgu mudelites väiksemad masinõppe mudelid, mida mudelid saavad uue ülesande täitmiseks treenida. "See võib selgitada peaaegu kõiki õppimisnähtusi, mida oleme nende suurte mudelite puhul näinud, " ütleb ta. Selle hüpoteesi testimiseks kasutasid teadlased närvivõrgu mudelit, mida nimetatakse trafoks, millel on sama arhitektuur nagu GPT-3, kuid mis oli spetsiaalselt koolitatud kontekstis õppimiseks. Selle trafo arhitektuuri uurides tõestasid nad teoreetiliselt, et see suudab oma varjatud olekutes kirjutada lineaarse mudeli. Närvivõrk koosneb paljudest omavahel ühendatud sõlmede kihtidest, mis töötlevad andmeid. Peidetud olekud on sisend- ja väljundkihtide vahelised kihid. Nende matemaatilised hinnangud näitavad, et see lineaarne mudel on kirjutatud kusagil trafo kõige varasemates kihtides. Seejärel saab trafo värskendada lineaarset mudelit, rakendades lihtsaid õppealgoritme. Sisuliselt simuleerib ja treenib mudel endast väiksemat versiooni.

Varjatud kihtide uurimine

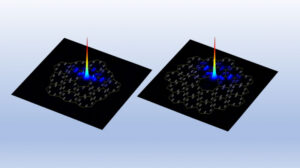

Teadlased uurisid seda hüpoteesi sondeerimiskatsete abil, kus nad uurisid trafo peidetud kihte, et proovida teatud kogust taastada. "Antud juhul proovisime taastada lineaarse mudeli tegeliku lahenduse ja saime näidata, et parameeter on kirjutatud peidetud olekus. See tähendab, et lineaarne mudel on kuskil sees, ”ütleb ta. Selle teoreetilise töö põhjal võivad teadlased võimaldada trafol teostada kontekstis õppimist, lisades närvivõrgule vaid kaks kihti. Akyürek hoiatab, et enne seda tuleb veel palju tehnilisi üksikasju välja töötada, kuid see võib aidata inseneridel luua mudeleid, mis suudavad täita uusi ülesandeid, ilma et oleks vaja uute andmetega ümberõpet. Edaspidi plaanib Akyürek jätkata kontekstis õppimise uurimist funktsioonidega, mis on keerukamad kui selles töös uuritud lineaarsed mudelid. Nad võiksid neid katseid rakendada ka suurte keelemudelite puhul, et näha, kas nende käitumist kirjeldavad ka lihtsad õppealgoritmid. Lisaks soovib ta süveneda eelkoolitusandmete tüüpidesse, mis võimaldavad kontekstis õppimist. "Selle tööga saavad inimesed nüüd visualiseerida, kuidas need mudelid saavad eeskujudelt õppida. Seega loodan, et see muudab mõne inimese arvamust kontekstis õppimise kohta, ”ütleb Akyürek. "Need mudelid pole nii lollid, kui inimesed arvavad. Nad ei jäta neid ülesandeid lihtsalt pähe. Nad saavad õppida uusi ülesandeid ja me oleme näidanud, kuidas seda saab teha.

- SEO-põhise sisu ja PR-levi. Võimenduge juba täna.

- Platoblockchain. Web3 metaversiooni intelligentsus. Täiustatud teadmised. Juurdepääs siia.

- Allikas: https://www.nanowerk.com/news2/robotics/newsid=62325.php