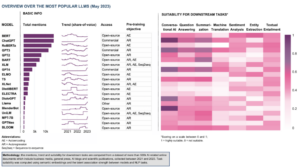

Kiiresti arenevas tehisintellekti valdkonnas on loomuliku keele töötlemine muutunud nii teadlaste kui ka arendajate keskpunktiks. Ehitades vundamentidele Trafo arhitektuur ja BERTi kahesuunaline uuendus, on viimastel aastatel esile kerkinud mitmeid murrangulisi keelemudeleid, mis nihutavad masinate mõistmise ja genereerimise piire.

Selles artiklis käsitleme uusimaid edusamme suuremahuliste keelemudelite maailmas, uurime iga mudeli täiustusi, nende võimalusi ja potentsiaalseid rakendusi. Uurime ka visuaalse keele mudeleid (VLM), mis on koolitatud töötlema mitte ainult tekstilisi, vaid ka visuaalseid andmeid.

Kui soovite vahele jätta, on siin toodud keelemudelid:

- OpenAI GPT-3

- Google'i LaMDA

- Google'i PaLM

- Flamingo, autor DeepMind

- Salesforce'i BLIP-2

- LLaMA, autor Meta AI

- OpenAI GPT-4

Kui see põhjalik hariv sisu on teile kasulik, saate seda teha tellige meie AI-uuringute meililist hoiatada, kui avaldame uut materjali.

Kõige olulisemad suured keelemudelid (LLM) ja visuaalkeele mudelid (VLM) 2023. aastal

1. OpenAI GPT-3

kokkuvõte

OpenAI meeskond tutvustas GPT-3 alternatiivina iga uue keeleülesande jaoks märgistatud andmekogumile. Nad väitsid, et keelemudelite suurendamine võib parandada ülesannete agnostika mõne kaadri jõudlust. Selle soovituse testimiseks õpetasid nad välja 175B-parameetrilise autoregressiivse keelemudeli, nn GPT-3ja hindas selle toimivust enam kui kahe tosina NLP-ülesande puhul. Hindamine mõne võttega õppimise, ühekordse õppimise ja nullkaadriga õppimise alusel näitas, et GPT-3 saavutas paljulubavaid tulemusi ja ületas isegi aeg-ajalt peenhäälestatud mudelitega saavutatud tipptasemel tulemusi.

Mis on eesmärk?

- Olemasolevale probleemile alternatiivse lahenduse soovitamiseks, kui iga uue keeleülesande jaoks on vaja märgistatud andmestikku.

Kuidas probleemile lähenetakse?

- Teadlased soovitasid suurendada keelemudeleid, et parandada ülesannete agnostilist jõudlust mõne võttega.

- . GPT-3 mudel kasutab sama mudelit ja arhitektuuri nagu GPT-2, sealhulgas modifitseeritud initsialiseerimine, eelnormaliseerimine ja pöörduv tokeniseerimine.

- Kuid erinevalt GPT-2-st kasutab see trafo kihtides vaheldumisi tihedaid ja lokaalselt ribadega hõredaid tähelepanumustreid, nagu Hõreda trafo.

Millised on tulemused?

- GPT-3 mudel ilma peenhäälestuseta saavutab paljude NLP-ülesannete puhul paljutõotavaid tulemusi ja ületab isegi aeg-ajalt tipptasemel mudeleid, mis on selle konkreetse ülesande jaoks täpselt häälestatud:

- Kohta CoQA etalon, 81.5 F1 nullkaadri seadistuses, 84.0 F1 ühe löögi seadistuses ja 85.0 F1 mõne kaadri seadistuses, võrreldes peenhäälestatud SOTA tulemusega 90.7 F1.

- Kohta TriviaQA etalon, 64.3% täpsus null-võtte seadistusel, 68.0% ühekordsel võttel ja 71.2% mõne kaadri seadistusel, ületades tehnika taseme (68%) 3.2% võrra.

- Kohta Lambada andmekogum, 76.2% täpsus nullkaadri seadistuses, 72.5% ühekordses seadistuses ja 86.4% mõne kaadri seadistuses, ületades tehnika taseme (68%) 18%.

- 175B parameetriga GPT-3 mudeli genereeritud uudisteartikleid on inimeste hinnangul raske eristada tegelikest (täpsusega vaevalt üle juhuse taseme ~52%).

- Vaatamata GPT-3 märkimisväärsele jõudlusele, sai see AI kogukonnalt vastakaid hinnanguid:

- "GPT-3 hüpe on liiga palju. See on muljetavaldav (aitäh ilusate komplimentide eest!), kuid sellel on siiski tõsiseid nõrkusi ja mõnikord tehakse väga rumalaid vigu. AI muudab maailma, kuid GPT-3 on vaid väga varane pilguheit. Meil on veel palju välja mõelda." – Sam Altman, OpenAI tegevjuht ja kaasasutaja.

- "Olen šokeeritud, kui raske on genereerida GPT-3 põhjal teksti moslemite kohta, millel pole midagi pistmist vägivallaga… või tapmisega…” – Abubakar Abid, Gradio tegevjuht ja asutaja.

- "Ei. GPT-3 ei saa põhimõtteliselt aru maailmast, millest ta räägib. Korpuse edasine suurendamine võimaldab sellel luua usaldusväärsema pastišši, kuid mitte parandada oma põhilist arusaamatust maailmast. GPT-4 demod nõuavad endiselt inimeste kirsikorjamist. – Gary Marcus, Robust.ai tegevjuht ja asutaja.

- "GPT3 suurejoonelise jõudluse ekstrapoleerimine tulevikku viitab sellele, et vastus elule, universumile ja kõigele on vaid 4.398 triljonit parameetrit." – Geoffrey Hinton, Turingi auhinna võitja.

Kust selle uuringu kohta rohkem teada saada?

Kust saab rakenduskoodi saada?

- Kood ise pole saadaval, kuid osa andmestiku statistikat koos tingimusteta, filtreerimata 2048-märgise näidistega GPT-3-st avaldatakse GitHub.

2. Google'i LaMDA

kokkuvõte

Lakeel Models jaoks Ddialoog Arakendused (TheMDA). Nendel mudelitel on maksimaalselt 137B parameetrit ja neid on koolitatud kasutama väliseid teadmisteallikaid. LaMDA arendajad pidasid silmas kolme peamist eesmärki – kvaliteeti, ohutust ja põhjendatust. Tulemused näitasid, et peenhäälestus võimaldab vähendada kvaliteedilõhet inimeste tasemele, kuid mudeli jõudlus jäi ohutuse ja maanduse osas alla inimese taseme.

Google'i Bard, vabastatud hiljuti ChatGPT alternatiivina toidab LaMDA. Vaatamata sellele, et Bard on sageli märgistatud kui igav, võib seda pidada tõendiks Google'i pühendumusest seada esikohale ohutus, isegi keset Google'i ja Microsofti vahelist intensiivset rivaalitsemist generatiivse tehisintellekti valdkonnas domineerimise saavutamise nimel.

Mis on eesmärk?

- Mudeli loomiseks avatud domeeni dialoogirakenduste jaoks, kus dialoogiagent suudab vestelda mis tahes teemal ja vastused on mõistlikud, kontekstipõhised, põhinevad usaldusväärsetel allikatel ja on eetilised.

Kuidas probleemile lähenetakse?

- LaMDA on üles ehitatud Transformer, närvivõrgu arhitektuur, mille Google Research leiutas ja avatud lähtekoodiga 2017. aastal.

- Nagu teisedki suured keelemudelid, sealhulgas BERT ja GPT-3, on LaMDA koolitatud terabaitide tekstiandmetega, et õppida, kuidas sõnad üksteisega seostuvad, ja ennustada, millised sõnad tõenäoliselt järgmisena tulevad.

- Erinevalt enamikust keelemudelitest koolitati LaMDA dialoogi, et leida nüansse, mis eristavad avatud vestlust muudest keelevormidest.

- Mudel on ka peenhäälestatud, et parandada selle vastuste mõistlikkust, ohutust ja spetsiifilisust. Kuigi fraasid nagu "see on tore" ja "ma ei tea" võivad paljudes dialoogistsenaariumides olla tähendusrikkad, ei vii need tõenäoliselt huvitavate ja kaasahaaravate vestlusteni.

- LaMDA generaator genereerib esmalt mitu kandidaatvastust, mis kõik hinnatakse selle järgi, kui ohutud, mõistlikud, konkreetsed ja huvitavad need on. Madala turvaskooriga vastused filtreeritakse välja ja seejärel valitakse vastuseks kõrgeim tulemus.

Millised on tulemused?

- Arvukad katsed näitavad, et LaMDA võib osaleda avatud vestlustes erinevatel teemadel.

- Mitmed kvalitatiivsed hinnangud kinnitasid, et mudeli vastused kipuvad olema mõistlikud, konkreetsed, huvitavad ja põhinevad usaldusväärsetel välisallikatel, kuid arenguruumi on veel.

- Vaatamata kõigile seni tehtud edusammudele tunnistavad autorid, et mudelil on endiselt palju piiranguid, mis võivad põhjustada sobimatuid või isegi kahjulikke reaktsioone.

Kust selle uuringu kohta rohkem teada saada?

Kust saab rakenduskoodi saada?

- Avatud lähtekoodiga PyTorchi rakendus LaMDA koolituseelse arhitektuuri jaoks on saadaval aadressil GitHub.

3. Google'i PaLM

kokkuvõte

Pateistmoodi Lahastus Model (PALM) on 540-miljardiline parameeter, transformeril põhinev keelemudel. PaLM-i koolitati 6144 TPU v4 kiibil, kasutades Pathwaysi, uut ML-süsteemi, mis võimaldab tõhusalt treenida mitme TPU Podiga. Mudel demonstreerib skaleerimise eeliseid vähesel määral õppimisel, saavutades tipptasemel tulemusi sadade keele mõistmise ja põlvkonna võrdlusnäitajate põhjal. PaLM edestab peenhäälestatud tipptasemel mudeleid mitmeastmeliste arutlusülesannete puhul ja ületab BIG-i võrdlusalusel inimese keskmist jõudlust.

Mis on eesmärk?

- Paremaks arusaamist sellest, kuidas suurte keelemudelite skaleerimine mõjutab vähesel määral õppimist.

Kuidas probleemile lähenetakse?

- Põhiidee on laiendada 540 miljardi parameetriga keelemudeli koolitust süsteemiga Pathways:

- Meeskond kasutas andmete paralleelsust Podi tasemel kahe Cloud TPU v4 Podi vahel, kasutades samas standardandmeid ja mudeli paralleelsust igas Podis.

- Nad suutsid koolitust skaleerida 6144 TPU v4 kiibile, mis on seni suurim koolitusel kasutatud TPU-põhine süsteemikonfiguratsioon.

- Mudel saavutas koolituse efektiivsuse 57.8% riistvara FLOP-ide kasutamisest, mis, nagu autorid väidavad, on kõrgeim seni saavutatud koolitustõhusus suurte keelemudelite jaoks sellel skaalal.

- PaLM-mudeli koolitusandmed sisaldasid ingliskeelsete ja mitmekeelsete andmekogumite kombinatsiooni, mis sisaldasid kvaliteetseid veebidokumente, raamatuid, Vikipeediat, vestlusi ja GitHubi koodi.

Millised on tulemused?

- Arvukad katsed näitavad, et mudeli jõudlus kasvas järsult, kui meeskond suurendas oma suurimat mudelit.

- PaLM 540B saavutas läbimurdelise jõudluse mitme väga raske ülesande täitmisel:

- Keele mõistmine ja genereerimine. Kasutusele võetud mudel ületas varasemate suurte mudelite mõne kaadriga jõudlust 28 ülesande puhul 29-st, mis hõlmavad küsimustele vastamise ülesandeid, sulgemis- ja lauselõpetamisülesandeid, kontekstis lugemist mõistmise ülesandeid, terve mõistuse ülesandeid, SuperGLUE ülesandeid ja rohkem. PalMi jõudlus BIG-pingi ülesannete täitmisel näitas, et see suudab eristada põhjuseid ja tagajärgi ning mõista kontseptuaalseid kombinatsioone sobivas kontekstis.

- Põhjendus. Kaheksakordse viipaga lahendab PaLM 8% probleemidest GSM58K-s, mis on tuhandete keerukate kooliastmete matemaatikaküsimuste etalon, ületades varasemat 8% parimat tulemust, mis saadi GPT-55 3B mudeli peenhäälestamisel. PaLM näitab ka võimet genereerida selgeid selgitusi olukordades, mis nõuavad mitmeastmelise loogilise järelduse, maailmateadmiste ja sügava keele mõistmise keerulist kombinatsiooni.

- Koodi genereerimine. PaLM toimib samaväärselt peenhäälestatud Codex 12B-ga, kasutades samal ajal treenimiseks 50 korda vähem Pythoni koodi, kinnitades, et suured keelemudelid edastavad nii teistest programmeerimiskeeltest kui ka loomulike keelte andmeid tõhusamalt.

Kust selle uuringu kohta rohkem teada saada?

Kust saab rakenduskoodi saada?

- Konkreetse Transformeri arhitektuuri mitteametlik PyTorchi rakendus PaLM-i uurimistööst on saadaval aadressil GitHub. Seda ei skaleerita ja see avaldatakse ainult hariduslikel eesmärkidel.

4. Flamingo by DeepMind

kokkuvõte

Flamingo on tipptasemel visuaalkeele mudelite (VLM) perekond, mis on koolitatud suuremahulistes multimodaalsetes veebikorpustes, mis sisaldavad segatud teksti ja pilte. Selle koolituse abil saavad mudelid kohaneda uute ülesannetega, kasutades minimaalseid kommenteeritud näiteid, mis on esitatud viipadena. Flamingo sisaldab peamisi arhitektuurilisi edusamme, mis on loodud selleks, et ühendada eelkoolitatud ainult nägemist ja ainult keelt kasutavate mudelite tugevad küljed, töödelda erinevalt põimitud visuaalseid ja tekstilisi andmeid ning kohandada sujuvalt pilte või videoid sisenditena. Mudelid näitavad muljetavaldavat kohanemisvõimet mitmesuguste pildi- ja videoülesannetega, nagu visuaalne küsimustele vastamine, tiitrite lisamise ülesanded ja valikvastustega visuaalne küsimustele vastamine, seades uued jõudlusstandardid, kasutades ülesandespetsiifilisi viipasid mõne võttega õppimisel.

Mis on eesmärk?

- Et võimaldada multimodaalsetel mudelitel lühikeste juhiste põhjal kiiresti õppida ja uusi ülesandeid täita, toimige järgmiselt.

- Laialdaselt kasutatav paradigma, mille kohaselt treenitakse mudelit suurel hulgal jälgitavatel andmetel ja seejärel peenhäälestatakse see konkreetse ülesande jaoks, on ressursimahukas ja nõuab tuhandeid annoteeritud andmepunkte koos ülesandepõhise hüperparameetri hoolika häälestamisega.

- Praegused mudelid, mis kasutavad kontrastset objektiivi, võimaldavad nullkaadriga kohanemist uute ülesannetega, kuid ei suuda teha rohkem avatud ülesandeid, nagu subtiitrid või visuaalne küsimustele vastamine, kuna neil puuduvad keele genereerimise võimalused.

- Selle uuringu eesmärk on tutvustada uut mudelit, mis käsitleb tõhusalt neid probleeme ja näitab suurepärast jõudlust vähese andmemahuga režiimides.

Kuidas probleemile lähenetakse?

- DeepMind tutvustas Flamingot, VLM-e, mis on mõeldud mitmesuguste avatud nägemis- ja keeleülesannete jaoks vähesel määral õppimiseks, kasutades vaid üksikuid sisend-/väljundnäiteid.

- Flamingo mudelid on visuaalselt konditsioneeritud autoregressiivse teksti genereerimise mudelid, mis suudavad töödelda piltide ja/või videotega segatud tekstimärke ning genereerida väljundina teksti.

- Flamingo arhitektuur sisaldab kahte täiendavat eelkoolitatud ja külmutatud mudelit:

- Nägemismudel, mis suudab "tajuda" visuaalseid stseene.

- Suur keelemudel, mille ülesandeks on põhilised arutluskäigud.

- Uudsed arhitektuurikomponendid integreerivad need mudelid viisil, mis säilitab nende arvutusmahuka eelkoolituse käigus omandatud teadmised.

- Lisaks on Flamingo mudelitel tajujal põhinev arhitektuur, mis võimaldab neil neelata kõrge eraldusvõimega pilte või videoid. See arhitektuur võib luua kindla arvu visuaalseid märke pildi/video kohta laia ja muutuva visuaalse sisendi funktsioonide hulgast.

Millised on tulemused?

- Uuring näitab, et sarnaselt LLM-idega, mis on head õppijad, saavad VLM-id õppida mõnest sisendi/väljundi näitest piltide ja videote mõistmise ülesannete jaoks, nagu klassifitseerimine, pealdised või küsimustele vastamine.

- Flamingo loob uue etalon vähese kaadriga õppimises, näidates suurepärast jõudlust 16 mitmeliigilise keele ja pildi/video mõistmise ülesande puhul.

- Nendest 6 ülesandest 16 puhul ületab Flamingo tipptasemel jõudlust, kuigi kasutab ainult 32 ülesandepõhist näidet – ligikaudu 1000 korda vähem ülesandespetsiifilisi treeningandmeid kui praegustel tipptasemel mudelitel.

Kust selle uuringu kohta rohkem teada saada?

Kust saab rakenduskoodi saada?

- DeepMind ei avaldanud Flamingo ametlikku rakendust.

- Sissejuhatava lähenemisviisi avatud lähtekoodiga teostuse leiate veebisaidilt OpenFlamingo Github Repo.

- Saadaval on alternatiivne PyTorchi rakendus siin.

5. Salesforce'i BLIP-2

kokkuvõte

BLIP-2 on tõhus ja üldine visiooni- ja keelemudelite eelkoolitusraamistik, mis on loodud selleks, et vältida suuremahuliste mudelite eelkoolituse üha kallimaid kulusid. BLIP-2 kasutab riiulilt külmutatud eelkoolitatud pildikodeerijaid ja külmutatud suuri keelemudeleid, et käivitada nägemiskeele eelkoolitus, hõlmates kahes etapis eelkoolitatud kerget päringutransformaatorit. Esimene etapp käivitab nägemuskeele esituse õppimise külmutatud kujutise kodeerijast ja teine etapp käivitab visioonist keelele generatiivse õppimise külmutatud keelemudelist. Hoolimata sellest, et sellel on oluliselt vähem treenitavaid parameetreid, ületab BLIP-2 tipptasemel meetodeid, edestades DeepMindi Flamingo80B nullkaadri VQAv8.7 puhul 2% võrra, millel on 54 korda vähem treenitavaid parameetreid. Mudelil on ka paljulubavad nullkaadri pildist tekstiks genereerimise võimalused, järgides loomuliku keele juhiseid.

Mis on eesmärk?

- Nägemiskeele ülesannete tipptasemel jõudluse saavutamiseks, vähendades samal ajal arvutuskulusid.

Kuidas probleemile lähenetakse?

- Salesforce'i meeskond tutvustas uut visioonikeelset eelkoolituse raamistikku nimega BLIP-2, Bootstrapping Lkeel-IMage Pkordusõpe külmutatud unimodaalsete mudelitega:

- Eelkoolitatud unimodaalsed mudelid jäävad eelkoolituse ajal külmutatuks, et vähendada arvutuskulusid ja vältida katastroofilist unustamist.

- Et hõlbustada transpordiliikidevahelist joondust ja ületada modaalsuse lõhe eelkoolitatud nägemismudelite ja eelkoolitatud keelemudelite vahel, pakub meeskond välja kerge päringutransformaatori (Q-Former), mis toimib teabe kitsaskohana külmutatud kujutise kodeerija ja külmutatud kujutise vahel. LLM.

- Q-former on eelkoolitatud uue kaheetapilise strateegiaga:

- Esimeses eelkoolituse etapis viiakse läbi visiooni-keele esitusõpe. See sunnib Q-Formerit õppima teksti jaoks kõige asjakohasemat visuaalset esitust.

- Teises eelkoolituse etapis viiakse läbi visioonist keele generatiivset õpet, ühendades Q-Formeri väljundi külmutatud LLM-iga. Q-Former on koolitatud nii, et LLM saab selle väljundi visuaalset esitust tõlgendada.

Millised on tulemused?

- BLIP-2 pakub erakordseid tipptasemel tulemusi mitmesuguste visioonikeelsete ülesannete puhul, mis hõlmavad visuaalset küsimustele vastamist, piltide pealdisi ja pilditeksti otsimist.

- Näiteks zero-shot VQAv8.7 puhul ületab see Flamingot 2%.

- Lisaks saavutatakse see silmapaistev jõudlus oluliselt suurema arvutitõhususega:

- BLIP-2 ületab Flamingo-80B, kasutades samal ajal 54 korda vähem treenitavaid parameetreid.

- BLIP-2 suudab loomuliku keele juhiste põhjal luua nullkaadri kujutist tekstiks, sillutades sellega teed oskuste, nagu visuaalsete teadmiste arutlemine ja visuaalne vestlus, arendamiseks.

- Lõpuks on oluline märkida, et BLIP-2 on mitmekülgne lähenemine, mis võib kasutada keerukamaid unimodaalseid mudeleid, et veelgi parandada nägemiskeele eelkoolituse jõudlust.

Kust selle uuringu kohta rohkem teada saada?

Kust saab rakenduskoodi saada?

Ametlik BLIP-2 rakendus on saadaval aadressil GitHub.

6. LLaMA Meta AI poolt

kokkuvõte

Meta AI meeskond kinnitab, et väiksemaid mudeleid, mis on koolitatud rohkemate žetoonidega, on lihtsam ümber õpetada ja konkreetsete tooterakenduste jaoks peenhäälestada. Seetõttu tutvustavad nad Kõned (Large Lakeel Model Meta AI), põhikeelemudelite kogumik parameetritega 7B kuni 65B. LLaMA 33B ja 65B treeniti 1.4 triljonil märgil, samas kui väikseimat mudelit LLaMA 7B treeniti ühel triljonil märgil. Nad kasutasid eranditult avalikult kättesaadavaid andmekogumeid, sõltumata omandiõigusega või piiratud andmetest. Meeskond rakendas ka peamisi arhitektuurilisi täiustusi ja treeningkiiruse optimeerimise tehnikaid. Järelikult ületas LLaMA-13B GPT-3, olles üle 10 korra väiksem, ja LLaMA-65B pakkus konkurentsivõimelist jõudlust PaLM-540B-ga.

Mis on eesmärk?

- Demonstreerida parima jõudlusega mudelite koolitamise teostatavust ainult avalikult juurdepääsetavatel andmekogumitel, ilma omandiõigusega või piiratud andmeallikatele tuginemata.

- Pakkuda teadlaskonnale väiksemaid ja tulemuslikumaid mudeleid ning seeläbi võimaldada neil, kellel puudub juurdepääs suurele hulgale infrastruktuurile, uurida suuri keelemudeleid.

Kuidas probleemile lähenetakse?

- LLaMA mudeli koolitamiseks kasutasid teadlased ainult andmeid, mis on avalikult kättesaadavad ja ühilduvad avatud hankimisega.

- Samuti on nad standardse Transformeri arhitektuuri juurde viinud mõned täiustused:

- Võttes kasutusele GPT-3 metoodika, suurendati koolituse stabiilsust iga trafo alamkihi sisendi normaliseerimisega, mitte väljundi normaliseerimisega.

- PaLM-mudelitest inspireerituna asendasid teadlased jõudluse parandamiseks ReLU mittelineaarsuse SwiGLU aktiveerimisfunktsiooniga.

- Inspireeritud Su jt (2021), kõrvaldasid nad absoluutsed positsioonilised manused ja lisasid selle asemel pöörlevad positsioonilised manused (RoPE) võrgu igasse kihti.

- Lõpuks parandas Meta AI meeskond oma mudeli treeningkiirust järgmiselt:

- Tõhusa põhjusliku mitme peaga tähelepanu rakendamise kasutamine, mitte salvestades tähelepanu kaalusid ega arvutades maskeeritud võtme/päringu skoori.

- Kontrollpunkti kasutamine, et minimeerida ümberarvutatud aktiveerimisi tagurpidi liikumise ajal.

- Aktivatsioonide arvutamise ja GPU-de vahelise võrgu kaudu toimuva suhtluse kattumine (all_reduce operatsioonide tõttu).

Millised on tulemused?

- LLaMA-13B ületab GPT-3 vaatamata sellele, et see on üle 10 korra väiksem, samas kui LLaMA-65B hoiab PaLM-540B vastu.

Kust selle uuringu kohta rohkem teada saada?

Kust saab rakenduskoodi saada?

- Meta AI pakub juurdepääsu LLaMA-le akadeemilistele teadlastele, valitsuse, kodanikuühiskonna, akadeemiliste institutsioonide ja ülemaailmsete tööstuse uurimislaboritega seotud isikutele üksikjuhtumite hindamise alusel. Kandideerimiseks minge järgmisele GitHubi hoidla.

7. OpenAI GPT-4

kokkuvõte

GPT-4 on suuremahuline multimodaalne mudel, mis aktsepteerib pildi- ja tekstisisendeid ning genereerib tekstiväljundeid. Konkurentsi- ja ohutusprobleemide tõttu ei peeta konkreetseid üksikasju mudeli arhitektuuri ja koolituse kohta. Jõudluse poolest ületab GPT-4 varasemaid keelemudeleid traditsiooniliste võrdlusnäitajate alusel ning näitab märkimisväärset paranemist kasutaja kavatsuste mõistmises ja ohutusomadustes. Mudel saavutab ka erinevatel eksamitel inimtasemel jõudlust, sealhulgas 10% parima tulemuse simuleeritud ühtse baarieksamil.

Mis on eesmärk?

- Töötada välja suuremahuline multimodaalne mudel, mis suudab vastu võtta pildi- ja tekstisisendeid ning toota tekstiväljundeid.

- Töötada välja taristu ja optimeerimismeetodid, mis käituvad prognoositavalt paljudes skaalades.

Kuidas probleemile lähenetakse?

- Konkurentsikeskkonna ja ohutusega seotud mõjude tõttu otsustas OpenAI jätta avaldamata üksikasjad arhitektuuri, mudeli suuruse, riistvara, koolitusarvutuse, andmestiku koostamise ja koolitusmeetodite kohta.

- Nad avalikustavad, et:

- GPT-4 on transformaatoril põhinev mudel, mis on eelnevalt koolitatud ennustama dokumendis järgmist märgi.

- See kasutab avalikult kättesaadavaid andmeid ja kolmanda osapoole litsentsitud andmeid.

- Mudelit viimistleti, kasutades RLHF-i (Inforcement Learning from Human Feedback) meetodit.

- Kinnitamata teave viitab sellele, et GPT-4 ei ole ainulaadne tihe mudel nagu tema eelkäijad, vaid kaheksast erinevast mudelist koosnev koalitsioon, millest igaüks sisaldab hämmastavalt 220 miljardit parameetrit.

Millised on tulemused?

- GPT-4 saavutab enamikul erialastel ja akadeemilistel eksamitel inimtasemel jõudluse, saavutades simuleeritud ühtse baarieksami parima 10%.

- Eelkoolitatud GPT-4 baasmudel edestab olemasolevaid keelemudeleid ja varasemaid tipptasemel süsteeme traditsiooniliste NLP-etalonide puhul, ilma etalonipõhise meisterdamise või täiendavate koolitusprotokollideta.

- GPT-4 näitab kasutaja kavatsuste järgimise olulist paranemist, kuna selle vastuseid eelistatakse GPT-3.5 vastustele 70.2% ChatGPT ja OpenAI API 5,214 viipast.

- GPT-4 ohutusomadused on võrreldes GPT-3.5-ga märkimisväärselt paranenud: keelatud sisu taotlustele vastamine on vähenenud 82% ja tundlike taotluste (nt meditsiiniline nõustamine ja enesevigastamine) eeskirjade järgimine on 29% suurenenud.

Kust selle uuringu kohta rohkem teada saada?

Kust saab rakenduskoodi saada?

- GPT-4 koodi juurutamine pole saadaval.

Suurte (nägemus)keelemudelite reaalsed rakendused

Viimaste aastate kõige olulisemad AI-uuringute läbimurded pärinevad suurtest tehisintellekti mudelitest, mis on koolitatud tohutute andmekogumite põhjal. Need mudelid näitavad muljetavaldavat jõudlust ja on põnev mõelda, kuidas AI võib muuta terveid tööstusharusid, nagu klienditeenindus, turundus, e-kaubandus, tervishoid, tarkvaraarendus, ajakirjandus ja paljud teised.

Suurtel keelemudelitel on palju reaalseid rakendusi. GPT-4 loetleb järgmised:

- Loomuliku keele mõistmine ja genereerimine vestlusrobotite ja virtuaalsete assistentide jaoks.

- Masintõlge keelte vahel.

- Artiklite, aruannete või muude tekstidokumentide kokkuvõte.

- Sentiment analüüs turu-uuringuks või sotsiaalmeedia monitooringuks.

- Sisu genereerimine turunduse, sotsiaalmeedia või loomingulise kirjutamise jaoks.

- Küsimustele vastamise süsteemid klienditoe või teadmistebaaside jaoks.

- Teksti klassifikatsioon rämpsposti filtreerimiseks, teemade kategoriseerimiseks või dokumentide korraldamiseks.

- Isikupärastatud keeleõppe- ja juhendamisvahendid.

- Koodi genereerimise ja tarkvara arendamise abi.

- Meditsiiniline, juriidiline ja tehniline dokumentide analüüs ja abi.

- Juurdepääsetavustööriistad puuetega inimestele, nagu tekst kõneks ja kõnest tekstiks teisendamine.

- Kõnetuvastus- ja transkriptsiooniteenused.

Kui lisame visuaalse osa, laienevad võimalike rakenduste valdkonnad veelgi:

Väga põnev on jälgida hiljutisi tehisintellekti läbimurdeid ja mõelda nende potentsiaalsetele reaalsetele rakendustele. Kuid enne nende mudelite reaalses elus kasutuselevõttu peame käsitlema vastavaid riske ja piiranguid, mis on kahjuks üsna olulised.

Riskid ja piirangud

Kui küsite GPT-4-lt selle riskide ja piirangute kohta, pakub see teile tõenäoliselt pika nimekirja asjakohastest probleemidest. Pärast selle loendi filtreerimist ja mõnede täiendavate kaalutluste lisamist olen jõudnud järgmiste peamiste riskide ja piiranguteni, mis on tänapäevastel suurte keelemudelitel.

- Eelarvamus ja diskrimineerimine: need mudelid õpivad tohutul hulgal tekstiandmetest, mis sisaldavad sageli eelarvamusi ja diskrimineerivat sisu. Selle tulemusena võivad loodud väljundid tahtmatult kinnistada stereotüüpe, solvavat kõnepruuki ja diskrimineerimist selliste tegurite alusel nagu sugu, rass või religioon.

- Väärinformatsioon: suured keelemudelid võivad luua sisu, mis on faktiliselt vale, eksitav või aegunud. Kuigi mudelid on koolitatud mitmesuguste allikate põhjal, ei pruugi need alati pakkuda kõige täpsemat või ajakohasemat teavet. Sageli juhtub see seetõttu, et mudel seab prioriteediks selliste väljundite genereerimise, mis on grammatiliselt õiged või tunduvad sidusad, isegi kui need on eksitavad.

- Mõistmise puudumine: Kuigi need mudelid näivad mõistvat inimkeelt, toimivad nad peamiselt koolitusandmete mustrite ja statistiliste seoste tuvastamise kaudu. Neil puudub sügav arusaam nende loodud sisust, mis võib mõnikord põhjustada mõttetuid või ebaolulisi väljundeid.

- Sobimatu sisu: keelemudelid võivad mõnikord luua sisu, mis on solvav, kahjulik või sobimatu. Kuigi püütakse sellist sisu minimeerida, võib see siiski ilmneda koolitusandmete olemuse ja mudelite võimetuse tõttu konteksti või kasutaja kavatsusi eristada.

Järeldus

Suured keelemudelid on kahtlemata muutnud loomuliku keele töötlemise valdkonda ja näidanud tohutut potentsiaali tootlikkuse suurendamisel erinevates rollides ja tööstusharudes. Nende võime luua inimsarnast teksti, automatiseerida igapäevaseid ülesandeid ning pakkuda abi loomingulistes ja analüütilistes protsessides on muutnud need asendamatuteks tööriistadeks tänapäeva kiires ja tehnoloogiapõhises maailmas.

Siiski on ülioluline tunnistada ja mõista nende võimsate mudelitega seotud piiranguid ja riske. Ei saa tähelepanuta jätta selliseid probleeme nagu eelarvamus, desinformatsioon ja pahatahtliku kasutamise võimalus. Kuna jätkame nende AI-põhiste tehnoloogiate integreerimist oma igapäevaellu, on oluline leida tasakaal nende võimete võimendamise ja inimeste järelevalve tagamise vahel, eriti tundlikes ja kõrge riskiga olukordades.

Kui meil õnnestub generatiivseid tehisintellekti tehnoloogiaid vastutustundlikult kasutusele võtta, sillutame teed tulevikule, kus tehisintellekt ja inimteadmised töötavad koos, et edendada innovatsiooni ja luua kõigi jaoks parem maailm.

Kas teile meeldib see artikkel? Registreeruge, et saada rohkem AI-uuringute värskendusi.

Anname teile teada, kui avaldame rohkem selliseid kokkuvõtlikke artikleid.

seotud

- SEO-põhise sisu ja PR-levi. Võimenduge juba täna.

- PlatoData.Network Vertikaalne generatiivne Ai. Jõustage ennast. Juurdepääs siia.

- PlatoAiStream. Web3 luure. Täiustatud teadmised. Juurdepääs siia.

- PlatoESG. Autod/elektrisõidukid, Süsinik, CleanTech, Energia, Keskkond päikeseenergia, Jäätmekäitluse. Juurdepääs siia.

- BlockOffsets. Keskkonnakompensatsiooni omandi ajakohastamine. Juurdepääs siia.

- Allikas: https://www.topbots.com/top-language-models-transforming-ai-in-2023/

- :on

- :on

- :mitte

- : kus

- $ UP

- 1

- 10

- 12b

- 16

- 2%

- 2017

- 2021

- 2023

- 214

- 220

- 28

- 32

- 50

- 7

- 70

- 710

- 72

- 8

- 84

- 90

- a

- võime

- Võimalik

- MEIST

- üle

- absoluutne

- akadeemiline

- aktsepteerima

- Nõustub

- juurdepääs

- juurdepääsetav

- majutada

- Vastavalt

- täpsus

- täpne

- saavutada

- Saavutab

- saavutamisel

- kinnitada

- üle

- Aktiveerimine

- aktiveerimised

- õigusaktid

- kohandama

- kohandamine

- lisama

- lisades

- lisamine

- Täiendavad lisad

- aadress

- aadressid

- Vastuvõtmine

- edusammud

- nõuanne

- pärast

- vastu

- Agent

- AI

- ai uuringud

- Eesmärgid

- AL

- sama

- Materjal: BPA ja flataatide vaba plastik

- võimaldama

- Lubades

- võimaldab

- mööda

- Ka

- alternatiiv

- Kuigi

- alati

- keset

- vahel

- summa

- summad

- an

- analüüs

- Analüütiline

- ja

- Teine

- vastus

- mistahes

- API

- ilmuma

- rakendused

- kehtima

- lähenemine

- asjakohane

- umbes

- arhitektuuri-

- arhitektuur

- OLEME

- valdkondades

- ümber

- Array

- Kunst

- artikkel

- kaubad

- kunstlik

- tehisintellekti

- AS

- Abi

- assistendid

- seotud

- ühendused

- At

- tähelepanu

- autorid

- automatiseerima

- saadaval

- keskmine

- vältima

- auhind

- Saldo

- baar

- baas

- põhineb

- põhiline

- alus

- BE

- sest

- muutuma

- enne

- on

- alla

- võrrelda

- kriteeriumid

- Kasu

- Parem

- vahel

- erapoolikus

- kalduvusi

- Miljard

- Raamatud

- Bootstrap

- mõlemad

- piirid

- läbimurre

- läbimurdeid

- BRIDGE

- lai

- ehitama

- Ehitus

- ehitatud

- kuid

- by

- kutsutud

- CAN

- kandidaat

- ei saa

- võimeid

- võimeline

- Võimsus

- ettevaatlik

- juhul

- katastroofiline

- Põhjus

- tegevjuht

- Tegevjuht ja asutaja

- raske

- võimalus

- muutma

- jututoad

- ChatGPT

- laastud

- nõudma

- klassifikatsioon

- Cloud

- Asutaja

- kood

- SIDUS

- kogumine

- kombinatsioon

- kombinatsioonid

- Tulema

- kohustus

- KOMMUNIKATSIOON

- kogukond

- võrreldes

- kokkusobiv

- konkurentsivõimeline

- täiendavad

- keeruline

- Vastavus

- komponendid

- arvutamine

- Arvutama

- arvuti

- arvutustehnika

- kontseptuaalne

- Murettekitav

- konfiguratsioon

- KINNITATUD

- ühendamine

- Järelikult

- kaalutlused

- ehitus

- sisu

- kontekst

- kontekstid

- jätkama

- kontrast

- Vestlus

- vestlused

- Konverteerimine

- parandada

- Vastav

- Maksma

- kulud

- võiks

- looma

- loodud

- Loominguline

- usutav

- otsustav

- Praegune

- klient

- Kasutajatugi

- Klienditugi

- viimase peal

- iga päev

- andmed

- andmepunktid

- andmekogumid

- kuupäev

- otsustatud

- vähenema

- sügav

- Deepmind

- annab

- näitama

- Näidatud

- näitab

- näidates

- Demod

- Olenevalt

- juurutamine

- kavandatud

- Vaatamata

- detailid

- arendama

- Arendajad

- arenev

- & Tarkvaraarendus

- Dialoog

- Dialoog

- raske

- puuetega

- Avalikustama

- Diskrimineerimine

- eristama

- mitu

- do

- dokument

- dokumendid

- ei

- Ülekaal

- Ära

- tosin

- ajam

- dubleeritud

- kaks

- ajal

- e

- e-kaubandus

- E&T

- iga

- Varajane

- lihtsam

- haridus-

- mõju

- tõhusalt

- efektiivsus

- tõhus

- jõupingutusi

- kõrvaldatud

- tekkinud

- võimaldama

- võimaldades

- haarav

- kaasamine

- Inglise

- suurendama

- tõhustatud

- lisaseadmed

- suurendamine

- tagades

- oluline

- looma

- kehtestab

- eetiline

- hinnatud

- hindamine

- hindamised

- Isegi

- Iga

- kõik

- tõend

- areneb

- läbivaatamine

- näide

- näited

- ületab

- erandlik

- põnev

- ainult

- eksponaadid

- olemasolevate

- Laiendama

- katseid

- teadmised

- Avastades

- väline

- f1

- hõlbustada

- tegurid

- Langema

- pere

- kaugele

- lummav

- tempokas

- tunnusjoon

- Objekte

- FUNKTSIOONID

- tagasiside

- vähe

- vähem

- väli

- Joonis

- filtreerimine

- leidma

- esimene

- Määrama

- fikseeritud

- järgima

- Järel

- eest

- vormid

- Sihtasutused

- Asutaja

- Raamistik

- Alates

- külmutatud

- funktsioon

- põhiline

- põhimõtteliselt

- edasi

- tulevik

- saadud

- lõhe

- SUGU

- tekitama

- loodud

- genereerib

- teeniva

- põlvkond

- generatiivne

- Generatiivne AI

- generaator

- saama

- GitHub

- Pilk

- Globaalne

- Go

- eesmärk

- läheb

- hea

- Valitsus

- GPU

- klass

- murranguline

- Grupp

- olnud

- juhtub

- Raske

- riistvara

- kahjulik

- Olema

- võttes

- tervishoid

- siin

- kvaliteetne

- kõrgresolutsiooniga

- kõrge riskiga

- rohkem

- kõrgeim

- omab

- Kuidas

- aga

- HTML

- HTTPS

- tohutu

- inim-

- sajad

- hype

- Hüperparameetrite häälestamine

- idee

- identifitseerimiseks

- if

- pilt

- pildid

- tohutu

- täitmine

- rakendatud

- mõjud

- oluline

- muljetavaldav

- parandama

- paranenud

- paranemine

- parandusi

- in

- sügavuti minev

- võimetus

- sisaldama

- lisatud

- Kaasa arvatud

- Inkorporeeritud

- sisaldab

- kaasates

- Suurendama

- kasvanud

- kasvav

- üha rohkem

- eraldi

- inimesed

- tööstusharudes

- tööstus

- info

- Infrastruktuur

- Algatab

- Innovatsioon

- sisend

- sisendite

- selle asemel

- institutsioonid

- juhised

- integreerima

- Intelligentsus

- tahtlus

- huvitav

- sisse

- kehtestama

- sisse

- Leiutatud

- probleem

- küsimustes

- IT

- ITS

- ise

- ajakirjandus

- jpg

- lihtsalt

- Võti

- peamised eesmärgid

- Teadma

- teadmised

- Labs

- puudus

- maastik

- keel

- Keeled

- suur

- suuremahuline

- suurim

- hiljemalt

- kiht

- kihid

- viima

- Õppida

- õppimine

- Õigus

- vähem

- Tase

- taset

- Finantsvõimendus

- võimendab

- võimendav

- Litsentseeritud

- elu

- kerge

- nagu

- Tõenäoliselt

- piirangud

- nimekiri

- Nimekirjad

- Elab

- Laama

- kohapeal

- loogiline

- Pikk

- Vaata

- Partii

- Madal

- masinad

- tehtud

- tegema

- TEEB

- palju

- Marcus

- Turg

- turu uuring

- Turundus

- materjal

- matemaatika

- max laiuse

- maksimaalne

- mai..

- tähendusrikas

- Meedia

- meditsiini-

- Merge

- Meta

- Metoodika

- meetodid

- Microsoft

- meeles

- minimaalne

- Väärinformatsioon

- eksitav

- vigu

- segatud

- ML

- mudel

- mudelid

- Kaasaegne

- modifitseeritud

- järelevalve

- rohkem

- kõige

- palju

- mitmekordne

- Moslemid

- Natural

- Loomulik keel

- Natural Language Processing

- loodus

- Vajadus

- vaja

- võrk

- Neural

- Neuraalne keel

- Närvivõrgus

- Uus

- uudised

- järgmine

- kena

- nlp

- eelkõige

- mitte midagi

- number

- arvukad

- eesmärk

- eesmärgid

- esineda

- of

- solvav

- ametlik

- sageli

- on

- ONE

- ones

- ainult

- avatud

- avatud lähtekoodiga

- OpenAI

- töötama

- Operations

- optimeerimine

- or

- organisatsioon

- Muu

- teised

- meie

- välja

- edestades

- Ületab tulemusi

- väljund

- tasumata

- üle

- enda

- palm

- Paber

- paradigma

- parameeter

- parameetrid

- osa

- osalema

- eriti

- sooritama

- mustrid

- sillutama

- Sillutis

- kohta

- täitma

- jõudlus

- esitades

- täidab

- fraasid

- valima

- Platon

- Platoni andmete intelligentsus

- PlatoData

- kaunad

- Punkt

- võrra

- Poliitika

- võimalik

- potentsiaal

- sisse

- võimas

- ennustada

- eelistatud

- eelmine

- eelkõige

- Eelnev

- prioriteetsuse

- Probleem

- probleeme

- protsess

- Protsessid

- töötlemine

- tootma

- Toode

- tootlikkus

- professionaalne

- Programming

- programmeerimiskeeled

- Edu

- paljutõotav

- omadused

- teeb ettepaneku

- varaline

- protokollid

- anda

- tingimusel

- annab

- avalikult

- avaldatud

- eesmärkidel

- Lükkamine

- Python

- pütorch

- kvalitatiivne

- kvaliteet

- küsimus

- Küsimused

- kiiresti

- Rass

- valik

- kiiresti

- pigem

- Lugemine

- reaalne

- päris elu

- päris maailm

- hiljuti

- hiljuti

- tunnustamine

- tunnistama

- vähendama

- vähendamine

- režiimid

- tugevdamise õppimine

- vabastama

- vabastatud

- asjakohane

- usaldusväärne

- usaldusväärsed allikad

- religioon

- tuginedes

- jääma

- jäi

- tähelepanuväärne

- asendatakse

- Aruanded

- esindamine

- Taotlusi

- nõudma

- Vajab

- teadustöö

- Teaduskogukond

- Teadlased

- ressursimahukas

- suhtes

- vastates

- vastus

- vastuste

- piiratud

- kaasa

- Tulemused

- säilitab

- Arvustused

- murranguliseks muuta

- revolutsiooniliselt

- riskide

- võistlus

- jõuline

- rollid

- ruum

- ohutu

- ohutus

- müügijõud

- sama

- Skaala

- Kaalud

- ketendamine

- stsenaariumid

- stseenide

- Kool

- skoor

- hinded

- Hinded

- sujuvalt

- Teine

- tundub

- nähtud

- väljavalitud

- tundlik

- eri

- Seeria

- tõsine

- teenus

- Teenused

- komplekt

- kehtestamine

- mitu

- vapustatud

- Lühike

- näitama

- näitas

- Näitused

- kirjutama

- märkimisväärne

- märgatavalt

- Samamoodi

- ainsus

- olukordades

- SUURUS

- oskused

- väiksem

- So

- nii kaugel

- sotsiaalmeedia

- Sotsiaalse meedia

- Ühiskond

- tarkvara

- tarkvaraarenduse

- Ainult

- lahendus

- Lahendab

- mõned

- keeruline

- allikas

- Allikad

- Allhange

- spam

- konkreetse

- eriti

- spetsiifilisus

- tähelepanuväärne

- kõnest tekstiks

- kiirus

- Stabiilsus

- Stage

- etappidel

- standard

- standardite

- riik

- modernne

- statistiline

- statistika

- Veel

- Strateegia

- tugevused

- lööma

- Uuring

- mahukas

- edukas

- selline

- soovitama

- Soovitab

- KOKKUVÕTE

- parem

- järelevalve

- toetama

- ületas

- süsteem

- süsteemid

- Läbirääkimised

- Ülesanne

- ülesanded

- meeskond

- Tehniline

- tehnikat

- Tehnoloogiad

- tingimused

- test

- teksti genereerimine

- Tekst kõneks

- kui

- tänan

- et

- .

- Tulevik

- Riik

- maailm

- oma

- Neile

- SIIS

- Seal.

- sellega

- seetõttu

- Need

- nad

- mõtlema

- kolmanda osapoole

- see

- need

- kuigi?

- tuhandeid

- kolm

- Läbi

- korda

- et

- tänane

- kokku

- sümboolne

- Tokeniseerimine

- märgid

- liiga

- töövahendid

- ülemine

- TOPBOOTID

- teema

- Teemasid

- suunas

- traditsiooniline

- Rong

- koolitatud

- koolitus

- üle

- trafo

- transformeerivate

- Tõlge

- triljon

- Turing

- juhendamine

- kaks

- tingimusteta

- all

- mõistma

- mõistmine

- võtma

- kahtlemata

- kahjuks

- Universum

- erinevalt

- ajakohane

- Uudised

- kasutama

- Kasutatud

- Kasutaja

- kasutusalad

- kasutamine

- kasutab ära

- sort

- eri

- suur

- mitmekülgne

- väga

- Video

- Videod

- virtuaalne

- nägemus

- VOX

- oli

- Tee..

- we

- web

- Hästi

- olid

- M

- millal

- mis

- kuigi

- WHO

- kogu

- lai

- Lai valik

- Wikipedia

- will

- koos

- jooksul

- ilma

- sõnad

- Töö

- koos töötama

- maailm

- kirjutamine

- aastat

- veel

- sa

- sephyrnet

- Nullkaadri õpe