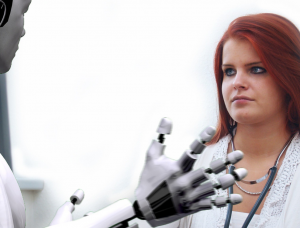

La inteligencia artificial (IA) ha revolucionado diversas industrias, ofreciendo numerosos beneficios y oportunidades. Sin embargo, han surgido preocupaciones sobre la posibilidad de que la IA perpetúe la discriminación y los prejuicios. Este artículo explora el tema de la discriminación por IA y arroja luz sobre los desafíos de identificar y abordar los sesgos integrados en los sistemas de IA. Los expertos de la industria expresan dudas sobre las implicaciones morales y éticas de la IA, citando preocupaciones sobre la desinformación, los sesgos en los algoritmos y la generación de contenido engañoso. A medida que se intensifican los debates en torno a la IA, existe un creciente llamado a una regulación significativa para garantizar la transparencia, la rendición de cuentas y la protección de los derechos fundamentales.

Desafíos para las industrias financieras con IA

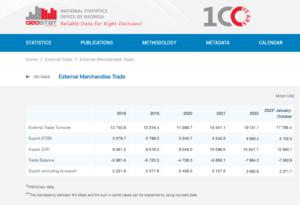

Según Nabil Manji, director de criptografía y Web3 en Worldpay by FIS, la eficacia de los productos de IA depende en gran medida de la calidad del material fuente utilizado para la formación. En una entrevista con CNBC, Manji explicó que dos factores principales contribuyen al rendimiento de la IA: los datos a los que tiene acceso y las capacidades del modelo de lenguaje grande.

Para ilustrar la importancia de los datos, Manji mencionó que empresas como Reddit han declarado públicamente restricciones a la extracción de datos, exigiendo el pago por el acceso. En el sector de servicios financieros, destacó el desafío de los sistemas de datos fragmentados en varios idiomas y formatos. Esta falta de consolidación y armonización limita la eficacia de los productos impulsados por la IA, especialmente en comparación con industrias con infraestructura de datos estandarizada y modernizada.

Según Manji, la utilización de blockchain o tecnología de contabilidad distribuida puede ofrecer una solución potencial para abordar este problema. Este enfoque innovador puede proporcionar una mayor transparencia de los datos fragmentados almacenados dentro de los intrincados sistemas de los bancos convencionales. Sin embargo, reconoció que la naturaleza altamente regulada y de lento movimiento de los bancos podría impedir su capacidad para adoptar rápidamente nuevas herramientas de inteligencia artificial, a diferencia de las empresas de tecnología más ágiles como Microsoft y Google, que han estado a la vanguardia del impulso de la innovación durante los últimos años. décadas.

Teniendo en cuenta estos factores, resulta evidente que la industria financiera enfrenta desafíos únicos al aprovechar la IA debido a las complejidades de la integración de datos y la naturaleza inherente del sector bancario.

Según Rumman Chowdhury, exjefe de ética, transparencia y responsabilidad del aprendizaje automático en Twitter, los préstamos son un ejemplo notable de cómo el sesgo en los sistemas de inteligencia artificial puede afectar negativamente a las comunidades marginadas. En su intervención en una mesa redonda celebrada en Ámsterdam, Chowdhury destacó la práctica histórica de la “línea roja” en Chicago durante la década de 1930. La línea roja implicó negar préstamos a vecindarios predominantemente afroamericanos basándose en la demografía racial.

Chowdhury explicó que aunque los algoritmos modernos pueden no incluir explícitamente la raza como un dato, los sesgos aún pueden codificarse implícitamente. Al desarrollar algoritmos para evaluar el riesgo de los distritos y las personas con fines crediticios, los datos históricos que contienen sesgos pueden perpetuar la discriminación sin darse cuenta.

Angle Bush, la visionaria detrás de Black Women in Artificial Intelligence, destacó la importancia de reconocer los peligros asociados con la reproducción de sesgos incrustados en datos históricos al emplear sistemas de inteligencia artificial para tomar determinaciones de aprobación de préstamos. Esta práctica puede llevar al rechazo automático de solicitudes de préstamos de comunidades marginadas, perpetuando así las desigualdades raciales o de género.

Frost Li, un desarrollador experimentado de IA, señaló los desafíos de la personalización en Integración de IA. La selección de "características principales" para entrenar modelos de IA a veces puede implicar factores no relacionados que pueden conducir a resultados sesgados. Li proporcionó un ejemplo de cómo las nuevas empresas de tecnología financiera dirigidas a extranjeros podrían enfrentar diferentes criterios de evaluación crediticia en comparación con los bancos locales, que están más familiarizados con las escuelas y comunidades locales.

Niklas Guske, director de operaciones de Taktile, una startup especializada en automatizar la toma de decisiones para fintechs, aclaró que la IA generativa no se suele utilizar para crear calificaciones crediticias o calificaciones de riesgo de los consumidores. Por el contrario, su fortaleza radica en el preprocesamiento de datos no estructurados, como archivos de texto, para mejorar la calidad de los datos para los modelos de suscripción convencionales.

En resumen, el uso de la IA en los préstamos y los servicios financieros genera preocupaciones sobre el sesgo y la discriminación. Los sesgos históricos incorporados en los datos y la selección de características irrelevantes durante el entrenamiento de la IA pueden conducir a resultados injustos. Es fundamental que los bancos y las instituciones financieras reconozcan y aborden estos problemas para evitar la perpetuación inadvertida de la discriminación al implementar soluciones de IA.

Prueba de discriminación por IA

Demostrar la discriminación basada en la IA puede ser un desafío, como lo ponen de relieve ejemplos como el caso de Apple y Goldman Sachs. El Departamento de Servicios Financieros del Estado de Nueva York desestimó las acusaciones de imponer límites más bajos a la Apple Card para las mujeres, citando una falta de pruebas que lo fundamenten.

Kim Smouter, directora de la Red Europea Contra el Racismo, señala que el despliegue masivo de la IA genera opacidad en los procesos de toma de decisiones, lo que dificulta que las personas identifiquen y aborden la discriminación.

Smouter explica que las personas suelen tener un conocimiento limitado de cómo funcionan los sistemas de IA, lo que dificulta la detección de casos de discriminación o sesgos sistémicos. Se vuelve aún más complejo cuando la discriminación es parte de un problema más amplio que afecta a varias personas. Smouter hace referencia al escándalo holandés de bienestar infantil, donde un gran número de solicitudes de prestaciones fueron etiquetadas erróneamente como fraudulentas debido a prejuicios institucionales. Descubrir tales disfunciones es un desafío, y obtener reparación puede ser difícil y llevar mucho tiempo, lo que lleva a daños importantes y a veces irreversibles.

Estos ejemplos ilustran las dificultades inherentes a la hora de fundamentar la discriminación basada en la IA y obtener reparaciones cuando se produce dicha discriminación. La complejidad de los sistemas de inteligencia artificial y la falta de transparencia en los procesos de toma de decisiones pueden dificultar que las personas reconozcan y aborden casos de discriminación de manera efectiva.

Según Chowdhury, existe una necesidad apremiante de que un organismo regulador global similar a las Naciones Unidas aborde los riesgos asociados con la IA. Si bien la IA ha mostrado una innovación notable, los tecnólogos y especialistas en ética han planteado preocupaciones con respecto a sus implicaciones morales y éticas. Estas preocupaciones abarcan cuestiones como la desinformación, los prejuicios raciales y de género incorporados en los algoritmos de IA y la generación de contenido engañoso mediante herramientas como ChatGPT.

Chowdhury expresa su preocupación por entrar en un mundo de posverdad donde la información en línea, incluidos texto, vídeo y audio, deja de ser confiable debido a la IA generativa. Esto plantea preguntas sobre cómo podemos garantizar la integridad de la información y cómo podemos confiar en ella para tomar decisiones informadas. Con la Ley de IA de la Unión Europea como ejemplo, una regulación significativa de la IA es crucial en este momento. Sin embargo, existen preocupaciones sobre el largo plazo que se necesita para que las propuestas regulatorias entren en vigor, lo que podría retrasar las acciones necesarias.

Smouter enfatiza la necesidad de una mayor transparencia y responsabilidad en los algoritmos de IA. Esto incluye hacer que los algoritmos sean más comprensibles para los no expertos, realizar pruebas y publicar resultados, establecer procesos de quejas independientes, realizar auditorías e informes periódicos e involucrar a comunidades racializadas en el diseño y despliegue de tecnología. Se prevé que la aplicación de la Ley de IA, que adopta una perspectiva de derechos fundamentales e introduce conceptos como la reparación, comenzará en aproximadamente dos años. Reducir este cronograma sería ventajoso para defender la transparencia y la rendición de cuentas como aspectos integrales de la innovación.

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoData.Network Vertical Generativo Ai. Empodérate. Accede Aquí.

- PlatoAiStream. Inteligencia Web3. Conocimiento amplificado. Accede Aquí.

- PlatoESG. Automoción / vehículos eléctricos, Carbón, tecnología limpia, Energía, Ambiente, Solar, Gestión de residuos. Accede Aquí.

- Desplazamientos de bloque. Modernización de la propiedad de compensaciones ambientales. Accede Aquí.

- Fuente: https://www.forexnewsnow.com/fintech/the-urgency-of-addressing-ai-discrimination-transparency-accountability-and-regulatory-timelines/

- :posee

- :es

- :no

- :dónde

- a

- capacidad

- Nuestra Empresa

- de la máquina

- seguimiento semanal

- reconoció

- Actúe

- acciones

- dirección

- direccionamiento

- adoptar

- ventajoso

- negativamente

- afectar

- Africano

- en contra

- ágil

- AI

- Ley de IA

- Sistemas de IA

- Entrenamiento de IA

- algoritmos

- Alegaciones

- Aunque

- American

- Ámsterdam

- an

- y

- anticipado

- Apple

- Tarjeta de manzana

- aplicaciones

- enfoque

- aprobación

- aproximadamente

- somos

- artículo

- artificial

- inteligencia artificial

- AS

- aspectos

- evaluar

- evaluación

- asociado

- At

- audio

- auditorías

- Automático

- automatizar

- Bancario

- sector bancario

- Bancos

- basado

- BE

- a las que has recomendado

- se convierte en

- esto

- detrás de

- es el beneficio

- beneficios

- parcialidad

- parcial

- los prejuicios

- Negro

- blockchain

- cuerpo

- Trae

- más amplio

- by

- llamar al

- PUEDEN

- capacidades

- tarjeta

- case

- Reto

- retos

- desafiante

- ChatGPT

- Chicago

- sus hijos

- reclamaciones

- aclarado

- CNBC

- Comunidades

- Empresas

- en comparación con

- queja

- integraciones

- complejidades

- complejidad

- conceptos

- Inquietudes

- conductible

- consolidación

- Clientes

- contiene

- contenido

- contrario

- contribuir

- convencional

- arrullo

- Creamos

- crédito

- criterios

- crucial

- cripto

- peligros

- datos

- infraestructura de datos

- integración de datos

- calidad de los datos

- debates

- décadas

- Toma de Decisiones

- decisiones

- Demografía

- Departamento

- depende

- despliegue

- Diseño

- Developer

- el desarrollo

- una experiencia diferente

- difícil

- dificultades

- Director

- descubrimiento

- Discriminación

- discusión

- distribuidos

- Libro mayor distribuido

- tecnología de libro distribuido

- conducción

- dos

- durante

- Holandés

- Eficaz

- de manera eficaz

- eficacia

- integrado

- surgido

- enfatiza

- abarcar

- cumplimiento

- mejorar

- mejorado

- garantizar

- que entran a los

- especialmente

- el establecimiento

- ético

- ética

- Europea

- Incluso

- evidencia sólida

- evidente

- ejemplo

- ejemplos

- experimentado

- explicado

- Explica

- explora

- expreso

- Cara

- caras

- factores importantes

- familiar

- Caracteristicas

- pocos

- archivos

- financiero

- industrias financieras

- Instituciones financieras

- servicios financieros

- Fintech

- startups fintech

- Fintechs

- FIS

- primer plano

- Ex

- fragmentado

- fraudulento

- Desde

- fundamental

- Género

- generación de AHSS

- generativo

- IA generativa

- Buscar

- Goldman

- Goldman Sachs

- mayor

- Creciendo

- daño

- Tienen

- he

- cabeza

- fuertemente

- Destacado

- altamente

- histórico

- Cómo

- Sin embargo

- HTTPS

- Identifique

- identificar

- implementación

- implicaciones

- importancia

- imponente

- in

- incluir

- incluye

- Incluye

- independientes

- individuos

- industrias

- energético

- desigualdades

- información

- informó

- EN LA MINA

- inherente

- Innovation

- originales

- Institucional

- instituciones

- un elemento indispensable

- integración

- integridad

- Intelligence

- Entrevista

- dentro

- Presenta

- involucrar

- involucra

- que implica

- cuestiones

- IT

- SUS

- especialistas

- Falta

- idioma

- Idiomas

- large

- Lead

- líder

- aprendizaje

- Libro mayor

- préstamo

- aprovechando

- li

- se encuentra

- luz

- como

- Limitada

- límites

- préstamo

- Préstamos

- local

- BANCOS LOCALES

- inferior

- máquina

- máquina de aprendizaje

- Inicio

- para lograr

- Realizar

- Misa

- materiales

- Puede..

- significativo

- mencionado

- Microsoft

- podría

- Desinformación

- engañoso

- modelo

- modelos

- Moderno

- momento

- moral

- más,

- múltiples

- Naciones

- Naturaleza

- necesario

- ¿ Necesita ayuda

- del sistema,

- Nuevo

- New York

- Estado de Nueva York

- Departamento de Servicios Financieros del Estado de Nueva York

- no expertos

- notable

- número

- numeroso

- numerosos beneficios

- obtención

- of

- LANZAMIENTO

- que ofrece

- a menudo

- on

- en línea

- funcionar

- Del Mañana

- or

- salir

- resultados

- panel

- panel de discusión

- parte

- pasado

- pago

- actuación

- periódico

- personalización

- la perspectiva

- Platón

- Inteligencia de datos de Platón

- PlatónDatos

- punto

- puntos

- posible

- la posibilidad

- predominantemente

- prensado

- evitar

- Problema

- en costes

- Productos

- Propuestas

- Protección

- proporcionar

- previsto

- en público

- DTP

- fines

- calidad

- Preguntas

- Carrera

- racismo

- elevado

- plantea

- reconocer

- la reducción de

- referencias

- con respecto a

- regulados

- Regulación

- regulador

- confiar

- relevantes

- Informes

- restricciones

- Resultados

- revolucionado

- derechos

- Riesgo

- riesgos

- Sachs

- Escándalo

- Escuelas

- puntuaciones

- tanteo

- raspado

- sector

- seleccionar

- selección

- Servicios

- mostrado

- significado

- importante

- similares

- a medida

- Soluciones

- Fuente

- hablar

- especializada

- inicio

- Startups

- Estado

- Departamento de Estado

- Sin embargo

- almacenados

- fuerza

- tal

- RESUMEN

- Rodeando

- rápidamente

- sistémico

- Todas las funciones a su disposición

- entrada

- toma

- orientación

- tecnología

- empresas de tecnología

- tecnólogos

- Tecnología

- pruebas

- esa

- La

- La Fuente

- su

- Ahí.

- de este modo

- Estas

- así

- prolongado

- calendario

- líneas de tiempo

- a

- tema

- Formación

- Transparencia

- dos

- típicamente

- comprensible

- aseguramiento

- injusto

- único

- United

- naciones unidas

- diferente a

- Defender

- urgencia

- utilizan el

- usado

- diversos

- Video

- visionario

- we

- Web3

- Bienestar

- tuvieron

- cuando

- que

- mientras

- dentro de

- Mujeres

- mundo

- WorldPay

- preocuparse

- se

- años

- york

- zephyrnet