lagos de datos y capas semánticas han existido durante mucho tiempo, cada uno viviendo en sus propios jardines amurallados, estrechamente acoplados a casos de uso bastante limitados. A medida que la infraestructura de datos y análisis migra a la nube, muchos cuestionan cómo encajan estos componentes tecnológicos fundamentales en la pila moderna de datos y análisis. En este artículo, profundizaremos en cómo un lago de datos y una capa semántica en conjunto alteran la relación tradicional entre los lagos de datos y la infraestructura de análisis. Aprenderemos cómo un lago semántico puede simplificar drásticamente arquitecturas de datos en la nube, elimine el movimiento de datos innecesario y reduzca el tiempo de valorización y los costos de la nube.

La arquitectura tradicional de datos y análisis

En 2006, Amazon presentó Amazon Web Services (AWS) como una nueva forma de descargar el centro de datos local a la nube. Un servicio central de AWS era su almacén de datos de archivos y con eso nació el primer lago de datos en la nube, Amazon S3. A partir de entonces, otros proveedores de la nube introducirían sus propias versiones de la infraestructura del lago de datos en la nube.

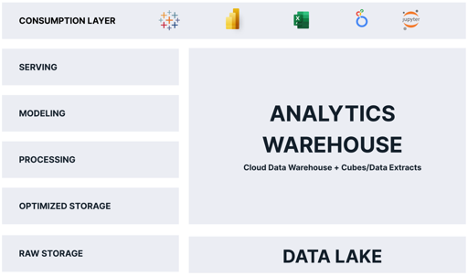

Durante la mayor parte de su vida, el lago de datos en la nube ha sido relegado a desempeñar el papel de tonto, barato almacenamiento de datos - Una puesta en escena área para datos sin procesar, hasta que los datos pudieran ser procesados en algo útil. Para el análisis, el lago de datos sirvió como un contenedor de datos hasta que se pudiera copiar y cargar en una plataforma de análisis optimizada, generalmente un almacén de datos en la nube relacional que alimentaba cubos OLAP, extractos de datos de herramientas de inteligencia comercial (BI) patentadas como Tableau Hyper o Power BI Premium, o todo lo anterior. Como resultado de este patrón de procesamiento, los datos debían almacenarse al menos dos veces, una en su forma sin procesar y otra en su forma "analítica optimizada".

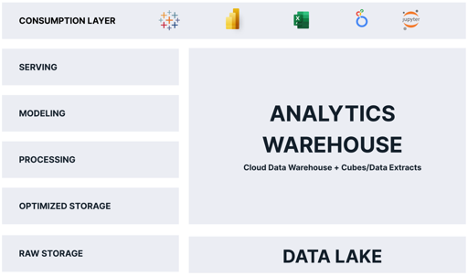

No es sorprendente que la mayoría de las arquitecturas tradicionales de análisis en la nube se parezcan al siguiente diagrama:

Como puede ver, el "almacén de análisis" es responsable de la mayoría de las funciones que entregan análisis a los consumidores. El problema de esta arquitectura es el siguiente:

- Los datos se almacenan dos veces, lo que aumenta los costos y genera complejidad operativa.

- Los datos en el almacén de análisis son una instantánea, lo que significa que los datos quedan obsoletos al instante.

- Los datos en el almacén de análisis suelen ser un subconjunto de los datos en el lago de datos, lo que limita las preguntas que los consumidores pueden hacer.

- El almacén de análisis se escala por separado y de manera diferente a la plataforma de datos en la nube, lo que presenta costos adicionales, problemas de seguridad y complejidad operativa.

Dados estos inconvenientes, podría preguntarse "¿Por qué los arquitectos de datos en la nube elegirían este patrón de diseño?" La respuesta está en las demandas de los consumidores analíticos. Si bien, en teoría, el lago de datos podría brindar consultas analíticas directamente a los consumidores, en la práctica, el lago de datos es demasiado lento e incompatible con las herramientas de análisis populares.

¡Ojalá el lago de datos pudiera brindar los beneficios de un almacén de análisis y pudiéramos evitar almacenar datos dos veces!

El nacimiento de la casa del lago de datos

El término "Lakehouse" vio su debut en 2020 con el libro blanco seminal Databricks “¿Qué es una casa del lago?” por Ben Lorica, Michael Armbrust, Reynold Xin, Matei Zaharia y Ali Ghodsi. Los autores introdujeron la idea de que el lago de datos podría servir como un motor para entregar análisis, no solo como un almacén de archivos estáticos.

Los proveedores de lagos de datos cumplieron su visión mediante la introducción de motores de consulta escalables y de alta velocidad que funcionan con archivos de datos sin procesar en el lago de datos y exponen una interfaz SQL estándar ANSI. Con esta innovación clave, los defensores de esta arquitectura argumentan que los lagos de datos pueden comportarse como un almacén de análisis, sin necesidad de duplicar datos.

Sin embargo, resulta que el almacén de análisis realiza otras funciones vitales que no se satisfacen solo con la arquitectura del lago de datos, que incluyen:

- Entregar consultas de "velocidad de pensamiento" (consultas en menos de 2 segundos) de manera consistente en una amplia gama de consultas.

- Presentar una capa semántica amigable para los negocios que permite a los consumidores hacer preguntas sin necesidad de escribir SQL.

- Aplicar el gobierno y la seguridad de los datos en el momento de la consulta.

Entonces, para que un lago de datos realmente reemplace el almacén de análisis, necesitamos algo más.

El papel de la capa semántica

He escrito mucho sobre el papel del capa semántica en la pila de datos moderna. En resumen, una capa semántica es una vista lógica de los datos comerciales que aprovecha la tecnología de virtualización de datos para traducir los datos físicos en datos amigables para el negocio en el momento de la consulta.

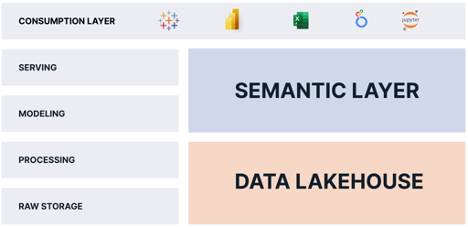

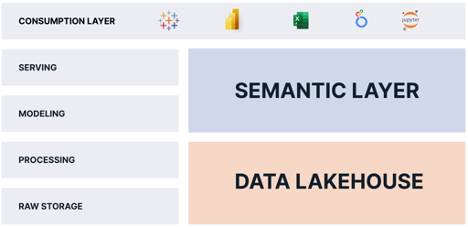

Al agregar una plataforma de capa semántica sobre un lago de datos, podemos eliminar las funciones del almacén de análisis por completo porque la plataforma de capa semántica:

- Ofrece "consultas a la velocidad del pensamiento" en el lago de datos mediante la virtualización de datos y el ajuste automatizado del rendimiento de las consultas.

- Ofrece una capa semántica amigable para los negocios que reemplaza las vistas semánticas propietarias que están integradas dentro de cada herramienta de BI y permite a los usuarios comerciales hacer preguntas sin necesidad de escribir consultas SQL.

- Ofrece control de datos y seguridad en el momento de la consulta.

Una plataforma de capa semántica entrega las piezas faltantes que faltan en el lago de datos. Al combinar una capa semántica con un lago de datos, las organizaciones pueden:

- Elimine las copias de datos y simplifique las canalizaciones de datos.

- Consolide el gobierno y la seguridad de los datos.

- Ofrezca una "fuente única de verdad" para las métricas comerciales.

- Reduzca la complejidad operativa manteniendo los datos en el lago de datos.

- Proporcione acceso a más datos y datos más oportunos a los consumidores de análisis.

La casa del lago semántico: todos ganan

Todo el mundo gana con esta arquitectura. Los consumidores obtienen acceso a datos más detallados sin latencia. Los equipos de TI e ingeniería de datos tienen menos datos para mover y transformar. Finanzas gasta menos dinero en costos de infraestructura en la nube.

Como puede ver, al combinar una capa semántica con un lago de datos, las organizaciones pueden simplificar sus operaciones de análisis y datos, y entregar más datos, más rápido, a más consumidores, con menos costo.

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- Platoblockchain. Inteligencia del Metaverso Web3. Conocimiento amplificado. Accede Aquí.

- Fuente: https://www.dataversity.net/the-semantic-lakehouse-explained/

- :es

- 1

- 2020

- a

- Nuestra Empresa

- arriba

- de la máquina

- Adicionales

- Todos

- permite

- solo

- Amazon

- Amazon Web Services

- Servicios Web de Amazon (AWS)

- Pruebas analíticas

- Analytics

- y

- https://www.youtube.com/watch?v=xB-eutXNUMXJtA&feature=youtu.be

- arquitectura

- somos

- Reservada

- argumentar

- en torno a

- artículo

- AS

- At

- Autorzy

- Confirmación de Viaje

- AWS

- BE

- porque

- a continuación

- beneficios

- entre

- nacido

- inteligencia empresarial

- by

- PUEDEN

- cases

- Reubicación

- desafiante

- barato

- Elige

- Soluciones

- infraestructura de nube

- combinar

- complejidad

- componentes

- Inquietudes

- Clientes

- copias

- Core

- Cost

- Precio

- podría

- acoplado

- crea

- datos

- Data Center

- Lago de datos

- Plataforma de datos

- almacenamiento de datos

- Databricks

- VERSIDAD DE DATOS

- entregamos

- liberado

- entregar

- entrega

- demandas

- Diseño

- directamente

- dramáticamente

- inconvenientes

- cada una

- ya sea

- eliminarlos

- integrado

- Motor

- Ingeniería

- motores

- explicado

- Extractos

- bastante

- más rápida

- alimentación

- Archive

- archivos

- financiar

- Nombre

- cómodo

- siguiente

- formulario

- Desde

- funciones

- Jardines

- obtener

- gobierno

- Tienen

- Alta

- tenencia

- Cómo

- HTML

- HTTPS

- idea

- in

- Incluye

- Los aumentos

- EN LA MINA

- Innovation

- Intelligence

- Interfaz

- introducir

- Introducido

- Presentamos

- IT

- SUS

- acuerdo

- Clave

- lago

- Estado latente

- .

- APRENDE:

- apalancamientos

- Vida

- como

- límites

- alga viva

- lógico

- Largo

- largo tiempo

- Mira

- parece

- Lote

- Mayoría

- muchos

- max-ancho

- significa

- Métrica

- Michael

- podría

- que falta

- Moderno

- dinero

- más,

- MEJOR DE TU

- movimiento

- movimiento

- ¿ Necesita ayuda

- necesidad

- Nuevo

- of

- on

- operativos.

- Operaciones

- optimizado

- para las fiestas.

- Otro

- EL DESARROLLADOR

- Patrón de Costura

- actuación

- realiza

- los libros físicos

- piezas

- plataforma

- Platón

- Inteligencia de datos de Platón

- PlatónDatos

- jugando

- Popular

- industria

- Power BI

- Premium

- Problema

- tratamiento

- propietario

- Preguntas

- distancia

- Crudo

- datos en bruto

- reducir

- relación

- reemplazar

- responsable

- resultado

- Función

- satisfecho

- escalable

- escamas

- segundos

- EN LINEA

- ayudar

- de coches

- Servicios

- simplificar

- lento

- Instantánea

- algo

- Fuente

- velocidad

- SQL

- montón

- estándar

- tienda

- almacenados

- resumir

- Cuadro

- equipos

- Tecnología

- esa

- El

- su

- Estas

- pensamiento

- fuertemente

- equipo

- a

- juntos

- demasiado

- del IRS

- parte superior

- tradicional

- Transformar

- la traducción

- Twice

- típicamente

- bajo

- utilizan el

- usuarios

- propuesta de

- vendedores

- Ver

- vistas

- visión

- vital

- Amurallado

- Manejo de

- Camino..

- web

- servicios web

- que

- mientras

- complejo de salvador blanco

- amplio

- Amplia gama

- seguirá

- TRIUNFOS

- sin

- Actividades:

- se

- escribir

- escrito

- zephyrnet