Hablé recientemente con Stelios Diamantidis (Arquitecto Distinguido, Jefe de Estrategia, Soluciones de Diseño Autónomo) sobre el anuncio de Synopsys en el 100th tapeout del cliente usando su solución DSO.ai. Mi preocupación sobre los artículos relacionados con la IA es evitar la exageración que rodea a la IA en general y, por el contrario, el escepticismo en reacción a esa exageración que lleva a algunos a descartar todas las afirmaciones de IA como aceite de serpiente. Estaba feliz de escuchar a Stelios reír y estar de acuerdo de todo corazón. Tuvimos una discusión muy fundamentada sobre lo que DSO.ai puede hacer hoy, lo que sus clientes de referencia ven en la solución (basado en lo que puede hacer hoy) y lo que me podría decir sobre la tecnología.

Qué hace DSO.ai

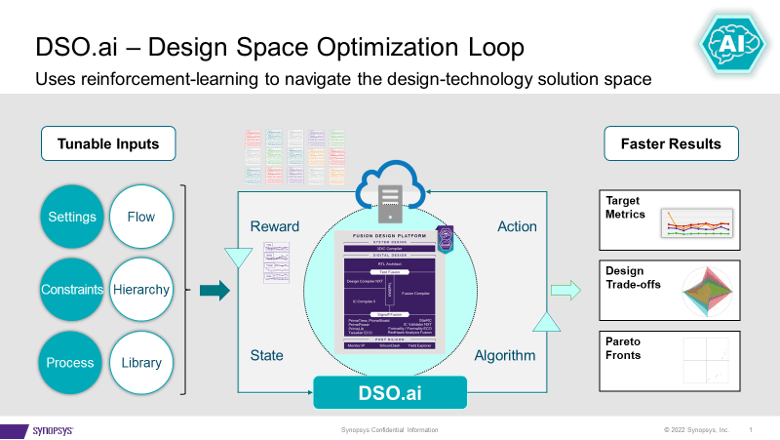

DSO.ai se combina con Fusion Compiler e IC Compiler II, lo que, como Stelios tuvo cuidado de enfatizar, significa que se trata de una solución de optimización a nivel de bloque; Los SoC completos aún no son un objetivo. Esto se ajusta a las prácticas de diseño actuales, ya que Stelios dijo que un objetivo importante es adaptarse fácilmente a los flujos existentes. El propósito de la tecnología es permitir que los ingenieros de implementación, a menudo un solo ingeniero, mejoren su productividad mientras exploran un espacio de diseño más grande para un mejor PPA que podría haber sido descubierto de otra manera.

Synopsys anunció el primer tapeout en el verano de 2021 y ahora ha anunciado 100 tapeouts. Eso habla bien de la demanda y la eficacia de una solución como esta. Stelios agregó que el valor se vuelve aún más obvio para las aplicaciones que deben instanciar un bloque muchas veces. Piense en un servidor de muchos núcleos, una GPU o un conmutador de red. Optimice un bloque una vez, cree instancias muchas veces, eso puede sumar una mejora significativa de PPA.

Pregunté si los clientes que hacen esto están trabajando a 7 nm o menos. Sorprendentemente, hay un uso activo hasta 40 nm. Un ejemplo interesante es un controlador de flash, un diseño que no es muy sensible al rendimiento pero que puede ejecutarse en decenas a cientos de millones de unidades. Reducir el tamaño incluso en un 5% aquí puede tener un gran impacto en los márgenes.

¿Qué hay debajo del capó?

DSO.ai se basa en el aprendizaje por refuerzo, un tema candente en estos días, pero no prometí exageraciones en este artículo. Le pedí a Stelios que profundizara un poco más, aunque no me sorprendió cuando dijo que no podía revelar demasiado. Lo que podía decirme era bastante interesante. Señaló que, en aplicaciones más generales, un ciclo a través de un conjunto de entrenamiento (una época) asume un método rápido (de segundos a minutos) para evaluar los siguientes pasos posibles, por ejemplo, a través de comparaciones de gradientes.

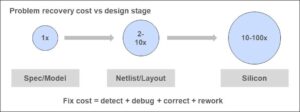

Pero el diseño de bloques serio no se puede optimizar con estimaciones rápidas. Cada prueba debe ejecutarse a través del flujo de producción completo, mapeándose a procesos de fabricación reales. Flujos que pueden tardar horas en ejecutarse. Parte de la estrategia para el aprendizaje por refuerzo efectivo dada esta restricción es el paralelismo. El resto es salsa secreta DSO.ai. Ciertamente, puede imaginar que si esa salsa secreta puede generar mejoras efectivas basadas en una época determinada, entonces el paralelismo acelerará el progreso a través de la próxima época.

Con ese fin, esta capacidad realmente debe ejecutarse en una nube para admitir el paralelismo. La nube local privada es una opción. Microsoft ha anunciado que están hospedando DSO.ai en Azure, y ST informa en el comunicado de prensa de DSO.ai que usaron esta capacidad para optimizar la implementación de un núcleo Arm. Me imagino que podría haber algunos debates interesantes sobre los pros y los contras de ejecutar una optimización en una nube pública en, digamos, 1000 servidores si la reducción del área vale la pena.

Valoración de los clientes

Synopsys afirma que los clientes (incluidos ST y SK Hynix en este anuncio) informan aumentos de productividad de 3x+, hasta un 25 % menos de energía total y una reducción significativa en el tamaño del troquel, todo con un uso reducido de los recursos generales. Dado lo que describió Stelios, esto me parece razonable. La herramienta permite la exploración de más puntos en el espacio de estado de diseño dentro de un programa determinado de lo que sería posible si esa exploración fuera manual. Siempre que el algoritmo de búsqueda (la salsa secreta) sea efectivo, por supuesto que encontraría un óptimo mejor que una búsqueda manual.

En resumen, ni exageración de IA ni aceite de serpiente. DSO.ai sugiere que AI está ingresando a la corriente principal como una extensión de ingeniería creíble para los flujos existentes. Puedes aprender más de la comunicado de prensa y desde este blog.

Comparte esta publicación a través de:

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- Platoblockchain. Inteligencia del Metaverso Web3. Conocimiento amplificado. Accede Aquí.

- Fuente: https://semiwiki.com/artificial-intelligence/324430-synopsys-design-space-optimization-hits-a-milestone/

- 100

- 2021

- a

- Acerca

- acelerar

- a través de

- lector activo

- adicional

- AI

- algoritmo

- Todos

- permite

- y

- anunció

- Anuncio

- aplicaciones

- Reservada

- ARM

- en torno a

- artículo

- autónomo

- evitar

- Azure

- basado

- se convierte en

- a continuación

- mejores

- Big

- Poco

- Bloquear

- cuidadoso

- ciertamente

- reclamaciones

- Soluciones

- cómo

- Protocolo de Tratamiento

- Desventajas

- controlador

- Core

- podría

- curso

- creíble

- Current

- cliente

- Clientes

- Cycle

- Días

- debates

- Demanda

- descrito

- Diseño

- El

- discusión

- Descartar

- Distinguido

- "Hacer"

- DE INSCRIPCIÓN

- cada una

- pasan fácilmente

- Eficaz

- eficacia

- enfatizar

- habilitar

- ingeniero

- Ingeniería

- certificados

- suficientes

- época

- estima

- Incluso

- ejemplo

- existente

- exploración

- Explorar

- extensión

- RÁPIDO

- Encuentre

- Nombre

- cómodo

- Flash

- de tus señales

- Flujos

- en

- ser completados

- fusión

- General

- dado

- objetivo

- GPU

- Ahorrar

- cabeza

- esta página

- Golpes

- hosting

- HOT

- HORAS

- HTTPS

- Bombo

- Impacto

- implementación

- importante

- mejorar

- es la mejora continua

- in

- Incluye

- Los aumentos

- interesante

- IT

- mayores

- risa

- APRENDE:

- aprendizaje

- Largo

- hecho

- Corriente principal

- manual

- Fabricación

- muchos

- cartografía

- márgenes

- max-ancho

- significa

- Método

- Microsoft

- podría

- hito

- millones

- minutos

- más,

- Neither

- del sistema,

- Next

- obvio

- Aceite

- ONE

- optimización

- Optimización

- optimizado

- óptimo

- Optión

- de otra manera

- total

- parte

- actuación

- Platón

- Inteligencia de datos de Platón

- PlatónDatos

- punto

- puntos

- posible

- Publicación

- industria

- prácticas

- prensa

- Comunicado de prensa

- privada

- en costes

- Producción

- productividad

- Progreso

- prometido

- PROS

- público

- nube pública

- propósito

- Búsqueda

- reacción

- real

- mejor

- recientemente

- Reducción

- la reducción de

- aprendizaje reforzado

- ,

- reporte

- Informes

- Recursos

- RESTO

- género

- Ejecutar

- correr

- Said

- programa

- Buscar

- segundos

- Secreto

- sensible

- grave

- set

- En Corto

- importante

- soltero

- Tamaño

- Escepticismo

- a medida

- Soluciones

- algo

- Espacio

- Habla

- Estado

- pasos

- Estrategia

- Sugiere

- verano

- SOPORTE

- sorprendido

- Switch

- ¡Prepárate!

- Target

- Tecnología

- El

- El Área

- su

- A través de esta formación, el personal docente y administrativo de escuelas y universidades estará preparado para manejar los recursos disponibles que derivan de la diversidad cultural de sus estudiantes. Además, un mejor y mayor entendimiento sobre estas diferencias y similitudes culturales permitirá alcanzar los objetivos de inclusión previstos.

- veces

- a

- hoy

- demasiado

- del IRS

- tema

- Total

- Formación

- juicio

- bajo

- unidades que

- utilizan el

- propuesta de

- vía

- ¿

- que

- mientras

- seguirá

- dentro de

- trabajando

- valor

- se

- zephyrnet