El aprendizaje automático (ML), una rama de la inteligencia artificial (IA), ha ganado mucha atención en los últimos años. ML se centra en entrenar computadoras para que aprendan de los datos, con la ayuda de algoritmos y modelos, para tomar decisiones o predicciones. En este enfoque de formación, las máquinas no tienen que programarse explícitamente. Las computadoras aprenden de la experiencia, al igual que los humanos. La IA va más allá del aprendizaje automático al abarcar diversas técnicas, como el procesamiento del lenguaje natural (PNL), la visión por computadora y la robótica. Su objetivo es crear máquinas inteligentes que puedan simular el comportamiento humano y realizar tareas complejas de forma autónoma. Comprender los conceptos básicos del aprendizaje automático es esencial para cualquier persona interesada en estos campos, ya que tienen un inmenso potencial para transformar industrias como la atención médica, las finanzas, el transporte y más.

In ML, las máquinas analizan conjuntos de datos muy grandes para identificar patrones, tendencias y relaciones dentro de los datos. Esta capacidad basada en datos ayuda a las máquinas a tomar decisiones informadas o realizar predicciones precisas.

El papel de los datos en el aprendizaje automático

Los datos sirven como base sobre la que se construyen los modelos y se hacen predicciones. Las técnicas de preprocesamiento, como la limpieza, transformación y normalización de los datos, garantizan su idoneidad para el análisis. La extracción de características desempeña un papel vital en el aprendizaje automático al identificar atributos o características relevantes dentro del conjunto de datos que contribuyen a predicciones precisas. Este proceso implica seleccionar o transformar variables que mejor representen los patrones subyacentes en los datos.

Conceptos de preprocesamiento de datos

Preprocesamiento de datos juega un papel fundamental en la mejora de la precisión y confiabilidad de los modelos de ML. En este paso, los datos sin procesar se limpian eliminando errores e inconsistencias y luego se preparan en un formato adecuado para un análisis posterior. Otro paso importante en el preprocesamiento de datos es el manejo valores faltantes. Los datos faltantes pueden introducir sesgos y afectar la precisión del modelo. Estos pasos de preprocesamiento garantizan que los algoritmos de aprendizaje funcionen como se espera.

Otro paso importante es el escalado de características, donde las variables se ajustan para evitar que ciertas características dominen a otras, asegurando así una representación justa de las características dentro del modelo.

Además, las variables categóricas a menudo requieren codificación en representaciones numéricas para ser compatibles con los algoritmos de ML. Técnicas como la codificación one-hot o la codificación de etiquetas se utilizan comúnmente para convertir variables categóricas en valores numéricos significativos. Además, los valores atípicos pueden distorsionar el rendimiento del modelo; por lo tanto, se aplican métodos de detección de valores atípicos para identificarlos y manejarlos adecuadamente.

En general, el preprocesamiento de datos preciso garantiza que los modelos de aprendizaje automático reciban entradas limpias, consistentes y confiables. Esto no sólo mejora la precisión sino que también permite una mejor generalización al hacer predicciones sobre datos invisibles.

Conceptos de capacitación en datos: aprendizaje supervisado y no supervisado

Algoritmos ML Puede entrenar modelos mediante dos métodos principales: aprendizaje supervisado y aprendizaje no supervisado. En el aprendizaje supervisado, el modelo aprende de datos etiquetados donde cada ejemplo se combina con su resultado correcto.

Por otra parte, aprendizaje sin supervisión El método se basa en "datos sin etiquetar", donde solo están disponibles las funciones de entrada. El objetivo es descubrir estructuras o patrones inherentes dentro de los datos sin etiquetas predefinidas. Este enfoque es útil para tareas como agrupar instancias similares o reducir la dimensionalidad.

Independientemente del enfoque elegido, datos de entrenamiento juega un papel fundamental en el aprendizaje automático. Los conjuntos de datos de alta calidad son esenciales para construir modelos sólidos capaces de generalizar bien a ejemplos invisibles. Además de los datos de entrenamiento, la ingeniería de funciones también desempeña un papel vital en los procesos de aprendizaje automático. Implica transformar características de entrada sin procesar en una representación más adecuada que capture información significativa sobre el problema en cuestión.

Conceptos de algoritmos de aprendizaje automático: modelado predictivo, redes neuronales y aprendizaje profundo

En el ámbito del ML, los algoritmos forman la columna vertebral de la creación de sistemas inteligentes capaces de realizar predicciones y decisiones precisas. El modelado predictivo es un concepto fundamental en ML que implica el uso de datos históricos para construir modelos para pronosticar resultados futuros. Al analizar patrones y relaciones dentro de los datos, los modelos predictivos nos permiten hacer predicciones informadas sobre casos nuevos e invisibles.

Redes neuronales, una clase especial de algoritmos, imita fielmente la estructura y el funcionamiento del cerebro humano. Las redes neuronales, que consisten en nodos o "neuronas" interconectados, funcionan excepcionalmente bien para reconocer patrones complejos y extraer información significativa a partir de grandes cantidades de datos. Han demostrado ser muy eficaces en diversos ámbitos, como el reconocimiento de imágenes, el procesamiento del lenguaje natural y los sistemas de recomendación.

El aprendizaje profundo (DL) es un subconjunto de redes neuronales que ha ganado una enorme popularidad en los últimos años debido a su notable desempeño en tareas desafiantes. Implica entrenar redes neuronales con capas reveladas progresivamente (de ahí el término "profundo") para permitir una "adquisición de conocimiento" jerárquica a partir de datos sin procesar. Esto permite que los modelos DL aprendan automáticamente características complejas sin ingeniería de características explícita.

Al profundizar en las técnicas de modelado predictivo, explorar el funcionamiento interno de las redes neuronales y comprender el poder de los enfoques de DL, los principiantes pueden obtener información valiosa sobre cómo los algoritmos impulsan las soluciones de ML.

Conceptos de evaluación del rendimiento del modelo: sobreajuste, subajuste, validación cruzada, matriz de confusión y curva Roc

Evaluación rendimiento del modelo es un paso crucial en el proceso de LD. Este subtema explorará varios conceptos importantes relacionados con la evaluación del rendimiento del modelo.

Durante la fase de entrenamiento, el modelo ajusta sus parámetros internos para minimizar los errores entre los resultados previstos y los valores objetivo reales. Este proceso, conocido como "optimización" o "ajuste", permite al modelo generalizar su aprendizaje a ejemplos invisibles. Por lo tanto, es vital evaluar el desempeño del modelo entrenado en datos invisibles para evaluar su capacidad de realizar predicciones precisas en escenarios del mundo real. Aquí es donde entran en juego los datos de prueba. Los datos de prueba actúan como un conjunto de datos independiente que no se utilizó durante el entrenamiento pero que contiene patrones y distribuciones similares.

Sobreajuste Ocurre cuando un modelo es demasiado complejo: captura patrones irrelevantes de los datos de entrenamiento. Este tipo de modelos no funciona bien con datos nuevos. El desajuste es exactamente lo contrario: ocurre cuando un modelo es demasiado simple para capturar los patrones subyacentes en los datos, lo que conduce a un rendimiento deficiente.

Validación cruzada se utiliza para evaluar el rendimiento de un modelo en datos invisibles. Esto implica dividir el conjunto de datos en múltiples subconjuntos y luego entrenar y probar el modelo en los subconjuntos de datos de forma iterativa.

Métricas como la exactitud, la precisión, la recuperación y la puntuación F1 proporcionan información sobre qué tan bien se generalizan los modelos a datos nuevos o no vistos. Comprender estos conceptos permitirá a los principiantes evaluar sus modelos de ML de manera efectiva y tomar decisiones informadas con respecto a su desempeño.

Extracción de funciones e ingeniería de funciones: ejemplos de la vida real

Un ejemplo de ello es la PNL, donde extrayendo características relevantes a partir de datos de texto es crucial. En el análisis de sentimientos, por ejemplo, se pueden extraer características como la frecuencia de las palabras, las etiquetas de partes del discurso o los léxicos de sentimientos para entrenar un modelo para clasificar el texto como positivo o negativo.

En las aplicaciones de visión por computadora, la extracción de características es esencial para reconocer objetos y patrones dentro de las imágenes. Las redes neuronales convolucionales (CNN) a menudo utilizan modelos previamente entrenados como VGGNet o ResNet para extraer características significativas a partir de imágenes antes del entrenamiento en tareas específicas como la detección de objetos o la clasificación de imágenes.

Otro ejemplo de la vida real lo podemos encontrar en los sistemas de detección de fraude. Para detectar transacciones fraudulentas de manera efectiva, se diseñan varias funciones basadas en el historial de transacciones, incluida la frecuencia de las transacciones, la falta de coincidencia de ubicaciones, patrones de compra inusuales y anomalías en las direcciones IP.

En aplicaciones sanitarias, la ingeniería de funciones juega un papel importante. Por ejemplo, el riesgo de enfermedad cardíaca se puede predecir utilizando datos del paciente como la edad, la presión arterial, los niveles de colesterol y el hábito de fumar. Estas variables se seleccionan cuidadosamente y se diseñan en características significativas que capturan el conocimiento médico relevante.

Sistemas de recomendación y detección de anomalías: ejemplos de la vida real

En la era digital actual, los sistemas de recomendación se han convertido en una parte integral de nuestra vida cotidiana. Desde recomendaciones de películas personalizadas en plataformas de streaming hasta sugerencias de productos específicos en sitios web de comercio electrónico, estos sistemas desempeñan un papel crucial a la hora de mejorar la experiencia del usuario. Al aprovechar los algoritmos de aprendizaje automático, los sistemas de recomendación analizan grandes cantidades de datos para predecir con precisión las preferencias de los usuarios.

Un ejemplo destacado de sistemas de recomendación es el filtrado colaborativo, que sugiere elementos basados en las preferencias y comportamientos de usuarios similares. Esta técnica ha revolucionado la forma en que descubrimos contenido nuevo, fomentando una sensación de personalización en un mundo en línea que de otro modo sería abrumador.

Otro aspecto fascinante del aprendizaje automático son los algoritmos de detección de anomalías. Estos algoritmos destacan por identificar desviaciones de patrones o comportamientos esperados dentro de un conjunto de datos. Desde la detección de fraude en transacciones financieras hasta la detección de intrusiones en la red en ciberseguridad, la detección de anomalías desempeña un papel vital en la protección contra actividades maliciosas.

Al emplear técnicas como la agrupación en clústeres, el modelado estadístico y las redes neuronales, los algoritmos de detección de anomalías pueden identificar valores atípicos y anomalías que podrían pasar desapercibidas con los métodos tradicionales basados en reglas. Esta capacidad los convierte en herramientas invaluables para mejorar las medidas de seguridad en diversas industrias.

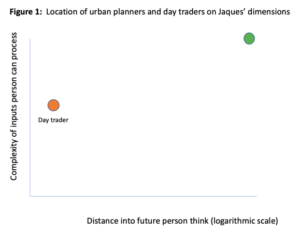

En el ámbito del aprendizaje automático, análisis de series temporales desempeña un papel fundamental, permitiéndonos extraer información valiosa de los datos que evolucionan con el tiempo. Esta rama de la estadística se centra en comprender y predecir patrones en datos secuenciales, lo que la convierte en una herramienta indispensable para diversas aplicaciones de la vida real. Un área destacada donde el análisis de series de tiempo juega un papel crucial es la previsión financiera.

Al analizar los precios históricos de las acciones o los tipos de cambio de divisas, los modelos de ML pueden pronosticar tendencias futuras y ayudar a los inversores a tomar decisiones informadas. De manera similar, en el pronóstico de ventas, comprender los patrones de ventas pasados es esencial para predecir la demanda futura y optimizar la gestión del inventario.

Otra aplicación vital se encuentra en el campo de las ciencias ambientales. El análisis de series temporales nos ayuda a comprender los patrones climáticos al examinar las fluctuaciones de temperatura, los niveles de precipitación o incluso los índices de calidad del aire durante períodos prolongados. Al identificar tendencias y estacionalidades dentro de estos conjuntos de datos, los investigadores pueden hacer predicciones precisas sobre los impactos del cambio climático y guiar a los responsables de políticas en consecuencia.

Además, el análisis de series temporales también encuentra su importancia en la atención sanitaria. Al analizar los signos vitales del paciente a lo largo del tiempo o estudiar los patrones de progresión de la enfermedad, los profesionales médicos pueden realizar mejores diagnósticos y predecir los resultados de la enfermedad con mayor precisión.

En general, el análisis de series temporales constituye un componente integral de las aplicaciones de aprendizaje automático en diversos dominios.

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoData.Network Vertical Generativo Ai. Empodérate. Accede Aquí.

- PlatoAiStream. Inteligencia Web3. Conocimiento amplificado. Accede Aquí.

- PlatoESG. Carbón, tecnología limpia, Energía, Ambiente, Solar, Gestión de residuos. Accede Aquí.

- PlatoSalud. Inteligencia en Biotecnología y Ensayos Clínicos. Accede Aquí.

- Fuente: https://www.dataversity.net/machine-learning-concepts-for-beginners/

- :posee

- :es

- :no

- :dónde

- 224

- 300

- a

- capacidad

- Nuestra Empresa

- en consecuencia

- la exactitud

- preciso

- precisamente

- a través de

- actividades

- hechos

- real

- Ad

- adición

- Adicionalmente

- dirección

- Equilibrado

- ajusta

- afectar

- en contra

- edad

- AI

- paquete de capacitación DWoVH

- AIRE

- algoritmo

- algoritmos

- también

- cantidades

- an

- análisis

- analizar

- el análisis de

- y

- Detección de anomalías

- Otra

- cualquier

- nadie

- aplausos

- Aplicación

- aplicaciones

- aplicada

- enfoque

- enfoques

- adecuadamente

- somos

- Reservada

- artificial

- inteligencia artificial

- Inteligencia Artificial (AI)

- AS

- aspecto

- evaluar

- ayudar

- At

- atributos

- automáticamente

- autónomamente

- Hoy Disponibles

- Columna vertebral

- basado

- básica

- BE

- a las que has recomendado

- antes

- Principiantes

- comportamiento

- MEJOR

- mejores

- entre

- Más allá de

- parcialidad

- sangre

- Presión sanguínea

- Cerebro

- Rama

- build

- Construir la

- construido

- pero

- by

- PUEDEN

- capacidad

- capaz

- capturar

- capturas

- Capturando

- Carreras

- estudiar cuidadosamente

- a ciertos

- desafiante

- el cambio

- características

- elegido

- clase

- clasificación

- clasificar

- limpia

- Limpieza

- Clima

- Cambio climático

- de cerca

- clustering

- colaboración

- proviene

- comúnmente

- compatibilidad

- integraciones

- componente

- comprender

- computadora

- Visión por computador

- Aplicaciones de visión artificial

- computadoras

- concepto

- conceptos

- confusión

- consistente

- Que consiste

- contiene

- contenido

- contribuir

- convertir

- correcta

- Para crear

- Creamos

- crucial

- Moneda

- La Ciberseguridad

- datos

- basada en datos

- conjuntos de datos

- VERSIDAD DE DATOS

- decisiones

- profundo

- Demanda

- detectar

- Detección

- digital

- era digital

- descrubrir

- Enfermedades

- distribuciones

- diverso

- do

- sí

- dominios

- dominante

- el lado de la transmisión

- dos

- durante

- comercio electrónico

- cada una

- Eficaz

- de manera eficaz

- empleando

- habilitar

- permite

- permitiendo

- codificación

- que abarca

- ingeniería

- Ingeniería

- mejorar

- garantizar

- asegura

- asegurando que

- ambientales

- Errores

- esencial

- Éter (ETH)

- evaluar

- evaluación

- evaluación

- Incluso

- Evento

- diario

- evoluciona

- Examinar

- ejemplo

- ejemplos

- Excel

- excepcionalmente

- Intercambio

- esperado

- experience

- explícitamente

- explorar

- Explorar

- extendido

- extraerlos

- Extracción

- f1

- feria

- fascinante

- Feature

- Caracteristicas

- campo

- Terrenos

- filtración

- financiar

- financiero

- encuentra

- fluctuaciones del mercado.

- se centra

- Pronóstico

- formulario

- formato

- Formularios

- el fomento de

- encontrado

- Fundación

- fraude

- detección de fraude

- fraudulento

- Frecuencia

- Desde

- funcionamiento

- fundamental

- promover

- futuras

- Obtén

- ganado

- Go

- objetivo

- Va

- mayor

- guía

- mano

- encargarse de

- que sucede

- Tienen

- la salud

- Corazón

- Enfermedad del corazón

- ayuda

- ayuda

- por lo tanto

- jerárquica

- Alta

- alta calidad

- altamente

- histórico

- historia

- mantener

- Cómo

- HTML

- HTTPS

- humana

- Humanos

- Identifique

- identificar

- imagen

- Clasificación de la imagen

- Reconocimiento de imagen

- imágenes

- inmenso

- Impactos

- importante

- mejora

- la mejora de

- in

- Incluye

- inconsistencias

- independientes

- Indices

- industrias

- información

- informó

- inherente

- interior

- Las opciones de entrada

- entradas

- Insights

- ejemplo

- instancias

- un elemento indispensable

- Intelligence

- De Operación

- interconectado

- interesado

- interno

- dentro

- intrincado

- introducir

- detección de intrusiones

- inestimable

- inventario

- La gestión del inventario

- Inversionistas

- implica

- IP

- Dirección IP

- IT

- artículos

- SUS

- solo

- nuggets

- especialistas

- conocido

- Label

- Etiquetas

- idioma

- large

- ponedoras

- líder

- APRENDE:

- aprendizaje

- aprovechando

- se encuentra

- como

- Etiqueta LinkedIn

- Vidas

- Ubicación

- máquina

- máquina de aprendizaje

- Máquinas

- hecho

- para lograr

- HACE

- Realizar

- malicioso

- Management

- Matrix

- max-ancho

- significativo

- medidas

- servicios

- Método

- métodos

- podría

- minimizar

- que falta

- ML

- Algoritmos ML

- modelo

- modelado

- modelos

- más,

- película

- múltiples

- my

- Natural

- Lenguaje natural

- Procesamiento natural del lenguaje

- negativas

- del sistema,

- telecomunicaciones

- Neural

- redes neuronales

- Nuevo

- nlp

- nodos

- objeto

- Detección de objetos

- objetos

- of

- a menudo

- on

- ONE

- en línea

- , solamente

- opuesto

- optimizando

- or

- Otro

- Otros

- de otra manera

- "nuestr

- Resultado

- resultados

- atípico

- salidas

- Más de

- abrumador

- emparejado

- parámetros

- parte

- pasado

- paciente

- datos del paciente

- .

- realizar

- actuación

- períodos

- personalización

- Personalizado

- fase

- esencial

- Plataformas

- Platón

- Inteligencia de datos de Platón

- PlatónDatos

- Jugar

- juega

- Podcast

- los responsables políticos

- pobre

- popularidad

- positivo

- posible

- industria

- Precisión

- predefinido

- predecir

- previsto

- predecir

- Predicciones

- profético

- preferencias

- preparado

- presión

- evitar

- Precios

- primario

- Problema

- tratamiento

- Producto

- Sugerencias de productos

- profesionales

- programado

- progresión

- progresivamente

- destacado

- probado

- proporcionar

- comprar

- calidad

- Tarifas

- Crudo

- datos en bruto

- mundo real

- reino

- recepción

- reciente

- reconocimiento

- reconociendo

- Recomendación

- recomendaciones

- reducción

- con respecto a

- relacionado

- Relaciones

- fiabilidad

- confianza

- relevantes

- la eliminación de

- representar

- representación

- exigir

- investigadores

- revolucionado

- Riesgo

- robótica

- robusto

- Función

- salvaguardar

- ventas

- la ampliación

- escenarios

- Ciencia:

- Puntuación

- EN LINEA

- Medidas de Seguridad

- seleccionado

- seleccionar

- sentido

- sentimiento

- Serie

- sirve

- Varios

- Shutterstock

- significado

- importante

- Letreros y Pancartas

- similares

- Del mismo modo

- sencillos

- Fumar

- Soluciones

- soluciones y

- estadístico

- statistics

- paso

- pasos

- en stock

- en streaming

- estructura

- estructuras

- Estudiando

- tal

- Sugiere

- idoneidad

- adecuado

- aprendizaje supervisado

- Todas las funciones a su disposición

- ¡Prepárate!

- Target

- afectados

- tareas

- la técnica

- técnicas

- término

- Pruebas

- texto

- esa

- La

- su

- Les

- luego

- Estas

- ellos

- así

- Así

- equipo

- Series de tiempo

- a

- de hoy

- juntos

- demasiado

- del IRS

- tradicional

- Entrenar

- entrenado

- Formación

- transaccional

- Transacciones

- transformadora

- de transporte

- tremendo

- Tendencias

- dos

- tipo

- descubrir

- subyacente

- comprensión

- aprendizaje sin supervisión

- insólito

- a

- us

- utilizan el

- usado

- eficiente

- Usuario

- experiencia como usuario

- usuarios

- usando

- Valioso

- Valores

- diversos

- Vasto

- muy

- visto

- visión

- vital

- fue

- Camino..

- we

- sitios web

- WELL

- cuando

- que

- seguirá

- dentro de

- sin

- Palabra

- labores

- mundo

- años

- ZDNET

- zephyrnet