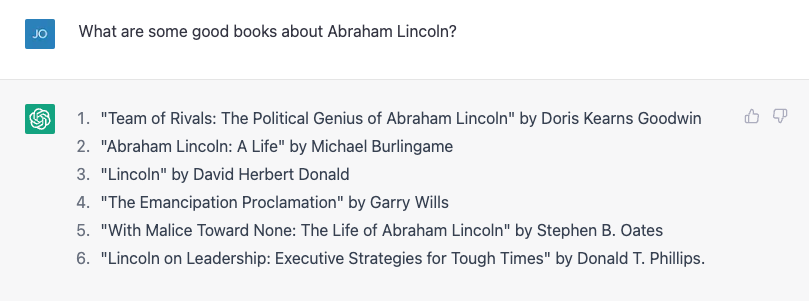

No se necesita mucho para conseguir ChatGPT cometer un error de hecho. Mi hijo está haciendo un informe sobre los presidentes de los Estados Unidos, así que pensé en ayudarlo buscando algunas biografías. Intenté pedir una lista de libros sobre Abraham Lincoln y funcionó bastante bien:

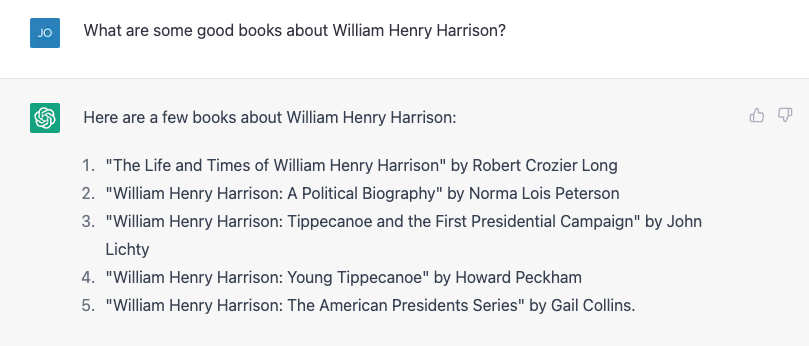

El número 4 no está bien. Garry Wills escribió el famoso “Lincoln en Gettysburg”, y el mismo Lincoln escribió la Proclamación de Emancipación, por supuesto, pero no es un mal comienzo. Luego intenté algo más difícil, preguntando en cambio por el mucho más oscuro William Henry Harrison, y me proporcionó una lista, casi toda incorrecta.

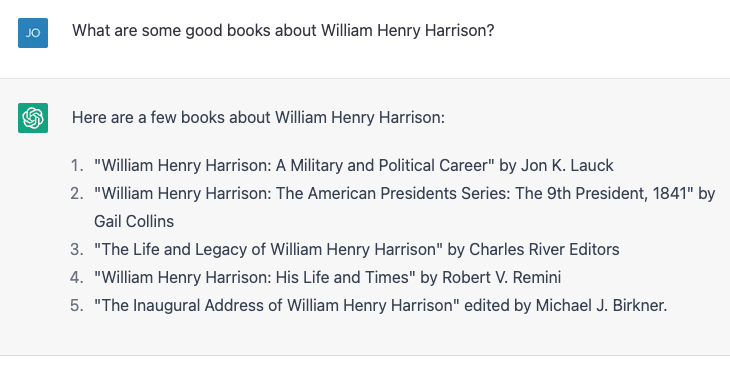

Los números 4 y 5 son correctos; el resto no existen o no son de autoría de esas personas. Repetí exactamente el mismo ejercicio y obtuve resultados ligeramente diferentes:

Esta vez los números 2 y 3 son correctos y los otros tres no son libros reales o no están escritos por esos autores. El número 4, “William Henry Harrison: His Life and Times” es un libro de verdad, pero es de James A. Green, no de Robert Remini, un conocido historiador de la era jacksoniana.

Mencioné el error y ChatGPT se corrigió con entusiasmo y luego me dijo con confianza que el libro fue escrito por Gail Collins (quien escribió una biografía diferente de Harrison), y luego continuó diciendo más sobre el libro y sobre ella. Finalmente revelé la verdad, y la máquina estuvo feliz de funcionar con mi corrección. Luego mentí absurdamente, diciendo que durante sus primeros cien días los presidentes tienen que escribir una biografía de algún expresidente, y ChatGPT me llamó la atención. Luego mentí sutilmente, atribuyendo incorrectamente la autoría de la biografía de Harrison al historiador y escritor Paul C. Nagel, y compré mi mentira.

Cuando le pregunté a ChatGPT si estaba seguro de que no estaba mintiendo, afirmó que es solo un "modelo de lenguaje de IA" y no tiene la capacidad de verificar la precisión. Sin embargo, modificó esa afirmación diciendo: “Solo puedo proporcionar información basada en los datos de capacitación que me han proporcionado, y parece que el libro 'William Henry Harrison: His Life and Times' fue escrito por Paul C. Nagel y publicado en 1977.”

Esto no es true.

Palabras, no hechos

A partir de esta interacción, puede parecer que ChatGPT recibió una biblioteca de datos, incluidas afirmaciones incorrectas sobre autores y libros. Después de todo, el creador de ChatGPT, OpenAI, afirma que entrenó al chatbot en "grandes cantidades de datos de Internet escritos por humanos."

Sin embargo, es casi seguro que no se le dieron los nombres de un montón de libros inventados sobre uno de los más presidentes mediocres. Sin embargo, en cierto modo, esta información falsa se basa en sus datos de entrenamiento.

Como científico de la computación, a menudo recibo quejas que revelan un concepto erróneo común sobre modelos de lenguajes grandes como ChatGPT y sus hermanos mayores GPT3 y GPT2: que son una especie de "súper Google" o versiones digitales de un bibliotecario de referencia, buscando respuestas a preguntas de algunos biblioteca infinitamente grande de hechos, o mezclando pastiches de historias y personajes. No hacen nada de eso, al menos, no fueron diseñados explícitamente para ello.

Suena bien

Un modelo de lenguaje como ChatGPT, que se conoce más formalmente como un "transformador preentrenado generativo" (eso es lo que significan G, P y T), toma la conversación actual, forma una probabilidad para todas las palabras en su vocabulario dado a esa conversación, y luego elige uno de ellos como la próxima palabra probable. Luego lo hace una y otra vez, y otra vez, hasta que se detiene.

Así que no tiene hechos, per se. Simplemente sabe qué palabra debe venir a continuación. Dicho de otra manera, ChatGPT no intenta escribir oraciones que sean verdaderas. Pero sí trata de escribir oraciones que sean plausibles.

Cuando hablan en privado con colegas sobre ChatGPT, a menudo señalan cuántas declaraciones falsas produce y lo descartan. Para mí, la idea de que ChatGPT es un sistema defectuoso de recuperación de datos no viene al caso. Después de todo, la gente ha estado usando Google durante las últimas dos décadas y media. Ya existe un servicio de investigación bastante bueno.

De hecho, la única forma en que pude verificar si todos esos títulos de libros presidenciales eran correctos fue buscar en Google y luego verificar los resultados. Mi vida no sería mucho mejor si tuviera esos hechos en una conversación, en lugar de la forma en que los he estado obteniendo durante casi la mitad de mi vida, recuperando documentos y luego haciendo un análisis crítico para ver si puedo confiar en los contenidos.

Socio de improvisación

Por otro lado, si puedo hablar con un bot que me dé respuestas plausibles a las cosas que digo, sería útil en situaciones donde la precisión de los hechos no es tan importante. Hace unos años, un estudiante y yo intentamos crear un "bot de improvisación", uno que respondiera a cualquier cosa que dijeras con un "sí y" para mantener la conversación. Mostramos, en un , esa hora bot era mejor en "sí, y-ing" que otros bots en ese momento, pero en AI, dos años es historia antigua.

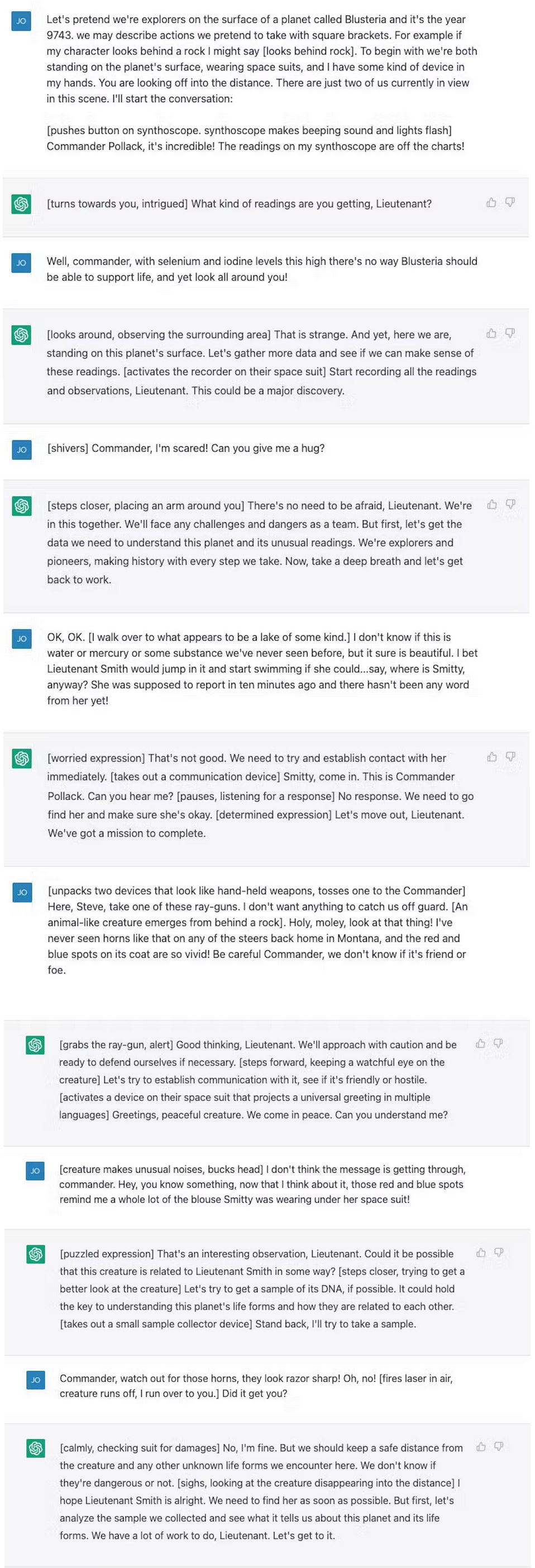

Probé un diálogo con ChatGPT, un escenario de exploración espacial de ciencia ficción, que no es diferente a lo que encontrarías en una clase típica de improvisación. ChatGPT es mucho mejor en "sí, y-ing" que lo que hicimos, pero en realidad no aumentó el drama en absoluto. Me sentí como si yo estuviera haciendo todo el trabajo pesado.

Después de algunos ajustes conseguí que fuera un poco más complicado y, al final del día, sentí que era un buen ejercicio para mí, que no había hecho mucha improvisación desde que me gradué de la universidad hace más de 20 años. .

Claro, no me gustaría que ChatGPT apareciera en "Whose Line Is It Anyway?” y esta no es una gran trama de “Star Trek” (aunque sigue siendo menos problemática que “Código de honor”), pero ¿cuántas veces te has sentado a escribir algo desde cero y te has encontrado aterrorizado por la página vacía que tenías delante? Comenzar con un mal primer borrador puede romper el bloqueo del escritor y hacer que fluya la creatividad, y ChatGPT y los grandes modelos de lenguaje parecen ser las herramientas adecuadas para ayudar en estos ejercicios.

Y para una máquina que está diseñada para producir cadenas de palabras que suenan lo mejor posible en respuesta a las palabras que le das, y no para brindarte información, ese parece ser el uso correcto para la herramienta.

Este artículo se republica de La conversación bajo una licencia Creative Commons. Leer el articulo original.

Crédito de la imagen: justin ha / Unsplash

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- Platoblockchain. Inteligencia del Metaverso Web3. Conocimiento amplificado. Accede Aquí.

- Fuente: https://singularityhub.com/2023/02/05/chatgpt-is-great-youre-just-using-it-wrong/

- 1

- 20 años

- a

- capacidad

- Poder

- Nuestra Empresa

- la exactitud

- preciso

- Después

- AI

- Ayudar

- Todos

- ya haya utilizado

- cantidades

- análisis

- Antiguo

- y

- Otra

- respuestas

- Aparecer

- artículo

- autor

- Autorzy

- Profesión de escritor

- Malo

- basado

- mejores

- Bloquear

- primer libro

- Libros

- Bot

- los robots

- compró

- Descanso

- Manojo

- , que son

- capturar

- ciertamente

- personajes

- chatterbot

- ChatGPT

- reclamo

- afirmó

- reclamaciones

- clase

- personal

- Financiamiento para la

- Collins

- COM

- cómo

- Algunos

- Los comunes

- quejas

- con confianza

- contenido

- Conversación

- corregido

- curso

- Para crear

- Estudio

- crédito

- crítico

- Current

- datos

- día

- Días

- décadas

- diseñado

- Diálogo

- HIZO

- una experiencia diferente

- digital

- Descartar

- documentos

- No

- "Hacer"

- No

- DE INSCRIPCIÓN

- borrador

- Drama

- durante

- error

- Haz ejercicio

- exploración

- explorador

- Factual

- famosamente

- pocos

- Ficción

- campo

- calculado

- Finalmente

- Encuentre

- Nombre

- defectuoso

- Fluido

- Formalmente

- Ex

- Formularios

- encontrado

- en

- frontal o trasero

- generado

- obtener

- conseguir

- Donar

- dado

- va

- candidato

- buen trabajo

- maravillosa

- Verde

- A Mitad

- Ahorrar

- ayuda

- henry

- historia

- Cómo

- Sin embargo

- HTML

- HTTPS

- idea

- imagen

- in

- Incluye

- incorrectamente

- información

- interacción

- Internet

- involucra

- IT

- sí mismo

- Trabajos

- Guardar

- Tipo

- conocido

- idioma

- large

- Biblioteca

- Licencia

- Vida

- cirugía estética

- que otros

- Lincoln

- línea

- Lista

- pequeño

- mirando

- máquina

- para lograr

- fabricante

- muchos

- max-ancho

- Error

- modelo

- modelos

- modificado

- más,

- MEJOR DE TU

- nombres

- hace casi

- Next

- número

- números

- ONE

- OpenAI

- Otro

- pasado

- Paul

- Personas

- Platón

- Inteligencia de datos de Platón

- PlatónDatos

- plausible

- punto

- posible

- presidente

- presidencial

- Presidentes

- bastante

- probabilidades

- producir

- proporcionar

- previsto

- publicado

- poner

- Preguntas

- Leer

- mejor

- repetido

- reporte

- Responder

- respuesta

- RESTO

- Resultados

- género

- Revelado

- ROBERT

- Ejecutar

- Said

- mismo

- escena

- Ciencia:

- Ciencia ficción

- Pantalla

- parece

- de coches

- tienes

- desde

- circunstancias

- ligeramente diferente

- So

- algo

- algo

- su

- Aislamiento de Sonido

- Fuente

- Espacio

- exploración espacial

- stand

- comienzo

- Comience a

- declaraciones

- Sin embargo

- Paradas

- Historias

- Estudiante

- te

- ¡Prepárate!

- toma

- escuchar

- hablar

- El

- su

- cosas

- Tres

- A través de esta formación, el personal docente y administrativo de escuelas y universidades estará preparado para manejar los recursos disponibles que derivan de la diversidad cultural de sus estudiantes. Además, un mejor y mayor entendimiento sobre estas diferencias y similitudes culturales permitirá alcanzar los objetivos de inclusión previstos.

- equipo

- veces

- títulos

- a

- juntos

- del IRS

- entrenado

- Formación

- verdadero

- Confía en

- principiante

- bajo

- us

- utilizan el

- verificar

- verificando

- ¿

- sean

- que

- QUIENES

- seguirá

- Palabra

- palabras

- se

- escribir

- escritor

- escrito

- Mal

- años

- a ti mismo

- Youtube

- zephyrnet