Ha habido conmoción en todo el mundo por el rápido ritmo de progreso con ChatGPT y otra inteligencia artificial creada con lo que se conoce como grandes modelos de lenguaje (LLM). Estos sistemas pueden producir texto que parece mostrar pensamiento, comprensión e incluso creatividad.

Pero, ¿pueden estos sistemas realmente pensar y comprender? Esta no es una pregunta que pueda responderse a través del avance tecnológico, pero un análisis filosófico cuidadoso y un argumento nos dicen que la respuesta es no. Y sin trabajar en estos temas filosóficos, nunca comprenderemos completamente los peligros y beneficios de la revolución de la IA.

En 1950, el padre de la informática moderna, Alan Turing, publicado un documento que estableció una forma de determinar si una computadora piensa. Esto ahora se llama "la prueba de Turing". Turing imaginó a un ser humano entablando una conversación con dos interlocutores ocultos a la vista: uno otro ser humano, el otro una computadora. El juego consiste en averiguar cuál es cuál.

Si una computadora puede engañar al 70 por ciento de los jueces en una conversación de 5 minutos haciéndoles creer que es una persona, la computadora pasa la prueba. ¿Pasar la prueba de Turing, algo que ahora parece inminente, mostraría que una IA ha logrado el pensamiento y la comprensión?

Desafío de ajedrez

Turing desechó esta pregunta por considerarla irremediablemente vaga y la reemplazó con una definición pragmática de "pensamiento", según la cual pensar solo significa pasar la prueba.

Sin embargo, Turing se equivocó cuando dijo que la única noción clara de "comprensión" es la puramente conductual de pasar su prueba. Aunque esta forma de pensar ahora domina la ciencia cognitiva, también existe una noción clara y cotidiana de "comprensión" que está ligada a conocimiento. Comprender en este sentido es captar conscientemente alguna verdad sobre la realidad.

En 1997, el Deep Blue AI venció al gran maestro de ajedrez Garry Kasparov. En una concepción puramente conductual de la comprensión, Deep Blue tenía un conocimiento de la estrategia de ajedrez que supera a cualquier ser humano. Pero no era consciente: no tenía sentimientos ni experiencias.

Los seres humanos comprenden conscientemente las reglas del ajedrez y la lógica de una estrategia. Deep Blue, por el contrario, era un mecanismo insensible que había sido entrenado para desempeñarse bien en el juego. Del mismo modo, ChatGPT es un mecanismo insensible que ha sido entrenado en grandes cantidades de datos creados por humanos para generar contenido que parece haber sido escrito por una persona.

No comprende conscientemente el significado de las palabras que escupe. Si “pensamiento” significa el acto de reflexión consciente, entonces ChatGPT no tiene pensamientos sobre nada.

Hora de pagar

¿Cómo puedo estar tan seguro de que ChatGPT no es consciente? En la década de 1990, el neurocientífico Christof Koch apuesta filósofo David Chalmers una caja de buen vino que los científicos habrían precisado por completo los "correlatos neuronales de la conciencia" en 25 años.

Con esto quiso decir que habrían identificado las formas de actividad cerebral necesarias y suficientes para la experiencia consciente. Ya era hora de que Koch pague, ya que no hay consenso de que esto haya sucedido.

Esto es porque conocimiento no se puede observar mirando dentro de tu cabeza. En sus intentos por encontrar una conexión entre la actividad cerebral y la experiencia, los neurocientíficos deben confiar en el testimonio de sus sujetos o en marcadores externos de conciencia. Pero hay múltiples formas de interpretar los datos.

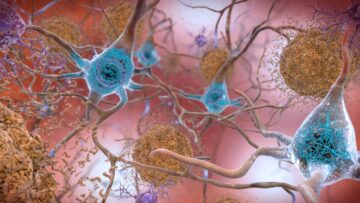

Algunos científicos creen que existe una estrecha conexión entre la conciencia y la cognición reflexiva: la capacidad del cerebro para acceder a la información y utilizarla para tomar decisiones. Esto los lleva a pensar que la corteza prefrontal del cerebro, donde tienen lugar los procesos de alto nivel de adquisición de conocimiento, está esencialmente involucrada en toda experiencia consciente. Otros lo niegan, argumentando en cambio que ocurre en cualquier región local del cerebro en la que tenga lugar el procesamiento sensorial relevante.

Los científicos tienen una buena comprensión de la química básica del cerebro. También hemos progresado en la comprensión de las funciones de alto nivel de varias partes del cerebro. Pero casi no tenemos ni idea de la parte intermedia: cómo se realiza el funcionamiento de alto nivel del cerebro a nivel celular.

La gente se emociona mucho con el potencial de los escáneres para revelar el funcionamiento del cerebro. Pero fMRI (imágenes por resonancia magnética funcional) tiene una resolución muy baja: cada píxel en un escáner cerebral corresponde a 5.5 millones de neuronas, lo que significa que hay un límite en la cantidad de detalles que estos escáneres pueden mostrar.

Creo que el progreso en la conciencia vendrá cuando entendamos mejor cómo funciona el cerebro.

Pausa en desarrollo

Como argumento en mi próximo libro ¿Por qué? El Propósito del Universo, la conciencia debe haber evolucionado porque marcó una diferencia de comportamiento. Los sistemas con conciencia deben comportarse de manera diferente y, por lo tanto, sobrevivir mejor que los sistemas sin conciencia.

Si todo el comportamiento estuviera determinado por la química y la física subyacentes, la selección natural no tendría ninguna motivación para hacer conscientes a los organismos; habríamos evolucionado como mecanismos de supervivencia insensibles.

Mi apuesta, entonces, es que a medida que aprendamos más sobre el funcionamiento detallado del cerebro, identificaremos con precisión qué áreas del cerebro encarnan la conciencia. Esto se debe a que esas regiones exhibirán un comportamiento que no se puede explicar con la química y la física actualmente conocidas. Ya, algunos neurocientíficos están buscando posibles nuevas explicaciones para la conciencia para complementar las ecuaciones básicas de la física.

Si bien el procesamiento de LLM ahora es demasiado complejo para que lo entendamos por completo, sabemos que, en principio, podría predecirse a partir de la física conocida. Sobre esta base, podemos afirmar con confianza que ChatGPT no es consciente.

Hay muchos peligros que plantea la IA, y apoyo totalmente el reciente llamado de decenas de miles de personas, incluidos los líderes tecnológicos Steve Wozniak y Elon Musk, pausar desarrollo para abordar las preocupaciones de seguridad. El potencial de fraude, por ejemplo, es inmenso. Sin embargo, el argumento de que los descendientes a corto plazo de los sistemas de IA actuales serán súper inteligentes y, por lo tanto, una gran amenaza para la humanidad, es prematuro.

Esto no significa que los sistemas de IA actuales no sean peligrosos. Pero no podemos evaluar correctamente una amenaza a menos que la categoricemos con precisión. Los LLM no son inteligentes. Son sistemas entrenados para dar la apariencia exterior de inteligencia humana. Da miedo, pero no tanto.![]()

Este artículo se republica de La conversación bajo una licencia Creative Commons. Leer el articulo original.

Crédito de la imagen: Gerd Altmann en Pixabay

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoAiStream. Inteligencia de datos Web3. Conocimiento amplificado. Accede Aquí.

- Acuñando el futuro con Adryenn Ashley. Accede Aquí.

- Compra y Vende Acciones en Empresas PRE-IPO con PREIPO®. Accede Aquí.

- Fuente: https://singularityhub.com/2023/05/23/chatgpt-cant-think-consciousness-is-something-entirely-different-to-todays-ai/

- :posee

- :es

- :no

- $ UP

- 1

- 2019

- 70

- a

- capacidad

- Poder

- Nuestra Empresa

- arriba

- AC

- de la máquina

- precisamente

- alcanzado

- adquisición

- Actúe

- actividad

- dirección

- avanzar

- avanzado

- Después

- AI

- Sistemas de IA

- Alan

- Alan Turing

- Todos

- ya haya utilizado

- también

- Aunque

- cantidades

- an

- análisis

- y

- Otra

- https://www.youtube.com/watch?v=xB-eutXNUMXJtA&feature=youtu.be

- cualquier

- cualquier cosa

- somos

- áreas

- argumentar

- argumento

- en torno a

- artículo

- artificial

- inteligencia artificial

- AS

- At

- Los intentos

- básica

- base

- BE

- porque

- esto

- "Ser"

- CREEMOS

- a continuación

- beneficios

- Bet

- mejores

- entre

- Poco

- Azul

- primer libro

- Cerebro

- Actividad cerebral

- pero

- .

- by

- llamar al

- , que son

- PUEDEN

- cuidadoso

- case

- ChatGPT

- química

- Ajedrez

- limpiar

- clic

- Cerrar

- código

- cognitivo

- recoger

- COM

- cómo

- Los comunes

- integraciones

- comprender

- computadora

- informática

- concepción

- Inquietudes

- con confianza

- conexión

- consciente

- Conocimiento

- Consenso

- contenido

- contraste

- Conversación

- corresponde

- podría

- Para contrarrestar

- creado

- Estudio

- creatividad

- crédito

- cs

- Current

- En la actualidad

- peligroso

- peligros

- datos

- David

- decisiones

- profundo

- detalle

- detallado

- determina

- determinar

- Desarrollo

- un cambio

- una experiencia diferente

- Pantalla

- do

- sí

- No

- domina

- don

- DE INSCRIPCIÓN

- Elon

- Elon Musk

- final

- comprometido

- enteramente

- ecuaciones

- esencialmente

- Incluso

- diario

- evolucionado

- ejemplo

- excitado

- exhibir

- experience

- Experiencias

- explicado

- externo

- sentimientos

- Encuentre

- en fin

- Formularios

- próximo

- fraude

- en

- completamente

- funcional

- funcionamiento

- funciones

- juego

- generar

- obtener

- gif

- Donar

- candidato

- agarrar

- tenido

- pasó

- que sucede

- Tienen

- he

- cabeza

- por lo tanto

- Oculto

- de alto nivel

- su

- Cómo

- Sin embargo

- HTML

- http

- HTTPS

- enorme

- humana

- Inteligencia humana

- con Humildad

- i

- no haber aun identificado una solucion para el problema

- Identifique

- if

- imaginado

- Proyección de imagen

- inmenso

- in

- Incluye

- info

- información

- Intelligence

- De Operación

- dentro

- involucra

- cuestiones

- IT

- solo

- Saber

- especialistas

- conocido

- Koch

- idioma

- large

- los líderes

- Prospectos

- APRENDE:

- Nivel

- Licencia

- como

- LIMITE LAS

- local

- mirando

- Baja

- hecho

- gran

- para lograr

- Realizar

- muchos

- personalizado

- sentido

- significa

- significó

- mecanismo

- los mecanismos de

- millones

- modelos

- Moderno

- más,

- Motivación

- mucho más

- múltiples

- Almizcle

- debe

- my

- Natural

- Naturaleza

- necesario

- Neuronas

- nunca

- Nuevo

- no

- Noción

- ahora

- of

- on

- ONE

- , solamente

- or

- Otro

- Otros

- salir

- página

- dinero

- pasa

- Pasando (Paso)

- Pagar

- (PDF)

- Personas

- por ciento

- realizar

- persona

- con

- datos personales

- Física

- Colocar

- Platón

- Inteligencia de datos de Platón

- PlatónDatos

- Por favor

- posible

- pragmático

- precisamente

- previsto

- Prematuro

- principio

- en costes

- tratamiento

- producir

- Progreso

- puramente

- propósito

- pregunta

- rápido

- Rate

- Leer

- Realidad

- realizado

- realmente

- reciente

- reflexión

- región

- regiones

- confiar

- remove

- reemplazados

- Resolución

- resonancia

- género

- Revolution

- reglas

- s

- Safety

- Said

- escanear

- Ciencia:

- los científicos

- ver

- la búsqueda de

- parece

- selección

- sentido

- Mostrar

- So

- algo

- algo

- Steve

- Steve Wozniak

- Estrategia

- suficiente

- complementar

- SOPORTE

- supervivencia

- sobrevivir

- Todas las funciones a su disposición

- ETIQUETA

- ¡Prepárate!

- toma

- tecnología

- tecnológico

- les digas

- tener

- test

- testimonio

- que

- esa

- El

- el mundo

- su

- Les

- luego

- Ahí.

- Estas

- ellos

- pensar

- Ideas

- piensa

- así

- aquellos

- pensamiento

- miles

- amenaza

- A través de esta formación, el personal docente y administrativo de escuelas y universidades estará preparado para manejar los recursos disponibles que derivan de la diversidad cultural de sus estudiantes. Además, un mejor y mayor entendimiento sobre estas diferencias y similitudes culturales permitirá alcanzar los objetivos de inclusión previstos.

- Atado

- equipo

- a

- de hoy

- demasiado

- entrenado

- verdad

- Turing

- prueba de Turing

- dos

- bajo

- subyacente

- entender

- comprensión

- us

- utilizan el

- diversos

- muy

- Ver

- fue

- Camino..

- formas

- we

- WELL

- cuando

- sean

- que

- Wikipedia

- seguirá

- sin

- palabras

- Actividades:

- rutina de ejercicio

- trabajando

- labores

- funciona

- mundo

- se

- escrito

- Mal

- años

- Usted

- tú

- zephyrnet

- cero