jay dawani es el cofundador y director ejecutivo de Laboratorios lemurianos, una startup que desarrolla una plataforma informática acelerada diseñada específicamente para aplicaciones de IA. La plataforma rompe las barreras del hardware para hacer que el desarrollo de la IA sea más rápido, más barato, más sostenible y accesible para más de unas pocas empresas.

Antes de fundar Lemurian, Jay fundó otras dos empresas en el ámbito de la IA. También es autor del libro mejor valorado “Matemáticas para el aprendizaje profundo."

Jay, experto en inteligencia artificial, robótica y matemáticas, se desempeñó como CTO de BlocPlay, una empresa pública que construye una plataforma de juegos basada en blockchain, y se desempeñó como Director de IA en GEC, donde dirigió el desarrollo de varios proyectos de clientes que cubren áreas desde comercio minorista, comercio algorítmico, plegamiento de proteínas, robots para exploración espacial, sistemas de recomendación y más. En su tiempo libre, también ha sido asesor en NASA Frontier Development Lab, Spacebit y SiaClassic.

La última vez que presentamos Lemurian Labs, usted se centró en la robótica y la IA de vanguardia. Ahora está centrado en el centro de datos y la infraestructura de la nube. ¿Qué pasó que te hizo querer dar un giro?

De hecho, pasamos de centrarnos en la construcción de un sistema en chip de alto rendimiento y baja latencia para aplicaciones de robótica autónoma que pudiera acelerar todo el ciclo de sentido, planificación y acción a construir un acelerador de dominio específico para IA centrado en aplicaciones a escala de centro de datos. . Pero no fue sólo un pivote ordinario; Fue una llamada de atención que sentimos que teníamos la responsabilidad de responder.

En 2018, estábamos trabajando en el entrenamiento de un modelo de parámetros de 2.1 millones de dólares, pero abandonamos el esfuerzo porque el costo era tan extraordinariamente alto que no podíamos justificarlo. Así que imaginen mi sorpresa de que GPT3, que OpenAI lanzó como ChatGPT en noviembre de 2022, fuera un modelo de parámetros de 175 mil millones de dólares. Este modelo es más de 80 veces más grande que en el que estábamos trabajando apenas 4 años antes, lo cual es a la vez emocionante y aterrador.

El coste de entrenar un modelo de este tipo es, cuanto menos, asombroso. Según las tendencias de escala actuales, podemos esperar que el costo de entrenar un modelo de IA de vanguardia supere los mil millones de dólares en un futuro no muy lejano. Si bien las capacidades de estos modelos serán asombrosas, el costo es ridículamente alto. Según esta trayectoria, sólo un puñado de empresas con muy buenos recursos y sus propios centros de datos podrán darse el lujo de entrenar, implementar y ajustar estos modelos. Esto no se debe únicamente a que la computación sea costosa y requiera mucha energía, sino también a que las pilas de software en las que confiamos no fueron diseñadas para este mundo.

Debido a limitaciones geográficas y energéticas, hay un número limitado de lugares para construir centros de datos. Para satisfacer las demandas informáticas de la IA, debemos poder construir máquinas de escala zetta sin necesidad de 20 reactores nucleares para alimentarlas. Necesitamos una solución más práctica, escalable y económica. Miramos a nuestro alrededor y no vimos a nadie en el camino para resolver esto. Y así, pasamos a la mesa de dibujo para mirar el problema de manera integral como un sistema de sistemas y razonar sobre una solución desde los primeros principios. Nos preguntamos cómo diseñaríamos la pila completa, desde el software hasta el hardware, si tuviéramos que atender económicamente 10 mil millones de consultas de LLM por día. Hemos puesto nuestra mirada en una máquina de escala zetta de menos de 200 MW, para 2028.

El truco consiste en verlo desde el punto de vista de una escala inconmensurable: diferentes partes de un sistema siguen diferentes reglas de escala, por lo que en algún momento las cosas simplemente dejan de funcionar, comienzan a fallar o la compensación costo-beneficio ya no tiene sentido. Cuando esto sucede, la única opción es rediseñar el sistema. Nuestra evaluación y solución abarca la carga de trabajo, el sistema numérico, el modelo de programación, el compilador, el tiempo de ejecución y el hardware de manera integral.

Afortunadamente, nuestros inversores actuales y el resto del mercado ven la visión, y recaudamos una ronda inicial de $9 millones para desarrollar nuestro formato numérico, PAL, para explorar el espacio de diseño y converger en una arquitectura para nuestro acelerador de dominio específico, y diseñar nuestra compilador y tiempo de ejecución. En las simulaciones, hemos podido lograr una ganancia de rendimiento 20 veces mayor en un menor consumo de energía que las GPU modernas, y proyectamos poder ofrecer un beneficio 8 veces mayor en el rendimiento del sistema por el costo total de propiedad con la misma tecnología de transistores.

No hace falta decir que tenemos mucho trabajo por delante, pero estamos muy entusiasmados con la perspectiva de poder redefinir la economía del centro de datos para garantizar un futuro en el que la IA esté disponible en abundancia para todos.

Eso ciertamente suena emocionante y esos números suenan impresionantes. Pero usted ha mencionado sistemas numéricos, hardware, compiladores y tiempos de ejecución como todas las cosas en las que se centra; parece mucho para que cualquier empresa lo asuma a la vez. Parece una propuesta muy arriesgada. ¿No se supone que las startups deben estar más enfocadas?

Parecen muchos esfuerzos diferentes, pero, de hecho, es un esfuerzo con muchas partes interconectadas. Resolver sólo uno de estos componentes de forma aislada de los demás sólo obstaculizará el potencial de innovación porque da como resultado pasar por alto las ineficiencias y los cuellos de botella sistémicos. Jensen Huang lo dijo mejor: "Para ser una empresa de informática acelerada, tienes que ser una empresa completa", y estoy totalmente de acuerdo. Son el líder actual del mercado por una razón. Pero desafiaría la idea de que no estamos centrados. Nuestro enfoque se encuentra en cómo pensamos sobre el problema de manera integral y cómo resolverlo mejor para nuestros clientes.

Hacer eso requiere un enfoque multidisciplinario como el nuestro. Cada parte de nuestro trabajo informa y apoya a las demás, permitiéndonos crear una solución que es mucho más que la suma de sus partes. Imagínese si tuviera que construir un auto de carreras. No elegirías arbitrariamente un chasis, agregarías neumáticos de carrera y colocarías el motor más potente que puedas encontrar y competir, ¿verdad? Se podría pensar en la aerodinámica de la carrocería del automóvil para reducir la resistencia y mejorar la carga aerodinámica, optimizar la distribución del peso para un buen manejo, diseñar el motor a medida para obtener el máximo rendimiento, obtener un sistema de refrigeración para evitar el sobrecalentamiento, especificar una jaula antivuelco para mantener seguro al conductor. , etc. Cada uno de estos elementos se basa e informa al otro.

Dicho esto, es arriesgado intentar hacerlo todo a la vez para cualquier empresa de cualquier sector. Para gestionar los riesgos, estamos adoptando un enfoque gradual, lo que nos permite validar nuestra tecnología con los clientes y ajustar nuestra estrategia según sea necesario. Hemos demostrado que nuestro formato numérico funciona y que tiene un mejor área de rendimiento de potencia que los tipos de punto flotante equivalentes, al mismo tiempo que tiene mejores propiedades numéricas que facilitan la cuantificación de redes neuronales a anchos de bits más pequeños. Hemos diseñado una arquitectura en la que nos sentimos seguros y que es adecuada tanto para el entrenamiento como para la inferencia. Pero más importante que todo eso es tener el software correcto, y ese es el grueso de nuestro enfoque inmediato. Necesitamos asegurarnos de tomar las decisiones correctas en nuestra pila de software sobre dónde vemos el mundo dentro de uno, dos o más años a partir de hoy.

Crear una empresa de hardware es difícil, costoso y lleva mucho tiempo. En primer lugar, centrarse en el software parece un negocio muy viable por sí solo y potencialmente más atractivo para los inversores en el clima actual. ¿Por qué también fabrican hardware, dado que tantas empresas bien financiadas en el sector están cerrando sus puertas, luchando por lograr la adopción por parte de los clientes y los actores más grandes están construyendo su propio hardware?

Tiene toda la razón en que las empresas de software generalmente han podido obtener capital mucho más fácilmente que las empresas de hardware, y que el hardware es muy difícil. Nuestro enfoque actual está principalmente en el software porque ahí es donde vemos el problema más grande. Permítanme ser claro, el problema no es si puedo ejecutar kernels en una CPU o GPU con alto rendimiento; Ese es un problema resuelto hace mucho tiempo. El problema actual es cómo hacemos que sea más fácil para los desarrolladores obtener más rendimiento, de manera productiva, a partir de varios miles de clústeres de nodos compuestos por computación heterogénea sin pedirles que revisen su flujo de trabajo.

Ese es el problema que actualmente estamos enfocados en resolver con una pila de software que brinda a los desarrolladores superpoderes y desbloquea la capacidad total de las computadoras a escala de almacén, para que podamos entrenar e implementar modelos de IA de manera más económica.

Ahora bien, con respecto a la inversión, sí, los capitalistas de riesgo están siendo más selectivos en el tipo de empresas que respaldan, pero eso también significa que están buscando empresas con el potencial de ofrecer productos verdaderamente innovadores que tengan un camino claro hacia la comercialización y al mismo tiempo tengan un impacto significativo. Hemos aprendido de los desafíos y errores de otros y hemos diseñado activamente nuestro modelo de negocio y hoja de ruta para abordar los riesgos. También es importante tener en cuenta que lo que ha hecho que las startups tengan éxito rara vez ha sido la facilidad con la que pueden recaudar fondos de capital de riesgo, sino que tiene más que ver con su ingenio, terquedad y enfoque en el cliente.

Y antes de que preguntes, todavía estamos trabajando en hardware, pero principalmente en simulación en este momento. No tenemos intención de suspender la grabación por un tiempo. Pero podemos guardar esa conversación para otro momento.

Esto es ciertamente convincente y su enfoque gradual es muy diferente en comparación con lo que hemos visto hacer a otras compañías de hardware. Entiendo el problema que dice que abordará su pila de software, pero ¿cómo se diferencia su software de los diversos esfuerzos del mercado?

La mayoría de las empresas a las que se refiere se centran en facilitar la programación de GPU mediante la introducción de modelos de programación basados en mosaicos o de mapeo de tareas para obtener más rendimiento de las GPU, o en la creación de nuevos lenguajes de programación para programar núcleos de alto rendimiento en diferentes Plataformas con soporte para montaje en línea. Esos son problemas importantes que están abordando, pero consideramos que el problema que estamos resolviendo es casi ortogonal.

Pensemos por un momento en la cadencia de las transiciones de hardware y software. Las arquitecturas de un solo núcleo ganaron rendimiento gracias a la velocidad del reloj y la densidad de los transistores, pero finalmente las velocidades del reloj se estancaron. El paralelismo que utiliza muchos núcleos evitó esto y proporcionó aceleraciones considerables. Al software le llevó aproximadamente una década ponerse al día, porque hubo que repensar los modelos de programación, los compiladores y los tiempos de ejecución para ayudar a los desarrolladores a extraer el valor de este paradigma. Luego, las GPU comenzaron a convertirse en aceleradores de uso general, nuevamente con un modelo de programación diferente. Una vez más, los desarrolladores tardaron casi una década en extraer valor aquí.

Una vez más, el hardware se está estancando: la ley de Moore, las limitaciones energéticas y térmicas, los cuellos de botella en la memoria y la diversidad de cargas de trabajo, además de la necesidad de una cantidad exponencial de más computación, nos están empujando a construir arquitecturas informáticas cada vez más heterogéneas para lograr un mejor rendimiento, eficiencia y costo total. Por supuesto, este cambio en el hardware creará desafíos para el software porque no tenemos los compiladores y tiempos de ejecución adecuados para respaldar la próxima evolución de la informática. Sin embargo, esta vez no deberíamos tener que esperar otros 10 años para que el software extraiga el valor de arquitecturas heterogéneas o grandes clusters, especialmente cuando están más del 80% sin utilizar.

En lo que nos estamos centrando es en construir un modelo de programación consciente de la heterogeneidad con paralelismo basado en tareas, abordando el rendimiento portátil con optimizaciones entre procesadores, compilación consciente del contexto y asignación dinámica de recursos. Y para nosotros, no importa si se trata de una CPU, GPU, TPU, SPU (arquitectura de Lemurian) o una malla de todas ellas. Sé que suenan como muchas palabras sofisticadas, pero lo que realmente significa es que hemos hecho posible programar cualquier tipo de procesador con un solo enfoque, y podemos transferir código de un tipo de procesador a otro con un mínimo esfuerzo sin necesidad de sacrificar el rendimiento y programar el trabajo de forma adaptativa y dinámica entre nodos.

Si lo que dice es cierto, es posible que redefina completamente la informática. Hablemos de financiación. El año pasado recaudó 9 millones de dólares en financiación inicial, lo que significa un fuerte apoyo de los inversores y confianza en su visión. ¿Qué has hecho desde entonces?

Durante el año pasado, impulsados por la financiación inicial, hemos logrado avances significativos. Con nuestro equipo ahora de 20 miembros, abordamos meticulosamente los desafíos, interactuamos con los clientes y refinamos nuestro enfoque.

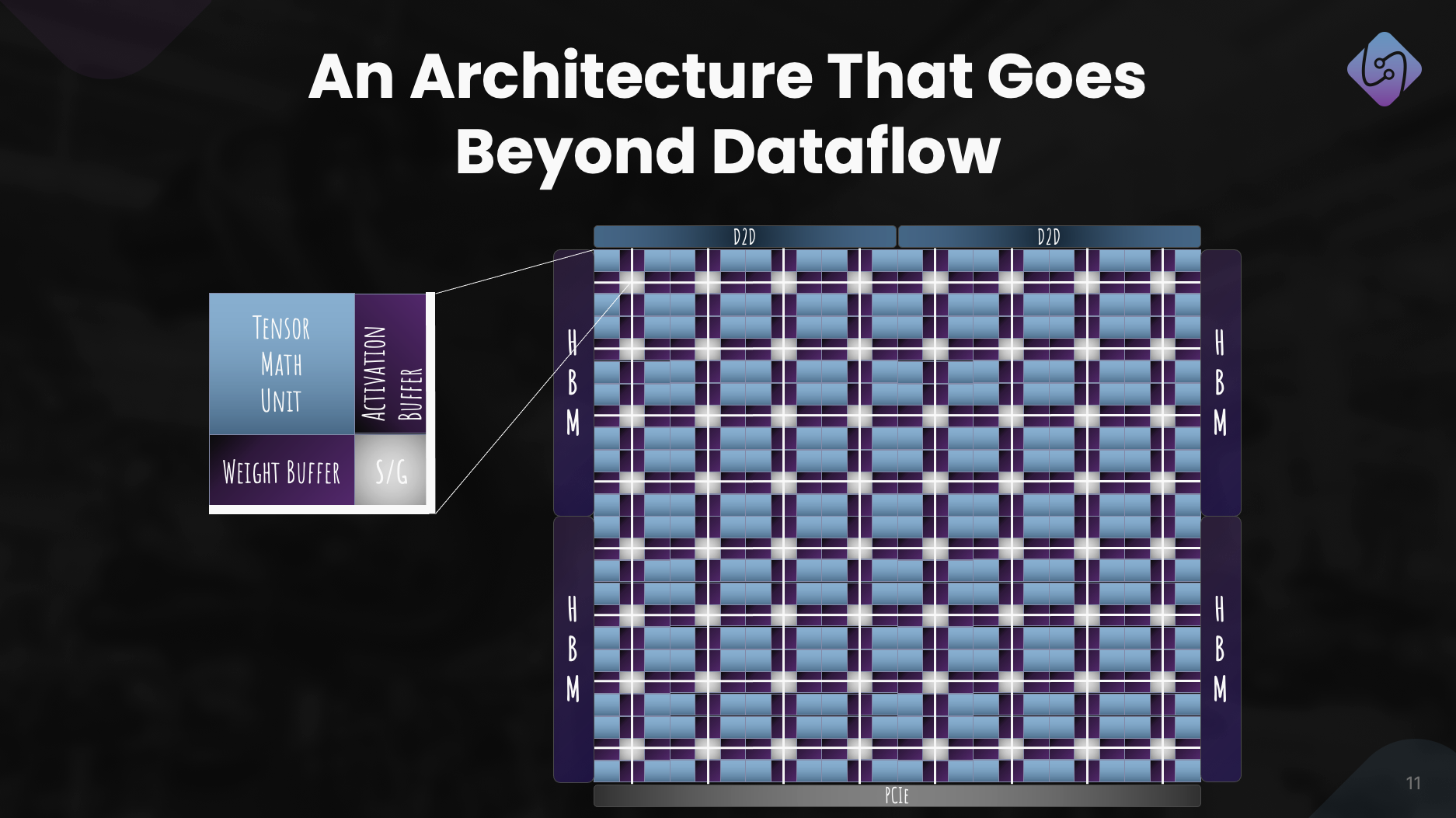

Nos concentramos en mejorar PAL para entrenamiento e inferencia, exploramos la arquitectura informática para nuestro acelerador y desarrollamos un simulador para métricas de rendimiento. Al mismo tiempo, reinventamos nuestra pila de software para aplicaciones de centros de datos, enfatizando la computación heterogénea.

Este esfuerzo dio como resultado una arquitectura bien definida, que muestra la eficacia de PAL para la IA a escala. Más allá de los avances tecnológicos, buscamos colaboraciones y actividades de divulgación para democratizar el acceso. Estos esfuerzos posicionan a Lemurian Labs para abordar los desafíos inmediatos de los clientes, preparándose para el lanzamiento de nuestro silicio de producción.

¿Cuáles son los planes a mediano plazo de Lemurian Labs con respecto al desarrollo de la pila de software, las colaboraciones y la mejora de la arquitectura del acelerador?

Nuestro objetivo inmediato es crear una pila de software dirigida a CPU, GPU y nuestros aceleradores de IA con rendimiento portátil, que estará disponible para los primeros socios a finales de año. Actualmente estamos en conversaciones con la mayoría de las principales empresas de semiconductores, proveedores de servicios en la nube, hiperescaladores y empresas de inteligencia artificial para darles acceso a nuestro compilador y tiempo de ejecución. Paralelamente, continuamos trabajando y mejorando la arquitectura de nuestro acelerador para lograr un sistema de hardware y software verdaderamente codiseñado. Y, por supuesto, acabamos de comenzar a aumentar nuestra serie A con un gran interés por parte de la comunidad de inversores, lo que nos permitirá hacer crecer nuestro equipo y cumplir nuestro objetivo de entrega de productos de software a finales de año.

Para terminar, ¿cómo cree que contribuirá Lemurian Labs a cambiar el panorama del desarrollo, la accesibilidad y la equidad de la IA en los próximos años?

No nos propusimos redefinir la informática sólo para obtener ganancias comerciales o por diversión. Como lemurianos, nuestra fuerza impulsora es que creemos en el potencial transformador de la IA y que más que unas pocas empresas deberían tener los recursos para definir el futuro de esta tecnología y cómo la usamos. Tampoco nos parece aceptable que la infraestructura del centro de datos para la IA esté en camino de consumir hasta el 20% de la energía mundial para 2030. Todos nos unimos porque creemos que hay un mejor camino a seguir para la sociedad si podemos hacer La IA sea más accesible al reducir drásticamente su costo asociado, acelerar el ritmo de la innovación en IA y ampliar su impacto. Al abordar los desafíos de la infraestructura de hardware actual, buscamos allanar el camino para dotar a mil millones de personas de las capacidades de la IA, garantizando una distribución equitativa de esta tecnología avanzada. Esperamos que nuestro compromiso con las soluciones centradas en productos, la colaboración y la innovación continua nos posicione como una fuerza impulsora para que el futuro del desarrollo de la IA sea positivo.

Lea también

Comparte esta publicación a través de:

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoData.Network Vertical Generativo Ai. Empodérate. Accede Aquí.

- PlatoAiStream. Inteligencia Web3. Conocimiento amplificado. Accede Aquí.

- PlatoESG. Carbón, tecnología limpia, Energía, Ambiente, Solar, Gestión de residuos. Accede Aquí.

- PlatoSalud. Inteligencia en Biotecnología y Ensayos Clínicos. Accede Aquí.

- Fuente: https://semiwiki.com/ceo-interviews/341485-ceo-interview-jay-dawani-of-lemurian-labs-2/

- :posee

- :es

- :no

- :dónde

- 9 millones de dólares

- $ UP

- 1

- 10

- 20

- 2018

- 2022

- 2028

- 2030

- 20x

- 300

- 4

- a

- Poder

- Nuestra Empresa

- absolutamente

- acelerar

- acelerado

- acelerador

- aceleradores

- aceptable

- de la máquina

- accesibilidad

- accesible

- Lograr

- a través de

- activamente

- add

- dirección

- dirigido

- direccionamiento

- ajustar

- Adopción

- avanzado

- Tecnología avanzada

- avances

- tutor

- de nuevo

- adelante

- AI

- Modelos AI

- algorítmico

- comercio algorítmico

- Todos

- asignación

- Permitir

- casi

- también

- Amazon

- an

- y

- Otra

- https://www.youtube.com/watch?v=xB-eutXNUMXJtA&feature=youtu.be

- cualquier

- nadie

- atractivo

- aplicaciones

- enfoque

- arbitrariamente

- arquitectura

- arquitecturas

- somos

- áreas

- en torno a

- artificial

- inteligencia artificial

- AS

- contacta

- pidiendo

- Asamblea

- evaluación

- asociado

- asombroso

- At

- autor

- autónomo

- Hoy Disponibles

- Atrás

- las barreras

- basado

- BE

- porque

- cada vez

- esto

- antes

- "Ser"

- creencia

- CREEMOS

- es el beneficio

- MEJOR

- mejores

- Más allá de

- más grande

- mil millones

- basado en blockchain

- tablero

- cuerpo

- ambas

- cuellos de botella

- Ruptura

- rompe

- ampliar

- build

- Construir la

- construye

- construido

- abultar

- modelo de negocio

- negocios

- pero

- by

- Cadencia

- llamar al

- llegó

- PUEDEN

- Puede conseguir

- capacidades

- capacidad

- capital

- lucha

- Reubicación

- ceo

- Entrevista al CEO

- ciertamente

- Reto

- retos

- cambio

- chasis

- ChatGPT

- más barato

- limpiar

- cliente

- Clima

- Reloj

- cierre

- Soluciones

- infraestructura de nube

- Co-founder

- código

- colaboración

- colaboraciones

- viniendo

- completo

- comercialización

- compromiso

- vibrante e inclusiva

- Empresas

- compañía

- en comparación con

- irresistible

- compilador

- completamente

- componentes

- Calcular

- computadora

- computadoras

- informática

- seguros

- restricciones

- consumir

- continue

- continuo

- contribuyendo

- converger

- Conversación

- conversaciones

- sistema de refrigeración

- correcta

- Cost

- podría

- curso

- cubierta

- CPU

- Para crear

- Cruz

- CTO

- Current

- En la actualidad

- personalizado

- diseño personalizado

- cliente

- Clientes

- datos

- Data Center

- Datacenter

- día

- década

- decisiones

- profundo

- definir

- entregamos

- entrega

- demandas

- democratizar

- densidad

- desplegar

- Diseño

- diseñado

- desarrollar

- desarrollado

- desarrolladores

- el desarrollo

- Desarrollo

- HIZO

- una experiencia diferente

- diferenciar

- Director

- Distante

- Diversidad

- do

- sí

- No

- "Hacer"

- dólares

- dominio

- hecho

- No

- puertas

- dramáticamente

- dibujo

- conductor

- conducción

- Soltar

- lugar de trabajo dinámico

- dinamicamente

- cada una

- Más temprano

- Temprano en la

- más fácil

- pasan fácilmente

- económicamente

- Ciencias económicas

- Southern Implants

- eficacia

- eficiencia

- esfuerzo

- esfuerzos

- elementos

- enfatizando

- empoderamiento

- habilitar

- permitiendo

- engloba

- final

- energía

- comprometido

- Motor

- mejorar

- mejorar

- garantizar

- asegurando que

- Todo

- equitativas

- equidad

- Equivalente a

- especialmente

- etc.

- finalmente

- todos

- evolución

- exceden

- excitado

- emocionante

- existente

- esperar

- costoso

- experto

- exploración

- explorar

- explorado

- exponencialmente

- extraerlos

- extraordinariamente

- hecho

- elegante

- muchos

- más rápida

- destacado

- sentir

- error

- pocos

- Encuentre

- Nombre

- flotante

- Focus

- centrado

- enfoque

- seguir

- Footprint

- FORCE

- formato

- adelante

- Fundado

- la fundación de

- Desde

- frontera

- alimentado

- ser completados

- Completa pila

- completamente

- diversión

- universidad

- futuras

- Futuro de la IA

- Obtén

- ganado

- juego de azar

- plataforma de juegos

- engranaje

- General

- en general

- geográfico

- obtener

- conseguir

- Donar

- dado

- da

- objetivo

- va

- candidato

- tiene

- GPU

- GPU

- innovador

- Crecer

- tenido

- puñado

- Manejo

- pasó

- que sucede

- Materiales

- Tienen

- es

- he

- ayuda

- esta página

- Alta

- impedir

- su

- Golpear

- golpeando

- esperanza

- Cómo

- Como Hacer

- HTTPS

- huang

- Hambriento

- i

- if

- imagen

- inmediata

- Impacto

- importante

- impresionante

- mejorar

- es la mejora continua

- in

- cada vez más

- energético

- ineficiencias

- Informa

- EN LA MINA

- Innovation

- Intelligence

- la intención de

- interconectado

- intereses

- Entrevista

- Presentamos

- inversión extranjera

- inversor

- Inversionistas

- solo

- IT

- SUS

- Jensen Huang

- jpg

- solo

- Guardar

- Tipo

- Saber

- el lab

- labs

- paisaje

- Idiomas

- large

- mayores

- Apellido

- El año pasado

- Estado latente

- de derecho criminal

- líder

- líder

- aprendido

- menos

- LED

- dejar

- como

- Etiqueta LinkedIn

- ll

- llm

- Largo

- largo tiempo

- por más tiempo

- Mira

- miró

- mirando

- Lote

- Baja

- bajando

- máquina

- Máquinas

- hecho

- para lograr

- HACE

- Realizar

- gestionan

- muchos

- Mercado

- Líder de mercado

- matemáticas

- Materia

- max-ancho

- máximas

- Puede..

- me

- significa

- Conoce a

- Miembros

- Salud Cerebral

- mencionado

- simplemente

- malla

- meticulosamente

- Métrica

- millones

- mínimo

- errores

- modelo

- modelos

- Moderno

- momento

- más,

- MEJOR DE TU

- mucho más

- multidisciplinario

- my

- NASA

- ¿ Necesita ayuda

- necesidad

- telecomunicaciones

- Neural

- redes neuronales

- Nuevo

- Next

- no

- nodo

- nodos

- nota

- Noción

- Noviembre

- ahora

- nuclear

- número

- números

- of

- LANZAMIENTO

- on

- una vez

- ONE

- , solamente

- OpenAI

- optimizaciones

- Optimización

- Optión

- or

- solicite

- ordinario

- Otro

- Otros

- nuestros

- nosotros mismos

- salir

- alcance

- Más de

- Revisar

- EL DESARROLLADOR

- propiedad

- Paz

- paradigma

- Paralelo

- parámetro

- parte

- socios

- partes

- pasado

- camino

- pavimentar

- Personas

- actuación

- escalonado

- recoger

- Pivot

- Lugares

- jubilación

- plataforma

- Plataformas

- Platón

- Inteligencia de datos de Platón

- PlatónDatos

- más

- punto

- Punto de vista.

- portátil

- posición

- abiertas

- positivo

- posible

- Publicación

- posible

- la posibilidad

- industria

- poderoso

- Metodología

- bastante

- evitar

- las cuales

- principios

- Problema

- problemas

- tratamiento

- Procesador

- Producto

- Producción

- Productos

- Programa

- Programación

- lenguajes de programación

- proyecta

- propiedades

- valor.

- perspectiva

- Proteínas

- probado

- previsto

- los proveedores

- público

- puramente

- propósito

- Emprendedor

- consultas

- Carrera

- carreras

- aumento

- elevado

- elevar

- raramente

- Leer

- realmente

- razón

- Recomendación

- redefinir

- rediseñar

- reducir

- a recomendar

- refinado

- con respecto a

- reimaginado

- ,

- liberado

- confiar

- requiere

- Recurso

- Recursos

- responsabilidad

- RESTO

- resultado

- Resultados

- el comercio minorista

- Derecho

- riesgos

- Arriesgado

- hoja de ruta

- robótica

- los robots

- Rodar

- aproximadamente

- redondo

- reglas

- correr

- sacrificar

- ambiente seguro

- Said

- mismo

- Guardar

- dices

- decir

- escalable

- Escala

- la ampliación

- programa

- programada

- ver

- dispersores

- Fundacion de semillas

- Ronda de semillas

- EL EQUIPO

- parece

- visto

- selectivo

- semiconductor

- sentido

- Serie

- Serie A

- ayudar

- servido

- de coches

- proveedores de servicios

- set

- Varios

- la formación

- Turno

- tienes

- Demostramos a usted

- Monumentos

- importante

- significa

- Silicio

- simulación

- simulaciones

- simulador

- simultáneamente

- desde

- soltero

- considerable

- diapositiva

- menores

- So

- Sociedades

- Software

- a medida

- Soluciones

- RESOLVER

- resuelto

- Resolver

- algo

- Aislamiento de Sonido

- suena

- Espacio

- exploración espacial

- Espacial

- soluciones y

- específicamente

- velocidad

- velocidades

- montón

- Stacks

- asombroso

- comienzo

- fundó

- inicio

- Startups

- Sin embargo

- Detener

- Estrategia

- zancadas

- fuerte

- Luchando

- exitosos

- tal

- adecuado

- suma

- SOPORTE

- soportes

- Supuesto

- sorpresa

- sostenible,

- te

- sistémico

- Todas las funciones a su disposición

- adaptado

- ¡Prepárate!

- toma

- toma

- escuchar

- cinta

- Target

- tiene como objetivo

- equipo

- tecnología

- Tecnología

- que

- esa

- El

- El futuro de las

- El paisaje

- el mundo

- su

- Les

- luego

- Ahí.

- térmico

- Estas

- ellos

- cosas

- pensar

- así

- aquellos

- ¿aunque?

- mil

- A través de esta formación, el personal docente y administrativo de escuelas y universidades estará preparado para manejar los recursos disponibles que derivan de la diversidad cultural de sus estudiantes. Además, un mejor y mayor entendimiento sobre estas diferencias y similitudes culturales permitirá alcanzar los objetivos de inclusión previstos.

- rendimiento

- equipo

- neumáticos

- a

- hoy

- juntos

- demasiado

- se

- Total

- difícil

- hacia

- seguir

- Plataforma de

- Entrenar

- Formación

- trayectoria

- transformador

- transición

- transiciones

- Tendencias

- truco

- verdadero

- verdaderamente

- try

- dos

- tipos

- bajo

- entender

- unidad

- desbloquea

- a

- us

- utilizan el

- usando

- VALIDAR

- propuesta de

- diversos

- VC

- Fondos de VC

- VCs

- muy

- vía

- y

- Ver

- visión

- esperar

- quieres

- Manejo de

- fue

- we

- peso

- WELL

- bien definido

- fuimos

- tuvieron

- ¿

- cuando

- sean

- que

- mientras

- porque

- seguirá

- sin

- palabras

- Actividades:

- flujo de trabajo

- trabajando

- funciona

- mundo

- mundo

- se

- año

- años

- si

- Usted

- tú

- zephyrnet