Introducción

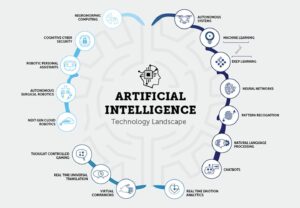

A medida que el campo de la inteligencia artificial (IA) continúa creciendo y evolucionando, se vuelve cada vez más importante para los aspirantes a desarrolladores de IA mantenerse actualizados con las últimas investigaciones y avances. Una de las mejores maneras de hacerlo es leyendo artículos sobre IA para desarrolladores de GenAI, que brindan información valiosa sobre técnicas y algoritmos de vanguardia. Este artículo explorará 15 artículos de IA esenciales para desarrolladores de GenAI. Estos artículos cubren diversos temas, desde el procesamiento del lenguaje natural hasta la visión por computadora. Mejorarán su comprensión de la IA y aumentarán sus posibilidades de conseguir su primer trabajo en este apasionante campo.

Importancia de los artículos sobre IA para los desarrolladores de GenAI

Los artículos de IA para desarrolladores de GenAI permiten a investigadores y expertos compartir sus hallazgos, metodologías y avances con la comunidad en general. Al leer estos artículos, obtendrá acceso a los últimos avances en IA, lo que le permitirá mantenerse a la vanguardia y tomar decisiones informadas en su trabajo. Además, los artículos de IA para desarrolladores de GenAI a menudo brindan explicaciones detalladas de algoritmos y técnicas, lo que le brinda una comprensión más profunda de cómo funcionan y cómo se pueden aplicar a problemas del mundo real.

La lectura de artículos sobre IA para desarrolladores de GenAI ofrece varios beneficios para los aspirantes a desarrolladores de IA. En primer lugar, le ayuda a mantenerse actualizado con las últimas investigaciones y tendencias en el campo. Este conocimiento es crucial a la hora de postularse para trabajos relacionados con la IA, ya que los empleadores suelen buscar candidatos familiarizados con los avances más recientes. Además, leer artículos sobre IA le permite ampliar sus conocimientos y obtener una comprensión más profunda de los conceptos y metodologías de la IA. Este conocimiento se puede aplicar a sus proyectos e investigaciones, lo que lo convertirá en un desarrollador de IA más competente y capacitado.

Tabla de contenidos.

Descripción general: documentos esenciales sobre IA para desarrolladores de GenAI con enlaces

Documento 1: Transformers: atención es todo lo que necesitas

Enlace: Léalo aquí

Resumen del artículo

El artículo presenta Transformer, una novedosa arquitectura de red neuronal para tareas de transducción de secuencias, como la traducción automática. A diferencia de los modelos tradicionales basados en redes neuronales recurrentes o convolucionales, Transformer se basa únicamente en mecanismos de atención, eliminando la necesidad de recurrencia y convoluciones. Los autores sostienen que esta arquitectura ofrece un rendimiento superior en términos de calidad de traducción, mayor paralelización y reducción del tiempo de capacitación.

Información clave de los artículos sobre IA para desarrolladores de GenAI

- Mecanismo de atención

El Transformer se basa completamente en mecanismos de atención, lo que le permite capturar dependencias globales entre secuencias de entrada y salida. Este enfoque permite que el modelo considere relaciones sin estar limitado por la distancia entre elementos en las secuencias.

- Paralelización

Una ventaja importante de la arquitectura Transformer es su mayor paralelización. Los modelos recurrentes tradicionales sufren de cálculo secuencial, lo que dificulta la paralelización. El diseño del Transformer permite un procesamiento paralelo más eficiente durante el entrenamiento, reduciendo los tiempos de entrenamiento.

- Calidad y eficiencia superiores

El artículo presenta resultados experimentales en tareas de traducción automática, lo que demuestra que Transformer logra una calidad de traducción superior en comparación con los modelos existentes. Supera los resultados de última generación anteriores, incluidos los modelos de conjunto, por un margen significativo. Además, el Transformer logra estos resultados con un tiempo de entrenamiento considerablemente menor.

- Rendimiento de traducción

En la tarea de traducción del inglés al alemán del WMT 2014, el modelo propuesto logra una puntuación BLEU de 28.4, superando los mejores resultados existentes en más de 2 BLEU. En la tarea de inglés a francés, el modelo establece una nueva puntuación BLEU de última generación para un solo modelo de 41.8 después de un entrenamiento de solo 3.5 días en ocho GPU.

- Generalización a otras tareasLos autores demuestran que la arquitectura Transformer se generaliza bien a tareas más allá de la traducción automática. Aplican con éxito el modelo al análisis de circunscripciones inglesas, mostrando su adaptabilidad a diferentes problemas de transducción de secuencias.

Documento 2: BERT: Entrenamiento previo de transformadores bidireccionales profundos para la comprensión del lenguaje

Enlace: Léalo aquí

Resumen del artículo

La formación previa del modelo de lenguaje ha demostrado ser eficaz para mejorar diversas tareas de procesamiento del lenguaje natural. El artículo distingue entre enfoques basados en características y de ajuste fino para aplicar representaciones de lenguaje previamente entrenadas. BERT se introduce para abordar las limitaciones en los enfoques de ajuste, en particular la restricción de unidireccionalidad de los modelos de lenguaje estándar. El artículo propone un objetivo de preentrenamiento del "Modelo de lenguaje enmascarado" (MLM), inspirado en la tarea Cloze, para permitir representaciones bidireccionales. También se utiliza una tarea de “predicción de la siguiente oración” para preparar previamente de forma conjunta representaciones de pares de texto.

Información clave de los artículos sobre IA para desarrolladores de GenAI

- Importancia del preentrenamiento bidireccional

El artículo enfatiza la importancia del preentrenamiento bidireccional para las representaciones del lenguaje. A diferencia de los modelos anteriores, BERT utiliza modelos de lenguaje enmascarados para permitir representaciones bidireccionales profundas, superando los modelos de lenguaje unidireccional utilizados en trabajos anteriores.

- Reducción de arquitecturas de tareas específicas

BERT demuestra que las representaciones previamente entrenadas reducen la necesidad de arquitecturas específicas para tareas muy diseñadas. Se convierte en el primer modelo de representación basado en ajustes que logra un rendimiento de vanguardia en una amplia gama de tareas a nivel de oración y de token, superando a las arquitecturas específicas de tareas.

- Avances de última generación

BERT logra nuevos resultados de última generación en once tareas de procesamiento del lenguaje natural, lo que demuestra su versatilidad. Las mejoras notables incluyen un aumento sustancial en la puntuación GLUE, la precisión de MultiNLI y mejoras en las tareas de respuesta a preguntas de SQuAD v1.1 y v2.0.

También puede leer: Ajuste fino de BERT con modelado de lenguaje enmascarado

Documento 3: GPT: los modelos de lenguaje son aprendices de pocas oportunidades

Enlace: Léalo aquí

Resumen del artículo

El artículo analiza las mejoras logradas en las tareas de procesamiento del lenguaje natural (PNL) mediante la ampliación de los modelos de lenguaje, centrándose en GPT-3 (Generative Pre-trained Transformer 3), un modelo de lenguaje autorregresivo con 175 mil millones de parámetros. Los autores destacan que si bien los recientes modelos de PNL demuestran ganancias sustanciales a través del entrenamiento previo y el ajuste, a menudo requieren conjuntos de datos de tareas específicas con miles de ejemplos para el ajuste. Por el contrario, los humanos pueden realizar nuevas tareas lingüísticas con pocos ejemplos o instrucciones sencillas.

Información clave de los artículos sobre IA para desarrolladores de GenAI

- La ampliación mejora el rendimiento en pocos disparos

Los autores demuestran que la ampliación de los modelos de lenguaje mejora significativamente el rendimiento independiente de las tareas y en pocas oportunidades. GPT-3, con su gran tamaño de parámetros, a veces logra competitividad con enfoques de ajuste de última generación sin ajustes específicos de tareas o actualizaciones de gradiente.

- Amplia aplicabilidad

GPT-3 exhibe un sólido rendimiento en varias tareas de PNL, incluida la traducción, la respuesta a preguntas, las tareas de cierre y las tareas que requieren razonamiento sobre la marcha o adaptación de dominio. - Desafíos y limitaciones

Si bien GPT-3 muestra notables capacidades de aprendizaje en pocas oportunidades, los autores identifican conjuntos de datos en los que tiene dificultades y resaltan cuestiones metodológicas relacionadas con la capacitación en grandes corpus web. - Generación de artículos similares a los humanos

GPT-3 puede generar artículos de noticias que a los evaluadores humanos les resulta difícil distinguir de los artículos escritos por humanos. - Impactos sociales y consideraciones más amplias

El artículo analiza los impactos sociales más amplios de las capacidades de GPT-3, particularmente en la generación de texto similar al humano. Las implicaciones de su desempeño en diversas tareas se consideran en términos de aplicaciones prácticas y desafíos potenciales. - Limitaciones de los enfoques actuales de PNL

Los autores destacan las limitaciones de los enfoques actuales de PNL, en particular su dependencia de conjuntos de datos de ajuste específicos de tareas, lo que plantea desafíos como el requisito de grandes conjuntos de datos etiquetados y el riesgo de sobreajuste a distribuciones de tareas estrechas. Además, surgen preocupaciones con respecto a la capacidad de generalización de estos modelos fuera de los límites de su distribución de capacitación.

Documento 4: CNN: clasificación de ImageNet con redes neuronales convolucionales profundas

Enlace: Léalo aquí

Resumen del artículo

El artículo describe el desarrollo y entrenamiento de una red neuronal convolucional (CNN) grande y profunda para la clasificación de imágenes en los conjuntos de datos del ImageNet Large Scale Visual Recognition Challenge (ILSVRC). El modelo logra mejoras significativas en la precisión de la clasificación en comparación con los métodos más avanzados anteriores.

Información clave de los artículos sobre IA para desarrolladores de GenAI

- Arquitectura modelo

La red neuronal utilizada en el estudio es una CNN profunda con 60 millones de parámetros y 650,000 neuronas. Consta de cinco capas convolucionales, algunas seguidas de capas de agrupación máxima y tres capas completamente conectadas con un softmax final de 1000 vías para clasificación.

- Datos de muestra

El modelo se entrena con un conjunto de datos sustancial de 1.2 millones de imágenes de alta resolución del concurso ImageNet ILSVRC-2010. El proceso de formación implica clasificar imágenes en 1000 clases diferentes.

- Rendimiento

El modelo logra tasas de error entre los 1 primeros y los 5 primeros del 37.5 % y 17.0 % en los datos de prueba, respectivamente. Estas tasas de error son considerablemente mejores que las del estado de la técnica anterior, lo que indica la eficacia del enfoque propuesto.

- Mejoras en el sobreajuste

El artículo presenta varias técnicas para abordar los problemas de sobreajuste, incluidas neuronas no saturadas, implementación eficiente de GPU para un entrenamiento más rápido y un método de regularización llamado "abandono" en capas completamente conectadas. - Eficiencia Computacional

A pesar de las demandas computacionales de entrenar grandes CNN, el artículo señala que las GPU actuales y las implementaciones optimizadas hacen factible entrenar dichos modelos en imágenes de alta resolución.

- Contribuciones

El artículo destaca las contribuciones del estudio, incluido el entrenamiento de una de las redes neuronales convolucionales más grandes en conjuntos de datos de ImageNet y el logro de resultados de última generación en competencias ILSVRC.

También puede leer: Un tutorial completo para aprender redes neuronales convolucionales

Documento 5: GAT: Redes de atención gráfica

Enlace: Léalo aquí

Resumen del artículo

El artículo presenta una arquitectura basada en la atención para la clasificación de nodos en datos estructurados en gráficos, mostrando su eficiencia, versatilidad y rendimiento competitivo en varios puntos de referencia. La incorporación de mecanismos de atención demuestra ser una herramienta poderosa para el manejo de gráficos estructurados arbitrariamente.

Información clave de los artículos sobre IA para desarrolladores de GenAI

- Redes de atención de gráficos (GAT)Los GAT aprovechan las capas de atención propia enmascaradas para abordar las limitaciones de los métodos anteriores basados en convoluciones de gráficos. La arquitectura permite a los nodos prestar atención a las características de sus vecindarios, especificando implícitamente diferentes pesos para diferentes nodos sin depender de costosas operaciones matriciales o conocimientos a priori de la estructura del gráfico.

- Abordar los desafíos basados en el espectro

Los GAT abordan simultáneamente varios desafíos en las redes neuronales de gráficos basadas en espectros. Los desafíos de Graph Attention Network (GAT) implican filtros localizados espacialmente, cálculos intensos y filtros no localizados espacialmente. Además, los GAT dependen de la base propia laplaciana, lo que contribuye a su aplicabilidad a problemas inductivos y transductivos.

- Rendimiento en todos los puntos de referencia

Los modelos GAT logran o igualan resultados de última generación en cuatro puntos de referencia de gráficos establecidos: conjuntos de datos de redes de citas Cora, Citeseer y Pubmed, así como un conjunto de datos de interacción proteína-proteína. Estos puntos de referencia cubren escenarios de aprendizaje tanto transductivos como inductivos, lo que muestra la versatilidad de los GAT.

- Comparación con enfoques anteriores

El artículo proporciona una descripción general completa de los enfoques anteriores, incluidas las redes neuronales recursivas, Graficar redes neuronales (GNN), métodos espectrales y no espectrales y mecanismos de atención. Los GAT incorporan mecanismos de atención, lo que permite una paralelización eficiente entre pares de nodos vecinos y su aplicación a nodos con diferentes grados.

- Eficiencia y aplicabilidadLos GAT ofrecen una operación eficiente y paralelizable que se puede aplicar a nodos gráficos con diferentes grados especificando pesos arbitrarios a los vecinos. El modelo se aplica directamente a problemas de aprendizaje inductivo, lo que lo hace adecuado para tareas en las que es necesario generalizar a gráficos completamente invisibles.

- Relación con modelos anteriores

Los autores señalan que los GAT pueden reformularse como una instancia particular de MoNet, compartir similitudes con redes relacionales y conectarse a obras que utilizan operaciones de atención vecinal. El modelo de atención propuesto se compara con enfoques relacionados como Duan et al. (2017) y Denil et al. (2017).

Documento 6: ViT: Una imagen vale 16 × 16 palabras: transformadores para el reconocimiento de imágenes a escala

Enlace: Léalo aquí

Resumen del artículo

El artículo reconoce el predominio de las arquitecturas convolucionales en la visión por computadora a pesar del éxito de las arquitecturas Transformer en el procesamiento del lenguaje natural. Inspirándose en la eficiencia y escalabilidad de los transformadores en PNL, los autores aplicaron un transformador estándar directamente a las imágenes con modificaciones mínimas.

Ellos introducen el Transformador de visión (ViT), donde las imágenes se dividen en parches y la secuencia de incrustaciones lineales de estos parches sirve como entrada al Transformer. El modelo se entrena en tareas de clasificación de imágenes de forma supervisada. Inicialmente, cuando se entrena en conjuntos de datos de tamaño mediano como ImageNet sin una regularización sólida, ViT logra precisiones ligeramente por debajo de ResNets comparables.

Sin embargo, los autores revelan que la formación a gran escala es crucial para el éxito de ViT, superando las limitaciones impuestas por la ausencia de ciertos sesgos inductivos. Cuando se entrena previamente en conjuntos de datos masivos, ViT supera a las redes convolucionales de última generación en múltiples puntos de referencia, incluidos ImageNet, CIFAR-100 y VTAB. El artículo subraya el impacto del escalado en el logro de resultados notables con arquitecturas Transformer en visión por computadora.

Información clave de los artículos sobre IA para desarrolladores de GenAI

- Transformador en visión por computadora

El artículo cuestiona la dependencia predominante de las redes neuronales convolucionales (CNN) para tareas de visión por computadora. Demuestra que un Transformer puro, cuando se aplica directamente a secuencias de parches de imágenes, puede lograr un rendimiento excelente en tareas de clasificación de imágenes.

- Transformador de visión (ViT)

Los autores presentan Vision Transformer (ViT), un modelo que utiliza mecanismos de autoatención similares a los Transformers en PNL. ViT puede lograr resultados competitivos en varios puntos de referencia de reconocimiento de imágenes, incluidos ImageNet, CIFAR-100 y VTAB.

- Preformación y transferencia de aprendizaje

El artículo enfatiza la importancia de un entrenamiento previo con grandes cantidades de datos, similar al enfoque en PNL, y luego transferir las representaciones aprendidas a tareas específicas de reconocimiento de imágenes. ViT, cuando se entrena previamente en conjuntos de datos masivos como ImageNet-21k o JFT-300M, supera a las redes convolucionales de última generación en varios puntos de referencia.

- Eficiencia ComputacionalViT logra resultados notables con sustancialmente menos recursos computacionales durante el entrenamiento que Redes convolucionales de última generación. Esta eficiencia es particularmente notable cuando el modelo se entrena previamente a gran escala.

- Impacto de escala

El documento destaca la importancia del escalamiento para lograr un rendimiento superior con arquitecturas Transformer en visión por computadora. El entrenamiento a gran escala en conjuntos de datos que contienen millones a cientos de millones de imágenes ayuda a ViT a superar la falta de algunos sesgos inductivos presentes en las CNN.

Documento 7: AlphaFold2: estructura proteica de alta precisión con AlphaFold

Enlace: Léalo aquí

Resumen del artículo

El artículo “AlphaFold2: Estructura proteica de alta precisión con AlphaFold” presenta AlphaFold2, un modelo de aprendizaje profundo que predice con precisión las estructuras de las proteínas. AlphaFold2 aprovecha una arquitectura novedosa basada en la atención y logra un gran avance en el plegamiento de proteínas.

Información clave de los artículos sobre IA para desarrolladores de GenAI

- AlfaFold2 utiliza una red neuronal profunda con mecanismos de atención para predecir la estructura 3D de las proteínas a partir de sus secuencias de aminoácidos.

- El modelo se entrenó en un gran conjunto de datos de estructuras de proteínas conocidas y logró una precisión sin precedentes en la 14ª competencia de plegamiento de proteínas de Evaluación Crítica de Predicción de la Estructura de Proteínas (CASP14).

- Las predicciones precisas de AlphaFold2 pueden revolucionar potencialmente el descubrimiento de fármacos, la ingeniería de proteínas y otras áreas de la bioquímica.

Documento 8: GAN: redes generativas adversarias

Enlace: Léalo aquí

Resumen del artículo

El artículo aborda los desafíos en el entrenamiento de modelos generativos profundos e introduce un enfoque innovador llamado redes adversariales. En este marco, los modelos generativo y discriminativo participan en un juego en el que el modelo generativo pretende producir muestras indistinguibles de los datos reales. Por el contrario, el modelo discriminativo diferencia entre muestras reales y generadas. El proceso de entrenamiento adversario conduce a una solución única, en la que el modelo generativo recupera la distribución de datos.

Información clave de los artículos sobre IA para desarrolladores de GenAI

- Marco de confrontación

Los autores introducen un marco de confrontación donde se entrenan dos modelos simultáneamente: un modelo generativo (G) que captura la distribución de datos y un modelo discriminativo (D) que estima la probabilidad de que una muestra provenga de los datos de entrenamiento en lugar del modelo generativo.

- Juego MinimaxEl procedimiento de entrenamiento implica maximizar la probabilidad de que el modelo discriminativo cometa un error. Este marco está formulado como un juego minimax para dos jugadores, donde el modelo generativo tiene como objetivo generar muestras indistinguibles de los datos reales, y el modelo discriminativo tiene como objetivo clasificar si una muestra es real o si se generó correctamente.

- Solución única

Existe una solución única en funciones arbitrarias para G y D, donde G recupera la distribución de datos de entrenamiento y D es igual a 1/2 en todas partes. Este equilibrio se alcanza mediante el proceso de entrenamiento adversario.

- Perceptrones multicapa (MLP)Los autores demuestran que todo el sistema se puede entrenar mediante retropropagación cuando los perceptrones multicapa representan G y D. Esto elimina la necesidad de cadenas de Markov o redes de inferencia aproximada desenrolladas durante el entrenamiento y la generación de muestras.

- Sin inferencia aproximada

El marco propuesto evita las dificultades de aproximar cálculos probabilísticos intratables en la estimación de máxima verosimilitud. También supera los desafíos para aprovechar los beneficios de las unidades lineales por partes en el contexto generativo.

Documento 9: RoBERTa: un enfoque de preentrenamiento BERT sólidamente optimizado

Enlace: Léalo aquí

Resumen del artículo

El documento aborda el problema del subentrenamiento de BERT y presenta RoBERTa, una versión optimizada que supera el rendimiento de BERT. Las modificaciones en el procedimiento de entrenamiento de RoBERTa y el uso de un nuevo conjunto de datos (CC-NEWS) contribuyen a obtener resultados de última generación en múltiples tareas de procesamiento del lenguaje natural. Los hallazgos enfatizan la importancia de las opciones de diseño y las estrategias de capacitación en la efectividad del preentrenamiento del modelo lingüístico. Los recursos publicados, incluido el modelo y el código de RoBERTa, contribuyen a la comunidad de investigación.

Información clave de los artículos sobre IA para desarrolladores de GenAI

- Entrenamiento insuficiente de BERT

Los autores encuentran que BERTI, un modelo de lenguaje ampliamente utilizado, estaba significativamente subcapacitado. Al evaluar cuidadosamente el impacto del ajuste de hiperparámetros y el tamaño del conjunto de entrenamiento, muestran que BERT se puede mejorar para igualar o superar el rendimiento de todos los modelos publicados después.

- Receta de entrenamiento mejorada (RoBERTa)

Los autores introducen modificaciones en el procedimiento de entrenamiento BERT, dando lugar a RoBERTa. Estos cambios implican períodos de entrenamiento extendidos con lotes más grandes, eliminación del objetivo de predicción de la siguiente oración, entrenamiento en secuencias más largas y ajustes del patrón de enmascaramiento dinámico para los datos de entrenamiento.

- Contribución del conjunto de datosEl documento presenta un nuevo conjunto de datos llamado CC-NEWS, que es comparable en tamaño a otros conjuntos de datos de uso privado. Incluir este conjunto de datos ayuda a controlar mejor los efectos del tamaño del conjunto de entrenamiento y contribuye a mejorar el rendimiento en las tareas posteriores.

- Logros de rendimiento

RoBERTa, con las modificaciones sugeridas, logra resultados de última generación en varias tareas de referencia, incluidas GLUE, RACE y SQuAD. Iguala o supera el rendimiento de todos los métodos posteriores a BERT en tareas como MNLI, QNLI, RTE, STS-B, SQuAD y RACE.

- Competitividad de la formación previa del modelo de lenguaje enmascarado

El artículo reafirma que el objetivo de preentrenamiento del modelo de lenguaje enmascarado, con las opciones de diseño correctas, es competitivo con otros objetivos de entrenamiento propuestos recientemente.

- Recursos liberados

Los autores lanzan su modelo RoBERTa, junto con el código de preentrenamiento y ajuste implementado en PyTorch, lo que contribuye a la reproducibilidad y una mayor exploración de sus hallazgos.

Lea también Una suave introducción a RoBERTa

Documento 10: NeRF: Representación de escenas como campos de radiación neuronal para síntesis de vistas

Enlace: Léalo aquí

Resumen del artículo

La optimización implica minimizar el error entre las imágenes observadas con poses de cámara conocidas y las vistas representadas a partir de la representación continua de la escena. El documento aborda los desafíos relacionados con la convergencia y la eficiencia mediante la introducción de codificación posicional para manejar funciones de mayor frecuencia y proponiendo un procedimiento de muestreo jerárquico para reducir la cantidad de consultas necesarias para un muestreo adecuado.

Información clave de los artículos sobre IA para desarrolladores de GenAI

- Representación de escena continua

El artículo presenta un método para representar escenas complejas como campos de radiación neuronal 5D utilizando redes básicas de perceptrón multicapa (MLP).

- Representación diferenciable

El procedimiento de renderizado propuesto se basa en técnicas clásicas de renderizado de volumen, lo que permite la optimización basada en gradientes utilizando imágenes RGB estándar.

- Estrategia de muestreo jerárquico

Se introduce una estrategia de muestreo jerárquico para optimizar la capacidad de MLP hacia áreas con contenido de escena visible, abordando problemas de convergencia.

- Codificación posicionalEl uso de codificación posicional para asignar coordenadas 5D de entrada a un espacio de dimensiones superiores permite la optimización exitosa de los campos de radiación neuronal para contenido de escenas de alta frecuencia.

El método propuesto supera los enfoques de síntesis de vistas de última generación, incluido el ajuste de representaciones neuronales 3D y el entrenamiento de redes convolucionales profundas. Este artículo presenta una representación de escena neuronal continua para representar vistas novedosas fotorrealistas de alta resolución a partir de imágenes RGB en entornos naturales, con comparaciones adicionales mostradas en el video complementario para resaltar su efectividad en el manejo de geometría y apariencia de escenas complejas.

Documento 11: FunSearch: Descubrimientos matemáticos a partir de la búsqueda de programas con modelos de lenguaje grandes

Enlace: Léalo aquí

Resumen del artículo

El artículo presenta FunSearch, un enfoque novedoso para aprovechar los modelos de lenguaje grande (LLM) para resolver problemas complejos, particularmente en el descubrimiento científico. El principal desafío abordado es la aparición de confabulaciones (alucinaciones) en los LLM, lo que lleva a declaraciones plausibles pero incorrectas. FunSearch combina un LLM previamente capacitado con un evaluador sistemático en un procedimiento evolutivo para superar esta limitación.

Información clave de los artículos sobre IA para desarrolladores de GenAI

- Resolución de problemas con LLM

El artículo aborda la cuestión de los LLM que confabulan o no generan ideas novedosas y soluciones correctas para problemas complejos. Enfatiza la importancia de encontrar ideas nuevas y verificablemente correctas, especialmente para desafíos matemáticos y científicos.

- Procedimiento Evolutivo – FunSearch

FunSearch combina un LLM previamente capacitado con un evaluador en un proceso evolutivo. Iterativamente convierte programas de baja puntuación en programas de alta puntuación, asegurando el descubrimiento de nuevos conocimientos. El proceso implica indicaciones óptimas, evolución de los esqueletos del programa, mantenimiento de la diversidad del programa y escalamiento asincrónico.

- Aplicación a la combinatoria extrema

El artículo demuestra la eficacia de FunSearch en el problema del conjunto de límites en combinatoria extrema. FunSearch descubre nuevas construcciones de conjuntos de gran capitalización, superando los resultados más conocidos y proporcionando la mayor mejora en 20 años al límite inferior asintótico.

- Problema algorítmico: embalaje de contenedores en línea

FunSearch se aplica al problema del empaquetado de contenedores en línea, lo que lleva al descubrimiento de nuevos algoritmos que superan a los tradicionales en distribuciones de interés bien estudiadas. Las aplicaciones potenciales incluyen la mejora de los algoritmos de programación de trabajos.

- Programas versus solucionesFunSearch se centra en generar programas que describen cómo resolver un problema en lugar de generar soluciones directamente. Estos programas tienden a ser más interpretables, facilitan las interacciones con expertos en el dominio y son más fáciles de implementar que otros tipos de descripciones, como las redes neuronales.

- Impacto Interdisciplinario

La metodología de FunSearch permite explorar una amplia gama de problemas, lo que lo convierte en un enfoque versátil con aplicaciones interdisciplinarias. El artículo destaca su potencial para realizar descubrimientos científicos verificables utilizando LLM.

Documento 12: VAE: Bayes variacionales de codificación automática

Enlace: Léalo aquí

Resumen del artículo

El artículo “Auto-Encoding Variational Bayes” aborda el desafío de la inferencia y el aprendizaje eficientes en modelos probabilísticos dirigidos con variables latentes continuas, particularmente cuando las distribuciones posteriores son intratables y tratan con grandes conjuntos de datos. Los autores proponen un algoritmo de aprendizaje e inferencia variacional estocástica que se adapta bien a grandes conjuntos de datos y sigue siendo aplicable incluso en distribuciones posteriores intratables.

Información clave de los artículos sobre IA para desarrolladores de GenAI

- Reparametrización del límite inferior variacional

El artículo demuestra una reparametrización del límite inferior variacional, lo que da como resultado un estimador de límite inferior. Este estimador se puede optimizar utilizando métodos de gradiente estocástico estándar, lo que lo hace computacionalmente eficiente.

- Inferencia posterior eficiente para variables latentes continuasLos autores proponen el algoritmo Auto-Encoding VB (AEVB) para conjuntos de datos con variables latentes continuas por punto de datos. Este algoritmo utiliza el estimador de gradiente estocástico variacional bayesiano (SGVB) para optimizar un modelo de reconocimiento, lo que permite una inferencia posterior aproximada eficiente a través de un muestreo ancestral. Este enfoque evita costosos esquemas de inferencia iterativos como Markov Chain Monte Carlo (MCMC) para cada punto de datos.

- Ventajas teóricas y resultados experimentales

Las ventajas teóricas del método propuesto se reflejan en los resultados experimentales. El artículo sugiere que el modelo de reparametrización y reconocimiento conduce a la eficiencia computacional y la escalabilidad, lo que hace que el enfoque sea aplicable a grandes conjuntos de datos y en situaciones donde lo posterior es intratable.

Lea también: Revelando la esencia del estocástico en el aprendizaje automático

Documento 13: MEMORIA A CORTO PLAZO

Enlace: Léalo aquí

Resumen del artículo

El artículo aborda el desafío de aprender a almacenar información durante intervalos de tiempo prolongados en redes neuronales recurrentes. Introduce un método novedoso y eficiente basado en gradientes llamado "Memoria larga a corto plazo" (LSTM), que supera los problemas de reflujo de errores insuficientes y en decadencia. LSTM impone un flujo de errores constante a través de "carruseles de errores constantes" y utiliza unidades de puerta multiplicativas para controlar el acceso. Con complejidad espacio-temporal local (O(1) por paso de tiempo y peso), los resultados experimentales muestran que LSTM supera a los algoritmos existentes en cuanto a velocidad de aprendizaje y tasas de éxito, especialmente para tareas con retrasos prolongados.

Información clave de los artículos sobre IA para desarrolladores de GenAI

- Análisis del problema

El artículo proporciona un análisis detallado de los desafíos asociados con el reflujo de errores en redes neuronales recurrentes, destacando los problemas de las señales de error que explotan o desaparecen con el tiempo.

- Introducción de LSTM

Los autores presentan LSTM como una arquitectura novedosa diseñada para abordar los problemas de señales de error que desaparecen y explotan. LSTM incorpora un flujo de errores constante a través de unidades especializadas y emplea unidades de puerta multiplicativas para regular el acceso a este flujo de errores.

- Resultados experimentales

A través de experimentos con datos artificiales, el artículo demuestra que LSTM supera a otros algoritmos de redes recurrentes, incluidos BPTT, RTRL, correlación en cascada recurrente, redes Elman y Neural Sequence Chunking. LSTM muestra un aprendizaje más rápido y mayores tasas de éxito, particularmente en la resolución de tareas complejas con largos retrasos.

- Local en el espacio y el tiempo

LSTM se describe como una arquitectura local en el espacio y el tiempo, con una complejidad computacional por paso de tiempo y un peso de O (1).

- Aplicabilidad

La arquitectura LSTM propuesta resuelve de manera efectiva tareas complejas, artificiales y con retraso prolongado que no fueron abordadas con éxito por los algoritmos de red recurrentes anteriores.

- Limitaciones y ventajas

El artículo analiza las limitaciones y ventajas de LSTM, proporcionando información sobre la aplicabilidad práctica de la arquitectura propuesta.

Lea también: ¿Qué es el LSTM? Introducción a la memoria a largo plazo

Documento 14: Aprendizaje de modelos visuales transferibles a partir de la supervisión del lenguaje natural

Enlace: Léalo aquí

Resumen del artículo

El artículo explora el entrenamiento de sistemas de visión por computadora de última generación aprendiendo directamente a partir de texto sin formato sobre imágenes en lugar de depender de conjuntos fijos de categorías de objetos predeterminadas. Los autores proponen una tarea previa al entrenamiento para predecir qué título corresponde a una imagen determinada, utilizando un conjunto de datos de 400 millones de pares (imagen, texto) recopilados de Internet. El modelo resultante, CLIP (Preentrenamiento de imágenes y lenguaje contrastivo), demuestra un aprendizaje eficiente y escalable de representaciones de imágenes. Después de la capacitación previa, el lenguaje natural hace referencia a conceptos visuales, lo que permite una transferencia inmediata a diversas tareas posteriores. CLIP se compara con más de 30 conjuntos de datos de visión por computadora, lo que muestra un desempeño competitivo sin capacitación específica para tareas.

Información clave de los artículos sobre IA para desarrolladores de GenAI

- Formación en Lenguaje Natural para Visión por Computador

El artículo explora el uso de la supervisión del lenguaje natural para entrenar modelos de visión por computadora en lugar del enfoque de entrenamiento tradicional en conjuntos de datos etiquetados colectivamente como ImageNet.

- Tarea previa al entrenamientoLos autores proponen una tarea previa al entrenamiento simple: predecir qué título corresponde a una imagen determinada. Esta tarea se utiliza para aprender representaciones de imágenes de última generación desde cero en un conjunto de datos masivo de 400 millones de pares (imagen, texto) recopilados en línea.

- Transferencia de disparo cero

Después del entrenamiento previo, el modelo utiliza lenguaje natural para hacer referencia a conceptos visuales aprendidos o describir otros nuevos. Esto permite la transferencia cero del modelo a tareas posteriores sin requerir capacitación específica en el conjunto de datos.

- Evaluación comparativa de diversas tareas

El artículo evalúa el rendimiento del enfoque propuesto en más de 30 conjuntos de datos de visión por computadora diferentes, cubriendo tareas como OCR, reconocimiento de acciones en videos, geolocalización y clasificación de objetos detallada.

- Rendimiento competitivo

El modelo demuestra un rendimiento competitivo con líneas de base totalmente supervisadas en diversas tareas, que a menudo igualan o superan la precisión de los modelos entrenados en conjuntos de datos específicos de tareas sin capacitación adicional específica del conjunto de datos.

- Estudio de escalabilidad

Los autores estudian la escalabilidad de su enfoque entrenando una serie de ocho modelos con diferentes niveles de recursos computacionales. Se ha descubierto que el rendimiento de la transferencia es una función informática perfectamente predecible.

- Robustez del modelo

El artículo destaca que los modelos CLIP de disparo cero son más robustos que los modelos ImageNet supervisados con precisión equivalente, lo que sugiere que la evaluación de disparo cero de los modelos independientes de la tarea proporciona una medida más representativa de la capacidad de un modelo.

Documento 15: LORA: ADAPTACIÓN DE BAJO RANGO DE MODELOS DE LENGUAS GRANDES

Enlace: Léalo aquí

Resumen del artículo

El artículo propone LoRA como un método eficiente para adaptar grandes modelos de lenguaje previamente entrenados a tareas específicas, abordando los desafíos de implementación asociados con su tamaño cada vez mayor. El método reduce sustancialmente los parámetros entrenables y los requisitos de memoria de la GPU al tiempo que mantiene o mejora la calidad del modelo en varios puntos de referencia. La implementación de código abierto facilita aún más la adopción de LoRA en aplicaciones prácticas.

Información clave de los artículos sobre IA para desarrolladores de GenAI

1. Planteamiento del problema

- El entrenamiento previo a gran escala seguido de un ajuste fino es un enfoque común en el procesamiento del lenguaje natural.

- El ajuste fino se vuelve menos factible a medida que los modelos crecen, particularmente cuando se implementan modelos con parámetros masivos, como GPT-3 (175 mil millones de parámetros).

2. Solución propuesta: Adaptación de bajo rango (LoRA)

- El artículo presenta LoRA, un método que congela los pesos de los modelos previamente entrenados e introduce matrices de descomposición de rangos entrenables en cada capa de la arquitectura Transformer.

- LoRA reduce significativamente la cantidad de parámetros entrenables para tareas posteriores en comparación con el ajuste completo.

3. Beneficios de LoRA

- Reducción de parámetros: en comparación con el ajuste fino, LoRA puede reducir la cantidad de parámetros entrenables hasta 10,000 veces, lo que lo hace computacionalmente más eficiente.

- Eficiencia de la memoria: LoRA reduce los requisitos de memoria de la GPU hasta 3 veces en comparación con el ajuste fino.

- Calidad del modelo: a pesar de tener menos parámetros entrenables, LoRA funciona a la par o mejor que el ajuste fino en términos de calidad del modelo en varios modelos, incluidos RoBERTa, DeBERTa, GPT-2 y GPT-3.

4. Superar los desafíos de implementación

- El documento aborda el desafío de implementar modelos con muchos parámetros mediante la introducción de LoRA, lo que permite un cambio de tareas eficiente sin volver a entrenar todo el modelo.

5. Eficiencia y baja latencia de inferencia

- LoRA facilita compartir un modelo previamente entrenado para construir múltiples módulos LoRA para diferentes tareas, lo que reduce los requisitos de almacenamiento y la sobrecarga del cambio de tareas.

- La capacitación se vuelve más eficiente, reduciendo la barrera de entrada del hardware hasta 3 veces cuando se utilizan optimizadores adaptativos.

6. Compatibilidad e integración

- LoRA es compatible con varios métodos anteriores y se puede combinar con ellos, como el ajuste de prefijos.

- El diseño lineal propuesto permite fusionar matrices entrenables con pesos congelados durante la implementación, sin introducir latencia de inferencia adicional en comparación con los modelos completamente ajustados.

7. Investigación empírica

- El artículo incluye una investigación empírica sobre la deficiencia de rango en la adaptación del modelo lingüístico, lo que proporciona información sobre la eficacia del enfoque LoRA.

8. Implementación de código abierto

- Los autores proporcionan un paquete que facilita la integración de LoRA con modelos PyTorch y lanzan implementaciones y puntos de control de modelos para RoBERTa, DeBERTa y GPT-2.

También puedes leer: Ajuste eficiente de parámetros de modelos de lenguaje grandes con LoRA y QLoRA

Conclusión

En conclusión, profundizar en los 15 artículos de IA esenciales para desarrolladores de GenAI destacados en este artículo no es simplemente una recomendación sino un imperativo estratégico para cualquier aspirante a desarrollador. Estos artículos sobre IA ofrecen un recorrido integral a través del diverso panorama de la inteligencia artificial, que abarca dominios críticos como el procesamiento del lenguaje natural, la visión por computadora y más. Al sumergirse en los conocimientos e innovaciones presentados en estos artículos, los desarrolladores obtienen una comprensión profunda de las técnicas y algoritmos de vanguardia del campo.

Relacionado:

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoData.Network Vertical Generativo Ai. Empodérate. Accede Aquí.

- PlatoAiStream. Inteligencia Web3. Conocimiento amplificado. Accede Aquí.

- PlatoESG. Carbón, tecnología limpia, Energía, Ambiente, Solar, Gestión de residuos. Accede Aquí.

- PlatoSalud. Inteligencia en Biotecnología y Ensayos Clínicos. Accede Aquí.

- Fuente: https://www.analyticsvidhya.com/blog/2024/01/essential-ai-papers-every-gen-ai-developer-must-read/

- :posee

- :es

- :no

- :dónde

- $ UP

- 000

- 1

- 10

- 11

- 12

- 13

- 14

- 15%

- 17

- 20

- 20 años

- 2014

- 2017

- 28

- 30

- 3d

- 400

- 41

- 60

- 7

- 8

- 9

- 913

- a

- capacidad

- Nuestra Empresa

- AC

- de la máquina

- la exactitud

- preciso

- precisamente

- Lograr

- alcanzado

- Logra

- el logro de

- a través de

- la columna Acción

- adaptaciónes

- adaptado

- Adicionales

- Adicionalmente

- dirección

- dirigido

- direcciones

- direccionamiento

- ajustes

- Adopción

- avances

- Ventaja

- ventajas

- adversario

- Después

- adelante

- AI

- paquete de capacitación DWoVH

- AL

- algoritmo

- algoritmos

- Todos

- permitir

- Permitir

- permite

- a lo largo de

- también

- cantidades

- an

- análisis

- y

- cualquier

- aplicable

- Aplicación

- aplicaciones

- aplicada

- se aplica

- Aplicá

- La aplicación de

- enfoque

- enfoques

- aproximado

- arquitectura

- somos

- áreas

- argumentar

- surgir

- artículo

- artificial

- inteligencia artificial

- Inteligencia Artificial (AI)

- AS

- aspirantes

- evaluación

- asociado

- At

- asistir

- Autorzy

- barrera

- basado

- básica

- BE

- se convierte en

- "Ser"

- a continuación

- comparado

- los puntos de referencia

- beneficios

- MEJOR

- mejores

- entre

- Más allá de

- los prejuicios

- mil millones

- BIN

- empujón

- ambas

- obligado

- ruptura

- avances

- más amplio

- Construir la

- construido

- pero

- by

- , que son

- llegó

- cámara

- PUEDEN

- candidatos

- tapa

- capacidades

- capacidad

- Capacidad

- capturar

- capturas

- estudiar cuidadosamente

- cascadas

- categoría

- a ciertos

- cadena

- cadenas

- Reto

- retos

- desafiante

- posibilidades

- Cambios

- opciones

- privadas

- clasificación

- clasificar

- CNN

- código

- combinado

- combina

- Algunos

- vibrante e inclusiva

- comparable

- en comparación con

- comparaciones

- compatible

- competente

- competencia

- Competiciones

- competitivos

- competitividad

- completamente

- integraciones

- complejidad

- exhaustivo

- cálculo

- computational

- computaciones

- computadora

- Visión por computador

- informática

- conceptos

- Inquietudes

- conclusión

- Contacto

- conectado

- Considerar

- considerado

- consiste

- constante

- contenido

- concurso

- contexto

- continúa

- continuo

- contraste

- contribuir

- contribuye

- contribuyendo

- contribuciones

- control

- Convergencia

- red neuronal convolucional

- correcta

- correctamente

- La correlación

- corresponde

- costoso

- Protectora

- cubierta

- crítico

- crucial

- Current

- curva

- innovador

- datos

- conjuntos de datos

- Días

- tratar

- decisiones

- disminuye

- profundo

- deep learning

- red neuronal profunda

- más profundo

- demandas

- demostrar

- demuestra

- vas demostrando

- depender

- dependencias

- desplegar

- Desplegando

- despliegue

- describir

- descrito

- describe

- Diseño

- diseñado

- A pesar de las

- detallado

- Developer

- desarrolladores

- el desarrollo

- una experiencia diferente

- difícil

- dificultades

- que dirigieron

- directamente

- Descubre

- descubrimiento

- distancia

- distinguir

- distingue

- distribuciones

- diverso

- Diversidad

- do

- dominio

- dominios

- Dominio

- droga

- el descubrimiento de fármacos

- durante

- lugar de trabajo dinámico

- E & T

- cada una

- más fácil

- Eficaz

- de manera eficaz

- eficacia

- los efectos

- eficacia

- eficiencia

- eficiente

- ocho

- ya sea

- elementos

- once

- elimina

- eliminando

- enfatizar

- enfatiza

- empleadores

- emplea

- habilitar

- permite

- permitiendo

- codificación

- y conseguir de esta manera

- Ingeniería

- Inglés

- mejorar

- mejoras

- Mejora

- asegurando que

- Todo

- enteramente

- entrada

- igual

- equilibrio

- Equivalente a

- error

- especialmente

- esencia

- esencial

- se establece

- estima

- Éter (ETH)

- evaluación

- evaluación

- Incluso

- en todas partes

- evoluciona

- evoluciona

- evolución

- ejemplos

- exceden

- excede

- excelente,

- emocionante

- exposiciones

- existente

- existe

- Expandir

- costoso

- experimental

- experimentos

- expertos

- exploración

- explorar

- explora

- Explorar

- extendido

- facilita

- facilitando

- fallando

- familiar

- más rápida

- factible

- Caracteristicas

- pocos

- menos

- campo

- Terrenos

- filtros

- final

- Encuentre

- la búsqueda de

- Los resultados

- Nombre

- adecuado

- Digital XNUMXk

- fijas

- de tus señales

- se centra

- enfoque

- seguido

- encontrado

- Digital XNUMXk

- Marco conceptual

- Frecuencia

- Desde

- congelado

- ser completados

- completamente

- función

- funciones

- promover

- Obtén

- Ganancias

- juego

- GAN

- portón

- Génai

- generar

- generado

- la generación de

- generativo

- modelo generativo

- suaves

- geometría

- dado

- Diezmos y Ofrendas

- Buscar

- GPU

- GPU

- gráfica

- graficar redes neuronales

- gráficos

- Crecer

- encargarse de

- Manejo

- Materiales

- es

- ayuda

- jerárquica

- Alta

- Alta frecuencia

- de alta resolución

- más alto

- Destacar

- Destacado

- destacando

- destacados

- altamente

- Cómo

- Como Hacer

- HTTPS

- humana

- Humanos

- Cientos

- cientos de millones

- Ajuste de hiperparámetros

- ideas

- Identifique

- imagen

- Clasificación de la imagen

- Reconocimiento de imagen

- ImagenNet

- imágenes

- Impacto

- Impactos

- INDISPENSABLE

- implementación

- implementaciones

- implementado

- implicaciones

- importancia

- importante

- Impuesta

- mejorado

- es la mejora continua

- mejoras

- mejora

- la mejora de

- in

- incluir

- incluye

- Incluye

- incorporar

- incorpora

- aumente

- aumentado

- creciente

- cada vez más

- indicando

- información

- informó

- posiblemente

- innovaciones

- originales

- Las opciones de entrada

- Insights

- inspirado

- ejemplo

- Instrucciones

- integración

- Intelligence

- intenso

- interacción

- interacciones

- intereses

- Internet

- dentro

- introducir

- Introducido

- Presenta

- Presentamos

- Introducción

- investigación

- involucrar

- implica

- cuestiones

- IT

- SUS

- Trabajos

- Empleo

- jpg

- especialistas

- conocido

- Falta

- aterrizaje

- paisaje

- idioma

- large

- Gran escala

- mayores

- mayor

- Estado latente

- más reciente

- .

- ponedoras

- líder

- Prospectos

- APRENDE:

- aprendido

- aprendizaje

- menos

- Apalancamiento

- apalancamientos

- aprovechando

- como

- probabilidad

- la limitación

- limitaciones

- Limitada

- local

- Largo

- largo tiempo

- Mira

- Baja

- inferior

- bajando

- máquina

- máquina traductora

- hecho

- el mantenimiento de

- gran

- para lograr

- Realizar

- manera

- muchos

- mapa

- Margen

- masivo

- Match

- cerillas

- pareo

- matemático

- Matrix

- max-ancho

- maximizando

- máximas

- medir

- los mecanismos de

- Salud Cerebral

- simplemente

- la fusión de

- Método

- metodologías

- Metodología

- métodos

- millones

- millones

- mínimo

- minimizando

- Error

- modelo

- modelos

- Modificaciones

- Módulos

- más,

- más eficiente

- Por otra parte

- MEJOR DE TU

- múltiples

- debe

- Debes leer

- Natural

- Lenguaje natural

- Procesamiento natural del lenguaje

- Naturaleza

- ¿ Necesita ayuda

- nerf

- Nets

- del sistema,

- telecomunicaciones

- Neural

- red neural

- redes neuronales

- NeurIPS

- Neuronas

- Nuevo

- noticias

- Next

- nlp

- no

- nodo

- nodos

- notable

- nota

- Notas

- novela

- número

- objeto

- objetivo

- ,

- observado

- aparición

- OCR

- of

- LANZAMIENTO

- Ofertas

- a menudo

- on

- ONE

- las

- en línea

- , solamente

- de código abierto

- Inteligente

- Operaciones

- optimización

- Optimización

- optimizado

- or

- Otro

- Superar

- superando

- Supera

- salida

- afuera

- Más de

- Superar

- superación

- visión de conjunto

- paquete

- pares

- pankaj

- Papel

- papeles

- Paralelo

- parámetro

- parámetros

- particular

- particularmente

- Parches

- Patrón de Costura

- (PDF)

- para

- realizar

- actuación

- realiza

- períodos

- Fotorrealista

- Platón

- Inteligencia de datos de Platón

- PlatónDatos

- plausible

- punto

- plantea

- posible

- la posibilidad

- poderoso

- Metodología

- Aplicaciones Prácticas

- predecir

- Previsible

- predecir

- predicción

- Predicciones

- Predice

- presente

- presentó

- regalos

- anterior

- primario

- Anterior

- probabilidades

- Problema

- problemas

- procedimientos

- tratamiento

- producir

- un profundo

- Programa

- Programas

- proyecta

- ofrece

- propuesto

- propone

- proponiendo

- Proteínas

- Proteínas

- probado

- Demuestra

- proporcionar

- proporciona un

- proporcionando

- publicado

- piñón

- calidad

- consultas

- Carrera

- distancia

- clasificar

- Tarifas

- más bien

- Crudo

- alcanzado

- Leer

- Reading

- reafirma

- real

- mundo real

- reciente

- recientemente

- recetas

- reconocimiento

- Recomendación

- recuperación

- reaparición

- recurrente

- recursiva

- reducir

- Reducción

- reduce

- la reducción de

- reducción

- referencia

- referencias

- refleja

- con respecto a

- Regula tu

- relacionado

- Relaciones

- ,

- liberado

- dependencia

- confiando

- permanece

- relevantes

- prestados

- representación

- representar

- representación

- representante

- que representa

- exigir

- requisito

- Requisitos

- la investigación

- Comunidad de Investigación

- investigadores

- Recursos

- respectivamente

- resultante

- Resultados

- reentrenamiento

- género

- revolucionar

- RGB

- Derecho

- Riesgo

- robusto

- Escalabilidad

- escalable

- Escala

- escamas

- la ampliación

- escenarios

- escena

- Escenas

- programación

- esquemas

- científico

- Puntuación

- rayar

- Buscar

- sentencia

- Secuencia

- Serie

- sirve

- set

- Sets

- ajustes

- Varios

- Compartir

- compartir

- a corto plazo

- Mostrar

- exhibido

- Demostramos a usted

- demostración

- Shows

- señales

- significado

- importante

- significativamente

- similares

- similitudes

- sencillos

- simultáneamente

- circunstancias

- Tamaño

- experto

- sin inconvenientes

- societal

- únicamente

- a medida

- Soluciones

- RESOLVER

- Resuelve

- Resolver

- algo

- a veces

- Espacio

- Espacio y tiempo

- abarcando

- especializado

- soluciones y

- Espectral

- velocidad

- dividido

- estándar

- el estado de la técnica

- declaraciones

- quedarse

- paso

- STORAGE

- tienda

- Estratégico

- estrategias

- Estrategia

- fuerte

- estructura

- estructurado

- estructuras

- Luchas

- ESTUDIO

- sustancial

- sustancialmente

- comercial

- exitosos

- Con éxito

- tal

- Sugiere

- adecuado

- superior

- supervisión

- supera

- incomparable

- SVG

- síntesis

- te

- Todas las funciones a su disposición

- Tarea

- tareas

- técnicas

- tender

- términos

- test

- texto

- que

- esa

- La

- La gráfica

- su

- Les

- luego

- teorético

- Estas

- ellos

- así

- miles

- Tres

- A través de esta formación, el personal docente y administrativo de escuelas y universidades estará preparado para manejar los recursos disponibles que derivan de la diversidad cultural de sus estudiantes. Además, un mejor y mayor entendimiento sobre estas diferencias y similitudes culturales permitirá alcanzar los objetivos de inclusión previstos.

- equipo

- veces

- a

- del IRS

- Temas

- hacia

- tradicional

- Entrenar

- entrenado

- Formación

- transferir

- Transferencia

- transformador

- transformers

- Traducción

- Calidad de traducción

- Tendencias

- tutoriales

- dos

- tipos

- subraya

- comprensión

- único

- unidades que

- diferente a

- sin precedentes

- actualizado

- Actualizaciones

- utilizan el

- usado

- usos

- usando

- utiliza

- v1

- Valioso

- diversos

- verificable

- versátil

- versatilidad

- versión

- Video

- Videos

- Ver

- vistas

- visibles

- visión

- sistemas de visión

- visual

- Reconocimiento visual

- volumen

- vs

- fue

- formas

- web

- peso

- WELL

- cuando

- sean

- que

- mientras

- amplio

- Amplia gama

- extensamente

- más ancho

- Comunidad más amplia

- Wikipedia

- seguirá

- dentro de

- sin

- palabras

- Actividades:

- funciona

- valor

- escrito

- años

- flexible

- Usted

- tú

- zephyrnet