Imagen por editor

Es 2023, lo que significa que la mayoría de las empresas en la mayoría de las industrias están recopilando información e impulsando decisiones más inteligentes con la ayuda de big data. Esto no es una gran sorpresa en estos días: la capacidad de recopilar, categorizar y analizar grandes conjuntos de datos es inmensamente útil cuando se trata de tomar decisiones comerciales basadas en datos.

Y, a medida que un número creciente de organizaciones adoptan la digitalización, la capacidad de captar y confiar en la utilidad del análisis de datos seguirá creciendo.

Sin embargo, esto es lo que pasa con los grandes datos: a medida que más organizaciones confían en ellos, mayor es la posibilidad de que más de ellos utilicen los grandes datos de forma incorrecta. ¿Por qué? Porque el big data y la información que ofrece solo son útiles si las organizaciones analizan sus datos con precisión.

Imagen de escalera de datos

Con ese fin, asegurémonos de evitar algunos errores comunes que a menudo afectan la precisión del análisis de datos. Siga leyendo para conocer estos problemas y cómo puede evitarlos.

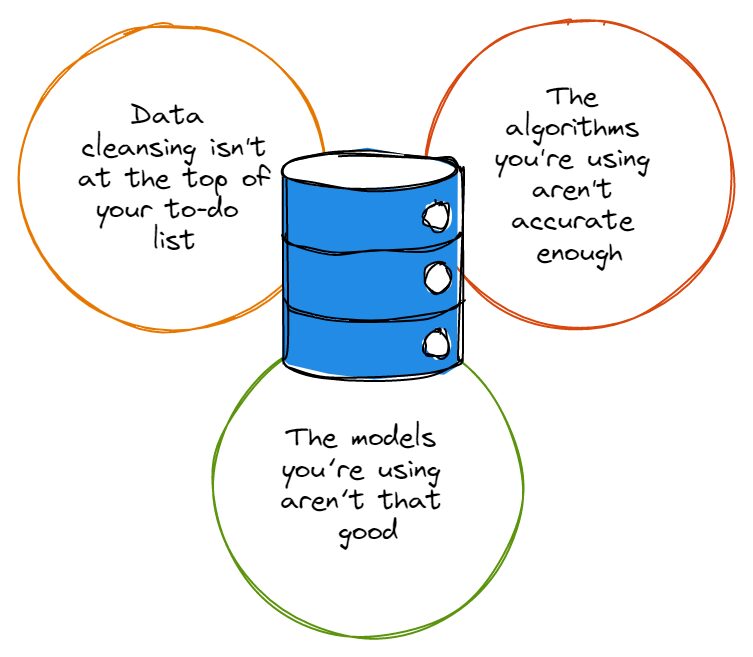

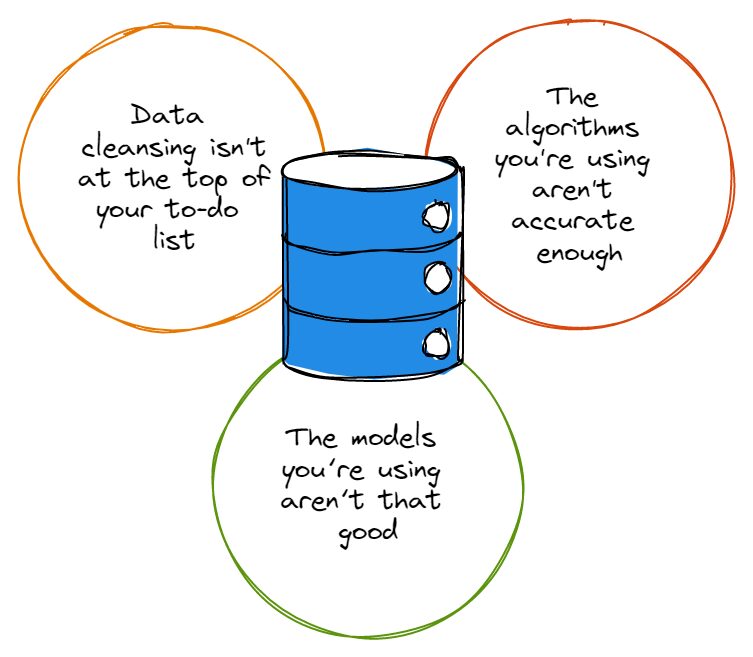

Antes de señalar con el dedo, debemos admitir que la mayoría de los conjuntos de datos tienen una buena cantidad de errores, y estos errores no le hacen ningún favor a nadie cuando llega el momento de analizar los datos. Ya sean errores tipográficos, convenciones de nomenclatura extrañas o redundancias, los errores en los conjuntos de datos confunden la precisión del análisis de datos.

Entonces, antes de que te entusiasmes demasiado con el buceo profundo en la madriguera del conejo de análisis de datos, primero debe asegurarse de que la limpieza de datos esté en la parte superior de su lista de tareas pendientes y de que siempre esté limpiando correctamente sus conjuntos de datos. Es posible que esté diciendo: "oye, la limpieza de datos requiere demasiado tiempo para que me moleste", a lo que asentimos con la cabeza con simpatía.

Afortunadamente para usted, puede invertir en soluciones como el análisis aumentado. Esto aprovecha los algoritmos de aprendizaje automático para acelerar la velocidad a la que realiza su análisis de datos (y también mejora la precisión de su análisis).

El resultado final: independientemente de la solución que utilice para automatizar y mejorar la limpieza de datos, aún necesita realizar la limpieza real; si no lo hace, nunca tendrá la base adecuada sobre la cual basar un análisis de datos preciso.

Como es el caso con los conjuntos de datos, la mayoría de los algoritmos no son perfectos al cien por cien; la mayoría de ellos tienen una buena cantidad de fallas y simplemente no funcionan de la manera que le gustaría que lo hicieran cada vez que los usa. Los algoritmos con un montón de imperfecciones pueden incluso ignorar datos que son esenciales para su análisis, o pueden centrarse en el tipo de datos incorrecto que en realidad no es tan importante.

No es ningún secreto que los nombres más importantes de la tecnología son constantemente examinando sus algoritmos y ajustarlos lo más cerca posible de la perfección, y es porque muy pocos algoritmos son realmente perfectos. Cuanto más preciso sea su algoritmo, mayor será la garantía de que sus programas están logrando sus objetivos y haciendo lo que necesita que hagan.

Además, si su organización cuenta con solo un par de científicos de datos, debe asegurarse de que esos científicos de datos realicen actualizaciones periódicas de los algoritmos que sus programas de análisis de datos; incluso puede valer la pena establecer un cronograma que responsabilice a los equipos por mantener y actualizar sus algoritmos de análisis de datos siguiendo un cronograma acordado.

Incluso mejor que eso puede ser establecer una estrategia que aprovecha los algoritmos basados en IA/ML, que deberían poder actualizarse automáticamente.

En su mayoría comprensiblemente, muchos líderes empresariales que no están directamente comprometidos con sus equipos de análisis de datos no se dan cuenta de que los algoritmos y modelos no son las mismas cosas. En caso de que USTED tampoco lo supiera, recuerde que los algoritmos son los métodos que usamos para analizar datos; los modelos son los cálculos que se crean aprovechando la salida de un algoritmo.

Los algoritmos pueden procesar datos durante todo el día, pero si su salida no pasa por modelos diseñados para verificar el análisis posterior, entonces no obtendrá ninguna información útil o utilizable.

Piénselo de esta manera: si tiene algoritmos sofisticados que procesan datos pero no tiene ningún conocimiento que mostrar, no tomará decisiones basadas en datos mejor de lo que era antes de tener esos algoritmos; sería como querer incorporar la investigación del usuario en la hoja de ruta de su producto pero ignorar el hecho de que, por ejemplo, la industria de la investigación de mercado generó $ 76.4 mil millones en ingresos en 2021, lo que representa un aumento del 100% desde 2008.

Sus intenciones pueden ser admirables, pero necesita hacer uso de las herramientas modernas y el conocimiento disponible para obtener esos conocimientos o construir esa investigación del usuario en su hoja de ruta lo mejor que pueda.

Es desafortunado que los modelos subóptimos sean una forma segura de arruinar la salida de sus algoritmos, sin importar cuán sofisticados sean esos algoritmos. Por lo tanto, es esencial que los ejecutivos de negocios y los líderes técnicos involucren más a sus expertos en análisis de datos para crear modelos que no sean ni demasiado complicados ni demasiado simples.

Y, dependiendo de la cantidad de datos con los que estén trabajando, los líderes empresariales pueden optar por pasar por algunos modelos diferentes antes de decidirse por el que mejor se adapte al volumen y tipo de datos que necesitan manejar.

Al final del día, si desea asegurarse de que su análisis de datos no sea incorrecto de manera constante, también debe recordar nunca seas víctima de prejuicios. Desafortunadamente, el sesgo es uno de los mayores obstáculos que deben superarse cuando se trata de mantener la precisión del análisis de datos.

Ya sea que influyan en el tipo de datos que se recopilan o afecten la forma en que los líderes empresariales interpretan los datos, los sesgos son variados y, a menudo, difíciles de precisar: los ejecutivos deben hacer todo lo posible para identificar sus sesgos y renunciar a ellos para beneficiarse de manera constante. análisis de datos precisos.

Los datos son poderosos: cuando se manejan correctamente, pueden otorgar a los líderes empresariales y sus organizaciones conocimientos inmensamente útiles que pueden transformar la forma en que desarrollan y entregan sus productos a sus clientes. Solo asegúrese de hacer todo lo que esté a su alcance para asegurarse de que sus análisis de datos sean precisos y no sufran los errores fácilmente evitables que hemos descrito en este artículo.

Nahla Davies es un desarrollador de software y escritor de tecnología. Antes de dedicar su trabajo a tiempo completo a la redacción técnica, se las arregló, entre otras cosas interesantes, para servir como programadora principal en una organización de marca experiencial Inc. 5,000 cuyos clientes incluyen Samsung, Time Warner, Netflix y Sony.

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- Platoblockchain. Inteligencia del Metaverso Web3. Conocimiento amplificado. Accede Aquí.

- Fuente: https://www.kdnuggets.com/2023/03/3-mistakes-could-affecting-accuracy-data-analytics.html?utm_source=rss&utm_medium=rss&utm_campaign=3-mistakes-that-could-be-affecting-the-accuracy-of-your-data-analytics

- :es

- 000

- 2021

- 2023

- a

- <del>

- capacidad

- Poder

- Nuestra Empresa

- acelerar

- lograr

- la exactitud

- preciso

- precisamente

- admirable

- admitir

- afectar

- afectando

- algoritmo

- algoritmos

- Todos

- hacerlo

- entre

- análisis

- Analytics

- analizar

- el análisis de

- y

- nadie

- somos

- artículo

- AS

- At

- aumentado

- automatizado

- automáticamente

- Hoy Disponibles

- evitar

- bases

- BE

- porque

- se convierte en

- antes

- "Ser"

- es el beneficio

- MEJOR

- mejores

- parcialidad

- Big

- Big Data

- más grande

- Mayor

- Fondo

- branding

- build

- Manojo

- negocios

- by

- PUEDEN

- case

- oportunidad

- comprobar

- Elige

- clientes

- Cerrar

- de cerca

- Codecademy

- El cobro

- cómo

- Algunos

- Complicado

- computaciones

- continue

- Convenciones

- podría

- Parejas

- Para crear

- creado

- crujido

- Clientes

- datos

- análisis de los datos

- Data Analytics

- conjuntos de datos

- basada en datos

- día

- Días

- decisiones

- profundo

- entregamos

- Dependiente

- diseñado

- desarrollar

- Developer

- una experiencia diferente

- difícil

- digitalización

- directamente

- "Hacer"

- DE INSCRIPCIÓN

- conducción

- pasan fácilmente

- ya sea

- Abrazar

- y conseguir de esta manera

- comprometido

- garantizar

- Errores

- esencial

- establecer

- el establecimiento

- Incluso

- Cada

- todo

- ejemplo

- excitado

- ejecutivos.

- experimental

- expertos

- feria

- Otoño

- favores

- pocos

- Nombre

- defectos

- Focus

- siguiendo

- Fundación

- Desde

- ser completados

- obtener

- Go

- Goals

- va

- conceder

- agarrar

- mayor

- mayores

- Crecer

- Creciendo

- garantizamos

- encargarse de

- Tienen

- ¡Aviso!

- ayuda

- mantiene

- Cómo

- HTML

- http

- HTTPS

- Obstáculos

- Identifique

- inmensamente

- importante

- mejorar

- mejora

- in

- Inc.

- incluir

- incorrectamente

- aumente

- industrias

- energético

- influenciando

- Insights

- intenciones

- Invertir

- cuestiones

- IT

- jpg

- nuggets

- Tipo

- especialistas

- Lead

- los líderes

- APRENDE:

- aprendizaje

- apalancamientos

- aprovechando

- como

- línea

- Lista

- Largo

- Lote

- máquina

- máquina de aprendizaje

- para lograr

- Realizar

- gestionado

- Mercado

- encuestas de mercado

- Materia

- significa

- métodos

- errores

- modelos

- Moderno

- más,

- MEJOR DE TU

- nombres

- nombrando

- ¿ Necesita ayuda

- Neither

- Netflix

- número

- of

- Ofertas

- on

- ONE

- solicite

- organización

- para las fiestas.

- Otro

- esbozado

- salida

- Superar

- por ciento

- perfecto

- realizar

- INVESTIGACIÓN PEW

- Platón

- Inteligencia de datos de Platón

- PlatónDatos

- posible

- industria

- poderoso

- Producto

- Productos

- Programador

- Programas

- apropiado

- correctamente

- Conejo

- Rate

- RE

- Leer

- darse cuenta de

- regularmente

- recordarlo

- que representa

- la investigación

- ingresos

- hoja de ruta

- s

- mismo

- Samsung

- programa

- los científicos

- Secreto

- ayudar

- Sets

- resolver

- Compartir

- tienes

- Mostrar

- sencillos

- simplemente

- desde

- más inteligente

- So

- Software

- a medida

- Soluciones

- algo

- Sony

- sofisticado

- Sin embargo

- Estrategia

- posterior

- tal

- sufrimiento

- sorpresa

- equipos

- tecnología

- Técnico

- esa

- La

- su

- Les

- sí mismos

- por lo tanto

- Estas

- cosa

- cosas

- A través de esta formación, el personal docente y administrativo de escuelas y universidades estará preparado para manejar los recursos disponibles que derivan de la diversidad cultural de sus estudiantes. Además, un mejor y mayor entendimiento sobre estas diferencias y similitudes culturales permitirá alcanzar los objetivos de inclusión previstos.

- equipo

- prolongado

- a

- demasiado

- parte superior

- Transformar

- pellizcar

- Comprensiblemente

- desgraciado

- Actualizar

- Actualizaciones

- actualización

- usable

- utilizan el

- Usuario

- Ve

- Víctima

- volumen

- falto

- Warner

- Camino..

- ¿

- sean

- que

- QUIENES

- seguirá

- Actividades:

- trabajando

- vale la pena

- escritor

- la escritura

- Mal

- tú

- zephyrnet