Μια τεχνική εργασία με τίτλο «Αποτελεσματική λύση LLM inference on Intel GPU» δημοσιεύτηκε από ερευνητές της Intel Corporation.

Περίληψη:

«Τα μοντέλα μεγάλων γλωσσών (LLM) που βασίζονται σε μετασχηματιστές έχουν χρησιμοποιηθεί ευρέως σε πολλούς τομείς και η αποτελεσματικότητα των συμπερασμάτων LLM γίνεται καυτό θέμα σε πραγματικές εφαρμογές. Ωστόσο, τα LLM συνήθως σχεδιάζονται περίπλοκα στη δομή του μοντέλου με τεράστιες λειτουργίες και εκτελούν συμπεράσματα στη λειτουργία αυτόματης παλινδρόμησης, καθιστώντας ένα δύσκολο έργο τον σχεδιασμό ενός συστήματος με υψηλή απόδοση.

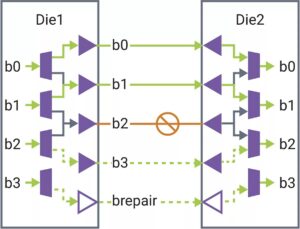

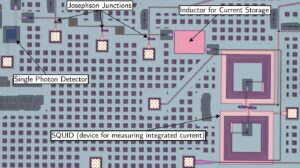

Σε αυτό το άρθρο, προτείνουμε μια αποτελεσματική λύση συμπερασμάτων LLM με χαμηλή καθυστέρηση και υψηλή απόδοση. Πρώτον, απλοποιούμε το επίπεδο αποκωδικοποιητή LLM συνδυάζοντας λειτουργίες κίνησης δεδομένων και στοιχείων για τη μείωση της συχνότητας πρόσβασης στη μνήμη και τη χαμηλότερη καθυστέρηση του συστήματος. Προτείνουμε επίσης μια πολιτική προσωρινής μνήμης τμήματος KV για τη διατήρηση του κλειδιού/τιμής των διακριτικών αιτήματος και απόκρισης σε ξεχωριστή φυσική μνήμη για αποτελεσματική διαχείριση της μνήμης της συσκευής, βοηθώντας στη μεγέθυνση του μεγέθους της παρτίδας χρόνου εκτέλεσης και στη βελτίωση της απόδοσης του συστήματος. Ένας προσαρμοσμένος πυρήνας Scaled-Dot-Product-Attention έχει σχεδιαστεί για να ταιριάζει με την πολιτική σύντηξης που βασίζεται στη λύση προσωρινής μνήμης τμήματος KV. Εφαρμόζουμε τη λύση συμπερασμάτων LLM στη GPU Intel και τη δημοσιεύουμε δημόσια. Σε σύγκριση με την τυπική εφαρμογή HuggingFace, η προτεινόμενη λύση επιτυγχάνει έως και 7 φορές χαμηλότερο λανθάνοντα χρόνο και 27 φορές υψηλότερη απόδοση για ορισμένα δημοφιλή LLM σε Intel GPU."

Βρείτε το τεχνικό χαρτί εδώ. Δημοσιεύθηκε Δεκέμβριος 2023 (προεκτύπωση).

Wu, Hui, Yi Gan, Feng Yuan, Jing Ma, Wei Zhu, Yutao Xu, Hong Zhu, Yuhua Zhu, Xiaoli Liu και Jinghui Gu. "Αποτελεσματική λύση συμπερασμάτων LLM σε Intel GPU." arXiv προεκτύπωση arXiv:2401.05391 (2023).

Σχετική ανάγνωση

Συμπεράσματα LLM σε CPU (Intel)

Ένα τεχνικό έγγραφο με τίτλο «Efficient LLM Inference on CPUs» δημοσιεύτηκε από ερευνητές της Intel.

Το AI Races To The Edge

Η εξαγωγή συμπερασμάτων και κάποια εκπαίδευση προωθούνται σε μικρότερες συσκευές καθώς η τεχνητή νοημοσύνη εξαπλώνεται σε νέες εφαρμογές.

- SEO Powered Content & PR Distribution. Ενισχύστε σήμερα.

- PlatoData.Network Vertical Generative Ai. Ενδυναμώστε τον εαυτό σας. Πρόσβαση εδώ.

- PlatoAiStream. Web3 Intelligence. Ενισχύθηκε η γνώση. Πρόσβαση εδώ.

- PlatoESG. Ανθρακας, Cleantech, Ενέργεια, Περιβάλλον, Ηλιακός, Διαχείριση των αποβλήτων. Πρόσβαση εδώ.

- PlatoHealth. Ευφυΐα βιοτεχνολογίας και κλινικών δοκιμών. Πρόσβαση εδώ.

- πηγή: https://semiengineering.com/llm-inference-on-gpus-intel/

- :είναι

- $UP

- 2023

- a

- πρόσβαση

- Επιτυγχάνει

- AI

- Επίσης

- an

- και

- εφαρμογές

- ΕΙΝΑΙ

- AS

- At

- βασίζονται

- γίνεται

- ήταν

- είναι

- by

- κρύπτη

- πρόκληση

- σύγκριση

- ΕΤΑΙΡΕΙΑ

- προσαρμοσμένη

- ημερομηνία

- Δεκέμβριος

- Υπηρεσίες

- σχεδιασμένα

- συσκευή

- Συσκευές

- Αποτελεσματικός

- αποδοτικότητα

- αποτελεσματικός

- μεγέθυνση

- Πεδία

- Για

- Συχνότητα

- τήξη

- συγχώνευση

- GPU

- GPU

- Έχω

- βοήθεια

- εδώ

- Ψηλά

- υψηλότερο

- Χονγκ

- ΚΑΥΤΌ

- Ωστόσο

- HTTPS

- Πρόσωπο αγκαλιάς

- εφαρμογή

- εκτέλεση

- βελτίωση

- in

- Intel

- IT

- jpg

- Διατήρηση

- Γλώσσα

- large

- Αφάνεια

- στρώμα

- llm

- Χαμηλός

- χαμηλότερα

- Κατασκευή

- διαχείριση

- πολοί

- μαζική

- Ταίριασμα

- Μνήμη

- Τρόπος

- μοντέλο

- μοντέλα

- κίνηση

- Νέα

- of

- on

- ανοίξτε

- λειτουργίες

- δικός μας

- Χαρτί

- εκτελέσει

- φυσικός

- Πλάτων

- Πληροφορία δεδομένων Plato

- Πλάτωνα δεδομένα

- πολιτική

- Δημοφιλής

- προτείνω

- προτείνεται

- δημοσίως

- δημοσιεύει

- δημοσιεύθηκε

- πίεσε

- ιπποδρομίες

- πραγματικός

- μείωση

- ζητήσει

- ερευνητές

- απάντησης

- τμήμα

- ξεχωριστό

- απλοποίηση

- Μέγεθος

- μικρότερος

- λύση

- μερικοί

- Spreads

- πρότυπο

- δομή

- σύστημα

- Έργο

- Τεχνικός

- Η

- αυτό

- διακίνηση

- με τίτλο

- προς την

- ένδειξη

- κουπόνια

- τοπικός

- Εκπαίδευση

- μεταχειρισμένος

- συνήθως

- ήταν

- we

- ευρέως

- με

- Γιουάν

- zephyrnet