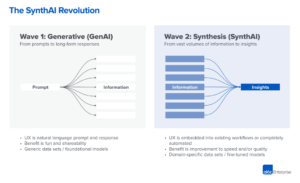

Vi begynder at se de meget tidlige stadier af en teknologisk stack dukke op i generativ kunstig intelligens (AI). Hundredvis af nye startups skynder sig ind på markedet for at udvikle fundamentmodeller, bygge AI-native apps og stand up-infrastruktur/værktøj.

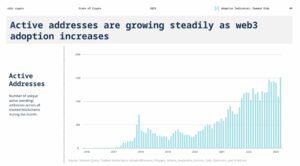

Mange hotte teknologitrends bliver overhypet langt før markedet indhenter det. Men det generative AI-boom er blevet ledsaget af reelle gevinster på rigtige markeder og reel trækkraft fra rigtige virksomheder. Modeller som Stable Diffusion og ChatGPT sætter historiske rekorder for brugervækst, og flere applikationer har nået $100 millioner i årlig omsætning mindre end et år efter lanceringen. Side-by-side sammenligninger viser AI-modeller udkonkurrerende mennesker i nogle opgaver i flere størrelsesordener.

Så der er nok tidlige data til at antyde, at massiv transformation finder sted. Hvad vi ikke ved, og hvad der nu er blevet det kritiske spørgsmål, er: Hvor på dette marked vil værdien opstå?

I løbet af det sidste år har vi mødt dusinvis af startup-stiftere og -operatører i store virksomheder, som beskæftiger sig direkte med generativ AI. Det har vi observeret leverandører af infrastruktur er sandsynligvis de største vindere på dette marked indtil videre, og fanger størstedelen af de dollars, der flyder gennem stakken. Applikationsvirksomheder vokser overordnet indtægter meget hurtigt, men kæmper ofte med fastholdelse, produktdifferentiering og bruttomargener. Og de fleste model udbydere, selvom de er ansvarlige for selve eksistensen af dette marked, har de endnu ikke opnået stor kommerciel skala.

Med andre ord, de virksomheder, der skaber mest værdi - dvs. at træne generative AI-modeller og anvende dem i nye apps - har ikke fanget det meste. Det er meget sværere at forudsige, hvad der vil ske næste gang. Men vi mener, at det vigtigste at forstå er, hvilke dele af stakken der virkelig er differentierede og forsvarlige. Dette vil have stor indflydelse på markedsstrukturen (dvs. horisontal vs. vertikal virksomhedsudvikling) og drivkræfterne bag langsigtet værdi (f.eks. marginer og fastholdelse). Indtil videre har vi haft svært ved at finde strukturel forsvarlighed overalt i stablen, uden for traditionelle voldgrave for etablerede.

Vi er utroligt positive med hensyn til generativ kunstig intelligens og tror på, at det vil have en massiv indflydelse i softwareindustrien og videre. Målet med dette indlæg er at kortlægge dynamikken i markedet og begynde at besvare de bredere spørgsmål om generative AI-forretningsmodeller.

Teknologistack på højt niveau: Infrastruktur, modeller og apps

For at forstå, hvordan det generative AI-marked tager form, skal vi først definere, hvordan stakken ser ud i dag. Her er vores foreløbige opfattelse.

Stakken kan opdeles i tre lag:

- Applikationer der integrerer generative AI-modeller i et brugervendt produkt, der enten kører deres egne modelpipelines ("end-to-end apps") eller er afhængige af en tredjeparts API

- Modeller at driver AI-produkter, der gøres tilgængelige enten som proprietære API'er eller som open source checkpoints (som igen kræver en hostingløsning)

- Infrastruktur leverandører (dvs. cloud-platforme og hardwareproducenter), der kører trænings- og inferensarbejdsbelastninger for generative AI-modeller

Det er vigtigt at bemærke: Dette er ikke et markedskort, men en ramme til at analysere markedet. I hver kategori har vi listet nogle få eksempler på velkendte leverandører. Vi har ikke gjort noget forsøg på at være omfattende eller liste alle de fantastiske generative AI-applikationer, der er blevet frigivet. Vi går heller ikke i dybden her med MLops eller LLMops-værktøjer, som endnu ikke er meget standardiseret og vil blive behandlet i et fremtidigt indlæg.

Den første bølge af generative AI-apps begynder at nå skala, men kæmper med fastholdelse og differentiering

I tidligere teknologicyklusser var den konventionelle visdom, at for at bygge en stor, uafhængig virksomhed skal du eje slutkunden - uanset om det betød individuelle forbrugere eller B2B-købere. Det er fristende at tro, at de største virksomheder inden for generativ AI også vil være slutbrugerapplikationer. Indtil videre er det ikke klart, at det er tilfældet.

Ganske vist har væksten af generative AI-applikationer været svimlende, drevet af ren og skær nyhed og et væld af brugssager. Faktisk er vi opmærksomme på mindst tre produktkategorier, der allerede har overskredet $100 millioner i årlig omsætning: billedgenerering, copywriting og kodeskrivning.

Vækst alene er dog ikke nok til at opbygge holdbare softwarevirksomheder. Kritisk set skal vækst være rentabel - i den forstand, at brugere og kunder, når de tilmelder sig, genererer overskud (høje bruttomarginer) og bliver ved i lang tid (høj fastholdelse). I mangel af stærk teknisk differentiering, driver B2B- og B2C-apps langsigtet kundeværdi gennem netværkseffekter, fastholdelse af data eller opbygning af stadig mere komplekse arbejdsgange.

I generativ AI holder disse antagelser ikke nødvendigvis stik. På tværs af app-virksomheder, vi har talt med, er der en bred vifte af bruttoavancer - så høje som 90 % i nogle få tilfælde, men oftere så lave som 50-60 %, hovedsageligt drevet af omkostningerne ved modelslutning. Væksten i toppen af tragten har været fantastisk, men det er uklart, om de nuværende strategier for kundeerhvervelse vil være skalerbare – vi ser allerede, at effektiviteten og fastholdelsen af betalt opkøb begynder at aftage. Mange apps er også relativt udifferentierede, da de er afhængige af lignende underliggende AI-modeller og ikke har opdaget åbenlyse netværkseffekter eller data/workflows, som er svære for konkurrenter at duplikere.

Så det er endnu ikke indlysende, at salg af slutbrugerapps er den eneste, eller endda den bedste, vej til at opbygge en bæredygtig generativ AI-forretning. Marginerne bør forbedres, efterhånden som konkurrencen og effektiviteten i sprogmodeller øges (mere om dette nedenfor). Fastholdelsen bør stige, efterhånden som AI-turister forlader markedet. Og der er et stærkt argument at fremføre for, at vertikalt integrerede apps har en fordel i at drive differentiering. Men der er stadig meget at bevise.

Når man ser fremad, er nogle af de store spørgsmål, som generative AI-appvirksomheder står over for:

- Vertikal integration ("model + app"). At forbruge AI-modeller som en service giver app-udviklere mulighed for at iterere hurtigt med et lille team og bytte modeludbydere, efterhånden som teknologien udvikler sig. På bagsiden hævder nogle udviklere, at produktet is modellen, og at træning fra bunden er den eneste måde at skabe forsvarlighed på – altså ved løbende at genoptræne på proprietære produktdata. Men det kommer på bekostning af meget højere kapitalkrav og et mindre smidigt produktteam.

- Bygningsfunktioner kontra apps. Generative AI-produkter har en række forskellige former: desktop-apps, mobilapps, Figma/Photoshop-plugins, Chrome-udvidelser, endda Discord-bots. Det er nemt at integrere AI-produkter, hvor brugerne allerede arbejder, da brugergrænsefladen generelt kun er en tekstboks. Hvilke af disse vil blive selvstændige virksomheder - og hvilke vil blive absorberet af etablerede virksomheder, som Microsoft eller Google, der allerede inkorporerer AI i deres produktlinjer?

- Håndtere gennem hype-cyklussen. Det er endnu ikke klart, om churn er iboende i det nuværende parti af generative AI-produkter, eller om det er en artefakt af et tidligt marked. Eller hvis stigningen i interessen for generativ AI vil falde, efterhånden som hypen aftager. Disse spørgsmål har vigtige konsekvenser for app-virksomheder, herunder hvornår man skal trykke gaspedalen på fundraising; hvor aggressivt at investere i kundeerhvervelse; hvilke brugersegmenter der skal prioriteres; og hvornår man skal erklære produkt-marked egnet.

Modeludbydere opfandt generativ kunstig intelligens, men har ikke nået stor kommerciel skala

Det, vi nu kalder generativ AI, ville ikke eksistere uden det strålende forsknings- og ingeniørarbejde, der er udført på steder som Google, OpenAI og Stability. Gennem nye modelarkitekturer og heroiske bestræbelser på at skalere træningspipelines, drager vi alle fordel af de overvældende muligheder i nuværende store sprogmodeller (LLM'er) og billedgenereringsmodeller.

Alligevel er omsætningen forbundet med disse virksomheder stadig relativt lille sammenlignet med brugen og buzzen. I billedgenerering har Stable Diffusion oplevet eksplosiv vækst i fællesskabet, understøttet af et økosystem af brugergrænseflader, hostede tilbud og finjusteringsmetoder. Men Stabilitet giver deres store checkpoints gratis væk som en kerne i deres forretning. I naturlige sprogmodeller dominerer OpenAI med GPT-3/3.5 og ChatGPT. Men relativt få dræber apps bygget på OpenAI eksisterer indtil videre, og priserne har allerede faldt en gang.

Dette kan kun være et midlertidigt fænomen. Stabilitet er en ny virksomhed, der endnu ikke har fokuseret på indtægtsgenerering. OpenAI har potentialet til at blive en massiv forretning, der tjener en betydelig del af alle NLP-kategoriens indtægter, efterhånden som flere dræber apps bliver bygget - især hvis deres integration i Microsofts produktportefølje går glat. I betragtning af den enorme brug af disse modeller er indtægter i stor skala muligvis ikke langt bagud.

Men der er også modkræfter. Modeller udgivet som open source kan hostes af alle, inklusive eksterne virksomheder, der ikke bærer omkostningerne forbundet med modeluddannelse i stor skala (op til titusinder eller hundreder af millioner af dollars). Og det er ikke klart, om nogen lukkede kildemodeller kan bevare deres forspring på ubestemt tid. For eksempel er vi begyndt at se LLM'er bygget af virksomheder som Anthropic, Cohere og Character.ai komme tættere på OpenAI niveauer af ydeevne, trænet på lignende datasæt (dvs. internettet) og med lignende modelarkitekturer. Eksemplet med stabil diffusion antyder det if open source-modeller når et tilstrækkeligt niveau af ydeevne og fællesskabssupport, så kan proprietære alternativer finde det svært at konkurrere.

Måske er den mest klare takeaway for modeludbydere indtil videre, at kommercialisering sandsynligvis er knyttet til hosting. Efterspørgslen efter proprietære API'er (f.eks. fra OpenAI) vokser hurtigt. Hostingtjenester til open source-modeller (f.eks. Hugging Face og Replicate) dukker op som nyttige hubs til nemt at dele og integrere modeller - og endda have nogle indirekte netværkseffekter mellem modelproducenter og forbrugere. Der er også en stærk hypotese om, at det er muligt at tjene penge gennem finjustering og hostingaftaler med virksomhedskunder.

Ud over det er der dog en række store spørgsmål, som modeludbydere står over for:

- Kommoditisering. Der er en almindelig tro på, at AI-modeller vil konvergere i ydeevne over tid. Når man taler med app-udviklere, er det tydeligt, at det ikke er sket endnu, med stærke ledere inden for både tekst- og billedmodeller. Deres fordele er ikke baseret på unikke modelarkitekturer, men på høje kapitalkrav, proprietære produktinteraktionsdata og knap AI-talent. Vil dette tjene som en varig fordel?

- Gradueringsrisiko. At stole på modeludbydere er en fantastisk måde for appvirksomheder at komme i gang og endda til at vokse deres virksomheder. Men der er incitament for dem til at bygge og/eller være vært for deres egne modeller, når de når skalaen. Og mange modeludbydere har meget skæve kundefordelinger, hvor nogle få apps repræsenterer størstedelen af omsætningen. Hvad sker der, hvis/når disse kunder skifter til intern AI-udvikling?

- Er penge vigtige? Løftet om generativ kunstig intelligens er så stort - og også potentielt så skadeligt - at mange modeludbydere har organiseret sig som almennyttige virksomheder (B-korps), udstedt overskudsandele med loft eller på anden måde inkorporeret almenvellet eksplicit i deres mission. Dette har overhovedet ikke hindret deres fundraising-indsats. Men der er en rimelig diskussion om, hvorvidt de fleste modeludbydere faktisk ønsker at fange værdi, og hvis de burde.

Infrastrukturleverandører rører ved alt og høster frugterne

Næsten alt i generativ AI passerer gennem en cloud-hostet GPU (eller TPU) på et tidspunkt. Uanset om det er modeludbydere/forskningslaboratorier, der kører træningsarbejdsbelastninger, hostingvirksomheder, der kører inferens/finjustering, eller applikationsvirksomheder, der udfører en kombination af begge - flops er livsnerven i generativ AI. For første gang i meget lang tid er fremskridt inden for den mest disruptive computerteknologi massivt computerbundet.

Som et resultat flyder mange af pengene på det generative AI-marked i sidste ende igennem til infrastrukturvirksomheder. For at sætte nogle meget grove tal omkring det: Vi anslår, at app-virksomheder i gennemsnit bruger omkring 20-40 % af omsætningen på slutninger og finjusteringer pr. kunde. Dette betales typisk enten direkte til cloud-udbydere for computerforekomster eller til tredjepartsmodeludbydere - som til gengæld bruger omkring halvdelen af deres omsætning på cloud-infrastruktur. Så det er rimeligt at gætte på, at 10-20 % af samlede indtægter i generativ AI går i dag til cloud-udbydere.

Oven i dette har startups, der træner deres egne modeller, rejst milliarder af dollars i venturekapital - hvoraf størstedelen (op til 80-90% i tidlige runder) typisk også bruges hos cloud-udbyderne. Mange offentlige teknologivirksomheder bruger hundredvis af millioner om året på modeltræning, enten hos eksterne cloud-udbydere eller direkte hos hardwareproducenter.

Dette er, hvad vi i tekniske termer vil kalde "en masse penge" - især for et begyndende marked. Det meste bliver brugt på Big 3 skyer: Amazon Web Services (AWS), Google Cloud Platform (GCP) og Microsoft Azure. Disse cloud-udbydere tilsammen bruge mere end $ 100 mia. Om året i capex for at sikre, at de har de mest omfattende, pålidelige og omkostningskonkurrencedygtige platforme. Især inden for generativ AI har de også fordel af forsyningsbegrænsninger, fordi de har fortrinsadgang til knap hardware (f.eks. Nvidia A100 og H100 GPU'er).

Interessant nok er vi dog begyndt at se troværdig konkurrence opstå. Udfordrere som Oracle har gjort indtog med store capex-udgifter og salgsincitamenter. Og nogle få startups, som Coreweave og Lambda Labs, er vokset hurtigt med løsninger rettet specifikt mod store modeludviklere. De konkurrerer på omkostninger, tilgængelighed og personlig support. De afslører også mere granulære ressourceabstraktioner (dvs. containere), mens de store skyer kun tilbyder VM-instanser på grund af GPU-virtualiseringsgrænser.

Bag kulisserne, at køre langt de fleste AI-arbejdsbelastninger, er måske den hidtil største vinder inden for generativ AI: Nvidia. Virksomheden rapporteret $3.8 milliarder af datacenterets GPU-omsætning i tredje kvartal af regnskabsåret 2023, herunder en meningsfuld del til generative AI-brugssager. Og de har bygget stærke voldgrave omkring denne virksomhed via årtiers investering i GPU-arkitekturen, et robust software-økosystem og dyb brug i det akademiske samfund. En nylig analyse fandt ud af, at Nvidia GPU'er er citeret i forskningsartikler 90 gange mere end de bedste AI-chipstartups tilsammen.

Der findes andre hardwaremuligheder, herunder Google Tensor Processing Units (TPU'er); AMD Instinct GPU'er; AWS Inferentia og Trainium chips; og AI-acceleratorer fra startups som Cerebras, Sambanova og Graphcore. Intel, sent til spillet, kommer også ind på markedet med deres avancerede Habana-chips og Ponte Vecchio GPU'er. Men indtil videre har få af disse nye chips taget betydelige markedsandele. De to undtagelser at se er Google, hvis TPU'er har vundet indpas i Stable Diffusion-fællesskabet og i nogle store GCP-aftaler, og TSMC, som menes at producere alle af de chips, der er angivet her, inklusive Nvidia GPU'er (Intel bruger en blanding af sine egne fabs og TSMC til at lave sine chips).

Infrastruktur er med andre ord et lukrativt, holdbart og tilsyneladende forsvarligt lag i stakken. De store spørgsmål at besvare for infra-virksomheder inkluderer:

- Holder fast i statsløse arbejdsbyrder. Nvidia GPU'er er de samme, uanset hvor du lejer dem. De fleste AI-arbejdsbelastninger er statsløse i den forstand, at modelinferens ikke kræver vedhæftede databaser eller lagring (bortset fra selve modelvægtene). Dette betyder, at AI-arbejdsbelastninger kan være mere bærbare på tværs af skyer end traditionelle applikationsarbejdsbelastninger. Hvordan kan cloud-udbydere i denne sammenhæng skabe klæbrighed og forhindre kunder i at hoppe til den billigste løsning?

- At overleve enden på chipknaphed. Prissætning for cloud-udbydere og for Nvidia selv er blevet understøttet af knappe forsyninger af de mest eftertragtede GPU'er. En udbyder fortalte os, at listeprisen for A100s faktisk har øget siden lanceringen, hvilket er meget usædvanligt for computerhardware. Når denne forsyningsbegrænsning i sidste ende fjernes gennem øget produktion og/eller vedtagelse af nye hardwareplatforme, hvordan vil dette påvirke cloud-udbydere?

- Kan en udfordrersky bryde igennem? Det er vi stærkt overbeviste om lodrette skyer vil tage markedsandele fra Big 3 med mere specialiserede tilbud. Inden for kunstig intelligens indtil videre har udfordrerne skabt meningsfuld trækkraft gennem moderat teknisk differentiering og støtte fra Nvidia - for hvem de etablerede cloud-udbydere både er de største kunder og nye konkurrenter. Det langsigtede spørgsmål er, vil dette være nok til at overvinde skalafordelene ved Big 3?

Så ... hvor vil værdien opstå?

Det ved vi selvfølgelig ikke endnu. Men baseret på de tidlige data, vi har for generativ AI, kombineret med vores erfaring med tidligere AI/ML-virksomheder, vores intuition er følgende.

Der ser i dag ikke ud til at være nogen systemiske voldgrave i generativ AI. Som en førsteordens tilnærmelse mangler applikationer stærk produktdifferentiering, fordi de bruger lignende modeller; modeller står over for uklar langsigtet differentiering, fordi de er trænet på lignende datasæt med lignende arkitekturer; cloud-udbydere mangler dyb teknisk differentiering, fordi de kører de samme GPU'er; og selv hardwarefirmaerne fremstiller deres chips på de samme fabrikker.

Der er selvfølgelig standardgrave: skalagrave ("Jeg har eller kan rejse flere penge end dig!"), forsyningskædegrave ("Jeg har GPU'erne, du har ikke!"), økosystemgrave (" Alle bruger allerede min software!"), algoritmiske voldgrave ("Vi er klogere end dig!"), distributionsgrave ("Jeg har allerede et salgsteam og flere kunder end dig!") og datapipeline-grave ("Jeg' har kravlet mere af internettet end dig!”). Men ingen af disse voldgrave har en tendens til at være holdbare på lang sigt. Og det er for tidligt at sige, om stærke, direkte netværkseffekter tager fat i ethvert lag af stakken.

Baseret på de tilgængelige data er det bare ikke klart, om der vil være en langsigtet, vinder-tag-alt dynamik i generativ AI.

Det her er underligt. Men for os er det gode nyheder. Den potentielle størrelse af dette marked er svær at forstå - et sted imellem al software , alle menneskelige bestræbelser — så vi forventer mange, mange spillere og sund konkurrence på alle niveauer af stablen. Vi forventer også, at både horisontale og vertikale virksomheder får succes med den bedste tilgang dikteret af slutmarkeder og slutbrugere. For eksempel, hvis den primære differentiering i slutproduktet er selve AI'en, er det sandsynligt, at vertikalisering (dvs. tæt kobling af den brugervendte app til den hjemmedyrkede model) vil vinde frem. Hvorimod hvis AI er en del af et større, long-tail funktionssæt, så er det mere sandsynligt, at horisontalisering vil forekomme. Selvfølgelig bør vi også se bygningen af mere traditionelle voldgrave over tid - og vi kan endda se nye typer voldgrave tage fat.

Uanset hvad, er en ting, vi er sikre på, at generativ AI ændrer spillet. Vi lærer alle reglerne i realtid, der er en enorm mængde værdi, der vil blive låst op, og det teknologiske landskab kommer til at se meget, meget anderledes ud som et resultat. Og vi er her for det!

Alle billeder i dette indlæg blev lavet ved hjælp af Midjourney.

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- Platoblokkæde. Web3 Metaverse Intelligence. Viden forstærket. Adgang her.

- Kilde: https://a16z.com/2023/01/19/who-owns-the-generative-ai-platform/

- $ 100 millioner

- $3

- 1

- a

- A100

- Om

- akademisk

- acceleratorer

- adgang

- opnået

- erhvervelse

- tværs

- faktisk

- Vedtagelse

- fremskridt

- Fordel

- fordele

- Efter

- aftaler

- forude

- AI

- AI platform

- ai use cases

- AI / ML

- algoritmisk

- Alle

- tillader

- alene

- allerede

- alternativer

- forbløffende

- Amazon

- Amazon Web Services

- Amazon Web Services (AWS)

- AMD

- beløb

- analysere

- ,

- annualiseret

- besvare

- nogen

- API'er

- app

- vises

- Anvendelse

- applikationer

- Anvendelse

- tilgang

- apps

- arkitektur

- argumentere

- argument

- omkring

- kunstig

- kunstig intelligens

- Kunstig intelligens (AI)

- forbundet

- tilgængelighed

- til rådighed

- gennemsnit

- AWS

- AWS-inferens

- Azure

- B2B

- B2C

- baseret

- Husk

- fordi

- bliver

- før

- bag

- tro

- Tro

- troede

- troende

- jf. nedenstående

- gavner det dig

- BEDSTE

- mellem

- Beyond

- Big

- Største

- Billion

- milliarder

- boom

- bots

- bundet

- Boks

- Pause

- strålende

- bredere

- bygge

- Bygning

- bygget

- Bullish

- virksomhed

- virksomheder

- købere

- ringe

- kapaciteter

- kapital

- fange

- Optagelse

- tilfælde

- tilfælde

- kategorier

- Boligtype

- center

- vis

- udfordrer

- Ændringer

- karakter

- ChatGPT

- billigste

- chip

- Chips

- Chrome

- citeret

- klar

- tættere

- Cloud

- sky infrastruktur

- Cloud platform

- kode

- kollektivt

- kombination

- kombineret

- Kom

- kommerciel

- kommercialisering

- Fælles

- samfund

- Virksomheder

- selskab

- sammenlignet

- konkurrere

- konkurrence

- konkurrenter

- komplekse

- omfattende

- Compute

- computing

- begrænsninger

- Forbrugere

- Beholdere

- sammenhæng

- løbende

- konventionelle

- Converge

- tekstforfatning

- Core

- Selskaber

- Koste

- Omkostninger

- kursus

- skabe

- oprettet

- Oprettelse af

- troværdig

- kritisk

- Nuværende

- kunde

- Kunder

- cykler

- data

- Data Center

- databaser

- datasæt

- deal

- Tilbud

- årtier

- dyb

- Efterspørgsel

- desktop

- udvikle

- udviklere

- Udvikling

- devs

- forskellige

- forskellige former

- differentieret

- Broadcasting

- direkte

- direkte

- disharmoni

- opdaget

- diskussion

- forstyrrende

- fordeling

- Distributioner

- Divided

- gør

- dollars

- dominerer

- Dont

- snesevis

- køre

- drevet

- drivere

- kørsel

- dynamisk

- dynamik

- hver

- tidligere

- Tidligt

- Optjening

- nemt

- økosystem

- Edge

- effekter

- effektivitet

- indsats

- enten

- smergel

- Engineering

- nok

- sikre

- Enterprise

- virksomhedskunder

- især

- skøn

- Endog

- til sidst

- at alt

- eksempel

- eksempler

- forvente

- erfaring

- udvidelser

- ekstern

- Ansigtet

- vender

- Fall

- Feature

- Funktionalitet

- få

- Finde

- finde

- Fornavn

- første gang

- Fiscal

- passer

- Flip

- Flowing

- strømme

- fokuserede

- efter

- Forces

- formularer

- fundet

- Foundation

- stiftere

- Framework

- Gratis

- fra

- Fundraising

- fremtiden

- gevinster

- spil

- GAS

- generelt

- generere

- generation

- generative

- Generativ AI

- få

- given

- giver

- mål

- Goes

- gå

- godt

- Google Cloud

- Google Cloud Platform

- GPU

- GPU'er

- forståelse

- stor

- brutto

- Grow

- Dyrkning

- voksen

- Vækst

- Halvdelen

- ske

- skete

- sker

- Hård Ost

- Hardware

- skadelig

- sund

- link.

- Høj

- højere

- stærkt

- historisk

- Hit

- hold

- bedrift

- Vandret

- host

- hostede

- Hosting

- HOT

- Hvordan

- HTTPS

- kæmpe

- menneskelig

- Hundreder

- hundreder af millioner

- Hype

- billede

- billedgenerering

- billeder

- KIMOs Succeshistorier

- implikationer

- vigtigt

- Forbedre

- in

- I andre

- Tilskyndelse

- Incitamenter

- omfatter

- Herunder

- Incorporated

- inkorporering

- Forøg

- øget

- Stigninger

- stigende

- utroligt

- Incumbent

- uafhængig

- individuel

- industrien

- Infrastruktur

- iboende

- integrere

- integreret

- integration

- Intel

- Intelligens

- interaktion

- interesse

- grænseflader

- Internet

- intuition

- Opfundet

- Invest

- investering

- Udstedt

- IT

- selv

- Nøgle

- Kend

- Labs

- Mangel

- landskab

- Sprog

- stor

- storstilet

- vid udstrækning

- større

- Efternavn

- Sidste år

- Sent

- lancere

- lag

- lag

- ledere

- læring

- Forlade

- Niveau

- niveauer

- Sandsynlig

- grænser

- linjer

- Liste

- Børsnoterede

- Lang

- lang tid

- langsigtet

- Se

- UDSEENDE

- Lot

- Lav

- lukrative

- lavet

- vedligeholde

- større

- Flertal

- lave

- Producenter

- mange

- kort

- marginer

- Marked

- markedskort

- Markedsstruktur

- Markeder

- massive

- massivt

- max-bredde

- meningsfuld

- midler

- metoder

- microsoft

- Microsoft Azure

- MidJourney

- million

- millioner

- Mission

- MLOps

- Mobil

- mobil-apps

- model

- modeller

- monetarisering

- tjene penge

- penge

- mere

- mest

- flere

- spirende

- Natural

- Naturligt sprog

- nødvendigvis

- Behov

- netværk

- Ny

- ny hardware

- nyheder

- næste

- adræt

- NLP

- roman

- nyhed

- nummer

- numre

- Nvidia

- Obvious

- tilbyde

- tilbud

- ONE

- åbent

- open source

- OpenAI

- Operatører

- Option

- Indstillinger

- oracle

- ordrer

- Organiseret

- Andet

- Ellers

- uden for

- Overvind

- egen

- ejer

- betalt

- papirer

- del

- særlig

- dele

- gennemløb

- sti

- ydeevne

- måske

- Personlig

- fænomen

- pipeline

- Place

- Steder

- perron

- Platforme

- plato

- Platon Data Intelligence

- PlatoData

- spillere

- overflod

- Plugins

- Punkt

- mulig

- Indlæg

- potentiale

- potentielt

- magt

- forudsige

- forhindre

- pris

- Priser

- primære

- Forud

- Prioriter

- forarbejdning

- Producenter

- Produkt

- produktion

- Produkter

- Profit

- rentabel

- overskud

- Progress

- løfte

- proprietære

- Bevise

- udbyder

- udbydere

- offentlige

- sætte

- Kvarter

- spørgsmål

- Spørgsmål

- hurtigt

- rejse

- hævet

- rækkevidde

- hurtigt

- nå

- nået

- ægte

- realtid

- rimelige

- nylige

- optegnelser

- relativt

- frigivet

- pålidelig

- fjernet

- Lej

- repræsenterer

- kræver

- Krav

- forskning

- ressource

- ansvarlige

- resultere

- tilbageholdelse

- indtægter

- indtægter

- Risiko

- robust

- runder

- regler

- Kør

- kører

- salg

- Salgsincitamenter

- samme

- skalerbar

- Scale

- Knappe

- Mangel

- scener

- se

- segmenter

- Salg

- forstand

- tjener

- tjeneste

- Tjenester

- sæt

- indstilling

- flere

- Shape

- Del

- Aktier

- bør

- Vis

- underskrive

- signifikant

- lignende

- siden

- Størrelse

- lille

- glat

- So

- indtil nu

- Software

- løsninger

- Løsninger

- nogle

- et eller andet sted

- Kilde

- specialiserede

- specifikt

- tilbringe

- brugt

- Stabilitet

- stabil

- stable

- etaper

- stå

- standalone

- standard

- starte

- påbegyndt

- Starter

- opstart

- Nystartede

- Stick

- Stadig

- opbevaring

- strategier

- stærk

- strukturel

- struktur

- Kamp

- lykkes

- tilstrækkeligt

- foreslår

- forsyne

- support

- Understøttet

- bølge

- bæredygtig

- Kontakt

- systemisk

- Tag

- tager

- Talent

- taler

- målrettet

- opgaver

- hold

- tech

- tech virksomheder

- Teknisk

- Teknologier

- midlertidig

- vilkår

- deres

- selv

- ting

- Tredje

- tredjepart

- tre

- Gennem

- Tied

- stramt

- tid

- gange

- til

- i dag

- også

- top

- trækkraft

- traditionelle

- uddannet

- Kurser

- Transformation

- enorm

- Tendenser

- sand

- tsmc

- TUR

- typer

- typisk

- ui

- Ultimativt

- underliggende

- forstå

- enestående

- enheder

- usædvanlig

- us

- Brug

- brug

- Bruger

- brugere

- værdi

- Vast

- leverandører

- venture

- venturekapital

- via

- Specifikation

- Ur

- Wave

- web

- webservices

- Kendt

- Hvad

- hvorvidt

- som

- mens

- WHO

- bred

- Bred rækkevidde

- Wikipedia

- vilje

- vinde

- vindere

- visdom

- uden

- ord

- Arbejde

- arbejdsgange

- skrivning

- år

- zephyrnet