07. februar 2023 (

Nanowerk nyheder) Store sprogmodeller som OpenAI's GPT-3 er massive neurale netværk, der kan generere menneskelignende tekst, fra poesi til programmeringskode. Disse maskinlæringsmodeller, der er trænet ved hjælp af masser af internetdata, tager en lille smule inputtekst og forudsiger derefter den tekst, der sandsynligvis kommer næste gang. Men det er ikke alt, disse modeller kan. Forskere udforsker et mærkeligt fænomen kendt som in-context learning, hvor en stor sprogmodel lærer at udføre en opgave efter kun at have set nogle få eksempler - på trods af at den ikke var trænet til den opgave. For eksempel kunne nogen fodre modellen med flere eksempelsætninger og deres følelser (positive eller negative), og derefter bede den med en ny sætning, og modellen kan give den korrekte stemning. Typisk vil en maskinlæringsmodel som GPT-3 skulle genoptrænes med nye data til denne nye opgave. Under denne træningsproces opdaterer modellen sine parametre, mens den behandler ny information for at lære opgaven. Men med in-context learning bliver modellens parametre ikke opdateret, så det ser ud til, at modellen lærer en ny opgave uden at lære noget som helst. Forskere fra MIT, Google Research og Stanford University stræber efter at opklare dette mysterium. De undersøgte modeller, der minder meget om store sprogmodeller for at se, hvordan de kan lære uden at opdatere parametre. Forskernes teoretiske resultater viser, at disse massive neurale netværksmodeller er i stand til at indeholde mindre, enklere lineære modeller begravet inde i dem. Den store model kunne derefter implementere en simpel indlæringsalgoritme til at træne denne mindre, lineære model til at fuldføre en ny opgave ved kun at bruge information, der allerede er indeholdt i den større model. Dens parametre forbliver faste. Et vigtigt skridt i retning af at forstå mekanismerne bag læring i kontekst, denne forskning åbner døren til mere udforskning omkring de læringsalgoritmer, som disse store modeller kan implementere, siger Ekin Akyürek, en kandidatstuderende i datalogi og hovedforfatter af et papir (

“What learning algorithm is in-context learning? Investigations with linear models”) at udforske dette fænomen. Med en bedre forståelse af kontekstindlæring kunne forskere gøre det muligt for modeller at udføre nye opgaver uden behov for dyr omskoling. "Normalt, hvis du vil finjustere disse modeller, skal du indsamle domænespecifikke data og lave noget kompleks konstruktion. Men nu kan vi bare give det et input, fem eksempler, og det opnår det, vi ønsker. Så in-context learning er et ret spændende fænomen,” siger Akyürek. Med Akyürek på papiret er Dale Schuurmans, en forsker ved Google Brain og professor i computervidenskab ved University of Alberta; samt seniorforfattere Jacob Andreas, X Consortium Assistant Professor i MIT Department of Electrical Engineering and Computer Science og medlem af MIT Computer Science and Artificial Intelligence Laboratory (CSAIL); Tengyu Ma, en assisterende professor i datalogi og statistik ved Stanford; og Danny Zhou, ledende videnskabsmand og forskningsdirektør hos Google Brain. Forskningen vil blive præsenteret på den internationale konference om læringsrepræsentationer.

En model i en model

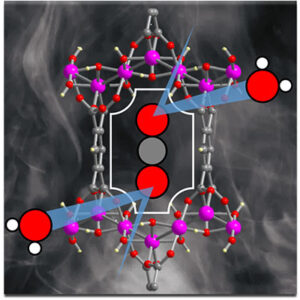

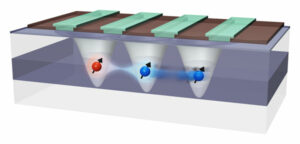

I maskinlæringsforskningssamfundet er mange forskere kommet til at tro, at store sprogmodeller kan udføre læring i kontekst på grund af, hvordan de er trænet, siger Akyürek. For eksempel har GPT-3 hundredvis af milliarder af parametre og blev trænet ved at læse store dele af tekst på internettet, fra Wikipedia-artikler til Reddit-indlæg. Så når nogen viser modeleksemplerne på en ny opgave, har den sandsynligvis allerede set noget meget lignende, fordi dets træningsdatasæt indeholdt tekst fra milliarder af websteder. Den gentager mønstre, den har set under træning, i stedet for at lære at udføre nye opgaver. Akyürek antog, at elever i kontekst ikke bare matcher tidligere sete mønstre, men i stedet lærer faktisk at udføre nye opgaver. Han og andre havde eksperimenteret ved at give disse modeller prompter ved hjælp af syntetiske data, som de ikke kunne have set nogen steder før, og fundet ud af, at modellerne stadig kunne lære af nogle få eksempler. Akyürek og hans kolleger mente, at disse neurale netværksmodeller måske har mindre maskinlæringsmodeller inde i dem, som modellerne kan træne til at udføre en ny opgave. "Det kunne forklare næsten alle de læringsfænomener, vi har set med disse store modeller," siger han. For at teste denne hypotese brugte forskerne en neural netværksmodel kaldet en transformer, som har samme arkitektur som GPT-3, men som var blevet specielt trænet til in-context learning. Ved at udforske denne transformers arkitektur beviste de teoretisk, at den kan skrive en lineær model inden for dens skjulte tilstande. Et neuralt netværk er sammensat af mange lag af indbyrdes forbundne noder, der behandler data. De skjulte tilstande er lagene mellem input- og outputlagene. Deres matematiske evalueringer viser, at denne lineære model er skrevet et sted i de tidligste lag af transformeren. Transformatoren kan derefter opdatere den lineære model ved at implementere simple indlæringsalgoritmer. I det væsentlige simulerer og træner modellen en mindre version af sig selv.

Undersøgelse af skjulte lag

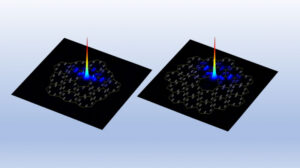

Forskerne udforskede denne hypotese ved hjælp af sonderingseksperimenter, hvor de kiggede i transformatorens skjulte lag for at forsøge at genvinde en vis mængde. "I dette tilfælde forsøgte vi at gendanne den faktiske løsning til den lineære model, og vi kunne vise, at parameteren er skrevet i de skjulte tilstande. Det betyder, at den lineære model er derinde et sted,” siger han. Med udgangspunkt i dette teoretiske arbejde kan forskerne muligvis gøre det muligt for en transformator at udføre læring i kontekst ved blot at tilføje to lag til det neurale netværk. Der er stadig mange tekniske detaljer, der skal udarbejdes, før det ville være muligt, advarer Akyürek, men det kan hjælpe ingeniører med at skabe modeller, der kan udføre nye opgaver uden behov for genoptræning med nye data. Fremover planlægger Akyürek at fortsætte med at udforske læring i kontekst med funktioner, der er mere komplekse end de lineære modeller, de studerede i dette arbejde. De kunne også anvende disse eksperimenter på store sprogmodeller for at se, om deres adfærd også er beskrevet af simple indlæringsalgoritmer. Derudover ønsker han at grave dybere ned i de typer fortræningsdata, der kan muliggøre læring i kontekst. "Med dette arbejde kan folk nu visualisere, hvordan disse modeller kan lære af eksempler. Så mit håb er, at det ændrer nogle menneskers syn på læring i kontekst,” siger Akyürek. "Disse modeller er ikke så dumme, som folk tror. De husker ikke kun disse opgaver. De kan lære nye opgaver, og vi har vist, hvordan det kan lade sig gøre.”

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- Platoblokkæde. Web3 Metaverse Intelligence. Viden forstærket. Adgang her.

- Kilde: https://www.nanowerk.com/news2/robotics/newsid=62325.php