I det hastigt udviklende felt af kunstig intelligens er naturlig sprogbehandling blevet et omdrejningspunkt for både forskere og udviklere. Bygger på grundlaget for Transformer arkitektur , BERTs tovejsopgradering, er der dukket flere banebrydende sprogmodeller op i de senere år, der rykker grænserne for, hvad maskiner kan forstå og generere.

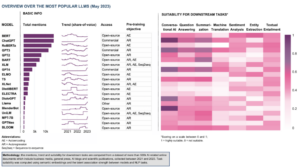

I denne artikel vil vi dykke ned i de seneste fremskridt i verden af store sprogmodeller, hvor vi udforsker forbedringer introduceret af hver model, deres muligheder og potentielle applikationer. Vi vil også se nærmere på Visual Langauge Models (VLM'er), der er trænet til at behandle ikke kun tekstlige, men også visuelle data.

Hvis du gerne vil springe rundt, er her de sprogmodeller, vi præsenterede:

- GPT-3 af OpenAI

- LaMDA fra Google

- PaLM af Google

- Flamingo af DeepMind

- BLIP-2 fra Salesforce

- LLaMA af Meta AI

- GPT-4 af OpenAI

Hvis dette dybdegående undervisningsindhold er nyttigt for dig, kan du abonner på vores AI-forskningsmailingliste for at blive advaret, når vi udgiver nyt materiale.

De vigtigste store sprogmodeller (LLM'er) og visuelle sprogmodeller (VLM'er) i 2023

1. GPT-3 af OpenAI

Resumé

OpenAI-teamet introducerede GPT-3 som et alternativ til at have et mærket datasæt til hver ny sprogopgave. De foreslog, at opskalering af sprogmodeller kan forbedre opgaveagnostisk få-skuds ydeevne. For at teste dette forslag trænede de en 175B-parameter autoregressiv sprogmodel, kaldet GPT-3, og evaluerede dens ydeevne på over to dusin NLP-opgaver. Evalueringen under få-skuds-læring, one-shot-læring og nul-shot-læring viste, at GPT-3 opnåede lovende resultater og endda lejlighedsvis overgik de avancerede resultater opnået med finjusterede modeller.

Hvad er målet?

- At foreslå en alternativ løsning på det eksisterende problem, når et mærket datasæt er nødvendigt for hver ny sprogopgave.

Hvordan gribes problemet an?

- Forskerne foreslog at opskalere sprogmodeller for at forbedre opgaveagnostisk få-skuds ydeevne.

- GPT-3 model bruger samme model og arkitektur som GPT-2, inklusive modificeret initialisering, præ-normalisering og reversibel tokenisering.

- Men i modsætning til GPT-2 bruger den skiftevis tætte og lokalt båndede sparsomme opmærksomhedsmønstre i lagene af transformeren, som i Sparsom transformator.

Hvad er resultaterne?

- GPT-3-modellen uden finjustering opnår lovende resultater på en række NLP-opgaver og overgår endda lejlighedsvis de avancerede modeller, der blev finjusteret til den specifikke opgave:

- På CoQA benchmark, 81.5 F1 i nul-shot-indstillingen, 84.0 F1 i one-shot-indstillingen og 85.0 F1 i få-shot-indstillingen, sammenlignet med 90.7 F1-score opnået ved finjusteret SOTA.

- På TriviaQA benchmark, 64.3 % nøjagtighed i nul-shot-indstillingen, 68.0 % i one-shot-indstillingen og 71.2 % i få-shot-indstillingen, hvilket overgår det nyeste (68 %) med 3.2 %.

- På LAMBADA datasæt, 76.2 % nøjagtighed i nul-shot-indstillingen, 72.5 % i one-shot-indstillingen og 86.4 % i få-shot-indstillingen, hvilket overgår det nyeste (68 %) med 18 %.

- Nyhedsartiklerne genereret af 175B-parameter GPT-3-modellen er svære at skelne fra rigtige ifølge menneskelige evalueringer (med nøjagtighed knap over chanceniveauet på ~52%).

- På trods af den bemærkelsesværdige ydeevne af GPT-3 fik den blandede anmeldelser fra AI-samfundet:

- "GPT-3-hypen er alt for meget. Den er imponerende (tak for de fine komplimenter!), men den har stadig alvorlige svagheder og laver nogle gange meget dumme fejl. AI kommer til at ændre verden, men GPT-3 er bare et meget tidligt glimt. Vi har stadig meget at finde ud af." – Sam Altman, CEO og medstifter af OpenAI.

- "Jeg er chokeret over, hvor svært det er at generere tekst om muslimer fra GPT-3, som ikke har noget at gøre med vold... eller at blive dræbt..." - Abubakar Abid, CEO og grundlægger af Gradio.

- "Ingen. GPT-3 forstår grundlæggende ikke den verden, den taler om. En yderligere forøgelse af korpus vil give den mulighed for at generere en mere troværdig pastiche, men ikke rette op på dens grundlæggende mangel på forståelse af verden. Demoer af GPT-4 vil stadig kræve menneskelig kirsebærplukning." – Gary Marcus, CEO og grundlægger af Robust.ai.

- "At ekstrapolere den spektakulære præstation af GPT3 ind i fremtiden tyder på, at svaret på livet, universet og alting kun er 4.398 billioner parametre." – Geoffrey Hinton, vinder af Turing Award.

Hvor kan man lære mere om denne forskning?

Hvor kan du få implementeringskode?

- Selve koden er ikke tilgængelig, men nogle datasætstatistikker sammen med ubetingede, ufiltrerede 2048-token-eksempler fra GPT-3 udgives på GitHub.

2. LaMDA af Google

Resumé

Language Modeller til Ddialog Aansøgninger (MDA) blev skabt gennem processen med at finjustere en gruppe transformatorbaserede neurale sprogmodeller, der er specielt designet til dialoger. Disse modeller har et maksimum på 137B parametre og blev trænet til at bruge eksterne videnkilder. LaMDA-udviklere havde tre hovedmål for øje - kvalitet, sikkerhed og jordforbindelse. Resultaterne viste, at finjustering muliggør indsnævring af kvalitetsgabet til menneskelige niveauer, men modellens ydeevne forblev under menneskelige niveauer med hensyn til sikkerhed og jordforbindelse.

Googles Bard, frigivet for nylig som et alternativ til ChatGPT, er drevet af LaMDA. På trods af at Bard ofte bliver stemplet som kedeligt, kunne det ses som et bevis på Googles forpligtelse til at prioritere sikkerhed, selv midt i den intense rivalisering mellem Google og Microsoft om at etablere dominans inden for generativ AI.

Hvad er målet?

- At bygge en model for åbne-domæne-dialogapplikationer, hvor en dialogagent er i stand til at konversere om ethvert emne, hvor svarene er fornuftige, specifikke for konteksten, baseret på pålidelige kilder og etiske.

Hvordan gribes problemet an?

- LaMDA er bygget på Transformer, en neural netværksarkitektur, som Google Research opfandt og åbnede i 2017.

- Ligesom andre store sprogmodeller, inklusive BERT og GPT-3, trænes LaMDA på terabyte tekstdata for at lære, hvordan ord relaterer til hinanden og derefter forudsige, hvilke ord der sandsynligvis kommer næste gang.

- Men i modsætning til de fleste sprogmodeller blev LaMDA trænet i dialog for at opfange nuancer, der adskiller åben samtale fra andre sprogformer.

- Modellen er også finjusteret for at forbedre fornuftigheden, sikkerheden og specificiteten af dens svar. Selvom sætninger som "det er rart" og "jeg ved det ikke" kan være meningsfulde i mange dialogscenarier, vil de sandsynligvis ikke føre til interessante og engagerende samtaler.

- LaMDA-generatoren genererer først adskillige kandidatsvar, som alle bedømmes baseret på, hvor sikre, fornuftige, specifikke og interessante de er. Svar med lav sikkerhedsscore filtreres fra, og derefter vælges det toprangerede resultat som svar.

Hvad er resultaterne?

- Talrige eksperimenter viser, at LaMDA kan deltage i engagerende åbne samtaler om en række forskellige emner.

- En række kvalitative evalueringer bekræftede, at modellens svar har tendens til at være fornuftige, specifikke, interessante og baseret på pålidelige eksterne kilder, men der er stadig plads til forbedringer.

- På trods af alle de fremskridt, der er gjort indtil videre, erkender forfatterne, at modellen stadig har mange begrænsninger, der kan resultere i at generere upassende eller endda skadelige svar.

Hvor kan man lære mere om denne forskning?

Hvor kan du få implementeringskode?

- En open source PyTorch-implementering til LaMDAs førtræningsarkitektur er tilgængelig på GitHub.

3. PaLM af Google

Resumé

Paderfra Langst Model (Håndflade) er en 540-milliarder parameter, Transformer-baseret sprogmodel. PaLM blev trænet på 6144 TPU v4-chips ved hjælp af Pathways, et nyt ML-system til effektiv træning på tværs af flere TPU Pods. Modellen demonstrerer fordelene ved skalering i få-skuds læring, og opnår avancerede resultater på hundredvis af sprogforståelse og generations benchmarks. PaLM udkonkurrerer finjusterede state-of-the-art modeller på flertrins-ræsonneringsopgaver og overgår den gennemsnitlige menneskelige præstation på BIG-bench-benchmark.

Hvad er målet?

- At forbedre forståelsen af, hvordan skalering af store sprogmodeller påvirker få-skudsindlæring.

Hvordan gribes problemet an?

- Nøgleideen er at skalere træningen af en 540 milliarder parameter sprogmodel med Pathways-systemet:

- Holdet brugte dataparallelisme på Pod-niveau på tværs af to Cloud TPU v4 Pods, mens de brugte standarddata og modelparallelisme inden for hver Pod.

- De var i stand til at skalere træning til 6144 TPU v4-chips, den største TPU-baserede systemkonfiguration, der er brugt til træning til dato.

- Modellen opnåede en træningseffektivitet på 57.8 % hardware FLOPs udnyttelse, hvilket, som forfatterne hævder, er den højeste, endnu opnåede træningseffektivitet for store sprogmodeller på denne skala.

- Træningsdataene for PaLM-modellen inkluderede en kombination af engelske og flersprogede datasæt indeholdende webdokumenter af høj kvalitet, bøger, Wikipedia, samtaler og GitHub-kode.

Hvad er resultaterne?

- Talrige eksperimenter viser, at modellens ydeevne steg kraftigt, da holdet skalerede til deres største model.

- PaLM 540B opnåede banebrydende ydeevne på flere meget vanskelige opgaver:

- Sprogforståelse og -generering. Den introducerede model overgik tidligere store modellers få-skuds ydeevne på 28 ud af 29 opgaver, der inkluderer spørgsmål-besvarende opgaver, cloze- og sætningsfuldførelsesopgaver, læseforståelsesopgaver i konteksten, ræsonnementopgaver med sund fornuft, SuperGLUE-opgaver og mere. PaLM's præstation på BIG-bench-opgaver viste, at den kunne skelne årsag og virkning, samt forstå konceptuelle kombinationer i passende sammenhænge.

- Ræsonnement. Med 8-shot prompting løser PaLM 58 % af problemerne i GSM8K, et benchmark af tusindvis af udfordrende matematikspørgsmål på grundskoleniveau, og overgår den tidligere topscore på 55 % opnået ved at finjustere GPT-3 175B-modellen. PaLM demonstrerer også evnen til at generere eksplicitte forklaringer i situationer, der kræver en kompleks kombination af flertrins logisk slutning, verdenskendskab og dyb sprogforståelse.

- Generering af kode. PaLM yder på niveau med den finjusterede Codex 12B, mens den bruger 50 gange mindre Python-kode til træning, hvilket bekræfter, at store sprogmodeller overfører læring fra både andre programmeringssprog og naturlige sprogdata mere effektivt.

Hvor kan man lære mere om denne forskning?

Hvor kan du få implementeringskode?

- En uofficiel PyTorch-implementering af den specifikke Transformer-arkitektur fra PaLM-forskningspapiret er tilgængelig på GitHub. Den skaleres ikke og udgives kun til undervisningsformål.

4. Flamingo af DeepMind

Resumé

Flamingo er en banebrydende familie af visuelle sprogmodeller (VLM'er), trænet i storskala multimodale webkorpus med blandet tekst og billeder. Med denne træning kan modellerne tilpasse sig nye opgaver ved hjælp af minimale kommenterede eksempler, givet som en prompt. Flamingo inkorporerer vigtige arkitektoniske fremskridt designet til at fusionere styrkerne ved forudtrænede modeller med kun syn og kun sprog, behandle sekvenser af variabelt sammenflettede visuelle og tekstmæssige data og tilpasse billeder eller videoer som input problemfrit. Modellerne demonstrerer en imponerende tilpasningsevne til en række billed- og videoopgaver såsom visuel besvarelse af spørgsmål, billedtekstopgaver og visuel besvarelse af flere valgmuligheder, der sætter nye præstationsstandarder ved hjælp af opgavespecifikke prompter i få-skuds-læring.

Hvad er målet?

- For at gøre fremskridt i retning af at aktivere multimodale modeller til hurtigt at lære og udføre nye opgaver baseret på korte instruktioner:

- Det meget brugte paradigme med at fortræne en model på en stor mængde overvågede data og derefter finjustere den til den specifikke opgave, er ressourcekrævende og kræver tusindvis af annoterede datapunkter sammen med omhyggelig justering af hyperparameter pr. opgave.

- Nuværende modeller, der bruger et kontrastivt mål, giver mulighed for nul-shot-tilpasning til nye opgaver, men kommer til kort med mere åbne opgaver som billedtekster eller visuel besvarelse af spørgsmål, fordi de mangler sproggenereringsevner.

- Denne forskning har til formål at introducere en ny model, der effektivt adresserer disse problemer og demonstrerer overlegen ydeevne i regimer med lavt dataindhold.

Hvordan gribes problemet an?

- DeepMind introducerede Flamingo, VLM'er designet til få-skuds læring på forskellige åbne visioner og sprogopgaver, ved kun at bruge nogle få input/output eksempler.

- Flamingo-modeller er visuelt konditionerede autoregressive tekstgenereringsmodeller, der kan behandle teksttokens blandet med billeder og/eller videoer og generere tekst som output.

- Flamingos arkitektur inkorporerer to komplementære fortrænede og frosne modeller:

- En visionsmodel, der er i stand til at "opfatte" visuelle scener.

- En stor sprogmodel, der har til opgave at udføre grundlæggende ræsonnement.

- Nye arkitekturkomponenter integrerer disse modeller på en måde, der bevarer den viden, der er opnået under deres beregningsintensive fortræning.

- Derudover har Flamingo-modeller en Perceiver-baseret arkitektur, der giver dem mulighed for at indtage billeder eller videoer i høj opløsning. Denne arkitektur kan generere et fast antal visuelle tokens pr. billede/video fra en bred og variabel række af visuelle inputfunktioner.

Hvad er resultaterne?

- Forskningen viser, at i lighed med LLM'er, som er gode elever med få skud, kan VLM'er lære af nogle få input/output-eksempler til billed- og videoforståelsesopgaver såsom klassificering, billedtekst eller besvarelse af spørgsmål.

- Flamingo etablerer et nyt benchmark inden for få-skuds læring, der demonstrerer overlegen ydeevne på en bred vifte af 16 multimodale sprog- og billed-/videoforståelsesopgaver.

- For 6 ud af disse 16 opgaver overgår Flamingo ydeevnen af den finjusterede state of the art, selvom den kun bruger 32 opgavespecifikke eksempler – cirka 1000 gange færre opgavespecifikke træningsdata end de nuværende toppræsterende modeller.

Hvor kan man lære mere om denne forskning?

Hvor kan du få implementeringskode?

- DeepMind frigav ikke den officielle implementering af Flamingo.

- Du kan finde open source-implementering af den introducerede tilgang i OpenFlamingo Github Repo.

- Den alternative PyTorch-implementering er tilgængelig link..

5. BLIP-2 fra Salesforce

Resumé

BLIP-2 er en effektiv og generisk fortræningsramme for vision- og sprogmodeller, designet til at omgå de stadig mere uoverkommelige omkostninger ved fortræning af store modeller. BLIP-2 udnytter hyldefrosne forudtrænede billedkodere og frosne store sprogmodeller til at starte vision-sprog-fortræning med en letvægts Querying Transformer, der er forudtrænet i to trin. Det første trin initierer vision-sprog-repræsentationslæring fra en frossen billedkoder, og den anden fase driver vision-til-sprog-generativ læring fra en frossen sprogmodel. På trods af at have betydeligt færre parametre, der kan trænes, overgår BLIP-2 de avancerede metoder og overgår DeepMinds Flamingo80B med 8.7 % på nul-shot VQAv2 med 54 gange færre parametre, der kan trænes. Modellen udviser også lovende nul-shot billed-til-tekst-genereringsfunktioner efter naturlige sprog instruktioner.

Hvad er målet?

- For at få state-of-the-art ydeevne på vision sprog opgaver, og samtidig reducere beregningsomkostningerne.

Hvordan gribes problemet an?

- Salesforce-teamet introducerede en ny vision-sprog fortræningsramme kaldet BLIP-2, Bootstrapping Lsprog-IMage Pgenoptræning med frosne unimodale modeller:

- De fortrænede unimodale modeller forbliver frosne under fortræning for at reducere beregningsomkostningerne og undgå problemet med katastrofal glemsel.

- For at lette tværmodal tilpasning og bygge bro over modalitetskløften mellem præ-trænede synsmodeller og præ-trænede sprogmodeller, foreslår teamet en letvægts Querying Transformer (Q-Former), der fungerer som en informationsflaskehals mellem den frosne billedkoder og den frosne. LLM.

- Q-former er fortrænet med en ny to-trins strategi:

- Det første fortræningstrin udfører vision-sprog-repræsentationslæring. Dette tvinger Q-Formeren til at lære visuel repræsentation, der er mest relevant for teksten.

- Det andet før-træningstrin udfører vision-til-sprog generativ læring ved at forbinde output fra Q-Former til en frossen LLM. Q-Former er trænet således, at dens output visuelle repræsentation kan fortolkes af LLM.

Hvad er resultaterne?

- BLIP-2 leverer enestående, state-of-the-art resultater på tværs af en række vision-sprog opgaver, der omfatter visuel besvarelse af spørgsmål, billedtekstning og billedtekst-hentning.

- For eksempel udkonkurrerer den Flamingo med 8.7 % på zero-shot VQAv2.

- Desuden opnås denne enestående ydeevne med væsentligt højere computereffektivitet:

- BLIP-2 overgår Flamingo-80B, mens den bruger 54× færre parametre, der kan trænes.

- BLIP-2 har kapaciteten til at udføre nul-shot-billede-til-tekst-generering som svar på naturlige sproginstruktioner, og dermed baner vejen for udvikling af færdigheder som visuel vidensræsonnement og visuel samtale blandt andre.

- Endelig er det vigtigt at bemærke, at BLIP-2 er en alsidig tilgang, der kan udnytte mere sofistikerede unimodale modeller til yderligere at forbedre ydeevnen af synssprog før træning.

Hvor kan man lære mere om denne forskning?

Hvor kan du få implementeringskode?

Den officielle BLIP-2 implementering er tilgængelig på GitHub.

6. LLaMA af Meta AI

Resumé

Meta AI-teamet hævder, at mindre modeller trænet på flere tokens er nemmere at genoptræne og finjustere til specifikke produktapplikationer. Derfor introducerer de Opkald (Large Language Model Meta AI), en samling af grundlæggende sprogmodeller med 7B til 65B parametre. LLaMA 33B og 65B blev trænet på 1.4 billioner tokens, mens den mindste model, LLaMA 7B, blev trænet på en billion tokens. De brugte udelukkende offentligt tilgængelige datasæt uden at være afhængige af proprietære eller begrænsede data. Holdet implementerede også vigtige arkitektoniske forbedringer og træningshastighedsoptimeringsteknikker. Som følge heraf klarede LLaMA-13B sig bedre end GPT-3, idet den var over 10 gange mindre, og LLaMA-65B udviste konkurrencedygtig ydeevne med PaLM-540B.

Hvad er målet?

- At demonstrere gennemførligheden af at træne toppræsterende modeller udelukkende på offentligt tilgængelige datasæt uden at stole på proprietære eller begrænsede datakilder.

- At give forskersamfundet mindre og mere effektive modeller og dermed gøre det muligt for dem, der ikke har adgang til store mængder infrastruktur, at studere store sprogmodeller.

Hvordan gribes problemet an?

- For at træne LLaMA-modellen brugte forskere kun data, der er offentligt tilgængelige og kompatible med open sourcing.

- De har også introduceret et par forbedringer til standard Transformer-arkitekturen:

- Ved at vedtage GPT-3-metoden blev træningsstabiliteten forbedret ved at normalisere input for hvert transformatorunderlag i stedet for at normalisere outputtet.

- Inspireret af PaLM-modellerne erstattede forskerne ReLU-lineariteten med SwiGLU-aktiveringsfunktionen for at forbedre ydeevnen.

- Inspireret af Su et al (2021), eliminerede de de absolutte positionelle indlejringer og inkorporerede i stedet roterende positionelle indlejringer (RoPE) på hvert lag af netværket.

- Endelig forbedrede Meta AI-teamet træningshastigheden for deres model ved at:

- Brug af effektiv kausal multi-head opmærksomhed implementering ved ikke at gemme opmærksomhedsvægte eller beregne maskerede nøgle-/forespørgselsscores.

- Brug af checkpointing til at minimere genberegnede aktiveringer under tilbageløbet.

- Overlapper beregningen af aktiveringer og kommunikationen mellem GPU'er over netværket (på grund af all_reduce-operationer).

Hvad er resultaterne?

- LLaMA-13B overgår GPT-3 på trods af at være over 10 gange mindre, mens LLaMA-65B holder stand mod PaLM-540B.

Hvor kan man lære mere om denne forskning?

Hvor kan du få implementeringskode?

- Meta AI giver adgang til LLaMA til akademiske forskere, personer med tilknytning til regeringen, civilsamfundet, akademiske institutioner og globale industriforskningslaboratorier på et individuelt case-evalueringsgrundlag. Gå til følgende for at ansøge GitHub repository.

7. GPT-4 af OpenAI

Resumé

GPT-4 er en storstilet, multimodal model, der accepterer billed- og tekstinput og genererer tekstoutput. På grund af konkurrence- og sikkerhedshensyn tilbageholdes specifikke detaljer om modellens arkitektur og træning. Med hensyn til ydeevne overgår GPT-4 tidligere sprogmodeller på traditionelle benchmarks og viser betydelige forbedringer i brugerhensigtsforståelse og sikkerhedsegenskaber. Modellen opnår også præstationer på menneskeligt niveau på forskellige eksamener, herunder en top 10% score på en simuleret Uniform Bar Examination.

Hvad er målet?

- At udvikle en storstilet, multimodal model, som kan acceptere billed- og tekstinput og producere tekstoutput.

- At udvikle infrastruktur og optimeringsmetoder, der opfører sig forudsigeligt på tværs af en lang række skalaer.

Hvordan gribes problemet an?

- På grund af konkurrencemæssige landskabs- og sikkerhedsimplikationer besluttede OpenAI at tilbageholde detaljer om arkitektur, modelstørrelse, hardware, træningsberegning, datasætkonstruktion og træningsmetoder.

- De afslører, at:

- GPT-4 er en transformer-baseret model, der er fortrænet til at forudsige det næste token i et dokument.

- Den bruger offentligt tilgængelige data og tredjepartslicenserede data.

- Modellen blev finjusteret ved hjælp af Reinforcement Learning from Human Feedback (RLHF).

- Ubekræftede oplysninger tyder på, at GPT-4 ikke er en enestående tæt model som sine forgængere, men en kraftcenter-koalition af otte separate modeller, der hver indeholder svimlende 220 milliarder parametre.

Hvad er resultaterne?

- GPT-4 opnår præstationer på menneskeligt niveau på de fleste professionelle og akademiske eksamener, især scorer i top 10% på en simuleret Uniform Bar Examination.

- Den fortrænede base GPT-4-model overgår eksisterende sprogmodeller og tidligere avancerede systemer på traditionelle NLP-benchmarks, uden benchmark-specifik udformning eller yderligere træningsprotokoller.

- GPT-4 demonstrerer en væsentlig forbedring med hensyn til følgende brugerhensigt, med dens svar foretrukket frem for GPT-3.5's svar i 70.2 % af 5,214 prompter fra ChatGPT og OpenAI API.

- GPT-4s sikkerhedsegenskaber er væsentligt forbedret sammenlignet med GPT-3.5, med et fald på 82 % i at svare på anmodninger om ikke-tilladt indhold og en stigning på 29 % i overholdelse af politikker for følsomme anmodninger (f.eks. medicinsk rådgivning og selvskade).

Hvor kan man lære mere om denne forskning?

Hvor kan du få implementeringskode?

- Kodeimplementering af GPT-4 er ikke tilgængelig.

Anvendelser i den virkelige verden af store (vision) sprogmodeller

De seneste års væsentligste AI-forskningsgennembrud kommer fra store AI-modeller, der er trænet på enorme datasæt. Disse modeller demonstrerer imponerende ydeevne, og det er fascinerende at tænke på, hvordan kunstig intelligens kan revolutionere hele industrier, såsom kundeservice, marketing, e-handel, sundhedspleje, softwareudvikling, journalistik og mange andre.

Store sprogmodeller har adskillige applikationer i den virkelige verden. GPT-4 viser følgende:

- Naturlig sprogforståelse og generering for chatbots og virtuelle assistenter.

- Maskinoversættelse mellem sprog.

- Sammenfatning af artikler, rapporter eller andre tekstdokumenter.

- Følelsesanalyse til markedsundersøgelser eller overvågning af sociale medier.

- Indholdsgenerering til markedsføring, sociale medier eller kreativ skrivning.

- Spørgsmålsbesvarelsessystemer til kundesupport eller vidensbaser.

- Tekstklassificering til spamfiltrering, emnekategorisering eller dokumentorganisering.

- Personaliserede sprogindlærings- og vejledningsværktøjer.

- Kodegenerering og bistand til softwareudvikling.

- Medicinsk, juridisk og teknisk dokumentanalyse og assistance.

- Tilgængelighedsværktøjer for personer med handicap, såsom tekst-til-tale og tale-til-tekst konvertering.

- Tjenester til talegenkendelse og transskription.

Hvis vi tilføjer en visuel del, udvides områderne for mulige anvendelser yderligere:

Det er meget spændende at følge de seneste AI-gennembrud og tænke over deres potentielle applikationer i den virkelige verden. Men før vi implementerer disse modeller i det virkelige liv, skal vi tage fat på de tilsvarende risici og begrænsninger, som desværre er ret betydelige.

Risici og begrænsninger

Hvis du spørger GPT-4 om dets risici og begrænsninger, vil det sandsynligvis give dig en lang liste af relevante bekymringer. Efter at have filtreret gennem denne liste og tilføjet nogle yderligere overvejelser, er jeg endt med følgende sæt af nøglerisici og begrænsninger, som moderne store sprogmodeller besidder:

- Bias og diskrimination: Disse modeller lærer af enorme mængder tekstdata, som ofte indeholder skævheder og diskriminerende indhold. Som et resultat kan de genererede output utilsigtet videreføre stereotyper, stødende sprogbrug og diskrimination baseret på faktorer som køn, race eller religion.

- misinformation: Store sprogmodeller kan generere indhold, der er faktuelt forkert, vildledende eller forældet. Selvom modellerne er trænet på en bred vifte af kilder, giver de muligvis ikke altid den mest nøjagtige eller opdaterede information. Ofte sker dette, fordi modellen prioriterer at generere output, der er grammatisk korrekte eller virker sammenhængende, selvom de er vildledende.

- Manglende forståelse: Selvom disse modeller ser ud til at forstå menneskeligt sprog, fungerer de primært ved at identificere mønstre og statistiske sammenhænge i træningsdataene. De har ikke en dyb forståelse af det indhold, de genererer, hvilket nogle gange kan resultere i meningsløse eller irrelevante output.

- Upassende indhold: Sprogmodeller kan nogle gange generere indhold, der er stødende, skadeligt eller upassende. Selvom der gøres en indsats for at minimere sådant indhold, kan det stadig forekomme på grund af karakteren af træningsdataene og modellernes manglende evne til at skelne kontekst eller brugerhensigt.

Konklusion

Store sprogmodeller har utvivlsomt revolutioneret området for naturlig sprogbehandling og demonstreret et enormt potentiale i at øge produktiviteten på tværs af forskellige roller og brancher. Deres evne til at generere menneskelignende tekst, automatisere hverdagsagtige opgaver og yde assistance i kreative og analytiske processer har gjort dem til uundværlige værktøjer i nutidens hurtige, teknologidrevne verden.

Det er dog afgørende at anerkende og forstå de begrænsninger og risici, der er forbundet med disse kraftfulde modeller. Problemer som bias, misinformation og potentialet for ondsindet brug kan ikke ignoreres. Mens vi fortsætter med at integrere disse AI-drevne teknologier i vores daglige liv, er det vigtigt at finde en balance mellem at udnytte deres evner og sikre menneskelig overvågning, især i følsomme og højrisikosituationer.

Hvis det lykkes os at anvende generative AI-teknologier ansvarligt, vil vi bane vejen for en fremtid, hvor kunstig intelligens og menneskelig ekspertise arbejder sammen for at drive innovation og skabe en bedre verden for alle.

Nyder du denne artikel? Tilmeld dig flere AI-forskningsopdateringer.

Vi giver dig besked, når vi udgiver flere oversigtsartikler som denne.

Relaterede

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk dig selv. Adgang her.

- PlatoAiStream. Web3 intelligens. Viden forstærket. Adgang her.

- PlatoESG. Automotive/elbiler, Kulstof, CleanTech, Energi, Miljø, Solenergi, Affaldshåndtering. Adgang her.

- BlockOffsets. Modernisering af miljømæssig offset-ejerskab. Adgang her.

- Kilde: https://www.topbots.com/top-language-models-transforming-ai-in-2023/

- :har

- :er

- :ikke

- :hvor

- $OP

- 1

- 10

- 12b

- 16

- 2%

- 2017

- 2021

- 2023

- 214

- 220

- 28

- 32

- 50

- 7

- 70

- 710

- 72

- 8

- 84

- 90

- a

- evne

- I stand

- Om

- over

- absolutte

- akademisk

- Acceptere

- accepterer

- adgang

- tilgængelig

- imødekomme

- Ifølge

- nøjagtighed

- præcis

- opnået

- opnår

- opnå

- anerkende

- tværs

- Aktivering

- aktiveringer

- handlinger

- tilpasse

- tilpasning

- tilføje

- tilføje

- Desuden

- Yderligere

- adresse

- adresser

- Vedtagelsen

- fremskridt

- rådgivning

- Efter

- mod

- Agent

- AI

- ai forskning

- målsætninger

- AL

- ens

- Alle

- tillade

- tillade

- tillader

- sammen

- også

- alternativ

- Skønt

- altid

- midt

- blandt

- beløb

- beløb

- an

- analyse

- Analytisk

- ,

- En anden

- besvare

- enhver

- api

- vises

- applikationer

- Indløs

- tilgang

- passende

- cirka

- arkitektonisk

- arkitektur

- ER

- områder

- omkring

- Array

- Kunst

- artikel

- artikler

- kunstig

- kunstig intelligens

- AS

- Assistance

- assistenter

- forbundet

- foreninger

- At

- opmærksomhed

- forfattere

- automatisere

- til rådighed

- gennemsnit

- undgå

- tildeling

- Balance

- Bar

- bund

- baseret

- grundlæggende

- grundlag

- BE

- fordi

- bliver

- før

- være

- jf. nedenstående

- benchmark

- Benchmarks

- fordele

- Bedre

- mellem

- skævhed

- fordomme

- Billion

- Bøger

- Bootstrap

- både

- grænser

- gennembrud

- gennembrud

- BRIDGE

- bred

- bygge

- Bygning

- bygget

- men

- by

- kaldet

- CAN

- kandidat

- kan ikke

- kapaciteter

- stand

- Kapacitet

- forsigtig

- tilfælde

- katastrofale

- Årsag

- Direktør

- CEO og grundlægger

- udfordrende

- chance

- lave om

- chatbots

- ChatGPT

- Chips

- krav

- klassificering

- Cloud

- Medstifter

- kode

- SAMMENHÆNGENDE

- samling

- kombination

- kombinationer

- Kom

- engagement

- Kommunikation

- samfund

- sammenlignet

- kompatibel

- konkurrencedygtig

- komplementære

- komplekse

- Compliance

- komponenter

- beregning

- Compute

- computer

- computing

- konceptuelle

- Bekymringer

- Konfiguration

- BEKRÆFTET

- Tilslutning

- følgelig

- overvejelser

- opbygge

- indhold

- sammenhæng

- sammenhænge

- fortsæt

- kontrast

- Samtale

- samtaler

- Konvertering

- korrigere

- Tilsvarende

- Koste

- Omkostninger

- kunne

- skabe

- oprettet

- Kreativ

- troværdig

- afgørende

- Nuværende

- kunde

- Kundeservice

- Kunde support

- banebrydende

- dagligt

- data

- datapunkter

- datasæt

- Dato

- besluttede

- falde

- dyb

- DeepMind

- leverer

- demonstrere

- demonstreret

- demonstrerer

- demonstrerer

- Demoer

- Afhængigt

- implementering

- konstrueret

- Trods

- detaljer

- udvikle

- udviklere

- udvikling

- Udvikling

- dialog

- Dialog

- svært

- handicap

- offentliggøre

- diskrimination

- skelne

- forskelligartede

- do

- dokumentet

- dokumenter

- gør

- Dominans

- Dont

- dusin

- køre

- døbt

- grund

- i løbet af

- e

- e-handel

- E&T

- hver

- Tidligt

- lettere

- uddannelsesmæssige

- effekt

- effektivt

- effektivitet

- effektiv

- indsats

- elimineret

- opstået

- muliggøre

- muliggør

- omfatter

- engagerende

- Engelsk

- forbedre

- forbedret

- forbedringer

- styrke

- sikring

- væsentlig

- etablere

- indfører

- etisk

- evalueret

- evaluering

- evalueringer

- Endog

- Hver

- at alt

- bevismateriale

- udviklende

- undersøgelse

- eksempel

- eksempler

- overstiger

- enestående

- spændende

- udelukkende

- udstillinger

- eksisterende

- Udvid

- eksperimenter

- ekspertise

- Udforskning

- ekstern

- f1

- lette

- faktorer

- Fall

- familie

- langt

- fascinerende

- hurtig

- Feature

- featured

- Funktionalitet

- tilbagemeldinger

- få

- færre

- felt

- Figur

- filtrering

- Finde

- Fornavn

- Fix

- fast

- følger

- efter

- Til

- formularer

- Fonde

- grundlægger

- Framework

- fra

- frosset

- funktion

- fundamental

- fundamentalt

- yderligere

- fremtiden

- vundet

- kløft

- Køn

- generere

- genereret

- genererer

- generere

- generation

- generative

- Generativ AI

- generator

- få

- GitHub

- glimt

- Global

- Go

- mål

- gå

- godt

- Googles

- Regering

- GPU'er

- klasse

- banebrydende

- gruppe

- havde

- sker

- Hård Ost

- Hardware

- skadelig

- Have

- have

- sundhedspleje

- link.

- høj kvalitet

- høj opløsning

- høj risiko

- højere

- højeste

- besidder

- Hvordan

- Men

- HTML

- HTTPS

- kæmpe

- menneskelig

- Hundreder

- Hype

- Tuning af hyperparameter

- idé

- identificere

- if

- billede

- billeder

- enorme

- implementering

- implementeret

- implikationer

- vigtigt

- imponerende

- Forbedre

- forbedret

- forbedringer

- in

- dybdegående

- manglende evne

- omfatter

- medtaget

- Herunder

- Incorporated

- inkorporerer

- inkorporering

- Forøg

- øget

- stigende

- stigende

- individuel

- enkeltpersoner

- industrier

- industrien

- oplysninger

- Infrastruktur

- Indleder

- Innovation

- indgang

- indgange

- i stedet

- institutioner

- anvisninger

- integrere

- Intelligens

- hensigt

- interessant

- ind

- indføre

- introduceret

- Opfundet

- spørgsmål

- spørgsmål

- IT

- ITS

- selv

- journalistik

- jpg

- lige

- Nøgle

- centrale mål

- Kend

- viden

- Labs

- Mangel

- landskab

- Sprog

- Sprog

- stor

- storstilet

- største

- seneste

- lag

- lag

- føre

- LÆR

- læring

- Politikker

- mindre

- Niveau

- niveauer

- Leverage

- Udnytter

- løftestang

- Licenseret

- Livet

- letvægt

- ligesom

- Sandsynlig

- begrænsninger

- Liste

- Lister

- Lives

- Llama

- lokalt

- logisk

- Lang

- Se

- Lot

- Lav

- Maskiner

- lavet

- lave

- maerker

- mange

- Marcus

- Marked

- markedsundersøgelse

- Marketing

- materiale

- matematik

- max-bredde

- maksimal

- Kan..

- meningsfuld

- Medier

- medicinsk

- Flet

- Meta

- Metode

- metoder

- microsoft

- tankerne

- mindste

- misinformation

- misvisende

- fejl

- blandet

- ML

- model

- modeller

- Moderne

- modificeret

- overvågning

- mere

- mest

- meget

- flere

- Muslimer

- Natural

- Naturligt sprog

- Natural Language Processing

- Natur

- Behov

- behov

- netværk

- Neural

- Neuralt sprog

- neurale netværk

- Ny

- nyheder

- næste

- rart

- NLP

- især

- intet

- nummer

- talrige

- objektiv

- målsætninger

- forekomme

- of

- offensiv

- officiel

- tit

- on

- ONE

- dem

- kun

- åbent

- open source

- OpenAI

- betjene

- Produktion

- optimering

- or

- organisation

- Andet

- Andre

- vores

- ud

- at overgå

- udkonkurrerer

- output

- udestående

- i løbet af

- egen

- håndflade

- Papir

- paradigme

- parameter

- parametre

- del

- deltage

- især

- passerer

- mønstre

- bane

- Bane

- per

- udføre

- ydeevne

- udfører

- udfører

- sætninger

- pick

- plato

- Platon Data Intelligence

- PlatoData

- bælg

- Punkt

- punkter

- politikker

- mulig

- potentiale

- strøm

- vigtigste

- forudsige

- foretrækkes

- tidligere

- primært

- Forud

- prioritering

- Problem

- problemer

- behandle

- Processer

- forarbejdning

- producere

- Produkt

- produktivitet

- professionel

- Programmering

- programmeringssprog

- Progress

- lovende

- egenskaber

- foreslår

- proprietære

- protokoller

- give

- forudsat

- giver

- offentligt

- offentliggjort

- formål

- Pushing

- Python

- pytorch

- kvalitative

- kvalitet

- spørgsmål

- Spørgsmål

- hurtigt

- Løb

- rækkevidde

- hurtigt

- hellere

- Læsning

- ægte

- I virkeligheden

- virkelige verden

- nylige

- for nylig

- anerkendelse

- genkende

- reducere

- reducere

- regimer

- forstærkning læring

- frigive

- frigivet

- relevant

- pålidelig

- pålidelige kilder

- religion

- stole

- forblive

- forblevet

- bemærkelsesværdig

- udskiftes

- Rapporter

- repræsentation

- anmodninger

- kræver

- Kræver

- forskning

- Forskningsfællesskab

- forskere

- ressourceintensive

- respekt

- reagere

- svar

- reaktioner

- begrænset

- resultere

- Resultater

- bevarer

- Anmeldelser

- revolutionere

- revolutioneret

- risici

- rivalisering

- robust

- roller

- Værelse

- sikker

- Sikkerhed

- salgsstyrke

- samme

- Scale

- skalaer

- skalering

- scenarier

- scener

- Skole

- score

- scores

- scoring

- problemfrit

- Anden

- synes

- set

- valgt

- følsom

- adskille

- Series

- alvorlig

- tjeneste

- Tjenester

- sæt

- indstilling

- flere

- chokeret

- Kort

- Vis

- viste

- Shows

- underskrive

- signifikant

- betydeligt

- Tilsvarende

- ental

- situationer

- Størrelse

- færdigheder

- mindre

- So

- indtil nu

- Social

- sociale medier

- Samfund

- Software

- softwareudvikling

- Alene

- løsninger

- Løser

- nogle

- sofistikeret

- Kilde

- Kilder

- Sourcing

- spam

- specifikke

- specifikt

- specificitet

- spektakulære

- tale-til-tekst

- hastighed

- Stabilitet

- Stage

- etaper

- standard

- standarder

- Tilstand

- state-of-the-art

- statistiske

- statistik

- Stadig

- Strategi

- styrker

- strejke

- Studere

- væsentlig

- lykkes

- sådan

- tyder

- foreslår

- RESUMÉ

- overlegen

- tilsyn

- support

- overgået

- systemet

- Systemer

- Talks

- Opgaver

- opgaver

- hold

- Teknisk

- teknikker

- Teknologier

- vilkår

- prøve

- tekstgenerering

- Tekst-til-tale

- end

- tak

- at

- Fremtiden

- Staten

- verdenen

- deres

- Them

- derefter

- Der.

- derved

- derfor

- Disse

- de

- tror

- tredjepart

- denne

- dem

- selvom?

- tusinder

- tre

- Gennem

- gange

- til

- nutidens

- sammen

- token

- tokenization

- Tokens

- også

- værktøjer

- top

- TOPBOTS

- emne

- Emner

- mod

- traditionelle

- Tog

- uddannet

- Kurser

- overførsel

- transformer

- omdanne

- Oversættelse

- trillion

- turering

- Tutoring

- to

- ubetinget

- under

- forstå

- forståelse

- forpligter

- utvivlsomt

- desværre

- Universe

- I modsætning til

- up-to-date

- opdateringer

- brug

- anvendte

- Bruger

- bruger

- ved brug af

- udnytter

- række

- forskellige

- Vast

- alsidige

- meget

- video

- Videoer

- Virtual

- vision

- VOX

- var

- Vej..

- we

- web

- GODT

- var

- Hvad

- hvornår

- som

- mens

- WHO

- Hele

- bred

- Bred rækkevidde

- Wikipedia

- vilje

- med

- inden for

- uden

- ord

- Arbejde

- arbejde sammen

- world

- skrivning

- år

- endnu

- dig

- zephyrnet

- Zero-Shot Learning