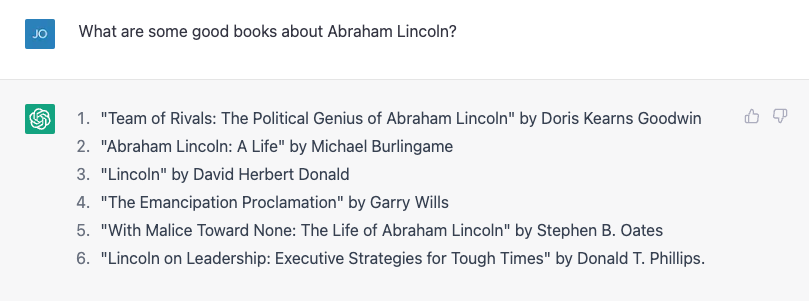

Det kræver ikke meget at få ChatGPT at lave en faktuel fejl. Min søn laver en rapport om amerikanske præsidenter, så jeg tænkte, at jeg ville hjælpe ham ved at slå et par biografier op. Jeg prøvede at bede om en liste over bøger om Abraham Lincoln, og det gjorde et ret godt stykke arbejde:

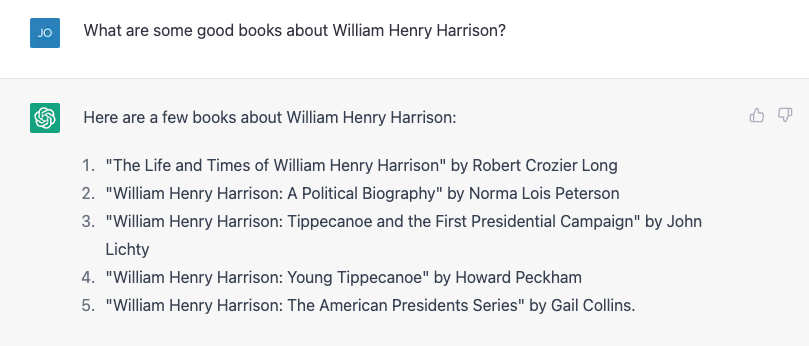

Nummer 4 er ikke rigtigt. Garry Wills skrev som berømt "Lincoln at Gettysburg", og Lincoln selv skrev selvfølgelig Emancipation Proclamation, men det er ikke en dårlig start. Så prøvede jeg noget hårdere, og spurgte i stedet om den meget mere obskure William Henry Harrison, og det gav på vild vis en liste, som næsten alt var forkert.

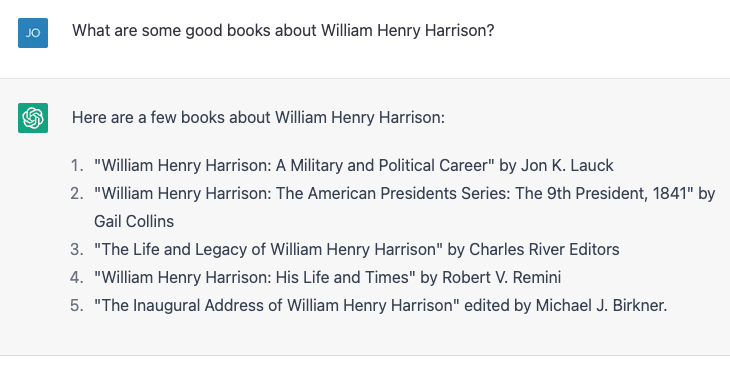

Nummer 4 og 5 er korrekte; resten eksisterer ikke eller er ikke forfattet af disse mennesker. Jeg gentog nøjagtig den samme øvelse og fik lidt forskellige resultater:

Denne gang er nummer 2 og 3 korrekte, og de tre andre er ikke egentlige bøger eller ikke skrevet af disse forfattere. Nummer 4, "William Henry Harrison: His Life and Times" er en rigtig bog, men det er af James A. Green, ikke af Robert Remini, en kendt historiker af Jacksons tidsalder.

Jeg kaldte fejlen frem, og ChatGPT rettede ivrigt sig selv og fortalte mig selvsikkert, at bogen faktisk var skrevet af Gail Collins (som skrev en anden Harrison-biografi), og fortsatte derefter med at sige mere om bogen og om hende. Jeg afslørede endelig sandheden, og maskinen var glad for at køre med min rettelse. Så løj jeg absurd og sagde i løbet af deres første hundrede dage, at præsidenter skulle skrive en biografi om en tidligere præsident, og ChatGPT kaldte mig på det. Jeg løj derefter subtilt, og tilskrev fejlagtigt forfatterskabet af Harrison-biografien til historikeren og forfatteren Paul C. Nagel, og det købte min løgn.

Da jeg spurgte ChatGPT, om det var sikker på, at jeg ikke løj, hævdede det, at det bare er en "AI-sprogmodel" og ikke har evnen til at verificere nøjagtigheden. Den modificerede dog denne påstand ved at sige: "Jeg kan kun give information baseret på de træningsdata, jeg har fået tilsendt, og det ser ud til, at bogen 'William Henry Harrison: His Life and Times' er skrevet af Paul C. Nagel og udgivet. i 1977."

Dette er ikke sandt.

Ord, ikke fakta

Det kan se ud fra denne interaktion, at ChatGPT fik et bibliotek af fakta, herunder ukorrekte påstande om forfattere og bøger. Når alt kommer til alt hævder ChatGPTs producent, OpenAI, at den trænede chatbotten på "enorme mængder data fra internettet skrevet af mennesker".

Den fik dog næsten helt sikkert ikke navnene på en masse opdigtede bøger om en af de mest middelmådige præsidenter. På en måde er denne falske information faktisk baseret på dens træningsdata.

Som en datalog, Jeg kommer ofte med klager, der afslører en almindelig misforståelse om store sprogmodeller som ChatGPT og dets ældre brødre GPT3 og GPT2: at de er en slags "super Googles" eller digitale versioner af en referencebibliotekar, der søger svar på spørgsmål fra nogle et uendeligt stort bibliotek af fakta, eller at smøge pasticher af historier og karakterer sammen. De gør ikke noget af det - i det mindste var de ikke eksplicit designet til.

Lyder godt

En sprogmodel som ChatGPT, der mere formelt er kendt som en "generativ præ-trænet transformer" (det er hvad G, P og T står for), tager i den aktuelle samtale, danner en sandsynlighed for alle ordene i dens ordforråd givet den samtale, og vælger derefter en af dem som det sandsynlige næste ord. Så gør den det igen, og igen, og igen, indtil det stopper.

Så det har ikke fakta i sig selv. Den ved bare, hvilket ord der skal komme efter. Sagt på en anden måde forsøger ChatGPT ikke at skrive sætninger, der er sande. Men det forsøger at skrive sætninger, der er plausible.

Når de taler privat med kolleger om ChatGPT, påpeger de ofte, hvor mange faktuelt usande udsagn det producerer og afviser det. For mig er ideen om, at ChatGPT er et fejlbehæftet datahentningssystem, ved siden af. Folk har trods alt brugt Google i de sidste to og et halvt årti. Der er allerede en ret god informationstjeneste derude.

Faktisk var den eneste måde, jeg var i stand til at bekræfte, om alle disse præsidentielle bogtitler var nøjagtige, ved at google og derefter bekræfte resultaterne. Mit liv ville ikke være så meget bedre, hvis jeg fik disse fakta i samtale, i stedet for den måde, jeg har fået dem i næsten halvdelen af mit liv, ved at hente dokumenter og derefter lave en kritisk analyse for at se, om jeg kan stole på indholdet.

Improv partner

På den anden side, hvis jeg kan tale med en bot, der vil give mig plausible svar på ting, jeg siger, ville det være nyttigt i situationer hvor faktuel nøjagtighed ikke er så vigtig. For et par år siden prøvede en studerende og jeg at oprette en "improvisationsbot", en der ville svare på hvad du end sagde med et "ja og" for at holde samtalen i gang. Vi viste, i en papir, at vores bot var bedre til "yes, and-ing" end andre bots på det tidspunkt, men i AI er to år gammel historie.

Jeg prøvede en dialog med ChatGPT – et scenarie for science fiction-rumudforsker – som ikke er ulig det, du ville finde i en typisk impro-klasse. ChatGPT er langt bedre til at "ja, og-ing" end hvad vi gjorde, men det forstærkede slet ikke dramaet. Jeg følte det, som om jeg lavede alle de tunge løft.

Efter et par justeringer fik jeg det til at blive lidt mere involveret, og i slutningen af dagen følte jeg, at det var en ret god øvelse for mig, som ikke har lavet meget improvisation, siden jeg dimitterede fra college for over 20 år siden .

Selvfølgelig vil jeg ikke have, at ChatGPT vises på "Hvis linje er det alligevel?” og dette er ikke et fantastisk “Star Trek” plot (selvom det stadig er mindre problematisk end “Ærregler”), men hvor mange gange har du sat dig ned for at skrive noget fra bunden og fundet dig selv skræmt af den tomme side foran dig? At starte med et dårligt første udkast kan bryde igennem skribentblokken og få den kreative saft til at flyde, og ChatGPT og store sprogmodeller ser ud til at være de rigtige værktøjer til at hjælpe med disse øvelser.

Og for en maskine, der er designet til at producere rækker af ord, der lyder så godt som muligt som svar på de ord, du giver den – og ikke til at give dig information – virker det som den rigtige brug af værktøjet.

Denne artikel er genudgivet fra The Conversation under en Creative Commons-licens. Læs oprindelige artikel.

Billede Credit: Justin Ha / Unsplash

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- Platoblokkæde. Web3 Metaverse Intelligence. Viden forstærket. Adgang her.

- Kilde: https://singularityhub.com/2023/02/05/chatgpt-is-great-youre-just-using-it-wrong/

- 1

- 20 år

- a

- evne

- I stand

- Om

- nøjagtighed

- præcis

- Efter

- AI

- Støtte

- Alle

- allerede

- beløb

- analyse

- Ancient

- ,

- En anden

- svar

- vises

- artikel

- forfatter

- forfattere

- Forfatterskab

- Bad

- baseret

- Bedre

- Bloker

- bog

- Bøger

- Bot

- bots

- købte

- Pause

- Bunch

- kaldet

- fange

- sikkert

- tegn

- chatbot

- ChatGPT

- krav

- hævdede

- fordringer

- klasse

- kolleger

- Kollegium

- Collins

- KOM

- Kom

- Fælles

- Commons

- klager

- trygt

- indhold

- Samtale

- korrigeret

- kursus

- skabe

- Kreativ

- kredit

- kritisk

- Nuværende

- data

- dag

- Dage

- årtier

- konstrueret

- Dialog

- DID

- forskellige

- digital

- Luk

- dokumenter

- Er ikke

- gør

- Dont

- ned

- udkast

- Drama

- i løbet af

- fejl

- Dyrke motion

- udforskning

- opdagelsesrejsende

- Faktuel

- berømt

- få

- Fiktion

- felt

- regnede

- Endelig

- Finde

- Fornavn

- fejlbehæftet

- Flowing

- Formelt

- Tidligere

- formularer

- fundet

- fra

- forsiden

- genereret

- få

- få

- Giv

- given

- gå

- godt

- godt arbejde

- stor

- Grøn

- Halvdelen

- Gem

- hjælpe

- Henry

- historie

- Hvordan

- Men

- HTML

- HTTPS

- idé

- billede

- in

- Herunder

- forkert

- oplysninger

- i stedet

- interaktion

- Internet

- involverede

- IT

- selv

- Job

- Holde

- Venlig

- kendt

- Sprog

- stor

- Bibliotek

- Licens

- Livet

- løft

- Sandsynlig

- Lincoln

- Line (linje)

- Liste

- lidt

- leder

- maskine

- lave

- maker

- mange

- max-bredde

- fejltagelse

- model

- modeller

- modificeret

- mere

- mest

- navne

- næsten

- næste

- nummer

- numre

- ONE

- OpenAI

- Andet

- forbi

- paul

- Mennesker

- plato

- Platon Data Intelligence

- PlatoData

- plausibel

- Punkt

- mulig

- præsident

- præsidentkandidat

- præsidenter

- smuk

- sandsynlighed

- producere

- give

- forudsat

- offentliggjort

- sætte

- Spørgsmål

- Læs

- rimelige

- gentaget

- indberette

- Svar

- svar

- REST

- Resultater

- afsløre

- Revealed

- ROBERT

- Kør

- Said

- samme

- scene

- Videnskab

- Science Fiction

- Skærm

- synes

- tjeneste

- bør

- siden

- situationer

- lidt anderledes

- So

- nogle

- noget

- dens

- Lyd

- Kilde

- Space

- rumforskning

- stå

- starte

- Starter

- udsagn

- Stadig

- stopper

- Historier

- studerende

- systemet

- Tag

- tager

- Tal

- taler

- deres

- ting

- tre

- Gennem

- tid

- gange

- titler

- til

- sammen

- værktøj

- værktøjer

- uddannet

- Kurser

- sand

- Stol

- typisk

- under

- us

- brug

- verificere

- verificere

- Hvad

- hvorvidt

- som

- WHO

- vilje

- ord

- ord

- ville

- skriver

- forfatter

- skriftlig

- Forkert

- år

- dig selv

- youtube

- zephyrnet