Suresh er en teknologileder med dyb teknisk ekspertise inden for halvledere, kunstig intelligens, cybersikkerhed, internet-of-things, hardware, software osv. Han tilbragte 20 år i branchen, senest som administrerende direktør for open source nul- stole på chip-udvikling hos Technology Innovation Institute, Abu Dhabi og i andre Fortune 500-halvledervirksomheder som Intel, Qualcomm og MediaTek i forskellige lederroller, hvor han forskede i og udviklede højtydende, energieffektive, post-kvantesikker, sikker mikrochips/system-on-chips (SoC'er)/acceleratorer til datacenter-, klient-, smartphone-, netværks-, IoT- og AI/ML-markederne. Han bidrog til Falcon LLM (rangeret som nr. 1 i huggingface) og var den førende arkitekt for den tilpassede AI-hardwareplatform (aflyst – prioriteter ændret). Han har 15+ amerikanske patenter og har udgivet/præsenteret på mere end 20+ konferencer.

Suresh er en teknologileder med dyb teknisk ekspertise inden for halvledere, kunstig intelligens, cybersikkerhed, internet-of-things, hardware, software osv. Han tilbragte 20 år i branchen, senest som administrerende direktør for open source nul- stole på chip-udvikling hos Technology Innovation Institute, Abu Dhabi og i andre Fortune 500-halvledervirksomheder som Intel, Qualcomm og MediaTek i forskellige lederroller, hvor han forskede i og udviklede højtydende, energieffektive, post-kvantesikker, sikker mikrochips/system-on-chips (SoC'er)/acceleratorer til datacenter-, klient-, smartphone-, netværks-, IoT- og AI/ML-markederne. Han bidrog til Falcon LLM (rangeret som nr. 1 i huggingface) og var den førende arkitekt for den tilpassede AI-hardwareplatform (aflyst – prioriteter ændret). Han har 15+ amerikanske patenter og har udgivet/præsenteret på mere end 20+ konferencer.

Suresh tjener også aktivt i en lederstilling hos RISC-V International, hvor han er formand for Trusted Computing Group for at udvikle RISC-V-fortrolig computerkapacitet og er formand for AI/ML-gruppen for at udvikle RISC-V-hardwareacceleration til AI/ML-arbejdsbelastninger som f.eks. Transformer Large Language Models brugt i ChatGPT slags applikationer. Han rådgiver også startups og venturekapitalfirmaer om investeringsbeslutningsstøtte, produktstrategi, teknologisk due diligence mv.

Han tog en MBA fra INSEAD, en MS fra Birla Institute of Technology & Science Pilani, et Systems Engineering-certifikat fra MIT, et AI-certifikat fra Stanford og et automotive funktionelt sikkerhedscertifikat fra TÜV SÜD.

Fortæl os om din virksomhed

"Mastiṣka AI” (Mastiṣka betyder hjerne på sanskrit) er en AI-virksomhed, der fokuserer på at bygge hjernelignende computere til at køre fundamentmodeller mere effektivt til fremtidens Generative AI-brug.

Hvilke problemer løser du?

I betragtning af fordelene ved AI/GenAI er dets efterspørgsel kun nødt til at stige, og det samme vil dets bivirkninger på vores planet. Hvordan kan vi reducere eller neutralisere bivirkningerne af AI på vores planet? Kulstoffangst og atomkraft er i den rigtige retning. Men vi er nødt til grundlæggende at gentænke den måde, vi laver kunstig intelligens på, er det den forkerte måde at lave tonsvis af matrixmultiplikationer på?

Vores hjerne kan lære og udføre mange opgaver parallelt, i og under 10W, men hvorfor bruger disse AI-systemer 10s megawatt til at træne modeller?

Måske byder fremtiden på energieffektive arkitekturer såsom neuromorfe arkitekturer og spidse neurale netværksbaserede transformatorer, der er tættest på den menneskelige hjerne, som kan forbruge 100-1000 gange lavere energi, og dermed reducere omkostningerne ved at bruge AI, og derved demokratisere det og spare vores planet.

De aktuelle udfordringer, vi står over for med kunstig intelligens, er a) tilgængelighed, b) tilgængelighed, c) overkommelighed og d) miljøsikkerhed sammen med nogle anbefalinger til at tackle dem.

Hvis vi forudser i fremtiden, demonstreres nogle nyttige AGI-koncepter i filmen "HER", hvor karakteren 'Samantha' – en samtaleagent, der er naturlig, forstår følelser, viser empati, er en fantastisk andenpilot på arbejdet – og kører videre håndholdte enheder hele dagen, så skal vi måske tage fat på nedenstående udfordringer lige nu.

Problem 1: At træne en LLM kan koste alt fra 150K til 10+ millioner dollars, og det tillader kun dem med dybere lommer at udvikle AI. Oven i købet er omkostningerne ved inferencing også enorme (koster 10 gange mere end en websøgning)

—> Vi er nødt til at forbedre energieffektiviteten af modeller/hardware for at demokratisere kunstig intelligens til gavn for menneskeheden.

Problem 2: Kørsel af enorme AI-modeller for samtaleagenter eller anbefalingssystemer belaster miljøet med hensyn til elforbrug og køling.

—> Vi er nødt til at forbedre energieffektiviteten af modeller/hardware for at redde vores planet for vores børn.

Problem 3: Den menneskelige hjerne er i stand til og kan multitaske, men bruger kun 10 watt i stedet for megawatt.

—> Måske skulle vi bygge maskiner som vores hjerner og ikke de almindelige matrixmultiplikatorer hurtigere.

Menneskeheden kan kun trives med bæredygtige innovationer og ikke ved at fælde alle skove og koge havene i innovationens navn. Vi skal beskytte vores planet for vores børns velfærd og kommende generationer...

Hvilke anvendelsesområder er dine stærkeste?

Træning og inferencing af transformator (og fremtidig neural arkitektur) baserede fundamentmodeller, med 50-100x mere energieffektivt sammenlignet med nutidens GPU-baserede løsninger.

Hvad holder dine kunder vågne om natten?

Problemer for kunder, der i øjeblikket bruger andre produkter:

Elforbrug til træning af humungous sprogmodeller er uden for taget, for eksempel koster træning af en 13B parameter LLM på 390B teksttokens på 200 GPU'er i 7 dage $151,744 (Kilde: HuggingFace ny træningsklynge-serviceside – https://lnkd.in/g6Vc5cz3). Og endnu større modeller med 100+B-parametre koster $10+M bare at træne. Betal derefter for at konkludere, hver gang der kommer en ny hurtig anmodning.

Vandforbrug til køling, forskere ved University of California, Riverside estimerede miljøpåvirkningen af ChatGPT-lignende tjenester og siger, at den suger 500 milliliter vand op (tæt på, hvad der er i en 16-ounce vandflaske), hver gang du spørger den en serie med mellem 5 og 50 meddelelser eller spørgsmål. Udvalget varierer afhængigt af, hvor dens servere er placeret og sæsonen. Estimatet inkluderer indirekte vandforbrug, som virksomhederne ikke måler - såsom at køle kraftværker, der forsyner datacentrene med elektricitet. (Kilde: https://lnkd.in/gybcxX8C)

Problemer for ikke-kunder af nuværende produkter:

Har ikke råd til CAPEX at købe hardware

Har ikke råd til at bruge cloud-tjenester

Kan ikke innovere eller udnytte kunstig intelligens – sidder fast i en servicemodel, der eliminerer enhver konkurrencefordel

Hvordan ser konkurrencelandskabet ud, og hvordan differentierer man sig?

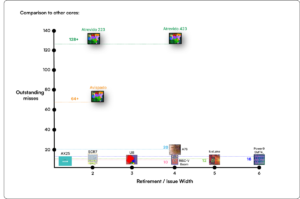

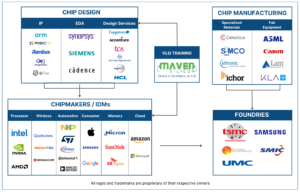

- GPU'er dominerer træningsområdet, selvom specialiserede ASIC'er også konkurrerer i dette segment

- Cloud & Edge-inferens har for mange tilgængelige muligheder

Digital, Analog, Photonic — you name it, folk forsøger at tackle det samme problem.

Kan du dele dine tanker om den nuværende tilstand af chiparkitektur for AI/ML, hvilket betyder, hvad ser du som de vigtigste tendenser og muligheder lige nu?

Følgende tendenser:

Tendens 1: For 10 år siden blomstrede hardware-aktiveret deep learning, og nu hæmmer den samme hardware fremskridt. På grund af de enorme omkostninger til hardware og el-omkostninger til at køre modeller, er det blevet en udfordring at få adgang til hardwaren. Kun virksomheder med dybe lommer har råd til disse og er ved at blive monopoler.

Tendens 2: Nu hvor disse modeller er der, er vi nødt til at bruge dem til praktiske formål, så den inferencerende belastning vil stige, hvilket gør det muligt for CPU'er med AI-acceleratorer at komme frem i rampelyset igen.

Tendens 3: Startups forsøger at komme med alternative flydende tal-repræsentationer, som det traditionelle IEEE-format - såsom logaritmisk og posit-baseret - er gode, men ikke nok. PPA$ designrumsoptimering eksploderer, når vi forsøger at optimere en og anden går på spil.

Tendens 4: Industrien bevæger sig væk fra den servicebaserede model af AI til at være vært for sine egne private modeller i sine egne lokaler - men adgang til hardware er en udfordring på grund af forsyningsmangel, sanktioner osv.

Aktuel situation:

Tilgængeligheden af hardware og data fremmede væksten af AI for 10 år siden, nu hæmmer den samme hardware det - lad mig forklare

Lige siden CPU'er havde det elendigt, og GPU'er blev genbrugt til AI, skete der mange ting

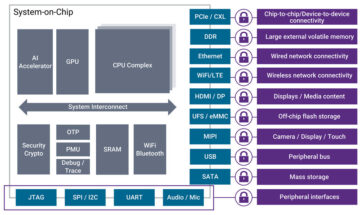

Virksomheder har henvendt sig til 4 segmenter af AI/ML, nemlig – 1) cloud-træning, 2) cloud-inferencing, 3) edge-inferencing og 4) edge-træning (fødereret læring til privatlivsfølsomme applikationer).

Digital & Analog

Træningsside – et væld af virksomheder, der laver GPU'er, kundeacceleratorer baseret på RISC-V, chips i wafer-skala (850 kerner) og så videre, hvor traditionelle CPU'er mangler (deres generelle formål). Inferensside – NN-acceleratorer er tilgængelige fra alle producenter, i smartphones, bærbare computere og andre edge-enheder.

Analog memristor-baserede arkitekturer dukkede også op for noget tid siden.

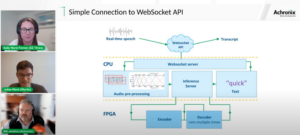

Vi mener, at CPU'er kan være meget gode til at konkludere, hvis vi forbedrer det med acceleration såsom matrixudvidelser

RISC-V side af tingene:

På RISC-V-siden udvikler vi acceleratorer til matrixoperationer og andre ikke-lineære operationer for at eliminere mulige flaskehalse for transformatorarbejdsbelastninger. Von Neumann-flaskehalse løses også ved at bygge minder tættere på computing, hvilket i sidste ende gør CPU'er med AI-acceleration til det rigtige valg til inferencing.

Muligheder:

Der er unikke muligheder for at udfylde markedet for funderingsmodeller. Eksempel - OpenAI har nævnt, at de ikke var i stand til at sikre nok AI compute (GPU'er) til at fortsætte med at presse deres ChatGPT-tjenester ... og nyhedsrapporterne om elomkostninger på 10 gange af almindelig internetsøgning og 500 ml vand til at køle systemerne ned for hver forespørgsel. Der er et marked at udfylde her - det er ikke en niche, men det er hele markedet, der vil demokratisere kunstig intelligens til at tackle alle de ovenfor nævnte udfordringer - a) tilgængelighed, b) tilgængelighed, c) overkommelig pris og d) miljøsikkerhed

Hvilke nye funktioner/teknologi arbejder du på?

Vi bygger hjerne som computer ved at udnytte neuromodrfiske teknikker og skræddersy modeller for at drage fordel af den energieffektive hardware, genbrug af tilgængelige åbne rammer

Hvordan forestiller du dig, at AI/ML-sektoren vokser eller ændrer sig i de næste 12-18 måneder?

Efterhånden som efterspørgslen efter GPU'er er blevet mindre (koster som $30), plus nogle dele af verden står over for sanktioner for at købe disse GPU'er, føler nogle dele af verden, at de er fastfrosset i AI-forskning og -udvikling uden adgang til GPU'er. Alternative hardwareplatforme kommer til at fange markedet.

Modeller vil måske begynde at skrumpe - tilpassede modeller eller endda fundamentalt vil informationstætheden vokse

Samme spørgsmål, men hvad med væksten og forandringen i de næste 3-5 år?

a) CPU'er med AI-udvidelser ville fange AI-inferensmarkedet

b) Modeller ville blive smidige, og parametre vil falde ud, når informationstætheden forbedres fra 16 % til 90 %

c) Energieffektiviteten forbedres, CO2-fodaftrykket reduceres

d) Nye arkitekturer kommer op

e) hardwareomkostninger og energiomkostninger falder, så adgangsbarrieren for mindre virksomheder til at skabe og træne modeller bliver overkommelig

f) folk taler om pre-AGI-øjeblikket, men mit benchmark ville være den karakteriserede Samantha (konversations-AI) i filmen "hende".. Det er måske usandsynligt i betragtning af de høje omkostninger ved at opskalere

Hvad er nogle af de udfordringer, der kan påvirke eller begrænse væksten i AI/ML-sektoren?

a) Adgang til hardware

b) Energiomkostninger og køleomkostninger og miljøskader

Læs også:

CEO Interview: David Moore fra Pragmatic

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk dig selv. Adgang her.

- PlatoAiStream. Web3 intelligens. Viden forstærket. Adgang her.

- PlatoESG. Kulstof, CleanTech, Energi, Miljø, Solenergi, Affaldshåndtering. Adgang her.

- PlatoHealth. Bioteknologiske og kliniske forsøgs intelligens. Adgang her.

- Kilde: https://semiwiki.com/ceo-interviews/338703-ceo-interview-suresh-sugumar-of-mastiska-ai/

- :har

- :er

- :ikke

- :hvor

- $OP

- 1

- 10

- 150

- 20

- 20 år

- 200

- 50

- 500

- 7

- a

- I stand

- Om

- over

- Abu Dhabi

- acceleration

- acceleratorer

- adgang

- tilgængelighed

- aktivt

- adresse

- rettet

- adressering

- Fordel

- Anliggender

- igen

- Agent

- midler

- AGI

- siden

- AI

- AI modeller

- ai forskning

- AI-systemer

- ai use cases

- AI / ML

- justeret

- Alle

- tillade

- tillader

- sammen

- også

- alternativ

- forbløffende

- an

- ,

- En anden

- enhver

- overalt

- Anvendelse

- applikationer

- arkitektur

- ER

- områder

- Ankommer

- kunstig

- kunstig intelligens

- AS

- Asics

- spørg

- At

- automotive

- tilgængelighed

- til rådighed

- væk

- b

- barriere

- baseret

- BE

- bliver

- bliver

- blive

- været

- være

- Tro

- jf. nedenstående

- benchmark

- gavner det dig

- fordele

- mellem

- Beyond

- flaskehalse

- bundet

- Brain

- hjerner

- bygge

- Bygning

- men

- købe

- by

- california

- CAN

- aflyst

- kapacitet

- stand

- kapital

- fange

- kulstof

- kulstofopsamling

- tilfælde

- Centers

- Direktør

- Interview med CEO

- certifikat

- udfordre

- udfordringer

- lave om

- ændret

- skiftende

- karakter

- ChatGPT

- Børn

- chip

- Chips

- valg

- Chopra

- kunde

- Luk

- tættere

- Cloud

- Cluster

- co2

- Kom

- Virksomheder

- selskab

- sammenlignet

- konkurrere

- konkurrencedygtig

- Compute

- computer

- computere

- computing

- begreber

- konferencer

- forbruge

- forbrug

- fortsæt

- bidrog

- konversation

- samtale AI

- Cool

- Koste

- Omkostninger

- kunne

- skabe

- Nuværende

- Nuværende tilstand

- For øjeblikket

- skik

- kunde

- Kunder

- skære

- Cybersecurity

- data

- datacentre

- Datacenter

- David

- dag

- Dage

- beslutning

- dyb

- dyb læring

- dybere

- Efterspørgsel

- demokratisere

- demokratisering

- demonstreret

- tæthed

- Afhængigt

- Design

- udvikle

- udviklet

- udvikling

- Udvikling

- Enheder

- Dhabi

- differentiere

- diligence

- retning

- Direktør

- do

- gør

- gør

- dollars

- Dont

- ned

- dr

- Drop

- grund

- optjent

- Edge

- effekter

- effektivitet

- effektiv

- effektivt

- elektricitet

- elforbrug

- eliminere

- eliminerer

- følelser

- Empati

- energi

- energieffektivitet

- Engineering

- forbedre

- nok

- Hele

- indrejse

- Miljø

- miljømæssige

- envision

- skøn

- anslået

- etc.

- Ether (ETH)

- Endog

- til sidst

- Hver

- eksempel

- udøvende

- Administrerende direktør

- eksisterer

- ekspertise

- Eksploderer

- udvidelser

- Ansigtet

- vender

- falk

- hurtigere

- følelse

- udfylde

- firmaer

- flydende

- fokuserede

- Fod

- Til

- forudse

- format

- rigdom

- Foundation

- rammer

- fra

- frosset

- næring

- funktionel

- fundamentalt

- fremtiden

- Generelt

- generationer

- generative

- Generativ AI

- given

- Go

- Goes

- gå

- godt

- GPU'er

- gruppe

- Dyrkning

- Vækst

- Hardware

- Have

- he

- dermed

- link.

- Høj

- besidder

- Hosting

- Hvordan

- HTTPS

- kæmpe

- KrammerFace

- menneskelig

- Menneskelighed

- IEEE

- if

- billede

- KIMOs Succeshistorier

- Forbedre

- forbedrer

- in

- I andre

- omfatter

- Forøg

- industrien

- oplysninger

- innovere

- Innovation

- innovationer

- i stedet

- Institut

- Intel

- Intelligens

- internationalt

- Internet

- Interview

- investering

- tingenes internet

- IT

- ITS

- lige

- børn

- Venlig

- Mangel

- landskab

- Sprog

- laptops

- stor

- større

- føre

- Leadership" (virkelig menneskelig ledelse)

- LÆR

- læring

- lad

- Leverage

- løftestang

- ligesom

- rampelyset

- GRÆNSE

- belastning

- placeret

- Se

- ligner

- lavere

- Maskiner

- Making

- Fabrikant

- mange

- Marked

- Markeder

- Matrix

- max-bredde

- Kan..

- kan være

- MBA

- me

- betyder

- midler

- måle

- Memories

- nævnte

- måske

- million

- millioner dollars

- MIT

- model

- modeller

- øjeblik

- monopoler

- måned

- mere

- mest

- film

- flytning

- MS

- skal

- my

- navn

- nemlig

- Natural

- Behov

- netværksbaseret

- netværk

- Neural

- Ny

- nyheder

- næste

- niche

- nat

- adræt

- nu

- nukleare

- Atomkraft

- nummer

- oceaner

- of

- on

- ONE

- kun

- åbent

- open source

- OpenAI

- Produktion

- Muligheder

- optimering

- Optimer

- Indstillinger

- or

- Andet

- vores

- ud

- egen

- side

- Parallel

- parameter

- parametre

- dele

- Patenter

- Betal

- Mennesker

- måske

- planet

- planter

- perron

- Platforme

- plato

- Platon Data Intelligence

- PlatoData

- overflod

- plus

- lommer

- Punkt

- position

- mulig

- magt

- kraftværker

- Praktisk

- private

- Problem

- problemer

- Produkt

- Produkter

- Profil

- Progress

- prompter

- beskytte

- formål

- formål

- Skub ud

- sætter

- Qualcomm

- spørgsmål

- Spørgsmål

- rækkevidde

- rangeret

- Læs

- for nylig

- Anbefaling

- anbefalinger

- reducere

- reducere

- fast

- Rapporter

- anmode

- forskning

- forskning og udvikling

- forskere

- højre

- Riverside

- roller

- tag

- Kør

- kører

- løber

- sikker

- Sikkerhed

- samme

- Sanktioner

- sandkasse

- Gem

- besparelse

- siger

- skalering

- Videnskab

- Søg

- Sæson

- sektor

- sikker

- se

- segmenter

- halvleder

- Halvledere

- Series

- servere

- tjeneste

- Tjenester

- servering

- Del

- mangel

- bør

- viste

- Shows

- side

- signifikant

- siden

- mindre

- smartphone

- smartphones

- So

- Software

- Løsninger

- Løsning

- nogle

- Kilde

- Space

- specialiserede

- brugt

- Stanford

- starte

- Nystartede

- Tilstand

- Strategi

- stærkeste

- sådan

- forsyne

- support

- bæredygtig

- Systemer

- tackle

- tackle

- skræddersy

- Tag

- Tal

- opgaver

- Teknisk

- Teknologier

- teknologi innovation

- vilkår

- tekst

- end

- at

- Fremtiden

- oplysninger

- verdenen

- deres

- Them

- derefter

- Der.

- derved

- Disse

- de

- ting

- denne

- dem

- selvom?

- Trives

- tid

- til

- nutidens

- Tokens

- i morgen

- også

- top

- smid væk

- traditionelle

- Tog

- Kurser

- transformer

- transformers

- Tendenser

- betroet

- prøv

- forsøger

- under

- forstår

- universitet

- University of California

- usandsynligt

- us

- Brug

- brug

- anvendte

- ved brug af

- forskellige

- venture

- venturekapital

- venturekapitalfirmaer

- meget

- af

- var

- Vand

- Vej..

- we

- web

- Velfærd

- var

- Hvad

- hvornår

- som

- WHO

- hvorfor

- vilje

- med

- uden

- Arbejde

- arbejder

- world

- ville

- Forkert

- år

- dig

- Din

- zephyrnet