Jay Dawani er medstifter og administrerende direktør hos Lemurian Labs, en startup, der udvikler en accelereret computerplatform, der er skræddersyet specifikt til AI-applikationer. Platformen bryder igennem hardwarebarriererne for at gøre AI-udvikling hurtigere, billigere, mere bæredygtig og tilgængelig for mere end blot nogle få virksomheder.

Før han grundlagde Lemurian, grundlagde Jay to andre virksomheder inden for kunstig intelligens. Han er også forfatteren til den bedst bedømte "Matematik til dyb læring".

En ekspert på tværs af kunstig intelligens, robotteknologi og matematik, har Jay fungeret som CTO for BlocPlay, en offentlig virksomhed, der bygger en blockchain-baseret spilleplatform, og fungerede som direktør for AI hos GEC, hvor han ledede udviklingen af adskillige klientprojekter, der dækkede områder fra detailhandel, algoritmisk handel, proteinfoldning, robotter til rumudforskning, anbefalingssystemer og meget mere. I sin fritid har han også været rådgiver hos NASA Frontier Development Lab, Spacebit og SiaClassic.

Sidst vi præsenterede Lemurian Labs, var du fokuseret på robotteknologi og edge AI. Nu er du fokuseret på datacenter og cloud-infrastruktur. Hvad skete der, der fik dig til at ville dreje?

Faktisk gik vi fra at fokusere på at bygge en højtydende, lav latens, system-on-chip til autonome robotapplikationer, der kunne accelerere hele sense-plan-act loop til at bygge en domænespecifik accelerator til AI med fokus på datacenter-skala applikationer . Men det var ikke bare et almindeligt omdrejningspunkt; det var et opkald, vi følte, at vi havde ansvaret for at besvare.

I 2018 arbejdede vi på at træne en parametermodel på 2.1 milliarder dollar, men vi opgav indsatsen, fordi omkostningerne var så ekstraordinært høje, at vi ikke kunne retfærdiggøre det. Så forestil dig min overraskelse over, at GPT3, som OpenAI udgav som ChatGPT i november 2022, var en parametermodel på $175 milliarder. Denne model er mere end 80 gange større end den, vi arbejdede på kun 4 år tidligere, hvilket er både spændende og skræmmende.

Omkostningerne ved at træne sådan en model er mildest talt svimlende. Baseret på nuværende skaleringstendenser kan vi forvente, at omkostningerne ved at træne en frontier AI-model vil overstige en milliard dollars i en ikke alt for fjern fremtid. Selvom mulighederne for disse modeller vil være forbløffende, er omkostningerne latterligt høje. Baseret på denne bane vil kun en håndfuld meget ressourcestærke virksomheder med deres egne datacentre have råd til at træne, implementere og finjustere disse modeller. Dette er ikke udelukkende fordi computer er dyrt og strømkrævende, men også fordi de softwarestabler, vi stoler på, ikke er bygget til denne verden.

På grund af geografiske og energimæssige begrænsninger er der kun så mange steder at bygge datacentre. For at imødekomme computerkravene til AI skal vi være i stand til at bygge zettaskala-maskiner uden at kræve 20 atomreaktorer til at drive den. Vi har brug for en mere praktisk, skalerbar og økonomisk løsning. Vi kiggede os omkring og så ikke nogen på vej til at løse dette. Og så gik vi til tegnebrættet for at se på problemet holistisk som et system af systemer og ræsonnere om en løsning ud fra første principper. Vi spurgte os selv, hvordan vi ville designe hele stakken, fra software til hardware, hvis vi økonomisk skulle betjene 10 milliarder LLM-forespørgsler om dagen. Vi har sat vores blikke på en zettaskala-maskine på under 200 MW inden 2028.

Tricket er at se på det fra et synspunkt om uforholdsmæssig skalering - forskellige dele af et system følger forskellige skaleringsregler, så på et tidspunkt holder tingene bare op med at fungere, begynder at gå i stykker, ellers giver cost-benefit-afvejningen ikke længere mening. Når dette sker, er den eneste mulighed at redesigne systemet. Vores vurdering og løsning omfatter arbejdsbyrden, talsystem, programmeringsmodel, compiler, runtime og hardware holistisk.

Heldigvis ser vores eksisterende investorer og resten af markedet visionen, og vi rejste en seed-runde på $9 mio. for at udvikle vores talformat – PAL, for at udforske designrummet og konvergere om en arkitektur for vores domænespecifikke accelerator og arkitekt vores compiler og runtime. I simuleringer har vi været i stand til at opnå en 20X gennemløbsforøgelse i det mindre energifodaftryk end moderne GPU'er, og vi forventer at kunne levere en 8X fordel i systemets ydeevne for de samlede ejeromkostninger på den samme transistorteknologi.

Det er overflødigt at sige, at vi har en masse arbejde foran os, men vi er ret begejstrede for udsigten til at være i stand til at omdefinere datacenterøkonomi for at sikre en fremtid, hvor AI er rigeligt tilgængeligt for alle.

Det lyder bestemt spændende, og de tal lyder imponerende. Men du har nævnt talsystemer, hardware, compilere og kørselstider som alle de ting, du er fokuseret på – det lyder af meget for enhver virksomhed at tage fat på på én gang. Det virker som et meget risikabelt forslag. Skal startups ikke være mere fokuserede?

Det lyder som mange forskellige anstrengelser, men det er faktisk én indsats med mange indbyrdes forbundne dele. At løse kun én af disse komponenter isoleret fra de andre vil kun hindre potentialet for innovation, fordi det resulterer i at overse de systemiske ineffektiviteter og flaskehalse. Jensen Huang sagde det bedst, "For at være en accelereret computervirksomhed, skal du være en fuld stack-virksomhed", og jeg er helt enig. De er den nuværende markedsleder af en grund. Men jeg vil udfordre forestillingen om, at vi ikke er fokuserede. Det er i, hvordan vi tænker problemet helhedsorienteret, og hvordan vi bedst løser det for vores kunder, der er vores fokus.

At gøre det kræver en tværfaglig tilgang som vores. Hver del af vores arbejde informerer og understøtter de andre, hvilket gør os i stand til at skabe en løsning, der er langt mere end summen af dens dele. Tænk, hvis du skulle bygge en racerbil. Du ville ikke vilkårligt vælge et chassis, tilføje racerdæk og slippe den mest kraftfulde motor, du kan finde, og køre den, vel? Du ville tænke på aerodynamikken af bilens karrosseri for at reducere luftmodstanden og forbedre downforce, optimere vægtfordelingen for god håndtering, specialdesigne motoren til maksimal ydeevne, få et kølesystem for at forhindre overophedning, specificere et rullebur for at holde føreren sikker osv. Hvert af disse elementer bygger på og informerer det andet.

Når det er sagt, er det risikabelt at forsøge at gøre det hele på én gang for enhver virksomhed i enhver branche. For at håndtere risici anvender vi en trinvis tilgang, hvilket giver os mulighed for at validere vores teknologi med kunderne og justere vores strategi efter behov. Vi har bevist, at vores talformat virker, og at det har et bedre power-performance-areal end tilsvarende flydende kommatyper, samtidig med at det har bedre numeriske egenskaber, som gør det nemmere at kvantisere neurale netværk til mindre bitbredder. Vi har designet en arkitektur, som vi føler os trygge ved, og den er velegnet til både træning og slutning. Men vigtigere end alt det er at få softwaren rigtigt, og det er hovedparten af vores umiddelbare fokus. Vi skal sikre, at vi træffer de rigtige beslutninger i vores softwarestak, for hvor vi ser verden være et år eller to eller mere fra i dag.

At bygge et hardwarefirma er hårdt, dyrt og tager lang tid. Fokus på software lyder først som en meget levedygtig forretning i sig selv og potentielt mere tiltrækkende for investorer i det nuværende klima. Hvorfor laver du også hardware, da så mange velfinansierede virksomheder i rummet lukker deres døre, kæmper for at blive adopteret hos kunder og større aktører bygger deres eget hardware?

Du har fuldstændig ret i, at softwarevirksomheder generelt har været i stand til at rejse kapital meget nemmere end hardwarevirksomheder, og at hardware er meget hårdt. Vores nuværende fokus er meget på software, fordi det er der, vi ser det større problem. Lad mig være klar, problemet er ikke, om jeg kan få kerner til at køre på en CPU eller GPU med høj ydeevne; det er et længe løst problem. Problemet i dag er, hvordan vi gør det nemmere for udviklere at få mere ydeevne, produktivt ud af flere tusinde node-klynger, der består af heterogen databehandling, uden at bede dem om at revidere deres arbejdsgang.

Det er det problem, vi i øjeblikket fokuserer på at løse med en softwarestak, der giver udviklere superkræfter og låser op for den fulde kapacitet af computere i lagerskala, så vi mere økonomisk kan træne og implementere AI-modeller.

Med hensyn til investeringer, ja, VC'er er mere selektive i den slags virksomheder, de støtter, men det betyder også, at VC'er leder efter virksomheder med potentiale til at tilbyde virkelig banebrydende produkter, der har en klar vej til kommercialisering, mens de har betydelig indflydelse. Vi har lært af andres udfordringer og fejl og har aktivt designet vores forretningsmodel og køreplan for at imødegå risiciene. Det er også vigtigt at bemærke, at det, der har gjort startups succesrige, sjældent har været, hvor nemt de kan rejse VC-finansiering, men har mere at gøre med deres opfindsomhed, stædighed og kundefokus.

Og før du spørger, arbejder vi stadig på hardware, men primært i simulering lige nu. Vi har ikke tænkt os at optage et stykke tid. Men den samtale kan vi gemme til en anden gang.

Det er bestemt overbevisende, og din trinvise tilgang er meget anderledes sammenlignet med, hvad vi har set andre hardwarevirksomheder gøre. Jeg forstår det problem, du siger, at din softwarestak vil løse, men hvordan adskiller din software sig fra de forskellige indsatser på markedet?

De fleste af de virksomheder, du henviser til, fokuserer på at gøre det nemmere at programmere GPU'er ved at introducere flisebaserede eller opgavekortlægningsprogrammeringsmodeller for at få mere ydeevne ud af GPU'er, eller bygge nye programmeringssprog for at få højtydende kerner planlagt på forskellige platforme med støtte til in-line montage. Det er vigtige problemer, som de adresserer, men vi ser det problem, vi løser, som næsten ortogonalt.

Lad os et øjeblik tænke på kadencen af hardware- og softwareovergange. Single-core arkitekturer opnåede ydeevne fra klokhastighed og transistortæthed, men til sidst ramte klokhastigheder et plateau. Parallelisme ved hjælp af mange kerner omgik dette og gav betydelige speedups. Det tog softwaren omkring et årti at indhente, fordi programmeringsmodeller, kompilatorer og kørselstider skulle gentænkes for at hjælpe udviklere med at udvinde værdien i dette paradigme. Så begyndte GPU'er at blive acceleratorer til generelle formål, igen med en anden programmeringsmodel. Igen tog det næsten et årti for udviklere at udvinde værdi her.

Igen rammer hardware et plateau – Moores lov, energi- og termiske begrænsninger, flaskehalse i hukommelsen og mangfoldigheden af arbejdsbelastninger plus behovet for eksponentielt mere databehandling skubber os i retning af at bygge stadigt mere heterogene computerarkitekturer for bedre ydeevne, effektivitet og samlede omkostninger. Dette skift i hardware vil naturligvis skabe udfordringer for softwaren, fordi vi ikke har de rigtige compilere og runtimes til at understøtte den næste udvikling af computing. Denne gang skal vi dog ikke vente 10 år mere på, at software kan udvinde værdien af heterogene arkitekturer eller store klynger, især når de bliver mere end 80 % uudnyttede.

Det, vi fokuserer på, er at opbygge en heterogenitetsbevidst programmeringsmodel med opgavebaseret parallelitet, der adresserer bærbar ydeevne med krydsprocessoroptimeringer, kontekstbevidst kompilering og dynamisk ressourceallokering. Og for os er det lige meget, om det er en CPU, GPU, TPU, SPU (Lemurians arkitektur) eller en mesh af dem alle. Jeg ved, det lyder som mange smarte ord, men hvad det egentlig siger er, at vi har gjort det muligt at programmere enhver form for processor med en enkelt tilgang, og vi kan portere kode fra en slags processor til en anden med minimalt indsats uden at skulle ofre ydeevne, og planlæg arbejdet adaptivt og dynamisk på tværs af noder.

Hvis det, du siger, er sandt, kan du måske bare helt omdefinere computing. Lad os tale om finansiering. Du rejste $9 millioner i startfinansiering sidste år, hvilket betyder stærk investorstøtte og tro på din vision. Hvad har du lavet siden?

I løbet af det seneste år, drevet af startfinansieringen, har vi gjort betydelige fremskridt. Med vores team nu på 20 medlemmer, tog vi omhyggeligt fat på udfordringer, engagerede os med kunder og forfinede vores tilgang.

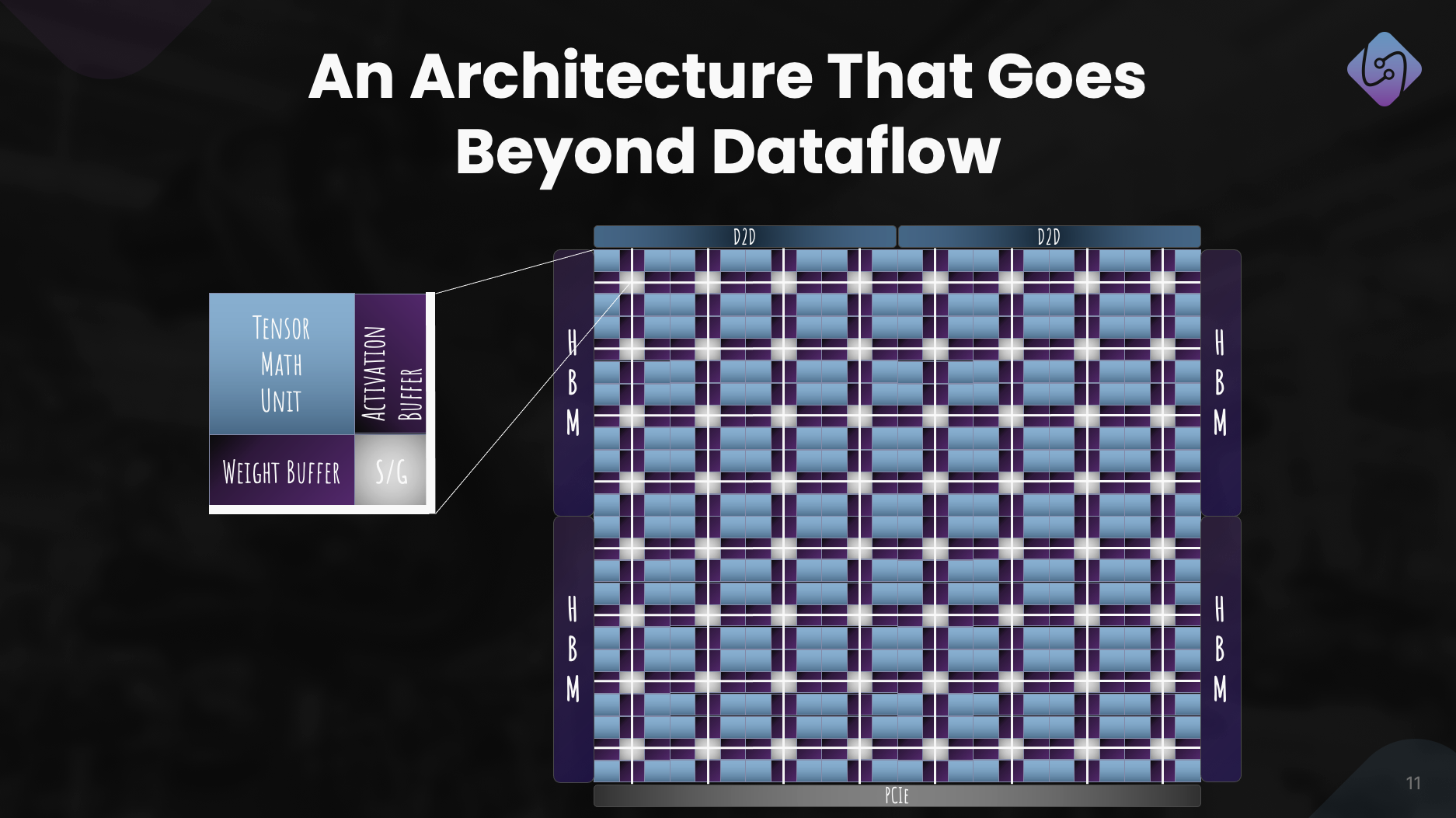

Vi fokuserede på at forbedre PAL til træning og inferens, udforskede computerarkitektur til vores accelerator og udviklede en simulator til præstationsmålinger. Samtidig gentænkte vi vores softwarestak til datacenterapplikationer med vægt på heterogen databehandling.

Denne indsats resulterede i en veldefineret arkitektur, der viser PAL's effektivitet til AI i skala. Ud over teknologiske fremskridt, forfulgte vi samarbejder og opsøgende for at demokratisere adgangen. Disse bestræbelser positionerer Lemurian Labs til at løse umiddelbare kundeudfordringer og forbereder sig på frigivelsen af vores produktionssilicium.

Hvad er Lemurian Labs' mellemfristede planer vedrørende udvikling af softwarestak, samarbejder og forbedring af acceleratorens arkitektur?

Vores umiddelbare mål er at skabe en softwarestak, der er målrettet CPU'er, GPU'er og vores AI-acceleratorer med bærbar ydeevne, som vil blive gjort tilgængelig for tidlige partnere i slutningen af året. Vi er i øjeblikket i samtaler med de fleste af de førende halvledervirksomheder, cloud-tjenesteudbydere, hyperscalere og AI-virksomheder for at give dem adgang til vores compiler og runtime. Parallelt hermed fortsætter vi med at arbejde på og forbedre vores accelerator-arkitektur for et ægte co-designet system af hardware og software. Og selvfølgelig er vi lige begyndt at rejse vores serie A med meget stor interesse fra investorsamfundet, hvilket vil gøre os i stand til at vokse vores team og nå vores mål for levering af softwareprodukter i slutningen af året.

Afslutningsvis, hvordan ser du Lemurian Labs bidrage til at ændre landskabet for AI-udvikling, tilgængelighed og retfærdighed i de kommende år?

Vi satte os ikke for at omdefinere computing kun for kommerciel gevinst eller for sjov. Som lemurianere er vores drivkraft, at vi tror på AIs transformative potentiale, og at mere end blot nogle få virksomheder bør have ressourcerne til at definere fremtiden for denne teknologi, og hvordan vi bruger den. Vi finder det heller ikke acceptabelt, at datacenterinfrastrukturen for kunstig intelligens er på vej til at forbruge så meget som 20 % af verdens energi i 2030. Vi kom alle sammen, fordi vi mener, at der er en bedre vej frem for samfundet, hvis vi kan gøre det. AI mere tilgængelig ved dramatisk at sænke de tilknyttede omkostninger, accelerere innovationstempoet inden for AI og udvide dens virkning. Ved at tage fat på udfordringerne i den nuværende hardwareinfrastruktur søger vi at bane vejen til at styrke en milliard mennesker med AI-kapaciteten og sikre en retfærdig distribution af denne avancerede teknologi. Vi håber, at vores forpligtelse til produktfokuserede løsninger, samarbejde og kontinuerlig innovation positionerer os som en drivkraft i at forme fremtiden for AI-udvikling til at være positiv.

Læs også:

Del dette opslag via:

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk dig selv. Adgang her.

- PlatoAiStream. Web3 intelligens. Viden forstærket. Adgang her.

- PlatoESG. Kulstof, CleanTech, Energi, Miljø, Solenergi, Affaldshåndtering. Adgang her.

- PlatoHealth. Bioteknologiske og kliniske forsøgs intelligens. Adgang her.

- Kilde: https://semiwiki.com/ceo-interviews/341485-ceo-interview-jay-dawani-of-lemurian-labs-2/

- :har

- :er

- :ikke

- :hvor

- $ 9 millioner

- $OP

- 1

- 10

- 20

- 2018

- 2022

- 2028

- 2030

- 20x

- 300

- 4

- a

- I stand

- Om

- absolut

- fremskynde

- accelereret

- accelerator

- acceleratorer

- acceptabel

- adgang

- tilgængelighed

- tilgængelig

- opnå

- tværs

- aktivt

- tilføje

- adresse

- rettet

- adressering

- justere

- Vedtagelse

- fremskreden

- Advanced Technology

- fremskridt

- rådgiver

- igen

- forude

- AI

- AI modeller

- algoritmisk

- algoritmisk handel

- Alle

- allokering

- tillade

- næsten

- også

- Amazon

- an

- ,

- En anden

- besvare

- enhver

- nogen

- tiltrækkende

- applikationer

- tilgang

- arbitrært

- arkitektur

- arkitekturer

- ER

- områder

- omkring

- kunstig

- kunstig intelligens

- AS

- spørg

- spørge

- Assembly

- vurdering

- forbundet

- forbløffende

- At

- forfatter

- autonom

- til rådighed

- tilbage

- barrierer

- baseret

- BE

- fordi

- blive

- været

- før

- være

- tro

- Tro

- gavner det dig

- BEDSTE

- Bedre

- Beyond

- større

- Billion

- blockchain-baserede

- board

- krop

- både

- flaskehalse

- Breaking

- pauser

- udvide

- bygge

- Bygning

- bygger

- bygget

- hovedparten

- virksomhed

- forretningsmodel

- virksomheder

- men

- by

- kadence

- ringe

- kom

- CAN

- Kan få

- kapaciteter

- kapacitet

- kapital

- brydning

- center

- Direktør

- Interview med CEO

- sikkert

- udfordre

- udfordringer

- skiftende

- chassis

- ChatGPT

- billigere

- klar

- kunde

- Klima

- ur

- lukning

- Cloud

- sky infrastruktur

- Medstifter

- kode

- samarbejde

- samarbejder

- kommer

- kommerciel

- kommercialisering

- engagement

- samfund

- Virksomheder

- selskab

- sammenlignet

- overbevisende

- compiler

- fuldstændig

- komponenter

- Compute

- computer

- computere

- computing

- sikker

- begrænsninger

- forbruge

- fortsæt

- kontinuerlig

- bidrager

- Converge

- Samtale

- samtaler

- klimakontrol

- korrigere

- Koste

- kunne

- kursus

- dækker

- CPU

- skabe

- Cross

- CTO

- Nuværende

- For øjeblikket

- skik

- brugerdefineret design

- kunde

- Kunder

- data

- Data Center

- Datacenter

- dag

- årti

- afgørelser

- dyb

- definere

- levere

- levering

- krav

- demokratisere

- tæthed

- indsætte

- Design

- konstrueret

- udvikle

- udviklet

- udviklere

- udvikling

- Udvikling

- DID

- forskellige

- differentiere

- Direktør

- Fjern

- fordeling

- Mangfoldighed

- do

- gør

- Er ikke

- gør

- dollars

- domæne

- færdig

- Dont

- døre

- dramatisk

- tegning

- driver

- kørsel

- Drop

- dynamisk

- dynamisk

- hver

- tidligere

- Tidligt

- lettere

- nemt

- økonomisk

- Økonomi

- Edge

- virkningsfuldhed

- effektivitet

- indsats

- indsats

- elementer

- at understrege

- bemyndigelse

- muliggøre

- muliggør

- vedrører generelt

- ende

- energi

- beskæftiget

- Engine (Motor)

- forbedre

- styrke

- sikre

- sikring

- Hele

- retfærdig

- egenkapital

- Ækvivalent

- især

- etc.

- til sidst

- alle

- evolution

- overstige

- ophidset

- spændende

- eksisterende

- forvente

- dyrt

- ekspert

- udforskning

- udforske

- udforsket

- eksponentielt

- ekstrakt

- ekstraordinært

- Faktisk

- fancy

- langt

- hurtigere

- featured

- føler sig

- fejl

- få

- Finde

- Fornavn

- flydende

- Fokus

- fokuserede

- fokusering

- følger

- Fodspor

- Til

- Tving

- format

- Videresend

- Grundlagt

- stiftende

- fra

- Frontier

- næring

- fuld

- Fuld stak

- fuldt ud

- sjovt

- finansiering

- fremtiden

- Fremtiden for AI

- Gevinst

- vundet

- spil

- spilplatform

- gearing

- Generelt

- generelt

- geografisk

- få

- få

- Giv

- given

- giver

- mål

- gå

- godt

- fik

- GPU

- GPU'er

- banebrydende

- Grow

- havde

- håndfuld

- Håndtering

- skete

- sker

- Hardware

- Have

- have

- he

- hjælpe

- link.

- Høj

- hindre

- hans

- Hit

- rammer

- håber

- Hvordan

- How To

- HTTPS

- Huang

- Hungry

- i

- if

- billede

- umiddelbar

- KIMOs Succeshistorier

- vigtigt

- imponerende

- Forbedre

- in

- stigende

- industrien

- ineffektivitet

- oplyser

- Infrastruktur

- Innovation

- Intelligens

- hensigt

- sammenkoblet

- interesse

- Interview

- indføre

- investering

- investor

- Investorer

- isolation

- IT

- ITS

- jensen huang

- jpg

- lige

- Holde

- Venlig

- Kend

- lab

- Labs

- landskab

- Sprog

- stor

- større

- Efternavn

- Sidste år

- Latency

- Lov

- leder

- førende

- lærte

- mindst

- Led

- lad

- ligesom

- ll

- llm

- Lang

- lang tid

- længere

- Se

- kiggede

- leder

- Lot

- Lav

- sænkning

- maskine

- Maskiner

- lavet

- lave

- maerker

- Making

- administrere

- mange

- Marked

- Markedsleder

- matematik

- Matter

- max-bredde

- maksimal

- Kan..

- me

- midler

- Mød

- Medlemmer

- Hukommelse

- nævnte

- blot

- mesh

- omhyggeligt

- Metrics

- million

- mindste

- fejl

- model

- modeller

- Moderne

- øjeblik

- mere

- mest

- meget

- tværfaglig

- my

- Nasa

- Behov

- behov

- behøve

- net

- Neural

- neurale netværk

- Ny

- næste

- ingen

- node

- noder

- Bemærk

- Begreb

- november

- nu

- nukleare

- nummer

- numre

- of

- tilbyde

- on

- engang

- ONE

- kun

- OpenAI

- optimeringer

- Optimer

- Option

- or

- ordrer

- almindelig

- Andet

- Andre

- vores

- os selv

- ud

- opsøgende

- i løbet af

- overhaling

- egen

- ejerskab

- Tempo

- paradigme

- Parallel

- parameter

- del

- partnere

- dele

- forbi

- sti

- bane

- Mennesker

- ydeevne

- Trinvis

- pick

- Pivot

- Steder

- planer

- perron

- Platforme

- plato

- Platon Data Intelligence

- PlatoData

- plus

- Punkt

- Synspunkt

- bærbare

- position

- positioner

- positiv

- mulig

- Indlæg

- potentiale

- potentielt

- magt

- vigtigste

- Praktisk

- smuk

- forhindre

- primært

- principper

- Problem

- problemer

- forarbejdning

- Processor

- Produkt

- produktion

- Produkter

- Program

- Programmering

- programmeringssprog

- projekter

- egenskaber

- proposition

- udsigten

- Protein

- gennemprøvet

- forudsat

- udbydere

- offentlige

- rent

- formål

- Pushing

- forespørgsler

- Løb

- Racing

- rejse

- hævet

- hæve

- sjældent

- Læs

- virkelig

- grund

- Anbefaling

- omdefinere

- redesign

- reducere

- henviser

- raffinerede

- om

- genoptaget

- frigive

- frigivet

- stole

- Kræver

- ressource

- Ressourcer

- ansvar

- REST

- resulteret

- Resultater

- detail

- højre

- risici

- Risikabel

- køreplan

- robotteknik

- robotter

- Roll

- groft

- rundt

- regler

- kører

- ofre

- sikker

- Said

- samme

- Gem

- siger

- siger

- skalerbar

- Scale

- skalering

- planlægge

- planlagt

- se

- frø

- Frøfinansiering

- Frø rund

- Søg

- synes

- set

- selektiv

- halvleder

- forstand

- Series

- Serie A

- tjener

- serveret

- tjeneste

- service-udøvere

- sæt

- flere

- forme

- skifte

- bør

- fremvisning

- Seværdigheder

- signifikant

- betegner

- Silicon

- simulation

- simuleringer

- simulator

- samtidigt

- siden

- enkelt

- betydelige

- Skub

- mindre

- So

- Samfund

- Software

- løsninger

- Løsninger

- SOLVE

- løst

- Løsning

- nogle

- Lyd

- lyde

- Space

- rumforskning

- rumlige

- specifikke

- specifikt

- hastighed

- hastigheder

- stable

- Stakke

- svimlende

- starte

- påbegyndt

- opstart

- Nystartede

- Stadig

- Stands

- Strategi

- fremskridt

- stærk

- Kæmper

- vellykket

- sådan

- egnede

- sum

- support

- Understøtter

- formodes

- overraskelse

- bæredygtig

- systemet

- systemisk

- Systemer

- skræddersyet

- Tag

- tager

- tager

- Tal

- tape

- mål

- mål

- hold

- tech

- Teknologier

- end

- at

- Fremtiden

- Landskabet

- verdenen

- deres

- Them

- derefter

- Der.

- termisk

- Disse

- de

- ting

- tror

- denne

- dem

- selvom?

- tusinde

- Gennem

- kapacitet

- tid

- dæk

- til

- i dag

- sammen

- også

- tog

- I alt

- hård

- mod

- spor

- Trading

- Tog

- Kurser

- bane

- transformative

- overgang

- overgange

- Tendenser

- trick

- sand

- virkelig

- prøv

- to

- typer

- under

- forstå

- enhed

- låser op

- på

- us

- brug

- ved brug af

- VALIDATE

- værdi

- forskellige

- VC

- VC finansiering

- VCS

- meget

- via

- levedygtig

- Specifikation

- vision

- vente

- ønsker

- Warehouse

- var

- we

- vægt

- GODT

- veldefinerede

- gik

- var

- Hvad

- hvornår

- hvorvidt

- som

- mens

- hvorfor

- vilje

- med

- uden

- ord

- Arbejde

- workflow

- arbejder

- virker

- world

- Verdens

- ville

- år

- år

- Ja

- dig

- Din

- zephyrnet