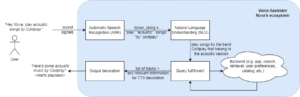

Nylige fremskridt i udviklingen af LLM'er har populariseret deres brug til forskellige NLP-opgaver, der tidligere blev løst ved hjælp af ældre maskinlæringsmetoder. Store sprogmodeller er i stand til at løse en række sprogproblemer såsom klassificering, opsummering, informationssøgning, oprettelse af indhold, besvarelse af spørgsmål og opretholdelse af en samtale - alt sammen ved hjælp af kun én enkelt model. Men hvordan ved vi, at de gør et godt stykke arbejde på alle disse forskellige opgaver?

Fremkomsten af LLM'er har bragt et uløst problem frem i lyset: Vi har ikke en pålidelig standard til at evaluere dem. Det, der gør evaluering sværere, er, at de bruges til meget forskelligartede opgaver, og vi mangler en klar definition af, hvad der er et godt svar for hver use case.

Denne artikel diskuterer nuværende tilgange til evaluering af LLM'er og introducerer en ny LLM-rangliste, der udnytter menneskelig evaluering, der forbedrer eksisterende evalueringsteknikker.

Den første og sædvanlige indledende form for evaluering er at køre modellen på flere kuraterede datasæt og undersøge dens ydeevne. HuggingFace oprettede en Åbn LLM Leaderboard hvor store modeller med åben adgang evalueres ved hjælp af fire velkendte datasæt (AI2 Reasoning Challenge , HellaSwag , MMLU , Sandfærdig QA). This corresponds to automatic evaluation and checks the model’s ability to get the facts for some specific questions.

Dette er et eksempel på et spørgsmål fra MMLU datasæt.

Emne: college_medicine

Spørgsmål: En forventet bivirkning af kreatintilskud er.

- A) muskelsvaghed

- B) øget kropsmasse

- C) muskelkramper

- D) tab af elektrolytter

Svar: (B)

At score modellen for at besvare denne type spørgsmål er en vigtig metrik og fungerer godt til faktatjek, men det tester ikke modellens generative evne. Dette er sandsynligvis den største ulempe ved denne evalueringsmetode, fordi generering af fri tekst er en af de vigtigste funktioner ved LLM'er.

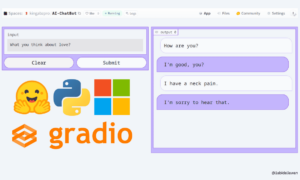

Der synes at være enighed i samfundet om, at for at kunne evaluere modellen ordentligt, har vi brug for menneskelig evaluering. Dette gøres typisk ved at sammenligne svarene fra forskellige modeller.

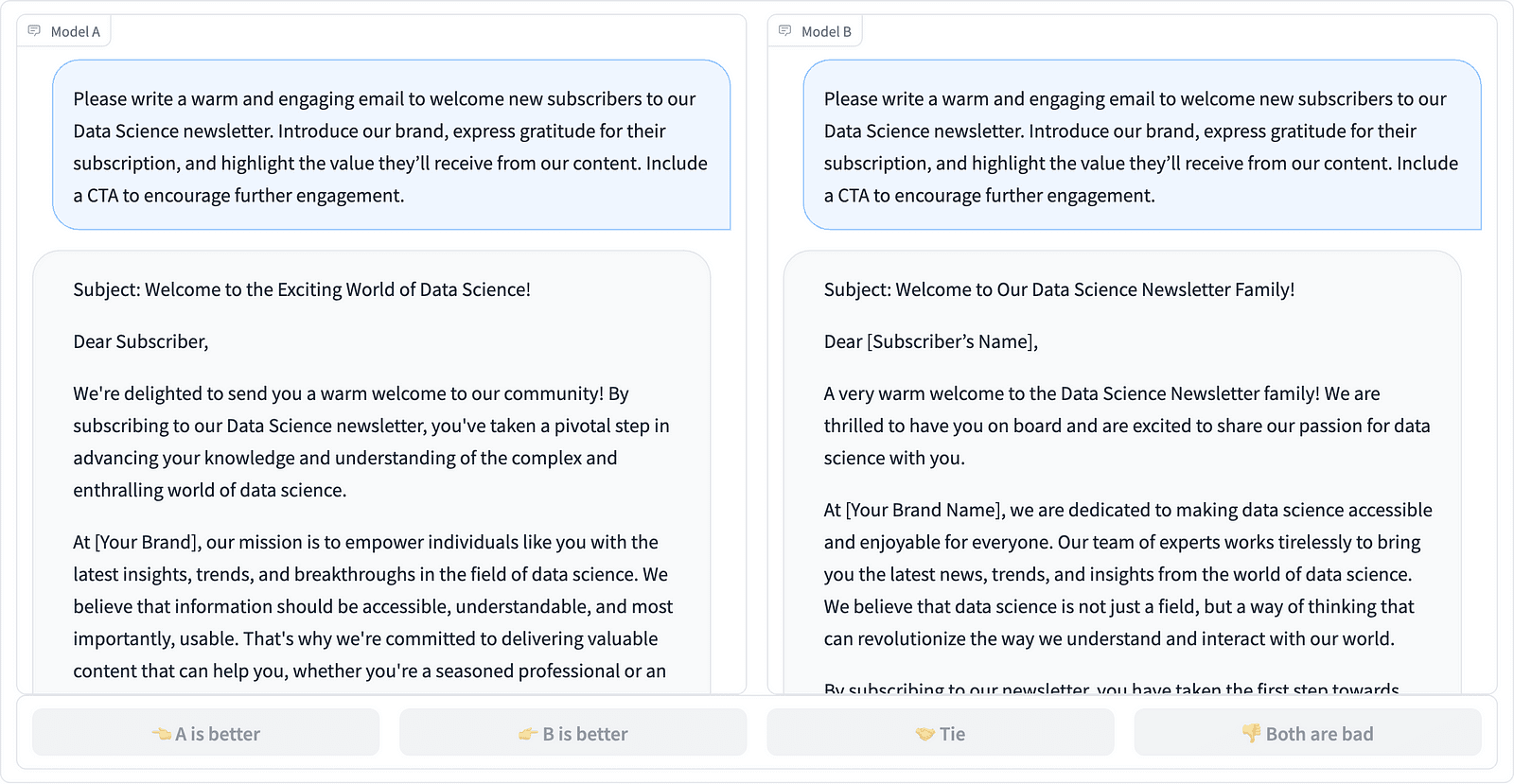

Comparing two prompt completions in the LMSYS project – screenshot by the Author

Annotatorer beslutter, hvilket svar der er bedre, som det ses i eksemplet ovenfor, og kvantificerer nogle gange forskellen i kvaliteten af promptafslutningerne. LMSYS Org har oprettet en leaderboard der bruger denne type menneskelig evaluering og sammenligner 17 forskellige modeller, der rapporterer Elo bedømmelse for hver model.

Fordi menneskelig evaluering kan være svær at skalere, har der været bestræbelser på at skalere og fremskynde evalueringsprocessen, og dette resulterede i et interessant projekt kaldet AlpacaEval. Her sammenlignes hver model med en baseline (text-davinci-003 leveret af GPT-4), og menneskelig evaluering erstattes med GPT-4-vurdering. Dette er faktisk hurtigt og skalerbart, men kan vi stole på, at modellen her udfører scoringen? Vi skal være opmærksomme på modelbias. Projektet har faktisk vist, at GPT-4 kan favorisere længere svar.

LLM-evalueringsmetoder fortsætter med at udvikle sig, efterhånden som AI-fællesskabet søger efter nemme, retfærdige og skalerbare tilgange. Den seneste udvikling kommer fra holdet hos Toloka med en ny leaderboard for yderligere at fremme de nuværende evalueringsstandarder.

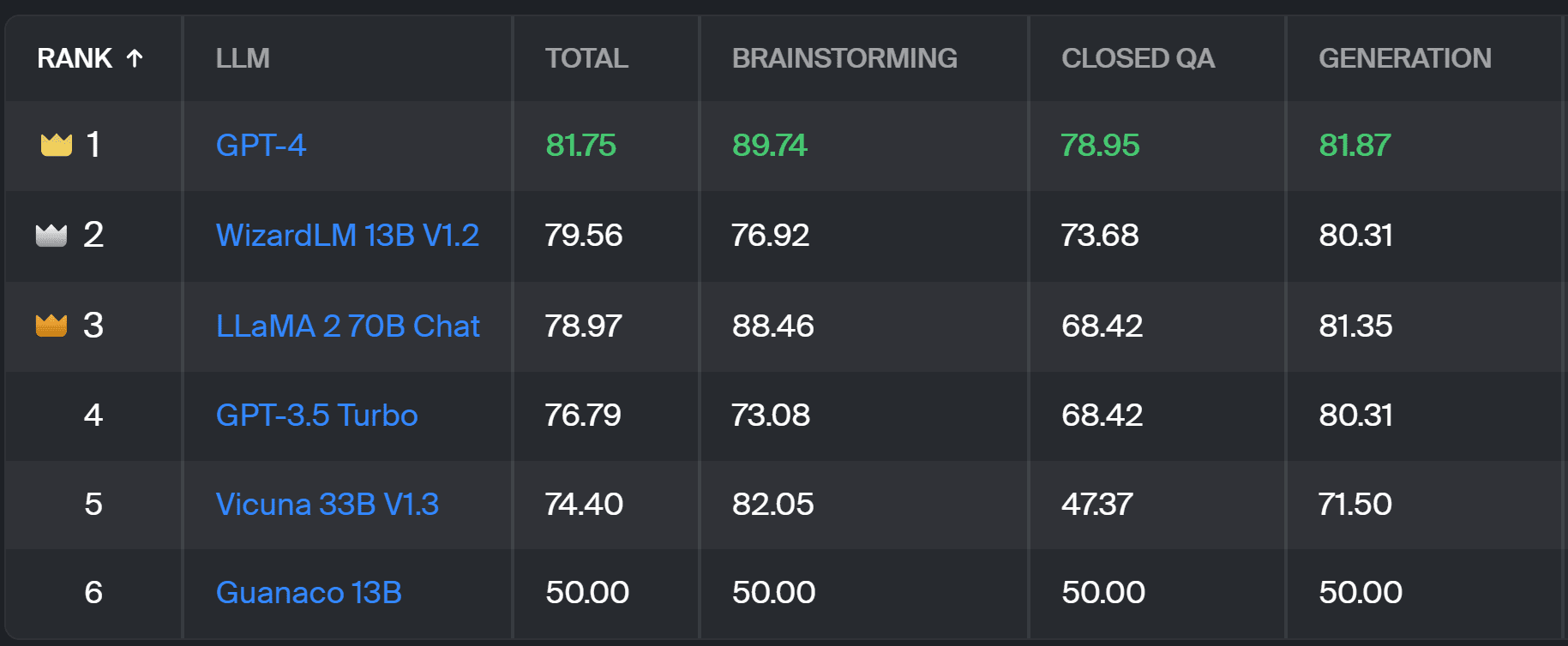

Den nye leaderboard sammenligner modelsvar med brugerprompter fra den virkelige verden, der er kategoriseret efter nyttige NLP-opgaver som beskrevet i dette InstructGPT papir. Den viser også hver models samlede gevinstrate på tværs af alle kategorier.

Toloka leaderboard – screenshot by the Author

Evalueringen, der er brugt til dette projekt, ligner den, der blev udført i AlpacaEval. Scoringerne på leaderboardet repræsenterer gevinstraten for den respektive model i forhold til Guanaco 13B model, som her tjener som en baseline sammenligning. Valget af Guanaco 13B er en forbedring af AlpacaEval-metoden, som bruger den snart forældede text-davinci-003-model som baseline.

Den faktiske evaluering udføres af menneskelige ekspertannotatorer på et sæt af virkelige prompter. For hver prompt får annotatorer to udfyldelser og bliver spurgt, hvilken de foretrækker. Du kan finde detaljer om metoden link..

Denne type menneskelig evaluering er mere nyttig end nogen anden automatisk evalueringsmetode og bør forbedre den menneskelige evaluering, der bruges til LMSYS leaderboard. Ulempen ved LMSYS-metoden er, at alle med link kan deltage i evalueringen, hvilket rejser alvorlige spørgsmål om kvaliteten af data indsamlet på denne måde. En lukket skare af ekspertannotatorer har bedre potentiale for pålidelige resultater, og Toloka anvender yderligere kvalitetskontrolteknikker for at sikre datakvaliteten.

I denne artikel har vi introduceret en lovende ny løsning til evaluering af LLM'er - Toloka Leaderboard. Tilgangen er innovativ, kombinerer styrkerne ved eksisterende metoder, tilføjer opgavespecifik granularitet og bruger pålidelige menneskelige annoteringsteknikker til at sammenligne modellerne.

Udforsk bestyrelsen, og del dine meninger og forslag til forbedringer med os.

Magdalena Konkiewicz er en dataevangelist hos Toloka, en global virksomhed, der understøtter hurtig og skalerbar AI-udvikling. Hun har en kandidatgrad i kunstig intelligens fra Edinburgh University og har arbejdet som NLP-ingeniør, udvikler og dataforsker for virksomheder i Europa og Amerika. Hun har også været involveret i at undervise og vejlede Data Scientists og bidrager jævnligt til Data Science og Machine Learning publikationer.

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk dig selv. Adgang her.

- PlatoAiStream. Web3 intelligens. Viden forstærket. Adgang her.

- PlatoESG. Kulstof, CleanTech, Energi, Miljø, Solenergi, Affaldshåndtering. Adgang her.

- PlatoHealth. Bioteknologiske og kliniske forsøgs intelligens. Adgang her.

- Kilde: https://www.kdnuggets.com/a-better-way-to-evaluate-llms?utm_source=rss&utm_medium=rss&utm_campaign=a-better-way-to-evaluate-llms

- :har

- :er

- :ikke

- :hvor

- $OP

- 17

- a

- evne

- Om

- over

- tværs

- faktiske

- faktisk

- Yderligere

- Tilføjer

- fremme

- fremskridt

- AI

- Alle

- også

- amerika

- an

- ,

- besvare

- svar

- enhver

- gælder

- tilgang

- tilgange

- ER

- Arena

- artikel

- kunstig

- kunstig intelligens

- AS

- At

- Automatisk Ur

- opmærksom på

- b

- Baseline

- BE

- fordi

- været

- Bedre

- fordomme

- Største

- board

- krop

- bragte

- virksomheder

- men

- by

- CAN

- stand

- tilfælde

- kategorier

- udfordre

- Kontrol

- valg

- klassificering

- klar

- lukket

- kombinerer

- kommer

- samfund

- selskab

- sammenligne

- sammenlignet

- sammenligne

- sammenligning

- Konsensus

- indhold

- indholdsskabelse

- fortsættende

- bidrager

- kontrol

- Samtale

- svarer

- oprettet

- skabelse

- crowd

- kurateret

- Nuværende

- data

- datakvalitet

- datalogi

- dataforsker

- datasæt

- beslutte

- definition

- Degree

- detaljer

- Udvikler

- Udvikling

- forskel

- forskellige

- Ulempe

- forskelligartede

- do

- gør

- gør

- færdig

- Dont

- downside

- hver

- let

- Edinburgh

- effekt

- indsats

- elektrolytter

- ingeniør

- sikre

- Europa

- evaluere

- evalueret

- evaluere

- evaluering

- Evangelist

- udvikle sig

- undersøge

- eksempel

- eksisterende

- forventet

- ekspert

- fakta

- retfærdig

- FAST

- favorisere

- Funktionalitet

- Finde

- Fornavn

- Til

- formular

- fire

- Gratis

- fra

- yderligere

- Gevinst

- indsamlede

- generere

- generative

- få

- GitHub

- given

- Global

- godt

- godt arbejde

- Hård Ost

- hårdere

- Have

- link.

- stærkt

- besidder

- Hvordan

- HTTPS

- KrammerFace

- menneskelig

- vigtigt

- Forbedre

- forbedringer

- forbedrer

- in

- oplysninger

- initial

- innovativ

- Intelligens

- interessant

- introduceret

- Introducerer

- involverede

- IT

- ITS

- Job

- lige

- bare en

- KDnuggets

- Kend

- Mangel

- Sprog

- stor

- seneste

- læring

- løftestang

- lys

- længere

- off

- maskine

- machine learning

- opretholdelse

- maerker

- måde

- Masse

- Master

- Kan..

- mentoring

- metode

- Metode

- metoder

- metrisk

- model

- modeller

- mere

- mest

- muskel

- Behov

- Ny

- ny løsning

- NLP

- of

- ældre

- on

- ONE

- åbent

- Udtalelser

- Andet

- skitseret

- samlet

- del

- udføre

- ydeevne

- udføres

- plato

- Platon Data Intelligence

- PlatoData

- potentiale

- foretrække

- tidligere

- sandsynligvis

- Problem

- problemer

- behandle

- projekt

- lovende

- prompter

- korrekt

- forudsat

- publikationer

- kvalitet

- spørgsmål

- Spørgsmål

- hæve

- Sats

- virkelige verden

- regelmæssigt

- pålidelig

- udskiftes

- Rapportering

- repræsentere

- dem

- svar

- reaktioner

- resulteret

- Resultater

- Rise

- Kør

- s

- skalerbar

- Scale

- Videnskab

- Videnskabsmand

- forskere

- scores

- scoring

- søgninger

- synes

- set

- alvorlig

- tjener

- sæt

- flere

- Del

- hun

- bør

- vist

- Shows

- side

- lignende

- enkelt

- løsninger

- Løsning

- nogle

- sommetider

- specifikke

- hastighed

- standard

- standarder

- styrker

- sådan

- Støtte

- Tag

- opgaver

- Undervisning

- hold

- teknikker

- prøve

- tekst

- end

- at

- deres

- Them

- Der.

- Disse

- de

- denne

- til

- Stol

- to

- typen

- typisk

- universitet

- på

- us

- Brug

- brug

- brug tilfælde

- anvendte

- Bruger

- bruger

- ved brug af

- sædvanlig

- række

- Vej..

- we

- Svaghed

- GODT

- Kendt

- var

- Hvad

- Hvad er

- som

- vinde

- med

- inden for

- arbejdede

- dig

- Din

- zephyrnet