ভূমিকা

একটি আবছা আলোকিত লাইব্রেরিতে দাঁড়িয়ে কল্পনা করুন, একটি জটিল নথির পাঠোদ্ধার করার জন্য লড়াই করার সময় ডজনখানেক অন্যান্য পাঠ্যকে জাগল করে। "অ্যাটেনশন ইজ অল ইউ নিড" কাগজটি তার বিপ্লবী স্পটলাইট উন্মোচন করার আগে এটি ছিল ট্রান্সফরমারের জগত - মনোযোগের প্রক্রিয়া.

সুচিপত্র

RNN-এর সীমাবদ্ধতা

ঐতিহ্যগত ক্রমিক মডেল, মত পৌনঃপুনিক নিউরাল নেটওয়ার্ক (RNNs), শব্দ দ্বারা প্রক্রিয়াকৃত ভাষা শব্দ, যা বিভিন্ন সীমাবদ্ধতার দিকে পরিচালিত করে:

- স্বল্প-পরিসর নির্ভরতা: RNNগুলি দূরবর্তী শব্দগুলির মধ্যে সংযোগগুলি বোঝার জন্য লড়াই করেছিল, প্রায়শই "যে লোকটি গতকাল চিড়িয়াখানা পরিদর্শন করেছিল" এর মতো বাক্যের অর্থের ভুল ব্যাখ্যা করে, যেখানে বিষয় এবং ক্রিয়া অনেক দূরে।

- সীমিত সমান্তরালতা: ক্রমানুসারে তথ্য প্রক্রিয়াকরণ সহজাতভাবে ধীর, দক্ষ প্রশিক্ষণ এবং গণনামূলক সম্পদের ব্যবহার প্রতিরোধ করে, বিশেষ করে দীর্ঘ অনুক্রমের জন্য।

- স্থানীয় প্রসঙ্গে ফোকাস করুন: RNN প্রাথমিকভাবে অবিলম্বে প্রতিবেশীদের বিবেচনা করে, বাক্যের অন্যান্য অংশ থেকে সম্ভাব্য গুরুত্বপূর্ণ তথ্য অনুপস্থিত।

এই সীমাবদ্ধতাগুলি ট্রান্সফরমারদের মেশিন অনুবাদ এবং প্রাকৃতিক ভাষা বোঝার মতো জটিল কাজগুলি সম্পাদন করার ক্ষমতাকে বাধাগ্রস্ত করে। তারপর এলো মনোযোগের প্রক্রিয়া, একটি বিপ্লবী স্পটলাইট যা শব্দগুলির মধ্যে লুকানো সংযোগগুলিকে আলোকিত করে, ভাষা প্রক্রিয়াকরণ সম্পর্কে আমাদের বোঝার পরিবর্তন করে৷ কিন্তু মনোযোগ ঠিক কি সমাধান করেছে, এবং কিভাবে এটি ট্রান্সফরমারদের জন্য গেম পরিবর্তন করেছে?

আসুন তিনটি মূল ক্ষেত্রে ফোকাস করা যাক:

দীর্ঘ পরিসর নির্ভরতা

- সমস্যা: ঐতিহ্যবাহী মডেলরা প্রায়শই "যে মহিলাটি পাহাড়ে বাস করত গত রাতে একটি শুটিং তারকা দেখেছিল" এর মতো বাক্যগুলিতে হোঁচট খেয়েছিল৷ তারা তাদের দূরত্বের কারণে "মহিলা" এবং "শুটিং স্টার" সংযোগ করতে লড়াই করেছিল, যার ফলে ভুল ব্যাখ্যা হয়েছিল।

- মনোযোগের প্রক্রিয়া: কল্পনা করুন যে মডেলটি বাক্য জুড়ে একটি উজ্জ্বল রশ্মি জ্বলছে, "নারী" কে সরাসরি "শুটিং স্টার" এর সাথে সংযুক্ত করছে এবং বাক্যটিকে সামগ্রিকভাবে বুঝতে পারছে। দূরত্ব নির্বিশেষে সম্পর্ক ক্যাপচার করার এই ক্ষমতা মেশিন অনুবাদ এবং সারসংক্ষেপের মতো কাজের জন্য গুরুত্বপূর্ণ।

এছাড়াও পড়ুন: লং শর্ট টার্ম মেমরি (LSTM) এর উপর একটি ওভারভিউ

সমান্তরাল প্রক্রিয়াকরণ শক্তি

- সমস্যা: ঐতিহ্যগত মডেলগুলি ক্রমানুসারে তথ্য প্রক্রিয়াকরণ করে, যেমন পৃষ্ঠায় একটি বইয়ের পৃষ্ঠা পড়া। এটি ধীর এবং অদক্ষ ছিল, বিশেষ করে দীর্ঘ পাঠ্যের জন্য।

- মনোযোগের প্রক্রিয়া: কল্পনা করুন একাধিক স্পটলাইট একই সাথে লাইব্রেরি স্ক্যান করছে, সমান্তরালভাবে পাঠ্যের বিভিন্ন অংশ বিশ্লেষণ করছে। এটি নাটকীয়ভাবে মডেলের কাজকে ত্বরান্বিত করে, এটিকে বিপুল পরিমাণ ডেটা দক্ষতার সাথে পরিচালনা করার অনুমতি দেয়। এই সমান্তরাল প্রক্রিয়াকরণ শক্তি জটিল মডেল প্রশিক্ষণ এবং রিয়েল-টাইম ভবিষ্যদ্বাণী করার জন্য অপরিহার্য।

গ্লোবাল কনটেক্সট সচেতনতা

- সমস্যা: প্রথাগত মডেলগুলি প্রায়শই পৃথক শব্দের উপর দৃষ্টি নিবদ্ধ করে, বাক্যের বিস্তৃত প্রসঙ্গ অনুপস্থিত। এটি কটাক্ষ বা দ্বিগুণ অর্থের মতো ক্ষেত্রে ভুল বোঝাবুঝির দিকে পরিচালিত করে।

- মনোযোগের প্রক্রিয়া: কল্পনা করুন স্পটলাইটটি পুরো লাইব্রেরি জুড়ে ছড়িয়ে পড়েছে, প্রতিটি বই গ্রহণ করে এবং তারা একে অপরের সাথে কীভাবে সম্পর্কিত তা বুঝতে পারে। এই বিশ্বব্যাপী প্রেক্ষাপট সচেতনতা মডেলটিকে প্রতিটি শব্দের ব্যাখ্যা করার সময় পাঠ্যের সম্পূর্ণতা বিবেচনা করার অনুমতি দেয়, যা একটি সমৃদ্ধ এবং আরও সূক্ষ্ম বোঝার দিকে পরিচালিত করে।

দ্ব্যর্থহীন পলিসিমাস শব্দ

- সমস্যা: "ব্যাঙ্ক" বা "আপেল" এর মতো শব্দগুলি বিশেষ্য, ক্রিয়া বা এমনকি কোম্পানি হতে পারে, যা অস্পষ্টতা তৈরি করে যা ঐতিহ্যগত মডেলগুলি সমাধান করতে লড়াই করে।

- মনোযোগের প্রক্রিয়া: একটি বাক্যে "ব্যাঙ্ক" শব্দের সমস্ত ঘটনার উপর মডেলটি স্পটলাইট উজ্জ্বল করে কল্পনা করুন, তারপরে পার্শ্ববর্তী প্রসঙ্গ এবং অন্যান্য শব্দের সাথে সম্পর্ক বিশ্লেষণ করুন। ব্যাকরণগত কাঠামো, কাছাকাছি বিশেষ্য এবং এমনকি অতীত বাক্যগুলি বিবেচনা করে, মনোযোগের প্রক্রিয়াটি উদ্দেশ্যমূলক অর্থ বের করতে পারে। পলিসেমাস শব্দগুলিকে দ্ব্যর্থহীন করার এই ক্ষমতা মেশিন অনুবাদ, পাঠ্য সংক্ষিপ্তকরণ এবং সংলাপ সিস্টেমের মতো কাজের জন্য অত্যন্ত গুরুত্বপূর্ণ।

এই চারটি দিক - দীর্ঘ-পরিসর নির্ভরতা, সমান্তরাল প্রক্রিয়াকরণ শক্তি, বিশ্বব্যাপী প্রসঙ্গ সচেতনতা, এবং দ্ব্যর্থতা - মনোযোগের প্রক্রিয়ার রূপান্তরকারী শক্তি প্রদর্শন করে। তারা ট্রান্সফরমারগুলিকে প্রাকৃতিক ভাষা প্রক্রিয়াকরণের অগ্রভাগে চালিত করেছে, তাদের উল্লেখযোগ্য নির্ভুলতা এবং দক্ষতার সাথে জটিল কাজগুলি মোকাবেলা করতে সক্ষম করেছে।

যেহেতু এনএলপি এবং বিশেষ করে এলএলএমগুলি বিকশিত হতে থাকে, মনোযোগের প্রক্রিয়াগুলি নিঃসন্দেহে আরও গুরুত্বপূর্ণ ভূমিকা পালন করবে। তারা শব্দের রৈখিক ক্রম এবং মানব ভাষার সমৃদ্ধ ট্যাপেস্ট্রির মধ্যে সেতু, এবং শেষ পর্যন্ত, এই ভাষাগত বিস্ময়গুলির সত্যিকারের সম্ভাবনাকে আনলক করার চাবিকাঠি। এই নিবন্ধটি বিভিন্ন ধরণের মনোযোগের প্রক্রিয়া এবং তাদের কার্যকারিতা সম্পর্কে আলোচনা করে।

1. স্ব-মনোযোগ: ট্রান্সফরমারের গাইডিং স্টার

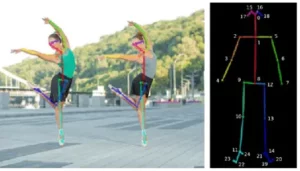

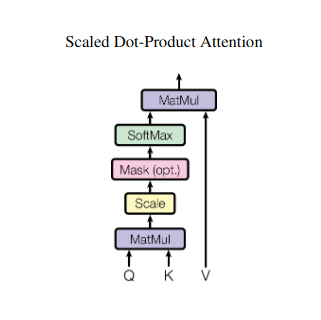

একটি সারাংশ লেখার সময় একাধিক বই জাগলিং এবং প্রতিটি নির্দিষ্ট প্যাসেজ উল্লেখ করার প্রয়োজন কল্পনা করুন. স্ব-মনোযোগ বা স্কেলড ডট-প্রোডাক্ট মনোযোগ একটি বুদ্ধিমান সহকারীর মতো কাজ করে, মডেলগুলিকে বাক্য বা টাইম সিরিজের মতো অনুক্রমিক ডেটা দিয়ে একই কাজ করতে সহায়তা করে। এটি ক্রমানুসারে প্রতিটি উপাদানকে অন্য প্রতিটি উপাদানে উপস্থিত হতে দেয়, কার্যকরভাবে দীর্ঘ-পরিসীমা নির্ভরতা এবং জটিল সম্পর্কগুলিকে ক্যাপচার করে।

এখানে এর মূল প্রযুক্তিগত দিকগুলির একটি ঘনিষ্ঠ দৃষ্টিভঙ্গি রয়েছে:

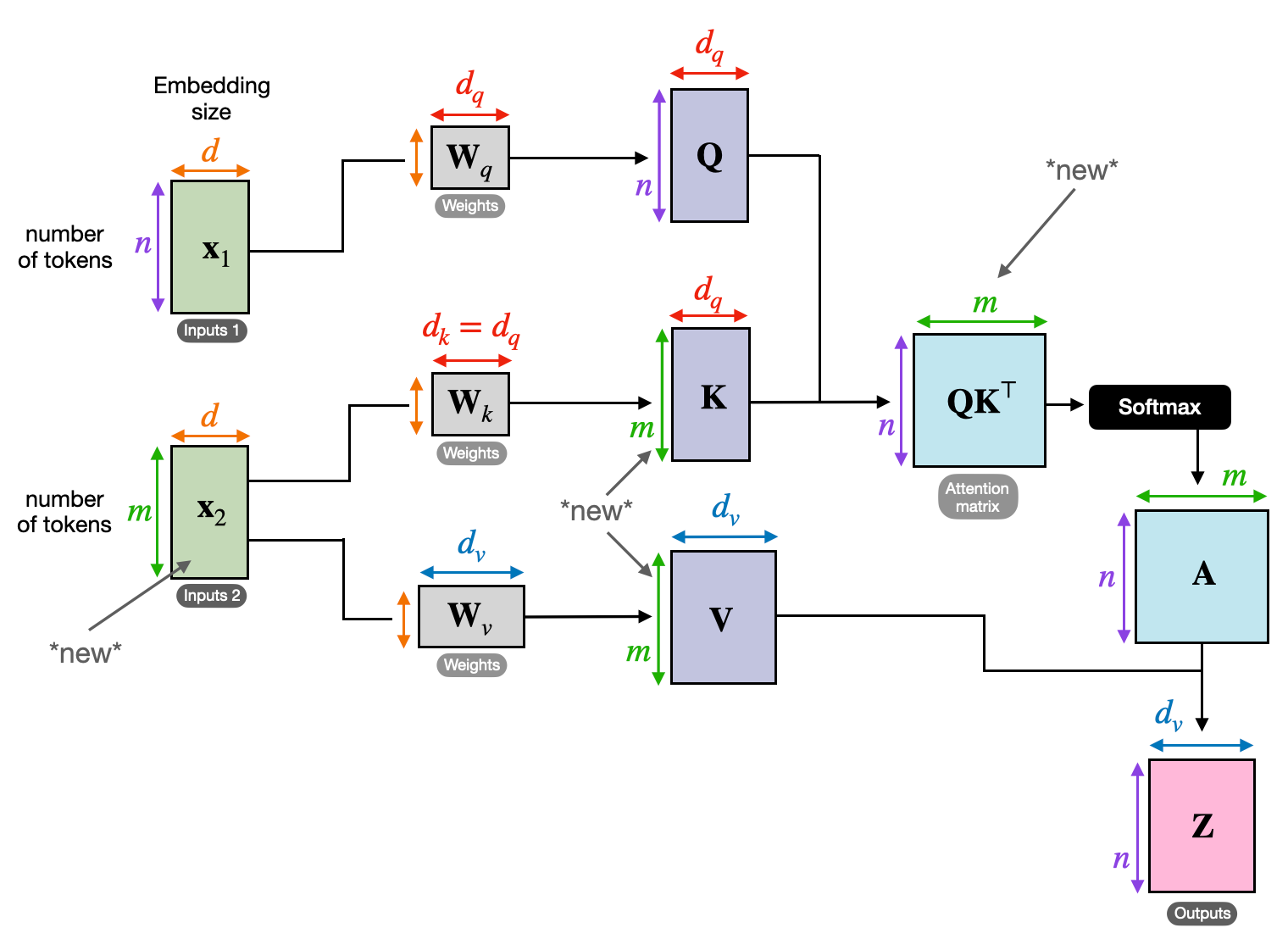

ভেক্টর প্রতিনিধিত্ব

প্রতিটি উপাদান (শব্দ, ডেটা পয়েন্ট) একটি উচ্চ-মাত্রিক ভেক্টরে রূপান্তরিত হয়, এর তথ্য সামগ্রী এনকোড করে। এই ভেক্টর স্থান উপাদানগুলির মধ্যে মিথস্ক্রিয়া জন্য ভিত্তি হিসাবে কাজ করে।

QKV রূপান্তর

তিনটি মূল ম্যাট্রিক্স সংজ্ঞায়িত করা হয়েছে:

- প্রশ্ন (প্রশ্ন): প্রতিটি উপাদান অন্যদের কাছে "প্রশ্ন" উপস্থাপন করে। Q বর্তমান উপাদানের তথ্যের প্রয়োজনীয়তা ক্যাপচার করে এবং অনুক্রমের মধ্যে প্রাসঙ্গিক তথ্যের জন্য তার অনুসন্ধান পরিচালনা করে।

- কী (কে): প্রতিটি উপাদানের তথ্যের "কী" ধরে রাখে। K প্রতিটি উপাদানের বিষয়বস্তুর সারাংশকে এনকোড করে, অন্যান্য উপাদানকে তাদের নিজস্ব প্রয়োজনের ভিত্তিতে সম্ভাব্য প্রাসঙ্গিকতা সনাক্ত করতে সক্ষম করে।

- মান (V): প্রতিটি উপাদান শেয়ার করতে চায় প্রকৃত সামগ্রী সংরক্ষণ করে। V এ বিস্তারিত তথ্য রয়েছে যা অন্যান্য উপাদানগুলি তাদের মনোযোগের স্কোরের উপর ভিত্তি করে অ্যাক্সেস করতে এবং লাভ করতে পারে।

মনোযোগ স্কোর গণনা

প্রতিটি উপাদান জোড়ার মধ্যে সামঞ্জস্যতা তাদের নিজ নিজ Q এবং K ভেক্টরের মধ্যে একটি ডট পণ্যের মাধ্যমে পরিমাপ করা হয়। উচ্চতর স্কোর উপাদানগুলির মধ্যে একটি শক্তিশালী সম্ভাব্য প্রাসঙ্গিকতা নির্দেশ করে।

স্কেল করা মনোযোগ ওজন

আপেক্ষিক গুরুত্ব নিশ্চিত করার জন্য, এই সামঞ্জস্য স্কোরগুলি একটি সফটম্যাক্স ফাংশন ব্যবহার করে স্বাভাবিক করা হয়। এটি 0 থেকে 1 পর্যন্ত মনোযোগের ওজনে পরিণত হয়, যা বর্তমান উপাদানের প্রেক্ষাপটের জন্য প্রতিটি উপাদানের ওজনযুক্ত গুরুত্বের প্রতিনিধিত্ব করে।

ওয়েটেড কনটেক্সট এগ্রিগেশন

V ম্যাট্রিক্সে মনোযোগের ওজন প্রয়োগ করা হয়, মূলত বর্তমান উপাদানের প্রাসঙ্গিকতার উপর ভিত্তি করে প্রতিটি উপাদান থেকে গুরুত্বপূর্ণ তথ্য হাইলাইট করে। এই ওজনযুক্ত যোগফল বর্তমান উপাদানের জন্য একটি প্রাসঙ্গিক উপস্থাপনা তৈরি করে, অনুক্রমের অন্যান্য সমস্ত উপাদান থেকে সংগ্রহ করা অন্তর্দৃষ্টিগুলিকে অন্তর্ভুক্ত করে।

উন্নত উপাদান প্রতিনিধিত্ব

এর সমৃদ্ধ প্রতিনিধিত্বের সাথে, উপাদানটি এখন তার নিজস্ব বিষয়বস্তুর পাশাপাশি অনুক্রমের অন্যান্য উপাদানের সাথে তার সম্পর্কগুলির গভীরতর বোঝার অধিকারী। এই রূপান্তরিত উপস্থাপনা মডেলের মধ্যে পরবর্তী প্রক্রিয়াকরণের ভিত্তি তৈরি করে।

এই বহু-পদক্ষেপ প্রক্রিয়া স্ব-মনোযোগ সক্ষম করে:

- দীর্ঘ-পরিসীমা নির্ভরতা ক্যাপচার করুন: দূরবর্তী উপাদানগুলির মধ্যে সম্পর্কগুলি সহজেই স্পষ্ট হয়ে ওঠে, এমনকি একাধিক হস্তক্ষেপকারী উপাদান দ্বারা পৃথক হলেও।

- মডেল জটিল মিথস্ক্রিয়া: অনুক্রমের মধ্যে সূক্ষ্ম নির্ভরতা এবং পারস্পরিক সম্পর্কগুলিকে আলোতে আনা হয়, যা ডেটা কাঠামো এবং গতিবিদ্যা সম্পর্কে আরও সমৃদ্ধ বোঝার দিকে পরিচালিত করে।

- প্রতিটি উপাদানকে প্রাসঙ্গিক করুন: মডেলটি প্রতিটি উপাদানকে বিচ্ছিন্নভাবে নয় বরং অনুক্রমের বৃহত্তর কাঠামোর মধ্যে বিশ্লেষণ করে, যার ফলে আরও সঠিক এবং সংক্ষিপ্ত ভবিষ্যদ্বাণী বা উপস্থাপনা করা হয়।

স্ব-মনোযোগ বৈপ্লবিক পরিবর্তন করেছে কিভাবে মডেলগুলি অনুক্রমিক ডেটা প্রক্রিয়া করে, মেশিন অনুবাদ, প্রাকৃতিক ভাষা তৈরি, সময় সিরিজের পূর্বাভাস এবং এর বাইরের মতো বিভিন্ন ক্ষেত্রে নতুন সম্ভাবনাগুলি আনলক করে৷ সিকোয়েন্সের মধ্যে লুকানো সম্পর্কগুলি উন্মোচন করার ক্ষমতা অন্তর্দৃষ্টি উন্মোচন এবং বিভিন্ন কাজের মধ্যে উচ্চতর কর্মক্ষমতা অর্জনের জন্য একটি শক্তিশালী হাতিয়ার প্রদান করে।

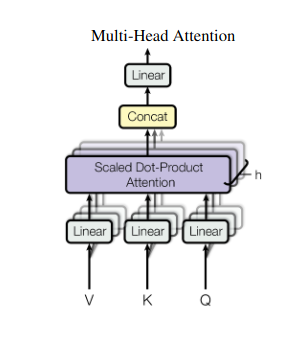

2. মাল্টি-হেড অ্যাটেনশন: বিভিন্ন লেন্সের মাধ্যমে দেখা

স্ব-মনোযোগ একটি সামগ্রিক দৃষ্টিভঙ্গি প্রদান করে, কিন্তু কখনও কখনও ডেটার নির্দিষ্ট দিকগুলিতে ফোকাস করা অত্যন্ত গুরুত্বপূর্ণ। সেখানেই মাল্টি-হেড অ্যাটেনশন আসে। একাধিক সহকারী থাকার কল্পনা করুন, প্রত্যেকে আলাদা লেন্স দিয়ে সজ্জিত:

- একাধিক "মাথা" তৈরি করা হয়, প্রতিটি তার নিজস্ব Q, K, এবং V ম্যাট্রিক্সের মাধ্যমে ইনপুট অনুক্রমে অংশগ্রহণ করে।

- প্রতিটি মাথা ডেটার বিভিন্ন দিকের উপর ফোকাস করতে শেখে, যেমন দীর্ঘ-পরিসর নির্ভরতা, সিনট্যাকটিক সম্পর্ক, বা স্থানীয় শব্দ মিথস্ক্রিয়া।

- প্রতিটি মাথা থেকে আউটপুট তারপর একত্রিত করা হয় এবং ইনপুটের বহুমুখী প্রকৃতি ক্যাপচার করে একটি চূড়ান্ত প্রতিনিধিত্বে প্রজেক্ট করা হয়।

এটি মডেলটিকে একই সাথে বিভিন্ন দৃষ্টিভঙ্গি বিবেচনা করার অনুমতি দেয়, যা ডেটার আরও সমৃদ্ধ এবং আরও সূক্ষ্ম বোঝার দিকে পরিচালিত করে।

3. ক্রস-অ্যাটেনশন: সিকোয়েন্সের মধ্যে সেতু তৈরি করা

তথ্যের বিভিন্ন অংশের মধ্যে সংযোগ বোঝার ক্ষমতা অনেক NLP কাজের জন্য অত্যন্ত গুরুত্বপূর্ণ। একটি বই পর্যালোচনা লেখার কল্পনা করুন – আপনি কেবল শব্দের জন্য পাঠ্য শব্দের সংক্ষিপ্তসার করবেন না, বরং অধ্যায় জুড়ে অন্তর্দৃষ্টি এবং সংযোগগুলি আঁকবেন। প্রবেশ করুন ক্রস মনোযোগ, একটি শক্তিশালী প্রক্রিয়া যা ক্রমগুলির মধ্যে সেতু তৈরি করে, মডেলগুলিকে দুটি স্বতন্ত্র উত্স থেকে তথ্য লাভের ক্ষমতা দেয়৷

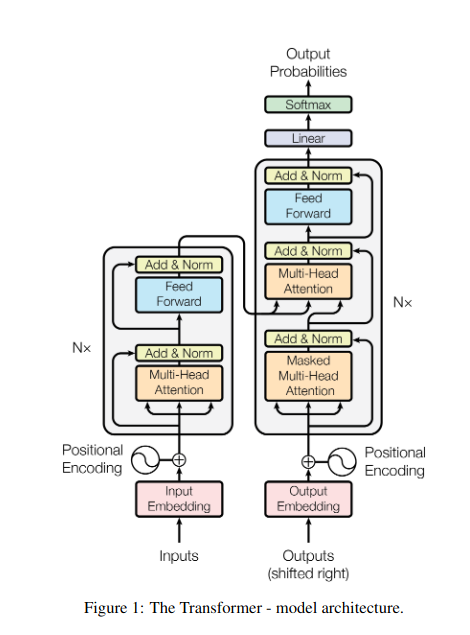

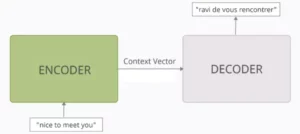

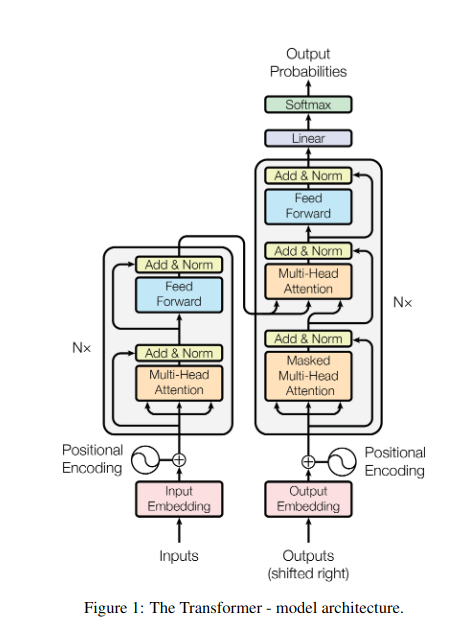

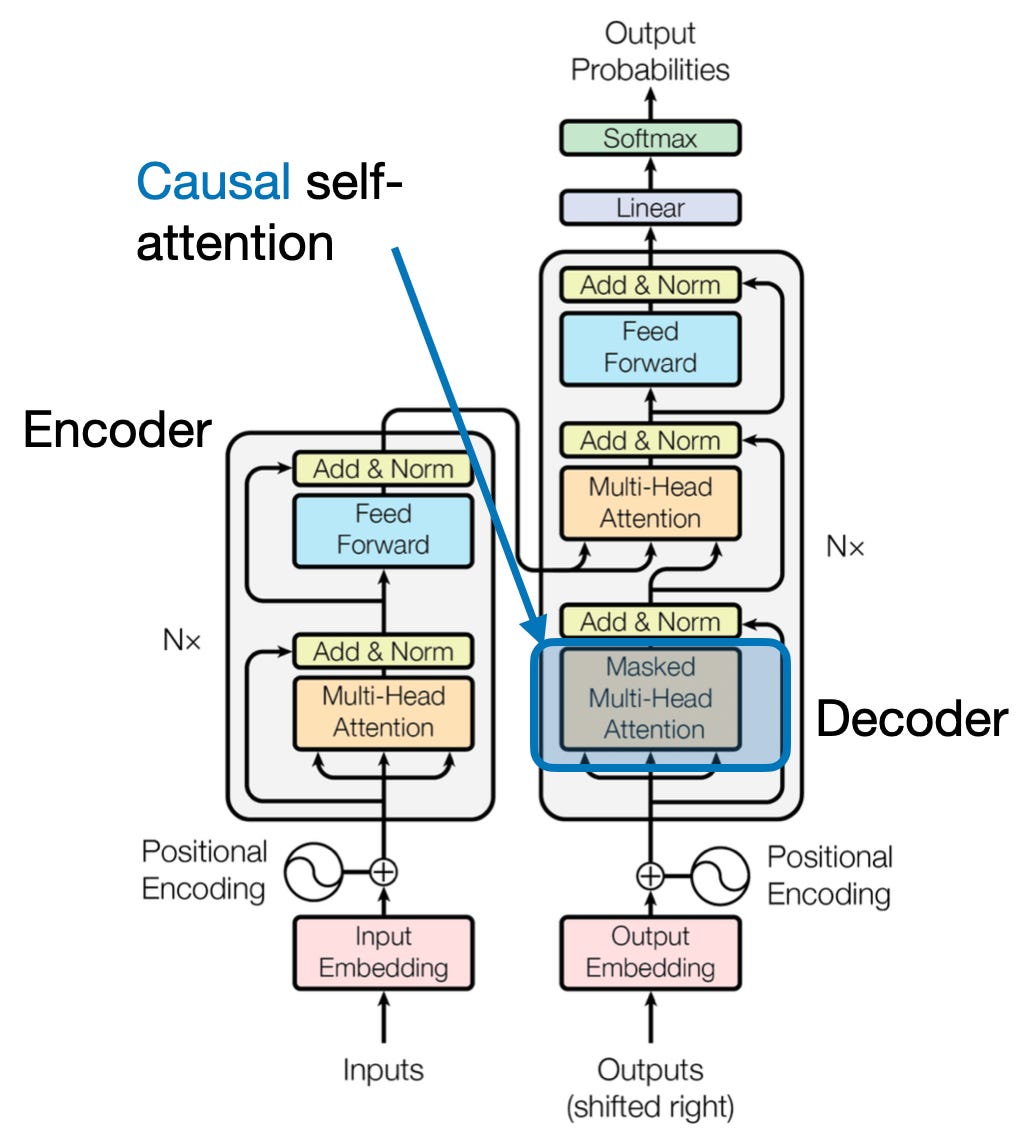

- ট্রান্সফরমারের মতো এনকোডার-ডিকোডার আর্কিটেকচারে, এনকোডার ইনপুট সিকোয়েন্স (বই) প্রক্রিয়া করে এবং একটি লুকানো উপস্থাপনা তৈরি করে।

- সার্জারির ডিকোডার আউটপুট সিকোয়েন্স (পর্যালোচনা) তৈরি করার সময় প্রতিটি ধাপে এনকোডারের লুকানো উপস্থাপনা দেখতে ক্রস-অ্যাটেনশন ব্যবহার করে।

- ডিকোডারের Q ম্যাট্রিক্স এনকোডারের K এবং V ম্যাট্রিক্সের সাথে যোগাযোগ করে, এটি পর্যালোচনার প্রতিটি বাক্য লেখার সময় বইয়ের প্রাসঙ্গিক অংশগুলিতে ফোকাস করতে দেয়।

এই প্রক্রিয়াটি মেশিন অনুবাদ, সংক্ষিপ্তকরণ এবং প্রশ্নের উত্তর দেওয়ার মতো কাজের জন্য অমূল্য, যেখানে ইনপুট এবং আউটপুট ক্রমগুলির মধ্যে সম্পর্ক বোঝা অপরিহার্য।

4. কার্যকারণ মনোযোগ: সময়ের প্রবাহ সংরক্ষণ

সামনে উঁকি না দিয়ে একটি বাক্যে পরবর্তী শব্দের পূর্বাভাস কল্পনা করুন। ঐতিহ্যগত মনোযোগের প্রক্রিয়াগুলি এমন কাজের সাথে লড়াই করে যার জন্য তথ্যের সাময়িক ক্রম সংরক্ষণ করা প্রয়োজন, যেমন পাঠ্য তৈরি এবং সময়-সিরিজের পূর্বাভাস। তারা ক্রমানুসারে সহজেই "সামনে উঁকি দেয়", যা ভুল ভবিষ্যদ্বাণীর দিকে পরিচালিত করে। কার্যকারণ মনোযোগ শুধুমাত্র পূর্বে প্রক্রিয়াকৃত তথ্যের উপর নির্ভর করে ভবিষ্যদ্বাণী নিশ্চিত করে এই সীমাবদ্ধতাকে সম্বোধন করে।

এখানে কিভাবে এটা কাজ করে

- মাস্কিং মেকানিজম: একটি নির্দিষ্ট মুখোশ মনোযোগ ওজন প্রয়োগ করা হয়, কার্যকরভাবে অনুক্রমের ভবিষ্যত উপাদানগুলিতে মডেলের অ্যাক্সেস ব্লক করে। উদাহরণ স্বরূপ, "The woman who..."-এ দ্বিতীয় শব্দটি ভবিষ্যদ্বাণী করার সময়, মডেলটি শুধুমাত্র "the" বিবেচনা করতে পারে এবং "who" বা পরবর্তী শব্দগুলিকে নয়।

- অটোরিগ্রেসিভ প্রসেসিং: তথ্য রৈখিকভাবে প্রবাহিত হয়, প্রতিটি উপাদানের উপস্থাপনা শুধুমাত্র এটির সামনে উপস্থিত উপাদানগুলি থেকে তৈরি হয়। মডেলটি শব্দ দ্বারা অনুক্রম শব্দ প্রক্রিয়া করে, সেই বিন্দু পর্যন্ত প্রতিষ্ঠিত প্রেক্ষাপটের উপর ভিত্তি করে ভবিষ্যদ্বাণী তৈরি করে।

টেক্সট জেনারেশন এবং সময়-সিরিজের পূর্বাভাসের মতো কাজের জন্য কার্যকারণ মনোযোগ অত্যন্ত গুরুত্বপূর্ণ, যেখানে সঠিক ভবিষ্যদ্বাণীর জন্য ডেটার সাময়িক ক্রম বজায় রাখা গুরুত্বপূর্ণ।

5. গ্লোবাল বনাম স্থানীয় মনোযোগ: ব্যালেন্স স্ট্রাইকিং

মনোযোগ মেকানিজমগুলি একটি মূল ট্রেড-অফের মুখোমুখি হয়: দক্ষ গণনা বজায় রাখা বনাম দীর্ঘ-পরিসীমা নির্ভরতা ক্যাপচার করা। এটি দুটি প্রাথমিক পদ্ধতির মধ্যে প্রকাশ করে: বিশ্বব্যাপী মনোযোগ এবং স্থানীয় মনোযোগ. একটি নির্দিষ্ট অধ্যায়ে ফোকাস করার পরিবর্তে একটি সম্পূর্ণ বই পড়ার কল্পনা করুন। বিশ্বব্যাপী মনোযোগ একবারে পুরো ক্রমটি প্রক্রিয়া করে, যখন স্থানীয় মনোযোগ একটি ছোট উইন্ডোতে ফোকাস করে:

- বিশ্বব্যাপী মনোযোগ দীর্ঘ-পরিসর নির্ভরতা এবং সামগ্রিক প্রসঙ্গ ক্যাপচার করে তবে দীর্ঘ ক্রমগুলির জন্য গণনাগতভাবে ব্যয়বহুল হতে পারে।

- স্থানীয় মনোযোগ আরো দক্ষ কিন্তু দূরবর্তী সম্পর্ক মিস করতে পারে.

বিশ্বব্যাপী এবং স্থানীয় মনোযোগের মধ্যে পছন্দ বিভিন্ন কারণের উপর নির্ভর করে:

- টাস্ক প্রয়োজনীয়তা: মেশিন ট্রান্সলেশনের মতো কাজগুলির জন্য দূরবর্তী সম্পর্কগুলি ক্যাপচার করা, বিশ্বব্যাপী মনোযোগের পক্ষে থাকা প্রয়োজন, যখন অনুভূতি বিশ্লেষণ স্থানীয় মনোযোগের ফোকাসকে সমর্থন করতে পারে।

- সিকোয়েন্স দৈর্ঘ্য: দীর্ঘতর ক্রমগুলি বিশ্বব্যাপী মনোযোগকে গণনাগতভাবে ব্যয়বহুল করে তোলে, স্থানীয় বা হাইব্রিড পদ্ধতির প্রয়োজন হয়৷

- মডেল ক্ষমতা: সম্পদের সীমাবদ্ধতা এমনকি বিশ্বব্যাপী প্রেক্ষাপটের প্রয়োজন এমন কাজের জন্য স্থানীয় মনোযোগের প্রয়োজন হতে পারে।

সর্বোত্তম ভারসাম্য অর্জন করতে, মডেলগুলি নিয়োগ করতে পারে:

- ডায়নামিক সুইচিং: গুরুত্ব এবং দূরত্বের উপর ভিত্তি করে অভিযোজিত, মূল উপাদানগুলির জন্য বিশ্বব্যাপী মনোযোগ এবং অন্যদের জন্য স্থানীয় মনোযোগ ব্যবহার করুন।

- হাইব্রিড পন্থা: একই স্তরের মধ্যে উভয় প্রক্রিয়াকে একত্রিত করুন, তাদের নিজ নিজ শক্তির ব্যবহার করুন।

এছাড়াও পড়ুন: গভীর শিক্ষায় নিউরাল নেটওয়ার্কের ধরন বিশ্লেষণ করা

উপসংহার

পরিশেষে, আদর্শ পদ্ধতিটি বিশ্বব্যাপী এবং স্থানীয় মনোযোগের মধ্যে একটি বর্ণালীতে অবস্থিত। এই ট্রেড-অফগুলি বোঝা এবং উপযুক্ত কৌশলগুলি গ্রহণ করা মডেলগুলিকে দক্ষতার সাথে বিভিন্ন স্কেল জুড়ে প্রাসঙ্গিক তথ্য ব্যবহার করতে দেয়, যার ফলে ক্রমটির আরও সমৃদ্ধ এবং আরও সঠিক বোঝার দিকে যায়।

তথ্যসূত্র

- Raschka, S. (2023)। "এলএলএম-এ স্ব-মনোযোগ, মাল্টি-হেড অ্যাটেনশন, ক্রস-অ্যাটেনশন, এবং কার্যকারণ-মনোযোগ বোঝা এবং কোডিং।"

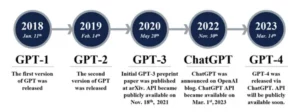

- ভাসওয়ানি, এ., এবং অন্যান্য। (2017)। "মনোযোগ আপনার প্রয়োজন।"

- Radford, A., et al. (2019)। "ভাষা মডেলগুলি তত্ত্বাবধানহীন মাল্টিটাস্ক লার্নার্স।"

সংশ্লিষ্ট

- এসইও চালিত বিষয়বস্তু এবং পিআর বিতরণ। আজই পরিবর্ধিত পান।

- PlatoData.Network উল্লম্ব জেনারেটিভ Ai. নিজেকে ক্ষমতায়িত করুন। এখানে প্রবেশ করুন.

- প্লেটোএআইস্ট্রিম। Web3 ইন্টেলিজেন্স। জ্ঞান প্রসারিত. এখানে প্রবেশ করুন.

- প্লেটোইএসজি। কার্বন, ক্লিনটেক, শক্তি, পরিবেশ সৌর, বর্জ্য ব্যবস্থাপনা. এখানে প্রবেশ করুন.

- প্লেটো হেলথ। বায়োটেক এবং ক্লিনিক্যাল ট্রায়াল ইন্টেলিজেন্স। এখানে প্রবেশ করুন.

- উত্স: https://www.analyticsvidhya.com/blog/2024/01/different-types-of-attention-mechanisms/

- : আছে

- : হয়

- :না

- :কোথায়

- $ ইউপি

- 1

- 2017

- 2019

- 2023

- 302

- 320

- 321

- 7

- a

- ক্ষমতা

- প্রবেশ

- সঠিকতা

- সঠিক

- অর্জন করা

- অর্জনের

- দিয়ে

- কাজ

- আসল

- ঠিকানাগুলি

- দত্তক

- এগিয়ে

- AL

- সব

- অনুমতি

- অনুমতি

- am

- অস্পষ্টতা

- পরিমাণে

- an

- বিশ্লেষণ

- বিশ্লেষণ

- বিশ্লেষণ

- এবং

- উত্তর

- পৃথক্

- আপাত

- ফলিত

- অভিগমন

- পন্থা

- রয়েছি

- এলাকার

- প্রবন্ধ

- AS

- আ

- সহায়ক

- সহায়ক

- At

- পরিচর্যা করা

- দোসর

- মনোযোগ

- সচেতনতা

- ভারসাম্য

- ভিত্তি

- ভিত্তি

- BE

- মরীচি

- পরিণত

- আগে

- মধ্যে

- তার পরেও

- রোধক

- বই

- বই

- উভয়

- ব্রিজ

- সেতু

- উজ্জ্বল

- বৃহত্তর

- আনীত

- ভবন

- তৈরী করে

- নির্মিত

- কিন্তু

- by

- মাংস

- CAN

- গ্রেপ্তার

- ক্যাচ

- ক্যাপচার

- মামলা

- পরিবর্তন

- অধ্যায়

- অধ্যায়গুলির

- পছন্দ

- কাছাকাছি

- কোডিং

- মেশা

- আসে

- কোম্পানি

- সঙ্গতি

- জটিল

- গণনা

- গণনা

- সংযোগ করা

- সংযোজক

- সংযোগ

- বিবেচনা

- বিবেচনা করা

- সীমাবদ্ধতার

- ধারণ

- বিষয়বস্তু

- প্রসঙ্গ

- অবিরত

- মূল

- সম্পর্কযুক্তরূপে

- নির্মিত

- সৃষ্টি

- তৈরি করা হচ্ছে

- সংকটপূর্ণ

- কঠোর

- বর্তমান

- উপাত্ত

- তথ্য বিজ্ঞান

- পাঠোদ্ধার করা

- গভীর

- গভীর

- সংজ্ঞায়িত

- delves

- নির্ভর

- নির্ভরতা

- নির্ভরতা

- বশ্যতা

- নির্ভর করে

- বিশদ

- সংলাপ

- DID

- বিভিন্ন

- সরাসরি

- দূরত্ব

- দূরবর্তী

- স্বতন্ত্র

- বিচিত্র

- do

- দলিল

- DOT

- ডবল

- ডজন

- নাটকীয়ভাবে

- আঁকা

- কারণে

- গতিবিদ্যা

- E&T

- প্রতি

- কার্যকরীভাবে

- দক্ষতা

- দক্ষ

- দক্ষতার

- উপাদান

- উপাদান

- ক্ষমতায়নের

- সম্ভব

- সক্রিয়

- এনকোডিং

- সমৃদ্ধ

- নিশ্চিত করা

- নিশ্চিত

- প্রবেশ করান

- সমগ্র

- সম্পূর্ণতা

- সজ্জিত

- বিশেষত

- সারমর্ম

- অপরিহার্য

- মূলত

- প্রতিষ্ঠিত

- এমন কি

- প্রতি

- গজান

- ঠিক

- ব্যয়বহুল

- কাজে লাগান

- নির্যাস

- মুখ

- কারণের

- এ পর্যন্ত

- আনুকূল্য

- ক্ষেত্র

- ক্ষেত্রসমূহ

- চূড়ান্ত

- প্রবাহ

- প্রবাহ

- কেন্দ্রবিন্দু

- দৃষ্টি নিবদ্ধ করা

- গুরুত্ত্ব

- মনোযোগ

- জন্য

- একেবারে পুরোভাগ

- ফর্ম

- ভিত

- চার

- ফ্রেমওয়ার্ক

- থেকে

- ক্রিয়া

- বৈশিষ্ট্য

- ভবিষ্যৎ

- খেলা

- উত্পন্ন

- উৎপাদিত

- প্রজন্ম

- বিশ্বব্যাপী

- বৈশ্বিক প্রেক্ষাপটে

- ধরা

- হত্তয়া

- নির্দেশিকা

- পথনির্দেশক

- হাতল

- আছে

- জমিদারি

- মাথা

- সাহায্য

- গোপন

- উচ্চ

- ঊর্ধ্বতন

- হাইলাইট

- ঝুলিতে

- হোলিস্টিক

- কিভাবে

- HTTPS দ্বারা

- মানবীয়

- অকুলীন

- i

- আদর্শ

- সনাক্ত করা

- if

- কল্পনা করা

- আশু

- গুরুত্ব

- গুরুত্বপূর্ণ

- in

- বেঠিক

- একত্রিত

- ইঙ্গিত

- স্বতন্ত্র

- অদক্ষ

- তথ্য

- মজ্জাগতভাবে

- ইনপুট

- অর্ন্তদৃষ্টি

- উদাহরণ

- বুদ্ধিমান

- অভিপ্রেত

- মিথষ্ক্রিয়া

- পারস্পরিক ক্রিয়ার

- ইন্টারেক্টিভ

- হস্তক্ষেপ

- মধ্যে

- অমুল্য

- বিচ্ছিন্নতা

- IT

- এর

- JPG

- মাত্র

- চাবি

- প্রধান ক্ষেত্র

- ভাষা

- গত

- স্তর

- নেতৃত্ব

- শিখতে

- শিখুন এবং বৃদ্ধি করুন

- শিক্ষার্থীদের

- শিক্ষা

- বরফ

- লেন্স

- লেন্স

- লেভারেজ

- উপজীব্য

- লাইব্রেরি

- মিথ্যা

- আলো

- মত

- সীমাবদ্ধতা

- সীমাবদ্ধতা

- স্থানীয়

- দীর্ঘ

- আর

- দেখুন

- ভালবাসা

- মেশিন

- মেশিন লার্নিং

- যন্ত্রানুবাদ

- বজায় রাখার

- করা

- মেকিং

- এক

- অনেক

- মাস্ক

- জরায়ু

- সর্বোচ্চ প্রস্থ

- অর্থ

- অর্থ

- মাপা

- পদ্ধতি

- মেকানিজম

- স্মৃতি

- হতে পারে

- মিস্

- অনুপস্থিত

- মডেল

- মডেল

- অধিক

- আরো দক্ষ

- বহুমুখী

- বহু

- প্রাকৃতিক

- স্বভাবিক ভাষা

- প্রাকৃতিক ভাষা জেনারেশন

- স্বাভাবিক ভাষা প্রক্রিয়াকরণ

- প্রাকৃতিক ভাষা বোঝা

- প্রকৃতি

- প্রয়োজন

- প্রয়োজন

- চাহিদা

- প্রতিবেশী

- নেটওয়ার্ক

- নিউরাল

- নিউরাল নেটওয়ার্ক

- নতুন

- পরবর্তী

- রাত

- NLP

- বিশেষ্য

- এখন

- সংক্ষিপ্ত

- of

- প্রায়ই

- on

- একদা

- কেবল

- অনুকূল

- or

- ক্রম

- অন্যান্য

- অন্যরা

- আমাদের

- বাইরে

- আউটপুট

- আউটপুট

- সামগ্রিক

- ওভারভিউ

- নিজের

- পৃষ্ঠা

- যুগল

- কাগজ

- সমান্তরাল

- যন্ত্রাংশ

- প্যাসেজ

- গত

- নিদর্শন

- সম্পাদন করা

- কর্মক্ষমতা

- দৃষ্টিকোণ

- টুকরা

- Plato

- প্লেটো ডেটা ইন্টেলিজেন্স

- প্লেটোডাটা

- খেলা

- বিন্দু

- ভঙ্গি

- possesses

- সম্ভাবনার

- ক্ষমতাশালী

- সম্ভাব্য

- সম্ভাব্য

- ক্ষমতা

- ক্ষমতাশালী

- পূর্বাভাসের

- ভবিষ্যতবাণী

- সংরক্ষণ করা

- নিরোধক

- পূর্বে

- প্রাথমিকভাবে

- প্রাথমিক

- প্রক্রিয়া

- প্রক্রিয়াজাত

- প্রসেস

- প্রক্রিয়াজাতকরণ

- প্রসেসিং শক্তি

- পণ্য

- অভিক্ষিপ্ত

- চালিত

- উপলব্ধ

- প্রশ্ন

- পরিসর

- রেঞ্জিং

- বরং

- পড়া

- ইচ্ছাপূর্বক

- পড়া

- প্রকৃত সময়

- উল্লেখ

- তথাপি

- সম্পর্ক

- উপর

- প্রাসঙ্গিকতা

- প্রাসঙ্গিক

- অসাধারণ

- প্রতিনিধিত্ব

- প্রতিনিধিত্বমূলক

- প্রতিনিধিত্ব করে

- প্রয়োজন

- সমাধান

- সংস্থান

- Resources

- নিজ নিজ

- ফলাফল

- এখানে ক্লিক করুন

- বৈপ্লবিক

- বিপ্লব হয়েছে

- ধনী

- ভূমিকা

- s

- একই

- সারক্যাসম

- করাত

- দাঁড়িপাল্লা

- স্ক্যানিং

- বিজ্ঞান

- স্কোর

- স্কোর

- সার্চ

- দ্বিতীয়

- এইজন্য

- বাক্য

- অনুভূতি

- ক্রম

- ক্রম

- স্থল

- বিভিন্ন

- শেয়ার

- জ্বলজ্বলে

- শুটিং

- সংক্ষিপ্ত

- গ্লাসকেস

- এককালে

- ধীর

- ক্ষুদ্রতর

- কেবলমাত্র

- সমাধান

- কখনও কখনও

- সোর্স

- স্থান

- নির্দিষ্ট

- বিশেষভাবে

- বর্ণালী

- গতি

- স্পটলাইট

- স্থায়ী

- তারকা

- ধাপ

- দোকান

- কৌশল

- শক্তি

- শক্তিশালী

- গঠন

- সংগ্রাম

- সংগ্রাম

- বিষয়

- পরবর্তী

- এমন

- উপযুক্ত

- সমষ্টি

- সংক্ষিপ্ত করা

- সংক্ষিপ্তসার

- উচ্চতর

- পার্শ্ববর্তী

- সিস্টেম

- সাজসরঁজাম

- গ্রহণ

- ট্যাপেষ্ট্রি

- কাজ

- কারিগরী

- মেয়াদ

- পাঠ

- পাঠ্য প্রজন্ম

- যে

- সার্জারির

- বিশ্ব

- তাদের

- তাহাদিগকে

- তারপর

- এইগুলো

- তারা

- এই

- তিন

- দ্বারা

- সময়

- সময় সিরিজ

- থেকে

- টুল

- ঐতিহ্যগত

- প্রশিক্ষণ

- রূপান্তরিত

- রুপান্তরিত

- ট্রান্সফরমার

- ট্রান্সফরমার

- রূপান্তর

- অনুবাদ

- সত্য

- দুই

- ধরনের

- পরিণামে

- বোঝা

- বোধশক্তি

- স্বপ্নাতীত

- উদ্ঘাটন

- প্রকটিত করা

- অপাবৃত

- ব্যবহার

- ব্যবহারসমূহ

- ব্যবহার

- বিভিন্ন

- সুবিশাল

- বনাম

- চেক

- পরিদর্শন

- অত্যাবশ্যক

- vs

- প্রয়োজন

- চায়

- ছিল

- আমরা একটি

- কি

- কখন

- যখন

- হু

- সমগ্র

- ব্যাপক

- প্রশস্ত পরিসর

- ইচ্ছা

- জানলা

- সঙ্গে

- মধ্যে

- ছাড়া

- নারী

- শব্দ

- শব্দ

- হয়া যাই ?

- বিশ্ব

- লেখা

- গতকাল

- আপনি

- zephyrnet

- চিড়িয়াখানা