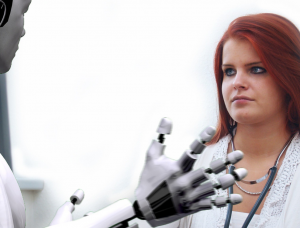

أحدث الذكاء الاصطناعي (AI) ثورة في العديد من الصناعات، حيث قدم العديد من الفوائد والفرص. ومع ذلك، ظهرت مخاوف بشأن إمكانية قيام الذكاء الاصطناعي بإدامة التمييز والتحيز. يستكشف هذا المقال موضوع التمييز في الذكاء الاصطناعي، ويسلط الضوء على تحديات تحديد ومعالجة التحيزات المضمنة في أنظمة الذكاء الاصطناعي. ويعرب المطلعون على الصناعة عن شكوكهم حول الآثار الأخلاقية والمعنوية للذكاء الاصطناعي، مشيرين إلى المخاوف بشأن المعلومات الخاطئة، والتحيز في الخوارزميات، وتوليد المحتوى المضلل. مع احتدام المناقشات المحيطة بالذكاء الاصطناعي، هناك دعوة متزايدة إلى وضع تنظيمات هادفة لضمان الشفافية والمساءلة وحماية الحقوق الأساسية.

تحديات الصناعات المالية مع الذكاء الاصطناعي

وفقًا لنبيل منجي، رئيس قسم العملات المشفرة وWeb3 في Worldpay by FIS، فإن فعالية منتجات الذكاء الاصطناعي تعتمد بشكل كبير على جودة المواد المصدرية المستخدمة للتدريب. وفي مقابلة مع CNBC، أوضح مانجي أن هناك عاملين رئيسيين يساهمان في أداء الذكاء الاصطناعي: البيانات التي يمكنه الوصول إليها وقدرات النموذج اللغوي الكبير.

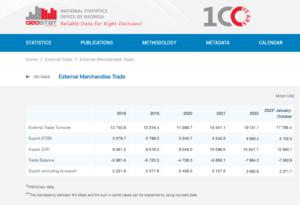

لتوضيح أهمية البيانات، ذكر مانجي أن شركات مثل Reddit قد أعلنت علنًا عن قيود على جمع البيانات، مما يتطلب الدفع مقابل الوصول إليها. وفي قطاع الخدمات المالية، سلط الضوء على التحدي الذي تمثله أنظمة البيانات المجزأة بمختلف اللغات والأشكال. ويحد هذا الافتقار إلى الدمج والمواءمة من فعالية المنتجات التي تعتمد على الذكاء الاصطناعي، وخاصة عند مقارنتها بالصناعات التي تتمتع ببنية تحتية موحدة وحديثة للبيانات.

وفقًا لمانجي، فإن استخدام تقنية blockchain أو تقنية دفتر الأستاذ الموزع قد يوفر حلاً محتملاً لمعالجة هذه المشكلة. يمكن لهذا النهج المبتكر أن يوفر شفافية معززة في البيانات المجزأة المخزنة داخل الأنظمة المعقدة للبنوك التقليدية. ومع ذلك، فقد أقر بأن طبيعة البنوك شديدة التنظيم وبطيئة الحركة قد تعيق قدرتها على تبني أدوات جديدة للذكاء الاصطناعي بسرعة، على عكس شركات التكنولوجيا الأكثر مرونة مثل مايكروسوفت وجوجل، والتي كانت في طليعة قيادة الابتكار خلال السنوات القليلة الماضية. عقود.

وبالنظر إلى هذه العوامل، يصبح من الواضح أن الصناعة المالية تواجه تحديات فريدة في الاستفادة من الذكاء الاصطناعي بسبب تعقيدات تكامل البيانات والطبيعة المتأصلة للقطاع المصرفي.

وفقًا لرومان شودري، الرئيس السابق لأخلاقيات التعلم الآلي والشفافية والمساءلة في تويتر، يعد الإقراض مثالًا بارزًا على كيفية تأثير التحيز في أنظمة الذكاء الاصطناعي سلبًا على المجتمعات المهمشة. وفي حديثه خلال حلقة نقاش في أمستردام، سلط شودري الضوء على الممارسة التاريخية المتمثلة في "الخطوط الحمراء" في شيكاغو خلال الثلاثينيات. تضمنت عملية إعادة الخط رفض القروض للأحياء التي تسكنها أغلبية من الأمريكيين من أصل أفريقي على أساس التركيبة السكانية العنصرية.

أوضح تشودري أنه على الرغم من أن الخوارزميات الحديثة قد لا تتضمن العرق بشكل صريح كنقطة بيانات، إلا أنه لا يزال من الممكن تشفير التحيزات ضمنيًا. عند تطوير الخوارزميات لتقييم مدى خطورة المناطق والأفراد لأغراض الإقراض، فإن البيانات التاريخية التي تحتوي على تحيزات يمكن أن تؤدي إلى إدامة التمييز عن غير قصد.

وسلط أنجل بوش، صاحب الرؤية وراء النساء السود في الذكاء الاصطناعي، الضوء على أهمية الاعتراف بالمخاطر المرتبطة بإعادة إنتاج التحيزات المضمنة في البيانات التاريخية عند استخدام أنظمة الذكاء الاصطناعي لاتخاذ قرارات الموافقة على القروض. ومن الممكن أن تؤدي مثل هذه الممارسة إلى الرفض التلقائي لطلبات القروض المقدمة من المجتمعات المهمشة، وبالتالي إدامة عدم المساواة العرقية أو بين الجنسين.

وأشار فروست لي، أحد مطوري الذكاء الاصطناعي ذوي الخبرة، إلى تحديات التخصيص في تكامل الذكاء الاصطناعي. يمكن أن يتضمن اختيار "الميزات الأساسية" لتدريب نماذج الذكاء الاصطناعي في بعض الأحيان عوامل غير ذات صلة قد تؤدي إلى نتائج متحيزة. قدم لي مثالاً على كيفية مواجهة الشركات الناشئة في مجال التكنولوجيا المالية التي تستهدف الأجانب معايير تقييم ائتمانية مختلفة مقارنة بالبنوك المحلية، التي هي أكثر دراية بالمدارس والمجتمعات المحلية.

أوضح نيكلاس جوسكي، مدير العمليات في شركة Taktile، وهي شركة ناشئة متخصصة في أتمتة عملية صنع القرار في مجال التكنولوجيا المالية، أن الذكاء الاصطناعي التوليدي لا يُستخدم عادةً لإنشاء درجات ائتمانية أو تسجيل مخاطر المستهلكين. بل على العكس من ذلك، تكمن قوتها في المعالجة المسبقة للبيانات غير المنظمة، مثل الملفات النصية، لتعزيز جودة البيانات لنماذج الاكتتاب التقليدية.

باختصار، يثير استخدام الذكاء الاصطناعي في الإقراض والخدمات المالية مخاوف بشأن التحيز والتمييز. يمكن أن تؤدي التحيزات التاريخية المضمنة في البيانات واختيار الميزات غير ذات الصلة أثناء تدريب الذكاء الاصطناعي إلى نتائج غير عادلة. ومن الأهمية بمكان أن تعترف البنوك والمؤسسات المالية بهذه القضايا وتعالجها لمنع استمرار التمييز غير المقصود عند تنفيذ حلول الذكاء الاصطناعي.

إثبات التمييز بالذكاء الاصطناعي

قد يكون إثبات التمييز القائم على الذكاء الاصطناعي أمرًا صعبًا، كما يتضح من أمثلة مثل القضية المتعلقة بشركة أبل وجولدمان ساكس. رفضت إدارة الخدمات المالية بولاية نيويورك مزاعم فرض حدود أدنى على بطاقة أبل للنساء، مشيرة إلى عدم وجود أدلة تثبت ذلك.

ويشير كيم سموتر، مدير الشبكة الأوروبية لمناهضة العنصرية، إلى أن النشر الجماعي للذكاء الاصطناعي يؤدي إلى الغموض في عمليات صنع القرار، مما يجعل من الصعب على الأفراد تحديد التمييز ومعالجته.

يوضح سموتر أن الأفراد غالبًا ما يكون لديهم معرفة محدودة بكيفية عمل أنظمة الذكاء الاصطناعي، مما يجعل من الصعب اكتشاف حالات التمييز أو التحيز النظامي. ويصبح الأمر أكثر تعقيدًا عندما يكون التمييز جزءًا من قضية أوسع تؤثر على أفراد متعددين. يشير سموتر إلى فضيحة رعاية الطفل الهولندية، حيث تم تصنيف عدد كبير من مطالبات الإعانات بشكل خاطئ على أنها احتيالية بسبب التحيز المؤسسي. إن اكتشاف مثل هذه الاختلالات يمثل تحديًا، وقد يكون الحصول على الإنصاف أمرًا صعبًا ويستغرق وقتًا طويلاً، مما يؤدي إلى ضرر كبير وأحيانًا لا يمكن إصلاحه.

توضح هذه الأمثلة الصعوبات الكامنة في إثبات التمييز القائم على الذكاء الاصطناعي والحصول على سبل الانتصاف عند حدوث مثل هذا التمييز. إن تعقيد أنظمة الذكاء الاصطناعي وانعدام الشفافية في عمليات صنع القرار يمكن أن يجعل من الصعب على الأفراد التعرف على حالات التمييز ومعالجتها بشكل فعال.

ووفقا لتشودري، هناك حاجة ملحة لإنشاء هيئة تنظيمية عالمية مماثلة للأمم المتحدة لمعالجة المخاطر المرتبطة بالذكاء الاصطناعي. وفي حين أظهر الذكاء الاصطناعي ابتكارا ملحوظا، فقد أثار خبراء التكنولوجيا وعلماء الأخلاق مخاوف بشأن آثاره الأخلاقية والمعنوية. وتشمل هذه المخاوف قضايا مثل المعلومات المضللة، والتحيزات العنصرية والجنسانية المتأصلة في خوارزميات الذكاء الاصطناعي، وتوليد المحتوى المضلل بواسطة أدوات مثل ChatGPT.

يعرب تشودري عن قلقه بشأن الدخول إلى عالم ما بعد الحقيقة حيث تصبح المعلومات عبر الإنترنت، بما في ذلك النصوص والفيديو والصوت، غير جديرة بالثقة بسبب الذكاء الاصطناعي المولد. وهذا يثير تساؤلات حول كيف يمكننا ضمان سلامة المعلومات وكيف يمكننا الاعتماد عليها لاتخاذ قرارات مستنيرة. وباستخدام قانون الذكاء الاصطناعي التابع للاتحاد الأوروبي كمثال، فإن التنظيم الهادف للذكاء الاصطناعي يشكل أهمية بالغة في هذه اللحظة. ومع ذلك، هناك مخاوف بشأن الجدول الزمني الطويل الذي تستغرقه المقترحات التنظيمية لتصبح فعالة، مما قد يؤدي إلى تأخير الإجراءات الضرورية.

يؤكد سموتر على الحاجة إلى قدر أكبر من الشفافية والمساءلة في خوارزميات الذكاء الاصطناعي. ويتضمن ذلك جعل الخوارزميات أكثر قابلية للفهم بالنسبة لغير الخبراء، وإجراء الاختبارات ونشر النتائج، وإنشاء عمليات مستقلة لتقديم الشكاوى، وإجراء عمليات تدقيق وإعداد تقارير دورية، وإشراك المجتمعات العنصرية في تصميم ونشر التكنولوجيا. ومن المتوقع أن يبدأ إنفاذ قانون الذكاء الاصطناعي، الذي يأخذ منظور الحقوق الأساسية ويقدم مفاهيم مثل الإنصاف، في غضون عامين تقريبًا. وسيكون تقليص هذا الجدول الزمني مفيدًا لدعم الشفافية والمساءلة باعتبارهما جانبين أساسيين من جوانب الابتكار.

- محتوى مدعوم من تحسين محركات البحث وتوزيع العلاقات العامة. تضخيم اليوم.

- PlatoData.Network Vertical Generative Ai. تمكين نفسك. الوصول هنا.

- أفلاطونايستريم. ذكاء Web3. تضخيم المعرفة. الوصول هنا.

- أفلاطون السيارات / المركبات الكهربائية ، كربون، كلينتك ، الطاقة، بيئة، شمسي، إدارة المخلفات. الوصول هنا.

- BlockOffsets. تحديث ملكية الأوفست البيئية. الوصول هنا.

- المصدر https://www.forexnewsnow.com/fintech/the-urgency-of-addressing-ai-discrimination-transparency-accountability-and-regulatory-timelines/

- :لديها

- :يكون

- :ليس

- :أين

- a

- القدرة

- من نحن

- الوصول

- المساءلة

- واعترف

- عمل

- الإجراءات

- العنوان

- معالجة

- تبنى

- مفيد

- سلبا

- تؤثر

- الأفريقي

- ضد

- رشيق

- AI

- قانون AI

- أنظمة الذكاء الاصطناعي

- تدريب الذكاء الاصطناعى

- خوارزميات

- مزاعم

- بالرغم ان

- أمريكي

- أمستردام

- an

- و

- كان متوقعا

- تفاح

- بطاقة أبل

- التطبيقات

- نهج

- موافقة

- ما يقرب من

- هي

- البند

- مصطنع

- الذكاء الاصطناعي

- AS

- الجوانب

- تقييم

- التقييم المناسبين

- أسوشيتد

- At

- سمعي

- التدقيق

- أوتوماتيك

- أتمتة

- البنوك والمصارف

- القطاع المصرفي

- البنوك

- على أساس

- BE

- أصبح

- يصبح

- كان

- وراء

- تستفيد

- الفوائد

- انحياز

- انحيازا

- التحيزات

- اسود

- سلسلة كتلة

- الجسدي

- يجلب

- أوسع

- by

- دعوة

- CAN

- قدرات

- فيزا وماستركارد

- حقيبة

- تحدى

- التحديات

- تحدي

- شات جي بي تي

- شيكاغو

- طفل

- مطالبات

- توضيح

- CNBC

- المجتمعات

- الشركات

- مقارنة

- شكوى

- مجمع

- التعقيدات

- تعقيد

- المفاهيم

- اهتمامات

- إجراء

- توحيد

- المستهلكين

- يحتوي

- محتوى

- عكس

- المساهمة

- تقليدي

- سجع

- خلق

- ائتمان

- المعايير

- حاسم

- التشفير

- الأخطار

- البيانات

- البنية التحتية للبيانات

- تكامل البيانات

- جودة البيانات

- المناقشات

- عقود

- اتخاذ القرار

- القرارات

- التركيبة السكانية

- القسم

- يعتمد

- نشر

- تصميم

- المطور

- تطوير

- مختلف

- صعبة

- الصعوبات

- مدير المدارس

- اكتشاف

- تمييز

- مناقشة

- وزعت

- دفتر الأستاذ الموزع

- توزيع تكنولوجيا دفتر الأستاذ

- قيادة

- اثنان

- أثناء

- الهولندية

- الطُرق الفعّالة

- على نحو فعال

- فعالية

- جزءا لا يتجزأ من

- ظهرت

- يؤكد

- شمل

- تطبيق

- تعزيز

- تعزيز

- ضمان

- الدخول

- خاصة

- تأسيس

- أخلاقي

- أخلاق

- المجلة الأوروبية

- حتى

- دليل

- واضح

- مثال

- أمثلة

- تمكنت

- شرح

- ويوضح

- يستكشف

- التعبير

- الوجه

- وجوه

- العوامل

- مألوف

- المميزات

- قليل

- ملفات

- مالي

- الصناعات المالية

- المؤسسات المالية

- الخدمات المالية

- FINTECH

- الشركات الناشئة fintech

- fintechs

- الجبهة الاسلامية للانقاذ

- في حالة

- طليعة

- سابق

- مجزأة

- محتال

- تبدأ من

- أساسي

- الجنس

- جيل

- توليدي

- الذكاء الاصطناعي التوليدي

- العالمية

- جولدمان

- جولدمان ساكس

- شراء مراجعات جوجل

- أكبر

- متزايد

- ضرر

- يملك

- he

- رئيس

- بشكل كبير

- سلط الضوء

- جدا

- تاريخي

- كيفية

- لكن

- HTTPS

- تحديد

- تحديد

- تحقيق

- آثار

- أهمية

- فرض

- in

- تتضمن

- يشمل

- بما فيه

- مستقل

- الأفراد

- الصناعات

- العالمية

- عدم المساواة

- معلومات

- وأبلغ

- البنية التحتية

- متأصل

- الابتكار

- مبتكرة

- المؤسسية

- المؤسسات

- متكامل

- التكامل

- سلامة

- رؤيتنا

- المقابلة الشخصية

- إلى

- يدخل

- تنطوي

- المشاركة

- تنطوي

- قضية

- مسائل

- IT

- انها

- المعرفة

- نقص

- لغة

- اللغات

- كبير

- قيادة

- قيادة

- تعلم

- دفتر الحسابات

- الإقراض

- الاستفادة من

- li

- يكمن

- ضوء

- مثل

- محدود

- حدود

- قرض

- القروض

- محلي

- البنوك المحلية

- خفض

- آلة

- آلة التعلم

- الرئيسية

- جعل

- القيام ب

- كتلة

- مادة

- مايو..

- ذات مغزى

- المذكورة

- مایکروسافت

- ربما

- معلومات خاطئة

- مضلل

- نموذج

- عارضات ازياء

- تقدم

- لحظة

- أخلاقي

- الأكثر من ذلك

- متعدد

- الأمم

- الطبيعة

- ضروري

- حاجة

- شبكة

- جديد

- نيويورك

- ولاية نيويورك

- دائرة ولاية نيويورك للخدمات المالية

- غير الخبراء

- جدير بالذكر

- عدد

- كثير

- فوائد عديدة

- الحصول على

- of

- عرض

- الوهب

- غالبا

- on

- online

- طريقة التوسع

- الفرص

- or

- خارج

- النتائج

- لوحة

- نقاش

- جزء

- الماضي

- وسائل الدفع

- أداء

- دوري

- التخصيص

- منظور

- أفلاطون

- الذكاء افلاطون البيانات

- أفلاطون داتا

- البوينت

- نقاط

- محتمل

- يحتمل

- ممارسة

- في الغالب

- الضغط

- منع

- المشكلة

- العمليات

- المنتجات

- اقتراحات

- الحماية

- تزود

- المقدمة

- علانية

- نشر

- أغراض

- جودة

- الأسئلة المتكررة

- سباق

- عنصرية

- رفع

- يثير

- الاعتراف

- رديت

- تقليص

- المراجع

- بخصوص

- ما هو مقنن

- اللائحة

- المنظمين

- اعتمد

- لافت للنظر

- التقارير

- القيود

- النتائج

- ثورة

- حقوق

- المخاطرة

- المخاطر

- ساكس

- فضيحة

- المدارس

- عشرات

- النقاط

- إلغاء

- القطاع

- اختيار

- اختيار

- خدماتنا

- أظهرت

- أهمية

- هام

- مماثل

- حل

- الحلول

- مصدر

- تحدث

- متخصصة

- بدء التشغيل

- البدء

- الولايه او المحافظه

- وزارة الخارجية

- لا يزال

- تخزين

- قوة

- هذه

- ملخص

- المحيط

- بسرعة

- النظامية

- أنظمة

- معالجة

- يأخذ

- استهداف

- التكنولوجيا

- شركات التكنولوجيا

- التكنولوجيين

- تكنولوجيا

- اختبارات

- أن

- •

- المصدر

- من مشاركة

- هناك.

- وبالتالي

- تشبه

- استهلاك الوقت

- الجدول الزمني

- الجداول الزمنية

- إلى

- أدوات

- موضوع

- قادة الإيمان

- الشفافية

- أو تويتر

- اثنان

- عادة

- مفهوم

- الاكتتاب

- غير منصف

- فريد من نوعه

- متحد

- الأمم المتحدة

- مختلف

- دعم

- إلحاح

- تستخدم

- مستعمل

- مختلف

- فيديو

- البصيرة

- we

- Web3

- خيرية

- كان

- متى

- التي

- في حين

- مع

- في غضون

- نسائي

- العالم

- WORLDPAY

- قلق

- سوف

- سنوات

- نيويورك

- زفيرنت